IT House melaporkan pada 12 Jun bahawa Meta baru-baru ini membuka sumber model bahasa AInya MusicGen di Github, yang berdasarkan model Transformer yang dilancarkan oleh Google pada 2017. Seperti yang ditunjukkan oleh nama model, MusicGen digunakan terutamanya untuk penjanaan muzik Ia boleh menukar teks dan melodi sedia ada kepada muzik lengkap .

Pasukan R&D berkata: "Kami menggunakan 20,000 jam muzik yang dibenarkan untuk melatih model, dan menggunakan pengekod EnCodec Meta untuk menguraikan data audio kepada unit yang lebih kecil untuk pemprosesan selari, dengan itu meningkatkan kecekapan dan penjanaan pengkomputeran MusicGen Kelajuan lebih baik daripada jenis model AI yang sama ”

Selain itu, MusicGen juga menyokong input gabungan teks dan melodi Sebagai contoh, anda boleh mencadangkan untuk menjana "sekeping lilting" dan pada masa yang sama meminta "untuk menggabungkannya dengan "Ode" Beethoven. kepada Joy" Gabungan".

Pasukan R&D juga menguji prestasi sebenar MusicGen. Keputusan menunjukkan bahawa berbanding dengan MusicLM Google dan model muzik lain seperti Riffusion, Mousai dan Noise2Music, MusicGen berprestasi lebih baik dalam petunjuk ujian seperti pemadanan gesaan muzik dan teks serta kredibiliti gubahan, dan secara keseluruhannya lebih tinggi sedikit daripada Google. Tahap MusicLM.

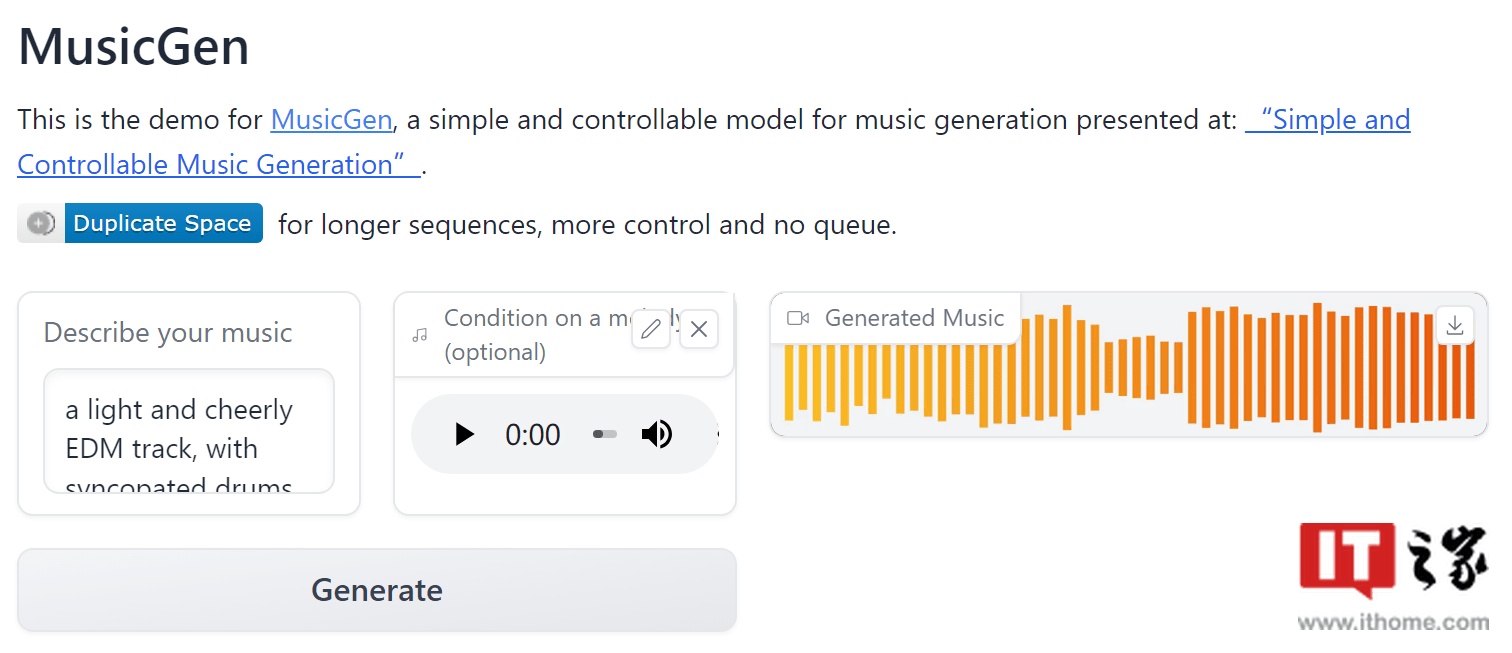

Meta telah membenarkan penggunaan komersial model ini dan telah mengeluarkan aplikasi web demo pada Huggingface.

IT House melampirkan alamat model : Klik di sini untuk pergi

Alamat permohonan demo: Klik di sini untuk pergi

Atas ialah kandungan terperinci Model bahasa AI sumber terbuka Meta MusicGen boleh menukar teks dan melodi kepada kepingan muzik yang lengkap. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!