Walaupun model bahasa berskala besar mempunyai keupayaan yang menakjubkan, disebabkan skala besarnya, kos yang diperlukan untuk penggunaannya selalunya besar. Universiti Washington, bersama-sama dengan Institut Penyelidikan Kepintaran Buatan Pengkomputeran Awan Google dan Penyelidikan Google, terus menyelesaikan masalah ini dan mencadangkan paradigma Penyulingan Langkah demi Langkah untuk membantu latihan model. Berbanding dengan LLM, kaedah ini lebih berkesan dalam melatih model kecil dan mengaplikasikannya pada tugasan tertentu, dan memerlukan kurang data latihan berbanding penalaan halus dan penyulingan tradisional. Pada tugasan penanda aras, model 770M T5 mereka mengatasi model PaLM 540B. Hebatnya, model mereka hanya menggunakan 80% daripada data yang tersedia.

Walaupun Model Bahasa Besar (LLM) telah menunjukkan pembelajaran Sedikit pukulan yang mengagumkan keupayaan, tetapi sukar untuk menggunakan model berskala besar sedemikian dalam aplikasi sebenar. Infrastruktur khusus yang menyediakan skala parameter 175 bilion LLM memerlukan sekurang-kurangnya 350GB memori GPU. Apatah lagi, LLM tercanggih hari ini terdiri daripada lebih daripada 500 bilion parameter, yang bermaksud ia memerlukan lebih banyak memori dan sumber pengkomputeran. Keperluan pengkomputeran sedemikian tidak dapat dicapai oleh kebanyakan pengeluar, apatah lagi aplikasi yang memerlukan kependaman rendah.

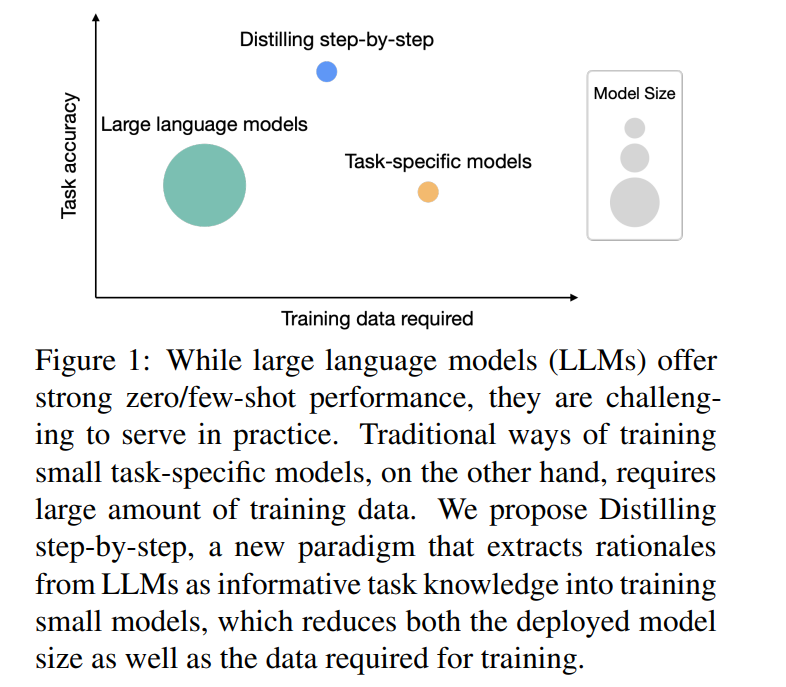

Untuk menyelesaikan masalah model besar ini, penyebar sering menggunakan model khusus yang lebih kecil. Model yang lebih kecil ini dilatih menggunakan paradigma biasa - penalaan halus atau penyulingan. Penalaan halus meningkatkan model kecil pra-latihan menggunakan data anotasi manusia hiliran. Penyulingan melatih model yang lebih kecil menggunakan label yang dihasilkan oleh LLM yang lebih besar. Malangnya, paradigma ini memerlukan kos sambil mengurangkan saiz model: untuk mencapai prestasi yang setanding dengan LLM, penalaan halus memerlukan label manusia yang mahal, manakala penyulingan memerlukan sejumlah besar data tidak berlabel yang sukar diperoleh.

Dalam kertas kerja bertajuk "Menyuling Langkah demi Langkah! Mengungguli Model Bahasa yang Lebih Besar dengan Kurang Data Latihan dan Saiz Model yang Lebih Kecil", penyelidik dari University of Washington dan Google Mekanisme mudah baharu , Penyulingan langkah demi langkah, diperkenalkan untuk melatih model yang lebih kecil menggunakan kurang data latihan. Mekanisme ini mengurangkan jumlah data latihan yang diperlukan untuk memperhalusi dan menyaring LLM, menghasilkan saiz model yang lebih kecil.

Pautan kertas: https://arxiv.org/pdf/2305.02301 v1.pdf

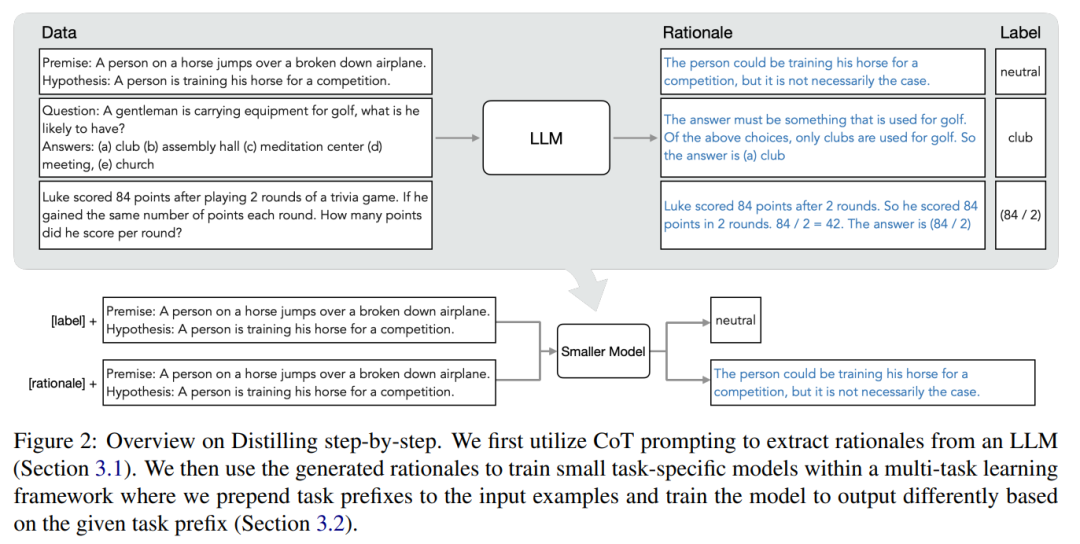

Inti mekanisme ini adalah untuk mengubah perspektif dan menganggap LLM sebagai agen yang boleh membuat alasan, bukannya sebagai sumber label bunyi. LLM boleh menjana rasional bahasa semula jadi yang boleh digunakan untuk menerangkan dan menyokong label yang diramalkan oleh model. Sebagai contoh, apabila ditanya "Seorang lelaki membawa peralatan golf, apakah yang mungkin dia miliki? (a) kelab, (b) auditorium, (c) pusat meditasi, (d) persidangan, (e) gereja" , LLM boleh menjawab "(a ) club" melalui penaakulan rantaian pemikiran (CoT), dan rasionalkan label ini dengan menjelaskan bahawa "jawapannya mestilah sesuatu yang digunakan untuk bermain golf." Daripada pilihan di atas, hanya kelab yang digunakan untuk golf. Kami menggunakan justifikasi ini sebagai maklumat tambahan yang lebih kaya untuk melatih model yang lebih kecil dalam tetapan latihan berbilang tugas dan melaksanakan ramalan label dan ramalan justifikasi.

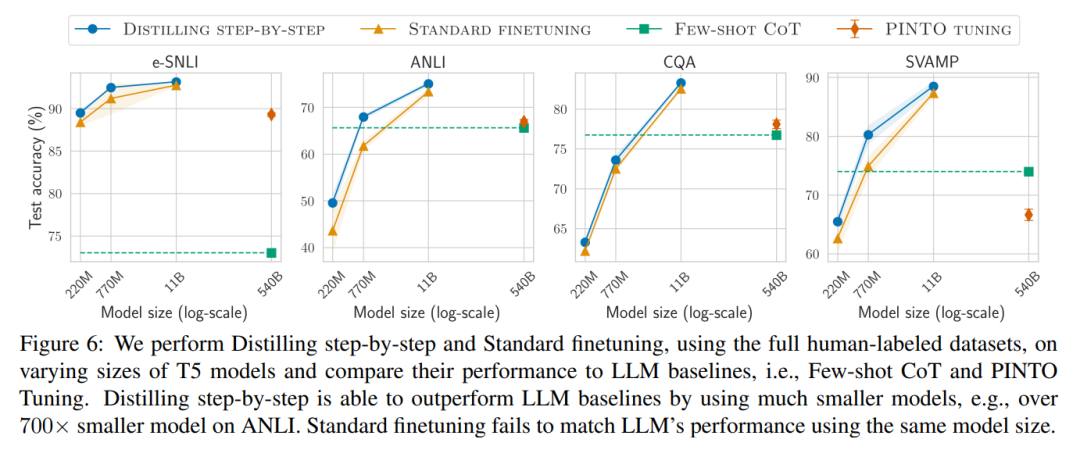

Seperti yang ditunjukkan dalam Rajah 1, penyulingan berperingkat boleh mempelajari model kecil khusus tugas dengan kurang daripada 1/500 bilangan parameter LLM. Penyulingan berperingkat juga menggunakan contoh latihan yang jauh lebih sedikit daripada penalaan halus atau penyulingan tradisional.

Keputusan eksperimen menunjukkan bahawa antara 4 penanda aras NLP, terdapat tiga eksperimen yang menjanjikan dalam kesimpulan.

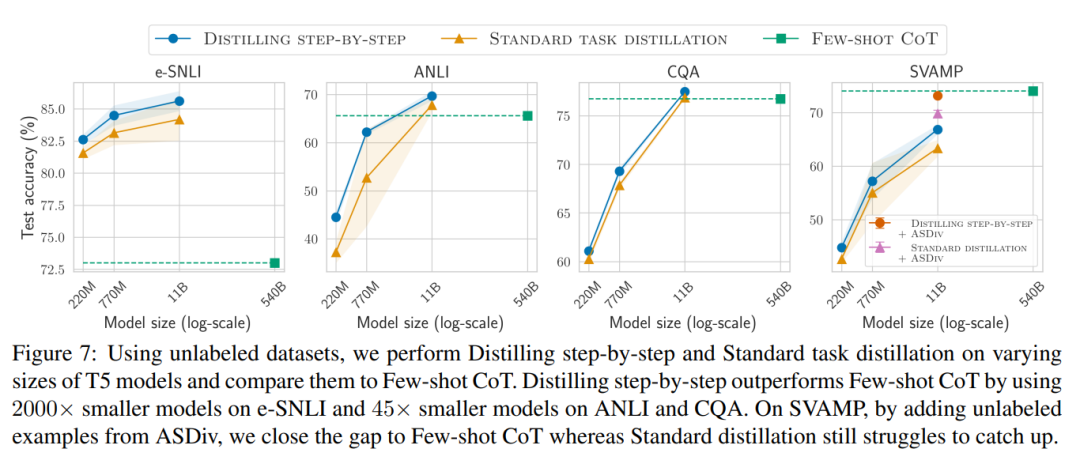

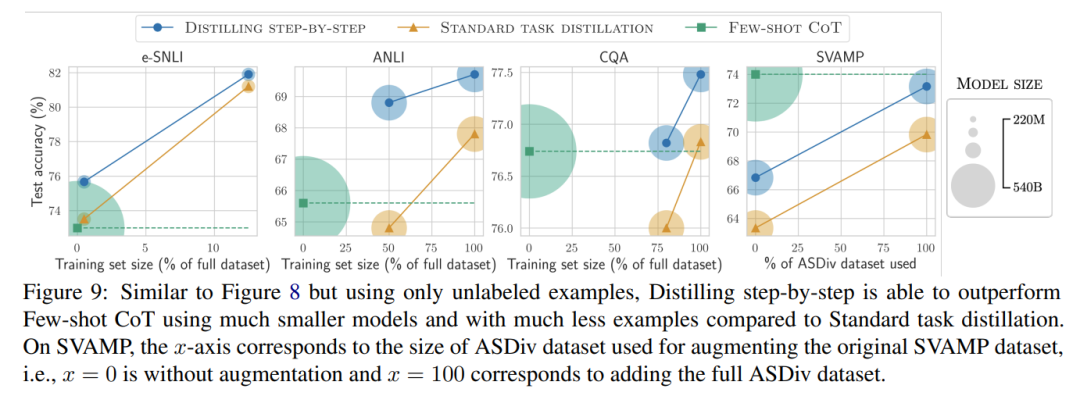

Apabila hanya terdapat data tidak berlabel, prestasi model kecil masih sama baiknya dengan LLM - hanya menggunakan model 11B T5 melebihi Prestasi PaLM sebanyak 540B telah diperbaiki.

Kajian selanjutnya menunjukkan bahawa apabila model yang lebih kecil berprestasi lebih buruk daripada LLM, penyulingan secara berperingkat boleh menggunakan data tidak berlabel tambahan dengan lebih berkesan daripada kaedah penyulingan standard. Jadikan model yang lebih kecil setanding dengan prestasi LLM.

Para penyelidik mencadangkan paradigma baharu penyulingan berperingkat, yang menggunakan keupayaan penaakulan LLM untuk ramalannya untuk melatih model yang lebih kecil dengan cara yang cekap data . Rangka kerja keseluruhan ditunjukkan dalam Rajah 2.

Paradigma mempunyai dua langkah mudah: pertama, diberi LLM dan data An tidak berlabel set menggesa LLM untuk menjana label output dan justifikasi untuk label. Rasional dijelaskan dalam bahasa semula jadi dan menyediakan sokongan untuk label yang diramalkan oleh model (lihat Rajah 2). Justifikasi ialah sifat tingkah laku yang muncul bagi LLM penyeliaan sendiri semasa.

Kemudian, sebagai tambahan kepada label tugas, gunakan sebab ini untuk melatih model hiliran yang lebih kecil. Secara terang-terangan, sebab boleh memberikan maklumat yang lebih kaya dan lebih terperinci untuk menerangkan sebab input dipetakan ke label output tertentu.

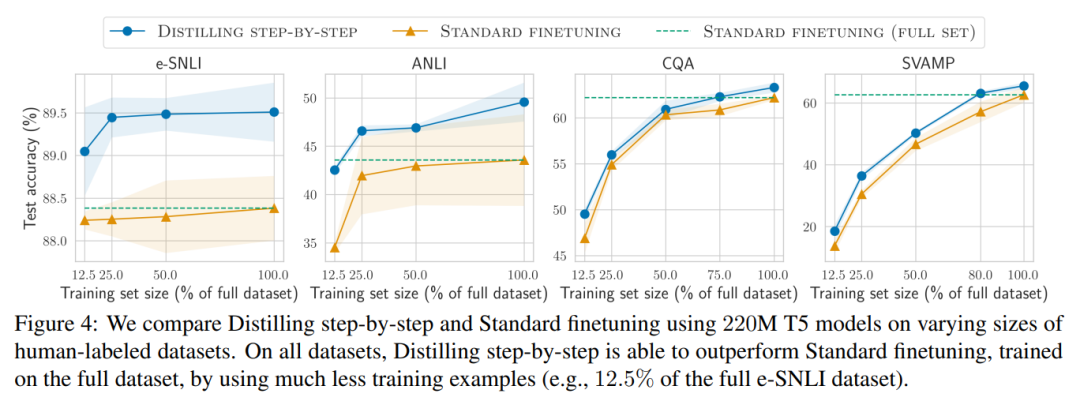

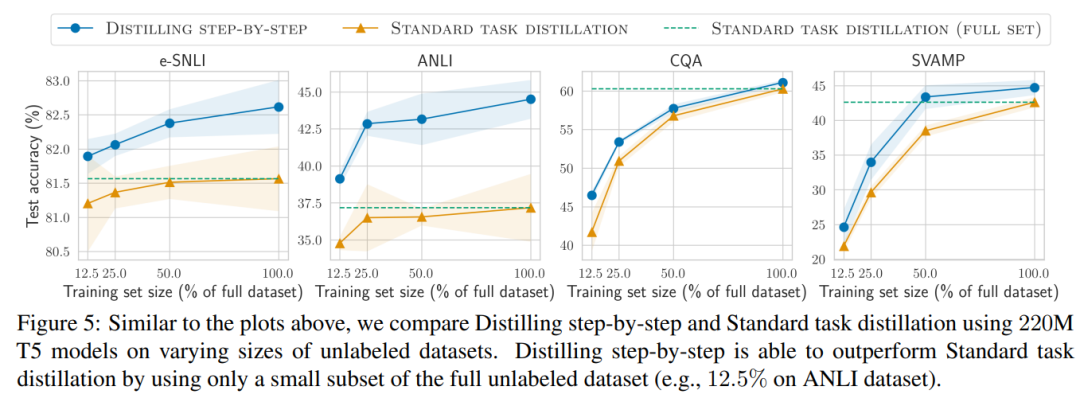

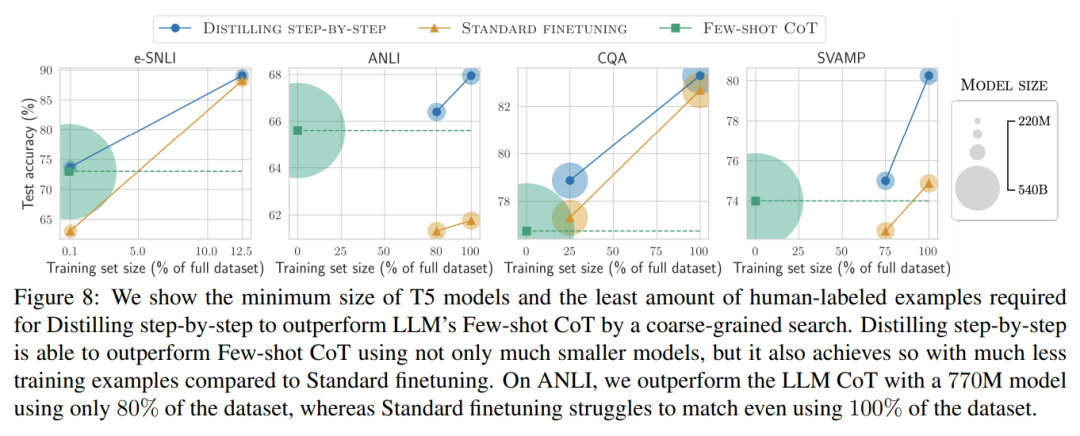

Para penyelidik mengesahkan keberkesanan penyulingan berperingkat dalam eksperimen. Pertama, berbanding kaedah penalaan halus dan penyulingan tugasan standard, penyulingan berperingkat membantu mencapai prestasi yang lebih baik dengan bilangan contoh latihan yang jauh lebih kecil, meningkatkan kecekapan data dengan ketara untuk mempelajari model khusus tugasan kecil.

Kedua, Kajian menunjukkan bahawa kaedah penyulingan berperingkat melebihi prestasi LLM dengan saiz model yang lebih kecil, dengan ketara mengurangkan kos penggunaan berbanding llm.

Akhir sekali, penyelidik menyiasat sumber minimum yang diperlukan oleh kaedah penyulingan berperingkat dari segi prestasi melebihi LLM, termasuk bilangan contoh latihan dan saiz model. Mereka menunjukkan bahawa pendekatan penyulingan berperingkat meningkatkan kecekapan data dan kecekapan penggunaan dengan menggunakan kurang data dan model yang lebih kecil.

Atas ialah kandungan terperinci Penyulingan juga boleh Langkah demi Langkah: kaedah baharu membolehkan model kecil setanding dengan model besar 2000 kali lebih besar. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Bagaimana untuk mengikat data dalam senarai lungsur

Bagaimana untuk mengikat data dalam senarai lungsur

Linux menambah kaedah sumber kemas kini

Linux menambah kaedah sumber kemas kini

Lihat maklumat sistem dalam linux

Lihat maklumat sistem dalam linux

penukaran pengekodan unicode

penukaran pengekodan unicode

Bagaimana untuk menyelesaikan masalah bahawa folder Win10 tidak boleh dipadamkan

Bagaimana untuk menyelesaikan masalah bahawa folder Win10 tidak boleh dipadamkan

Berapakah nilai satu Bitcoin dalam RMB?

Berapakah nilai satu Bitcoin dalam RMB?

Apakah jenis alat laso dalam PS?

Apakah jenis alat laso dalam PS?

Tiga kaedah pengekodan yang biasa digunakan

Tiga kaedah pengekodan yang biasa digunakan