Jun 2018

OpenAI mengeluarkan model GPT-1 dengan 110 juta parameter.

November 2018

OpenAI mengeluarkan model GPT-2 dengan 1.5 bilion parameter, tetapi disebabkan kebimbangan tentang penyalahgunaan, semua kod dan data model tidak dibuka kepada orang ramai.

Februari 2019

OpenAI membuka beberapa kod dan data model GPT-2, tetapi akses masih terhad.

10 Jun 2019

OpenAI mengeluarkan model GPT-3 dengan 175 bilion parameter dan menyediakan akses kepada beberapa rakan kongsi.

September 2019

OpenAI membuka semua kod dan data GPT-2 dan mengeluarkan versi yang lebih besar.

Mei 2020

OpenAI mengumumkan pelancaran versi beta model GPT-3, yang mempunyai 175 bilion parameter dan merupakan model pemprosesan bahasa semula jadi terbesar setakat ini.

Mac 2022

OpenAI mengeluarkan InstructGPT, menggunakan Penalaan Arahan

30 November 2022

OpenAI melepasi siri GPT-3.5 bahasa berskala besar. model AI perbualan baharu ChatGPT dikeluarkan secara rasmi selepas memperhalusi model tersebut.

15 Disember 2022

ChatGPT dikemas kini buat kali pertama, meningkatkan prestasi keseluruhan dan menambah ciri baharu untuk menyimpan dan melihat rekod perbualan sejarah.

9 Januari 2023

Kemas kini kedua ChatGPT meningkatkan ketulenan jawapan dan menambah fungsi "penjanaan henti" baharu.

21 Januari 2023

OpenAI mengeluarkan versi berbayar ChatGPT Professional yang terhad kepada sesetengah pengguna.

30 Januari 2023

Kemas kini ketiga ChatGPT bukan sahaja meningkatkan keaslian jawapan, tetapi juga meningkatkan kebolehan matematik.

2 Februari 2023

OpenAI secara rasmi melancarkan perkhidmatan langganan versi berbayar ChatGPT Berbanding dengan versi percuma, versi baharu bertindak balas dengan lebih pantas dan berjalan dengan lebih stabil.

15 Mac 2023

OpenAI secara mengejutkan melancarkan model berbilang mod berskala besar GPT-4, yang bukan sahaja boleh membaca teks, tetapi juga mengenali imej dan menjana hasil teks ChatGPT yang disambungkan terbuka kepada pengguna Plus.

Sebelum kemunculan GPT, model NLP dilatih terutamanya berdasarkan jumlah data beranotasi yang besar untuk tugasan tertentu. Ini akan membawa kepada beberapa pengehadan:

Data beranotasi berskala besar dan berkualiti tinggi tidak mudah diperolehi

Model terhad kepada latihan yang telah diterima dan mempunyai keupayaan generalisasi yang tidak mencukupi;

Tidak boleh melaksanakan pembangunan Tugas luar kotak mengehadkan aplikasi praktikal model.

Untuk mengatasi masalah ini, OpenAI memulakan laluan pra-latihan model besar. GPT-1 ialah model pra-latihan pertama yang dikeluarkan oleh OpenAI pada 2018. Ia menggunakan model Transformer sehala dan menggunakan lebih daripada 40GB data teks untuk latihan. Ciri utama GPT-1 ialah: pra-latihan generatif (tanpa diawasi) + penalaan halus tugas diskriminatif (diawasi). Pertama, kami menggunakan pra-latihan pembelajaran tanpa pengawasan dan menghabiskan 1 bulan pada 8 GPU untuk meningkatkan keupayaan bahasa sistem AI daripada sejumlah besar data tidak berlabel dan memperoleh sejumlah besar pengetahuan Kemudian kami menjalankan penalaan halus dan diselia membandingkannya dengan set data yang besar Bersepadu untuk meningkatkan prestasi sistem dalam tugasan NLP. GPT-1 menunjukkan prestasi cemerlang dalam penjanaan teks dan tugas pemahaman, menjadi salah satu model pemprosesan bahasa semula jadi yang paling maju pada masa itu.

Disebabkan kekurangan generalisasi model tugasan tunggal dan keperluan untuk sejumlah besar latihan berkesan berpasangan untuk pembelajaran berbilang tugas, GPT-2 ialah Ia telah dikembangkan dan dioptimumkan berdasarkan GPT-1, mengalih keluar pembelajaran diselia dan hanya mengekalkan pembelajaran tanpa pengawasan. GPT-2 menggunakan data teks yang lebih besar dan sumber pengkomputeran yang lebih berkuasa untuk latihan, dan saiz parameter mencapai 150 juta, jauh melebihi 110 juta parameter GPT-1. Selain menggunakan set data yang lebih besar dan model yang lebih besar untuk belajar, GPT-2 juga mencadangkan tugas baharu dan lebih sukar: pembelajaran sifar pukulan (sifar pukulan), iaitu menggunakan model pra-latihan secara langsung kepada banyak Tugas hiliran. GPT-2 telah menunjukkan prestasi cemerlang pada pelbagai tugas pemprosesan bahasa semula jadi, termasuk penjanaan teks, klasifikasi teks, pemahaman bahasa, dsb.

GPT-3 ialah yang terbaru dalam siri GPT bagi model Model yang menggunakan skala parameter yang lebih besar dan data latihan yang lebih kaya. Skala parameter GPT-3 mencapai 1.75 trilion, iaitu lebih daripada 100 kali ganda GPT-2. GPT-3 telah menunjukkan keupayaan luar biasa dalam penjanaan bahasa semula jadi, penjanaan dialog dan tugas pemprosesan bahasa lain Dalam sesetengah tugas, ia juga boleh mencipta bentuk ekspresi bahasa baharu.

GPT-3 mencadangkan konsep yang sangat penting: Pembelajaran dalam konteks Kandungan khusus akan diterangkan dalam tweet seterusnya.

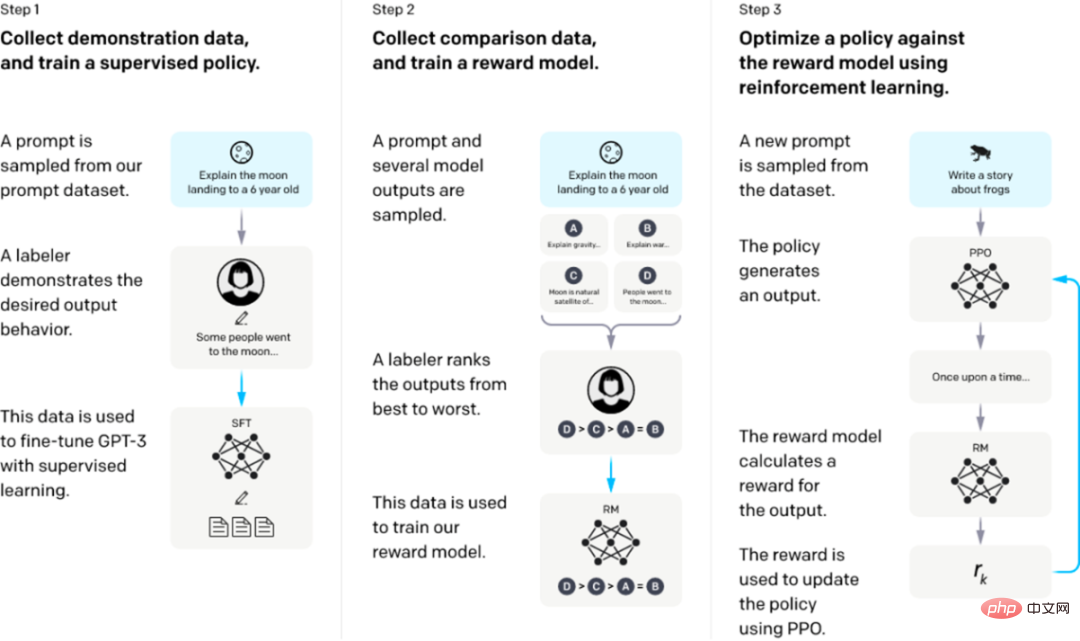

Latihan InstructGPT/ChatGPT dibahagikan kepada 3 langkah, dan data yang diperlukan untuk setiap langkah adalah berbeza sedikit .

Bermula daripada model bahasa yang telah dilatih, gunakan tiga langkah berikut.

Langkah 1: SFT penalaan halus yang diawasi: kumpulkan data demonstrasi dan latih dasar yang diawasi. Penanda kami menyediakan demonstrasi tingkah laku yang diingini pada pengedaran gesaan input. Kami kemudian menggunakan pembelajaran terselia untuk memperhalusi model GPT-3 yang telah dilatih pada data ini.

Langkah 2: Latihan Model Ganjaran. Kumpul data perbandingan dan latih model ganjaran. Kami mengumpul set data perbandingan antara output model, di mana pelabel menunjukkan output yang mereka lebih suka untuk input yang diberikan. Kami kemudian melatih model ganjaran untuk meramalkan output pilihan manusia.

Langkah 3: Pembelajaran pengukuhan melalui pengoptimuman dasar proksimal (PPO) pada model ganjaran: gunakan output RM sebagai ganjaran skalar. Kami menggunakan algoritma PPO untuk memperhalusi strategi penyeliaan untuk mengoptimumkan ganjaran ini.

Langkah 2 dan 3 boleh diulang secara berterusan; lebih banyak data perbandingan dikumpulkan pada strategi optimum semasa, yang digunakan untuk melatih RM baharu, dan kemudian strategi baharu.

Gesaan untuk dua langkah pertama datang daripada data penggunaan pengguna pada API dalam talian OpenAI dan ditulis tangan oleh anotasi yang diupah. Langkah terakhir adalah semua sampel daripada data API Data khusus InstructGPT:

1 set data SFT

Set data SFT digunakan untuk melatih langkah pertama. Model yang diselia menggunakan data baharu yang dikumpul untuk memperhalusi GPT-3 mengikut kaedah latihan GPT-3. Oleh kerana GPT-3 ialah model generatif berdasarkan pembelajaran segera, set data SFT juga merupakan sampel yang terdiri daripada pasangan balasan segera. Sebahagian daripada data SFT datang daripada pengguna OpenAI's PlayGround, dan sebahagian lagi datang daripada 40 pelabel yang digunakan oleh OpenAI. Dan mereka melatih pelabel itu. Dalam set data ini, tugas annotator adalah untuk menulis arahan sendiri berdasarkan kandungan.

2. Set data RM

Set data RM digunakan untuk melatih model ganjaran dalam langkah 2. Kita juga perlu menetapkan sasaran ganjaran untuk latihan ArahanGPT/ChatGPT. Matlamat ganjaran ini tidak semestinya boleh dibezakan, tetapi ia mesti diselaraskan secara menyeluruh dan realistik yang mungkin dengan perkara yang kita perlukan model untuk jana. Sememangnya, kami boleh memberikan ganjaran ini melalui anotasi manual Melalui gandingan buatan, kami boleh memberikan skor yang lebih rendah kepada kandungan yang dijana yang melibatkan berat sebelah untuk menggalakkan model tidak menjana kandungan yang tidak disukai manusia. Pendekatan InstructGPT/ChatGPT adalah dengan terlebih dahulu membiarkan model menjana sekumpulan teks calon, dan kemudian menggunakan pelabel untuk mengisih kandungan yang dijana mengikut kualiti data yang dijana.

3. Set data PPO

Data PPO InstructGPT tidak diberi anotasi dan ia datang daripada pengguna API GPT-3. Terdapat pelbagai jenis tugas penjanaan yang disediakan oleh pengguna yang berbeza, dengan perkadaran tertinggi termasuk tugas penjanaan (45.6%), QA (12.4%), sumbangsaran (11.2%), dialog (8.4%), dsb.

Lampiran:

Pelbagai sumber keupayaan ChatGPT:

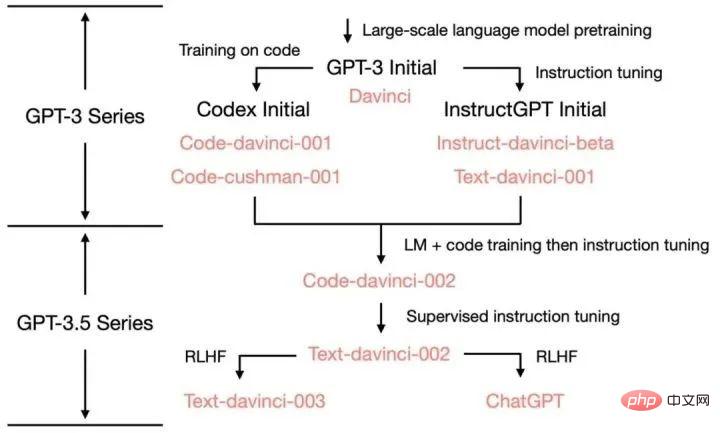

GPT -3 hingga ChatGPT dan keupayaan serta kaedah latihan versi lelaran di antara:

1. 3.5 keupayaan: https://yaofu.notion.site/GPT-3-5-360081d91ec245f29029d37b54573756

2. Garis masa paling lengkap bagi keseluruhan rangkaian! Dari masa lalu dan semasa ChatGPT kepada landskap kompetitif semasa dalam bidang AI https://www.bilibili.com/read/cv22541079

3 -Latihan, OpenAI.

4 kertas GPT-2: Model Bahasa ialah Pelajar Berbilang Tugas Tanpa Diawasi.

5.

6. Jason W, Maarten B, Vincent Y, et al adakah GPT "dilatih syaitan"? ——Tafsiran kertas InstructGPT https://cloud.tencent.com/developer/news/979148

Atas ialah kandungan terperinci SembangGPT topik satu sejarah evolusi keluarga GPT. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!