Adakah impian semua orang untuk memiliki ChatGPT menjadi kenyataan?

Sekarang, Microsoft telah membuka rangka kerja sistem sumber terbuka yang boleh menambah proses RLHF yang lengkap kepada latihan model - DeepSpeed Chat.

Dengan kata lain, model berkualiti tinggi seperti ChatGPT dari semua saiz kini berada di hujung jari anda!

Alamat projek: https://github.com/microsoft/DeepSpeed

Seperti yang kita sedia maklum, kerana OpenAI tidak Terbuka, komuniti sumber terbuka telah melancarkan LLaMa dan Alpaca untuk membolehkan lebih ramai orang untuk menggunakan model seperti ChatGPT , Vicuna, Databricks-Dolly dan model lain.

Walau bagaimanapun, disebabkan kekurangan sistem skala RLHF hujung ke hujung, latihan semasa model seperti ChatGPT masih sangat sukar. Kemunculan DeepSpeed Chat hanya menggantikan "pepijat" ini.

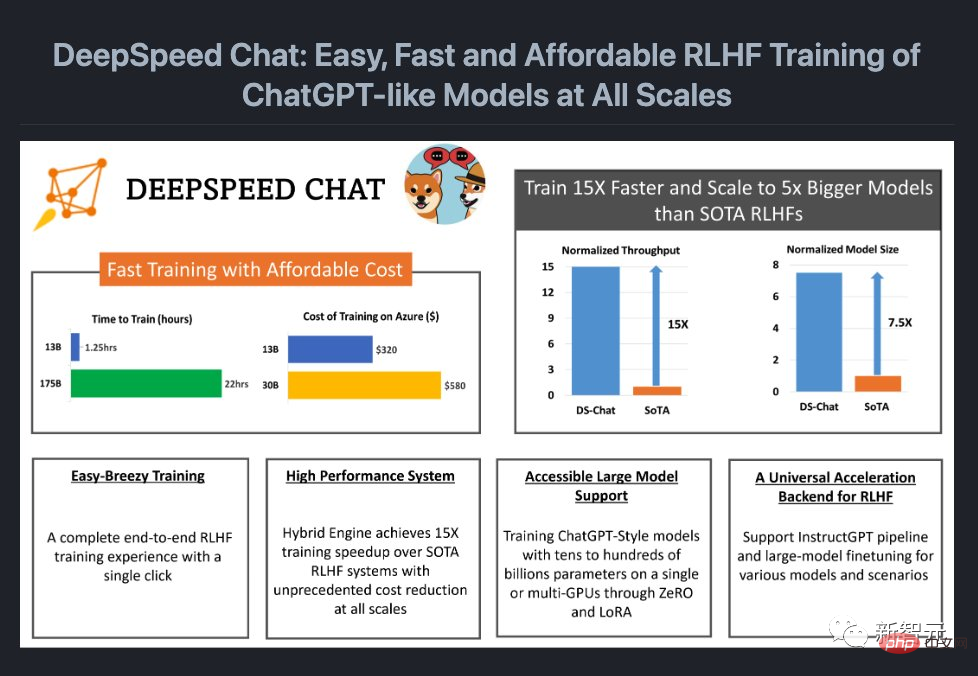

Apa yang lebih cerah ialah DeepSpeed Chat telah banyak mengurangkan kos.

Sebelum ini, persediaan berbilang GPU yang mahal adalah di luar kemampuan ramai penyelidik, malah dengan akses kepada gugusan berbilang GPU, kaedah sedia ada tidak mampu membayar ratusan bilion parameter model ChatGPT latihan.

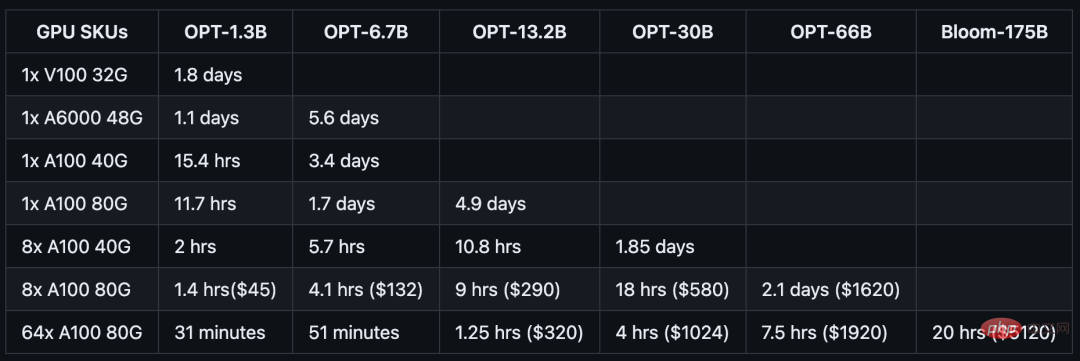

Kini, dengan hanya $1,620, anda boleh melatih model OPT-66B dalam masa 2.1 hari melalui enjin hibrid DeepSpeed-HE.

Jika anda menggunakan sistem berbilang nod, berbilang GPU, DeepSpeed-HE boleh membelanjakan 320 dolar AS untuk melatih model OPT-13B dalam masa 1.25 jam dan membelanjakan 5120 dolar AS untuk latih model OPT-13B dalam masa kurang daripada 1.25 jam Latih model OPT-175B dalam satu hari.

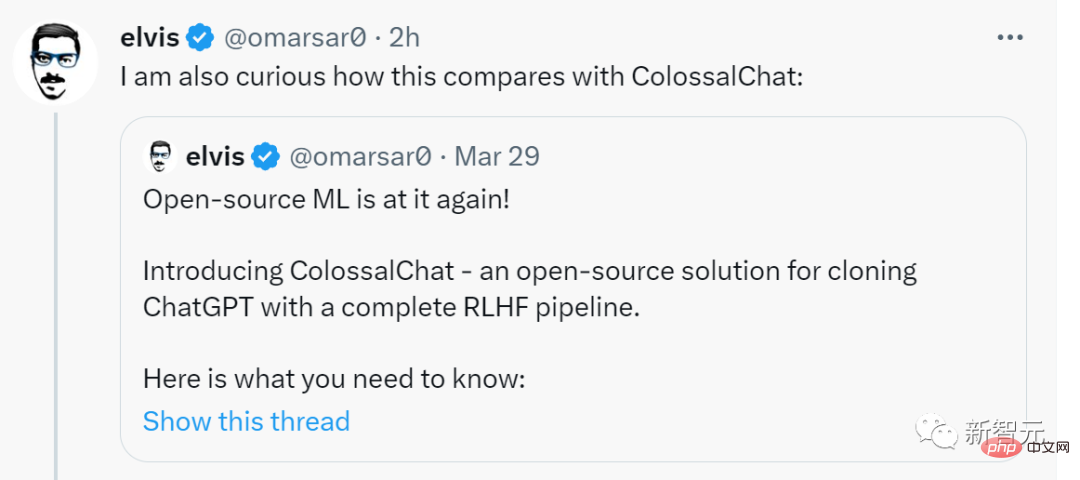

Elvis, bekas pakar Meta AI, dengan teruja memajukannya, mengatakan ini adalah masalah besar dan menyatakan rasa ingin tahu tentang bagaimana DeepSpeed Chat berbanding dengan ColossalChat.

Sekarang, mari kita lihat kesannya.

Selepas latihan dengan DeepSpeed-Chat, versi 1.3 bilion parameter "ChatGPT" menunjukkan prestasi yang sangat baik dalam sesi soal jawab. Anda bukan sahaja boleh mendapatkan konteks soalan, tetapi jawapan yang diberikan juga relevan.

Dalam berbilang pusingan perbualan, prestasi yang ditunjukkan oleh versi 1.3 bilion parameter "ChatGPT" ini benar-benar melebihi tanggapan yang wujud pada skala ini.

Sudah tentu, sebelum anda mengalaminya, anda perlu mengkonfigurasi persekitaran :

git clone https://github.com/microsoft/DeepSpeed.git cd DeepSpeed pip install . git clone https://github.com/microsoft/DeepSpeedExamples.git cd DeepSpeedExamples/applications/DeepSpeed-Chat/ pip install -r requirements.txt

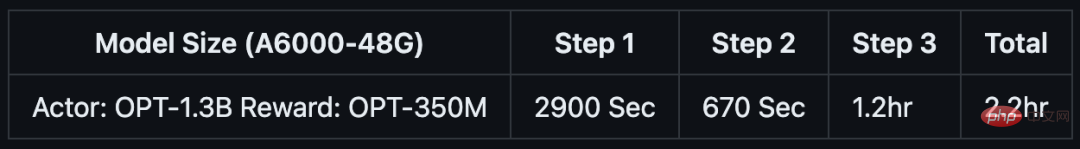

Jika anda hanya mempunyai 1-2 jam minum kopi atau rehat tengah hari Jika anda mempunyai masa, anda juga boleh cuba menggunakan DeepSpeed-Chat untuk melatih "mainan kecil".

Pasukan telah menyediakan contoh latihan khas untuk model 1.3B, yang boleh diuji pada GPU gred pengguna. The best part is, bila balik dari lunch break, semua dah siap.

python train.py --actor-model facebook/opt-1.3b --reward-model facebook/opt-350m --num-gpus 1

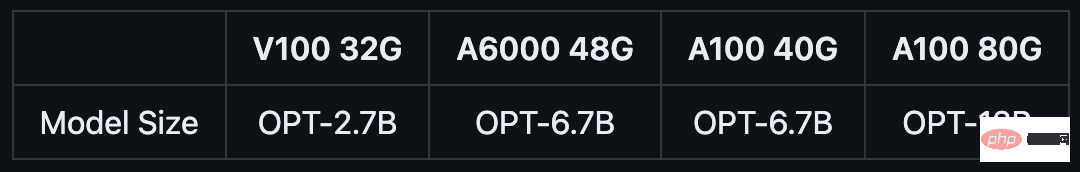

GPU NVIDIA A6000 gred pengguna dengan memori video 48GB:

如果你只有半天的时间,以及一台服务器节点,则可以通过预训练的OPT-13B作为actor模型,OPT-350M作为reward模型,来生成一个130亿参数的类ChatGPT模型:

python train.py --actor-model facebook/opt-13b --reward-model facebook/opt-350m --num-gpus 8

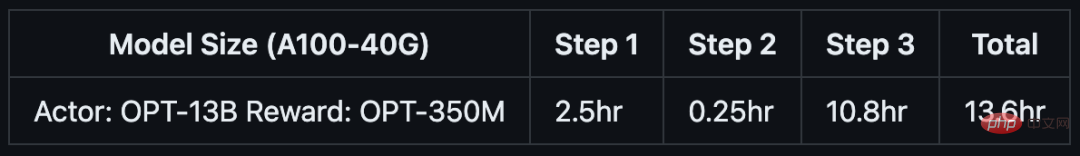

单DGX节点,搭载了8个NVIDIA A100-40G GPU:

如果你可以使用多节点集群或云资源,并希望训练一个更大、更高质量的模型。那么只需基于下面这行代码,输入你想要的模型大小(如66B)和GPU数量(如64):

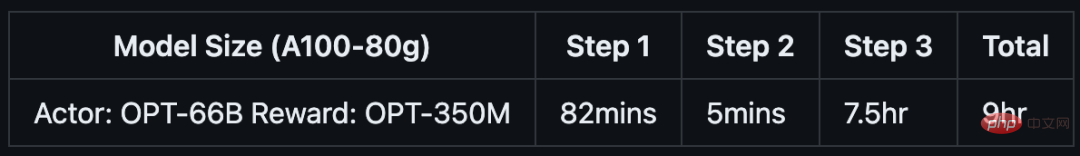

python train.py --actor-model facebook/opt-66b --reward-model facebook/opt-350m --num-gpus 64

8个DGX节点,每个节点配备8个NVIDIA A100-80G GPU:

具体来说,针对不同规模的模型和硬件配置,DeepSpeed-RLHF系统所需的时间和成本如下:

DeepSpeed Chat是一种通用系统框架,能够实现类似ChatGPT模型的端到端RLHF训练,从而帮助我们生成自己的高质量类ChatGPT模型。

DeepSpeed Chat具有以下三大核心功能:

1. 简化ChatGPT类型模型的训练和强化推理体验

开发者只需一个脚本,就能实现多个训练步骤,并且在完成后还可以利用推理API进行对话式交互测试。

2. DeepSpeed-RLHF模块

DeepSpeed-RLHF复刻了InstructGPT论文中的训练模式,并提供了数据抽象和混合功能,支持开发者使用多个不同来源的数据源进行训练。

3. DeepSpeed-RLHF系统

团队将DeepSpeed的训练(training engine)和推理能力(inference engine) 整合成了一个统一的混合引擎(DeepSpeed Hybrid Engine or DeepSpeed-HE)中,用于RLHF训练。由于,DeepSpeed-HE能够无缝地在推理和训练模式之间切换,因此可以利用来自DeepSpeed-Inference的各种优化。

DeepSpeed-RLHF系统在大规模训练中具有无与伦比的效率,使复杂的RLHF训练变得快速、经济并且易于大规模推广:

DeepSpeed-HE比现有系统快15倍以上,使RLHF训练快速且经济实惠。

例如,DeepSpeed-HE在Azure云上只需9小时即可训练一个OPT-13B模型,只需18小时即可训练一个OPT-30B模型。这两种训练分别花费不到300美元和600美元。

DeepSpeed-HE boleh menyokong model latihan dengan ratusan bilion parameter dan menjalankannya pada multi-nod multi-GPU sistem Menunjukkan kebolehskalaan yang sangat baik.

Oleh itu, model dengan 13 bilion parameter pun boleh dilatih dalam masa 1.25 jam sahaja. Untuk model dengan 175 bilion parameter, latihan menggunakan DeepSpeed-HE hanya mengambil masa kurang dari sehari.

Hanya satu GPU, DeepSpeed-HE boleh menyokong latihan untuk lebih daripada A model dengan 13 bilion parameter. Ini membolehkan saintis data dan penyelidik yang tidak mempunyai akses kepada sistem berbilang GPU dengan mudah mencipta bukan sahaja model RLHF yang ringan, tetapi juga model yang besar dan berkuasa untuk menghadapi senario penggunaan yang berbeza.

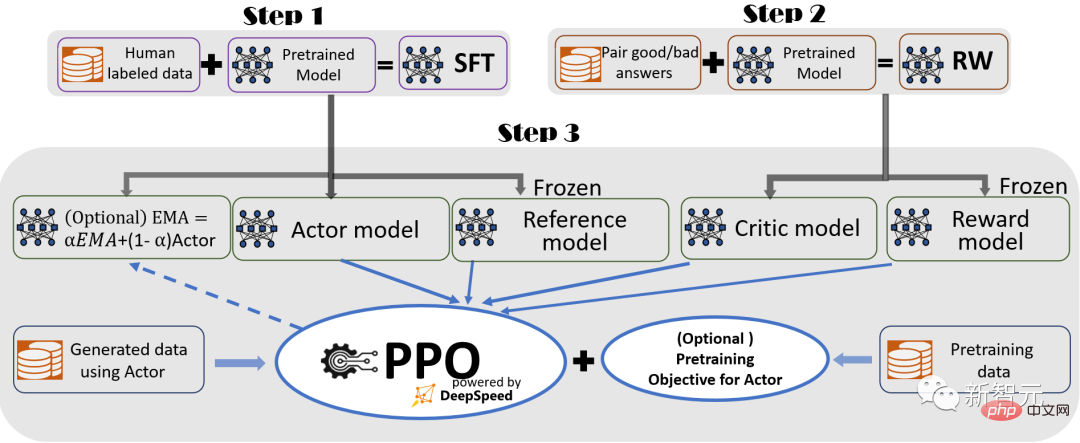

Untuk memberikan pengalaman latihan yang lancar, para penyelidik mengikuti InstructGPT dan menggunakannya dalam DeepSpeed- Sembang Ia mengandungi proses latihan hujung ke hujung yang lengkap.

Ilustrasi proses latihan RLHF DeepSpeed-Chat, termasuk beberapa fungsi pilihan

Proses ini terdiri daripada tiga langkah utama:

Penalaan Halus Terselia (SFT), menggunakan jawapan Pilih manusia untuk memperhalusi model bahasa pra-latihan untuk menjawab pelbagai pertanyaan.

Penalaan halus model ganjaran, dilatih dengan set data yang mengandungi penilaian manusia bagi berbilang jawapan untuk pertanyaan yang sama An independent ( biasanya lebih kecil daripada model ganjaran (RW) SFT.

Latihan RLHF Dalam langkah ini, model SFT dilatih daripada model RW dengan menggunakan anggaran pengoptimuman dasar (. Algoritma PPO) Maklum balas ganjaran diperhalusi lagi.

Dalam langkah 3, penyelidik juga menyediakan dua fungsi tambahan untuk membantu meningkatkan kualiti model:

- Purata Pergerakan Eksponen (EMA ) koleksi, anda boleh memilih pusat pemeriksaan berasaskan EMA untuk penilaian akhir.

- Latihan hibrid, mencampurkan objektif pra-latihan (iaitu ramalan perkataan seterusnya) dengan objektif PPO untuk mengelakkan regresi prestasi pada penanda aras awam (seperti SQuAD2.0).

Latihan EMA dan hibrid ialah dua ciri latihan yang sering diabaikan oleh rangka kerja sumber terbuka lain kerana ia tidak menghalang latihan.

Walau bagaimanapun, menurut InstructGPT, pusat pemeriksaan EMA cenderung untuk memberikan kualiti tindak balas yang lebih baik daripada model latihan akhir tradisional, dan latihan hibrid boleh membantu model mengekalkan keupayaan penyelesaian garis dasar pra-latihan.

Oleh itu, penyelidik menyediakan fungsi ini untuk pengguna supaya mereka boleh mendapatkan sepenuhnya pengalaman latihan yang diterangkan dalam InstructGPT.

Selain sangat konsisten dengan kertas InstructGPT, penyelidik juga menyediakan fungsi yang membolehkan pembangun menggunakan pelbagai sumber data untuk melatih model RLHF mereka sendiri:

DeepSpeed-Chat dilengkapi dengan (1) lapisan set data abstrak untuk menyatukan format set data yang berbeza dan (2) data membelah kefungsian Split/Blend, yang mana berbilang set data digabungkan dengan sewajarnya dan kemudian berpecah dalam 3 peringkat latihan.

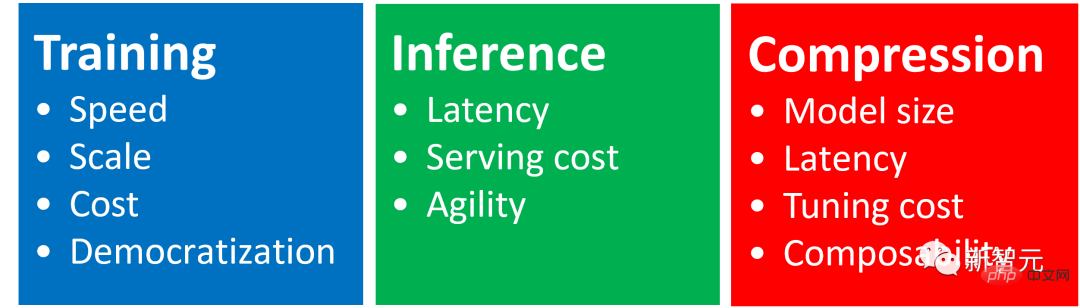

Menunjukkan langkah 1 dan 2 saluran paip RLHF berpandu, serupa dengan penalaan halus konvensional model besar, yang dipacu oleh pengoptimuman berasaskan ZeRO dan keselarian fleksibel dalam Latihan DeepSpeed Gabungan strategi untuk mencapai skala dan kelajuan.

Dan langkah 3 saluran paip adalah bahagian paling kompleks dari segi impak prestasi.

Setiap lelaran perlu mengendalikan dua peringkat dengan berkesan: a) peringkat inferens, digunakan untuk penjanaan token/pengalaman, untuk menjana input latihan b) peringkat latihan, pengemaskinian pelakon dan pemberat model ganjaran, serta interaksi dan penjadualan antara mereka.

Ia memperkenalkan dua kesukaran utama: (1) kos memori, kerana berbilang model SFT dan RW perlu dijalankan sepanjang peringkat ketiga (2) kelajuan peringkat penjanaan jawapan Lebih perlahan, jika tidak dipercepatkan dengan betul, akan melambatkan keseluruhan peringkat ketiga dengan ketara.

Selain itu, dua fungsi penting yang ditambah oleh penyelidik pada peringkat ketiga - pengumpulan purata bergerak eksponen (EMA) dan latihan hibrid, akan menanggung kos ingatan dan latihan tambahan.

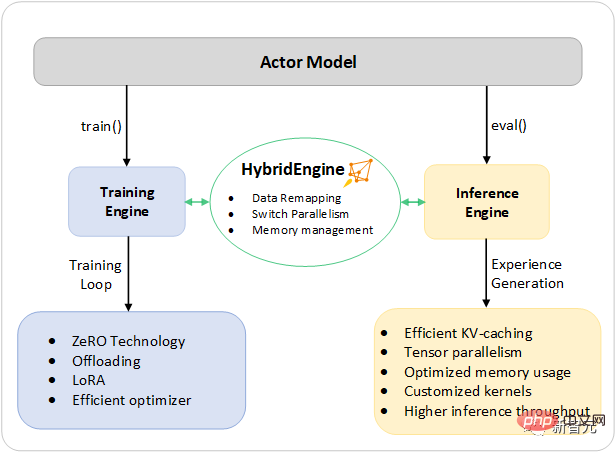

Untuk menangani cabaran ini, penyelidik telah menggabungkan semua keupayaan sistem latihan DeepSpeed dan inferens ke dalam infrastruktur bersatu, iaitu Enjin Hibrid.

Ia menggunakan enjin DeepSpeed asli untuk mod latihan pantas, sambil dengan mudah menggunakan enjin inferens DeepSpeed untuk mod penjanaan/penilaian, memberikan penyelesaian yang lebih baik untuk peringkat ketiga RLHF sistem latihan yang cepat.

Seperti yang ditunjukkan dalam rajah di bawah, peralihan antara latihan DeepSpeed dan enjin inferens adalah lancar: dengan mendayakan mod eval dan tren tipikal untuk model pelakon, semasa menjalankan inferens dan proses latihan , DeepSpeed telah memilih pengoptimuman yang berbeza untuk menjalankan model dengan lebih pantas dan meningkatkan daya pemprosesan keseluruhan sistem.

DeepSpeed hibrid reka bentuk enjin untuk mempercepatkan bahagian yang paling memakan masa dalam proses RLHF

Semasa proses pelaksanaan inferens fasa penjanaan pengalaman latihan RLHF, enjin DeepSpeed hibrid menggunakan sistem pengurusan memori yang ringan untuk mengendalikan cache KV dan keputusan pertengahan, sambil menggunakan teras dan tensor CUDA inferens yang sangat optimum. pengkomputeran selari , berbanding dengan penyelesaian sedia ada, daya pemprosesan (bilangan token sesaat) telah dipertingkatkan dengan banyak.

Semasa latihan, enjin hibrid membolehkan teknologi pengoptimuman memori seperti siri teknologi ZeRO DeepSpeed dan Penyesuaian Pesanan Rendah (LoRA).

Cara penyelidik mereka bentuk dan melaksanakan pengoptimuman sistem ini adalah untuk menjadikannya serasi antara satu sama lain dan boleh digabungkan bersama untuk memberikan kecekapan latihan tertinggi di bawah enjin hibrid bersatu.

Enjin hibrid boleh menukar pembahagian model dengan lancar semasa latihan dan inferens untuk menyokong inferens berasaskan selari tensor dan mekanisme pembahagian latihan berasaskan ZeRO.

Ia juga boleh mengkonfigurasi semula sistem memori untuk memaksimumkan ketersediaan memori dalam setiap mod.

Ini mengelakkan kesesakan peruntukan memori dan boleh menyokong saiz kelompok besar, meningkatkan prestasi dengan sangat baik.

Ringkasnya, Enjin Hibrid menolak sempadan latihan RLHF moden, memberikan skala dan kecekapan sistem yang tiada tandingan untuk beban kerja RLHF.

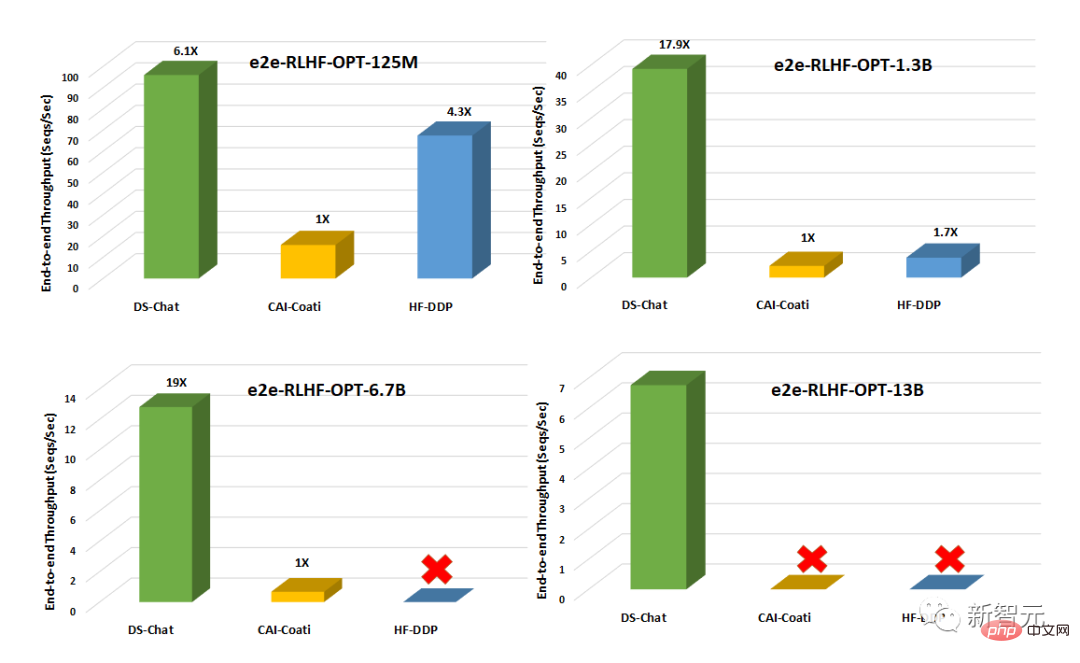

Berbanding dengan sistem sedia ada seperti Colossal-AI atau HuggingFace-DDP, DeepSpeed -Sembang mempunyai lebih daripada susunan magnitud pemprosesan, membolehkan melatih model pelakon yang lebih besar pada bajet kependaman yang sama atau melatih model bersaiz serupa pada kos yang lebih rendah.

Contohnya, DeepSpeed meningkatkan daya pemprosesan latihan RLHF lebih daripada 10 kali ganda pada satu GPU. Walaupun kedua-dua CAI-Coati dan HF-DDP boleh menjalankan model 1.3B, DeepSpeed boleh menjalankan model 6.5B pada perkakasan yang sama, iaitu secara langsung 5 kali lebih tinggi.

Pada berbilang GPU pada satu nod, DeepSpeed-Chat adalah 6-19 kali lebih pantas daripada CAI-Coati dari segi pemprosesan sistem, HF- DDP dipercepatkan sebanyak 1.4-10.5 kali. Pasukan itu menyatakan bahawa salah satu sebab utama DeepSpeed-Chat boleh mencapai keputusan yang sangat baik adalah pecutan yang disediakan oleh enjin hibrid semasa fasa penjanaan.

Atas ialah kandungan terperinci Semua orang ada ChatGPT! Microsoft DeepSpeed Chat dikeluarkan secara mengejutkan, satu klik RLHF melatih ratusan bilion model besar. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Penyelesaian kepada sambungan gagal antara wsus dan pelayan Microsoft

Penyelesaian kepada sambungan gagal antara wsus dan pelayan Microsoft Apakah perbezaan antara firewall perkakasan dan firewall perisian

Apakah perbezaan antara firewall perkakasan dan firewall perisian Kaedah pembundaran Java

Kaedah pembundaran Java Apa itu Ethereum

Apa itu Ethereum penyahpepijatan node.js

penyahpepijatan node.js Apakah kaedah analisis data?

Apakah kaedah analisis data? Bagaimana untuk menangani lag komputer yang perlahan dan tindak balas yang perlahan

Bagaimana untuk menangani lag komputer yang perlahan dan tindak balas yang perlahan 10 Aplikasi Dagangan Matawang Kripto Teratas

10 Aplikasi Dagangan Matawang Kripto Teratas