Model generatif berskala besar telah membawa penemuan besar kepada pemprosesan bahasa semula jadi dan juga penglihatan komputer dalam dua tahun yang lalu. Baru-baru ini, trend ini turut menjejaskan pembelajaran pengukuhan, terutamanya pembelajaran peneguhan luar talian (RL luar talian), seperti Decision Transformer (DT)[1], Trajectory Transformer (TT)[2], Gato[3], Diffuser[4], dsb. Kaedah ini menganggap data pembelajaran pengukuhan (termasuk status, tindakan, ganjaran dan kembali untuk pergi) sebagai rentetan data jujukan yang dimusnahkan, dan memodelkan data jujukan ini sebagai tugas teras pembelajaran. Model ini boleh dilatih menggunakan kaedah pembelajaran diselia atau diselia sendiri, mengelakkan isyarat kecerunan yang tidak stabil dalam pembelajaran tetulang tradisional. Walaupun menggunakan kaedah penambahbaikan dasar dan anggaran nilai yang kompleks, mereka menunjukkan prestasi yang sangat baik dalam pembelajaran peneguhan luar talian.

Artikel ini akan membincangkan secara ringkas tentang kaedah pembelajaran pengukuhan ini berdasarkan pemodelan jujukan Dalam artikel seterusnya, penulis akan memperkenalkan Perancang Pengekodan Trajektori (TAP) yang baru dicadangkan, yang menggunakan Vector Quantised. Variational AutoEncoder (VQ-VAE) ialah kaedah untuk pemodelan jujukan dan perancangan yang cekap dalam ruang tindakan terpendam.

Senibina Transformer [5] telah dicadangkan pada tahun 2017 dan perlahan-lahan mencetuskan revolusi dalam pemprosesan bahasa semula jadi BERT dan GPT-3 seterusnya secara beransur-ansur Gabungan penyeliaan kendiri + Transformer terus didorong ke tahap baharu Sementara sifat seperti pembelajaran beberapa pukulan terus muncul dalam bidang pemprosesan bahasa semula jadi, ia juga mula merebak ke bidang seperti penglihatan komputer [6][]. 7 ].

Walau bagaimanapun, untuk pembelajaran pengukuhan, proses ini nampaknya tidak begitu ketara sebelum 2021. Pada tahun 2018, mekanisme perhatian pelbagai kepala juga diperkenalkan ke dalam pembelajaran pengukuhan [8]. Percubaan sedemikian telah hangat sejak itu. Mengikut pengalaman peribadi penulis, Transformer sebenarnya tidak menunjukkan kelebihan yang stabil dan luar biasa dalam pembelajaran pengukuhan, dan ia juga sukar untuk dilatih. Dalam salah satu kerja kami menggunakan Relational GCN untuk pembelajaran pengukuhan dalam 20 tahun [9], kami sebenarnya telah mencuba Transformer di sebalik tabir, tetapi ia pada asasnya jauh lebih teruk daripada struktur tradisional (serupa dengan CNN), dan sukar untuk melatih secara stabil dan mendapatkan satu polisi yang boleh digunakan. Mengapa Transformer tidak serasi dengan pembelajaran pengukuhan dalam talian tradisional (RL dalam talian) masih menjadi persoalan terbuka Sebagai contoh, Melo [10] menjelaskan bahawa ia adalah kerana parameter inisialisasi Transformer tradisional tidak sesuai untuk pembelajaran pengukuhan, jadi saya tidak akan membincangkan. ia lebih jauh di sini.

Pada pertengahan 2021, keluaran Decision Transformer (DT) dan Trajectory Transformer (TT) mencetuskan gelombang baharu aplikasi Transformer dalam RL. Idea kedua-dua karya ini sebenarnya sangat mudah: Jika Transformer dan algoritma pembelajaran tetulang dalam talian tidak begitu serasi, bagaimana pula dengan hanya menganggap pembelajaran tetulang sebagai tugas pembelajaran yang diselia sendiri? Mengambil kesempatan daripada fakta bahawa konsep pembelajaran pengukuhan luar talian juga sangat popular, kedua-dua kerja ini telah mengunci tugas sasaran utama mereka ke dalam pemodelan set data luar talian, dan kemudian menggunakan model jujukan ini untuk kawalan dan membuat keputusan.

Untuk pembelajaran pengukuhan, urutan yang dipanggil terdiri daripada keadaan s , tindakan  , ganjaran r dan nilai ( nilai) v Trajektori yang terdiri daripada

, ganjaran r dan nilai ( nilai) v Trajektori yang terdiri daripada  . Nilai pada masa ini biasanya digantikan dengan return-to-go, yang boleh dianggap sebagai anggaran Monte Carlo. Set data luar talian terdiri daripada trajektori ini. Penjanaan trajektori adalah berkaitan dengan model dinamik persekitaran (dinamik) dan dasar tingkah laku (dasar tingkah laku)

. Nilai pada masa ini biasanya digantikan dengan return-to-go, yang boleh dianggap sebagai anggaran Monte Carlo. Set data luar talian terdiri daripada trajektori ini. Penjanaan trajektori adalah berkaitan dengan model dinamik persekitaran (dinamik) dan dasar tingkah laku (dasar tingkah laku)  . Pemodelan jujukan yang dipanggil adalah untuk memodelkan taburan kebarangkalian (taburan) yang menjana jujukan ini, atau secara tegasnya, beberapa kebarangkalian bersyarat.

. Pemodelan jujukan yang dipanggil adalah untuk memodelkan taburan kebarangkalian (taburan) yang menjana jujukan ini, atau secara tegasnya, beberapa kebarangkalian bersyarat.

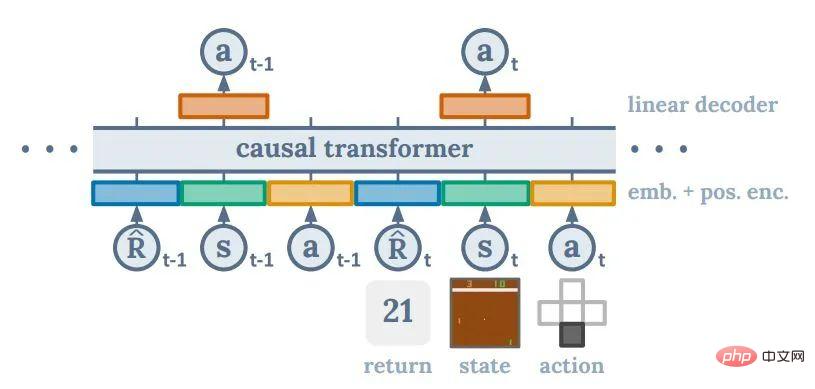

Pendekatan DT adalah untuk memodelkan pemetaan daripada data dan nilai masa lalu kepada tindakan (dasar bersyarat kembali), iaitu memodelkan jangkaan matematik kebarangkalian bersyarat sesuatu tindakan.  . Idea ini hampir sama dengan Upside Down RL [11], tetapi kemungkinan besar motivasi langsung di sebaliknya adalah untuk meniru kaedah GPT2/3 untuk menyelesaikan tugas hiliran berdasarkan gesaan. Satu masalah dengan pendekatan ini ialah tiada cara sistematik untuk menentukan nilai sasaran terbaik. Walau bagaimanapun, pengarang DT mendapati bahawa walaupun nilai sasaran ditetapkan kepada pulangan tertinggi dalam keseluruhan set data, prestasi akhir DT boleh menjadi sangat baik.

. Idea ini hampir sama dengan Upside Down RL [11], tetapi kemungkinan besar motivasi langsung di sebaliknya adalah untuk meniru kaedah GPT2/3 untuk menyelesaikan tugas hiliran berdasarkan gesaan. Satu masalah dengan pendekatan ini ialah tiada cara sistematik untuk menentukan nilai sasaran terbaik. Walau bagaimanapun, pengarang DT mendapati bahawa walaupun nilai sasaran ditetapkan kepada pulangan tertinggi dalam keseluruhan set data, prestasi akhir DT boleh menjadi sangat baik.

Bagi mereka yang mempunyai latar belakang pembelajaran pengukuhan Secara manusiawi, adalah sangat intuitif bahawa kaedah seperti DT boleh mencapai prestasi yang kukuh. Jika kaedah seperti DQN dan Kecerunan Dasar hanya boleh menganggap rangkaian saraf sebagai fungsi yang sesuai yang boleh digunakan untuk interpolasi dan generalisasi, penambahbaikan dan penilaian dasar dalam pembelajaran pengukuhan masih menjadi teras pembinaan dasar. DT boleh dikatakan sepenuhnya berdasarkan rangkaian saraf Keseluruhan proses di sebalik cara ia menghubungkan nilai sasaran yang berpotensi tidak realistik kepada tindakan yang sesuai adalah kotak hitam sepenuhnya. Kejayaan DT boleh dikatakan agak tidak munasabah dari sudut pembelajaran pengukuhan, tetapi saya fikir ini adalah daya tarikan penyelidikan empirikal seperti ini. Penulis percaya bahawa keupayaan generalisasi rangkaian saraf, atau Transformers, mungkin melebihi jangkaan sebelumnya bagi seluruh komuniti RL.

DT juga sangat mudah antara semua kaedah pemodelan jujukan, dan hampir semua masalah teras pembelajaran tetulang diselesaikan di dalam Transformer. Kesederhanaan ini adalah salah satu sebab mengapa ia kini paling popular. Walau bagaimanapun, sifat kotak hitamnya juga menyebabkan kita kehilangan banyak cengkaman pada tahap reka bentuk algoritma, dan beberapa pencapaian dalam pembelajaran pengukuhan tradisional sukar untuk digabungkan ke dalamnya. Keberkesanan keputusan ini telah berulang kali disahkan dalam beberapa eksperimen berskala sangat besar (seperti AlphaGo, AlphaStar, VPT).

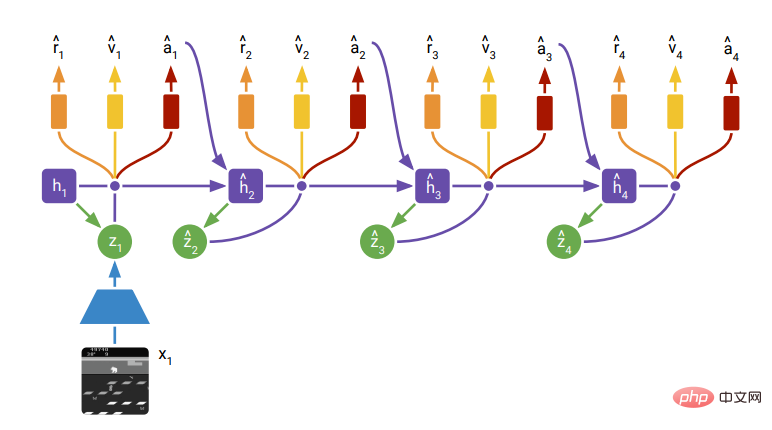

Pengubah Trajektori

tolak kembali-untuk-pergi. Kerana ia memodelkan pengedaran jujukan seterusnya, TT sebenarnya menjadi model penjanaan jujukan. Dengan mencari jujukan dengan anggaran nilai yang lebih baik dalam jujukan yang dijana, TT boleh mengeluarkan "pelan optimum". Bagi kaedah mencari jujukan optimum, TT menggunakan kaedah yang biasa digunakan dalam bahasa semula jadi: varian carian pancaran. Pada asasnya, ia adalah untuk sentiasa mengekalkan bahagian jujukan yang optimum  dalam jujukan yang dikembangkan, dan kemudian mencari set jujukan optimum seterusnya

dalam jujukan yang dikembangkan, dan kemudian mencari set jujukan optimum seterusnya  berdasarkannya.

berdasarkannya.

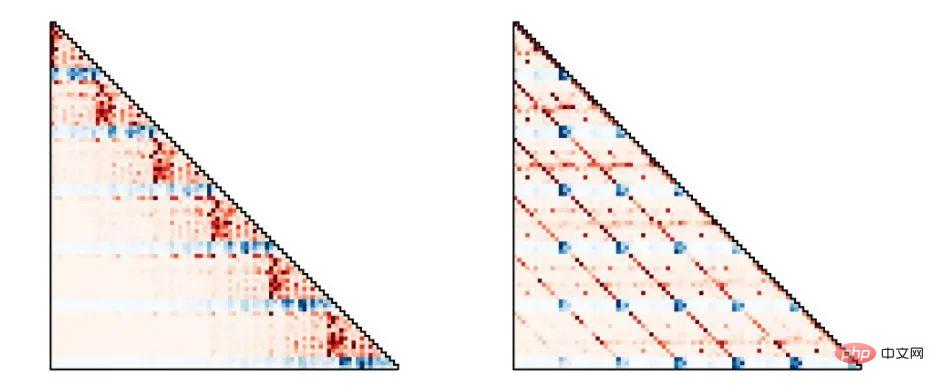

Dari perspektif pembelajaran pengukuhan, TT bukanlah tidak lazim seperti DT. Apa yang menarik tentangnya ialah (seperti DT) ia meninggalkan sepenuhnya struktur graf sebab Proses Keputusan Markov asal dalam pembelajaran pengukuhan. Kaedah berasaskan model sebelumnya, seperti PETS, model dunia, dramerv2, dsb., semuanya mengikut takrifan fungsi dasar, fungsi pemindahan, fungsi ganjaran, dsb. dalam proses Markov (atau Markov tersirat), iaitu syarat pengedaran keadaan ialah Keadaan langkah sebelumnya, dan tindakan, ganjaran dan nilai semuanya ditentukan oleh keadaan semasa. Seluruh komuniti pembelajaran pengukuhan secara amnya percaya bahawa ini boleh meningkatkan kecekapan sampel, tetapi struktur graf sedemikian sebenarnya mungkin menjadi kekangan. Peralihan dari RNN ke Transformer dalam bidang bahasa semula jadi dan dari CNN ke Transformer dalam bidang penglihatan komputer sebenarnya mencerminkan bahawa apabila data meningkat, membiarkan rangkaian mempelajari struktur graf dengan sendirinya adalah lebih kondusif untuk mendapatkan model yang berprestasi lebih baik.

DreamerV2, Rajah 3Memandangkan TT pada dasarnya menyerahkan semua tugas ramalan jujukan Tanpa Transformer, Transformer boleh mempelajari struktur graf yang lebih baik daripada data dengan lebih fleksibel. Seperti yang ditunjukkan dalam rajah di bawah, strategi tingkah laku yang dimodelkan oleh TT menunjukkan struktur graf yang berbeza mengikut tugasan dan set data yang berbeza. Bahagian kiri angka sepadan dengan strategi Markov tradisional, dan bahagian kanan angka sepadan dengan strategi purata bergerak tindakan.

Trajektori Transformer, Rajah 4

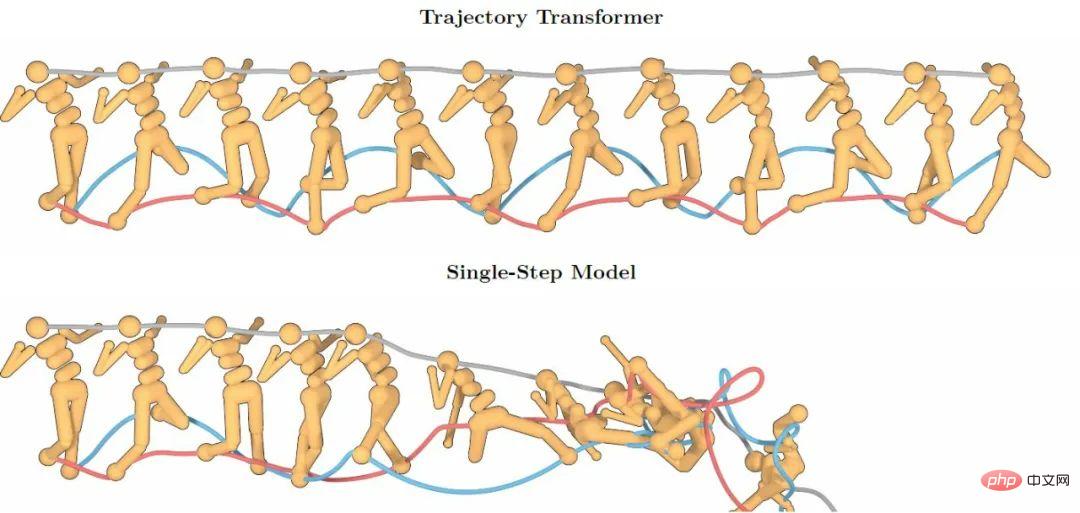

Transformer Pemodelan jujukan yang berkuasa Keupayaan membawa ketepatan pemodelan jujukan panjang yang lebih tinggi Rajah di bawah menunjukkan bahawa ramalan TT lebih 100 langkah masih mengekalkan ketepatan yang tinggi, manakala model ramalan satu langkah yang mengikut sifat Markov cepat runtuh disebabkan masalah superposisi ralat ramalan.

Trajektori Transformer, Rajah 2TT Walaupun berbeza dengan kaedah tradisional dari segi pemodelan khusus dan ramalan Ia berbeza, tetapi keupayaan ramalan yang diberikannya masih meninggalkan titik permulaan yang baik untuk keputusan lain yang akan disepadukan ke dalam pembelajaran pengukuhan pada masa hadapan. Walau bagaimanapun, TT mempunyai masalah penting dalam kelajuan ramalan: kerana ia perlu memodelkan pengedaran keseluruhan jujukan, ia mendiskrisikan semua elemen dalam jujukan mengikut dimensi Ini bermakna keadaan 100 dimensi perlu menduduki 100 elemen dalam jujukan . kedudukan, yang memudahkan panjang sebenar jujukan yang dimodelkan menjadi sangat panjang. Untuk Transformer, kerumitan pengiraannya untuk panjang jujukan N ialah  , yang menjadikan pensampelan ramalan masa depan daripada TT sangat mahal. Malah tugasan TT dengan kurang daripada 100 dimensi memerlukan beberapa saat atau bahkan berpuluh-puluh saat untuk membuat keputusan satu langkah Model sedemikian sukar untuk dimasukkan ke dalam kawalan robot masa nyata atau pembelajaran dalam talian.

, yang menjadikan pensampelan ramalan masa depan daripada TT sangat mahal. Malah tugasan TT dengan kurang daripada 100 dimensi memerlukan beberapa saat atau bahkan berpuluh-puluh saat untuk membuat keputusan satu langkah Model sedemikian sukar untuk dimasukkan ke dalam kawalan robot masa nyata atau pembelajaran dalam talian.

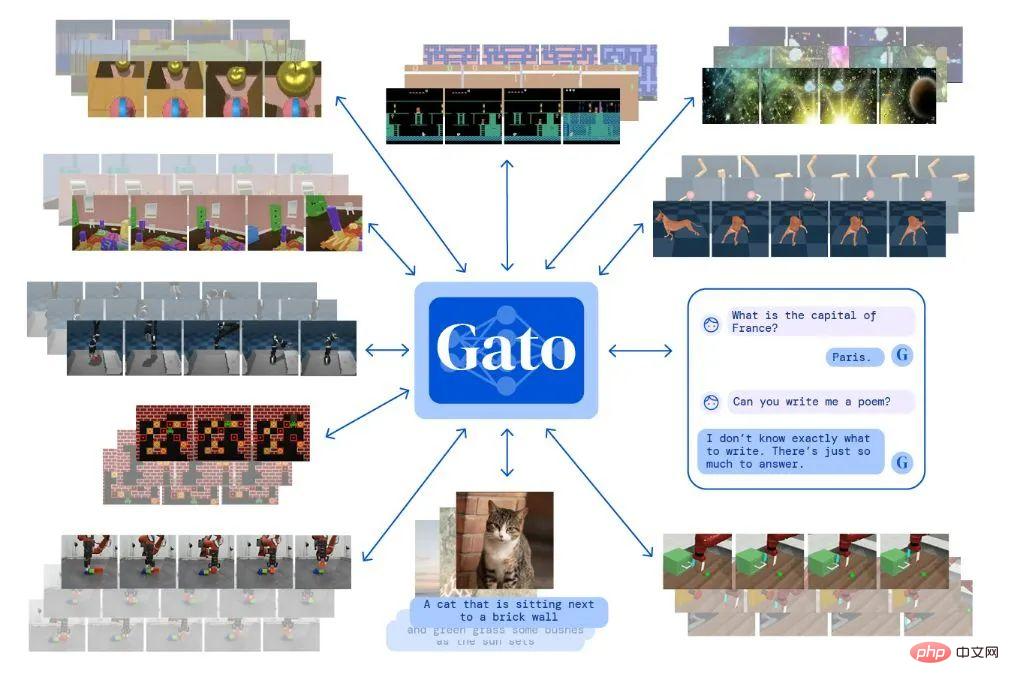

Gato ialah "model umum" yang diterbitkan oleh Deepmind, yang sebenarnya merupakan model penjanaan pelbagai tugas silang. Menggunakan Transformer yang sama, ia boleh menyelesaikan pelbagai tugas daripada menjawab soalan bahasa semula jadi, penerangan gambar, bermain permainan video kepada kawalan robot. Pendekatan Gato untuk memodelkan kawalan berterusan pada asasnya serupa dengan TT. Cuma Gato tidak melakukan pembelajaran pengukuhan dalam erti kata yang ketat Ia hanya memodelkan data urutan yang dijana oleh strategi pakar, dan kemudian apabila mengambil tindakan, ia hanya perlu mencuba tindakan seterusnya .

Blog Gato

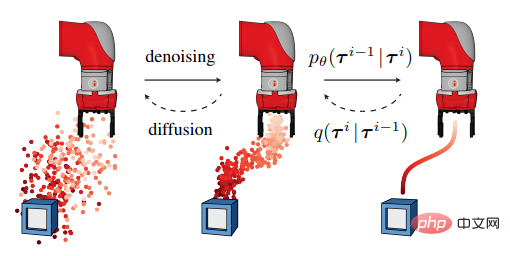

Model Resapan telah menjadi sangat popular dalam bidang penjanaan imej baru-baru ini dan DALLE-2 dan Resapan Stabil kedua-duanya berdasarkannya untuk penjanaan imej. Diffuser juga telah menggunakan kaedah ini untuk pembelajaran pengukuhan luar talian Ideanya adalah serupa dengan TT Ia mula-mula memodelkan taburan bersyarat bagi jujukan, dan kemudian sampel jujukan masa hadapan berdasarkan keadaan semasa.

Penyebar mempunyai fleksibiliti yang lebih besar daripada TT: ia boleh membenarkan model mengisi laluan tengah sambil menetapkan titik permulaan dan titik akhir, supaya ia boleh dikawal oleh fungsi dipacu matlamat (bukannya memaksimumkan ganjaran). Ia juga boleh mencampurkan berbilang matlamat dan syarat priori untuk mencapai matlamat untuk membantu model menyelesaikan tugas.

Diffuser Rajah 1Diffuser juga agak subversif berbanding model pembelajaran tetulang tradisional pelan yang dijana tidak dibentangkan secara beransur-ansur pada garis masa, tetapi menjadi lebih tepat secara beransur-ansur daripada kekaburan dalam erti kata keseluruhan jujukan. Kajian lanjut mengenai model resapan itu sendiri juga menjadi topik hangat dalam penglihatan komputer, dan kemungkinan besar akan ada satu kejayaan dalam model itu sendiri dalam beberapa tahun akan datang.

Namun, model resapan itu sendiri pada masa ini mempunyai kecacatan yang istimewa berbanding model generasi lain, iaitu kelajuan penjanaannya lebih perlahan berbanding model generasi lain. Ramai pakar dalam bidang berkaitan percaya bahawa ini mungkin dapat dikurangkan dalam beberapa tahun akan datang. Walau bagaimanapun, masa penjanaan beberapa saat pada masa ini sukar diterima untuk senario di mana pembelajaran pengukuhan memerlukan kawalan masa nyata. Penyebar mencadangkan kaedah yang boleh meningkatkan kelajuan penjanaan: bermula dari pelan langkah sebelumnya dan menambah sedikit bunyi untuk menjana semula rancangan langkah seterusnya, tetapi berbuat demikian akan mengurangkan prestasi model ke tahap tertentu.

Atas ialah kandungan terperinci Daripada Transformer to Diffusion Model, pelajari tentang kaedah pembelajaran pengukuhan berdasarkan pemodelan jujukan dalam satu artikel. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Bagaimana untuk membuka fail html

Bagaimana untuk membuka fail html

Tutorial pemasangan sistem Linux

Tutorial pemasangan sistem Linux

Analisis prospek syiling ICP

Analisis prospek syiling ICP

Tampalan vip petir

Tampalan vip petir

Penyelesaian laporan ralat fail sql import MySQL

Penyelesaian laporan ralat fail sql import MySQL

Bagaimana untuk menyelesaikan masalah skrin hitam selepas menghidupkan komputer dan tidak dapat memasuki desktop

Bagaimana untuk menyelesaikan masalah skrin hitam selepas menghidupkan komputer dan tidak dapat memasuki desktop

Pengenalan kepada penggunaan vscode

Pengenalan kepada penggunaan vscode

Platform pertukaran mata wang maya

Platform pertukaran mata wang maya