Selepas menukar teks kepada imej selama lebih daripada setengah tahun, gergasi teknologi seperti Meta dan Google telah menetapkan sasaran mereka ke medan perang baharu: teks kepada video.

Minggu lepas, Meta mengumumkan alat yang boleh menghasilkan video pendek berkualiti tinggi - Buat-A-Video Video yang dihasilkan menggunakan alat ini sangat imaginatif.

Sudah tentu, Google tidak boleh ketinggalan. Baru-baru ini, Ketua Pegawai Eksekutif syarikat Sundar Pichai secara peribadi mengumumkan pencapaian terbaharu mereka dalam bidang ini: dua alat teks ke video - Imagen Video dan Phenaki. Yang pertama memfokuskan pada kualiti video, manakala yang kedua terutamanya mencabar panjang video Boleh dikatakan bahawa masing-masing mempunyai kelebihan tersendiri.

Teddy bear mencuci pinggan di bawah telah dijana menggunakan Imagen Video Seperti yang anda lihat, resolusi dan keselarasan gambar adalah pasti.

Pemodelan generatif dalam sistem AI teks-ke-imej terkini Kemajuan yang ketara telah dicapai dalam DALL-E 2, Imagen, Parti, CogView dan Latent Diffusion. Khususnya, model resapan telah mencapai kejayaan besar dalam pelbagai tugas pemodelan generatif seperti anggaran ketumpatan, teks ke pertuturan, imej ke imej, teks ke imej dan sintesis 3D.

Apa yang Google mahu lakukan ialah menjana video daripada teks. Kerja sebelumnya mengenai penjanaan video telah memfokuskan pada set data terhad dengan model autoregresif, model pembolehubah terpendam dengan prior autoregresif dan lebih baru-baru ini, kaedah pembolehubah pendam bukan autoregresif. Model resapan juga telah menunjukkan keupayaan penjanaan video resolusi sederhana yang sangat baik.

Atas dasar ini, Google melancarkan Imagen Video, sistem penjanaan video bersyarat teks berdasarkan model penyebaran video lata. Memandangkan gesaan teks, Imagen Video boleh menjana video definisi tinggi melalui sistem yang terdiri daripada pengekod teks T5 beku, model penjanaan video asas dan model resolusi super video spatiotemporal berlatarkan.

Alamat kertas: https://imagen.research.google/video/paper.pdf

Dalam kertas kerja, Google menerangkan secara terperinci cara memanjangkan sistem ke dalam model teks-ke-video definisi tinggi, termasuk memilih model resolusi super spatiotemporal konvolusi sepenuhnya pada resolusi tertentu dan memilih parameter v daripada model penyebaran dan keputusan reka bentuk lain. Google juga telah berjaya memindahkan hasil penyelidikan penjanaan imej berasaskan resapan sebelumnya kepada tetapan penjanaan video.

Google mendapati bahawa Imagen Video dapat mempertingkatkan video 24fps 64 bingkai 128×128 yang dijana oleh kerja sebelumnya kepada 128 bingkai video HD 1280×768. Selain itu, Imagen Video mempunyai tahap kebolehkawalan dan pengetahuan dunia yang tinggi, boleh menjana animasi video dan teks dalam gaya artistik yang pelbagai, dan mempunyai keupayaan memahami objek 3D.

Mari kami menikmati beberapa lagi video yang dihasilkan oleh Imagen Video, seperti panda memandu:

Aoyou Kapal kayu di angkasa:

Untuk lebih banyak video yang dijana, sila lihat: https://imagen.research.google/video/

Kaedah dan Eksperimen

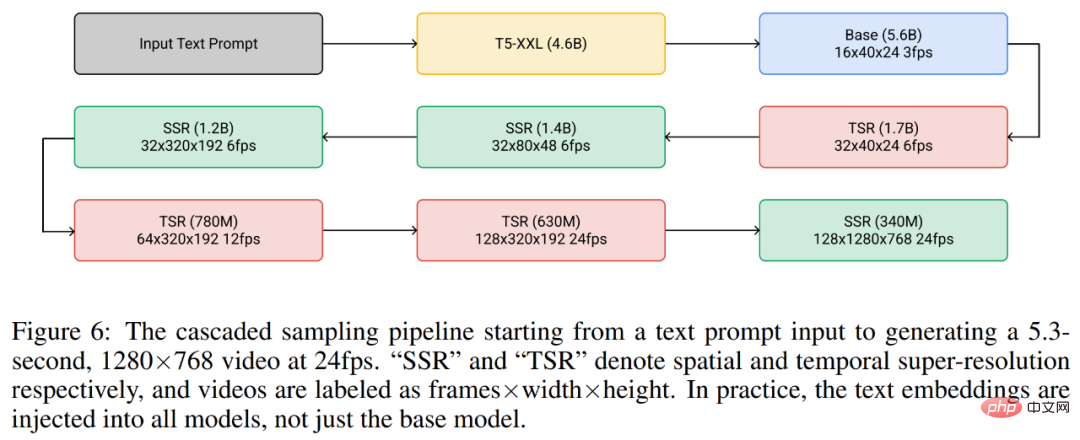

Secara keseluruhannya, rangka kerja penjanaan video Google ialah rangkaian tujuh model penyebaran sub-video, yang masing-masing melaksanakan penjanaan video bersyarat teks, resolusi super ruang dan resolusi super temporal. Menggunakan keseluruhan lata, Imagen Video mampu menghasilkan 128 bingkai video HD 1280×768 (kira-kira 126 juta piksel) pada 24 bingkai sesaat.

Sementara itu, dengan bantuan penyulingan progresif, Imagen Video menjana video berkualiti tinggi menggunakan hanya lapan langkah penyebaran dalam setiap submodel. Ini mempercepatkan masa penjanaan video sebanyak lebih kurang 18x.

Rajah 6 di bawah menunjukkan keseluruhan saluran paip Video Imagen, termasuk pengekod teks beku, model resapan video asas dan 3 resolusi super ruang (SSR) dan 3 resolusi super temporal (TSR) model. Tujuh model penyebaran video mempunyai sejumlah 11.6 bilion parameter.

Semasa proses penjanaan, model SSR menambah baik resolusi spatial semua bingkai input, manakala model TSR menambah baik resolusi temporal dengan mengisi bingkai perantaraan antara bingkai input. Semua model menjana blok bingkai lengkap secara serentak supaya model SSR tidak mengalami artifak yang ketara.

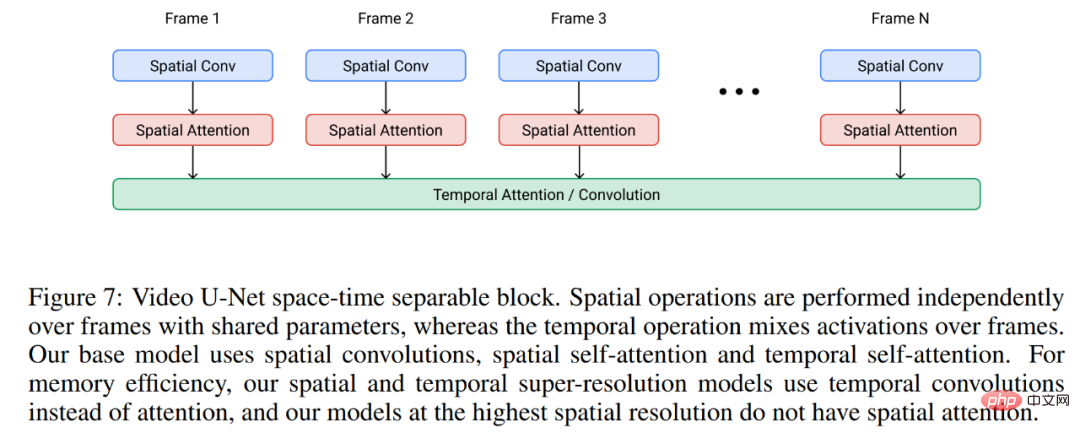

Video Imej dibina pada seni bina U-Net video, seperti ditunjukkan dalam Rajah 7 di bawah.

Dalam percubaan, Imagen Video dilakukan pada set data teks imej LAION-400M yang tersedia secara terbuka, 14 juta pasangan teks video dan 60 juta imej. Latih pada pasangan teks. Akibatnya, seperti yang dinyatakan di atas, Imagen Video bukan sahaja dapat menjana video definisi tinggi, tetapi juga mempunyai beberapa ciri unik yang tidak dimiliki oleh model generatif tidak berstruktur yang belajar semata-mata daripada data.

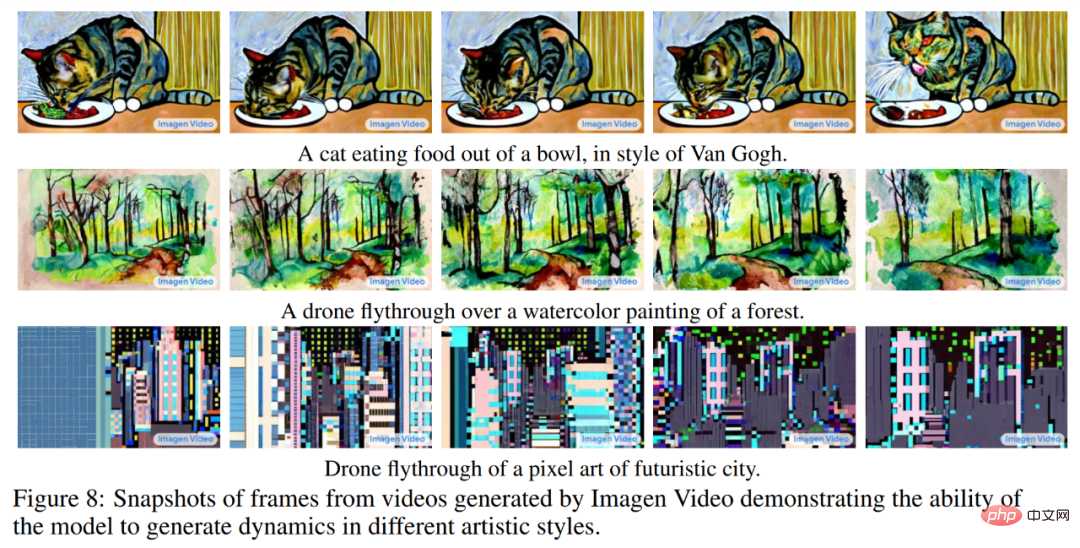

Rajah 8 di bawah menunjukkan keupayaan Video Imagen untuk menjana video dengan gaya artistik yang dipelajari daripada maklumat imej, seperti gaya lukisan Van Gogh atau video gaya cat air.

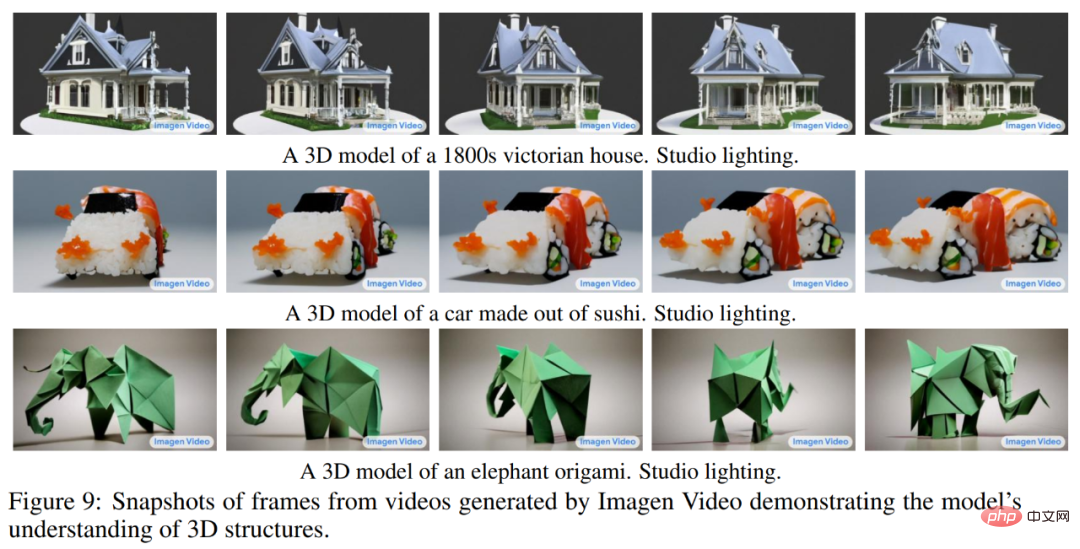

Rajah 9 di bawah menunjukkan keupayaan Imagen Video untuk memahami struktur 3D Ia boleh menjana video objek berputar, dan struktur umum objek juga boleh menjadi simpanan.

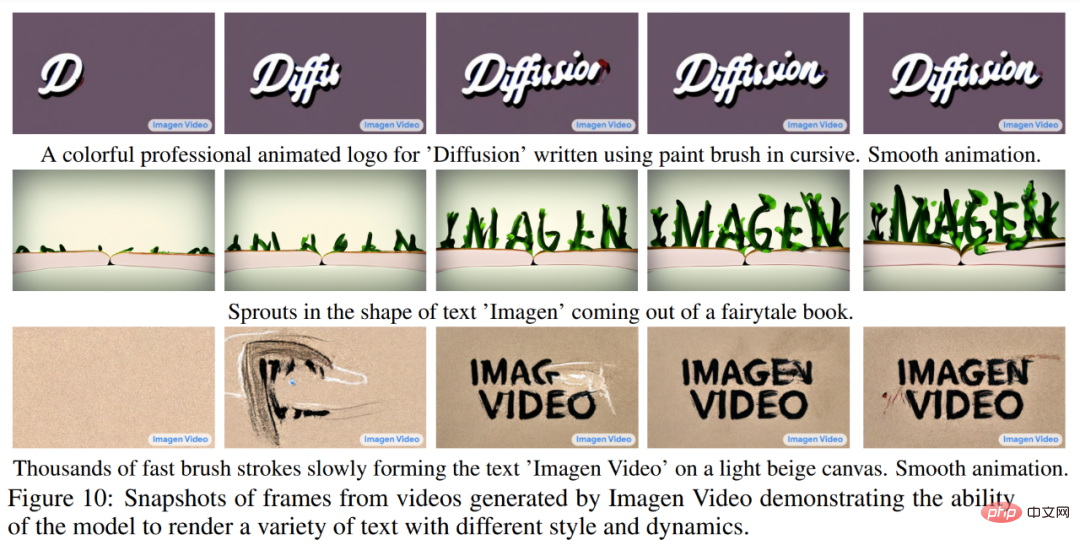

Rajah 10 di bawah menunjukkan cara Video Imagen boleh menjana teks dengan pasti dalam pelbagai gaya animasi, sesetengah daripadanya sukar dibuat menggunakan alatan tradisional.

Sila rujuk kertas asal untuk mendapatkan butiran eksperimen lanjut.

Kami tahu bahawa walaupun video pada asasnya adalah satu siri imej, menghasilkan video panjang yang koheren tidak begitu mudah, kerana terdapat sedikit data berkualiti tinggi yang tersedia untuk tugasan ini, dan tugas itu sendiri memerlukan pengiraan.

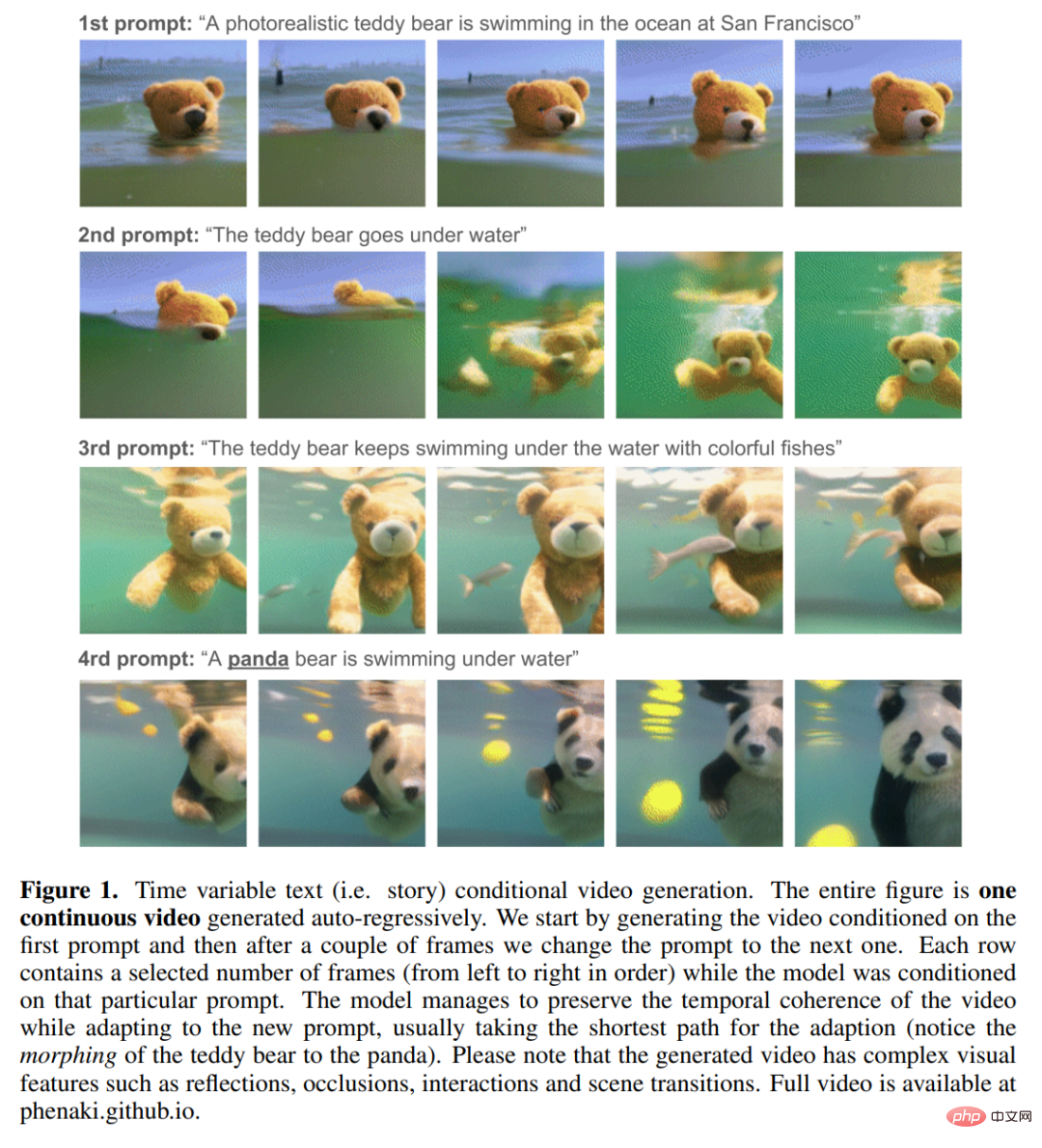

Apa yang lebih menyusahkan ialah gesaan teks pendek yang digunakan untuk penjanaan imej seperti sebelum ini biasanya tidak mencukupi untuk memberikan penerangan lengkap tentang video yang diperlukan oleh video ialah satu siri gesaan atau cerita. Sebaik-baiknya, model penjanaan video mesti boleh menjana video dalam apa-apa panjang dan melaraskan bingkai video yang dijana mengikut perubahan segera pada masa tertentu t. Hanya dengan keupayaan ini, karya yang dihasilkan oleh model boleh dipanggil "video" dan bukannya "imej bergerak", dan membuka jalan kepada aplikasi kreatif kehidupan sebenar dalam seni, reka bentuk dan penciptaan kandungan.

Penyelidik dari Google dan institusi lain berkata, “Untuk pengetahuan kami, penjanaan video bersyarat berasaskan cerita tidak pernah diterokai sebelum ini, dan ini adalah kertas kerja pertama yang bergerak ke arah matlamat ini . 》

Memandangkan tiada set data berasaskan cerita tersedia Belajar, tiada cara untuk penyelidik menyelesaikan tugasan ini hanya dengan bergantung pada kaedah pembelajaran mendalam tradisional (hanya belajar daripada data). Jadi mereka mereka bentuk model khusus untuk tugas itu.

Model teks-ke-video baharu ini dipanggil Phenaki, yang dilatih bersama menggunakan data "teks-ke-video" dan "teks-ke-imej". Model ini mempunyai keupayaan berikut:

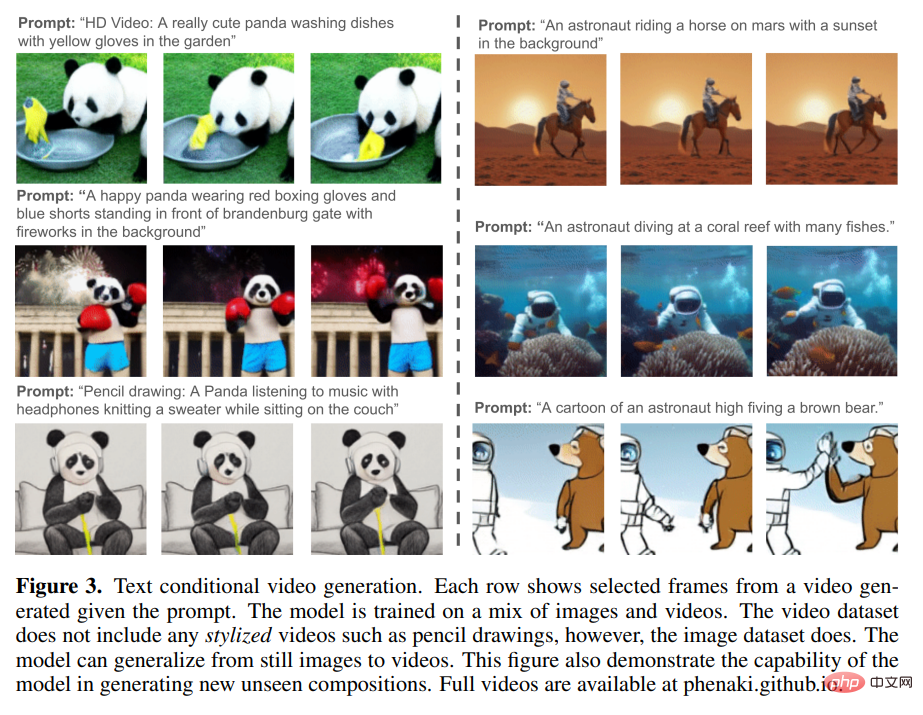

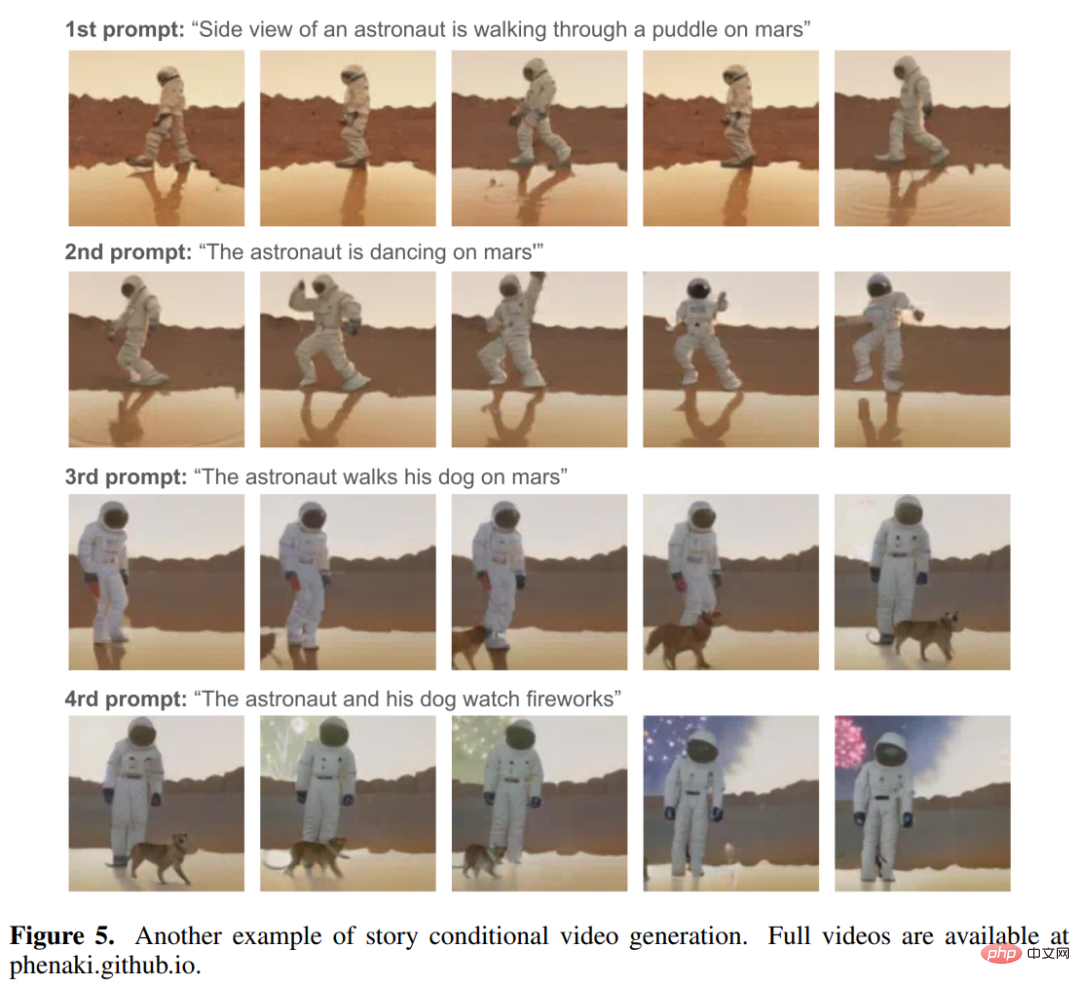

1. Hasilkan video pelbagai koheren sementara di bawah syarat gesaan domain terbuka, walaupun gesaan itu merupakan gabungan konsep baharu (lihat Rajah 3 di bawah ) . Video yang dijana boleh berdurasi beberapa minit, walaupun video yang digunakan untuk melatih model hanya 1.4 saat (8 bingkai/saat)

2 . Menurut Cerita (iaitu satu siri gesaan) hasilkan video, seperti yang ditunjukkan dalam Rajah 1 dan 5 di bawah:

Daripada animasi berikut kita dapat melihat keselarasan dan kepelbagaian video yang dihasilkan oleh Phenaki:

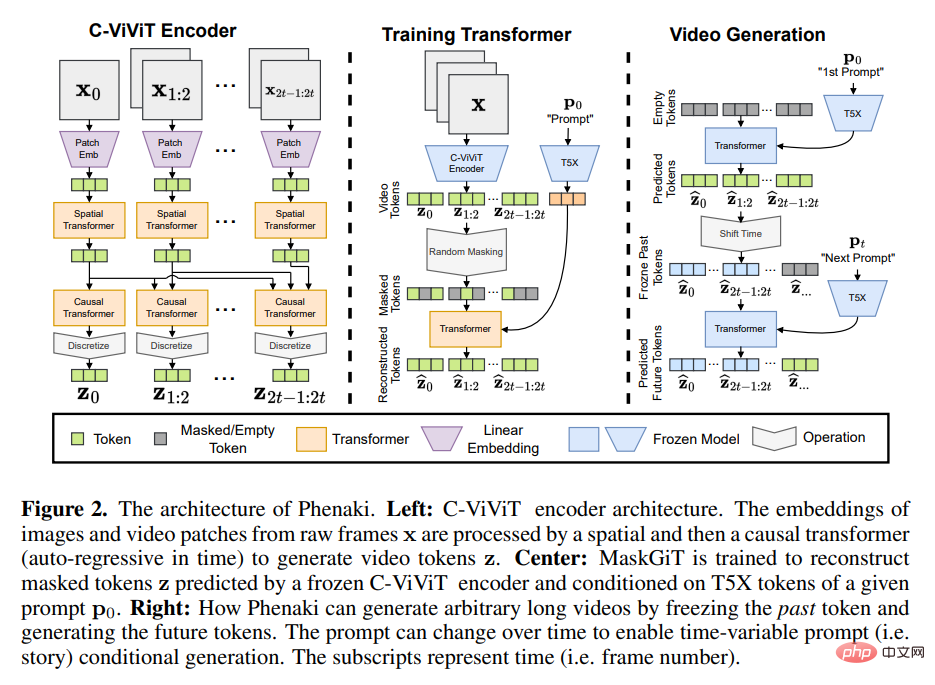

Untuk mencapai Untuk keupayaan ini, penyelidik tidak boleh bergantung pada pengekod video sedia ada, yang sama ada hanya menyahkod video bersaiz tetap atau mengekod bingkai secara bebas. Untuk menyelesaikan masalah ini, mereka memperkenalkan seni bina penyahkod pengekod baharu - C-ViViT.

C-ViViT boleh:

Diinspirasikan oleh penyelidikan terdahulu tentang teks autoregresif ke imej dan teks ke video , Reka bentuk Phenaki terutamanya terdiri daripada dua bahagian (lihat Rajah 2 di bawah): model penyahkod pengekod yang memampatkan video kepada pembenaman diskret (iaitu token) dan model pengubah yang menukar pembenaman teks kepada token video.

Mendapatkan representasi termampat bagi video ialah salah satu cabaran utama dalam menjana video daripada teks. Kerja sebelumnya sama ada menggunakan pengekod imej setiap bingkai, seperti VQ-GAN atau pengekod video panjang tetap, seperti VideoVQVAE. Yang pertama membenarkan penjanaan video dengan panjang sewenang-wenangnya, tetapi dalam penggunaan praktikal, video mestilah pendek kerana pengekod tidak boleh memampatkan video dalam masa dan token sangat berlebihan dalam bingkai berturut-turut. Yang terakhir adalah lebih cekap dari segi bilangan token, tetapi ia tidak membenarkan penjanaan video dengan panjang sewenang-wenangnya.

Mendapatkan representasi termampat bagi video ialah salah satu cabaran utama dalam menjana video daripada teks. Kerja sebelumnya sama ada menggunakan pengekod imej setiap bingkai, seperti VQ-GAN atau pengekod video panjang tetap, seperti VideoVQVAE. Yang pertama membenarkan penjanaan video dengan panjang sewenang-wenangnya, tetapi dalam penggunaan praktikal, video mestilah pendek kerana pengekod tidak boleh memampatkan video dalam masa dan token sangat berlebihan dalam bingkai berturut-turut. Yang terakhir adalah lebih cekap dari segi bilangan token, tetapi ia tidak membenarkan penjanaan video dengan panjang sewenang-wenangnya.

Di Phenaki, matlamat penyelidik adalah untuk menjana video berpanjangan berubah-ubah sambil memampatkan bilangan token video sebanyak mungkin, supaya model Transformer boleh digunakan dalam kekangan sumber pengkomputeran semasa. Untuk tujuan ini, mereka memperkenalkan C-ViViT, varian penyebab ViViT dengan perubahan seni bina tambahan untuk penjanaan video, yang boleh memampatkan video dalam kedua-dua dimensi temporal dan spatial sambil mengekalkan autoregresi temporal. Ciri ini membolehkan penjanaan video autoregresif dengan panjang sewenang-wenangnya.

Untuk mendapatkan pembenaman teks, Phenaki juga menggunakan model bahasa pra-latihan - T5X.

Sila rujuk kertas asal untuk butiran.

Atas ialah kandungan terperinci Bosan dengan penjanaan imej, Google beralih kepada teks → penjanaan video, dua alat berkuasa yang mencabar resolusi dan panjang pada masa yang sama. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!