Versi ringan ChatGPT berdasarkan model Meta ada di sini?

Hanya tiga hari sejak Meta mengumumkan pelancaran LLaMA, dan kaedah latihan sumber terbuka yang mengubahnya menjadi ChatGPT telah muncul dalam industri, mendakwa bahawa kelajuan latihan adalah sehingga 15 kali lebih pantas daripada ChatGPT .

LLaMA ialah GPT-3 yang sangat pantas dan sangat kecil yang dilancarkan oleh Meta Bilangan parameter hanya 10% daripada yang terakhir, dan ia hanya memerlukan satu GPU untuk dijalankan.

Kaedah untuk mengubahnya menjadi ChatGPT dipanggil ChatLLaMA, yang dilatih berdasarkan RLHF (pembelajaran pengukuhan berdasarkan maklum balas manusia) dan dengan cepat menjadi topik hangat di Internet.

Jadi, versi sumber terbuka Meta untuk ChatGPT benar-benar akan datang?

Tunggu sebentar, perkara tidak semudah itu.

Klik pada laman utama projek ChatLLaMA dan anda akan mendapati ia sebenarnya menggabungkan empat bahagian -

Kaedah DeepSpeed, RLHF , LLaMA dan set data yang dijana berdasarkan ejen LangChain.

Antaranya, DeepSpeed ialah perpustakaan pengoptimuman latihan pembelajaran dalam sumber terbuka, termasuk teknologi pengoptimuman sedia ada yang dipanggil Zero, yang digunakan untuk meningkatkan keupayaan latihan model besar Secara khusus, ia merujuk kepada membantu model meningkatkan latihan kelajuan, mengurangkan kos, meningkatkan ketersediaan model, dsb.

RLHF akan menggunakan model ganjaran untuk memperhalusi model pra-latihan. Model ganjaran mula-mula menggunakan berbilang model untuk menjana soalan dan jawapan, dan kemudian bergantung pada pengisihan manual bagi soalan dan jawapan supaya ia boleh belajar untuk menskor Kemudian, ia menjaringkan jawapan yang dijana oleh model berdasarkan pembelajaran ganjaran, dan meningkatkan keupayaan model melalui pembelajaran pengukuhan.

LangChain ialah perpustakaan pembangunan aplikasi model bahasa yang besar yang berharap dapat menyepadukan pelbagai model bahasa besar dan mencipta aplikasi praktikal digabungkan dengan sumber pengetahuan atau kuasa pengkomputeran lain. Ejen LangChain akan melepaskan keseluruhan proses pemikiran GPT-3 seperti rantaian pemikiran dan merekodkan operasi.

Pada masa ini anda akan mendapati bahawa perkara yang paling kritikal adalah masih berat model LLaMA. Dari mana ia datang?

Hei, pergi ke Meta dan mohon sendiri, ChatLLaMA tidak menyediakannya. (Walaupun Meta mendakwa LLaMA sumber terbuka, anda masih perlu memohon)

Jadi pada asasnya, ChatLLaMA bukanlah projek ChatGPT sumber terbuka, tetapi hanya kaedah latihan berdasarkan LLaMA Beberapa projek yang disepadukan dalam perpustakaannya pada asalnya adalah sumber terbuka.

Sebenarnya, ChatLLaMA tidak dibina oleh Meta, tetapi daripada syarikat AI permulaan bernama Nebuly AI.

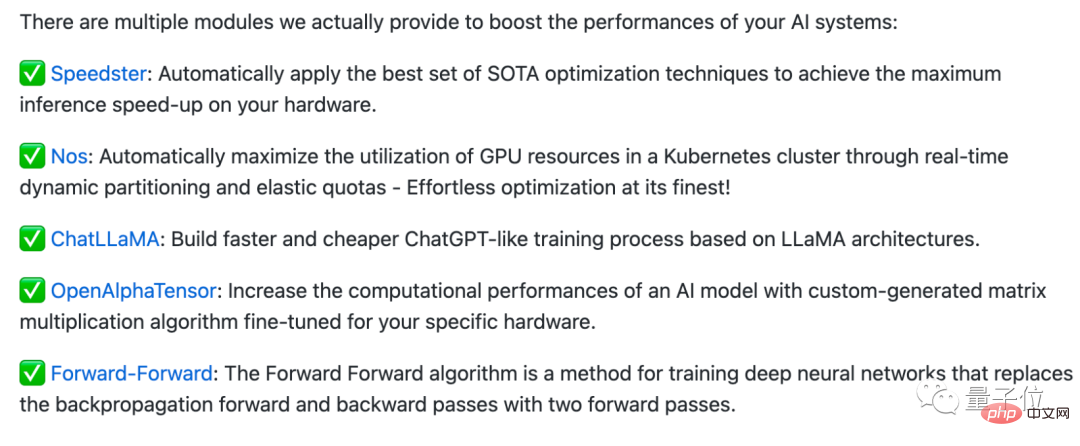

Nebuly AI telah membuat perpustakaan sumber terbuka yang dipanggil Nebullvm, yang menyepadukan satu siri modul pengoptimuman palam dan main untuk meningkatkan prestasi sistem AI.

Sebagai contoh, ini ialah beberapa modul yang disertakan dalam Nebullvm pada masa ini, termasuk OpenAlphaTensor berdasarkan algoritma AlphaTensor sumber terbuka DeepMind, modul pengoptimuman yang secara automatik mengesan perkakasan dan mempercepatkannya...

ChatLLaMA juga terdapat dalam siri modul ini, tetapi perlu diingatkan bahawa lesen sumber terbukanya tidak tersedia secara komersial.

Jadi, jika anda ingin menggunakan "ChatGPT yang dibangunkan sendiri domestik" secara langsung, ia mungkin tidak semudah itu (doge).

Setelah membaca projek ini, beberapa netizen berkata alangkah bagus jika seseorang benar-benar mendapat berat model (kod) LLaMA...

Tetapi Beberapa netizen juga menegaskan bahawa kenyataan "15 kali lebih cepat daripada kaedah latihan ChatGPT" adalah mengelirukan semata-mata:

Apa yang dipanggil 15 kali lebih cepat adalah hanya kerana model LLaMA itu sendiri sangat kecil dan malah boleh dijalankan pada satu GPU yang berjalan di atasnya, tetapi ia tidak sepatutnya kerana apa-apa yang dilakukan oleh projek ini, bukan?

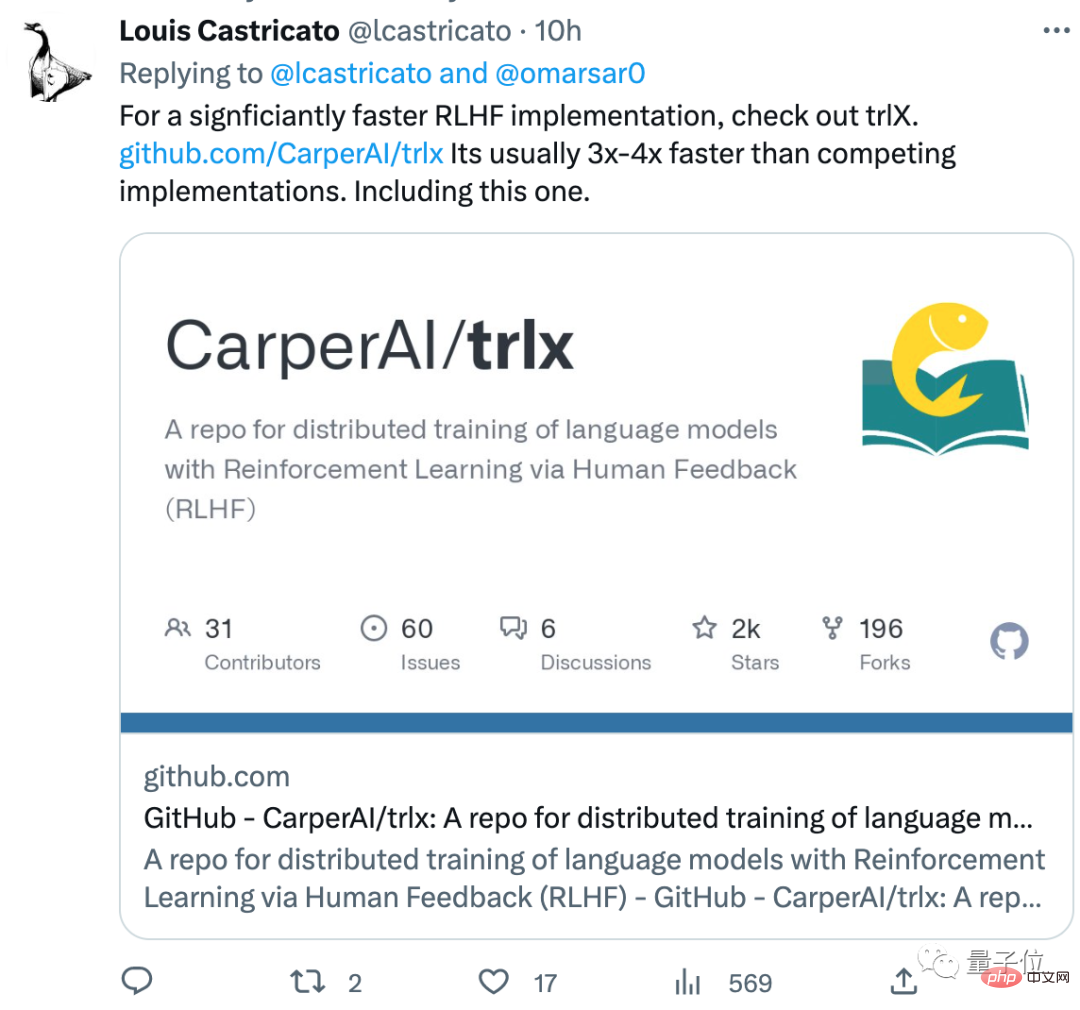

Netizen ini juga mengesyorkan kaedah latihan RLHF yang lebih baik daripada yang ada di perpustakaan, dipanggil trlx, dan kelajuan latihan lebih cepat daripada kaedah RLHF biasa . 3~4 kali:

Adakah anda mendapat kod untuk LLaMA? Apakah pendapat anda tentang kaedah latihan ini?

Alamat ChatLLaMA://m.sbmmt.com/link/fed537780f3f29cc5d5f313bbda423c4

Pautan rujukan://m.sbmmt.com/link/fe27f92b1e3f4997567807f38d567a35

Atas ialah kandungan terperinci Versi ringan kaedah latihan ChatGPT adalah sumber terbuka! Dibina di sekitar LLaMA dalam masa 3 hari sahaja, kelajuan latihan didakwa 15 kali lebih pantas daripada OpenAI. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Pengenalan kepada penggunaan kod keseluruhan vbs

Pengenalan kepada penggunaan kod keseluruhan vbs

Apakah maksud kappa?

Apakah maksud kappa?

Bagaimana untuk menetapkan lebar set medan

Bagaimana untuk menetapkan lebar set medan

Penggunaan teg benam

Penggunaan teg benam

Perkara yang perlu dilakukan jika suis Bluetooth tiada dalam Windows 10

Perkara yang perlu dilakukan jika suis Bluetooth tiada dalam Windows 10

Apakah masalah yang boleh diselesaikan oleh acara js yang menggelegak?

Apakah masalah yang boleh diselesaikan oleh acara js yang menggelegak?

Bagaimana untuk membuka fail pdb

Bagaimana untuk membuka fail pdb

Penyelesaian kod kacau Cina Ajax

Penyelesaian kod kacau Cina Ajax