Adakah AI maju lagi?

Dan ia adalah jenis yang menghasilkan video berterusan selama 30 saat daripada gambar.

emm.... Adakah kualitinya agak lembek? 🎜>Berhati-hati bahawa ini hanya dijana daripada satu imej (bingkai pertama) dan tidak mempunyai sebarang maklumat geometri yang dipaparkan.

Ini ialah rangka kerja umum untuk pemodelan imej dan tugas penglihatan berdasarkan ramalan bingkai kebarangkalian yang dicadangkan oleh DeepMind - Transframer baru-baru ini.

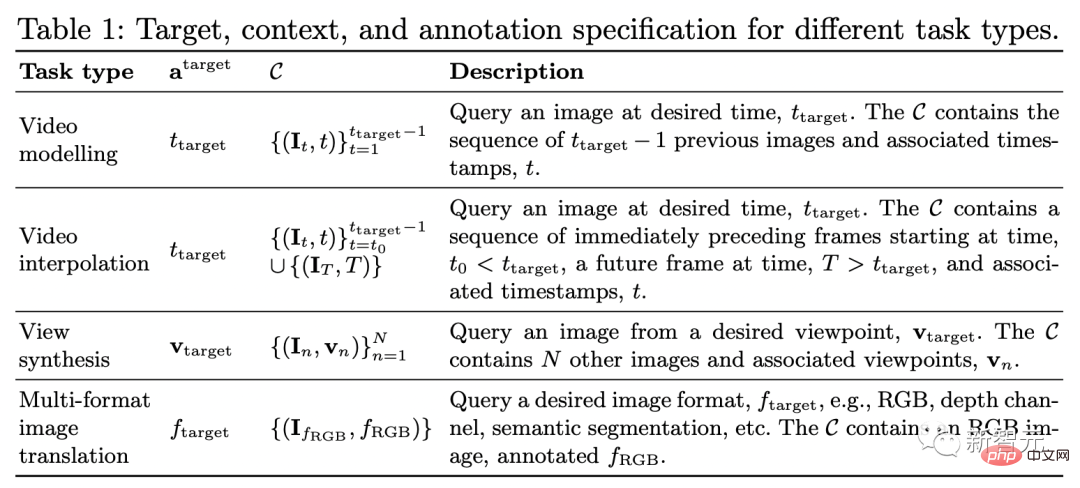

Ringkasnya, Transframer digunakan untuk meramalkan kebarangkalian sebarang bingkai.

Bingkai ini boleh dikondisikan pada satu atau lebih bingkai konteks beranotasi, sama ada bingkai video sebelumnya, cap masa atau pemandangan paparan berteg kamera .

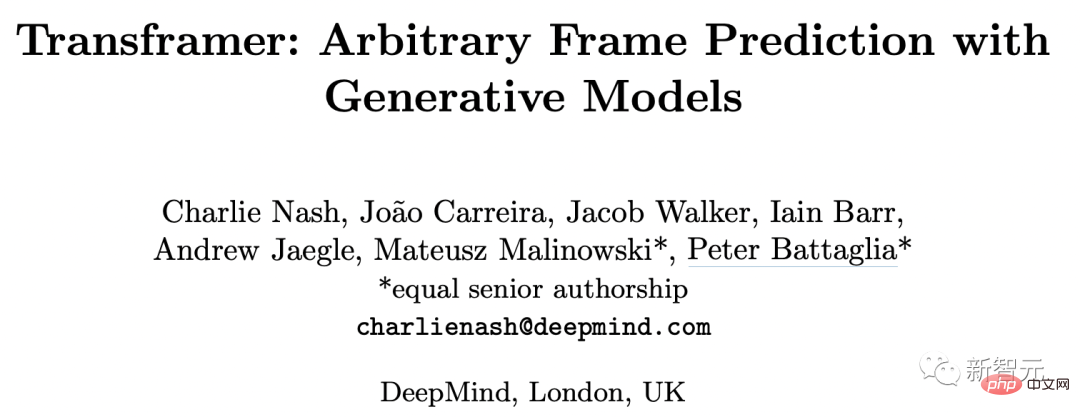

Seni Bina Transframer

Alamat kertas disiarkan di bawah. Kanak-kanak yang berminat boleh lihat ~ https://arxiv.org /abs/2203.09494

Alamat kertas disiarkan di bawah. Kanak-kanak yang berminat boleh lihat ~ https://arxiv.org /abs/2203.09494

Untuk menganggarkan taburan yang diramalkan pada imej sasaran, kami memerlukan model penjanaan ekspresi yang boleh menghasilkan output yang pelbagai dan berkualiti tinggi.

Walaupun keputusan DC Transformer pada domain imej tunggal boleh memenuhi keperluan, ia tidak terdapat dalam set teks berbilang imej {(In,an) }n kita perlukan sebagai syarat.

Oleh itu, kami melanjutkan DC Transformer untuk mendayakan ramalan bersyarat imej dan anotasi.

Kami menggantikan DC Transformer dengan pengekod gaya Vision-Transformer yang beroperasi pada imej DCT tunggal menggunakan seni bina U-Net berbilang bingkai, menggunakan Untuk memproses a set bingkai beranotasi dan imej DCT sasaran yang tersembunyi sebahagiannya.

Mari kita lihat cara seni bina Transframer berfungsi.

(a) Transframer mengambil sebagai input imej DCT (a1 dan a2) serta imej DCT sasaran yang tersembunyi (aT) dan anotasi tambahan, yang diproses oleh berbilang- pengekod U-Net bingkai. Seterusnya, output U-Net dihantar ke penyahkod DC-Transformer melalui perhatian silang, yang secara automatik mundur untuk menjana urutan Token DCT (huruf hijau) sepadan dengan bahagian tersembunyi imej sasaran. (b) Blok U-Net berbilang bingkai terdiri daripada blok lilitan NF-Net dan blok perhatian kendiri berbilang bingkai, yang bertukar maklumat antara bingkai input dan MLP sisa gaya Transformer.

Mari kita lihat U-Net Berbilang Bingkai yang memproses input imej.

Mari kita lihat U-Net Berbilang Bingkai yang memproses input imej.

Input U-Net ialah jujukan yang terdiri daripada bingkai N DCT dan bingkai DCT sasaran yang tersembunyi sebahagiannya, maklumat beranotasi dikaitkan dengan setiap bingkai input Disediakan dalam vektor bentuk.

Komponen teras U-Net ialah blok pengiraan yang mula-mula menggunakan blok konvolusi NF-ResNet yang dikongsi pada setiap bingkai input dan kemudian menggunakan gaya Transformer blok perhatian diri untuk mengagregatkan maklumat merentas bingkai. (Rajah 2 b)

Blok NF-ResNet terdiri daripada lilitan berkumpulan dan lapisan picitan dan pengujaan, bertujuan untuk meningkatkan prestasi TPU.

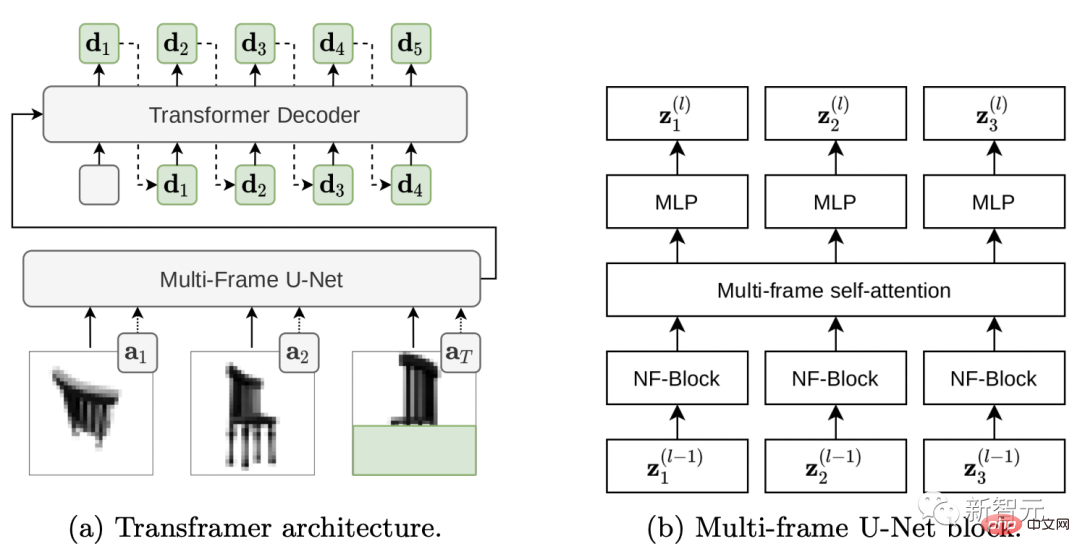

Di bawah, rajah (a) membandingkan jarangnya perwakilan DCT mutlak dan baki bagi video RoboNet (128x128) dan KITTI.

Memandangkan RoboNet terdiri daripada video statik dengan hanya beberapa elemen yang bergerak, kezaliman perwakilan bingkai baki meningkat dengan ketara.

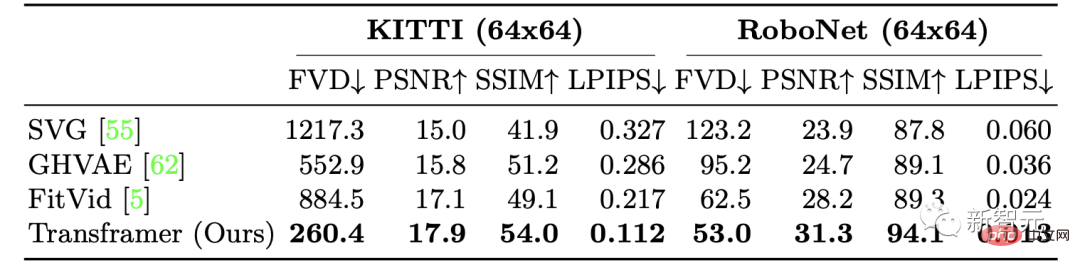

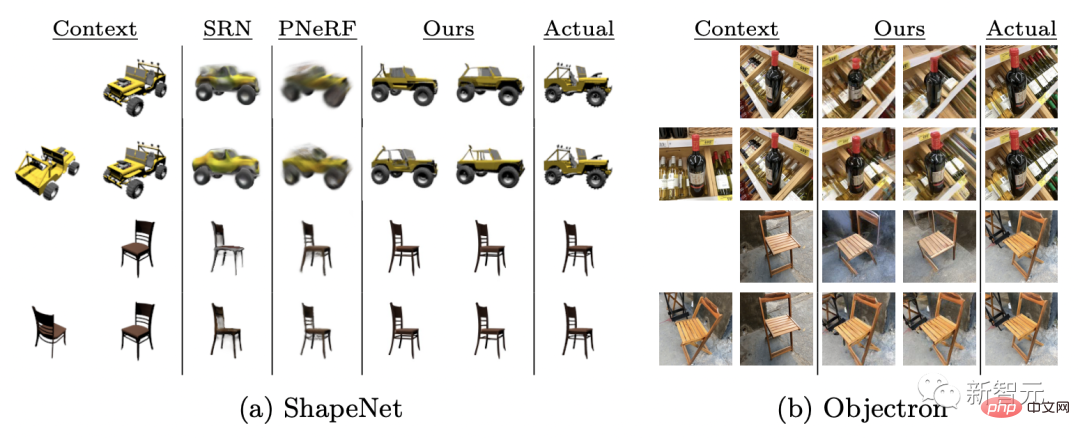

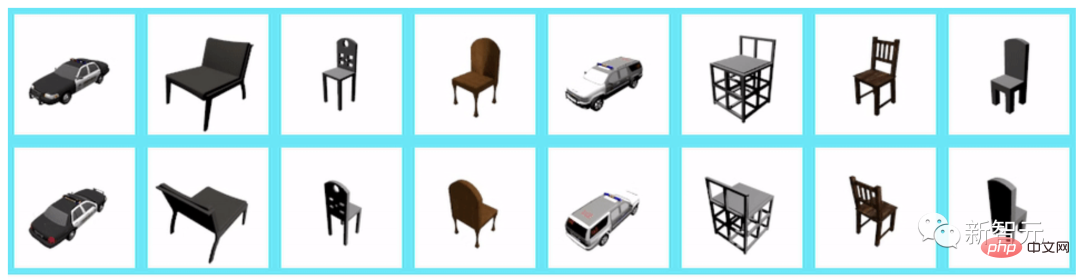

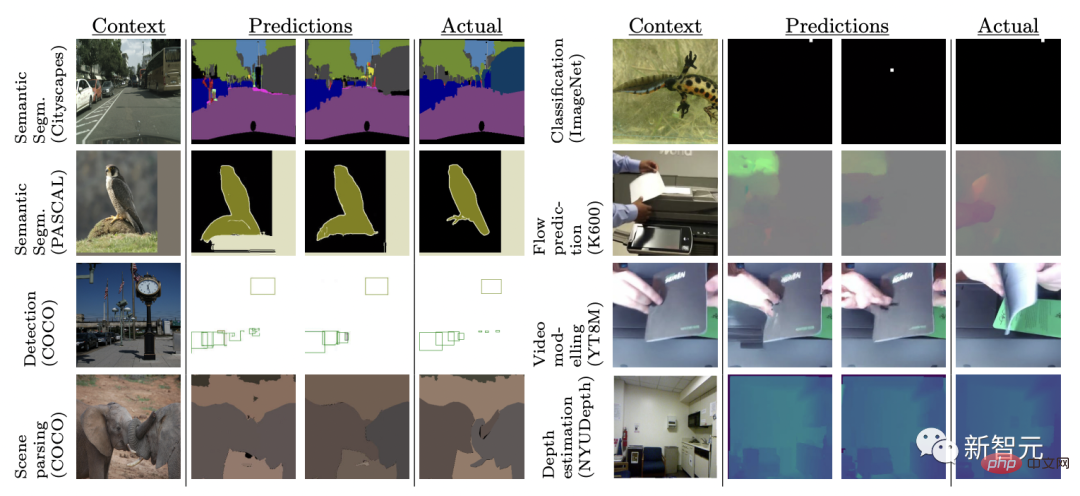

Dan video KITTI selalunya mempunyai kamera bergerak, mengakibatkan perbezaan hampir di mana-mana dalam bingkai berturut-turut. Tetapi dalam kes ini, faedah jarang kecil juga menjadi lemah. Melalui satu siri ujian pada set data dan tugasan, keputusan menunjukkan Transframer boleh digunakan untuk pelbagai tugas. Ini termasuk pemodelan video, sintesis paparan baharu, pembahagian semantik, pengecaman objek, anggaran kedalaman, ramalan aliran optik, dsb. Pemodelan Video Melalui Transframer Predict bingkai seterusnya diberikan urutan bingkai video input. Para penyelidik melatih prestasi Transframer mengenai penjanaan video pada set data KITTI dan RoboNet masing-masing. Untuk KITTI, diberikan 5 bingkai konteks dan 25 bingkai pensampelan, keputusan menunjukkan bahawa model Transframer berprestasi lebih baik pada semua metrik Prestasi LPIPS dan FVD telah dipertingkatkan, antaranya penambahbaikan LPIPS dan FVD adalah yang paling ketara. Di RoboNet, para penyelidik diberi 2 bingkai konteks dan 10 bingkai persampelan, masing-masing pada 64x64 dan 128x128 latihan telah dijalankan pada resolusi tertentu dan akhirnya mencapai keputusan yang sangat baik. Lihat Komposisi Dari segi sintesis paparan, kami bekerja dengan menyediakan paparan kamera sebagai konteks dan anotasi sasaran seperti yang diterangkan dalam Jadual 1 (baris 3), dan pensampelan seragam berbilang paparan konteks sehingga maksimum yang ditentukan. Model Transframer dinilai pada penanda aras ShapeNet, dengan ketara mengatasi prestasi PixelNeRF dan SRN dengan menyediakan 1-2 paparan kontekstual. Selain itu selepas penilaian ke atas dataset Objectron, dapat dilihat bahawa apabila diberikan paparan input tunggal, model menghasilkan Keluaran koheren, tetapi tiada beberapa ciri seperti kaki kerusi bersilang. Apabila 1 paparan konteks diberikan, paparan yang disintesis pada resolusi 128×128 adalah seperti berikut: Apabila 2 lagi paparan konteks diberikan, paparan yang disintesis pada resolusi 128×128 adalah seperti berikut: Tugas Penglihatan Pelbagai Tugas penglihatan komputer yang berbeza sering menggunakan seni bina yang kompleks dan fungsi kehilangan untuk dikendalikan. Di sini, para penyelidik bersama-sama melatih model Transframer pada 8 tugasan dan set data yang berbeza menggunakan fungsi kehilangan yang sama. 8 tugas tersebut ialah: ramalan aliran optik bagi imej tunggal, pengelasan objek, pengesanan dan segmentasi, segmentasi semantik (pada 2 set data), ramalan bingkai masa hadapan dan anggaran kedalaman. Hasilnya menunjukkan bahawa Transframer belajar untuk menjana sampel yang berbeza dalam tugasan yang sama sekali berbeza, seperti Cityscapes. model menghasilkan output yang berkualiti. Walau bagaimanapun, kualiti output model pada tugasan seperti ramalan bingkai masa hadapan dan pengesanan kotak sempadan adalah berubah-ubah, menunjukkan bahawa pemodelan dalam tetapan ini adalah seks yang lebih mencabar.

Lebih kuat dalam tugas berbilang penglihatan

Atas ialah kandungan terperinci Beri saya gambar dan hasilkan video 30 saat!. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Pengenalan kepada rangka kerja yang digunakan oleh vscode

Pengenalan kepada rangka kerja yang digunakan oleh vscode

Bagaimana untuk menetapkan vlanid

Bagaimana untuk menetapkan vlanid

Bagaimana untuk memasuki mod selamat pada komputer riba

Bagaimana untuk memasuki mod selamat pada komputer riba

Apakah sebab kegagalan untuk menyambung ke pelayan?

Apakah sebab kegagalan untuk menyambung ke pelayan?

Proses terperinci menaik taraf sistem win7 kepada sistem win10

Proses terperinci menaik taraf sistem win7 kepada sistem win10

Apakah mata wang yang dimiliki oleh USDT?

Apakah mata wang yang dimiliki oleh USDT?

Bagaimana untuk membuat tatal gambar dalam ppt

Bagaimana untuk membuat tatal gambar dalam ppt

Bagaimana untuk membeli syiling fil

Bagaimana untuk membeli syiling fil