Walaupun rangkaian saraf dalam mempunyai prestasi empirikal yang kuat dalam pengelasan imej, model sedemikian sering dianggap sebagai "kotak hitam" dan paling banyak dikritik kerana"sukar untuk dijelaskan" .

Sebaliknya,model konvolusi yang jarangjuga merupakan alat yang berkuasa untuk menganalisis imej semula jadi, yang menganggap bahawa isyarat boleh diwakili oleh volum Ia dinyatakan sebagai gabungan linear beberapa elemen dalam kamus konvolusi dan mempunyaikebolehtafsiran teoridankebolehpercayaan biologiyang baik.

Tetapi dalam aplikasi praktikal, model lilitan jarangWalaupun ia berfungsi pada dasarnya, ia tidak berfungsi sebaik yang sepatutnya jika dibandingkan dengan rangkaian dalam yang direka secara empirik Prestasi kelebihan.

Baru-baru ini,Kumpulan penyelidikan Profesor Ma Yimenerbitkan kertas kerja baharu di NeurIPS 2022, mengkaji penggunaan model konvolusi yang jarang dalam klasifikasi imej, dan Ketakpadanan antara empirikal prestasi dan kebolehtafsiran model konvolusi yang jarang berjaya ditangani.

Pautan kertas: https://arxiv.org/pdf/2210.12945.pdf

Pautan kod: https://github.com/Delay-Xili/SDNet

yang dicadangkan dalam artikel boleh Lapisan pengoptimuman mikrodigantikan denganPengekodan Jarang Konvolusi (CSC)terhadap lapisan separa konvolusi standard.

Hasilnya menunjukkan bahawa berbanding dengan rangkaian saraf tradisional, model ini mempunyai prestasi empirikal yang sama kuat pada set data CIFAR-10, CIFAR-100 dan ImageNet.

Dengan mengeksploitasi sifat pemulihan teguh pemodelan jarang, para penyelidik seterusnya menunjukkan bahawa dengan hanya pertukaran yang sesuai yang mudah antara terma regularisasi jarang dan pembinaan semula data, model ini boleh Lebih teguh untuk dimasukkan rasuah dangangguan musuh dalam menguji.

Profesor Ma Yi menerima ijazah sarjana muda berganda dalam automasi dan matematik gunaan dari Universiti Tsinghua pada tahun 1995, dan kemudian belajar di Universiti California, Berkeley , Amerika Syarikat, dan pada tahun 1997 Memperoleh ijazah sarjana dalam EECS, ijazah sarjana dalam matematik dan doktor falsafah dalam EECS pada tahun 2000.

Selepas tamat pengajian, beliau mengajar di Universiti Illinois di Urbana-Champaign dan menjadi profesor madya termuda dalam sejarah Jabatan Kejuruteraan Elektrik dan Komputer.

Pada tahun 2009, beliau berkhidmat sebagai penyelidik kanan dalam Kumpulan Pengkomputeran Visual Microsoft Research Asia. Pada 2014, beliau menyertai Pusat Pengajian Sains dan Teknologi Maklumat ShanghaiTech University sepenuh masa.

Menyertai Universiti California, Berkeley dan Institut Tsinghua-Berkeley Shenzhen pada 2018. Beliau kini merupakan profesor di Jabatan Kejuruteraan Elektrik dan Sains Komputer di University of California, Berkeley, dan juga merupakan Fellow IEEE, Fellow ACM dan Fellow SIAM

Minat penyelidikan Profesor Ma Yi termasuk penglihatan komputer 3D, model berdimensi rendah untuk data berdimensi tinggi, pengoptimuman skalabiliti dan pembelajaran mesin Topik penyelidikan terkini termasuk pembinaan semula geometri 3D berskala besar dan Interaksi dan hubungan antara model dimensi rendah dan rangkaian dalam.

Walaupun rangkaian convolutional deep (ConvNets) sudah menjadi kaedah arus perdana untuk klasifikasi imej dan mengatasi model lain dalam prestasi, komponen dalaman mereka Maksud data khusus bagi konvolusi, fungsi tak linear, dan normalisasi masih belum dijelaskan.

Dan pemodelan data jarang telah digunakan secara meluas dalam banyak isyarat dan pemprosesan imej, disokong oleh keupayaan untuk mempelajari perwakilan yang boleh ditafsir dan jaminan teori yang kukuh (seperti pengendalian data yang rosak), tetapi ia prestasi klasifikasi pada set data seperti ImageNet masih tidak sebaik model mendalam empirikal.

Walaupun model jarang dengan prestasi kukuh masih mempunyai kecacatan:

1) Struktur rangkaian perlu direka khas, yang mengehadkan kebolehgunaan model;

2) Kelajuan pengiraan latihan adalah beberapa urutan magnitud yang lebih perlahan;

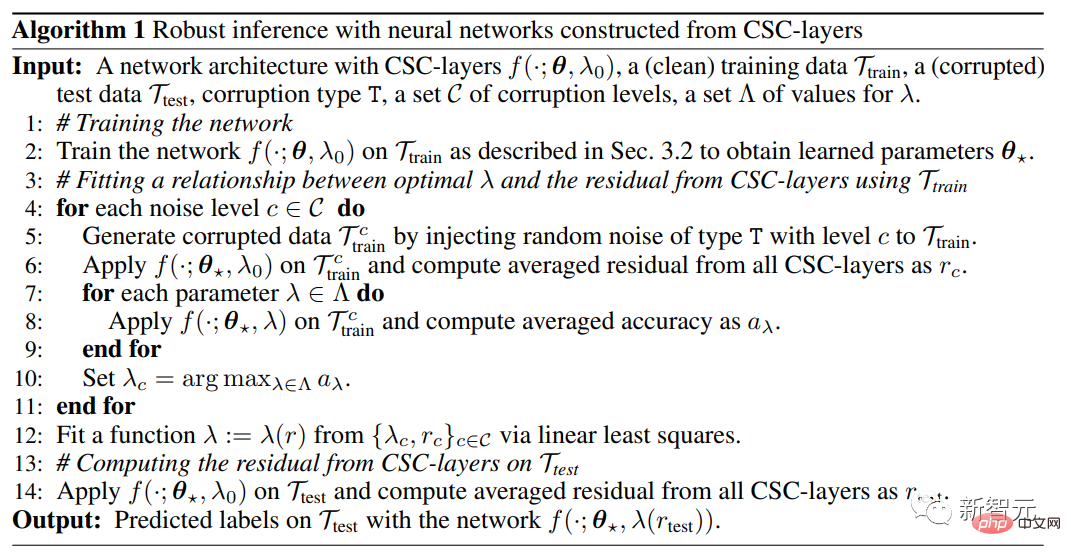

Para penyelidik mencadangkan rangka kerja pengecaman visual dalam kertas kerja ini, membuktikan bahawa pemodelan jarang boleh digabungkan dengan pembelajaran mendalam melalui reka bentuk yang mudah, dengan mengandaikan bahawa input lapisan boleh diwakili oleh semua titik data Diwakili oleh beberapa atom dalam kamus kongsi, ia mencapai prestasi yang sama seperti ConvNets standard sambil mempunyai kebolehtafsiran hierarki dan kestabilan yang lebih baik.

Kaedah ini merangkumi pemodelan jarang dalam lapisan tersirat dan menggunakannya sebagai pengganti untuk lapisan konvolusi dalam ConvNets standard.

Berbanding dengan fungsi eksplisit yang digunakan dalam lapisan bersambung sepenuhnya atau konvolusi klasik, lapisan tersembunyi menggunakan fungsi tersirat. Lapisan tersembunyi dalam kertas ini ditakrifkan berdasarkan masalah pengoptimuman input dan parameter berat lapisan, dan output lapisan tersembunyi adalah penyelesaian kepada masalah pengoptimuman.

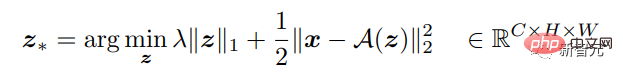

Memandangkan isyarat input berbilang dimensi, fungsi lapisan boleh ditakrifkan untuk melakukan pemetaan terbalik kepada output jarang yang lebih baik Bilangan saluran keluaran boleh berbeza daripada input, supaya perkara di atas boleh didapati Penyelesaian jarang optimum untuk masalah pengoptimuman jenis Lasso.

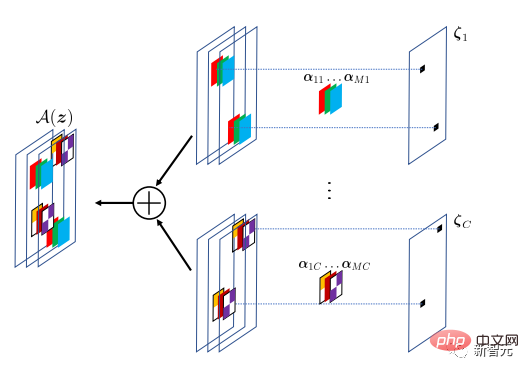

Lapisan tersembunyi ini melaksanakan model pengekodan jarang konvolusi (CSC), di mana isyarat input dianggarkan oleh gabungan linear jarang atom dalam konvolusi. kamus . Kamus konvolusi ini boleh dianggap sebagai parameter lapisan CSC, yang dilatih melalui perambatan belakang.

Matlamat model CSC adalah untuk membina semula isyarat input melalui operator A(z), di mana peta ciri z menentukan penapis lilitan dalam kedudukan dan nilai. Untuk bertolak ansur dengan perbezaan pemodelan, pembinaan semula tidak perlu tepat.

Berdasarkan pemetaan input-output yang ditentukan bagi lapisan CSC, perambatan ke hadapan boleh dilakukan dengan menyelesaikan pengoptimuman yang berkaitan, dan dengan mendapatkan penyelesaian pekali optimum berbanding dengan input x dan parameter Kecerunan A digunakan untuk melakukan perambatan balik.

Kemudian, keseluruhan rangkaian dengan lapisan CSC boleh dilatih daripada data berlabel secara hujung ke hujung dengan meminimumkan kehilangan entropi silang.

Hasil eksperimen

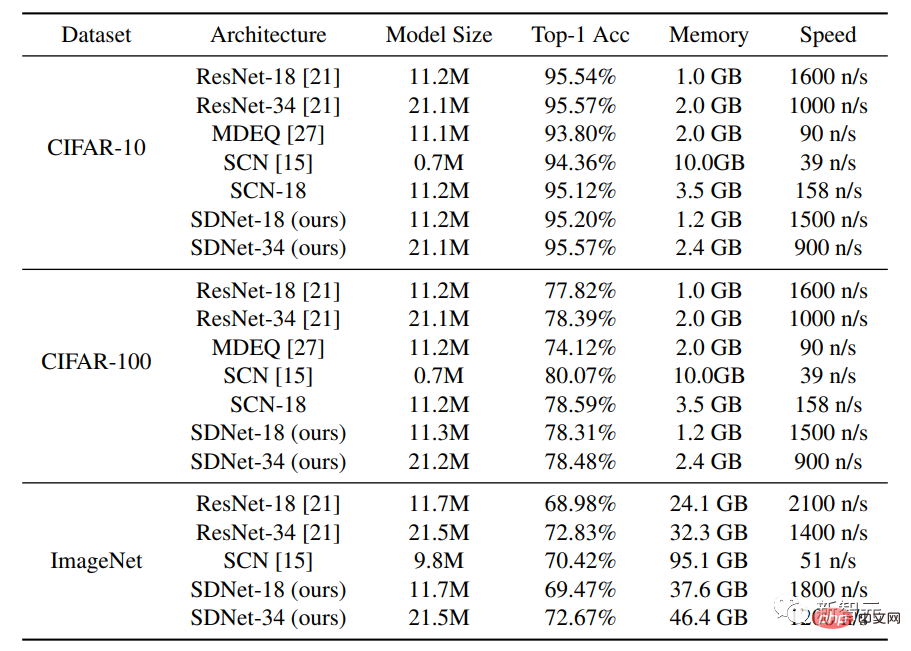

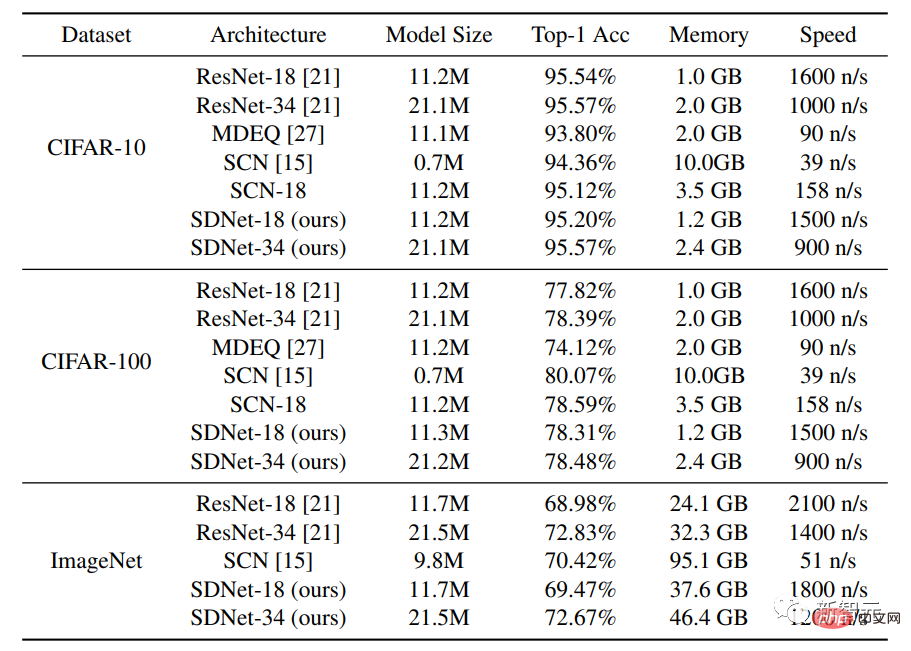

Set data yang digunakan dalam eksperimen ialah CIFAR-10 dan CIFAR-100 Setiap set data mengandungi 50,000 imej latihan dan 10,000 imej ujian Saiz setiap imej ialah 32 ×32 , saluran RGB.

Selain membandingkan kaedah dengan seni bina rangkaian standard ResNet-18 dan ResNet-34, penyelidik juga membandingkannya dengan model MDEQ dengan seni bina lapisan tersembunyi dan SCN dengan seni bina pemodelan jarang. perbandingan.

Keputusan eksperimen dapat dilihat bahawa di bawah skala model yang sama, ketepatan Top-1 SDNet-18/34 adalah sama dengan ketepatan ResNet-18/ 34 adalah serupa atau lebih tinggi, sementara mempunyai kelajuan inferens yang serupa. Hasilnya menunjukkan potensi rangkaian ini sebagai alternatif yang berkuasa kepada model dipacu data sedia ada, kerana model SDNet mempunyai kelebihan tambahan dalam mengendalikan imej yang rosak.

Selepas membandingkan model SDNet-18 dengan model MDEQ dengan saiz model yang serupa, didapati bahawa SDNet-18 bukan sahaja lebih tepat daripada MDEQ, tetapi juga lebih pantas (>7 kali). Perlu diingatkan bahawa MDEQ tidak boleh mengendalikan data yang rosak seperti SDNet.

Rangkaian SCN, yang juga menggunakan pemodelan jarang, telah mencapai ketepatan Top-1, tetapi kelemahan penting SCN ialah kelajuan latihannya sangat perlahan Sebabnya mungkin SCN itu menggunakan imej Berbanding dengan model pengekodan jarang konvolusi, ia perlu menyelesaikan lebih banyak masalah pengekodan yang jarang dalam setiap perambatan ke hadapan dan tidak boleh mendapat manfaat daripada pengkomputeran selari.

Inferens teguh mengendalikan gangguan input

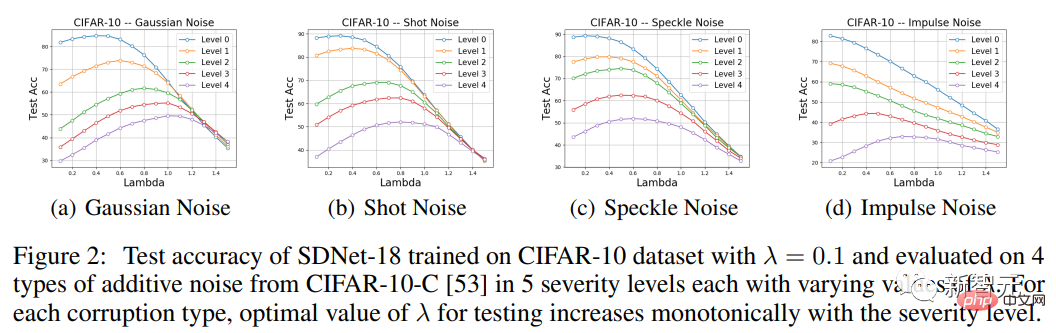

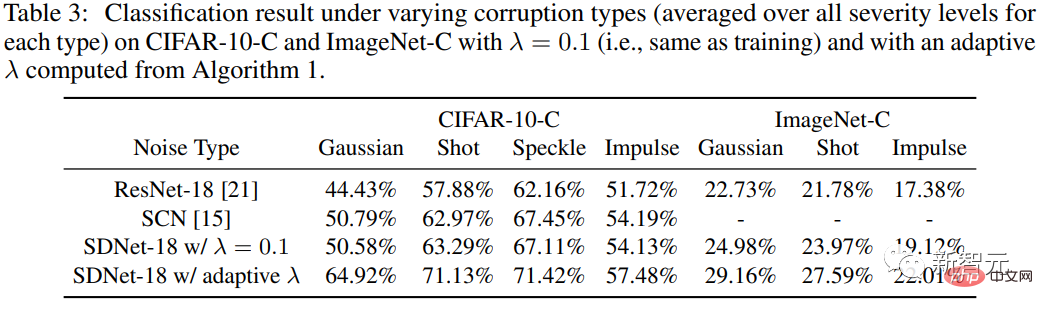

Untuk menguji keteguhan kaedah terhadap gangguan input, penyelidik menggunakan Kami membentangkan Dataset CIFAR-10-C, yang mana data itu rosak oleh pelbagai jenis hingar sintetik dan keparahan yang berbeza-beza.

Memandangkan lapisan CSC dalam model menghukum perbezaan masukan antara isyarat input dan isyarat yang dibina semula, SDNet secara teorinya sepatutnya lebih sesuai untuk mengendalikan bunyi tambahan.

Jadi bahagian eksperimen terutamanya tertumpu kepada empat jenis bunyi tambahan dalam CIFAR-10-C iaitu Gaussian noise, shot noise, speckle noise dan bunyi impuls, kemudian nilaikan ketepatan SDNet-18 dan bandingkan prestasinya dengan ResNet-18.

Ia boleh dilihat bahawa untuk pelbagai jenis hingar dan keterukan yang berbeza (kecuali hingar impuls tahap 0, 1 dan 2), sesuai Memilih nilai lambda yang berbeza daripada yang digunakan semasa latihan boleh membantu meningkatkan prestasi ujian.

Khususnya, lengkung ketepatan sebagai fungsi λ mempamerkan bentuk unimodal, dengan prestasi mula-mula meningkat dan kemudian menurun. Tambahan pula, dalam setiap jenis rasuah data, nilai λ di mana puncak prestasi dicapai meningkat secara monoton dengan peningkatan keterukan rasuah, pemerhatian yang konsisten dengan jangkaan.

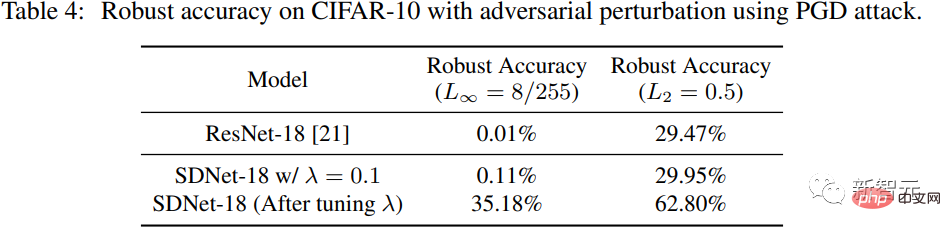

Mengendalikan gangguan musuh

Para penyelidik menggunakan PGD pada SDNet (λ =0.1) Menjana gangguan musuh, L ∞ paradigma gangguan ialah 8/255, dan paradigma L2 bagi gangguan ialah 0.5.

Berbanding dengan ResNet-18, kita dapat melihat bahawa apabila λ=0.1, Prestasi SDNet tidak jauh lebih baik daripada ResNet, tetapi ketepatan keteguhan boleh dipertingkatkan dengan melaraskan parameter λ.

Atas ialah kandungan terperinci 'Pengekodan jarang' bergerak dari teori kepada amalan! Kerja baharu Profesor Ma Yi dalam NeurIPS 2022: Prestasi konvolusi dan kekukuhan jarang mengatasi ResNet. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Kaedah pengekodan biasa

Kaedah pengekodan biasa Analisis prospek syiling ICP

Analisis prospek syiling ICP Apakah yang dimaksudkan untuk menyambung ke tingkap?

Apakah yang dimaksudkan untuk menyambung ke tingkap? Bagaimana untuk menetapkan nombor halaman dalam perkataan

Bagaimana untuk menetapkan nombor halaman dalam perkataan Bagaimana untuk menyelesaikan masalah skrin hitam selepas menghidupkan komputer dan tidak dapat memasuki desktop

Bagaimana untuk menyelesaikan masalah skrin hitam selepas menghidupkan komputer dan tidak dapat memasuki desktop apakah fail iso

apakah fail iso Apakah itu pemalam penyemak imbas

Apakah itu pemalam penyemak imbas Penyelesaian kepada tandatangan tidak sah

Penyelesaian kepada tandatangan tidak sah