Pautan kertas: https://arxiv.org/abs/2203.12602

Kod dan pemberat pra-latihan telah disumberkan secara terbuka di Github: https://github.com/MCG-NJU/VideoMAE

Direktori1 . Pengenalan latar belakang

2. Motivasi penyelidikan

3 Pengenalan kaedah

4. Eksperimen ablasi

6 >8. Kesan komuniti

9. Ringkasan

Pengenalan latar belakang

Pengiktirafan Tindakan: Klasifikasikan video dipangkas yang diberikan (Video Dipangkas) dan kenal pasti tindakan watak dalam video ini. Kaedah arus perdana semasa ialah berasaskan 2D (TSN, TSM, TDN, dsb.), berasaskan 3D (I3D, SlowFast, dsb.) dan berasaskan Transformer (TimeSformer, ViViT, MViT, VideoSwin, dsb.). Sebagai tugas asas dalam medan video, pengecaman tindakan sering digunakan sebagai rangkaian tulang belakang (Backbone) untuk pelbagai tugas hiliran dalam medan video (seperti pengesanan tingkah laku temporal, pengesanan tindakan spatiotemporal) untuk mengekstrak ciri spatiotemporal pada keseluruhan peringkat video atau pada peringkat klip video.

Pengesanan Tindakan: Tugas ini bukan sahaja memerlukan klasifikasi tindakan video, mengenal pasti tindakan watak dalam video, tetapi juga menggunakan kotak sempadan dalam ruang) menandakan kedudukan spatial watak. Pengesanan tindakan mempunyai pelbagai senario aplikasi dalam analisis video filem, analisis video sukan dan senario lain.

Motivasi penyelidikan

Walau bagaimanapun, Vision Transformer perlu menggunakan set data berlabel berskala besar untuk latihan. Pada mulanya, ViT asal (Vanilla Vision Transformer) mencapai prestasi yang baik melalui pra-latihan diselia menggunakan ratusan juta imej berlabel. Pengubah Video Semasa biasanya berdasarkan model Pengubah Penglihatan yang dilatih pada data imej (seperti TimeSformer, ViViT, dsb.) dan bergantung pada model data imej berskala besar yang telah terlatih (seperti ImageNet-1K, ImageNet-21K, JFT- 300M, dsb.). TimeSformer dan ViViT telah cuba melatih model Video Transformer dari awal dalam set data video, tetapi mereka tidak dapat mencapai hasil yang memuaskan. Oleh itu, cara melatih Video Transformer secara berkesan, terutamanya ViT asal (Vanilla Vision Transformer), secara langsung pada set data video tanpa menggunakan mana-mana model pra-latihan lain atau data imej tambahan masih menjadi masalah mendesak untuk diselesaikan . Perlu diingatkan bahawa set data video sedia ada agak kecil berbanding set data imej. Sebagai contoh, set data Kinectics-400 yang digunakan secara meluas hanya mempunyai lebih daripada 200,000 sampel latihan Bilangan sampel adalah kira-kira 1/50 daripada set data ImageNet-21K dan 1/1500 daripada set data JFT-300M jurang beberapa urutan magnitud. Pada masa yang sama, berbanding dengan melatih model imej, overhed pengiraan untuk melatih model video juga jauh lebih tinggi. Ini meningkatkan lagi kesukaran melatih Video Transformer pada set data video.

Baru-baru ini, paradigma latihan penyeliaan kendiri "menopeng-dan-pembinaan semula" telah dicapai dalam pemprosesan bahasa semula jadi (BERT) dan pemahaman imej (BEiT, MAE) mencapai kejayaan. Oleh itu, kami cuba menggunakan paradigma penyeliaan sendiri ini untuk melatih Video Transformer pada set data video dan mencadangkan algoritma pralatihan sendiri video VideoMAE (Video MAE) berdasarkan tugas proksi masking-and-reconstruction Autoencoder ). Model ViT yang telah dilatih oleh VideoMAE boleh mencapai hasil yang jauh lebih baik daripada kaedah lain pada set data video yang lebih besar seperti Kinetics-400 dan Something-Something V2, serta set data video yang agak kecil seperti UCF101 dan HMDB51.

MAE mengguna pakai seni bina pengekod-penyahkod asimetri untuk ramalan penyeliaan sendiri bagi tugasan latihan penyamaran dan pembinaan semula. Imej input beresolusi 224x224 mula-mula dibahagikan kepada blok (token) piksel visual tidak bertindih bersaiz 16 × 16. Setiap blok piksel (token) ditukar kepada ciri berdimensi tinggi melalui operasi pembenaman blok (benam token). MAE menggunakan nisbah topeng yang lebih tinggi (75%) untuk menutup beberapa blok piksel (token) secara rawak. Selepas operasi penyamaran, blok piksel yang tinggal dihantar ke pengekod untuk pengekstrakan ciri. Sejurus selepas itu, blok ciri yang diekstrak oleh pengekod disambungkan dengan bahagian lain daripada blok piksel boleh dipelajari yang dipratetap (token boleh dipelajari) untuk membentuk ciri yang sebesar saiz imej input asal. Akhir sekali, penyahkod ringan digunakan untuk membina semula imej asal berdasarkan ciri ini (dalam percubaan sebenar, sasaran pembinaan semula ialah blok piksel ternormal (token ternormal).

Berbanding dengan data imej, data video mengandungi lebih banyak bingkai dan mempunyai maklumat gerakan yang lebih kaya. Mari kita lihat ciri-ciri data video

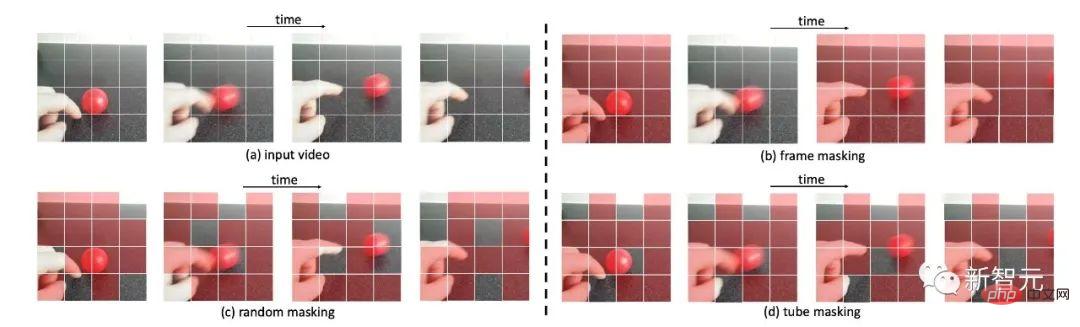

Contoh strategi penyamaran yang berbeza untuk data video

Video data mengandungi bingkai imej yang padat, dan maklumat semantik yang terkandung dalam bingkai imej ini berubah dengan sangat perlahan dari semasa ke semasa menyebabkan dua masalah dalam proses melaksanakan MAE Pertama, kecekapan latihan dikurangkan jika kadar bingkai padat video asal (seperti 30 FPS) akan menjadi sangat rendah kepada ciri penampilan statik dalam data atau beberapa ciri gerakan tempatan yang berubah secara perlahan Kedua, redundansi temporal dalam video akan mencairkan ciri gerakan dalam video Oleh itu, keadaan ini menjadikan tugas untuk membina semula tompok piksel bertopeng agak mudah kadar topeng biasa (cth., 50% hingga 75%) Masalah ini akan menjejaskan pra-latihan Backbone sebagai pengekod ciri diekstrak dalam proses

Video boleh dianggap sebagai dihasilkan oleh evolusi imej statik dari semasa ke semasa Terdapat juga korespondensi semantik antara bingkai video Jika strategi penyamaran tidak direka khusus, korelasi temporal ini boleh meningkatkan risiko "kebocoran maklumat" semasa proses pembinaan semula Secara khusus, seperti yang ditunjukkan dalam rajah, jika Menggunakan topeng rawak global atau bingkai imej bertopeng secara rawak, rangkaian boleh mengeksploitasi korelasi temporal dalam video untuk melakukan pembinaan semula blok dengan "menyalin dan menampal" tanpa terhalang. blok piksel pada kedudukan temporal yang sepadan dalam bingkai bersebelahan Tugas ejen juga boleh diselesaikan pada tahap tertentu, tetapi ia boleh menyebabkan VideoMAE hanya mempelajari ciri surat-menyurat temporal semantik yang lebih rendah dan bukannya maklumat semantik abstrak peringkat tinggi, seperti keupayaan penaakulan spatiotemporal untuk. kandungan video. Untuk mengurangkan keadaan ini, strategi penyamaran baharu perlu direka untuk menjadikan tugas pembinaan semula lebih mencabar, supaya rangkaian dapat mempelajari perwakilan ciri spatiotemporal dalam video >Pengenalan kepada kaedah VideoMAE

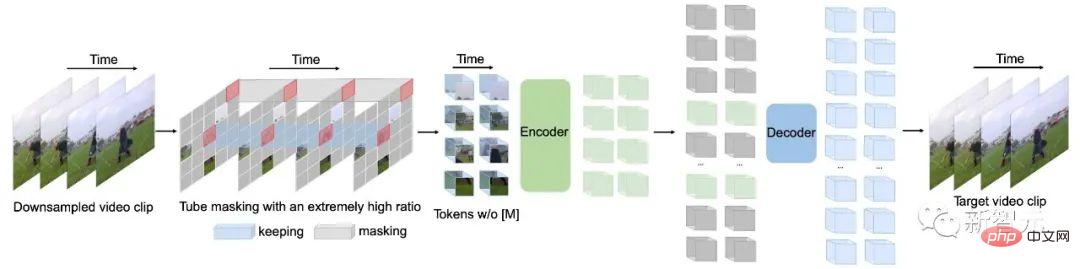

Rangka kerja keseluruhan VideoMAE

Rangka kerja keseluruhan VideoMAE

Untuk menyelesaikan proses pra-latihan video dalam artikel sebelumnya Untuk menangani masalah yang mungkin dihadapi apabila menggunakan tugas menutup dan membina semula, kami memperkenalkan beberapa reka bentuk baharu dalam VideoMAE.

Menurut analisis sebelumnya tentang lebihan temporal yang wujud dalam bingkai berterusan padat dalam video, kami memilih untuk menggunakan selang masa dalam strategi pensampelan VideoMAE untuk menjalankan video pra-latihan penyeliaan kendiri yang lebih cekap. Khususnya, segmen video yang terdiri daripada $t$ bingkai berturut-turut mula-mula diambil secara rawak daripada video asal. Klip video kemudiannya dimampatkan ke dalam bingkai menggunakan pensampelan dijarakkan sementara, setiap satu mengandungi  piksel. Dalam tetapan percubaan khusus, selang persampelan pada set data Kinetics-400 dan Something-Something V2 ditetapkan kepada 4 dan 2 masing-masing.

piksel. Dalam tetapan percubaan khusus, selang persampelan pada set data Kinetics-400 dan Something-Something V2 ditetapkan kepada 4 dan 2 masing-masing.

Sebelum input kepada pengekod, untuk klip video sampel, blok piksel diproses dalam bentuk spatio -Benam sendi temporal. Khususnya, piksel visual bersaiz  dalam klip video bersaiz

dalam klip video bersaiz  dianggap sebagai satu blok piksel visual. Oleh itu, selepas klip video sampel melepasi lapisan pembenaman blok ruang-masa (benam kiub),

dianggap sebagai satu blok piksel visual. Oleh itu, selepas klip video sampel melepasi lapisan pembenaman blok ruang-masa (benam kiub),  blok piksel visual boleh diperolehi. Dalam proses ini, dimensi saluran blok piksel visual juga akan dipetakan. Reka bentuk ini boleh mengurangkan saiz dimensi spatiotemporal data input, dan juga membantu mengurangkan redundansi spatiotemporal data video pada tahap tertentu.

blok piksel visual boleh diperolehi. Dalam proses ini, dimensi saluran blok piksel visual juga akan dipetakan. Reka bentuk ini boleh mengurangkan saiz dimensi spatiotemporal data input, dan juga membantu mengurangkan redundansi spatiotemporal data video pada tahap tertentu.

Untuk menyelesaikan masalah yang disebabkan oleh redundansi sementara dan Untuk menyelesaikan "kebocoran maklumat" masalah yang disebabkan oleh korelasi temporal, kaedah ini memilih untuk menggunakan strategi penutup saluran paip dalam proses pra-latihan yang diselia sendiri. Strategi penyamaran saluran paip secara semula jadi boleh memanjangkan kaedah penyamaran imej warna bingkai tunggal kepada keseluruhan jujukan video, iaitu, blok piksel visual pada lokasi spatial yang sama dalam bingkai berbeza akan bertopeng. Secara khusus, strategi penutup saluran paip boleh dinyatakan sebagai . Masa yang berbeza t berkongsi nilai yang sama. Menggunakan strategi penyamaran ini, token di lokasi spatial yang sama akan sentiasa bertopeng. Jadi untuk beberapa tampung piksel visual (cth., tampung piksel yang mengandungi jari dalam baris 4 contoh imej strategi penyamaran yang berbeza), rangkaian tidak akan dapat mencari bahagian yang sepadan dalam bingkai lain. Reka bentuk ini membantu mengurangkan risiko "kebocoran maklumat" semasa proses pembinaan semula, membolehkan VideoMAE membina semula token bertopeng dengan mengekstrak maklumat semantik peringkat tinggi daripada klip video asal.

Berbanding dengan data imej, data video mempunyai lebihan yang lebih kuat dan ketumpatan maklumat data video jauh lebih rendah daripada imej. Ciri ini membolehkan VideoMAE menggunakan kadar topeng yang sangat tinggi (cth. 90% hingga 95%) untuk pra-latihan. Perlu diingat bahawa kadar topeng lalai MAE ialah 75%. Keputusan eksperimen menunjukkan bahawa menggunakan kadar topeng yang sangat tinggi bukan sahaja dapat mempercepatkan pra-latihan (hanya 5% hingga 10% blok piksel visual dimasukkan ke pengekod), tetapi juga meningkatkan keupayaan perwakilan model dan kesan di hiliran tugasan.

Seperti yang dinyatakan sebelum ini, VideoMAE menggunakan kadar penyamaran yang sangat tinggi dan hanya mengekalkan sedikit token sebagai input kepada pengekod. Untuk mengekstrak dengan lebih baik ciri spatiotemporal bahagian token yang tidak terhalang ini, VideoMAE memilih untuk menggunakan ViT asal sebagai Tulang Belakang, dan pada masa yang sama menggunakan perhatian kendiri sendi spatiotemporal dalam lapisan perhatian (iaitu, struktur model ViT asal tidak diubah). Oleh itu semua token yang tidak terhalang boleh berinteraksi antara satu sama lain dalam lapisan perhatian diri. Kerumitan pengiraan tahap  mekanisme perhatian kendiri bersama spatio-temporal ialah kesesakan pengiraan rangkaian Dalam artikel sebelumnya, strategi nisbah topeng yang sangat tinggi telah digunakan untuk VideoMAE, dan hanya token yang tidak bertopeng (seperti 10%) dimasukkan ke dalam pengekod. Reka bentuk ini berkesan boleh mengurangkan masalah kerumitan pengiraan tahap

mekanisme perhatian kendiri bersama spatio-temporal ialah kesesakan pengiraan rangkaian Dalam artikel sebelumnya, strategi nisbah topeng yang sangat tinggi telah digunakan untuk VideoMAE, dan hanya token yang tidak bertopeng (seperti 10%) dimasukkan ke dalam pengekod. Reka bentuk ini berkesan boleh mengurangkan masalah kerumitan pengiraan tahap  ke tahap tertentu.

ke tahap tertentu.

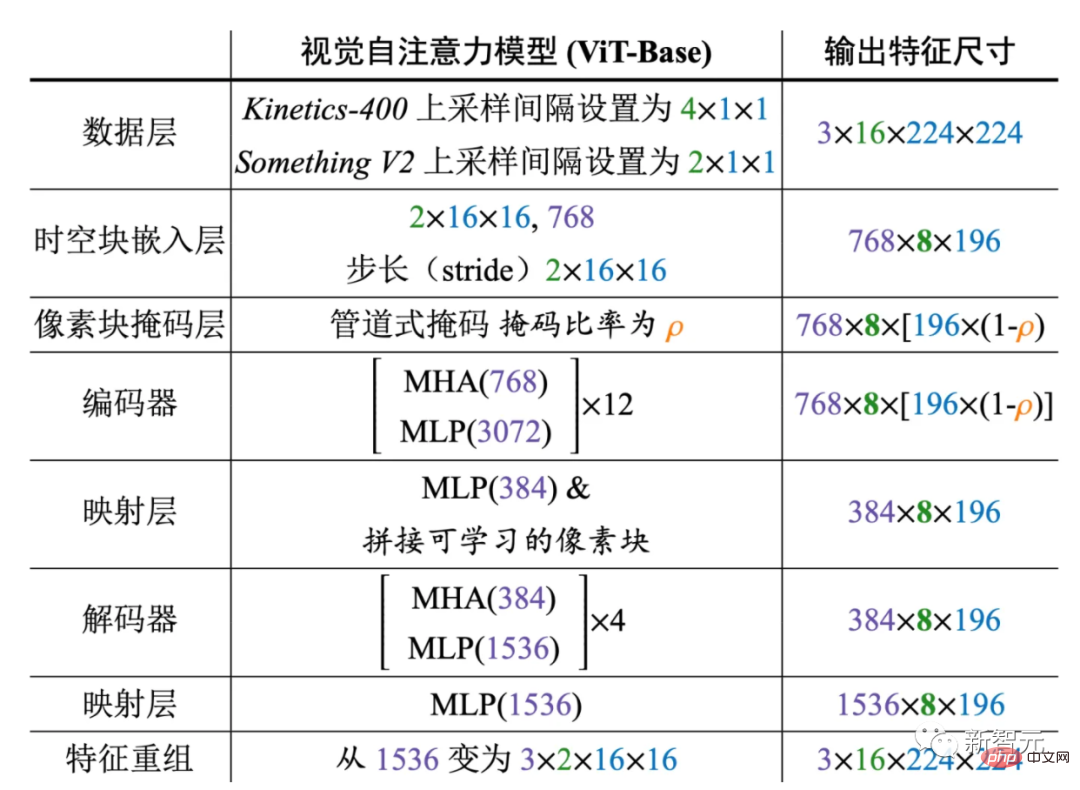

Butiran reka bentuk khusus rangka kerja VideoMAE

Rajah di atas menunjukkan reka bentuk seni bina khusus pengekod dan penyahkod yang digunakan oleh VideoMAE (mengambil ViT-B sebagai contoh). Kami menilai VideoMAE pada empat set data pengecaman tindakan video hiliran dan satu set data pengesanan tindakan. Set data ini memfokuskan pada pelbagai aspek maklumat gerakan dalam video. Kinetics-400 ialah set data video YouTube berskala besar yang mengandungi kira-kira 300,000 klip video yang dipangkas meliputi 400 kategori tindakan yang berbeza. Set data Kinetics-400 terutamanya mengandungi aktiviti dalam kehidupan seharian, dan beberapa kategori sangat berkorelasi dengan objek interaktif atau maklumat pemandangan. Video dalam set data Something-Something V2 terutamanya mengandungi objek berbeza yang melakukan tindakan yang sama, jadi pengecaman tindakan dalam set data ini lebih memfokuskan pada atribut gerakan dan bukannya maklumat objek atau pemandangan. Set latihan mengandungi kira-kira 170,000 klip video, dan set pengesahan mengandungi kira-kira 25,000 klip video. UCF101 dan HMDB51 ialah dua set data pengecaman tindakan video yang agak kecil. Set latihan UCF101 mengandungi kira-kira 9500 video, dan set latihan HMDB51 mengandungi kira-kira 3500 video. Semasa percubaan, kami mula-mula menggunakan VideoMAE untuk melakukan pra-latihan penyeliaan sendiri pada rangkaian pada set latihan, kemudian melakukan penalaan halus penyeliaan pengekod (ViT) pada set latihan, dan akhirnya menilai prestasi model pada set pengesahan. Untuk set data pengesanan tindakan AVA, kami akan memuatkan model yang dilatih pada set data Kinetics-400 terlebih dahulu dan melakukan penalaan halus penyeliaan pengekod (ViT).

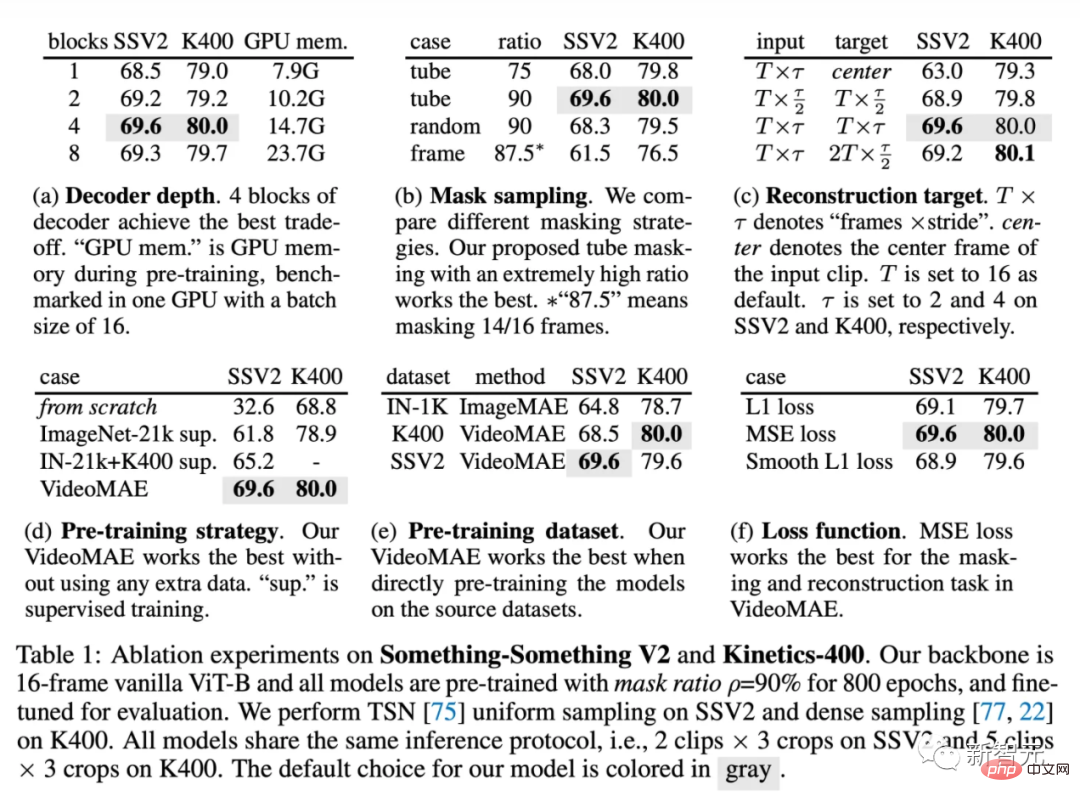

Bahagian ini menjalankan eksperimen ablasi pada VideoMAE pada set data Something-Something V2 dan Kinetics-400. Percubaan ablasi menggunakan model ViT asal dengan 16 bingkai input secara lalai. Pada masa yang sama, apabila menilai selepas penalaan halus, 2 klip video dan 3 tanaman telah dipilih untuk ujian pada Sesuatu-Sesuatu V2, dan 5 klip video dan 3 tanaman telah dipilih untuk ujian pada Kinetics-400.

Penyahkod ringan ialah Vide Satu komponen utama dalam oMAE. Keputusan eksperimen menggunakan penyahkod dengan kedalaman yang berbeza ditunjukkan dalam Jadual (a). Tidak seperti MAE, penyahkod yang lebih dalam dalam VideoMAE boleh mencapai prestasi yang lebih baik, manakala penyahkod yang lebih cetek boleh mengurangkan penggunaan memori GPU dengan berkesan. Bilangan lapisan penyahkod ditetapkan kepada 4 secara lalai. Mengikut reka bentuk empirikal MAE, lebar saluran penyahkod dalam VideoMAE ditetapkan kepada separuh daripada lebar saluran pengekod (contohnya, apabila ViT-B digunakan sebagai pengekod, lebar saluran penyahkod ditetapkan kepada 384 ).

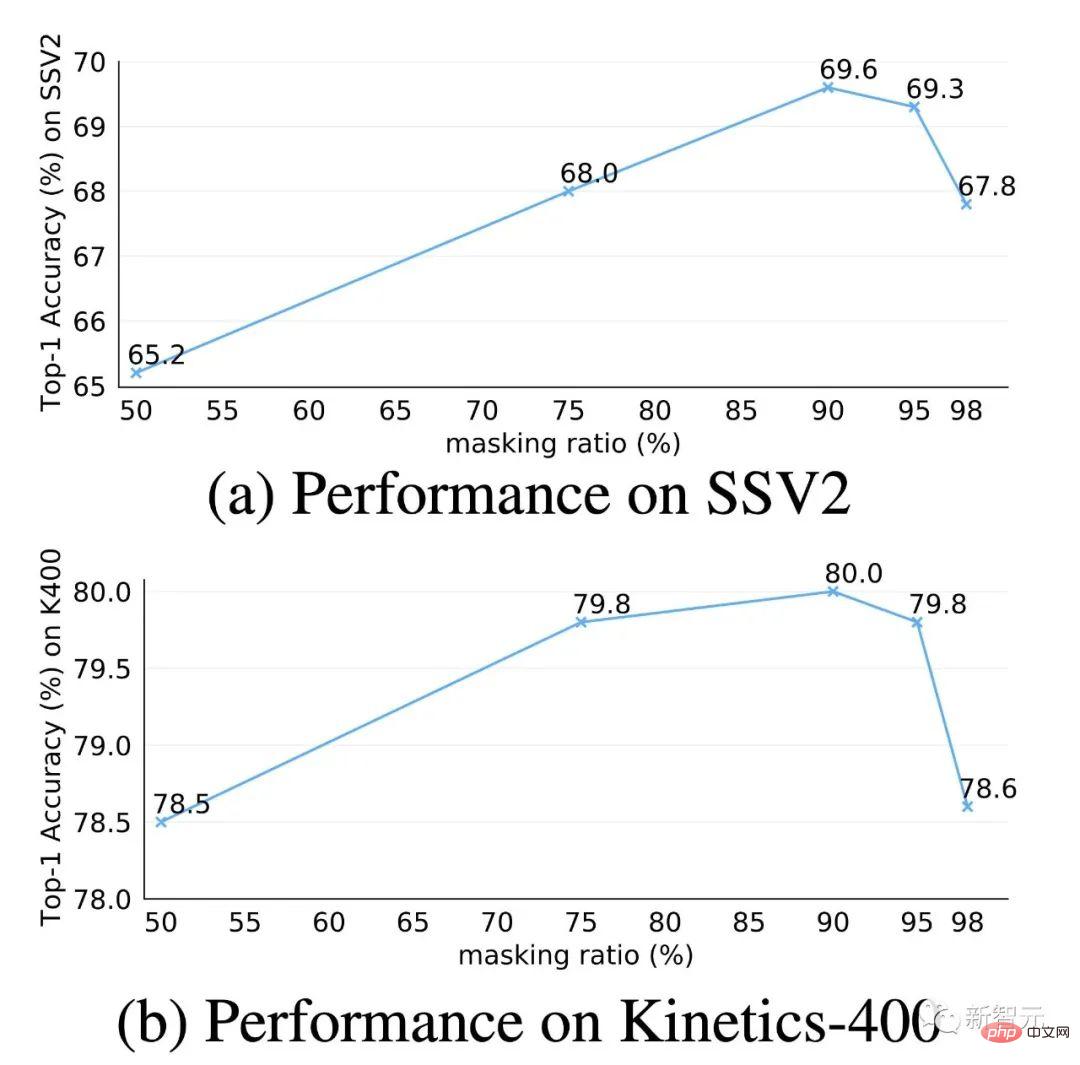

Bandingkan strategi penyamaran yang berbeza dengan strategi penyamaran saluran paip menggunakan nisbah penyamaran 75%. Seperti yang ditunjukkan dalam Jadual (b), prestasi topeng rawak global dan bingkai imej pelekat rawak adalah lebih teruk daripada strategi penutup saluran paip. Ini mungkin disebabkan oleh fakta bahawa strategi penutup saluran paip boleh mengurangkan lebihan masa dan korelasi pemasaan dalam data video pada tahap tertentu. Jika nisbah topeng dinaikkan kepada 90%, prestasi VideoMAE pada Something-Something boleh dipertingkatkan lagi daripada 68.0% kepada 69.6%. Reka bentuk strategi penyamaran dan nisbah penyamaran dalam VideoMAE boleh menjadikan penyamaran serta pembinaan semula sebagai tugas proksi yang lebih mencabar, memaksa model untuk mempelajari ciri spatiotemporal peringkat lebih tinggi.

Sasaran pembinaan semula dalam VideoMAE dibandingkan di sini, dan hasilnya adalah dalam Jadual (c). Pertama, prestasi VideoMAE dalam tugas hiliran akan berkurangan dengan ketara jika hanya bingkai tengah dalam klip video digunakan sebagai sasaran pembinaan semula. Pada masa yang sama, VideoMAE juga sangat sensitif terhadap selang persampelan. Jika anda memilih untuk membina semula klip video yang lebih padat, hasilnya akan jauh lebih rendah daripada klip video lalai yang dikurangkan secara sementara. Akhir sekali, kami juga cuba membina semula bingkai yang lebih padat dalam klip video daripada klip video yang dikurangkan secara sementara, tetapi tetapan ini memerlukan penyahkodan lebih banyak bingkai, menjadikan latihan lebih perlahan dan tidak begitu berkesan.

Strategi pra-latihan dalam VideoMAE dibandingkan di sini, dan hasilnya ditunjukkan dalam Jadual (d). Sama seperti kesimpulan percubaan kaedah sebelumnya (TimeSformer, ViViT), melatih ViT dari awal pada Something-Something V2, set data yang lebih sensitif kepada maklumat gerakan, tidak dapat mencapai hasil yang memuaskan. Jika model ViT pra-latihan pada set data imej berskala besar (ImageNet-21K) digunakan sebagai permulaan, ketepatan yang lebih baik boleh diperolehi, yang boleh dipertingkatkan daripada 32.6% kepada 61.8%. Menggunakan model yang telah dilatih pada ImageNet-21K dan Kinetics-400 meningkatkan lagi ketepatan kepada 65.2%. ViT, yang telah dilatih daripada set data video itu sendiri menggunakan VideoMAE, akhirnya boleh mencapai prestasi terbaik sebanyak 69.6% tanpa menggunakan sebarang data tambahan. Kesimpulan yang sama telah dicapai pada Kinetics-400.

Set data pra-latihan dalam VideoMAE dibandingkan di sini, dan hasilnya ditunjukkan dalam Jadual (e ). Pertama, mengikut tetapan MAE, ViT diselia sendiri dengan pra-latihan pada ImageNet-1K selama 1600 zaman. Lapisan pembenaman blok 2D kemudiannya dilambungkan ke dalam lapisan pembenaman blok spatiotemporal 3D menggunakan strategi dalam I3D, dan model itu diperhalusi pada set data video. Paradigma latihan ini boleh mengatasi model terlatih yang diselia dari awal. Seterusnya, prestasi model pralatihan MAE dibandingkan dengan model ViT pralatihan VideoMAE pada Kinetics-400. Ia boleh didapati bahawa VideoMAE boleh mencapai prestasi yang lebih baik daripada MAE. Walau bagaimanapun, kedua-dua model pra-latihan gagal mencapai prestasi yang lebih baik daripada VideoMAE, yang hanya pra-latihan diselia sendiri pada set data Something-Something V2. Ia boleh dianalisis bahawa perbezaan domain antara set data pra-latihan dan set data sasaran mungkin menjadi isu penting.

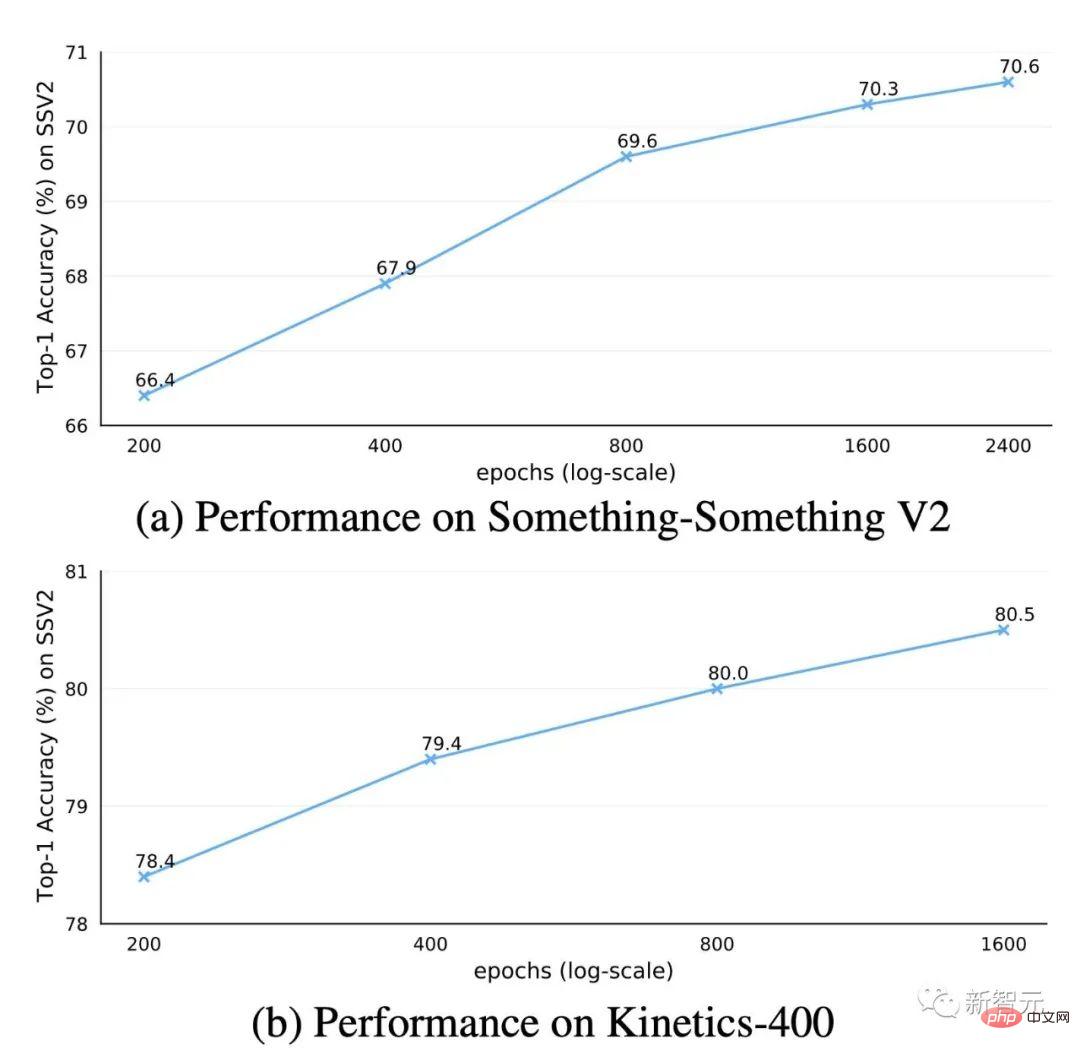

Jumlah pusingan pra-latihan dalam VideoMAE Impact

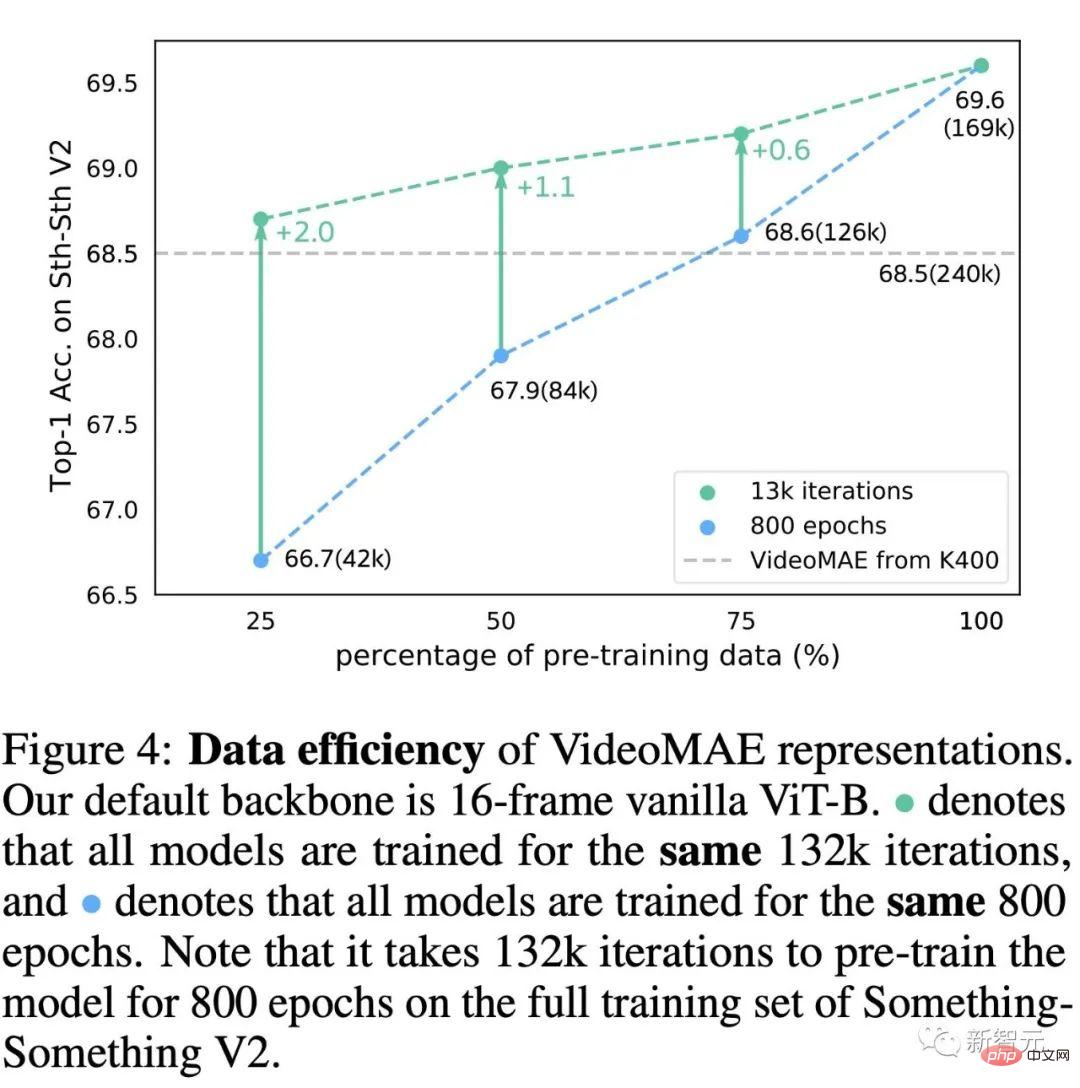

Dalam percubaan ablasi, jumlah bilangan zaman untuk pra-latihan VideoMAE ditetapkan kepada 800 secara lalai. Kami cuba menjalankan penerokaan mendalam tentang zaman pra-latihan pada set data Kinetics-400 dan Something-Something V2. Mengikut keputusan dalam rajah, menggunakan zaman pra-latihan yang lebih lama membawa kepada keuntungan yang konsisten pada kedua-dua set data.

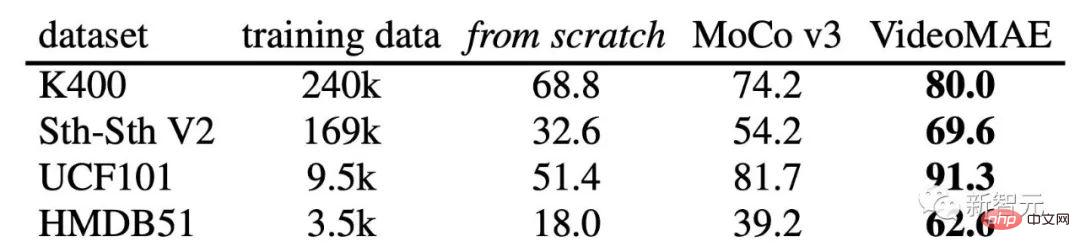

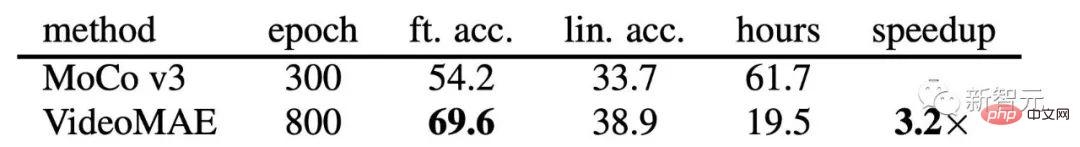

Perbandingan prestasi antara VideoMAE dan MoCov3 pada set data pengecaman tindakan video hiliran yang berbeza

Banyak karya terdahulu telah menjalankan penyelidikan meluas tentang video pra-latihan yang diselia sendiri, tetapi kaedah ini terutamanya menggunakan rangkaian saraf konvolusi sebagai Tulang Belakang, dan terdapat beberapa kaedah untuk mengkaji mekanisme latihan berasaskan ViT. Oleh itu, untuk mengesahkan keberkesanan VideoMAE berasaskan ViT untuk pra-latihan kendiri video, kami membandingkan dua kaedah latihan berasaskan ViT: (1) latihan model yang diselia dari awal, (2) menggunakan kaedah pembelajaran kontrastif (MoCo v3) Lakukan pra-latihan yang diselia sendiri. Mengikut keputusan eksperimen, boleh didapati bahawa VideoMAE jauh lebih baik daripada dua kaedah latihan yang lain. Contohnya, pada set data Kinetics-400, yang mempunyai saiz data terbesar, VideoMAE adalah kira-kira 10% lebih tepat daripada latihan dari awal dan kira-kira 6% lebih tinggi daripada keputusan pra-latihan MoCo v3. Prestasi cemerlang VideoMAE menunjukkan bahawa paradigma penyeliaan kendiri masking-and-construction menyediakan ViT dengan mekanisme pra-latihan

yang cekap. Pada masa yang sama, perlu diperhatikan bahawa apabila set latihan menjadi lebih kecil, jurang prestasi antara VideoMAE dan dua kaedah latihan yang lain menjadi lebih besar dan lebih besar. Perlu diingat bahawa walaupun set data HMDB51 hanya mengandungi kira-kira 3500 klip video, model pra-latihan berdasarkan VideoMAE masih boleh mencapai ketepatan yang sangat memuaskan. Keputusan baharu ini menunjukkan bahawa VideoMAE ialah pelajar yang cekap data. Ini berbeza daripada pembelajaran kontrastif, yang memerlukan sejumlah besar data untuk pra-latihan. Ciri cekap data VideoMAE amat penting dalam senario di mana data video adalah terhad.

Analisis kecekapan VideoMAE dan MoCov3 pada dataset Something-SomethingV2

Kami juga membandingkan kecekapan pengiraan pra-latihan menggunakan VideoMAE dan pra-latihan menggunakan MoCo v3. Disebabkan oleh tugas proksi yang sangat mencabar untuk menutup dan membina semula, rangkaian hanya boleh memerhati 10% daripada data input (90% daripada token bertopeng) dalam setiap lelaran, jadi VideoMAE memerlukan lebih banyak pusingan latihan. Bahagian token yang sangat tinggi dikaburkan Reka bentuk ini sangat menjimatkan penggunaan pengiraan dan masa pra-latihan. Pra-latihan VideoMAE untuk 800 pusingan hanya mengambil masa 19.5 jam, manakala pra-latihan MoCo v3 untuk 300 pusingan mengambil masa 61.7 jam.

Kesan nisbah penyamaran dalam VideoMAE

Kadar topeng yang sangat tinggi adalah salah satu reka bentuk teras dalam VideoMAE. Kami menjalankan penerokaan mendalam reka bentuk ini pada set data Kinetics-400 dan Something-Something V2. Mengikut keputusan dalam rajah, apabila nisbah topeng adalah sangat tinggi, malah 95%, rangkaian masih menunjukkan prestasi cemerlang pada dua set data penting ini untuk tugas pengecaman tindakan video hiliran. Fenomena ini sangat berbeza daripada BERT dalam pemprosesan bahasa semula jadi dan MAE untuk imej. Kewujudan redundansi temporal dan korelasi temporal dalam data video membolehkan VideoMAE beroperasi dengan nisbah topeng yang sangat tinggi berbanding data imej dan bahasa semula jadi.

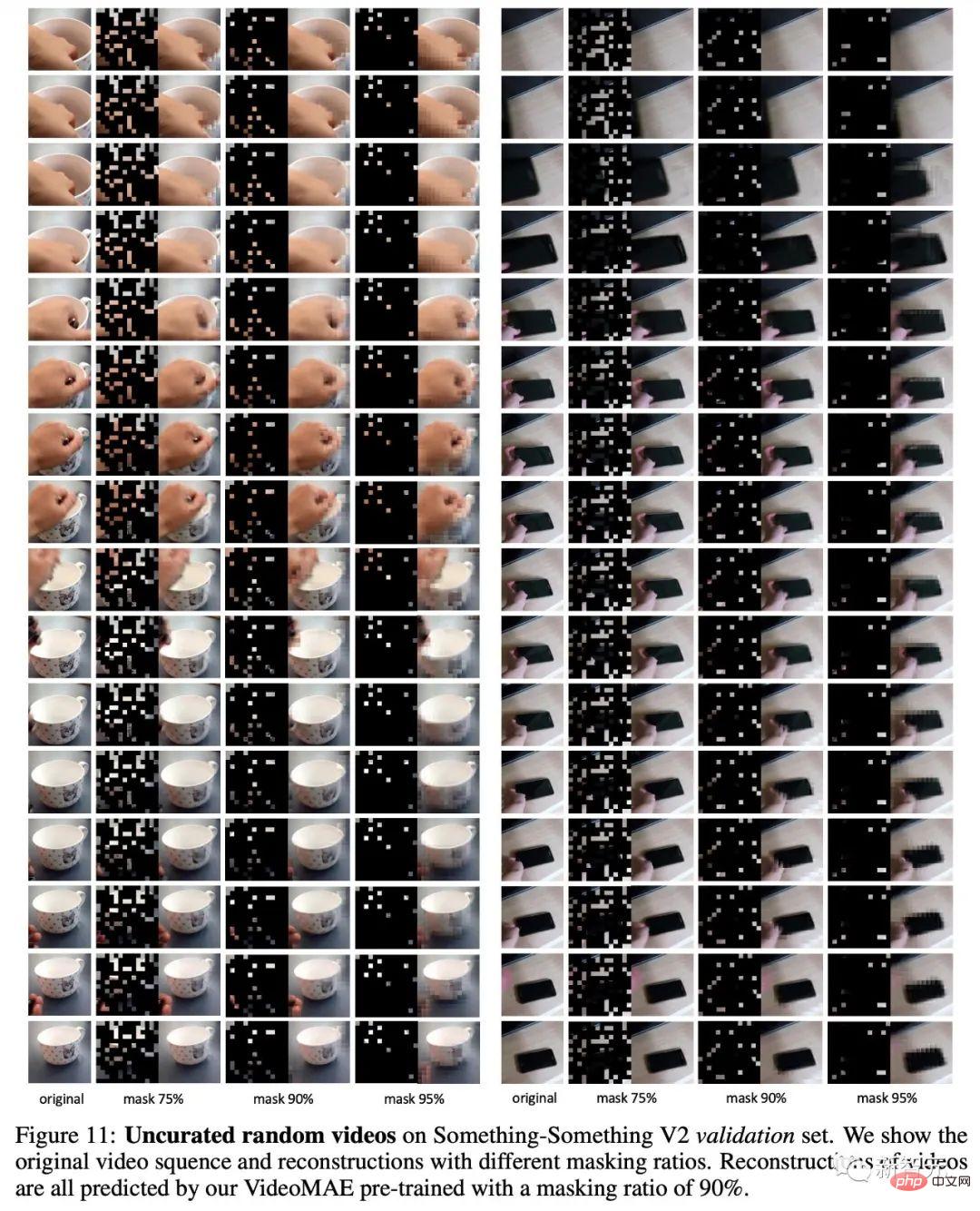

Kami juga memvisualisasikan contoh VideoMAE yang telah dilatih semula. Ia boleh didapati daripada angka bahawa VideoMAE boleh menghasilkan hasil pembinaan semula yang memuaskan walaupun pada kadar topeng yang sangat tinggi. Ini bermakna VideoMAE boleh mempelajari dan mengekstrak ciri spatiotemporal dalam video.

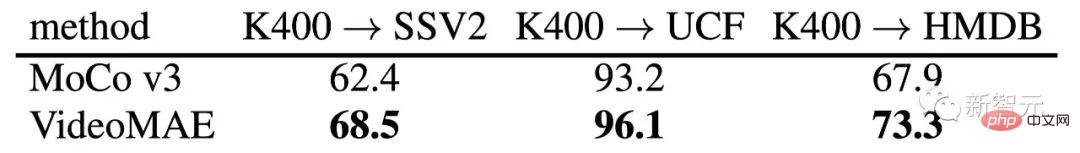

VideoMAE dan Prestasi MoCov3 perbandingan keupayaan pemindahan ciri pada set data yang lebih kecil

Untuk mengkaji lebih lanjut ciri yang dipelajari oleh VideoMAE, bahagian ini menilai keupayaan generalisasi dan pemindahan VideoMAE yang telah dilatih. Jadual di atas menunjukkan kesan pemindahan VideoMAE pra-latihan pada set data Kinetics-400 kepada set data Something-Something V2, UCF101 dan HMDB51. Pada masa yang sama, jadual juga menunjukkan keupayaan penghijrahan model pra-latihan menggunakan MoCo v3. Mengikut keputusan dalam jadual, keupayaan pemindahan dan generalisasi model pra-latihan menggunakan VideoMAE adalah lebih baik daripada model pra-latihan berdasarkan MoCo v3. Ini menunjukkan bahawa VideoMAE boleh mempelajari lebih banyak perwakilan ciri yang boleh dipindahkan. VideoMAE pralatihan pada set data Kinetics-400 berprestasi lebih baik daripada VideoMAE pralatih secara langsung pada set data UCF101 dan HMDB51. Tetapi model yang telah dilatih pada dataset Kinetics-400 memindahkan dengan buruk pada dataset Something-Something V2.

Untuk meneroka lebih lanjut sebab ketidakkonsistenan ini, kami menjalankan percubaan pada set data Something-Something V2 untuk mengurangkan bilangan video pra-latihan. . Proses penerokaan merangkumi dua eksperimen: (1) menggunakan bilangan pusingan latihan (zaman) yang sama untuk pra-latihan, (2) menggunakan bilangan lelaran (lelaran) yang sama untuk pra-latihan. Daripada keputusan dalam rajah, kita dapati bahawa apabila mengurangkan bilangan sampel pra-latihan, menggunakan lebih banyak lelaran latihan juga boleh meningkatkan prestasi model. Walaupun hanya 42,000 video pra-latihan digunakan, VideoMAE yang dilatih secara langsung pada set data Something-Something V2 masih boleh mencapai ketepatan yang lebih baik (68.7) berbanding set data Kinetics-400 yang telah dilatih menggunakan 240,000 data video berbanding 68.5%). Dapatan ini bermakna perbezaan domain merupakan satu lagi faktor penting yang perlu diberi perhatian semasa video pra-latihan yang diselia sendiri Apabila terdapat perbezaan domain antara set data pra-latihan dan set data sasaran, kualiti data pra-latihan adalah lebih penting. daripada kuantiti data. Pada masa yang sama, dapatan ini juga secara tidak langsung mengesahkan bahawa VideoMAE ialah pelajar yang cekap data untuk latihan pra-latihan kendiri video.

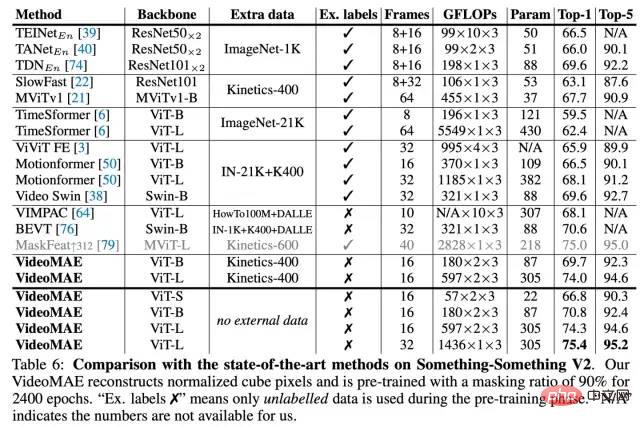

Sesuatu-Sesuatu keputusan percubaan dataset V2

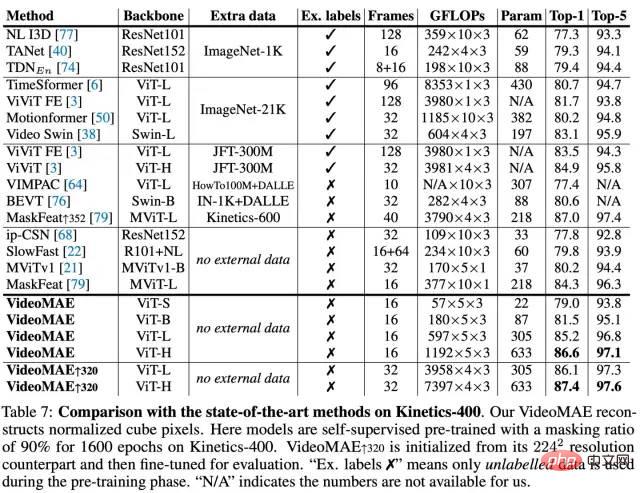

Kinetik-400 set data keputusan percubaan

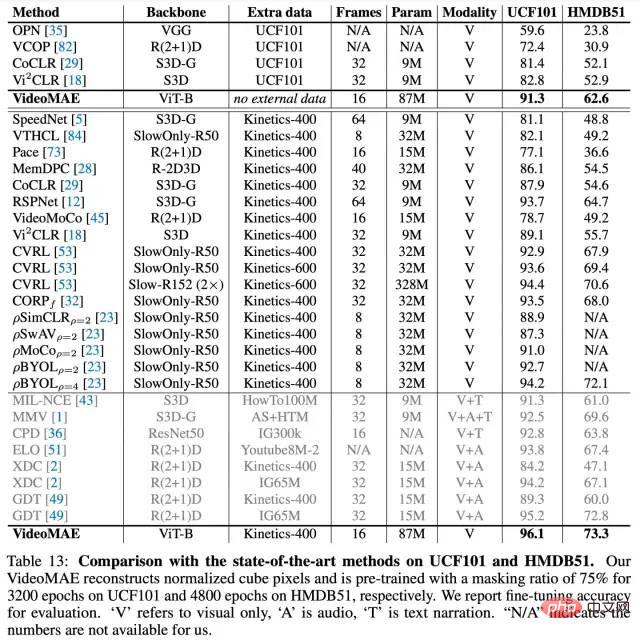

Keputusan percubaan set data UCF101 dan HMDB51

Ketepatan 1 teratas VideoMAE pada Something-Something V2 dan Kinetics-400 tanpa menggunakan sebarang data tambahan Mencapai 75.4% dan 87.4% masing-masing. Perlu diingat bahawa kaedah terkini pada set data Sesuatu-Sesuatu V2 sangat bergantung pada pemulaan model yang telah dilatih pada set data luaran. Sebaliknya, VideoMAE mampu mengatasi dengan ketara kaedah terbaik sebelumnya sebanyak kira-kira 5% dalam ketepatan tanpa menggunakan sebarang data luaran. VideoMAE juga boleh mencapai prestasi cemerlang pada set data Kinetics-400. Dalam kes data video terhad (contohnya, set data UCF101 hanya mengandungi kurang daripada 10,000 video latihan dan HMDB51 hanya mengandungi kira-kira 3500 video latihan), VideoMAE tidak perlu menggunakan sebarang data imej dan video tambahan, dan juga boleh digunakan dalam ini Jauh mengatasi kaedah terbaik sebelumnya pada set data video berskala kecil.

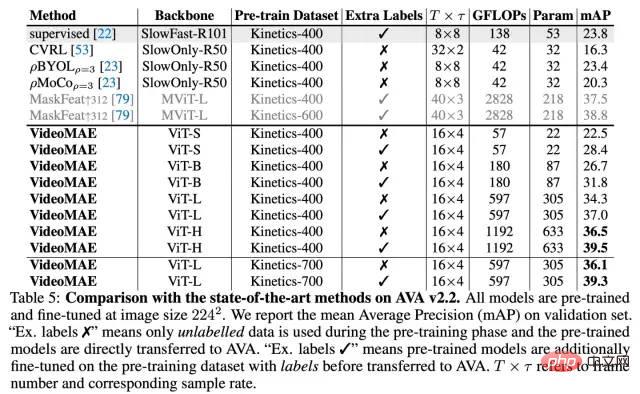

Hasil percubaan set data AVA v2.2

Selain tugas pengelasan tindakan tradisional, kami mengesahkan lagi keupayaan perwakilan model VideoMAE pada tugas pemahaman yang lebih canggih bagi pengesanan tindakan video. Kami memilih set data AVA v2.2 untuk percubaan. Dalam percubaan, model pra-latihan pada set data Kinetics-400 akan dimuatkan dahulu, dan kemudian ViT akan diperhalusi dengan cara yang diawasi. Ia boleh didapati daripada jadual bahawa model ViT yang telah dilatih oleh VideoMAE boleh mencapai hasil yang sangat baik pada set data AVA v2.2. Jika model ViT pra-latihan yang diselia sendiri diselia dengan diperhalusi lagi pada Kinetics-400, ia boleh melakukan tugas pengesanan tindakan dengan lebih baik (3 mAP-6mAP peningkatan). Ini juga menunjukkan bahawa prestasi model pra-latihan seliaan sendiri VideoMAE boleh dipertingkatkan lagi dengan melakukan penalaan halus diselia pada set data huluan dan kemudian berhijrah ke tugas hiliran.

Kami sumber terbuka model dan kod VideoMAE pada April tahun ini dan menerima perhatian dan pengiktirafan berterusan daripada komuniti.

Menurut senarai Paper with Code, VideoMAE telah menduduki tempat teratas dalam Something-Something V2[1] dan AVA 2.2[2] senarai masing-masing setengah tahun (dari akhir Mac 2022 hingga sekarang). Tanpa menggunakan sebarang data luaran, keputusan VideoMAE pada set data Kinetics-400[3], UCF101[4] dan HMDB51[5] juga adalah yang terbaik setakat ini.

https://huggingface.co/docs/transformers/main/en/model_doc/videomae

Beberapa bulan yang lalu, model VideoMAE telah disertakan dalam repositori rasmi Transformers Hugging Face Ia merupakan model pemahaman video pertama yang disertakan dalam repositori. Pada tahap tertentu, ia juga mencerminkan pengiktirafan masyarakat terhadap kerja kami! Kami berharap kerja kami dapat menyediakan kaedah asas yang mudah dan cekap untuk pra-latihan video berasaskan Transformer, dan juga memberi inspirasi kepada kaedah pemahaman video berasaskan Transformer seterusnya.

https://github.com/open-mmlab/mmaction2/tree/dev-1.x/configs/recognition/videomae

Pada masa ini, gudang pemahaman video MMAction2 juga menyokong inferens model VideoMAE.

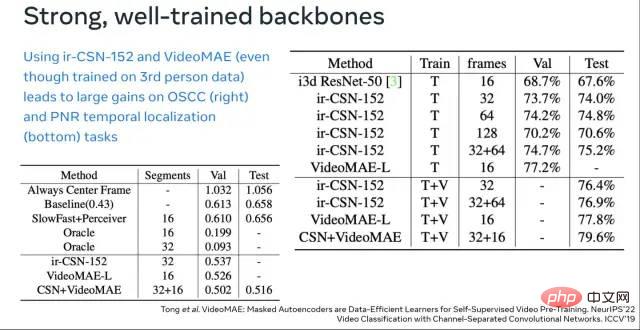

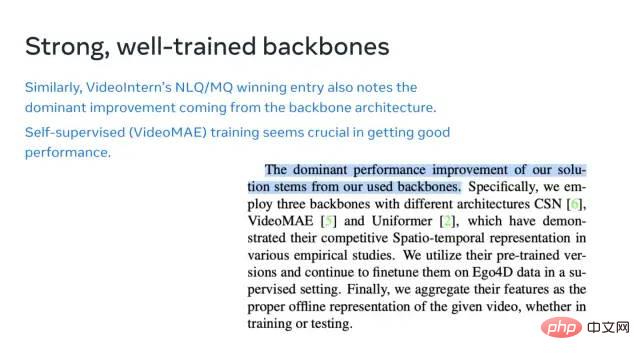

Pada Bengkel Ego4D Antarabangsa ECCV 2022 yang baru sahaja tamat, VideoMAE telah menjadi alat yang berkuasa untuk membantu semua orang bermain permainan ini. Makmal Kepintaran Buatan Shanghai memenangi kejuaraan dalam berbilang sub-trek Cabaran Ego4D ini. Antaranya, VideoMAE berfungsi sebagai tulang belakang yang penting, menyediakan ciri video yang berkuasa untuk penyelesaian mereka. Perlu diingat bahawa dari gambar pertama di atas, boleh didapati bahawa kesan VideoMAE (ViT-L) pra-latihan hanya pada Kinetics-400 sudah boleh mengatasi set data video IG-65M (kira-kira Kinetics-400). sampel data 300 kali) pada ir-CSN-152 yang telah dilatih. Ini juga mengesahkan lagi keupayaan perwakilan yang berkuasa bagi model pra-latihan VideoMAE.

Sumbangan utama kerja kami merangkumi tiga aspek berikut:

• Kami adalah orang pertama yang mencadangkan VideoMAE, rangka kerja pra-latihan sendiri yang diselia sendiri berdasarkan penyamaran dan pembinaan semula ViT. Walaupun dengan pra-latihan yang diselia sendiri pada set data video berskala lebih kecil, VideoMAE masih boleh mencapai prestasi yang sangat baik. Untuk menyelesaikan masalah "kebocoran maklumat" yang disebabkan oleh redundansi temporal dan korelasi temporal, kami mencadangkan penyamaran tiub dengan kadar penyamaran yang sangat tinggi ). Eksperimen menunjukkan bahawa reka bentuk ini adalah kunci kepada keupayaan muktamad VideoMAE untuk mencapai kesan SOTA. Pada masa yang sama, disebabkan oleh seni bina pengekod-penyahkod VideoMAE yang tidak simetri, penggunaan pengiraan proses pra-latihan dikurangkan dengan banyaknya, yang sangat menjimatkan masa proses pra-latihan.

• VideoMAE telah berjaya meluaskan pengalaman dalam bidang NLP dan imej kepada bidang pemahaman video dengan cara yang semula jadi tetapi berharga, mengesahkan bahawa tugas proksi mudah berdasarkan penyamaran dan pembinaan semula boleh menyediakan video pra-latihan yang diselia sendiri Penyelesaian yang mudah tetapi sangat berkesan. Prestasi model ViT selepas latihan pra-latihan sendiri menggunakan VideoMAE adalah jauh lebih baik daripada latihan dari awal atau kaedah pembelajaran kontrastif mengenai tugas hiliran dalam bidang pemahaman video (seperti pengecaman tindakan, pengesanan tindakan).

• Terdapat dua penemuan menarik semasa percubaan, yang mungkin telah diabaikan oleh kerja penyelidikan terdahulu dalam NLP dan pemahaman imej: (1) VideoMAE ialah pelajar yang cekap data . Malah pada set data video HMDB51, yang hanya mempunyai kira-kira 3,000 video, VideoMAE mampu melengkapkan pra-latihan diselia sendiri dan boleh mencapai hasil yang jauh melebihi kaedah lain pada tugas pengelasan hiliran. (2) Untuk video pra-latihan yang diselia sendiri, apabila terdapat jurang domain yang jelas antara set data pra-latihan dan set data tugas hiliran, kualiti data video mungkin lebih penting daripada kuantiti.

Atas ialah kandungan terperinci VideoMAE: paradigma baharu pra-latihan penyeliaan kendiri video yang ringkas dan cekap. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Aplikasi kecerdasan buatan dalam kehidupan

Aplikasi kecerdasan buatan dalam kehidupan

Apakah konsep asas kecerdasan buatan

Apakah konsep asas kecerdasan buatan

Bagaimana untuk menyelesaikan terlalu banyak log masuk

Bagaimana untuk menyelesaikan terlalu banyak log masuk

windows tidak boleh membuka add printer

windows tidak boleh membuka add printer

apa itu c#

apa itu c#

Penyelesaian kepada penetapan vscode antara muka Cina tidak berkuat kuasa

Penyelesaian kepada penetapan vscode antara muka Cina tidak berkuat kuasa

Bagaimana untuk memotong gambar panjang pada telefon bimbit Huawei

Bagaimana untuk memotong gambar panjang pada telefon bimbit Huawei

Bagaimana untuk memformat cakera keras dalam linux

Bagaimana untuk memformat cakera keras dalam linux