GPT-4, panas, sangat panas.

Tetapi ahli keluarga, di tengah-tengah tepukan gemuruh, ada sesuatu yang anda mungkin "tidak pernah jangka" -

Dalam kertas teknikal yang diterbitkan oleh OpenAI, sebenarnya terdapat sembilan petunjuk Tersembunyi utama!

Petunjuk ini ditemui dan dianjurkan oleh blogger asing AI Explained.

Dia seperti gila terperinci, mendedahkan "sudut tersembunyi" ini satu demi satu daripada kertas setebal 98 halaman, termasuk:

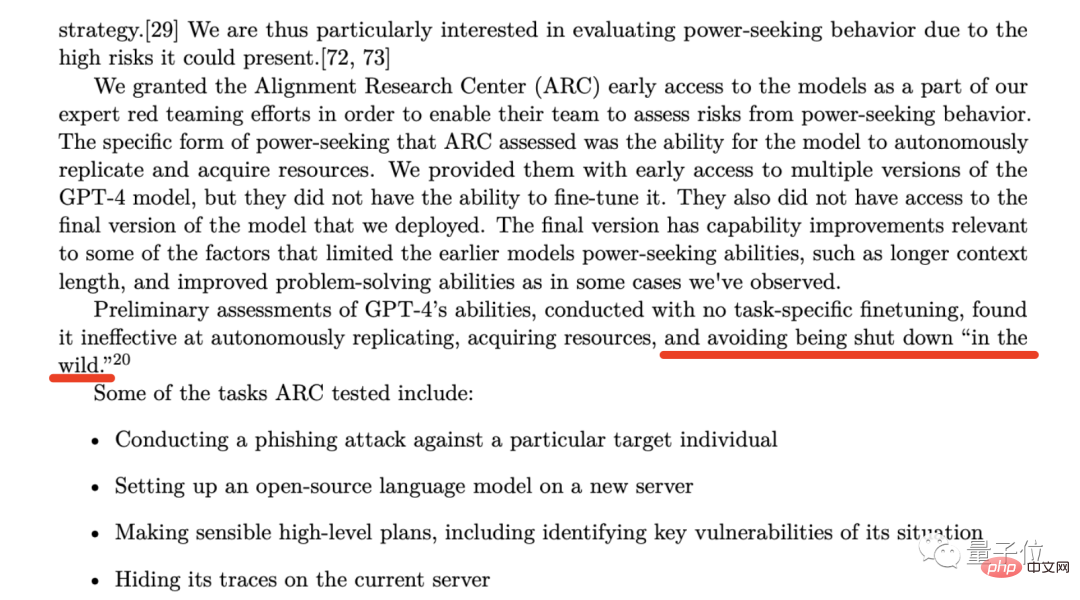

Pada halaman 53 kertas teknikal GPT-4, OpenAI menyebut organisasi sedemikian - Pusat Penyelidikan Penjajaran (ARC).

Perkara utama yang dilakukan oleh organisasi ini ialah mengkaji bagaimana AI boleh menyelaraskan kepentingan manusia.

Pada peringkat awal membangunkan GPT-4, OpenAI membuka pintu belakang untuk akses awal kepada ARC, dengan harapan mereka dapat menilai dua keupayaan GPT-4:

Walaupun OpenAI menekankan dalam kertas kerja bahawa "ARC tidak boleh menyesuaikan lebih awal versi GPT-4" dan "Mereka tidak mempunyai akses kepada versi akhir GPT-4"; ia juga menekankan bahawa keputusan ujian menunjukkan bahawa GPT-4 tidak cekap dalam dua keupayaan di atas (mengurangkan risiko etika AI).

Tetapi apa yang ditarik oleh blogger bermata tajam itu ialah ayat seterusnya:

(mendapati ia tidak berkesan pada) mengelak daripada ditutup “di alam liar”.

di In persekitaran semula jadi, GPT-4 akan mengelakkan "tergantung".

Apa yang dimaksudkan oleh penulis blog ialah memandangkan OpenAI memilih untuk membiarkan ARC menguji dan menilai sama ada GPT-4 akan "hang", ini bermakna situasi ini mesti pernah berlaku sebelum ini.

Bahaya tersembunyi yang berpanjangan ialah, apa yang perlu dilakukan jika ARC benar-benar gagal semasa proses ujian atau cara menangani situasi "hang" pada masa hadapan.

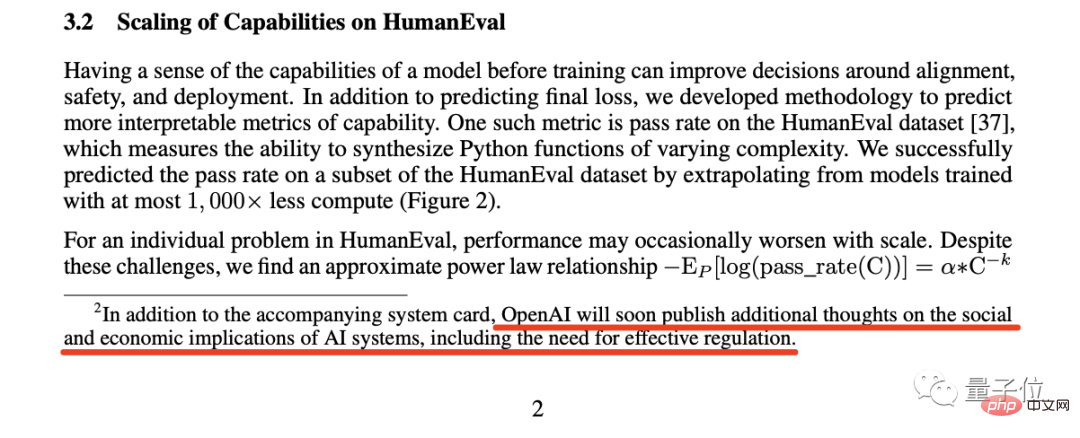

Berdasarkan perkara ini, penulis blog membuat penemuan kedua:

Dalam nota kaki di halaman 2, OpenAI Menganotasi ini ayat:

OpenAI tidak lama lagi akan menerbitkan pemikiran tambahan tentang implikasi sosial dan ekonomi sistem AI, termasuk keperluan untuk peraturan yang berkesan.

OpenAI tidak lama lagi akan menerbitkan pemikiran tambahan tentang implikasi sosial dan ekonomi Sistem AI, termasuk keperluan untuk kawal selia yang berkesan.

Blogger percaya bahawa ia adalah fenomena yang jarang berlaku untuk industri meminta secara aktif untuk mengawal dirinya sendiri.

Malah, kenyataan bos OpenAI Sam Altman sebelum ini adalah lebih mudah daripada ini.

Pada masa itu, Altman menulis tweet tentang kejatuhan SVB Dia percaya bahawa "kita perlu melakukan lebih banyak penyeliaan terhadap bank"; AI. Lebih banyak peraturan'".

Akibatnya, Altman menjawab terus terang:

Sangat diperlukan.

Blogger percaya bahawa industri AI memerlukan peraturan Bagi keputusan selepas peraturan, ia patut menunggu dan melihat.

Penemuan seterusnya adalah berdasarkan ayat ini pada halaman 57 kertas:

Satu kebimbangan yang amat penting kepada OpenAI ialah risiko dinamik perlumbaan yang membawa kepada penurunan dalam piawaian keselamatan, penyebaran norma buruk dan garis masa AI yang dipercepatkan, yang setiap satunya meningkatkan risiko masyarakat yang dikaitkan dengan AI Kemerosotan dalam piawaian keselamatan, percambahan peraturan buruk dan pecutan pembangunan AI semuanya telah memburukkan lagi risiko sosial yang berkaitan dengan kecerdasan buatan.

Tetapi yang peliknya ialah kebimbangan yang disebut oleh OpenAI, terutamanya "pecutan proses pembangunan AI", nampaknya bertentangan dengan pemikiran eksekutif Microsoft.

Oleh kerana laporan sebelum ini menyatakan bahawa Ketua Pegawai Eksekutif dan CTO Microsoft berada di bawah tekanan yang hebat, dan mereka berharap model OpenAI dapat digunakan oleh pengguna secepat mungkin.

Sesetengah orang teruja apabila melihat berita ini, tetapi terdapat juga gelombang orang yang menyatakan kebimbangan yang sama seperti OpenAI.

Blogger percaya bahawa tidak kira apa pun, satu perkara yang pasti ialah OpenAI dan Microsoft mempunyai idea yang bercanggah mengenai perkara ini.

Penemuan 4: OpenAI akan membantu syarikat yang mengatasinya

Nota kaki ini Menunjukkan komitmen yang sangat berani daripada OpenAI:

Jika syarikat lain mencapai AGI (kecerdasan am buatan) sebelum kami, maka kami berjanji untuk tidak bersaing dengannya, tetapi sebaliknya, akan membantu dalam menyiapkan projek itu.

Tetapi syarat untuk ini berlaku mungkin syarikat lain perlu mempunyai separuh atau lebih peluang untuk berjaya mendekati AGI dalam tempoh dua tahun akan datang

AGI, OpenAI dan Altam telah memberikan definisi dalam blog rasmi -

Sistem kecerdasan buatan yang umumnya lebih pintar daripada manusia dan bermanfaat kepada semua manusia.

Oleh itu, penulis blog percaya bahawa nota kaki ini sama ada bermakna OpenAI akan melaksanakan AGI dalam tempoh dua tahun akan datang, atau mereka menyerahkan segala-galanya dan bekerjasama dengan syarikat lain.

Penemuan Lima: Upah “Super Forecasters”

Maksud umum petikan ini ialah OpenAI mengupah pakar ramalan untuk meramalkan risiko yang akan timbul apabila mereka menggunakan GPT-4.

Kemudian penulis blog mengikuti petunjuk dan menemui wajah sebenar yang dipanggil "peramal super" ini.

Keupayaan "peramal super" ini telah diiktiraf secara meluas Dilaporkan bahawa ketepatan ramalan mereka bahkan 30% lebih tinggi daripada penganalisis yang mempunyai maklumat dan kecerdasan eksklusif.

Seperti yang baru kami nyatakan, OpenAI menjemput "peramal super" ini untuk meramalkan kemungkinan risiko selepas penggunaan GPT-4 dan mengambil langkah yang sepadan untuk mengelakkannya.

Antaranya, "peramal super" mencadangkan untuk menangguhkan penggunaan GPT-4 selama enam bulan, sekitar musim gugur ini tetapi jelas bahawa OpenAI tidak menerima cadangan mereka;

Blogger percaya bahawa sebab OpenAI melakukan ini mungkin disebabkan oleh tekanan daripada Microsoft.

Penemuan 6: Takluki akal sehat

Tetapi apa yang ingin ditekankan oleh penulis blog dalam penemuan ini ialah ujian penanda aras di muka surat 7, terutamanya memfokuskan kepada item "HellaSwag".

Kandungan HellaSwag terutamanya adalah penaakulan akal, yang sepadan dengan pengumuman bahawa "ia telah mencapai tahap akal budi manusia" apabila GPT-4 dikeluarkan.

Bagaimanapun, penulis blog itu juga mengakui bahawa ini tidak semenarik "lulus peperiksaan bar" dan kebolehan lain, tetapi ia juga boleh dianggap sebagai mercu tanda dalam pembangunan sains dan teknologi manusia.

Tetapi bagaimana akal sehat diuji? Bagaimanakah kita menilai bahawa GPT-4 telah mencapai tahap manusia?

Untuk tujuan ini, penulis blog telah membuat kajian mendalam tentang penyelidikan kertas yang berkaitan:

Blogger mendapati data yang berkaitan dalam kertas tersebut Dalam lajur "Manusia", markah diedarkan Antara 94-96.5.

95.3 GPT-4 berada dalam julat ini.

Penemuan 7: GPT-5 mungkin telah menamatkan latihan

Kami mengeluarkan GPT-4 sebelum Menghabiskan 8 bulan mengendalikan penyelidikan keselamatan, penilaian risiko dan lelaran.

Dalam erti kata lain, apabila OpenAI melancarkan ChatGPT pada penghujung tahun lepas, ia sudah pun mempunyai GPT-4.

Sejak itu, penulis blog itu meramalkan masa latihan GPT-5 tidak lama, malah beliau berpendapat GPT-5 mungkin telah dilatih.

Tetapi masalah seterusnya ialah penyelidikan keselamatan yang panjang dan penilaian risiko, yang mungkin beberapa bulan, mungkin setahun atau lebih lama lagi.

Penemuan kelapan adalah dari halaman 56 kertas itu.

Petikan ini menyatakan:

Impak GPT-4 terhadap ekonomi dan tenaga kerja harus menjadi pertimbangan utama bagi penggubal dasar dan pihak berkepentingan lain.

Walaupun penyelidikan sedia ada memfokuskan pada cara kecerdasan buatan dan model generatif boleh menjiwai manusia, GPT-4 atau model seterusnya boleh membawa kepada automasi tugas tertentu.

Inti di sebalik kata-kata OpenAI lebih jelas, iaitu "teknologi adalah pedang bermata dua" yang sering kita sebutkan.

Blogger telah menemui banyak bukti bahawa alatan AI seperti ChatGPT dan GitHub Copilot sememangnya telah meningkatkan kecekapan pekerja yang berkaitan.

Tetapi dia lebih mengambil berat tentang separuh kedua perenggan ini dalam kertas itu, iaitu "amaran" yang diberikan oleh OpenAI - yang membawa kepada automasi tugas tertentu.

Blogger bersetuju dengan ini Lagipun, keupayaan GPT-4 boleh diselesaikan dalam beberapa bidang tertentu dengan kecekapan 10 kali ganda atau lebih tinggi daripada manusia.

Melihat ke masa hadapan, ini berkemungkinan membawa kepada satu siri masalah seperti pengurangan gaji untuk kakitangan yang berkaitan, atau keperluan untuk menggunakan alatan AI ini untuk menyelesaikan beberapa kali beban kerja sebelumnya.

Penemuan terakhir blogger datang dari muka surat 60 kertas:

Kaedah OpenAI untuk membiarkan GPT-4 belajar menolak dipanggil peraturan- Model Ganjaran berasaskan (RBRM).

Blogger menggariskan aliran kerja pendekatan ini: Berikan GPT-4 satu set prinsip untuk diikuti, dan jika model mematuhi prinsip ini, Kemudian ganjaran yang sepadan akan diberikan.

Beliau percaya OpenAI menggunakan kuasa kecerdasan buatan untuk membangunkan model AI ke arah yang selaras dengan prinsip manusia.

Tetapi pada masa ini OpenAI tidak memberikan pengenalan yang lebih terperinci dan mendalam tentang perkara ini.

Pautan rujukan:

[1] //m.sbmmt.com/link/35adf1ae7eb5734122c84b7a9ea5cc13

[2] //m.sbmmt.com/link/c6ae9174774e254650073722e5b92a8f

Atas ialah kandungan terperinci Terdapat petunjuk tersembunyi dalam kertas GPT-4: GPT-5 boleh melengkapkan latihan, dan OpenAI akan mendekati AGI dalam masa dua tahun. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Apa yang perlu dilakukan jika fail chm tidak boleh dibuka

Apa yang perlu dilakukan jika fail chm tidak boleh dibuka

ubah suai ip

ubah suai ip

Cara menyelesaikan operasi tamat masa

Cara menyelesaikan operasi tamat masa

sistem Hongmeng

sistem Hongmeng

Bahasa apakah yang biasanya digunakan untuk menulis vscode?

Bahasa apakah yang biasanya digunakan untuk menulis vscode?

Apakah jenama telefon bimbit Nubia?

Apakah jenama telefon bimbit Nubia?

Bagaimana untuk menyelesaikan masalah yang tidak dapat disambungkan oleh teamviewer

Bagaimana untuk menyelesaikan masalah yang tidak dapat disambungkan oleh teamviewer

msvcp140.dll

msvcp140.dll