Dalam beberapa tahun kebelakangan ini, pasukan Sun Maosong dari Jabatan Sains Komputer di Universiti Tsinghua telah meneroka secara mendalam mekanisme dan ciri kaedah penalaan halus yang cekap untuk parameter model bahasa yang besar, dan bekerjasama dengan pasukan lain yang berkaitan di sekolah untuk melengkapkan hasil penyelidikan "Penalaan halus parameter yang cekap untuk model bahasa pra-latihan berskala besar" (Penalaan Halus Parameter yang cekap bagi Model Bahasa Pra-latihan Skala Besar) telah diterbitkan dalam "Kepintaran Mesin Alam" pada 2 Mac. Hasil penyelidikan telah disiapkan bersama oleh guru dan pelajar dari Jabatan Sains Komputer seperti Sun Maosong, Li Juanzi, Tang Jie, Liu Yang, Chen Jianfei, Liu Zhiyuan, dan Sekolah Siswazah Antarabangsa Shenzhen Zheng Haitao, Zheng Haitao. dan Sun Maosong ialah pengarang artikel yang sepadan dan mempunyai Ph.D. dalam Jabatan Sains Komputer di Universiti Tsinghua (mentor Zheng Haitao) dan Qin Yujia (mentor Liu Zhiyuan) ialah pengarang pertama artikel ini.

Sejak 2018, model bahasa pra-latihan (PLM) dan kaedah "pra-latihan-penalaan-halus" telah menjadi paradigma arus perdana untuk pemprosesan bahasa semula jadi (NLP), paradigma ini mula-mula menggunakan data tidak berlabel berskala besar untuk melatih model bahasa besar melalui pembelajaran penyeliaan kendiri untuk mendapatkan model asas, dan kemudian menggunakan data berlabel daripada tugasan hiliran untuk melaksanakan pembelajaran terselia untuk memperhalusi model parameter untuk mencapai penyesuaian kepada tugas hiliran.

Dengan perkembangan teknologi, PLM sudah pasti menjadi infrastruktur untuk pelbagai tugas NLP, dan dalam pembangunan PLM, terdapat trend yang tidak dapat dipulihkan: iaitu Model semakin besar dan lebih besar. . Model yang lebih besar bukan sahaja akan mencapai hasil yang lebih baik pada tugas yang diketahui, tetapi juga menunjukkan potensi untuk menyelesaikan tugas yang tidak diketahui yang lebih kompleks.

Walau bagaimanapun, model yang lebih besar juga menghadapi cabaran yang lebih besar dalam aplikasi Kaedah tradisional penalaan halus parameter penuh model pra-latihan berskala ultra besar menggunakan banyak pengiraan GPU. Kos sumber dan sumber simpanan yang besar adalah terlalu mahal. Kos ini juga telah mewujudkan sejenis "inersia" dalam dunia akademik, iaitu, penyelidik hanya mengesahkan kaedah mereka pada model kecil dan sederhana, dan lazimnya mengabaikan model berskala besar.

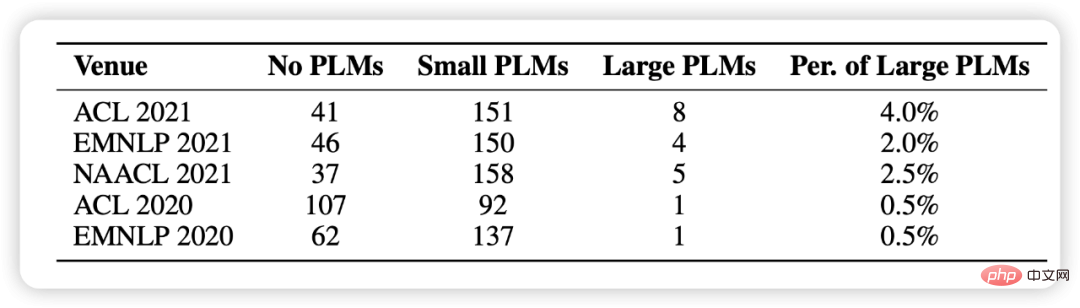

Dalam statistik artikel ini, kami memilih 1,000 kertas kerja secara rawak daripada lima persidangan NLP yang lalu dan mendapati bahawa menggunakan model pra-latihan telah menjadi paradigma asas penyelidikan, tetapi ia melibatkan besar model Tetapi terdapat sangat sedikit (seperti yang ditunjukkan dalam Rajah 1).

Rajah 1: Taburan statistik menggunakan model pra-latihan di antara 1000 kertas yang dipilih secara rawak

Dalam konteks ini, skema penyesuaian model baharu, kaedah cekap parameter semakin popular Menarik perhatian, berbanding dengan parameter penuh standard penalaan halus, kaedah ini hanya memperhalusi sebahagian kecil parameter model sambil membiarkan selebihnya tidak berubah, sangat mengurangkan kos pengkomputeran dan penyimpanan, sementara masih mempunyai prestasi yang setanding dengan penalaan halus parameter penuh. Kami percaya bahawa kaedah ini pada asasnya melaraskan pada "kenaikan" (Delta Paremters), jadi kami menamakannya Delta Tuning.

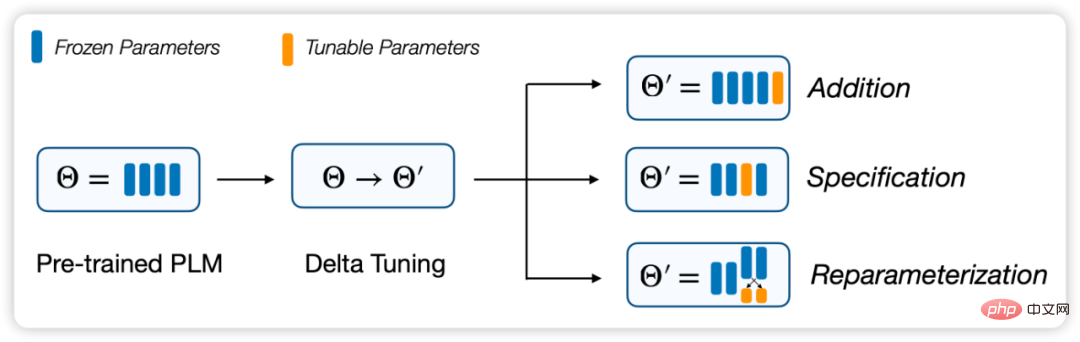

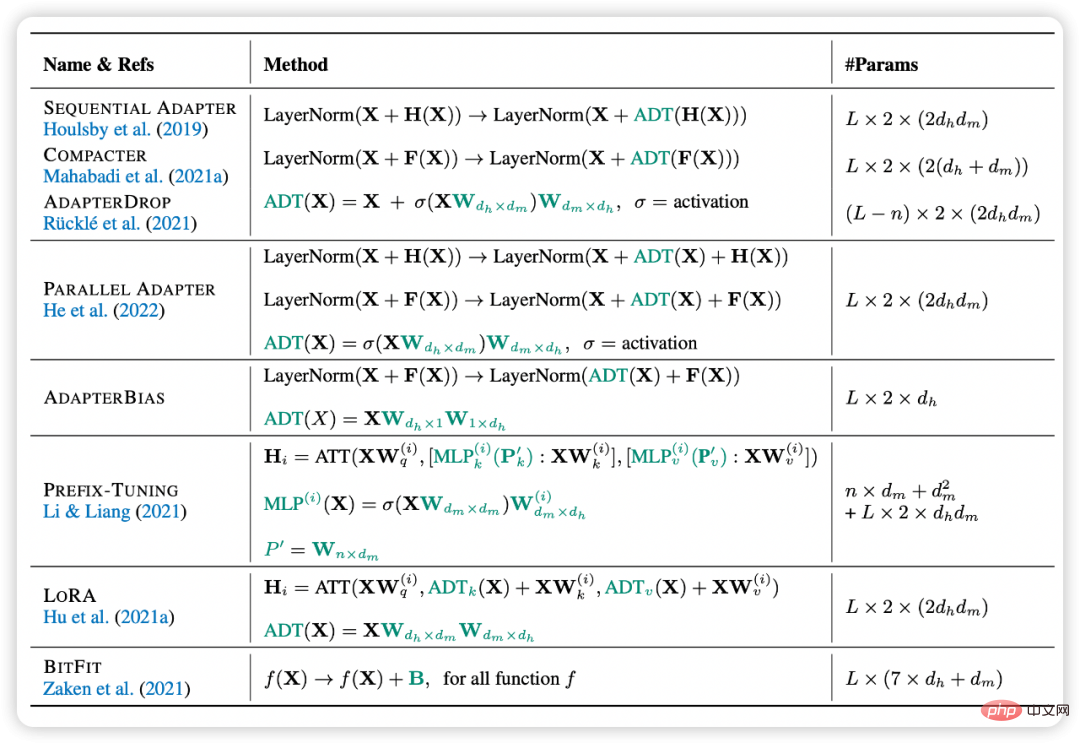

Dalam kertas kerja ini, kami mentakrifkan dan menghuraikan masalah Delta Tuning, dan menyemak penyelidikan terdahulu melalui rangka kerja bersatu. Dalam rangka kerja ini, kaedah penalaan delta sedia ada boleh dibahagikan kepada tiga kumpulan: kaedah tambahan (Berasaskan Penambahan), berasaskan spesifikasi (berasaskan Spesifikasi) dan kaedah reparameterisasi (Reparameterization).

Selain kepentingan praktikal, kami percaya bahawa ia juga mempunyai kepentingan teori yang sangat penting sedikit sebanyak mendedahkan mekanisme di sebalik model besar dan membantu kami mengembangkan lagi Teori untuk model besar dan juga rangkaian saraf yang mendalam. Untuk tujuan ini, kami mencadangkan rangka kerja teori untuk membincangkan Penalaan Delta dari dua perspektif pengoptimuman dan kawalan optimum untuk membimbing reka bentuk struktur dan algoritma seterusnya. Tambahan pula, kami menjalankan perbandingan percubaan komprehensif bagi kaedah perwakilan dan menunjukkan perbandingan prestasi komprehensif kaedah berbeza pada keputusan pada lebih daripada 100 tugasan NLP. Keputusan eksperimen meliputi penyelidikan dan analisis prestasi Delta Tuning, prestasi penumpuan, prestasi kecekapan, Kuasa Skala, prestasi generalisasi dan prestasi migrasi. Kami juga membangunkan OpenDelta, kit alat sumber terbuka yang membolehkan pengamal melaksanakan Penalaan Delta pada PLM dengan cekap dan fleksibel.

Rajah 2: Rangka kerja bahagian Penalaan Delta

Memandangkan model dan data latihan pra-latihan, PLM sesuai untuk Matlamat pemasangan adalah untuk menghasilkan model yang parameternya adalah . akan ditakrifkan sebagai operasi di atas model asal. Untuk penalaan halus parameter penuh tradisional, terdapat

, antaranya

ialah nilai kemas kini semua parameter dalam

berbanding dengan data latihan. Dalam Penalaan Delta,

merujuk kepada mengubah suai sebilangan kecil parameter. Dari segi empirikal, penalaan halus parameter penuh mempunyai

, manakala Penalaan Delta mempunyai

. Oleh itu, kita boleh membahagikan Penalaan Delta cekap parameter kepada tiga strategi berdasarkan bentuk dan struktur parameter yang diselaraskan, dan menyusun kaedah sebelumnya:

Kaedah jenis ini memperkenalkan modul atau parameter saraf boleh dilatih tambahan yang tidak terdapat dalam model asal. Dalam kaedah jenis ini, berdasarkan definisi di atas, kami mempunyai

. Kaedah tambahan biasa termasuk Penalaan Penyesuai, Penalaan Awalan, Penalaan Pantas, dsb. Mereka sentiasa memasukkan modul saraf berskala kecil atau parameter boleh laras ke dalam model, dan mencapai penyesuaian model yang cekap dengan memperhalusi hanya sebahagian kecil parameter ini. Antaranya, Penalaan penyesuai adalah kerja perintis kaedah jenis ini Ia membuktikan bahawa hanya menambah rangkaian saraf yang ringkas pada setiap lapisan boleh dibandingkan dengan penalaan halus parameter penuh pada banyak tugas. Pada masa yang sama, Penyesuai juga menunjukkan potensinya dalam senario berbilang tugas dan berbilang bahasa. Penalaan awalan dan Penalaan Pantas ialah algoritma penalaan delta yang sangat popular baru-baru ini. Mereka memasukkan beberapa vektor boleh laras ke dalam lapisan input atau lapisan pembentangan untuk penalaan halus. Antaranya, Prompt Tuning boleh dianggap sebagai versi ringkas Prefix Tuning, iaitu hanya menambah Soft Prompt pada lapisan input. Pendekatan ini mempunyai kelebihan yang sangat besar, iaitu, tidak perlu mengubah suai struktur dalaman model Pada masa yang sama, kerana bilangan parameter model meningkat kepada 10 bilion, ia juga telah terbukti bahawa ia boleh mencapai. kesan yang sama seperti penalaan halus parameter penuh pada sesetengah data. Walau bagaimanapun, kaedah jenis ini juga menghadapi masalah pengoptimuman yang besar. Eksperimen telah membuktikan bahawa kecekapan pengoptimumannya selalunya lebih rendah daripada paradigma penalaan halus yang lain, masa penumpuannya lebih lama, dan ia berprestasi buruk pada model kecil dan sederhana.

Rajah 3: Ekspresi Formal Delta Tuning

Kaedah jenis ini menentukan bahawa parameter tertentu dalam model asal menjadi boleh dilatih, manakala parameter lain dibekukan. Dalam kaedah jenis ini, kita boleh mewakili set parameter latihan sebagai , dan parameter yang dikemas kini pada masa ini sebagai . maka, nilai tambahan, jika tidak. Kaedah yang ditentukan tidak memperkenalkan sebarang parameter baharu ke dalam model, malah ia tidak berusaha untuk menukar struktur model, sebaliknya, ia secara langsung menentukan beberapa parameter untuk dioptimumkan. Idea ini mudah tetapi berfungsi dengan baik, contohnya beberapa kaedah hanya memperhalusi satu perempat daripada lapisan terakhir BERT dan RoBERTa dan boleh menghasilkan 90% prestasi penalaan halus parameter penuh. Kerja oleh BitFit menunjukkan bahawa dengan hanya mengoptimumkan istilah berat sebelah dalam model dan membekukan parameter lain, model masih boleh menghasilkan semula lebih 95% prestasi penalaan halus parameter penuh merentas berbilang penanda aras. Keputusan empirikal daripada BitFit juga menunjukkan bahawa walaupun kita menggunakan set parameter rawak kecil untuk penalaan delta (yang jelas merendahkan prestasi), model masih boleh menghasilkan hasil yang boleh diterima pada penanda aras GLUE. Satu lagi pemerhatian berharga ialah istilah bias yang berbeza mungkin mempunyai fungsi yang berbeza semasa penyesuaian model.

Selain menentukan secara manual atau heuristik parameter yang akan dikemas kini, kami juga boleh mempelajari spesifikasi sedemikian. Diff Pruning ialah salah satu kerja perwakilan, yang menyusun semula parameter model yang diperhalusi ke dalam jumlah parameter pra-latihan dan vektor perbezaan, iaitu. Isu utama pada masa ini adalah untuk menggalakkan vektor perbezaan menjadi jarang yang mungkin. Malah, Diff Pruning menggunakan lebih banyak memori GPU daripada penalaan halus parameter penuh kerana pengenalan parameter baharu untuk dioptimumkan semasa fasa pembelajaran, yang mungkin mencabar dalam aplikasi pada PLM yang besar. Kaedah masking (Masking) mempelajari topeng terpilih untuk PLM, mengemas kini hanya pemberat kritikal untuk tugasan tertentu. Untuk mempelajari set topeng sedemikian, matriks binari yang berkaitan dengan berat model diperkenalkan, di mana setiap nilai dijana oleh fungsi ambang. Semasa perambatan balik, matriks dikemas kini oleh penganggar hingar.

Kaedah jenis ini menyusun semula proses pengoptimuman sedia ada kepada bentuk yang sah parameter dengan mengubahnya. Nyatakan set parameter yang akan diparameterkan semula sebagai , dan dengan mengandaikan bahawa setiap satu diwakili oleh parameter baharu, maka parameter yang dikemas kini ditandakan sebagai , di mana . Ringkasnya, kaedah penparameteran semula selalunya berdasarkan andaian yang sama: bahawa proses penyesuaian model pra-latihan sememangnya berpangkat rendah atau berdimensi rendah. Oleh itu, proses ini boleh bersamaan dengan paradigma cekap parameter.

Sebagai contoh, kita boleh mengandaikan bahawa penyesuaian model mempunyai "dimensi intrinsik", dan dengan meparameterkan semula proses penalaan halus ke dalam proses pengoptimuman dalam subruang dimensi rendah, kita hanya boleh menggunakan parameter subruang penalaan halus dalam ruang untuk mencapai prestasi yang memuaskan. Dalam pengertian ini, PLM boleh berfungsi sebagai rangka kerja pemampatan umum untuk memampatkan kerumitan pengoptimuman daripada dimensi tinggi ke rendah. Secara umum, PLM yang lebih besar biasanya mempunyai dimensi intrinsik yang lebih kecil, dan proses pralatihan secara tersirat mengurangkan dimensi intrinsik PLM. Diilhamkan oleh pemerhatian ini, kaedah Delta Tuning yang diparameter semula juga dicadangkan, yang menyuparameter semula (sebahagian daripada) parameter model asal menggunakan parameter pengganti dimensi rendah, mengoptimumkan hanya parameter pengganti, dengan itu mengurangkan kos pengiraan dan memori.

Satu lagi karya terkenal, LoRA, menganggap bahawa perubahan dalam pemberat semasa pelarasan model mempunyai "kedudukan intrinsik" yang rendah. Berdasarkan andaian ini, mereka mencadangkan untuk mengoptimumkan penguraian peringkat rendah untuk perubahan dalam matriks berat asal dalam modul perhatian kendiri. Dalam penggunaan, matriks penguraian peringkat rendah yang dioptimumkan didarab untuk mendapatkan kenaikan matriks berat perhatian kendiri. Dengan cara ini, LoRA boleh memadankan prestasi diperhalusi pada penanda aras GLUE. Mereka menunjukkan keberkesanan pendekatan mereka pada PLM pelbagai saiz dan seni bina, malah GPT3.

Andaian dimensi rendah jenis ini bukan sahaja sesuai untuk penyesuaian tugasan tunggal, tetapi juga boleh diperluaskan kepada senario berbilang tugas. IPT menganggap bahawa subruang eigen dimensi rendah yang sama wujud untuk berbilang tugas, dan hanya melaraskan parameter subruang boleh mencapai hasil yang memuaskan pada lebih daripada 100 tugasan NLP pada masa yang sama. Daripada menggunakan subruang rawak, kaedah ini cuba mencari subruang biasa yang dikongsi oleh berbilang tugas NLP. Eksperimen menunjukkan bahawa dalam subruang dimensi rendah 250 dimensi, lebih daripada 80% prestasi Penalaan Pantas boleh dihasilkan semula pada lebih daripada 100 tugasan NLP dengan melaraskan hanya 250 parameter.

Adakah penalaan delta pada asasnya mempunyai persamaan? Kami percaya bahawa kaedah Delta Tuning bukan sahaja mempunyai nilai praktikal yang tinggi, tetapi juga mempunyai kepentingan teori yang meluas. Mereka semua nampaknya sentiasa membuktikan satu perkara: iaitu, proses penyesuaian model besar nampaknya merupakan proses kos yang sangat rendah. (berbanding dengan (untuk pra-latihan), ia boleh dicapai dengan data yang sangat sedikit dan penalaan parameter yang sangat sedikit. Kejayaan Delta Tuning memberi inspirasi kepada kami untuk meneroka lebih lanjut rangka kerja teori di sebalik penyesuaian model Artikel ini mencadangkan rangka kerja dari dua perspektif: pengoptimuman dan kawalan optimum untuk menjalankan kajian teori Delta Tuning. tafsiran.

Sudut pengoptimuman

Delta Tuning cuba mencapai hasil yang sama pada model bahasa berskala besar asal secara halus -menala sebilangan kecil parameter kesan penalaan halus parameter penuh dan mengurangkan penggunaan memori. Daripada perspektif pengoptimuman, kami menganalisis kesan Penalaan Delta dan membincangkan reka bentuk beberapa kaedah Penalaan Delta di bawah andaian dimensi rendah. Selepas menggunakan Penalaan Delta, fungsi objektif dan parameter yang bergantung padanya mungkin berubah. Untuk fungsi objektif baharu, hanya parameter yang berkaitan dengan Penalaan Delta dioptimumkan Jika nilai awal cukup baik, prestasi model tidak akan rosak dengan ketara di bawah andaian tertentu. Tetapi untuk memastikan keberkesanan Delta Tuning, adalah perlu untuk membangunkan struktur masalah untuk mereka bentuk fungsi objektif baru ini. Titik permulaan adalah untuk mengeksploitasi sifat semula jadi rendah dimensi masalah. Secara umumnya, terdapat dua idea yang telah terbukti berguna dalam amalan:

Oleh kerana untuk kebanyakan aplikasi dalam pembelajaran mendalam, fungsi objektif biasanya mempunyai banyak titik minimum tempatan, jadi apabila nilai awal hampir dengan titik minimum tempatan, hanya beberapa arah carian adalah penting, atau fungsi objektif boleh dianggarkan dengan fungsi yang lebih mudah dalam kejiranan ini. Oleh itu, kedua-dua idea pengoptimuman dijangka mencapai hasil yang baik, dan pengoptimuman parameter dimensi rendah biasanya lebih berkesan dan stabil.

Perwakilan dimensi rendah bagi ruang penyelesaian. Penyelidikan telah menunjukkan bahawa pengoptimuman parameter model bahasa pra-latihan mengikuti manifold berdimensi rendah (Aghajanyan et al., 2021), jadi manifold ini boleh dibenamkan ke dalam salah satu vektor penyelesaian perwakilan dimensi rendah. Jika perwakilan dimensi rendah ini tepat, maka penalaan halus parameter penuh pada model asal adalah bersamaan dengan penalaan halus pada parameter dimensi rendah ini. Sekiranya terdapat ralat dalam perwakilan dimensi rendah, maka apabila fungsi objektif model pra-latihan dan fungsi objektif baharu memenuhi kesinambungan Lipschitz, perbezaan kesan akhir antara penalaan halus parameter penuh dan parameter halus dimensi rendah- penalaan juga boleh dikawal.

Sesetengah kaedah Penalaan Delta mendapat manfaat daripada idea reka bentuk ini. Sebagai contoh, dalam LoRA (Hu et al., 2021a), matriks berat menggunakan anggaran peringkat rendah; dalam BitFit (Zaken et al., 2021) dan pemangkasan berbeza (Guo et al., 2021), hanya beberapa parameter terpilih sahaja pengoptimuman. Intipati kaedah ini adalah untuk mengemas kini parameter dalam subruang kecil vektor penyelesaian, dan akhirnya mencapai hasil yang lebih baik.

Perwakilan ruang fungsi berdimensi rendah. Pendekatan lain ialah dengan mereka bentuk terus fungsi anggaran fungsi objektif asal, dan menjangkakan ralat anggaran fungsi ini adalah kecil. Anggaran fungsi sedemikian boleh menjadi rangkaian tambahan (Houlsby et al., 2019) atau ruang ciri tambahan (Lester et al., 2021). Oleh kerana kita biasanya lebih mementingkan kesan akhir model bahasa, adalah munasabah untuk mempertimbangkan secara langsung kesan anggaran pada fungsi objektif itu sendiri.

Terdapat banyak cara berbeza untuk membina anggaran fungsi sedemikian dalam amalan. Yang paling mudah ialah membetulkan beberapa parameter dalam rangkaian dan hanya memperhalusi yang lain Kaedah ini menjangkakan bahawa sebahagian daripada rangkaian secara kasar boleh mencerminkan prestasi keseluruhan rangkaian. Oleh kerana peranan fungsi dalam rangkaian dicirikan oleh aliran data, perwakilan peringkat rendah boleh disuntik ke dalam laluan data dalam rangkaian asal, dan model baharu yang terhasil ialah rangkaian tambahan, seperti Penyesuai. Ralat fungsi ditentukan oleh kuasa perwakilan rangkaian delta.

Jika struktur autoregresif Transformer dibangunkan, beberapa anggaran fungsi yang lebih halus juga boleh diperolehi. Contohnya, penalaan segera (Lester et al., 2021) menambahkan satu siri token gesaan sebagai awalan pada input dan hanya memperhalusi parameter yang bergantung pada token gesaan ini. Kaedah ini boleh dianggap sebagai penambahan ruang ciri, dan terima kasih kepada sifat Transformer, fungsi sedemikian boleh menganggarkan fungsi asal dengan lebih baik dan membimbing model bahasa untuk memberi tumpuan kepada tugas tertentu. Kaedah yang berkaitan termasuk penalaan awalan (Li & Liang, 2021). Eksperimen telah mendapati bahawa penalaan segera mempunyai kelebihan yang lebih baik untuk model yang lebih besar dan set data yang lebih besar Ini juga munasabah kerana kaedah ini pada asasnya menggunakan fungsi dimensi rendah untuk menganggarkan fungsi dimensi tinggi, Apabila skala model dan data meningkat besar, secara semula jadi terdapat lebih banyak darjah kebebasan untuk memilih subruang penghampiran fungsi.

Dua perwakilan dimensi rendah biasanya boleh membawa kepada kaedah penalaan delta yang serupa secara rasmi. (He et al., 2022) membuat pernyataan bersatu secara rasmi mengenai Penyesuai, penalaan awalan dan LoRA, yang boleh dianggap sebagai melihat pelbagai teknik Penalaan Delta dari perspektif penghampiran fungsi. Perbincangan kami menunjukkan bahawa kaedah penalaan delta ini bergantung pada andaian dimensi rendah. Malah, terdapat juga subruang dimensi rendah biasa pada tugas yang berbeza (Qin et al., 2021b). Su et al. (2021) dan bahagian eksperimen kami juga menunjukkan kebolehpindahan Delta Tuning merentasi tugas yang berbeza. Oleh kerana kesan sebenar Penalaan Delta tidak dapat dielakkan berkaitan tugas, untuk mencapai kesan penalaan halus parameter penuh, adalah berfaedah untuk meneroka dan menggunakan struktur masalah itu sendiri dengan lebih baik atau mereka bentuk beberapa algoritma hibrid.

Sudut kawalan optimum

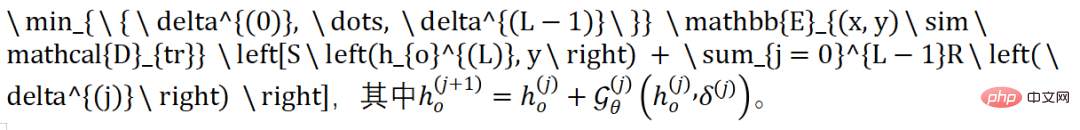

Berdasarkan teori terdahulu yang menerangkan pembelajaran mendalam dari sudut kawalan optimum, kita mulakan daripadanya didedahkan bahawa Delta Tuning boleh dianggap sebagai satu proses mencari pengawal yang optimum. Untuk model klasifikasi autoregresif, model akan menjana ramalan label dalam langkah terakhir (dilabelkan sebagai lokasi Proses pengoptimuman ini boleh dinyatakan sebagai:

Fungsi di sini mentakrifkan perambatan hadapan perubahan dalam PLM di bawah campur tangan Delta. Khususnya, pengaktifan yang boleh dipelajari ialah parameter tetap daripada supaya perwakilan pada lapisan boleh ditukar dengan betul kepada . Oleh itu, transformasi perwakilan antara dua lapisan berturut-turut diterangkan oleh fungsi dan sambungan baki dalam Transformer. Sama ada kaedah Penyesuai dan Awalan berasaskan Penambahan, kaedah BitFit yang ditentukan atau kaedah penparameteran berat LoRA, kita boleh memperoleh fungsi sedemikian untuk mewakili Penalaan Delta (derivasi terperinci ada dalam kertas).

Kami menganggap fungsi Softmax dan istilah regularisasi dalam Delta Tuning sebagai terminal, dan menganggap parameter Delta sebagai kehilangan operasi pembolehubah kawalan, dan merumuskan masalah Delta Tuning sebagai masa diskret masalah kawalan , jadi perambatan ke hadapan dan ke belakang dalam Delta Tuning adalah bersamaan dengan pengiraan proses comorphic dalam prinsip maksimum Pontryagin. Ringkasnya, penalaan tambahan boleh dilihat sebagai proses mencari pengawal optimum untuk PLM untuk tugas hiliran tertentu.

Analisis kami boleh memberi inspirasi kepada reka bentuk kaedah Penalaan Delta novel, dan kami juga menunjukkan bahawa campur tangan parameter delta dalam PLM adalah bersamaan dengan reka bentuk pengawal. Dengan menggunakan teori reka bentuk pengawal, kami mengharapkan untuk mencadangkan lebih banyak kaedah penalaan delta dengan jaminan teori bahawa struktur delta yang direka pada dasarnya boleh ditafsirkan di bawah pengujaan PLM yang mencukupi.

Analisis percubaan komprehensif Delta TuningSebagai kaedah yang cekap untuk merangsang dan memanggil PLM berskala besar, Delta Tuning mempunyai potensi besar dalam pelbagai senario aplikasi praktikal. Dalam bahagian ini, kami menjalankan eksperimen sistematik untuk mendapatkan pemahaman yang lebih mendalam tentang sifat kaedah penalaan delta arus perdana yang berbeza.

1. Analisis prestasi, penumpuan dan kecekapan

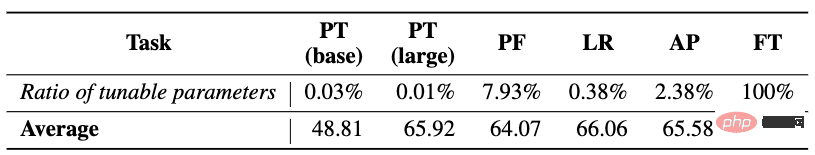

Kami mula-mula memilih Penalaan Halus parameter penuh dan empat kaedah Penalaan Delta yang mewakili (termasuk Penalaan Segera (PT), Penalaan Awalan (PF), LoRA (LR) dan Penyesuai (AP ) ) menyediakan perbandingan menyeluruh prestasi, penumpuan dan analisis kecekapan. Untuk menguji keupayaan pemodelan bahasa yang lebih pelbagai, kami memilih lebih daripada 100 tugas NLP biasa, termasuk klasifikasi teks (seperti klasifikasi sentimen, inferens bahasa semula jadi), menjawab soalan (seperti pemahaman bacaan ekstraktif), penjanaan bahasa (seperti ringkasan teks. ) , dialog) dan tugasan lain, dan input dan output semua tugasan dimodelkan ke dalam format urutan-ke-jujukan, supaya mudah untuk menggunakan model yang sama (T5) untuk memodelkan semua tugas secara seragam. Kecuali PT diuji pada asas T5 dan T5 besar, kaedah lain diuji pada asas T5.

Analisis Prestasi: Keputusan eksperimen ditunjukkan dalam jadual di atas, kita dapati bahawa , (1) Secara umum, memandangkan kaedah Penalaan Delta yang berbeza hanya memperhalusi beberapa parameter, meningkatkan kesukaran pengoptimuman, mereka tidak dapat menandingi prestasi FT dalam kebanyakan kes, tetapi jurang antara kedua-duanya tidak dapat diatasi Ini menunjukkan potensi untuk aplikasi berskala besar bagi penyesuaian parameter yang cekap. (2) Walaupun elemen reka bentuk bagi tiga kaedah PF, LR, dan AP adalah berbeza, ia adalah setanding dalam prestasi. Mana-mana satu daripada mereka boleh melakukan lebih baik daripada yang lain (atau FT) pada beberapa tugasan. Berdasarkan keputusan purata, kedudukan prestasi semua kaedah ialah FT > LR > AP > PF > PT. Pada masa yang sama, kami juga mendapati bahawa prestasi kaedah Delta Tuning tidak konsisten dengan bilangan parameter boleh larasnya, iaitu, lebih banyak parameter boleh laras tidak semestinya membawa prestasi yang lebih baik Sebaliknya, reka bentuk struktur khusus Delta Tuning mungkin memainkan peranan yang lebih penting. (3) PT adalah yang paling mudah untuk dilaksanakan antara kaedah ini (iaitu, ia tidak mengubah suai struktur dalaman model Dalam kebanyakan kes, prestasinya jauh ketinggalan berbanding kaedah penalaan delta yang lain.

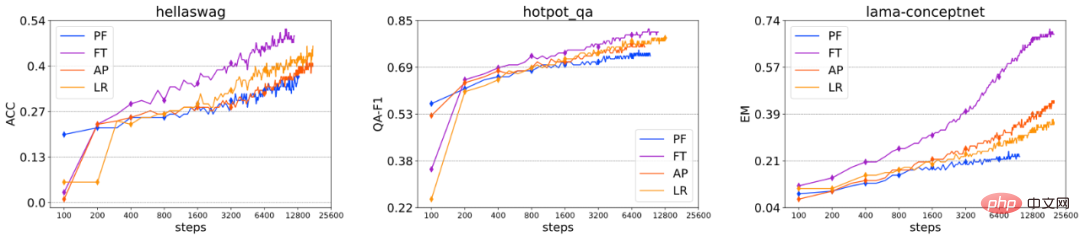

Analisis penumpuan: Kami memetik prestasi kaedah penalaan halus yang berbeza pada beberapa set data . Perubahan prestasi di bawah bilangan langkah latihan, yang tidak termasuk dalam rajah di atas kerana kelajuan penumpuan PT terlalu perlahan berbanding kaedah lain. Kita boleh mendapati bahawa, secara amnya, susunan kelajuan penumpuan kaedah penalaan halus ini ialah: FT > AP ≈ LR > PF. Walaupun PF mempunyai bilangan parameter boleh tala yang terbesar di antara semua kaedah Penalaan Delta, ia masih menghadapi beberapa kesukaran penumpuan, jadi kelajuan penumpuan tidak berkaitan secara langsung dengan bilangan parameter yang boleh diperhalusi. Dalam eksperimen, kami juga mendapati bahawa bagi setiap kaedah Penalaan Delta, prestasi dan penumpuan tidak sensitif kepada bilangan parameter boleh laras, tetapi lebih sensitif kepada struktur tertentu. Secara keseluruhan, eksperimen kami membawa kepada kesimpulan yang hampir sama dari segi penumpuan dan prestasi keseluruhan, dan kesimpulan ini disokong dengan baik oleh keputusan pada sejumlah besar set data.

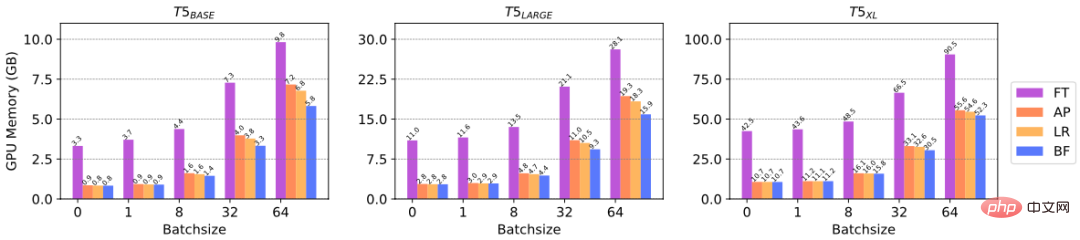

Analisis kecekapan: Delta Tuning boleh mengurangkan pengiraan kecerunan parameter, dengan itu menjimatkan memori GPU , Ia mencerminkan kecekapan sumber pengkomputeran. Untuk mengesahkan secara khusus peningkatan kecekapan Delta Tuning pada memori GPU, kami menjalankan eksperimen untuk membandingkan memori GPU yang digunakan oleh kaedah Delta Tuning yang berbeza untuk penalaan halus pada PLM dengan saiz yang berbeza. Khususnya, kami memilih tiga skala model T5, iaitu asas T5, T5-besar dan T5-xl, dan menguji memori GPU puncak yang dicapai pada saiz kelompok yang berbeza. Kami menggunakan NVIDIA A100 (memori GPU maksimum = 39.58GB) untuk percubaan. Daripada rajah di atas, kita dapat melihat bahawa apabila saiz kelompok kecil (contohnya, 1, 8), Delta Tuning boleh menjimatkan sehingga 3/4 daripada memori GPU, dan apabila saiz kelompok besar, Delta Tuning boleh menjimatkan sekurang-kurangnya 1/3 daripada memori GPU. Keputusan di atas mencerminkan kecekapan Delta Tuning dari segi sumber pengkomputeran.

2. Analisis Kebolehkomposan

Memandangkan kaedah Penalaan Delta yang berbeza adalah serasi antara satu sama lain, ini bermakna Oleh itu, ia boleh digunakan pada PLM yang sama pada masa yang sama. Jadi kami menyiasat sama ada gabungan Delta Tuning akan membawa kepada peningkatan prestasi. Secara khusus, kami meneroka dua kaedah gabungan: gabungan serentak dan gabungan berjujukan, dan memilih tiga kaedah Penalaan Delta yang mewakili, termasuk Penalaan Pantas, BitFit dan Penyesuai.

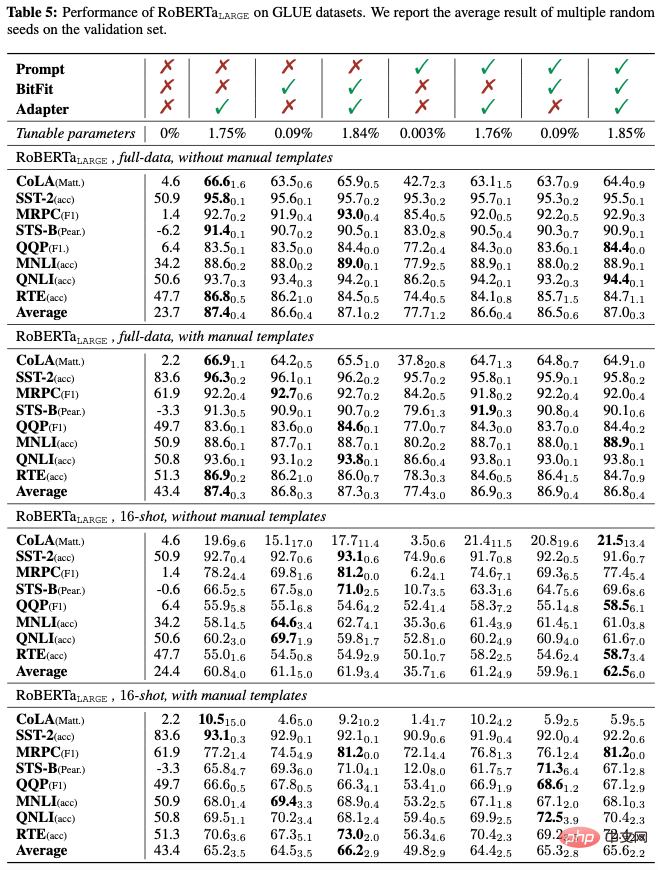

Gabungan serentak: Kami mula-mula meneroka kesan menggunakan tiga kaedah Penalaan Delta serentak dan menjalankan eksperimen pada 8 subtugas GLUE menggunakan RoBERTa-large. Kami menjalankan eksperimen dalam kedua-dua data penuh dan senario sumber rendah, dan meneroka kesan templat input tiruan pada prestasi Templat tiruan direka bentuk untuk merapatkan jurang antara pra-latihan dan penyesuaian tugasan hiliran.

Seperti yang dapat dilihat daripada jadual di atas, (1) sama ada dalam data penuh atau senario sumber rendah, sama ada Manual templat wujud, dan memperkenalkan Penyesuai dalam gabungan Penalaan Delta hampir selalu membantu prestasi GLUE purata; (2) memperkenalkan Penalaan Pantas dalam gabungan biasanya menjejaskan prestasi purata, menunjukkan bahawa Penalaan Pantas mungkin tidak serasi dengan dua kaedah Penalaan Delta yang lain; ) Memperkenalkan BitFit ke dalam campuran secara amnya meningkatkan prestasi purata; (4) Templat manual boleh meningkatkan prestasi sifar pukulan dengan ketara (dari 23.7 kepada 43.4) dengan menutup jurang antara penyesuaian tugas hiliran dan pra-latihan. Dalam tetapan beberapa tangkapan, templat tiruan juga boleh meningkatkan prestasi purata dengan ketara. Walau bagaimanapun, apabila isyarat penyeliaan latihan agak banyak (dalam senario data penuh), pengenalan templat buatan hanya menunjukkan peningkatan prestasi yang lemah, malah boleh merosakkan prestasi.

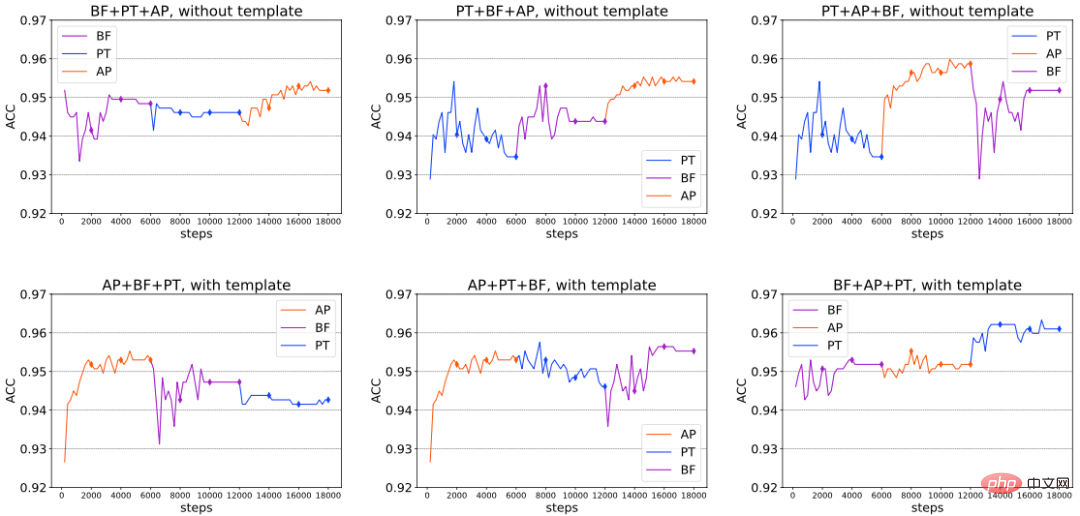

Kombinasi berurutan: Sebagai tambahan kepada gabungan serentak, kami terus mengkaji keserasian ketiga-tiga kaedah Penalaan Delta di atas apabila ia diperkenalkan dalam susunan tertentu. Secara khusus, kami membahagikan keseluruhan penalaan halus kepada 3 peringkat. Dalam setiap peringkat, kami melatih kaedah Penalaan Delta yang berasingan dalam peringkat berikut, kami menetapkan parameter Penalaan Delta yang dilatih pada peringkat sebelumnya tidak berubah dan hanya mengoptimumkan parameter Penalaan Delta yang baru diperkenalkan. Kami menjalankan eksperimen pada RoBERTa-besar dengan/tanpa templat tiruan pada set data klasifikasi sentimen SST-2. Hasilnya ditunjukkan dalam rajah di bawah (petikan), dari mana kita boleh membuat kesimpulan bahawa dalam beberapa kes, prestasi keseluruhan boleh terus dipertingkatkan dengan terus memperkenalkan kaedah Penalaan Delta baharu, sekali gus mengesahkan kelebihan gabungan berjujukan pada masa yang sama, kami juga mendapati , di bawah tetapan berbeza, tiada urutan gabungan optimum tetap. Gabungan optimum mungkin berbeza-beza disebabkan oleh tugas hiliran yang berbeza, seni bina model yang digunakan dan faktor lain.

Analisis jurang generalisasi: Keupayaan hafalan dan generalisasi pelbagai kaedah penalaan halus pada data latihan ( Generalisasi) bukanlah sama. Untuk tujuan ini, kami melaporkan jurang generalisasi (kesan set latihan - kesan set pembangunan) RoBERTa-large dalam tetapan data penuh Hasilnya ditunjukkan dalam jadual di bawah, dari mana kita boleh melihat bahawa (1) Generalisasi satu Kaedah Penalaan Delta Jurang sentiasa lebih kecil daripada Penalaan Halus, yang bermaksud penparameteran berlebihan boleh membantu untuk menghafal (overfit) sampel latihan dengan lebih baik. Penalaan Pantas cenderung mempunyai jurang generalisasi terkecil di antara semua kaedah penalaan delta. Memandangkan setiap kaedah Delta Tuning boleh membuat generalisasi dengan baik dan menunjukkan prestasi bukan remeh pada set pembangunan, overfitting set latihan mungkin bukan syarat yang diperlukan untuk generalisasi yang baik; jurang, malah mencapai tahap yang sama seperti Penalaan Halus penuh. Ini menunjukkan bahawa mengingati set latihan (Menghafal) mungkin tidak memerlukan terlalu banyak penalaan halus, dengan kata lain, apabila PLM menyesuaikan diri dengan tugas hiliran, walaupun kapasiti penalaan halus model itu kecil, ia masih cukup baik untuk menghafal; set latihan; (3) Menggunakan templat buatan secara amnya tidak menjejaskan jurang generalisasi.

3 Prestasi berubah apabila saiz model meningkat

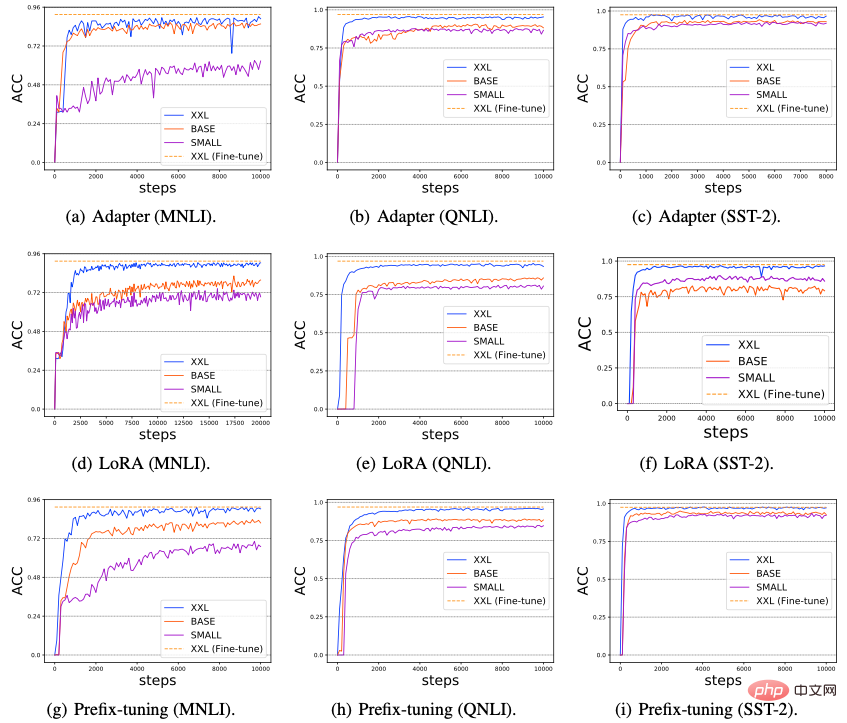

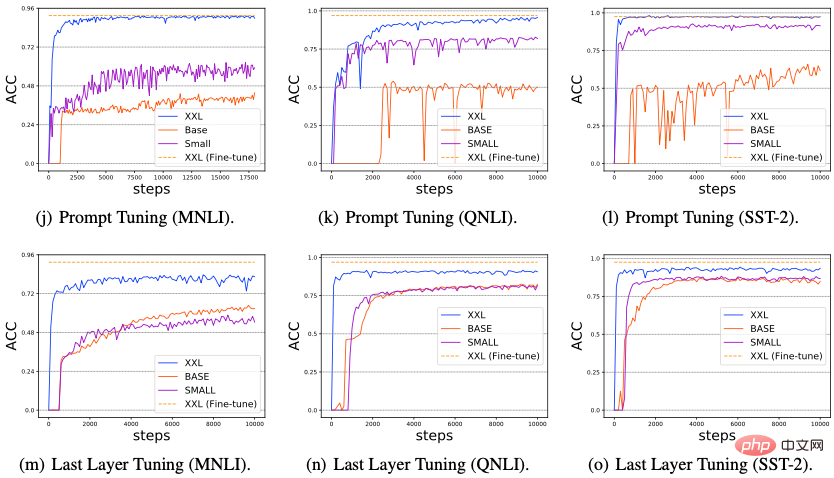

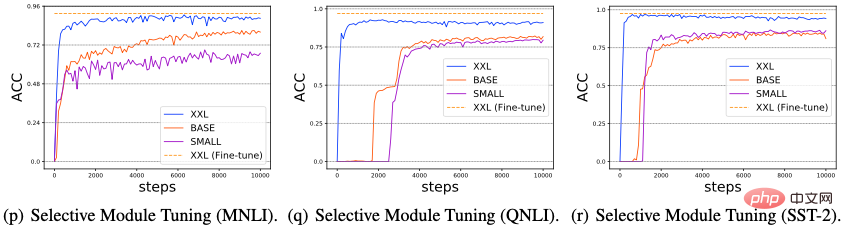

Kami mengkaji kesan peningkatan saiz model terhadap prestasi Delta Tuning pengaruh. Baru-baru ini, beberapa penyelidikan mendapati bahawa apabila saiz model PLM yang digunakan meningkat, prestasi Penalaan Pantas akan menjadi lebih kuat dan lebih kukuh, malah boleh mencapai tahap yang setanding dengan penalaan halus parameter penuh. Dalam bahagian ini, kami meneroka sama ada semua kaedah penalaan delta mempamerkan Kuasa Skala. Khususnya, kami menjalankan eksperimen pada tiga tugas NLP biasa: MNLI, QNLI dan SST-2, dan memilih tiga PLM skala yang semakin meningkat (T5-kecil, T5-asa, T5-xxl), dan menilai Prestasi enam penalaan delta perwakilan kaedah (Penyesuai, LoRA, Penalaan Awalan, Penalaan Pantas, Penalaan Lapisan Terakhir dan Penalaan Modul Terpilih), hasilnya ditunjukkan dalam rajah di bawah.

Daripada Rajah (a-i), kita boleh perhatikan bahawa apabila skala rangkaian PLM berkembang, prestasi dan penumpuan semua kaedah Penalaan Delta bertambah baik dengan ketara; menunjukkan bahawa berbanding dengan kaedah penalaan delta lain, Penalaan Pantas cenderung berprestasi buruk, pada PLM berskala kecil (T5-kecil dan T5-asas). Walau bagaimanapun, kaedah Delta Tuning yang lain tidak mempunyai masalah ini; (3) Berdasarkan keputusan yang sedia ada, dalam Rajah 11 (m-o) dan (p-r), kami selanjutnya mereka bentuk dua kaedah Delta Tuning: Last Layer Tuning dan Selective Module Tuning. Untuk Penalaan Lapisan Terakhir, kami hanya memperhalusi lapisan terakhir pengekod T5 untuk Penalaan Modul Terpilih, kami secara rawak memilih beberapa modul dalam model T5 untuk penalaan halus. Kedua-dua kaedah menunjukkan hasil yang sangat baik, terutamanya apabila skala PLM sangat besar, dengan Penalaan Modul Selektif sedikit lebih baik daripada Penalaan Lapisan Terakhir. Keputusan ini menunjukkan bahawa mengehadkan parameter boleh tala halus kepada lapisan tertentu mungkin bukan strategi yang baik. Sebaliknya, apabila skala PLM menjadi sangat besar, penalaan halus dengan memilih modul secara rawak merentas lapisan berbeza boleh mencapai prestasi cemerlang. Secara keseluruhan, keputusan di atas menunjukkan bahawa apabila saiz model PLM berkembang, peningkatan ketara dalam prestasi/kelajuan penumpuan pelbagai kaedah penalaan halus mungkin merupakan fenomena biasa dalam Penalaan Delta. Kami membuat spekulasi bahawa fenomena ini wujud kerana PLM yang lebih besar biasanya mempunyai dimensi intrinsik yang lebih kecil (Dimensi Intrinsik Oleh itu, hanya melaraskan beberapa parameter boleh memperoleh keupayaan perwakilan yang cukup kuat untuk dilaksanakan dalam tugasan hiliran sebagai tambahan, model yang lebih berparameter mungkin kurang berkemungkinan jatuh ke dalam optima tempatan semasa pengoptimuman hiliran, sekali gus mempercepatkan penumpuan.

4. Keupayaan penghijrahan antara tugas

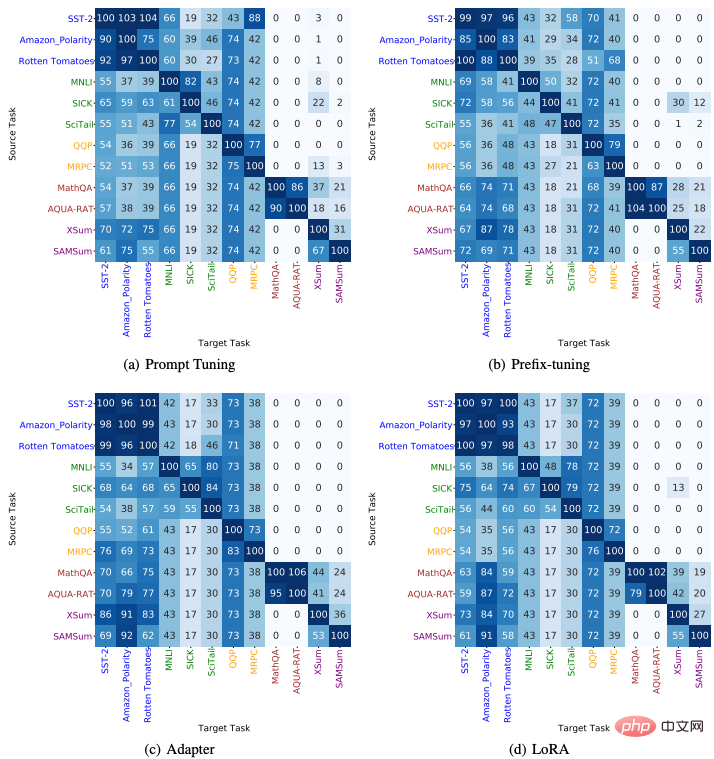

Kami mengkaji kebolehpindahan kaedah Delta Tuning antara tugas hiliran yang berbeza Khususnya, kami menggunakan 4 kaedah Penalaan Delta (Penalaan Segera, Penalaan Awalan, Penyesuai dan LoRA) dan 5 jenis 12 tugasan NLP (termasuk analisis sentimen, penaakulan bahasa semula jadi, pengecaman parafrasa, menjawab soalan, Ringkasan) dan memindahkan Delta parameter yang dilatih pada tugas sumber kepada tugas sasaran untuk menguji kesan pemindahan pukulan sifar. Hasilnya ditunjukkan dalam rajah di bawah, yang boleh kita perhatikan: (1) Untuk tugasan yang tergolong dalam kategori yang sama, pemindahan antara mereka biasanya berprestasi baik; ; (3) Di samping itu, kami mendapati bahawa parameter Delta yang dilatih daripada tugas penjanaan teks (seperti soal jawab dan ringkasan) boleh dipindahkan ke tugasan analisis sentimen dan mencapai prestasi cemerlang, yang menunjukkan bahawa tugas penjanaan teks mungkin lebih tugas yang kompleks untuk diselesaikan Kemahiran bahasa yang diperlukan untuk tugas itu mungkin termasuk kemahiran analisis sentimen.

Latihan pantas dan penjimatan ruang simpanan. Model pengubah, walaupun secara semula jadi boleh disejajarkan, sangat lambat untuk dilatih kerana saiznya yang besar. Walaupun kadar penumpuan Penalaan Delta mungkin lebih perlahan daripada penalaan halus parameter penuh tradisional, kelajuan latihan Penalaan Delta juga dipertingkatkan dengan ketara kerana usaha pengiraan parameter boleh tala halus semasa perambatan belakang dikurangkan dengan ketara. Penyelidikan terdahulu telah mengesahkan bahawa menggunakan Penyesuai untuk penalaan hiliran boleh mengurangkan masa latihan kepada 40% sambil mengekalkan prestasi yang setanding dengan penalaan halus parameter penuh. Disebabkan sifatnya yang ringan, parameter Delta terlatih juga boleh menjimatkan ruang storan, dengan itu memudahkan perkongsian dalam kalangan pengamal dan menggalakkan pemindahan pengetahuan.

Pembelajaran pelbagai tugas. Membina sistem kecerdasan buatan am telah lama menjadi matlamat penyelidik. Baru-baru ini, PLM yang sangat besar (cth., GPT-3) telah menunjukkan kebolehan yang menakjubkan untuk menyesuaikan pengedaran data yang berbeza secara serentak dan memudahkan prestasi hiliran pada pelbagai tugas. Oleh itu, dalam era pra-latihan berskala besar, pembelajaran pelbagai tugas semakin mendapat perhatian. Sebagai alternatif yang berkesan kepada kaedah penalaan halus parameter penuh, Delta Tuning mempunyai keupayaan pembelajaran berbilang tugas yang sangat baik sambil mengekalkan storan tambahan yang agak rendah. Aplikasi yang berjaya termasuk pembelajaran berbilang bahasa, pemahaman bacaan dan banyak lagi. Selain itu, Delta Tuning juga dijangka berfungsi sebagai penyelesaian yang berpotensi untuk melupakan bencana dalam pembelajaran berterusan. Kebolehan bahasa yang diperoleh semasa pra-latihan disimpan dalam parameter model. Oleh itu, mengemas kini semua parameter dalam PLM tanpa penyelarasan boleh membawa kepada pelupaan yang teruk dan bencana apabila PLM dilatih secara berurutan merentasi urutan tugas. Memandangkan Delta Tuning hanya menala parameter minimum, ia boleh menjadi penyelesaian yang berpotensi untuk mengurangkan masalah pelupaan bencana.

Penyajian model berpusat dan pengkomputeran selari. PLM yang sangat besar sering dikeluarkan sebagai perkhidmatan, iaitu, pengguna menggunakan model besar dengan berinteraksi dengan API yang diterbitkan oleh pembekal model, dan bukannya menyimpan model besar secara tempatan. Memandangkan kos komunikasi yang tidak dapat ditanggung antara pengguna dan penyedia perkhidmatan, Delta Tuning jelas merupakan pilihan yang lebih kompetitif daripada penalaan halus parameter penuh tradisional kerana sifatnya yang ringan. Di satu pihak, penyedia perkhidmatan boleh menyokong tugas hiliran yang diperlukan untuk melatih berbilang pengguna sambil menggunakan kurang pengkomputeran dan ruang storan. Di samping itu, memandangkan beberapa algoritma Penalaan Delta sememangnya boleh diselaraskan (seperti Penalaan Pantas dan Penalaan Awalan, dsb.), Penalaan Delta boleh membenarkan latihan/pengujian selari sampel daripada berbilang pengguna dalam kumpulan yang sama (Pengkomputeran Selari Dalam Kelompok) . Kerja-kerja baru-baru ini juga telah menunjukkan bahawa kebanyakan kaedah penalaan delta, jika tidak boleh selari, boleh diubah suai dalam beberapa cara untuk menyokong pengiraan selari. Sebaliknya, apabila kecerunan model pusat tidak tersedia kepada pengguna, Delta Tuning masih dapat mengoptimumkan PLM besar melalui algoritma kotak hitam tanpa kecerunan dan hanya memanggil API inferens model.

Atas ialah kandungan terperinci Analisis komprehensif parameter model besar dan penalaan halus yang cekap, penyelidikan Tsinghua diterbitkan dalam sub-jurnal Alam. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!