2022 ialah tahun apabila Kandungan Dihasilkan AI (AIGC) meletup Salah satu arahan yang popular ialah mengedit gambar melalui penerangan teks (gesaan teks). Kaedah sedia ada biasanya bergantung pada model generatif yang dilatih pada set data berskala besar, yang bukan sahaja menghasilkan pemerolehan data dan kos latihan yang tinggi, tetapi juga menghasilkan saiz model yang lebih besar. Faktor-faktor ini telah membawa ambang yang tinggi kepada pembangunan dan aplikasi teknologi sebenar, mengehadkan pembangunan dan kreativiti AIGC.

Sebagai tindak balas kepada perkara yang menyakitkan di atas, NetEase Interactive Entertainment AI Lab bekerjasama dengan Shanghai Jiao Tong University untuk menjalankan penyelidikan dan secara inovatif mencadangkan penyelesaian berdasarkan pemapar vektor boleh dibezakan - CLIPVG, untuk yang pertama masa Ia mencapai penyuntingan imej berpandukan teks tanpa bergantung pada mana-mana model generatif. Penyelesaian ini bijak menggunakan ciri-ciri elemen vektor untuk mengekang proses pengoptimuman Oleh itu, ia bukan sahaja dapat mengelakkan keperluan data yang besar dan overhed latihan yang tinggi, tetapi juga mencapai tahap optimum dari segi kesan penjanaan. Kertas yang sepadan "CLIPVG: Manipulasi Imej Berpandu Teks Menggunakan Grafik Vektor Boleh Dibezakan" telah disertakan dalam AAAI 2023.

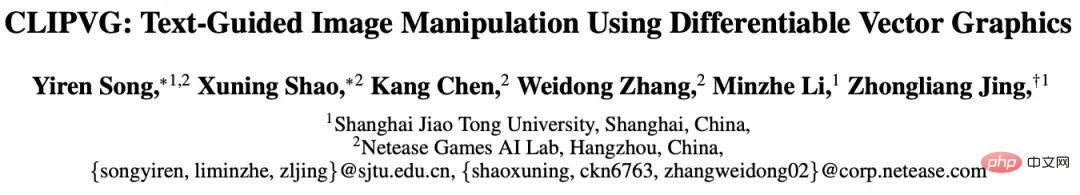

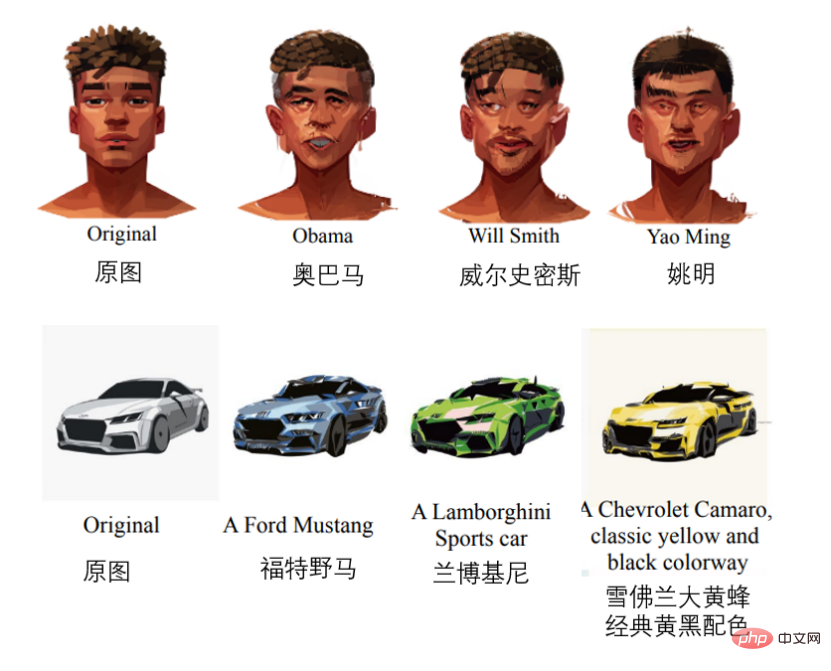

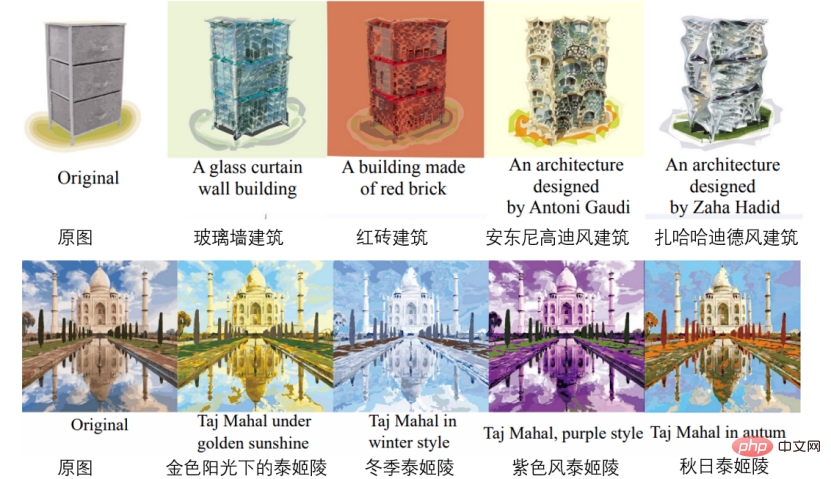

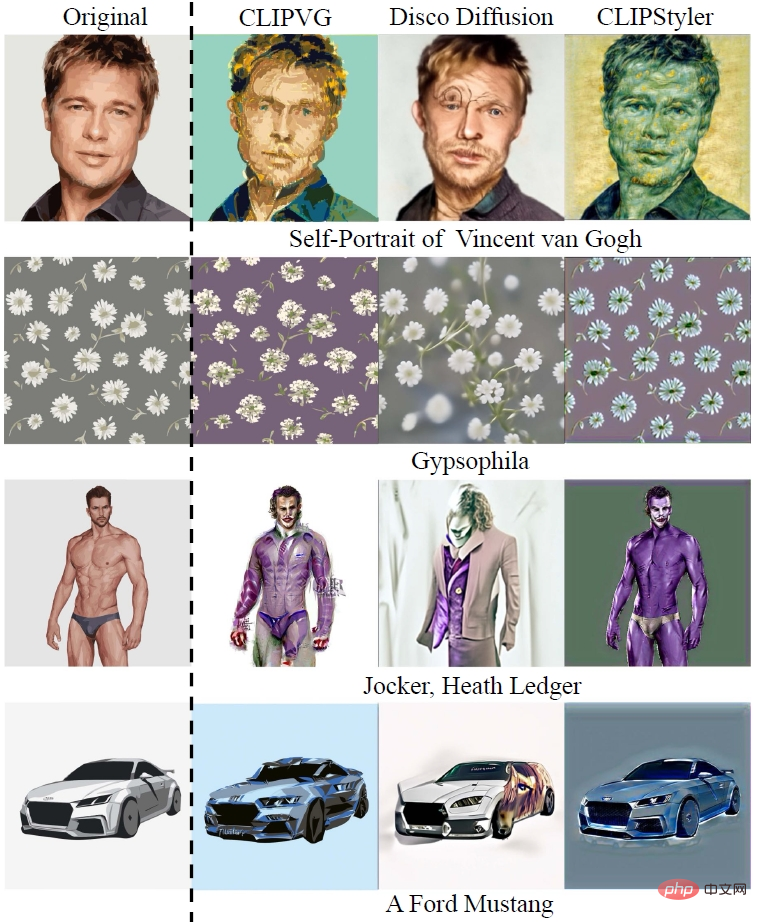

Beberapa kesan adalah seperti mengikut (mengikut urutan) Untuk penyuntingan muka, pengubahsuaian model kereta, penjanaan bangunan, perubahan warna, pengubahsuaian corak, pengubahsuaian fon).

sedang menjana Dari segi kesan, CLIPVG meningkatkan ketepatan semantik sebanyak 15.9% dan kualiti penjanaan sebanyak 23.6% berbanding penyelesaian lain yang diketahui dalam industri, iaitu, ia secara automatik boleh mengedit dan mengeluarkan imej yang lebih sesuai dari segi semantik dan bebas ralat. Dari segi fleksibiliti rangka kerja, memandangkan CLIPVG boleh menukar imej piksel secara automatik kepada grafik vektor, ia boleh mengedit warna imej, bentuk, sub-rantau dan sebagainya secara bebas dengan lebih fleksibel berbanding rangka kerja penyelidikan berasaskan imej piksel yang lain. Dari segi senario aplikasi, memandangkan CLIPVG tidak bergantung pada model generatif sama sekali, ia boleh digunakan pada julat yang lebih luas senario, seperti penggayaan potret, penyuntingan kartun, reka bentuk fon, pewarnaan automatik, dll. Malah boleh mencapai satu- padanan kepada-satu di bawah beberapa keadaan teks Bahagian yang berbeza pada gambar boleh disunting serentak.

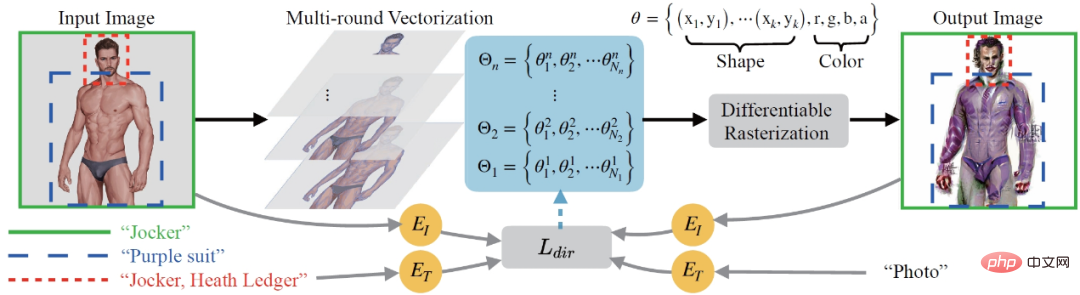

Dari perspektif keseluruhan proses, CLIPVG mula-mula mencadangkan kaedah pemvektoran berbilang pusingan yang boleh menukar imej piksel ke domain vektor dengan mantap dan menyesuaikan kepada keperluan penyuntingan imej seterusnya. Kehilangan ROI CLIP kemudiannya ditakrifkan sebagai fungsi kerugian untuk menyokong panduan dengan teks yang berbeza untuk setiap kawasan kepentingan (ROI). Keseluruhan proses pengoptimuman menggunakan pemapar vektor yang boleh dibezakan untuk melakukan pengiraan kecerunan pada parameter vektor (seperti warna blok warna, titik kawalan, dsb.).

CLIPVG menyepadukan teknologi daripada dua medan, satu ialah pengeditan imej berpandukan teks dalam domain piksel dan satu lagi ialah penjanaan imej vektor. Seterusnya, latar belakang teknikal yang berkaitan akan diperkenalkan secara bergilir-gilir.

Terjemahan imej berpandukan teks

Kaedah biasa untuk membolehkan AI "memahami" panduan teks semasa mengedit imej Ia menggunakan model Contrastive Language-Image Pra-Training (CLIP). Model CLIP boleh mengekodkan teks dan imej ke dalam ruang terpendam yang setanding dan menyediakan maklumat persamaan silang mod tentang "sama ada imej itu mematuhi penerangan teks", dengan itu mewujudkan hubungan semantik antara teks dan imej. Walau bagaimanapun, sebenarnya, sukar untuk membimbing penyuntingan imej secara berkesan hanya menggunakan model CLIP Ini kerana CLIP memberi tumpuan terutamanya pada maklumat semantik peringkat tinggi imej dan tidak mempunyai kekangan pada butiran tahap piksel, menyebabkan proses pengoptimuman. mudah jatuh ke dalam optimum tempatan (minimum tempatan) atau penyelesaian yang bertentangan.

Kaedah sedia ada yang biasa adalah menggabungkan CLIP dengan model penjanaan domain piksel berdasarkan GAN atau Diffusion, seperti StyleCLIP (Patashnik et al, 2021), StyleGAN-NADA (Gal et al, 2022), Disco Diffusion (alembik 2022), DiffusionCLIP (Kim, Kwon, dan Ye 2022), DALL·E 2 (Ramesh et al, 2022) dan sebagainya. Skim ini menggunakan model generatif untuk mengekang butiran imej, sekali gus menebus kelemahan menggunakan CLIP sahaja. Tetapi pada masa yang sama, model generatif ini sangat bergantung pada data latihan dan sumber pengkomputeran, dan akan menjadikan julat penyuntingan imej yang berkesan dihadkan oleh imej set latihan. Terhad oleh keupayaan untuk menjana model, kaedah seperti StyleCLIP, StyleGAN-NADA dan DiffusionCLIP hanya boleh mengehadkan satu model kepada medan tertentu, seperti imej muka. Walaupun kaedah seperti Disco Diffusion dan DALL·E 2 boleh mengedit sebarang imej, kaedah tersebut memerlukan data dan sumber pengkomputeran yang besar untuk melatih model generatif yang sepadan.

Pada masa ini terdapat sangat sedikit penyelesaian yang tidak bergantung pada model generatif, seperti CLIPstyler (Kwon dan Ye 2022). Semasa pengoptimuman, CLIPstyler akan membahagikan imej untuk diedit kepada tampung rawak dan menggunakan panduan CLIP pada setiap tampung untuk mengukuhkan kekangan pada butiran imej. Masalahnya ialah setiap tampung akan mencerminkan secara bebas semantik yang ditakrifkan oleh teks input Akibatnya, penyelesaian ini hanya boleh melakukan pemindahan gaya, tetapi tidak boleh melakukan pengeditan semantik peringkat tinggi secara keseluruhan.

Berbeza daripada kaedah domain piksel di atas, penyelesaian CLIPVG yang dicadangkan oleh NetEase Interactive Entertainment AI Lab menggunakan ciri grafik vektor untuk mengekang butiran imej bagi menggantikan model generatif. CLIPVG boleh menyokong sebarang imej input dan boleh melakukan pengeditan imej tujuan umum. Outputnya ialah grafik vektor format svg standard, yang tidak dihadkan oleh peleraian.

Sesetengah karya sedia ada menganggap penjanaan grafik vektor berpandukan teks, seperti CLIPdraw (Frans, Soros, dan Witkowski 2021), StyleCLIPdraw (Schaldenbrand, Liu , dan Oh 2022) et al. Pendekatan biasa ialah menggabungkan CLIP dengan pemapar vektor yang boleh dibezakan, dan bermula daripada grafik vektor yang dimulakan secara rawak dan secara beransur-ansur menghampiri semantik yang diwakili oleh teks. Penyampai vektor boleh dibezakan yang digunakan ialah Diffvg (Li et al. 2020), yang boleh merasterkan grafik vektor kepada imej piksel melalui pemaparan boleh dibezakan. CLIPVG juga menggunakan Diffvg untuk mewujudkan sambungan antara imej vektor dan imej piksel Berbeza daripada kaedah sedia ada, CLIPVG memfokuskan pada cara mengedit imej sedia ada dan bukannya menjananya secara langsung.

Memandangkan kebanyakan imej sedia ada adalah imej piksel, ia perlu divektorkan sebelum ia boleh diedit menggunakan ciri grafik vektor. Kaedah vektorisasi sedia ada termasuk Adobe Image Trace (AIT), LIVE (Ma et al. 2022), dsb., tetapi kaedah ini tidak mengambil kira keperluan penyuntingan berikutnya. CLIPVG memperkenalkan beberapa pusingan kaedah peningkatan vektorisasi berdasarkan kaedah sedia ada untuk meningkatkan keteguhan penyuntingan imej secara khusus.

Pelaksanaan teknikal

Proses keseluruhan CLIPVG ditunjukkan dalam rajah di bawah. Pertama, imej piksel input tertakluk kepada vektorisasi berbilang pusingan (Multi-round Vectorization) dengan ketepatan yang berbeza, di mana set elemen vektor yang diperoleh dalam pusingan ke-i ditandakan sebagai Θi. Keputusan yang diperolehi dalam setiap pusingan akan ditindih bersama sebagai objek pengoptimuman, dan ditukar kembali kepada domain piksel melalui pemaparan vektor boleh dibezakan (Rasterisasi Boleh Dibezakan). Keadaan permulaan imej output ialah pembinaan semula vektor imej input, dan kemudian pengoptimuman berulang dilakukan mengikut arah yang diterangkan dalam teks. Proses pengoptimuman akan mengira kehilangan ROI CLIP ( dalam rajah di bawah) berdasarkan julat kawasan dan teks yang berkaitan bagi setiap ROI, dan mengoptimumkan setiap elemen vektor mengikut kecerunan, termasuk parameter warna dan parameter bentuk.

dalam rajah di bawah) berdasarkan julat kawasan dan teks yang berkaitan bagi setiap ROI, dan mengoptimumkan setiap elemen vektor mengikut kecerunan, termasuk parameter warna dan parameter bentuk.

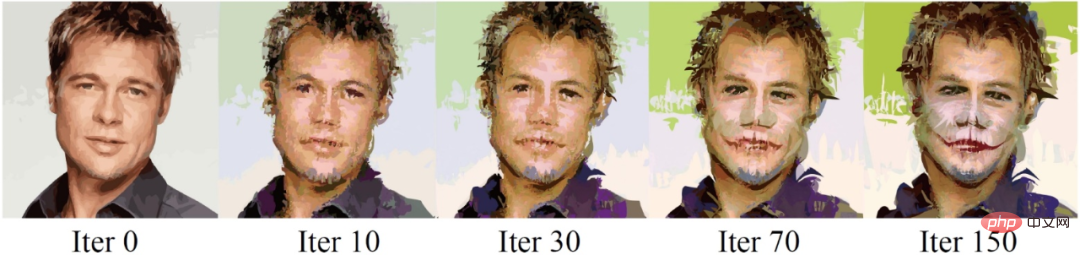

Keseluruhan proses pengoptimuman berulang boleh dilihat dalam contoh berikut, di mana teks panduan ialah "Jocker, Heath Ledger" (Joker, Heath Lejar) .

Vektorisasi

Grafik vektor boleh ditakrifkan sebagai koleksi elemen vektor, di mana setiap elemen vektor dikawal oleh satu siri parameter. Parameter elemen vektor bergantung pada jenisnya. Mengambil lengkung yang diisi sebagai contoh, parameternya ialah , dengan ialah Titik kawalan. parameter, ialah parameter untuk warna RGB dan kelegapan. Terdapat beberapa kekangan semula jadi semasa mengoptimumkan elemen vektor Contohnya, warna di dalam elemen sentiasa konsisten, dan hubungan topologi antara titik kawalannya juga tetap. Ciri-ciri ini mengimbangi kekurangan kekangan terperinci CLIP dan boleh meningkatkan keteguhan proses pengoptimuman.

Secara teorinya, CLIPVG boleh divektorkan menggunakan mana-mana kaedah sedia ada. Tetapi penyelidikan mendapati bahawa berbuat demikian boleh membawa kepada beberapa masalah dengan penyuntingan imej seterusnya. Pertama sekali, kaedah vektorisasi biasa boleh memastikan bahawa elemen vektor bersebelahan imej diselaraskan dengan sempurna dalam keadaan awal, tetapi setiap elemen akan bergerak dengan proses pengoptimuman, menyebabkan "retak" muncul di antara elemen. Kedua, kadangkala imej input agak mudah dan hanya memerlukan sebilangan kecil elemen vektor untuk dimuatkan, manakala kesan penerangan teks memerlukan butiran yang lebih kompleks untuk dinyatakan, mengakibatkan kekurangan bahan mentah yang diperlukan (elemen vektor) semasa penyuntingan imej.

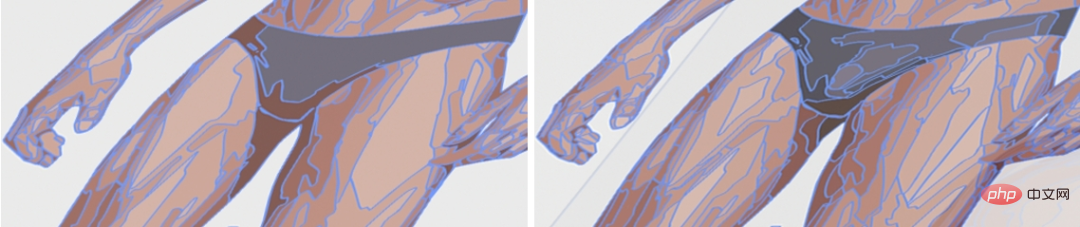

Sebagai tindak balas kepada masalah di atas, CLIPVG mencadangkan strategi vektorisasi berbilang pusingan Dalam setiap pusingan, kaedah sedia ada akan dipanggil untuk mendapatkan hasil vektor, yang akan ditindih mengikut urutan. Setiap pusingan meningkatkan ketepatan berbanding pusingan sebelumnya, iaitu vektor dengan blok elemen vektor yang lebih kecil. Rajah di bawah menggambarkan perbezaan dalam ketepatan yang berbeza semasa vektorisasi.

Set elemen vektor yang diperolehi oleh pusingan ke-i vektorisasi boleh dinyatakan sebagai  , dan keputusan yang dihasilkan oleh semua pusingan Set elemen vektor yang diperoleh selepas superposisi dilambangkan sebagai

, dan keputusan yang dihasilkan oleh semua pusingan Set elemen vektor yang diperoleh selepas superposisi dilambangkan sebagai  , iaitu objek pengoptimuman keseluruhan CLIPVG.

, iaitu objek pengoptimuman keseluruhan CLIPVG.

Fungsi kehilangan

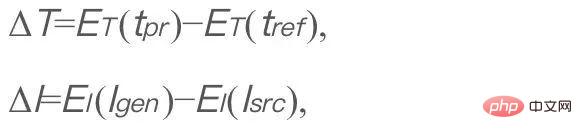

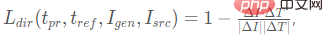

Serupa dengan StyleGAN-NADA dan CLIPstyler, CLIPVG menggunakan kehilangan CLIP berarah kepada The measurement generates korespondensi antara imej dan teks penerangan, yang ditakrifkan seperti berikut,

di mana  mewakili penerangan teks input.

mewakili penerangan teks input.  ialah teks rujukan tetap, ditetapkan kepada "foto" dalam CLIPVG dan

ialah teks rujukan tetap, ditetapkan kepada "foto" dalam CLIPVG dan  ialah imej yang dijana (objek yang akan dioptimumkan).

ialah imej yang dijana (objek yang akan dioptimumkan).  ialah imej asal.

ialah imej asal.  dan

dan  masing-masing ialah codec teks dan imej CLIP. ΔT dan ΔI masing-masing mewakili arah ruang terpendam bagi teks dan imej. Tujuan mengoptimumkan fungsi kehilangan ini adalah untuk menjadikan arah perubahan semantik selepas penyuntingan imej menepati huraian teks. T_ref tetap diabaikan dalam formula seterusnya. Dalam CLIPVG, imej yang dijana adalah hasil daripada pemaparan grafik vektor yang boleh dibezakan. Selain itu, CLIPVG menyokong memberikan penerangan teks yang berbeza kepada setiap ROI. Pada masa ini, kerugian CLIP arah akan ditukar kepada kerugian ROI CLIP berikut,

masing-masing ialah codec teks dan imej CLIP. ΔT dan ΔI masing-masing mewakili arah ruang terpendam bagi teks dan imej. Tujuan mengoptimumkan fungsi kehilangan ini adalah untuk menjadikan arah perubahan semantik selepas penyuntingan imej menepati huraian teks. T_ref tetap diabaikan dalam formula seterusnya. Dalam CLIPVG, imej yang dijana adalah hasil daripada pemaparan grafik vektor yang boleh dibezakan. Selain itu, CLIPVG menyokong memberikan penerangan teks yang berbeza kepada setiap ROI. Pada masa ini, kerugian CLIP arah akan ditukar kepada kerugian ROI CLIP berikut,

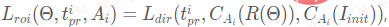

di mana Ai ialah kawasan ROI ke-i, yang ialah  Perihalan teks yang berkaitan. R ialah pemapar vektor yang boleh dibezakan, dan R(Θ) ialah keseluruhan imej yang diberikan.

Perihalan teks yang berkaitan. R ialah pemapar vektor yang boleh dibezakan, dan R(Θ) ialah keseluruhan imej yang diberikan.  ialah keseluruhan imej input.

ialah keseluruhan imej input.  mewakili operasi pemangkasan, yang bermaksud memotong kawasan

mewakili operasi pemangkasan, yang bermaksud memotong kawasan  daripada imej I. CLIPVG juga menyokong skim peningkatan berasaskan tampalan yang serupa dengan CLIPstyler, iaitu, berbilang tampung boleh dipangkas lagi secara rawak daripada setiap ROI, dan kerugian CLIP dikira untuk setiap tampung berdasarkan perihalan teks yang sepadan dengan ROI.

daripada imej I. CLIPVG juga menyokong skim peningkatan berasaskan tampalan yang serupa dengan CLIPstyler, iaitu, berbilang tampung boleh dipangkas lagi secara rawak daripada setiap ROI, dan kerugian CLIP dikira untuk setiap tampung berdasarkan perihalan teks yang sepadan dengan ROI.

Jumlah kerugian ialah jumlah kerugian ROI CLIP di semua kawasan, iaitu di sini

Rantau boleh menjadi ROI, atau tampalan dipotong daripada ROI.  ialah berat kehilangan yang sepadan dengan setiap kawasan.

ialah berat kehilangan yang sepadan dengan setiap kawasan.

CLIPVG akan mengoptimumkan set parameter vektor Θ berdasarkan fungsi kehilangan di atas. Apabila mengoptimumkan, anda juga boleh menyasarkan subset Θ sahaja, seperti parameter bentuk, parameter warna atau beberapa elemen vektor yang sepadan dengan kawasan tertentu.

Dalam bahagian percubaan, CLIPVG mula-mula mengesahkan keberkesanan berbilang pusingan strategi vektorisasi dan pengoptimuman domain vektor melalui eksperimen ablasi, dan kemudian membandingkannya dengan garis dasar sedia ada Perbandingan telah dibuat, dan senario aplikasi unik akhirnya ditunjukkan.

Eksperimen Ablasi

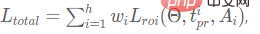

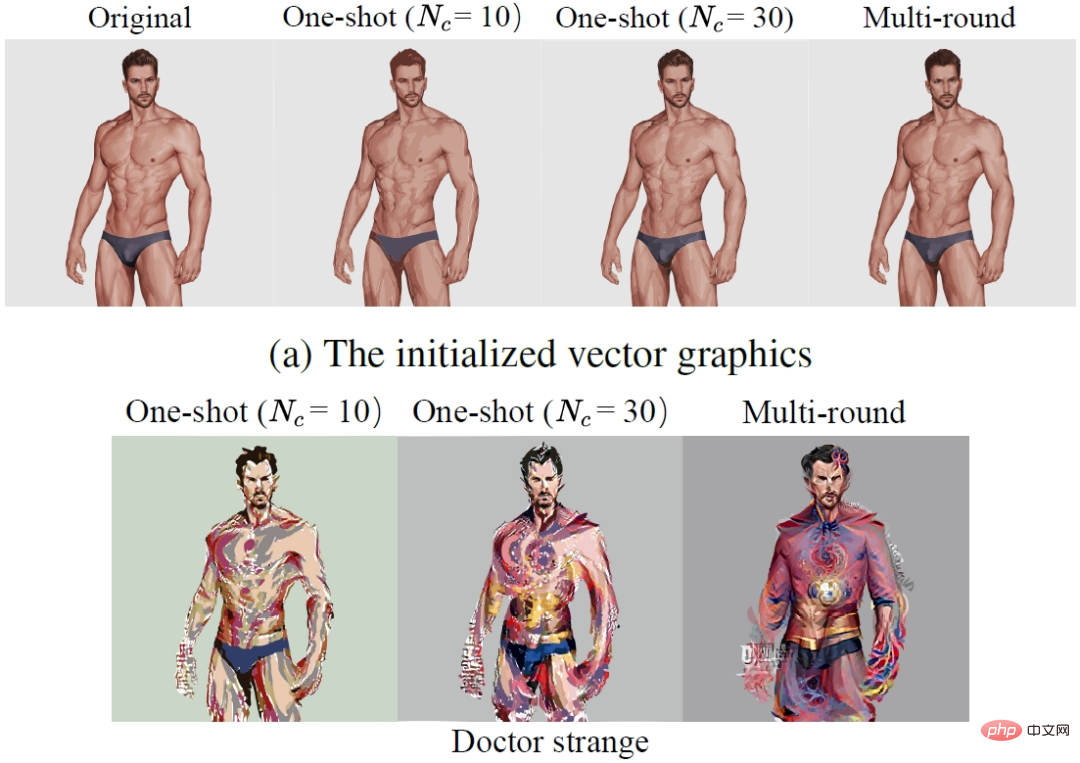

Kajian pertama membandingkan strategi berbilang pusingan dan kesan strategi vektorisasi satu pusingan. Baris pertama dalam rajah di bawah ialah hasil awal selepas vektorisasi, dan baris kedua ialah hasil yang diedit. di mana Nc mewakili ketepatan vektorisasi. Dapat dilihat bahawa berbilang pusingan vektorisasi bukan sahaja meningkatkan ketepatan pembinaan semula keadaan awal, tetapi juga berkesan menghapuskan keretakan antara elemen vektor selepas mengedit dan meningkatkan prestasi butiran.

Untuk mengkaji lebih lanjut ciri-ciri pengoptimuman domain vektor, kertas kerja membandingkan CLIPVG (kaedah domain vektor) dan CLIPstyler (kaedah domain piksel) menggunakan saiz tampalan yang berbeza Kesan peningkatan. Baris pertama dalam rajah di bawah menunjukkan kesan CLIPVG menggunakan saiz tampung yang berbeza, dan baris kedua menunjukkan kesan CLIPstyler. Penerangan teksnya ialah "Doctor Strange". Resolusi keseluruhan imej ialah 512x512. Dapat dilihat bahawa apabila saiz tampalan kecil (128x128 atau 224x224), kedua-dua CLIPVG dan CLIPstyler akan memaparkan warna merah dan biru yang mewakili "Doctor Strange" di kawasan tempatan yang kecil, tetapi semantik seluruh wajah tidak berubah dengan ketara . Ini kerana panduan CLIP pada masa ini tidak digunakan pada keseluruhan imej. Apabila CLIPVG meningkatkan saiz tampung kepada 410x410, anda boleh melihat perubahan jelas dalam identiti watak, termasuk gaya rambut dan ciri muka, yang disunting dengan berkesan mengikut perihalan teks. Jika penambahbaikan tampalan dialih keluar, kesan penyuntingan semantik dan kejelasan perincian akan dikurangkan, menunjukkan bahawa peningkatan tampung masih mempunyai kesan positif. Tidak seperti CLIPVG, CLIPstyler masih tidak boleh menukar identiti watak apabila tampalan lebih besar atau tampalan dialih keluar, tetapi hanya menukar warna keseluruhan dan beberapa tekstur tempatan. Sebabnya ialah kaedah membesarkan saiz tampalan dalam domain piksel kehilangan kekangan asas dan jatuh ke dalam optimum setempat. Set perbandingan ini menunjukkan bahawa CLIPVG boleh menggunakan kekangan pada butiran dalam domain vektor dengan berkesan dan menggabungkannya dengan skop CLIP (saiz tampung) yang lebih besar untuk mencapai pengeditan semantik peringkat tinggi, yang sukar dicapai dengan kaedah domain piksel.

Percubaan perbandingan

Dalam eksperimen perbandingan, kajian pertama kali menggunakan CLIPVG dan dua kaedah untuk mengedit gambar sewenang-wenangnya. Kaedah domain piksel telah dibandingkan, termasuk Disco Diffusion dan CLIPstyler Seperti yang anda lihat dalam rajah di bawah, untuk contoh "Potret Diri Vincent van Gogh", CLIPVG boleh mengedit identiti watak dan gaya lukisan pada masa yang sama, manakala kaedah domain piksel hanya boleh mencapai salah satu daripadanya. Untuk "Gypsophila", CLIPVG boleh mengedit bilangan dan bentuk kelopak dengan lebih tepat daripada kaedah garis dasar. Dalam contoh "Jocker, Heath Ledger" dan "A Ford Mustang", CLIPVG juga boleh mengubah semantik keseluruhan dengan mantap Secara relatifnya, Disco Diffusion terdedah kepada kecacatan tempatan, manakala CLIPstyler secara amnya hanya melaraskan tekstur dan warna.

(dari atas ke bawah: lukisan Van Gogh, gypsophila, Heath Ledger Joker , Ford Mustang)

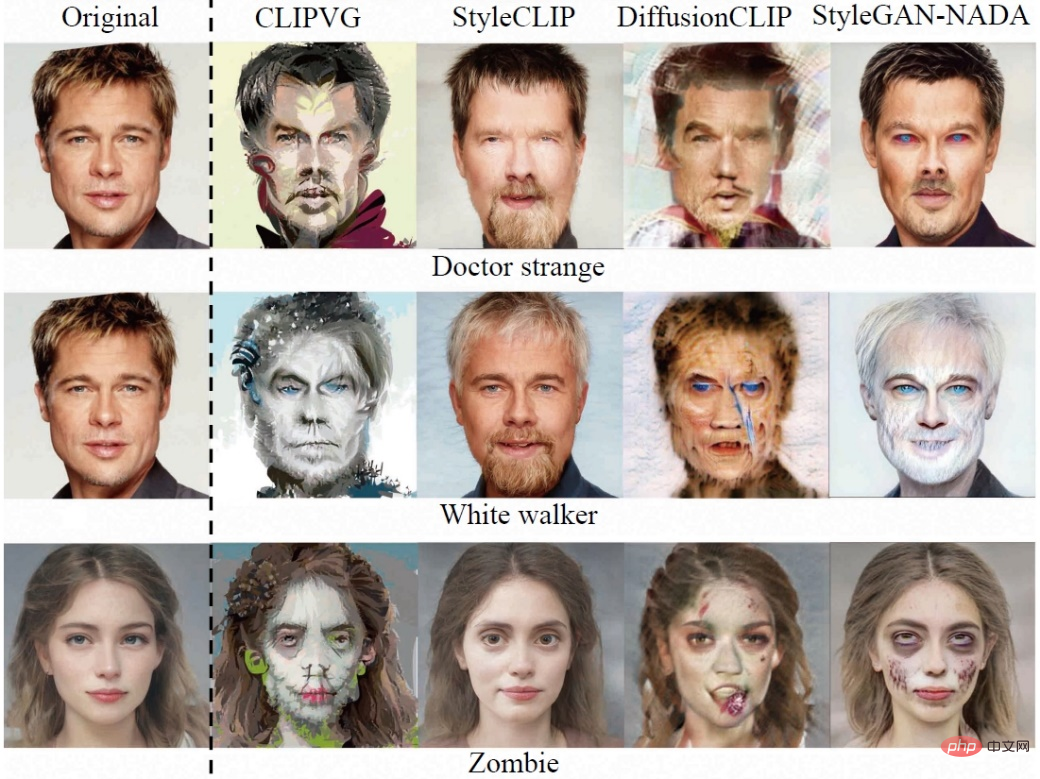

Para penyelidik kemudian membandingkan kaedah domain piksel untuk imej dalam medan tertentu (mengambil wajah manusia sebagai contoh), termasuk StyleCLIP, DiffusionCLIP dan StyleGAN-NADA. Disebabkan oleh skop penggunaan yang terhad, kualiti penjanaan kaedah asas ini secara amnya lebih stabil. Dalam set perbandingan ini, CLIPVG masih menunjukkan bahawa kesannya tidak kalah dengan kaedah sedia ada, terutamanya darjah konsistensi dengan teks sasaran selalunya lebih tinggi.

(Atas ke bawah: Doctor Strange, White Walkers, Zombies)

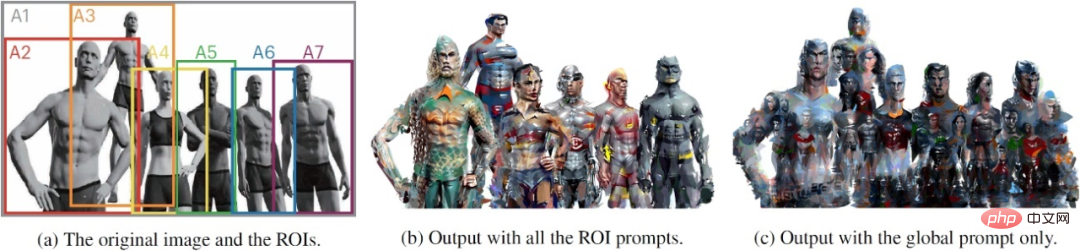

Menggunakan ciri grafik vektor dan fungsi kehilangan tahap ROI, CLIPVG boleh menyokong satu siri permainan inovatif yang sukar dicapai dengan kaedah sedia ada. Sebagai contoh, kesan pengeditan gambar berbilang orang yang ditunjukkan pada permulaan artikel ini dicapai dengan mentakrifkan perihalan teks tahap ROI yang berbeza untuk aksara yang berbeza. Bahagian kiri gambar di bawah ialah input, bahagian tengah ialah hasil pengeditan perihalan teks peringkat ROI, dan bahagian kanan ialah hasil keseluruhan gambar yang mempunyai hanya satu penerangan teks keseluruhan. Penerangan yang sepadan dengan kawasan A1 hingga A7 ialah 1. "Justice League Six", 2. "Aquaman", 3. "Superman", 4. "Wonder Woman" ), 5. "Cyborg" (Cyborg), 6. "Flash , Superhero DC" (The Flash, DC) dan 7. "Batman" (Batman). Dapat dilihat bahawa perihalan di peringkat ROI boleh diedit secara berasingan untuk setiap aksara, tetapi penerangan keseluruhan tidak dapat menjana ciri identiti individu yang berkesan. Memandangkan ROI bertindih antara satu sama lain, kaedah sedia ada sukar untuk mencapai penyelarasan keseluruhan CLIPVG walaupun setiap aksara diedit secara individu.

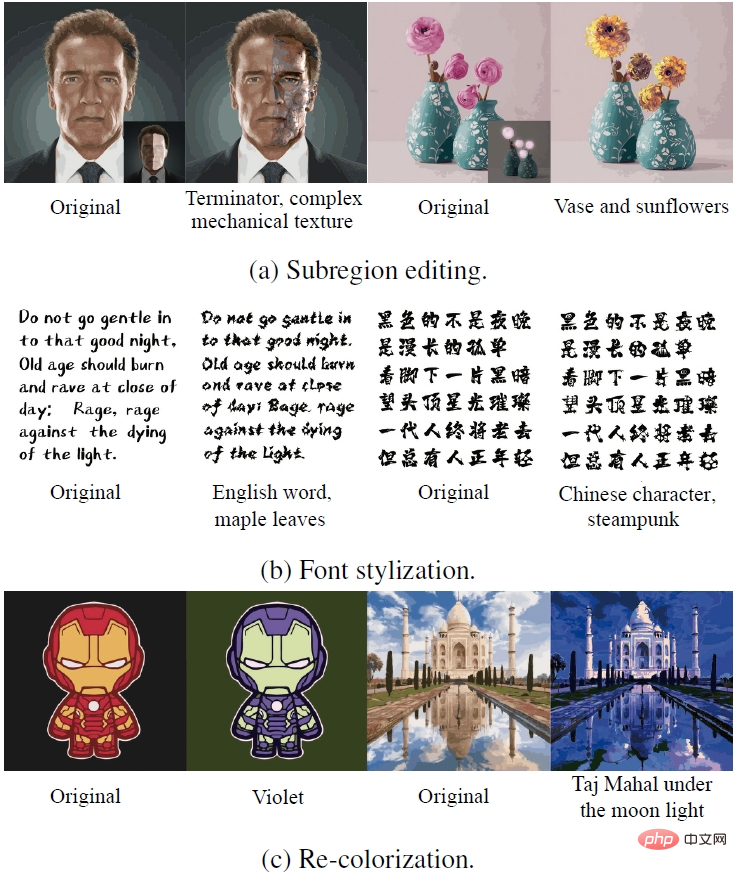

CLIPVG juga boleh mencapai pelbagai kesan penyuntingan khas dengan mengoptimumkan beberapa parameter vektor. Baris pertama dalam imej di bawah menunjukkan kesan pengeditan hanya sebahagian kawasan. Baris kedua menunjukkan kesan penjanaan fon mengunci parameter warna dan mengoptimumkan hanya parameter bentuk. Baris ketiga adalah bertentangan dengan baris kedua, mencapai tujuan mewarna semula dengan mengoptimumkan hanya parameter warna.

(atas ke bawah: penyuntingan sub-kawasan, penggayaan fon, perubahan warna imej)

Atas ialah kandungan terperinci Buat pertama kalinya, anda tidak bergantung pada model generatif, dan biarkan AI mengedit gambar dalam satu ayat sahaja!. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!