Model bahasa telah mengubah secara mendalam penyelidikan dan amalan dalam bidang pemprosesan bahasa semula jadi. Dalam beberapa tahun kebelakangan ini, model besar telah membuat penemuan penting dalam banyak bidang. Mereka tidak perlu diperhalusi pada tugasan hiliran Dengan arahan atau gesaan yang sesuai, mereka boleh mencapai prestasi yang cemerlang, kadangkala menakjubkan.

Sebagai contoh, GPT-3 [1] boleh menulis surat cinta, skrip dan menyelesaikan masalah penaakulan matematik yang kompleks dengan data, dan PaLM [2] boleh menerangkan jenaka. Contoh di atas hanyalah sebahagian besar daripada keupayaan model yang besar Banyak aplikasi telah dibangunkan menggunakan keupayaan model yang besar Anda boleh melihat banyak demo berkaitan di laman web OpenAI [3], tetapi keupayaan ini jarang ditunjukkan dalam model kecil.

Dalam kertas kerja yang diperkenalkan hari ini, keupayaan yang tidak dimiliki oleh model kecil tetapi model besar dipanggil keupayaan muncul (Emergent Abilities), yang bermaksud bahawa skala model cukup besar. pada tahap tertentu Keupayaan mendadak yang diperoleh kemudian. Ini adalah proses di mana perubahan kuantitatif menghasilkan perubahan kualitatif.

Kemunculan kebolehan yang timbul sukar untuk diramalkan. Mengapa model tiba-tiba memperoleh keupayaan tertentu apabila skala meningkat masih menjadi persoalan terbuka yang memerlukan penyelidikan lanjut untuk menjawab. Dalam artikel ini, penulis menyusun beberapa kemajuan terkini dalam memahami model besar dan memberikan beberapa pemikiran yang berkaitan, saya berharap untuk membincangkannya dengan anda.

Kertas berkaitan:

Apakah model besar? Apakah saiz yang dianggap "besar"? Ini tidak mempunyai definisi yang jelas.

Secara umumnya, parameter model mungkin perlu mencapai satu bilion tahap sebelum ia menunjukkan keupayaan yang berbeza dengan ketara daripada sifar tangkapan dan beberapa tangkapan model kecil. Dalam tahun-tahun kebelakangan ini, terdapat banyak model dengan ratusan bilion dan trilion parameter, yang telah mencapai prestasi SOTA pada satu siri tugasan. Dalam sesetengah tugasan, prestasi model meningkat dengan pasti dengan skala yang semakin meningkat, manakala dalam tugasan lain, model menunjukkan peningkatan mendadak dalam prestasi pada skala tertentu. Dua penunjuk boleh digunakan untuk mengklasifikasikan tugasan yang berbeza [4]:

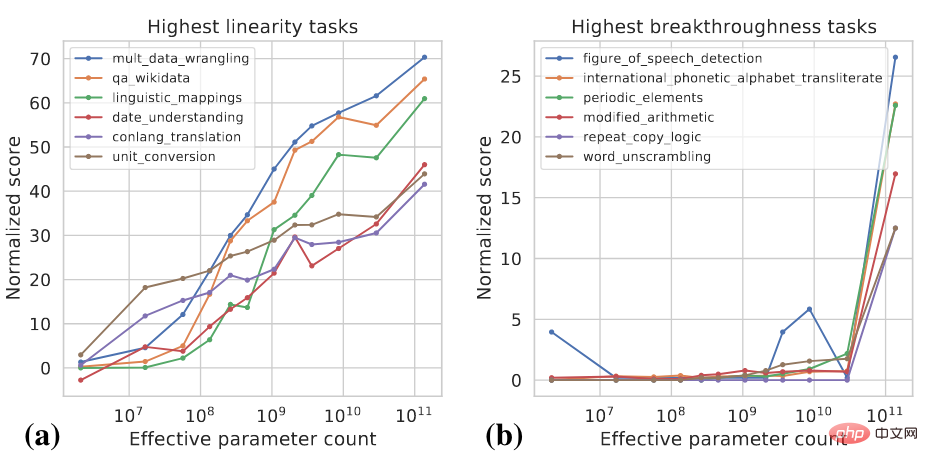

Kedua-dua penunjuk ini ialah fungsi skala model dan prestasi model Untuk butiran pengiraan khusus, sila rujuk [4]. Rajah di bawah menunjukkan beberapa contoh tugasan Lineariti tinggi dan Terobosan tinggi.

Tugas Lineariti Tinggi kebanyakannya berasaskan pengetahuan, yang bermaksud mereka bergantung terutamanya pada menghafal apa yang wujud dalam data latihan Maklumat , seperti menjawab soalan fakta. Model yang lebih besar biasanya menggunakan lebih banyak data untuk latihan dan boleh mengingati lebih banyak pengetahuan, jadi model menunjukkan peningkatan yang stabil dalam tugasan tersebut apabila skala meningkat. Tugasan pencapaian tinggi termasuk tugas yang lebih kompleks yang memerlukan penggunaan beberapa kebolehan yang berbeza atau pelaksanaan berbilang langkah untuk mendapatkan jawapan yang betul, seperti penaakulan matematik. Model yang lebih kecil berjuang untuk memperoleh semua keupayaan yang diperlukan untuk melaksanakan tugas tersebut.

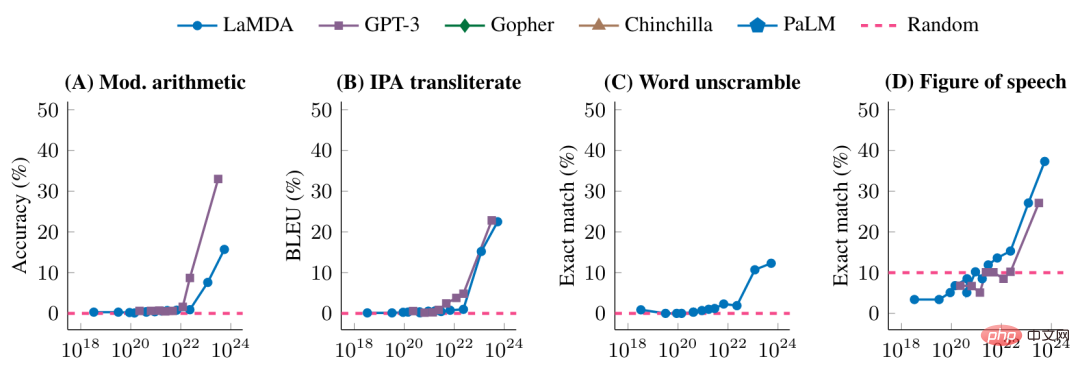

Angka berikut menunjukkan lagi prestasi model yang berbeza pada beberapa tugas terobosan tinggi

Sebelum mencapai skala model tertentu, prestasi model pada tugasan ini adalah rawak Selepas mencapai skala tertentu, terdapat peningkatan yang ketara.

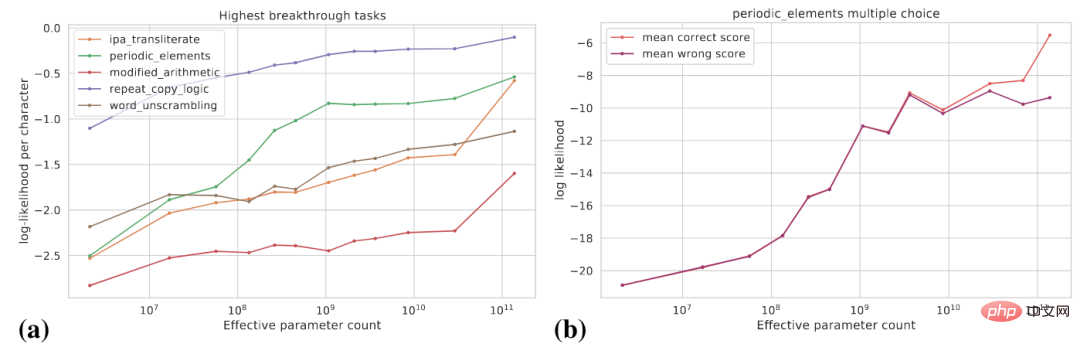

Apa yang kita lihat sebelum ini ialah model tiba-tiba memperoleh keupayaan tertentu selepas skala meningkat ke tahap tertentu Dari perspektif penunjuk khusus tugas, keupayaan ini muncul, tetapi dari perspektif lain, potensi perubahan dalam keupayaan model. Lebih licin. Artikel ini membincangkan dua perspektif berikut: (1) menggunakan penunjuk yang lebih lancar; (2) menguraikan tugas yang kompleks kepada berbilang subtugas.

Rajah berikut (a) menunjukkan lengkung perubahan kebarangkalian log sasaran sebenar untuk beberapa tugas penembusan tinggi Kebarangkalian log sasaran sebenar meningkat secara beransur-ansur apabila saiz model meningkat .

Rajah (b) menunjukkan bahawa untuk tugas aneka pilihan tertentu, apabila saiz model bertambah, Kebarangkalian log jawapan yang betul meningkat secara beransur-ansur, manakala kebarangkalian log jawapan yang salah meningkat secara beransur-ansur sehingga saiz tertentu dan kemudiannya dimatikan. Selepas skala ini, jurang antara kebarangkalian jawapan betul dan kebarangkalian jawapan salah semakin melebar, dan model mencapai peningkatan prestasi yang ketara.

Selain itu, untuk tugasan tertentu, katakan kita boleh menggunakan Exact Match dan BLEU untuk menilai prestasi model BLEU ialah penunjuk yang lebih lancar daripada Exact Match, dan penunjuk berbeza digunakan . Mungkin terdapat perbezaan yang ketara dalam trend yang dilihat.

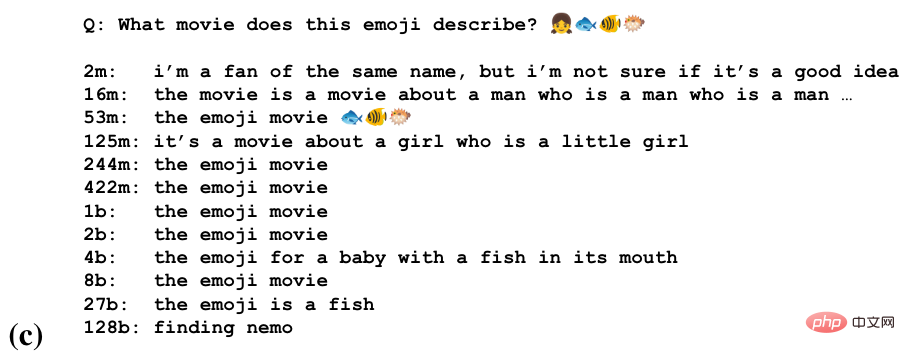

Untuk beberapa tugasan, model mungkin memperoleh keupayaan separa untuk melakukan tugasan pada skala yang berbeza. Gambar di bawah ialah tugas meneka nama filem melalui rentetan emoji

Kita dapat melihat bahawa model mula meneka pada beberapa skala Tajuk Filem, Mengenali Semantik Emoji pada Skala yang Lebih Besar, Menghasilkan Jawapan Betul pada Skala Terbesar.

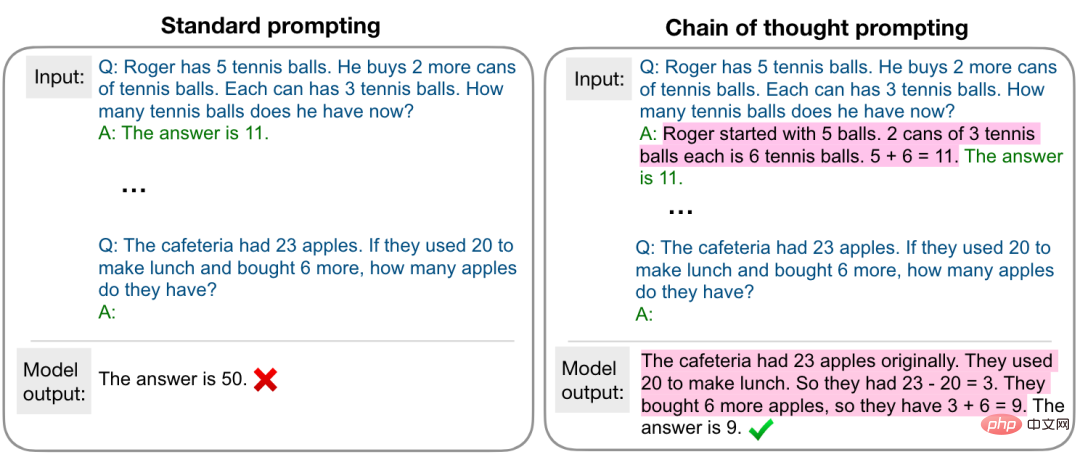

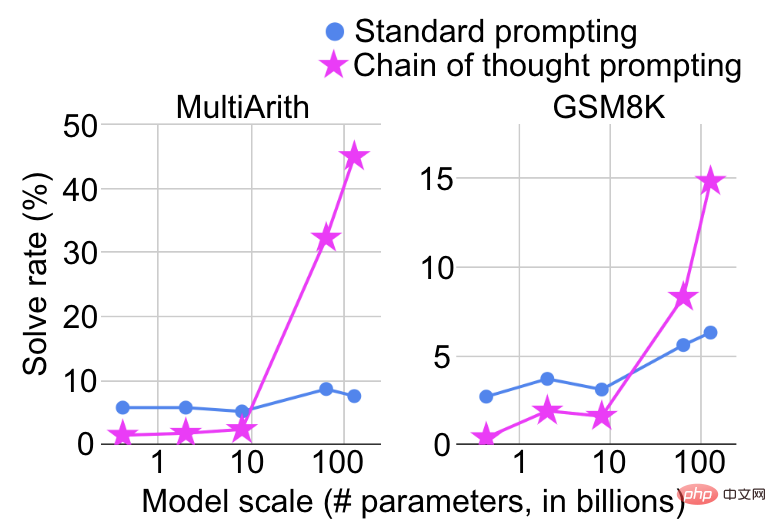

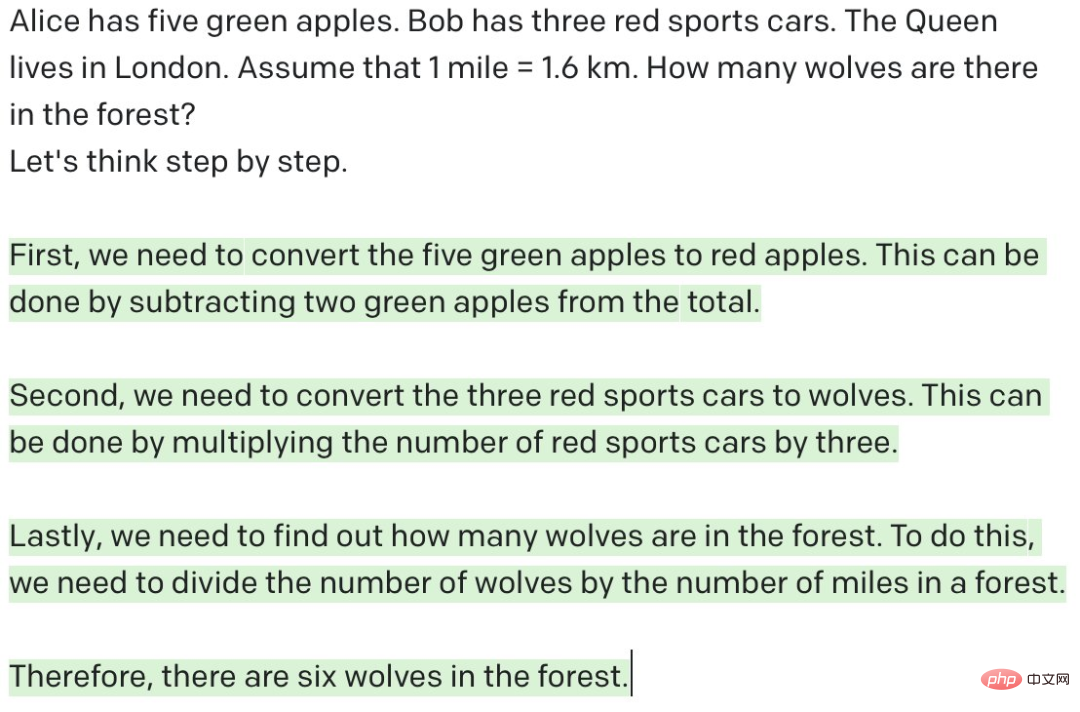

Skala model menunjukkan peningkatan mendadak dalam keupayaan juga bergantung pada cara tugas itu diformalkan. Sebagai contoh, pada tugasan penaakulan matematik yang kompleks, jika gesaan standard digunakan untuk menganggapnya sebagai tugasan soal jawab, peningkatan prestasi akan menjadi sangat terhad kerana saiz model meningkat Walau bagaimanapun, jika gesaan rantaian pemikiran [5]. digunakan seperti yang ditunjukkan dalam rajah di bawah, ia akan dianggap sebagai tugasan soal jawab Dianggap sebagai tugas inferens berbilang langkah, peningkatan prestasi yang ketara akan dilihat pada skala tertentu.

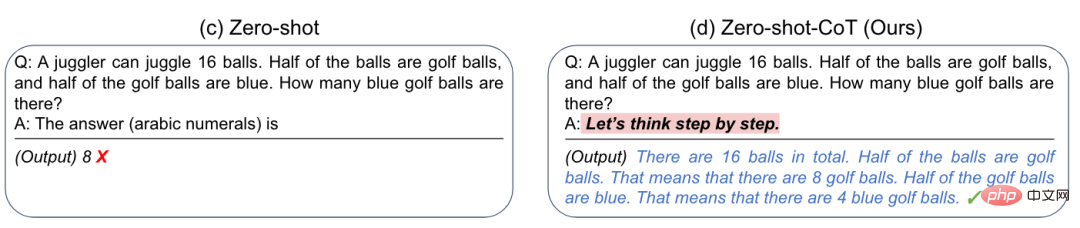

Apatah lagi, penyelidik mendapati bahawa dengan menambahkan gesaan ringkas "Mari kita fikirkan langkah demi langkah" boleh meningkatkan keupayaan penaakulan sifar pukulan GPT-3 [6], seperti yang ditunjukkan dalam rajah di bawah

Apa yang memberi inspirasi kepada kami ialah kadangkala model besar tidak dapat melakukan tugas tertentu dengan baik. Mungkin bukan ia tidak dapat melakukannya dengan baik, tetapi ia memerlukan cara yang sesuai untuk merangsang keupayaannya.

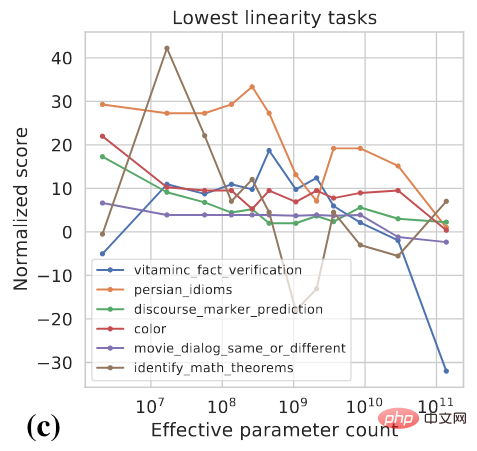

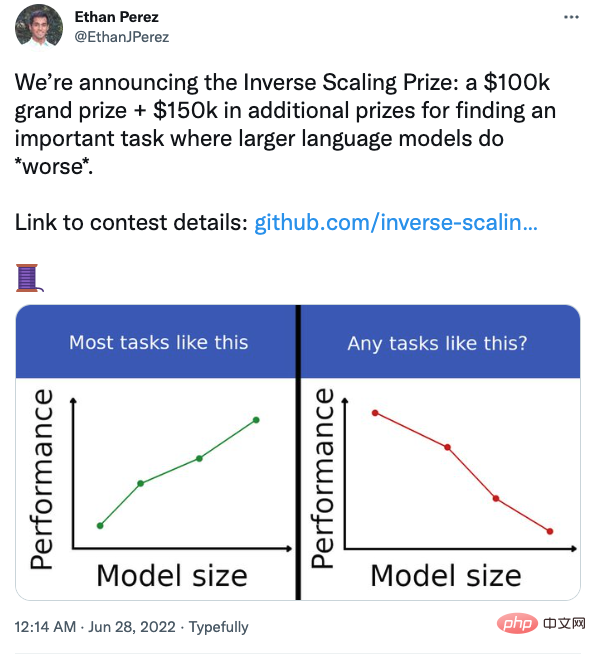

Perbincangan sebelum ini memberi kita perasaan intuitif bahawa prestasi mesti dipertingkatkan apabila skala model meningkat, tetapi adakah ini benar-benar berlaku? Malah, untuk sesetengah tugasan, prestasi sebenarnya mungkin menurun apabila model menjadi lebih besar, seperti yang ditunjukkan dalam rajah di bawah

Beberapa penyelidik di Universiti New York turut menganjurkan pertandingan untuk mencari tugas yang model menunjukkan prestasi yang lebih teruk apabila ia semakin besar.

Contohnya, dalam tugasan soal jawab, jika anda menambah kepercayaan anda bersama soalan, model besar akan lebih mudah terjejas. Pelajar yang berminat boleh memberi perhatian.

Encik Mei Yiqi pernah berkata, "Yang dikatakan ulama besar bukan bermaksud bangunan, tetapi penulis menggunakan istilah yang tidak sesuai di sini artikel ini dengan analogi: model besar yang dipanggil tidak bermakna ia mempunyai parameter, tetapi ia mempunyai keupayaan.

Atas ialah kandungan terperinci Google dan Stanford bersama-sama mengeluarkan artikel: Mengapa kita mesti menggunakan model besar?. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!