Sudah hampir empat bulan sejak keluaran awal ChatGPT. Dalam tempoh ini, prestasi hebat ChatGPT membuatkan orang tertanya-tanya sama ada AIGC akan direalisasikan lebih awal.

Walau bagaimanapun, rahsia yang terkenal ialah ChatGPT tidak mungkin menjadi sumber terbuka Ditambah dengan pelaburan besar dalam kuasa pengkomputeran dan data latihan yang besar, ia telah menetapkan banyak halangan untuk penyelidikan. komuniti untuk meniru tahap pelaksanaannya.

Menghadapi serangan ChatGPT, alternatif sumber terbuka adalah pilihan yang baik Walaupun ia mencapai fungsi yang sama, ia juga boleh membolehkan anda memahami mekanisme pengendalian ChatGPT melalui alternatif.

Dengan kemajuan teknologi, banyak model AI baharu lain yang serupa dengan ChatGPT kini telah muncul. Dalam artikel ini, kami akan mengambil kira projek penggantian sumber terbuka ChatGPT. Kandungan akan dibahagikan kepada dua bahagian, satu ialah ringkasan projek sumber terbuka seperti ChatGPT, dan satu lagi adalah tambahan kepada ringkasan projek.

Pengarang projek nichtdax telah menyusun 9 projek penggantian ChatGPT sumber terbuka. Mereka akan diperkenalkan satu persatu seterusnya.

Alamat projek: https://github.com/nichtdax/awesome -toally-open-chatgpt

PaLM-rlhf-pytorch

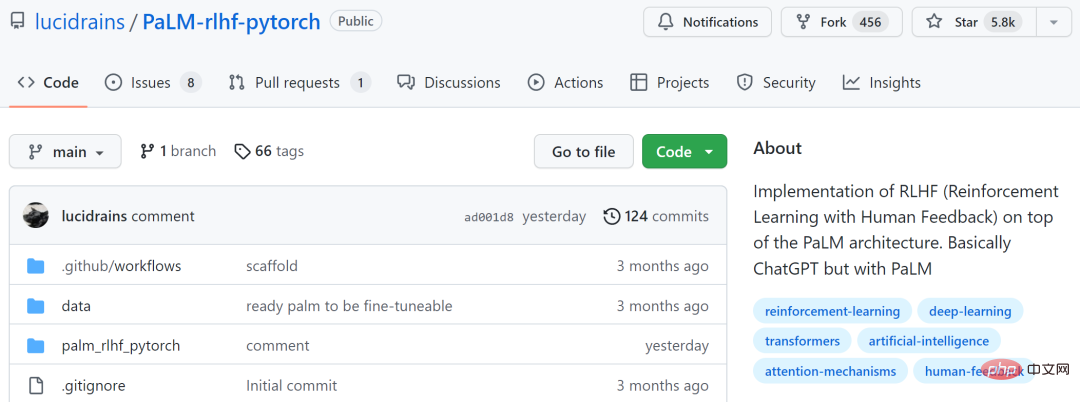

Projek pertama ialah " PaLM-rlhf-pytorch", pengarang projek ialah Phil Wang. Projek ini adalah pelaksanaan RLHF (Pembelajaran Pengukuhan dengan Maklum Balas Manusia) di atas seni bina PaLM, yang pada asasnya ChatGPT menggunakan PaLM.

Projek ini telah menerima 5.8k bintang di GitHub.

Alamat projek: https://github.com/lucidrains/PaLM-rlhf- pytorch

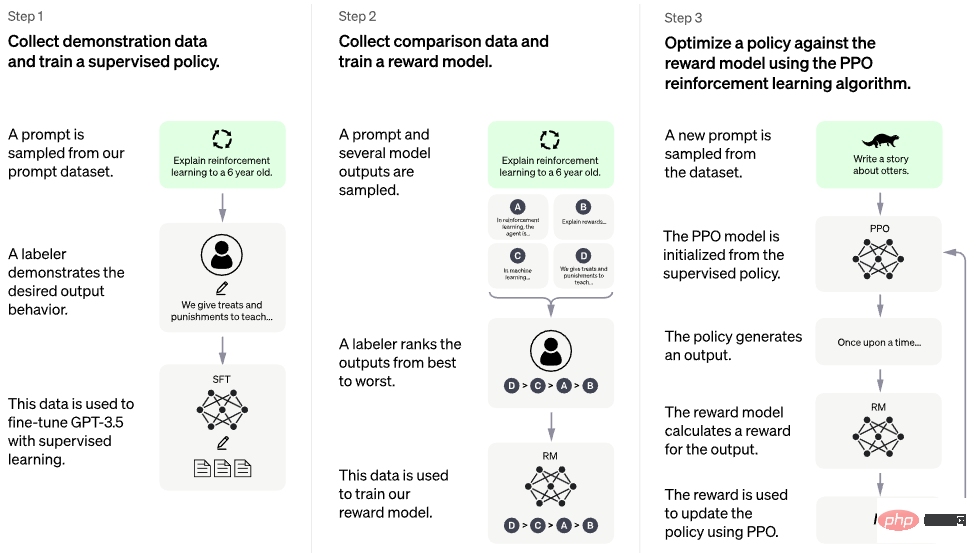

Gambar berikut menunjukkan proses latihan.

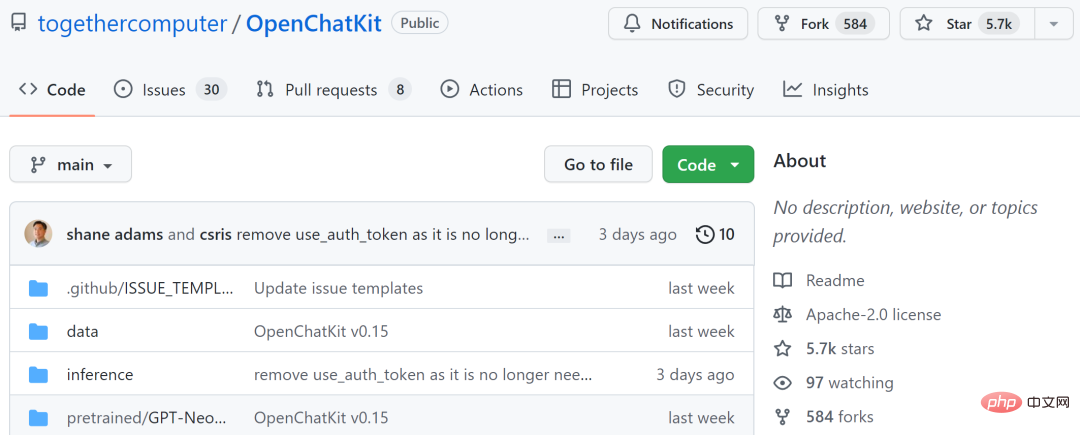

Projek kedua ialah "OpenChatKit Menyediakan a asas sumber terbuka yang berkuasa untuk mencipta chatbot khusus dan tujuan umum untuk pelbagai aplikasi. Kit ini termasuk model bahasa parameter 20 bilion yang ditala arahan, model penalaan parameter 6 bilion dan sistem perolehan berskala yang merangkumi respons terkini daripada repositori tersuai.

OpenChatKit dilatih pada set data latihan OIG-43M, yang merupakan gabungan Together, LAION dan Ontocord.ai. Penulis projek menyatakan bahawa ini bukan sahaja keluaran model, tetapi juga permulaan projek sumber terbuka. Mereka mengeluarkan satu set alat dan proses dan terus memperbaikinya melalui sumbangan komuniti.

Projek ini telah menerima 5.7k bintang di GitHub.

Alamat projek: https://github.com/togethercomputer/OpenChatKit

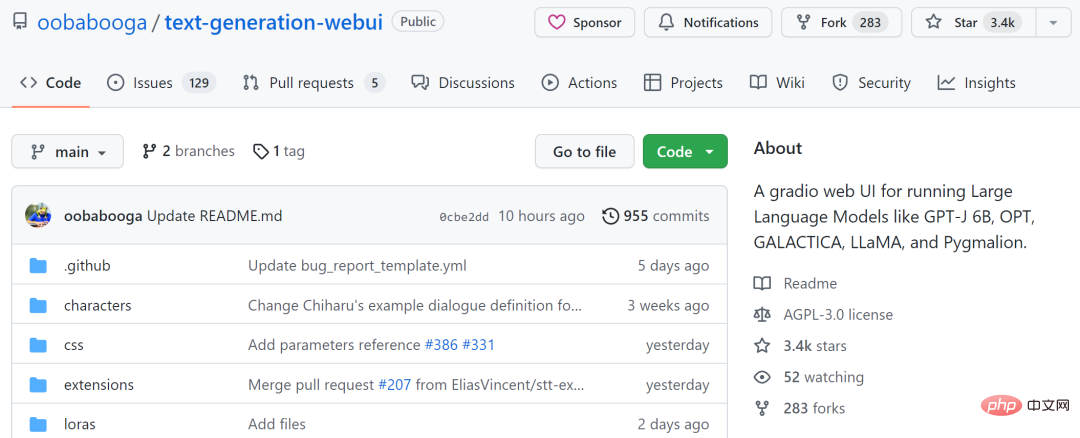

Projek ketiga ialah "text-generation-webui", yang merupakan alat untuk menjalankan GPT-J 6B, OPT, GALACTICA, LLaMA dan Gradio UI web untuk model bahasa besar seperti Pygmalion. Projek ini bertujuan untuk menjadi AUTOMATIC1111/stable-diffusion-webui bagi penjanaan teks.

Ciri-ciri termasuk menggunakan menu lungsur untuk bertukar antara model yang berbeza, menyediakan mod buku nota yang serupa dengan taman permainan OpenAI, mod sembang untuk dialog dan main peranan, menjana output HTML yang cantik dan banyak lagi.

Projek ini telah menerima 3.4k di GitHub.

Alamat projek: https://github.com/oobabooga/text-generation- webui

Projek keempat ialah "KoboldAI-Client", yang merupakan front-end berasaskan pelayar melalui berbilang model AI tempatan dan jauh Laksanakan AI -menulis dibantu.

KoboldAI-Client menyediakan rangkaian alat standard, termasuk memori, nota pengarang, maklumat dunia, simpan & muat, tetapan AI boleh laras, pilihan pemformatan dan mengimport teks sedia ada Kebolehan permainan pengembaraan AI Dungeon. Anda boleh menghidupkan mod Pengembaraan atau bermain permainan seperti AI Dungeon Unleashed.

Projek telah menerima 1.4k di GitHub.

Alamat projek: https://github.com/KoboldAI/KoboldAI-Client

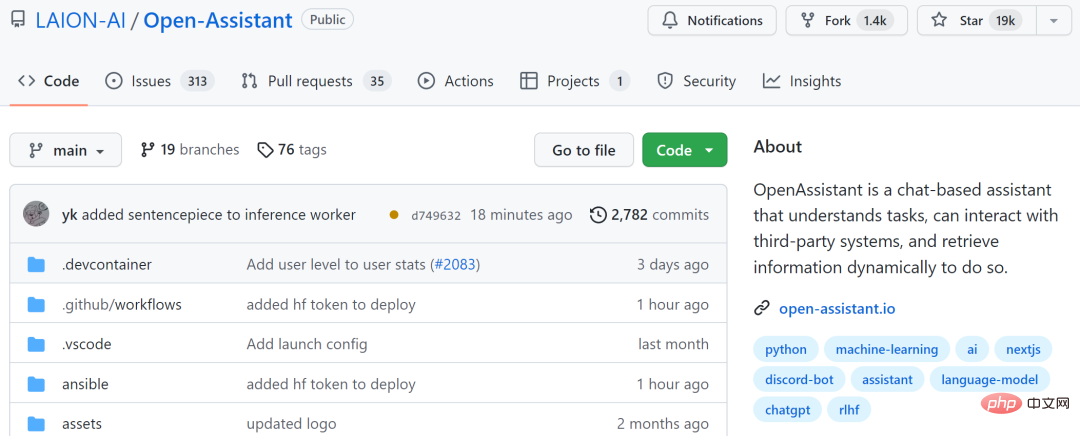

Projek kelima ialah "Open-Assistant", yang bertujuan untuk menjadikan model bahasa berasaskan sembang besar boleh diakses oleh semua orang. Pengarang projek berharap dapat mencetuskan revolusi dalam inovasi bahasa, sama seperti penyebaran yang stabil membantu dunia mencipta seni dan imej dengan cara baharu.

Pengarang projek merancang untuk mengumpul sampel pelaksanaan arahan yang dijana manusia berkualiti tinggi (arahan + respons), dengan matlamat >50k. Bagi setiap petunjuk yang dikumpul, mereka akan mencuba beberapa hasil penyiapan. Seterusnya, masukkan fasa latihan RLHF berdasarkan model arahan dan ganjaran.

Projek ini telah menerima 19k bintang di GitHub.

Alamat projek: https://github.com/LAION-AI/Open- Pembantu

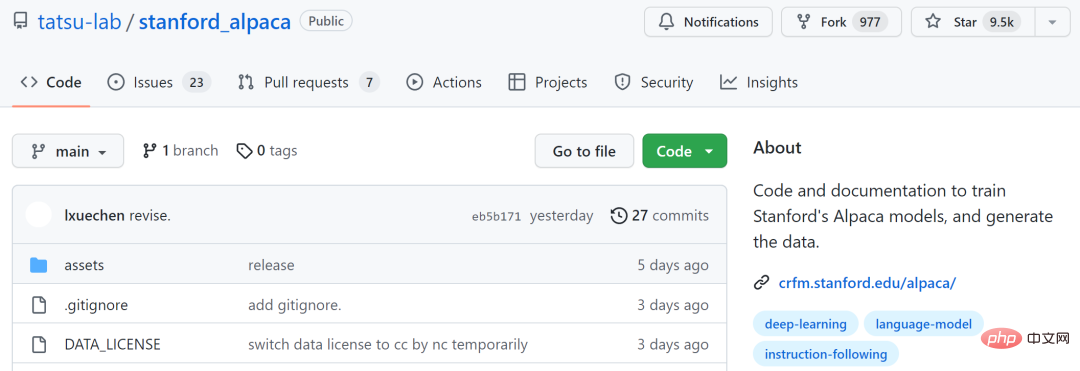

Projek keenam ialah "stanford_alpaca", yang bertujuan untuk membina dan berkongsi model LLaMA yang mengikut arahan. Repo ini mengandungi 52k data untuk memperhalusi model, kod untuk menjana data dan kod untuk memperhalusi model.

Projek ini telah menerima 9.5k bintang di GitHub.

Alamat projek: https://github.com/tatsu-lab/stanford_alpaca

Projek ketujuh ialah "ChatRWKV", yang serupa dengan ChatGPT, tetapi disokong oleh model RWKV (100% RNN) dan sumber terbuka. Menurut pengarang projek, RWKV kini merupakan satu-satunya model RNN yang boleh memadankan transformer dari segi kualiti dan kebolehskalaan, sambil menjadi lebih pantas dan menjimatkan VRAM.

Projek ini telah menerima 3.5k bintang di GitHub.

Alamat projek: https://github.com/BlinkDL/ChatRWKV

Projek kelapan ialah sumber terbuka Wisdom AI syarikat dan model bahasa perbualan Cina-Inggeris dwibahasa "ChatGLM-6B" yang diubah daripada pencapaian teknologi Tsinghua, berdasarkan Model Bahasa Umum (GLM) dengan 6.2 bilion parameter. Digabungkan dengan teknologi pengkuantitian model, pengguna boleh menggunakannya secara tempatan pada kad grafik gred pengguna (minimum 6GB memori video diperlukan pada tahap pengkuantitian INT4).

ChatGLM-6B menggunakan teknologi yang serupa dengan ChatGPT dan dioptimumkan untuk Soal Jawab dan dialog Cina. Selepas latihan dwibahasa dalam bahasa Cina dan Inggeris dengan kira-kira pengecam 1T, ditambah dengan penalaan halus yang diselia, layan diri maklum balas, pembelajaran pengukuhan maklum balas manusia dan teknologi lain, ChatGLM-6B dengan 6.2 bilion parameter telah dapat menjana jawapan yang agak konsisten dengan keutamaan manusia.

Walau bagaimanapun, disebabkan oleh skala kecil ChatGLM-6B, ia kini diketahui mempunyai beberapa batasan, seperti ralat logik fakta/matematik, kemungkinan menjana berbahaya/berat sebelah kandungan, dan Kemahiran kontekstual yang lemah, persepsi diri yang keliru, dan penghasilan arahan bahasa Inggeris yang bercanggah sepenuhnya dengan arahan bahasa Cina.

Projek ini telah menerima 6k bintang di GitHub.

Alamat projek: https://github.com/THUDM/ChatGLM-6B

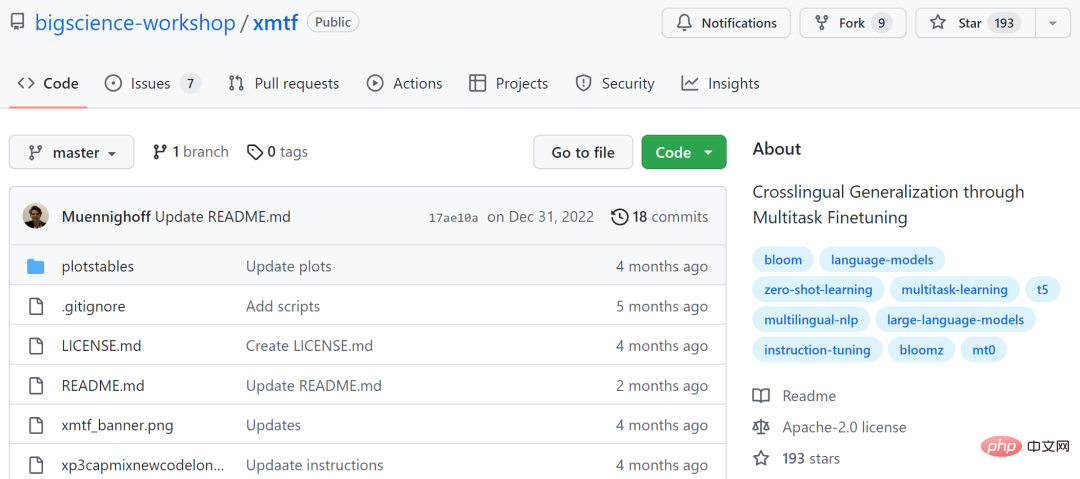

Antaranya, BLOOMZ ialah 176 bilion parameter dan model berbilang bahasa akses terbuka (di sini secara khusus merujuk kepada T5X Google ialah set data seliaan dalam 46 bahasa; dengan Terdapat gesaan dalam bahasa Inggeris dan terjemahan mesin.

Alamat projek: https://github.com/bigscience-workshop/xmtf

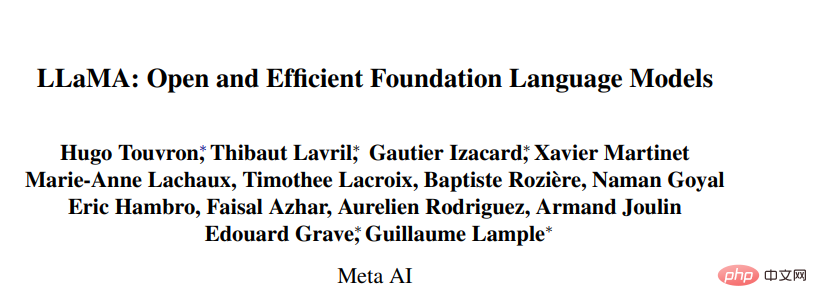

Pautan kertas: https://research.facebook.com/publications/llama-open-and-efficient-foundation-language -models/

projek llama.cpp telah merealisasikan menjalankan LLaMA pada MacBook, dan pembangun telah berjaya menjalankan LLaMA pada MacBook dengan 4GB RAM LLaMA 7B sedang berjalan pada Raspberry Pi. Ringkasnya, pembangun boleh menjalankan model LLaMA walaupun mereka tidak mempunyai GPU.

Alamat projek: https://github.com/ggerganov/llama.cpp

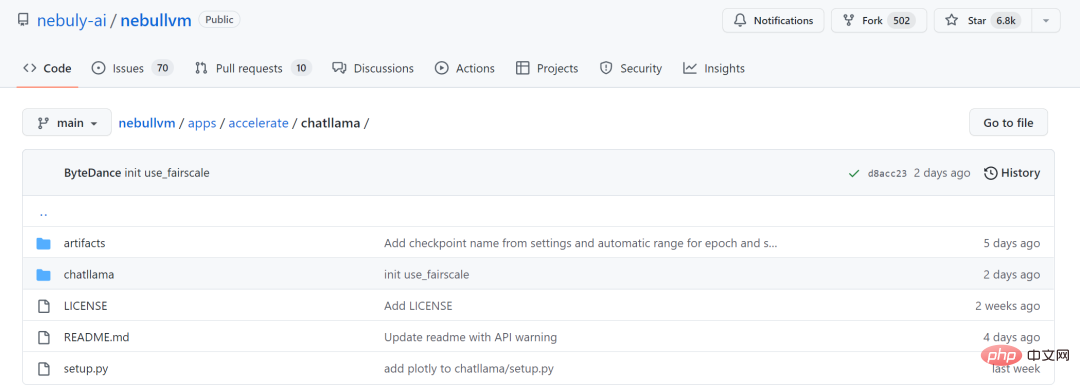

ChatLLaMA

Memandangkan siri model besar LLaMA tidak menggunakan kaedah RLHF, Nebuly AI sumber terbuka sumber terbuka kaedah latihan versi RLHF LLaMA (ChatLLaMA). Proses latihannya adalah serupa dengan ChatGPT, dan projek itu membenarkan membina perkhidmatan gaya ChatGPT berdasarkan model LLaMA yang telah terlatih. Berbanding dengan ChatGPT, LLaMA mempunyai seni bina yang lebih kecil, tetapi proses latihan dan inferens GPU tunggal adalah lebih pantas dan lebih murah perpustakaan juga menyokong semua seni bina model LLaMA (7B, 13B, 33B, 65B), jadi pengguna boleh dan membuat inferens keutamaan prestasi; memperhalusi model.

Alamat projek: https://github.com/nebuly-ai/nebullvm/ tree/main/apps/accelerate/chatllama

Mengharapkan lebih banyak projek sumber terbuka akan ditambahkan pada masa hadapan.

Atas ialah kandungan terperinci Masih bimbang tidak dapat bermain ChatGPT? Anda juga boleh mengalami dialog pintar dengan sedozen alternatif sumber terbuka ini. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Pendaftaran ChatGPT

Pendaftaran ChatGPT

Ensiklopedia ChatGPT percuma domestik

Ensiklopedia ChatGPT percuma domestik

Bagaimana untuk memasang chatgpt pada telefon bimbit

Bagaimana untuk memasang chatgpt pada telefon bimbit

Bolehkah chatgpt digunakan di China?

Bolehkah chatgpt digunakan di China?

Apakah yang dimaksudkan dengan penghalaan java?

Apakah yang dimaksudkan dengan penghalaan java?

Mengapa webstorm tidak boleh menjalankan fail

Mengapa webstorm tidak boleh menjalankan fail

Bagaimana untuk membuka dua akaun WeChat pada telefon mudah alih Huawei

Bagaimana untuk membuka dua akaun WeChat pada telefon mudah alih Huawei

Bagaimana untuk menyelesaikan masalah bahawa folder tidak mempunyai pilihan keselamatan

Bagaimana untuk menyelesaikan masalah bahawa folder tidak mempunyai pilihan keselamatan