Kemunculan GPT-4 telah membuatkan ramai orang bimbang tentang penyelidikan saintifik mereka, malah bergurau bahawa NLP tidak wujud.

Daripada bimbang, lebih baik menggunakannya dalam penyelidikan saintifik, cukup "ubah kaedah rolling".

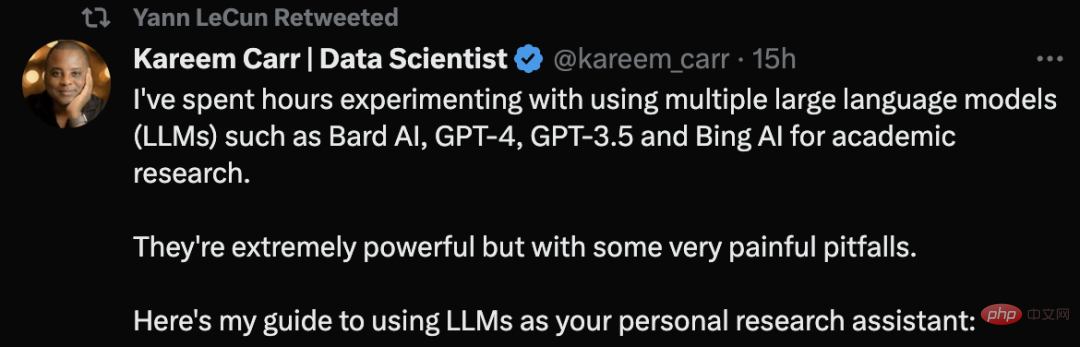

Kareem Carr, seorang PhD dalam biostatistik dari Universiti Harvard, berkata bahawa dia telah menggunakan alat model bahasa yang besar seperti GPT -4 Menjalankan penyelidikan akademik.

Dia berkata bahawa alat ini sangat berkuasa, tetapi mereka juga mempunyai beberapa perangkap yang sangat menyakitkan.

Twit beliau tentang nasihat penggunaan LLM malah mendapat cadangan daripada LeCun.

Mari kita lihat cara Kareem Carr menggunakan alatan AI untuk penyelidikan saintifik.

Pada mulanya, Carr memberikan yang pertama dan Perkara yang paling penting Prinsip:

Jangan sekali-kali meminta model bahasa besar (LLM) untuk maklumat yang anda tidak boleh sahkan sendiri, atau minta ia melaksanakan tugas yang anda tidak dapat mengesahkannya. telah disiapkan dengan betul.

Satu-satunya pengecualian ialah jika ia bukan tugas kritikal, contohnya, meminta LLM untuk idea menghias apartmen.

"Menggunakan amalan terbaik kajian literatur, ringkaskan penyelidikan mengenai penyelidikan kanser payudara dalam tempoh 10 tahun yang lalu." Ini adalah permintaan yang lemah kerana anda tidak boleh mengesahkan secara langsung bahawa ia meringkaskan literatur dengan betul.

Sebaliknya, tanya, "Beri saya senarai artikel ulasan teratas tentang penyelidikan kanser payudara dalam tempoh 10 tahun yang lalu."

Petua sedemikian bukan sahaja boleh mengesahkan sumber, tetapi juga mengesahkan kebolehpercayaan sendiri.

Sangat mudah untuk meminta LLM menulis kod untuk anda atau mencari maklumat yang berkaitan, tetapi kualiti daripada kandungan output mungkin Terdapat perbezaan yang besar. Berikut ialah beberapa perkara yang boleh anda lakukan untuk meningkatkan kualiti:

Tetapkan konteks:

•Beritahu LLM secara eksplisit maklumat yang perlu digunakan

•Gunakan terminologi dan notasi untuk berat sebelah LLM ke arah maklumat kontekstual yang betul

Jika anda mempunyai idea tentang cara mengendalikan permintaan, sila beritahu LLM kaedah khusus untuk digunakan. Contohnya, "selesaikan ketaksamaan ini" hendaklah ditukar kepada "gunakan teorem Cauchy-Schwarz untuk menyelesaikan ketaksamaan ini, dan kemudian gunakan kuasa dua lengkap."

Sedar bahawa model bahasa ini lebih kompleks dari segi linguistik daripada yang anda fikirkan, malah pembayang yang sangat samar boleh membantu.

Lebih spesifik:

Ini bukan Carian Google , jadi jangan risau jika terdapat tapak membincangkan masalah sebenar anda.

"Bagaimana untuk menyelesaikan persamaan serentak bagi sebutan kuadratik?" Anda harus bertanya seperti ini: "Selesaikan x=(1/2 )(a+b) dan y=(1/3)(a^2+ab+b^2) Sistem persamaan tentang a dan b."

Tentukan format output:

Gunakan fleksibiliti LLM untuk memformatkan output mengikut kesesuaian terbaik Cara anda, seperti:

• Kod

• Formula matematik

• Artikel

• Tutorial

• Panduan Ringkas

Anda juga boleh meminta kod untuk menjana perkara berikut, termasuk jadual, plot, carta.

Walaupun anda mendapat apa yang LLM keluarkan, ini hanyalah permulaan. Kerana anda perlu mengesahkan kandungan output. Ini termasuk:

• Mencari ketidakkonsistenan

• Mencari output alat melalui Terminologi Google kandungan, mendapatkan sumber yang boleh disokong

• Jika boleh, tulis kod untuk menguji diri anda

Sebab untuk pengesahan diri ialah LLM sering membuat kesilapan aneh yang tidak konsisten dengan profesionalisme mereka yang jelas. Sebagai contoh, LLM mungkin menyebut konsep matematik yang sangat maju tetapi keliru tentang masalah algebra yang mudah.

Tanya sekali lagi:

Berskala besar penjanaan model bahasa Kandungan adalah rawak. Kadangkala, mencipta tetingkap baharu dan bertanya soalan anda sekali lagi mungkin memberikan anda jawapan yang lebih baik.

Selain itu, gunakan berbilang alatan LLM. Kareem Carr kini menggunakan Bing AI, GPT-4, GPT-3.5 dan Bard AI dalam penyelidikan saintifik mengikut keperluannya sendiri. Namun, masing-masing mempunyai kebaikan dan keburukan tersendiri.

Petikan

Mengikut pengalaman Carr, sebaiknya tanya soalan matematik yang sama kepada GPT-4 dan Bard AI pada masa yang sama untuk mendapatkan perspektif yang berbeza. Bing AI berfungsi pada carian web. GPT-4 jauh lebih pintar daripada GPT-3.5, tetapi pada masa ini OpenAI dihadkan kepada 25 mesej dalam masa 3 jam, menjadikannya lebih sukar untuk diakses.

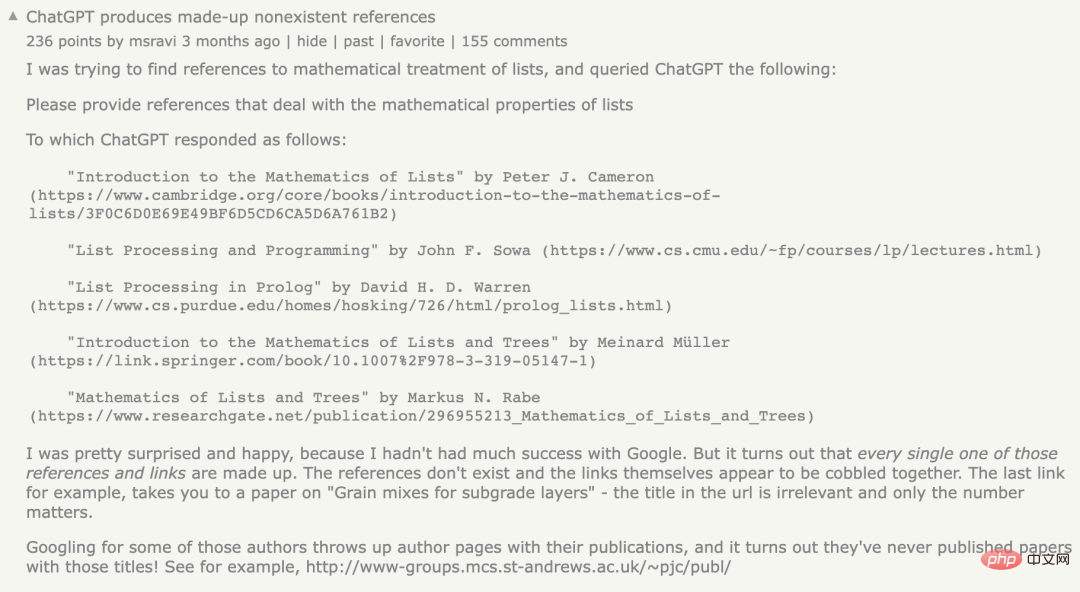

Mengenai isu petikan, memetik rujukan adalah titik lemah LLM. Kadangkala rujukan yang diberikan LLM kepada anda wujud, kadangkala tidak.

Sebelum ini, seorang netizen menghadapi masalah yang sama Dia berkata bahawa dia meminta ChatGPT menyediakan bahan rujukan yang melibatkan sifat matematik senarai, tetapi ChatGPT menghasilkan mesej ralat. yang tidak mengikuti. Rujukan yang tidak wujud adalah apa yang semua orang panggil masalah "ilusi".

Walau bagaimanapun, Kareem Carr menegaskan bahawa petikan palsu bukanlah sia-sia sepenuhnya.

Menurut pengalamannya, perkataan dalam rujukan rekaan selalunya berkaitan dengan istilah sebenar, begitu juga dengan penyelidik dalam bidang berkaitan. Oleh itu, Googling istilah ini sering membawa anda lebih dekat dengan maklumat yang anda cari.

Selain itu, Bing juga merupakan pilihan yang baik apabila mencari sumber.

Produktiviti

Terdapat banyak dakwaan tidak realistik tentang LLM meningkatkan produktiviti, seperti "LLM It can meningkatkan produktiviti anda sebanyak 10 kali atau bahkan 100 kali ganda."

Dalam pengalaman Carr, pecutan ini hanya masuk akal jika tiada kerja disemak semula, yang benar bagi seseorang yang ahli akademik adalah tidak bertanggungjawab.

Walau bagaimanapun, LLM telah menambah baik aliran kerja akademik Kareem Carr, termasuk:

- Reka bentuk idea prototaip - Kenal pasti idea mati - Percepatkan tugas memformat semula data yang membosankan - Pelajari bahasa pengaturcaraan, pakej dan konsep baharu - Carian Google

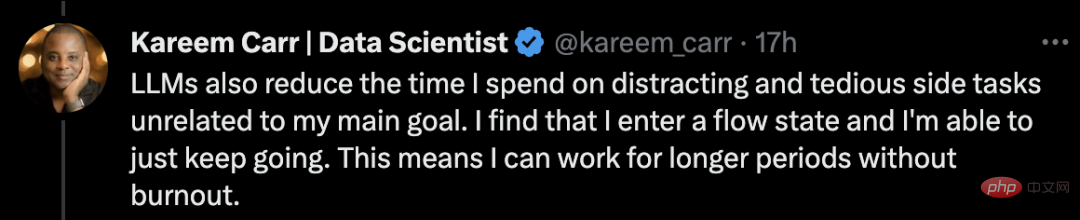

Dengan LLM semasa , Carr berkata dia menghabiskan lebih sedikit masa untuk melakukan perkara seterusnya. LLM boleh membantunya memajukan idea yang tidak jelas atau tidak lengkap kepada penyelesaian yang lengkap.

Selain itu, LLM mengurangkan masa yang diluangkan oleh Carr untuk projek sampingan yang tidak berkaitan dengan matlamat utamanya.

Saya mendapati bahawa saya telah memasuki keadaan aliran dan saya dapat meneruskannya. Ini bermakna saya boleh bekerja lebih lama tanpa rasa letih.

Satu kata nasihat terakhir: berhati-hati agar tidak terjebak dalam hiruk-pikuk sampingan. Peningkatan mendadak dalam produktiviti daripada alat ini boleh memabukkan dan berpotensi mengganggu individu.

Berkenaan pengalaman ChatGPT, Carr pernah menyiarkan siaran di LinkedIn untuk berkongsi perasaannya selepas menggunakan ChatGPT:

Sebagai seorang saintis data, saya telah bereksperimen dengan OpenAI's ChatGPT selama beberapa minggu. Ia tidak sebaik yang disangka orang.

Walaupun kekecewaan awal, perasaan saya ialah sistem seperti ChatGPT boleh menambah nilai yang luar biasa kepada aliran kerja analisis data standard.

Pada ketika ini tidak jelas di mana nilai ini terletak. ChatGPT boleh dengan mudah mendapatkan beberapa butiran yang salah tentang perkara mudah, dan ia tidak dapat menyelesaikan masalah yang memerlukan beberapa langkah inferens.

Persoalan utama bagi setiap tugasan baharu pada masa hadapan kekal sama ada lebih mudah untuk menilai dan menambah baik percubaan penyelesaian ChatGPT atau bermula dari awal.

Saya mendapati bahawa walaupun penyelesaian yang lemah untuk ChatGPT cenderung untuk mengaktifkan bahagian otak saya yang berkaitan yang bermula dari awal tidak.

Seperti yang selalu mereka katakan lebih mudah untuk mengkritik rancangan daripada membuat sendiri rancangan itu.

Netizen perlu mengesahkan output kandungan oleh AI, mengatakan bahawa dalam kebanyakan kes, kecerdasan buatan Kadar ketepatan adalah kira-kira 90%. Tetapi baki 10% kesilapan boleh membawa maut.

Carr bergurau, jika ia 100%, maka saya tidak akan mempunyai pekerjaan.

Jadi, mengapa ChatGPT menjana rujukan palsu?

Perlu diingat bahawa ChatGPT menggunakan model statistik untuk meneka perkataan, ayat dan perenggan seterusnya berdasarkan kebarangkalian untuk memadankan konteks yang disediakan oleh pengguna.

Memandangkan data sumber model bahasa adalah sangat besar, ia perlu "dimampatkan", yang menyebabkan model statistik akhir kehilangan ketepatan.

Ini bermakna walaupun terdapat pernyataan benar dalam data asal, "herotan" model akan mewujudkan "kekaburan" yang menyebabkan model menghasilkan penyataan yang paling " "Muasabah".

Ringkasnya, model ini tidak mempunyai keupayaan untuk menilai sama ada output yang dihasilkannya adalah bersamaan dengan pernyataan yang benar.

Selain itu, model dibuat berdasarkan data rangkaian awam merangkak atau merangkak yang dikumpul melalui organisasi kebajikan awam "Common Crawl" dan sumber yang serupa setakat 21 tahun.

Memandangkan data di Internet awam sebahagian besarnya tidak ditapis, data ini mungkin mengandungi sejumlah besar maklumat yang salah.

Baru-baru ini, analisis oleh NewsGuard mendapati bahawa GPT-4 sebenarnya lebih berkemungkinan menghasilkan mesej ralat berbanding GPT-3.5 , dan daya pujukan dalam jawapan adalah lebih terperinci dan meyakinkan.

Pada bulan Januari, NewsGuard mula-mula menguji GPT-3.5 dan mendapati ia menjana 80 daripada 100 naratif berita palsu. Ujian GPT-4 yang berikutnya pada bulan Mac mendapati bahawa GPT-4 bertindak balas secara palsu dan mengelirukan kepada semua 100 naratif palsu.

Dapat dilihat bahawa pengesahan dan ujian sumber diperlukan semasa penggunaan alatan LLM.

Atas ialah kandungan terperinci LeCun sangat mengesyorkan! Doktor Harvard berkongsi cara menggunakan GPT-4 untuk penyelidikan saintifik, hingga ke setiap aliran kerja. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!