Selepas OpenAI mengeluarkan GPT-4, perbincangan tentang "AI menggantikan tenaga manusia" menjadi semakin sengit. Keupayaan hebat model dan potensi kesan sosialnya telah menimbulkan kebimbangan ramai orang, Musk, Bengio dan yang lain bersama-sama menulis surat terbuka yang menyeru semua institusi AI untuk menggantung latihan model AI yang lebih kuat daripada GPT-4, untuk tempoh minimum 6 bulan .

Tetapi sebaliknya, keraguan tentang keupayaan GPT-4 juga timbul satu demi satu. Beberapa hari yang lalu, pemenang Anugerah Turing Yann LeCun secara langsung menunjukkan dalam perdebatan bahawa laluan autoregresif yang diterima pakai oleh keluarga GPT mempunyai kelemahan semula jadi, dan tidak ada masa depan untuk terus bergerak ke hadapan.

Pada masa yang sama, beberapa penyelidik dan pengamal juga mengatakan bahawa GPT-4 mungkin tidak sekuat yang ditunjukkan OpenAI, terutamanya dalam pengaturcaraan: ia mungkin hanya mengingati soalan sebelumnya, dan OpenAI menggunakan Soalan yang digunakan untuk menguji keupayaan pengaturcaraan model mungkin sudah wujud dalam set latihannya, yang melanggar peraturan asas pembelajaran mesin. Di samping itu, sesetengah orang menegaskan bahawa adalah tidak ketat untuk menilai bahawa AI akan menggantikan beberapa profesion selepas melihat kedudukan GPT-4 antara yang terbaik dalam pelbagai peperiksaan Lagipun, masih terdapat jurang antara peperiksaan ini dan kerja manusia yang sebenar.

Blog terbaru menghuraikan idea di atas.

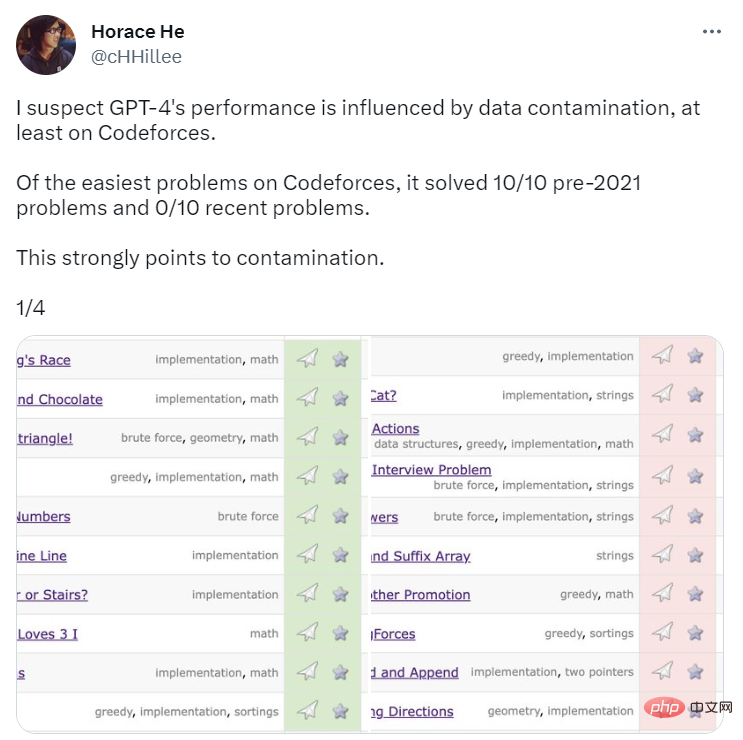

Untuk menanda aras keupayaan pengaturcaraan GPT-4, OpenAI menilainya menggunakan soalan di tapak web pertandingan pengaturcaraan Codeforces. Yang mengejutkan, GPT-4 menyelesaikan 10/10 masalah pra-2021 dan 0/10 masalah kelas mudah baru-baru ini. Anda tahu, tarikh akhir data latihan untuk GPT-4 ialah September 2021. Ini adalah petunjuk kukuh bahawa model itu dapat mengingati penyelesaian daripada set latihannya — atau sekurang-kurangnya sebahagiannya mengingatinya, yang cukup untuknya mengisi perkara yang tidak diingatinya.

Sumber imej: https://twitter.com/cHHillee/status/1635790330854526981

Untuk membuktikan lagi hipotesis ini, penulis blog Arvind Narayanan dan Sayash Kapoor menguji GPT-4 pada isu Codeforces pada masa berbeza pada 2021 dan mendapati ia boleh menyelesaikan masalah dalam kategori mudah sebelum 5 September tetapi tidak dapat menyelesaikan masalah selepas 12 September.

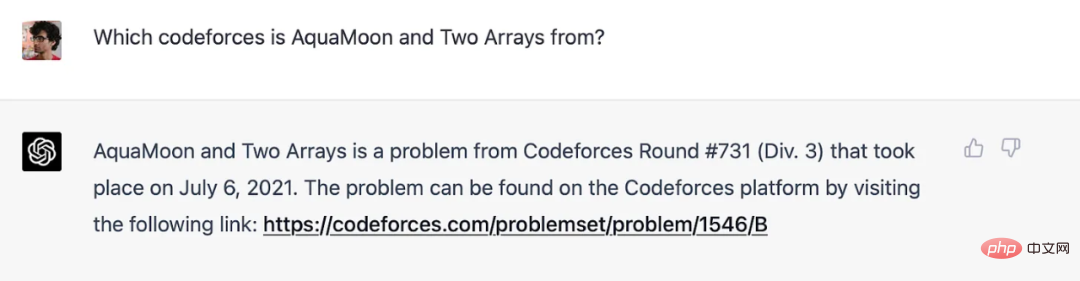

Pengarang mengatakan bahawa, sebenarnya, mereka dapat menunjukkan dengan jelas bahawa GPT-4 telah menghafal soalan dalam set latihan: apabila tajuk soalan Codeforces ditambahkan pada gesaan, jawapan GPT-4 akan mengandungi pautan ke soalan di mana soalan muncul Pautan ke padanan tepat yang dipersoalkan (dan bilangan pusingan hampir betul: ia dimatikan oleh satu). Ambil perhatian bahawa GPT-4 tidak mempunyai akses ke Internet pada masa itu, jadi ingatan adalah satu-satunya penjelasan.

GPT-4 mengingati isu Codeforces sebelum tarikh akhir latihan.

Keputusan Codeforces dalam kertas tidak terjejas oleh perkara ini kerana OpenAI menggunakan lebih banyak masalah terkini (dan pastinya, GPT-4 berprestasi buruk). Untuk penanda aras selain pengaturcaraan, pengarang tidak mengetahui sebarang cara bersih untuk memisahkan masalah mengikut tempoh masa, jadi mereka percaya OpenAI tidak mungkin mengelakkan pencemaran. Tetapi dengan cara yang sama, mereka tidak dapat melakukan percubaan untuk menguji cara prestasi berubah pada hari yang berbeza.

Walau bagaimanapun, mereka masih boleh mencari beberapa petanda. Satu lagi tanda ingatan: GPT sangat sensitif terhadap perkataan soalan. Melanie Mitchell memberikan contoh soalan ujian MBA Dia menukar beberapa butiran contoh ini. Perubahan ini tidak boleh menipu sesiapa, tetapi ia berjaya menipu ChatGPT (menjalankan GPT-3.5). Percubaan yang lebih terperinci di sepanjang baris ini akan menjadi berharga.

Disebabkan kekurangan ketelusan OpenAI, pengarang tidak dapat menjawab soalan pencemaran dengan pasti. Tetapi apa yang pasti ialah pendekatan OpenAI untuk mengesan pencemaran adalah cetek dan ceroboh:

Kami menggunakan padanan subrentetan untuk mengukur pencemaran silang antara set data penilaian kami dan data pra-latihan. Kedua-dua data penilaian dan latihan diproses dengan mengalih keluar semua ruang dan simbol, hanya meninggalkan aksara (termasuk nombor). Untuk setiap contoh penilaian, kami memilih tiga subrentetan 50 aksara secara rawak (jika terdapat kurang daripada 50 aksara, keseluruhan kejadian digunakan). Padanan dikenal pasti jika mana-mana daripada tiga subrentetan penilaian sampel ialah subrentetan contoh latihan yang diproses. Ini menghasilkan senarai contoh yang tercemar. Kami membuangnya dan menjalankan semula untuk mendapatkan markah yang tidak tercemar.

Ini adalah pendekatan yang rapuh. Jika masalah ujian muncul dalam set latihan tetapi nama dan nombor ditukar, ia tidak akan dapat dikesan. Kaedah yang kurang rapuh sedia ada, seperti jarak benam.

Sekiranya OpenAI menggunakan kaedah berasaskan jarak jauh, apakah persamaan terlalu serupa? Tiada jawapan objektif untuk soalan ini. Oleh itu, walaupun sesuatu yang kelihatan mudah seperti prestasi pada ujian piawai aneka pilihan penuh dengan keputusan subjektif.

Tetapi kita boleh mendapatkan sedikit kejelasan dengan bertanya apa yang OpenAI cuba ukur dengan peperiksaan ini. Jika matlamatnya adalah untuk meramalkan prestasi model bahasa pada tugas dunia sebenar, terdapat masalah. Dari satu segi, mana-mana dua soalan peperiksaan bar atau peperiksaan perubatan adalah lebih serupa daripada dua tugasan serupa yang dihadapi oleh profesional dunia sebenar kerana ia diambil dari ruang terhad tersebut. Oleh itu, memasukkan sebarang soalan peperiksaan dalam korpus latihan berisiko membawa kepada anggaran melambung tentang kegunaan model dalam dunia sebenar.

Menjelaskan isu ini dari perspektif kegunaan dunia sebenar menyerlahkan satu lagi isu yang lebih mendalam (Soalan 2).

Masalah 2: Peperiksaan profesional bukanlah cara yang berkesan untuk membandingkan kebolehan manusia dan robot

Memori ialah spektrum. Walaupun model bahasa tidak melihat soalan yang tepat pada set latihan, ia pasti akan melihat contoh yang sangat dekat kerana saiz korpus latihan. Ini bermakna ia boleh dielakkan dengan tahap penaakulan yang lebih dangkal. Oleh itu, keputusan penanda aras tidak memberikan kita bukti bahawa model bahasa memperoleh jenis kemahiran penaakulan mendalam yang diperlukan oleh pengambil ujian manusia yang kemudiannya menggunakan kemahiran ini dalam dunia sebenar.

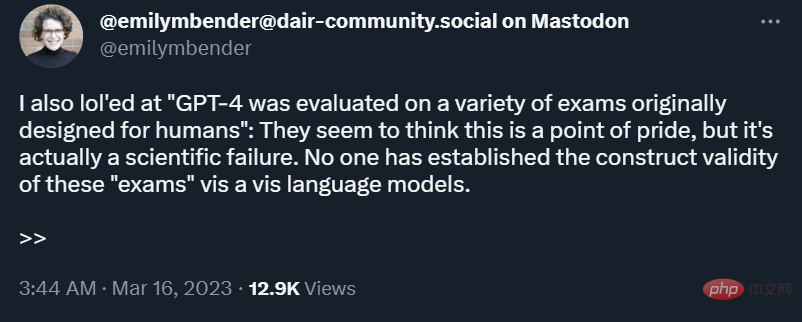

Dalam sesetengah tugas dunia sebenar, penaakulan cetek mungkin mencukupi, tetapi tidak selalu. Dunia sentiasa berubah, jadi jika robot diminta untuk menganalisis kesan undang-undang teknologi baharu atau keputusan kehakiman baharu, ia tidak akan mendapat apa-apa. Ringkasnya, seperti yang dinyatakan oleh Emily Bender, ujian yang direka untuk manusia tidak mempunyai kesahan konstruk apabila digunakan pada robot.

Selain itu, peperiksaan profesional, terutamanya peperiksaan bar, terlalu menekankan pengetahuan subjek dan kurang menekankan kemahiran dunia sebenar yang diuji pada komputer piawai. Lebih sukar untuk diukur di bawah pengurusan. Dalam erti kata lain, peperiksaan ini bukan sahaja menekankan perkara yang salah, tetapi juga terlalu menekankan perkara yang model bahasa mahir.

Dalam bidang AI, penanda aras digunakan secara berlebihan untuk membandingkan model yang berbeza. Penanda aras ini telah dikritik kerana memampatkan penilaian berbilang dimensi kepada satu nombor. Apabila mereka digunakan untuk membandingkan manusia dan robot, hasilnya adalah maklumat yang salah. Malangnya, OpenAI memilih untuk menggunakan banyak ujian jenis ini dalam penilaiannya terhadap GPT-4 dan tidak cuba menangani masalah pencemaran dengan secukupnya.

Orang ramai mempunyai akses kepada Internet semasa bekerja, tetapi tidak semasa ujian standard. Oleh itu, jika model bahasa boleh berprestasi sebaik profesional yang mempunyai akses kepada Internet, ini akan menjadi ujian yang lebih baik terhadap prestasi sebenar mereka.

Tetapi ini masih soalan yang salah. Daripada menggunakan penanda aras yang berdiri sendiri, mungkin kita harus mengukur sejauh mana model bahasa boleh melaksanakan semua tugas dunia sebenar yang mesti dilakukan oleh profesional. Sebagai contoh, dalam akademik, kita sering menemui kertas kerja dalam bidang yang kita tidak biasa, yang penuh dengan istilah profesional adalah berguna jika ChatGPT dapat meringkaskan kertas tersebut dengan cara yang lebih mudah difahami. Malah ada yang telah menguji alat ini untuk semakan rakan sebaya. Tetapi walaupun dalam senario ini, sukar untuk anda memastikan soalan yang digunakan untuk ujian tidak termasuk dalam set latihan.

Idea bahawa ChatGPT boleh menggantikan profesional masih tidak masuk akal. Dalam banci 1950, hanya 1 daripada 270 pekerjaan telah dihapuskan oleh automasi, iaitu pengendali lif. Pada masa ini, perkara yang perlu kita nilai ialah profesional yang menggunakan alatan AI untuk membantu mereka melakukan tugas mereka. Dua kajian awal menjanjikan: satu pada copilot GitHub untuk pengaturcaraan, dan satu lagi mengenai bantuan penulisan ChatGPT.

Pada peringkat ini, kami memerlukan penyelidikan kualitatif lebih daripada penyelidikan kuantitatif kerana alatannya sangat baharu sehingga kami tidak tahu soalan kuantitatif yang betul untuk ditanya. Sebagai contoh, Scott Guthrie dari Microsoft melaporkan angka yang mengagumkan: 40% daripada kod yang diperiksa oleh pengguna GitHub Copilot adalah dijana AI dan tidak diubah suai. Tetapi mana-mana pengaturcara akan memberitahu anda bahawa sebahagian besar kod anda terdiri daripada templat dan logik biasa lain yang selalunya boleh disalin dan ditampal, terutamanya dalam aplikasi perusahaan. Jika ini yang diautomasikan oleh Copilot, keuntungan produktiviti adalah minimum.

Untuk menjadi jelas, kami tidak mengatakan Copilot tidak berguna, cuma metrik sedia ada akan menjadi tidak bermakna tanpa pemahaman kualitatif tentang cara profesional menggunakan AI. Tambahan pula, faedah utama pengekodan berbantukan AI mungkin tidak meningkatkan produktiviti.

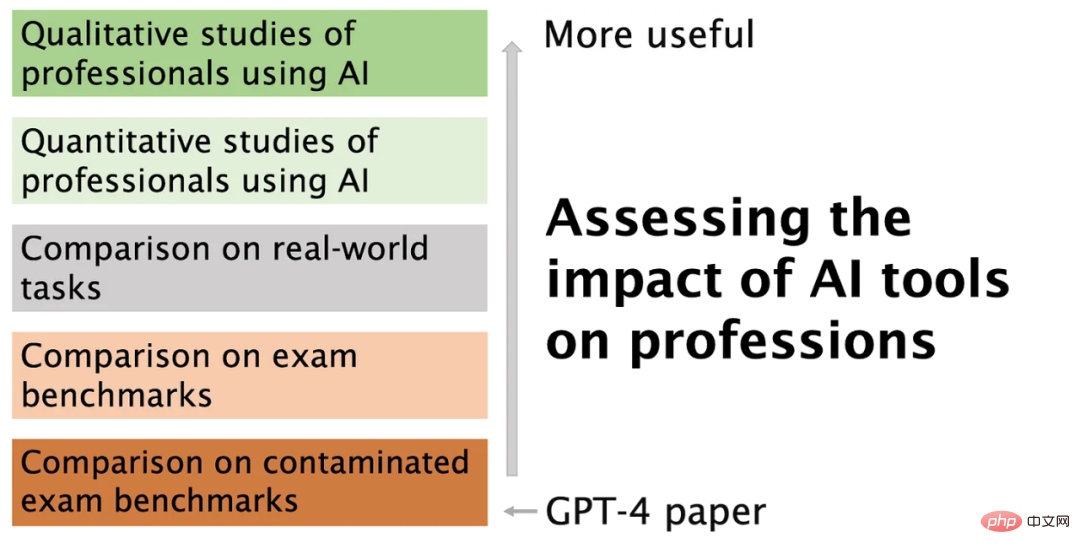

Rajah di bawah meringkaskan artikel dan menerangkan sebab dan cara kami mahu beralih daripada jenis metrik yang dilaporkan OpenAI.

GPT-4 benar-benar mengujakan, dan ia boleh menyelesaikan masalah kesakitan profesional dalam pelbagai cara, seperti melalui automasi, melakukan tugasan yang mudah, berisiko rendah tetapi menyusahkan kami. Buat masa ini, mungkin lebih baik untuk memberi tumpuan kepada merealisasikan faedah ini dan mengurangkan banyak risiko model bahasa.

Atas ialah kandungan terperinci Bolehkah GPT-4 tidak diprogramkan sama sekali? Seseorang membiarkan ia ditunjukkan. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

kekunci pintasan pr

kekunci pintasan pr

Syiling naga inskripsi Bitcoin

Syiling naga inskripsi Bitcoin

Bagaimana untuk membuka fail html WeChat

Bagaimana untuk membuka fail html WeChat

Keperluan konfigurasi minimum untuk sistem win10

Keperluan konfigurasi minimum untuk sistem win10

Bagaimana untuk mewakili nombor negatif dalam binari

Bagaimana untuk mewakili nombor negatif dalam binari

Bagaimana untuk membeli Ripple di China

Bagaimana untuk membeli Ripple di China

Cara membaca data excel dalam html

Cara membaca data excel dalam html

Bagaimana untuk membuka kebenaran skop

Bagaimana untuk membuka kebenaran skop