Doktor Cina dan saintis Google baru-baru ini mencadangkan model bahasa visual terlatih Vid2Seq, yang boleh membezakan dan menerangkan berbilang peristiwa dalam video. Kertas kerja ini telah diterima oleh CVPR 2023.

Baru-baru ini, penyelidik daripada Google mencadangkan model bahasa visual pra-latihan untuk menerangkan video berbilang acara - Vid2Seq, yang telah diterima oleh CVPR23.

Sebelum ini, memahami kandungan video merupakan tugas yang mencabar kerana video selalunya mengandungi berbilang peristiwa yang berlaku pada skala masa yang berbeza.

Contohnya, video seorang musher mengikat anjing pada kereta luncur dan kemudian anjing itu mula berlari melibatkan acara yang panjang (anjing eretan) dan acara singkat (anjing yang ditambat pada kereta luncur).

Satu cara untuk memajukan penyelidikan pemahaman video ialah melalui tugasan anotasi video yang padat, yang melibatkan pengesanan sementara dan menerangkan semua peristiwa dalam video berdurasi seminit.

Alamat kertas: https://arxiv.org/abs/2302.14115

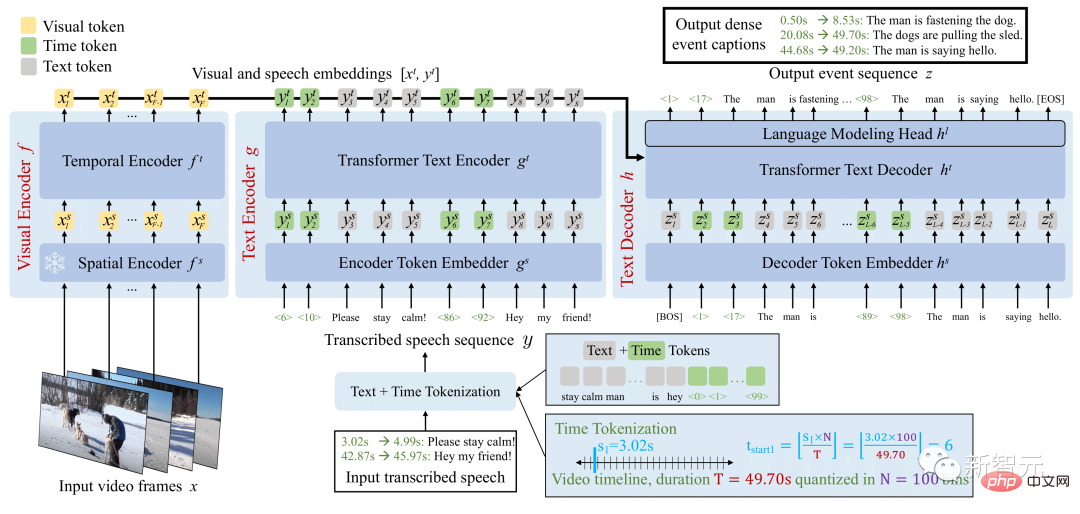

Seni bina Vid2Seq meningkatkan model bahasa dengan setem masa khas, membolehkannya Ramalkan sempadan peristiwa dan penerangan teks dengan lancar dalam urutan output yang sama.

Untuk pra-melatih model bersatu ini, para penyelidik mengeksploitasi video Diceritakan tanpa label.

Gambaran Keseluruhan Model Vid2Seq

Model Vid2Seq yang dihasilkan telah dilatih terlebih dahulu pada berjuta-juta video yang dikisahkan, menambah baik pelbagai tahap teknikal penanda aras anotasi video, termasuk Kapsyen YouCook2, ViTT dan ActivityNet.

Vid2Seq juga sangat sesuai untuk tetapan anotasi video padat beberapa tangkapan, tugas anotasi segmen video dan tugas anotasi video standard.

Seni bina Transformer berbilang modal telah menyegarkan SOTA bagi pelbagai tugasan video, seperti pengecaman tindakan. Walau bagaimanapun, menyesuaikan seni bina sedemikian kepada tugas yang kompleks untuk mencari dan menganotasi acara bersama dalam video berdurasi minit adalah tidak mudah.

Untuk mencapai matlamat ini, penyelidik mempertingkatkan model bahasa visual dengan penanda masa khas (seperti penanda teks) yang mewakili cap masa diskret dalam video, serupa dengan Pix2Seq dalam domain spatial.

Untuk input visual yang diberikan, model Vid2Seq yang terhasil boleh menerima input dan menjana urutan teks dan tanda masa.

Pertama, ini membolehkan model Vid2Seq memahami maklumat temporal input pertuturan yang ditranskripsi, yang diunjurkan sebagai satu jujukan token. Kedua, ini membolehkan Vid2Seq untuk bersama-sama meramalkan anotasi acara padat secara sementara dalam video sambil menjana satu jujukan penanda.

Seni bina Vid2Seq termasuk pengekod visual dan pengekod teks yang masing-masing mengekod bingkai video dan input pertuturan yang ditranskripsi. Pengekodan yang terhasil kemudiannya dimajukan kepada penyahkod teks, yang secara automatik meramalkan urutan output anotasi acara padat, serta kedudukan sementaranya dalam video. Seni bina ini dimulakan dengan tulang belakang visual yang kuat dan model bahasa yang kuat.

Mengumpul anotasi secara manual untuk anotasi video yang padat amat mahal disebabkan sifat tugasan yang intensif.

Oleh itu, penyelidik telah melatih model Vid2Seq menggunakan video narasi yang tidak berlabel, yang mudah didapati pada skala. Mereka juga menggunakan set data YT-Temporal-1B, yang merangkumi 18 juta video yang dikisahkan meliputi pelbagai domain.

Para penyelidik menggunakan ayat pertuturan yang ditranskripsi dan cap masa yang sepadan sebagai penyeliaan, yang diunjurkan sebagai urutan token tunggal.

Vid2Seq kemudiannya dilatih dengan objektif generatif yang mengajar penyahkod untuk meramalkan urutan pertuturan yang ditranskripsi sahaja yang diberikan input visual, dan objektif penolakan yang menggalakkan pembelajaran pelbagai mod, memerlukan model untuk topeng Ramalan dalam konteks urutan pertuturan ditranskripsi bising dan input visual. Khususnya, hingar ditambah pada urutan pertuturan dengan menutup token rentang secara rawak.

Model Vid2Seq pra-latihan yang terhasil boleh diperhalusi pada tugasan hiliran dengan objektif kebarangkalian maksimum yang mudah yang menggunakan paksaan guru (iaitu, apabila diberikan Ramalkan token seterusnya berdasarkan token sebenar asas sebelumnya).

Selepas penalaan halus, Vid2Seq mengatasi SOTA pada tiga penanda aras anotasi video padat hiliran standard (Kapsyen ActivityNet, YouCook2 dan ViTT) dan dua penanda aras anotasi klip video (MSR-VTT, MSVD).

Dalam kertas kerja, terdapat kajian ablasi tambahan, hasil kualitatif dan keputusan dalam tetapan beberapa tangkapan dan tugas anotasi perenggan video.

Hasilnya menunjukkan bahawa Vid2Seq boleh meramalkan sempadan dan anotasi peristiwa yang bermakna, dan anotasi dan sempadan yang diramalkan adalah berbeza dengan ketara daripada input pertuturan yang ditranskripsikan (ini juga menunjukkan bahawa kepentingan input penanda visual).

Contoh seterusnya ialah tentang siri arahan dalam resipi masakan, yang merupakan contoh ramalan anotasi acara padat oleh Vid2Seq pada set pengesahan YouCook2:

Yang berikut ialah contoh ramalan anotasi acara padat Vid2Seq pada set pengesahan ActivityNet Captions Dalam semua video ini, tiada pertuturan yang ditranskripsikan.

Walau bagaimanapun, masih akan ada kes kegagalan, seperti gambar yang ditandakan dengan warna merah di bawah Vid2Seq mengatakan bahawa ia adalah seseorang yang menanggalkan topinya di hadapan kamera.

Jadual 5 membandingkan Vid2Seq dengan kaedah anotasi video padat terkini: Vid2Seq menyegarkan SOTA pada tiga set data YouCook2, ViTT dan Kapsyen ActivityNet.

Penunjuk SODA Vid2Seq pada YouCook2 dan Kapsyen ActivityNet masing-masing adalah 3.5 dan 0.3 mata lebih tinggi daripada PDVC dan UEDVC. Dan E2ESG menggunakan pra-latihan teks biasa dalam domain di Wikihow, dan Vid2Seq lebih baik daripada kaedah ini. Keputusan ini menunjukkan bahawa model Vid2Seq yang telah dilatih mempunyai keupayaan yang kuat untuk melabelkan peristiwa padat.

Jadual 6 menilai prestasi penyetempatan acara model anotasi video padat. Berbanding dengan YouCook2 dan ViTT, Vid2Seq lebih unggul dalam mengendalikan anotasi video padat sebagai tugas penjanaan jujukan tunggal.

Walau bagaimanapun, Vid2Seq berprestasi rendah pada Kapsyen ActivityNet berbanding PDVC dan UEDVC. Berbanding dengan kedua-dua kaedah ini, Vid2Seq menyepadukan kurang pengetahuan terdahulu tentang penyetempatan temporal, manakala dua kaedah lain termasuk komponen khusus tugasan seperti pembilang acara atau melatih model secara berasingan untuk subtugasan penyetempatan.

Pengekod pengubah temporal visual, pengekod teks dan penyahkod teks kesemuanya mempunyai 12 lapisan, 12 kepala, membenamkan dimensi 768, Dimensi tersembunyi MLP 2048.

Jujukan pengekod dan penyahkod teks dipenggal atau dipadatkan kepada token L=S=1000 semasa pra-latihan, dan token S=1000 dan L=256 semasa penalaan halus. Semasa inferens, penyahkodan carian rasuk digunakan, 4 jujukan pertama dijejaki dan normalisasi panjang 0.6 digunakan.

Pengarang menggunakan pengoptimum Adam, β=(0.9, 0.999), tanpa pereputan berat.

Semasa pra-latihan, kadar pembelajaran 1e^-4 digunakan, dipanaskan secara linear (bermula dari 0) untuk 1000 lelaran pertama dan dikekalkan malar untuk lelaran yang tinggal.

Semasa penalaan halus, gunakan kadar pembelajaran 3e^-4, pemanasan secara linear (bermula dari 0) dalam 10% lelaran pertama dan kekalkan pereputan kosinus (turun hingga 0) dalam baki 90 % daripada lelaran. Dalam proses itu, saiz kumpulan 32 video digunakan dan dibahagikan pada 16 cip TPU v4.

Pengarang membuat 40 pelarasan zaman pada YouCook2, 20 pelarasan zaman pada Kapsyen ActivityNet dan ViTT, 5 pelarasan zaman kepada MSR-VTT dan 10 pelarasan zaman kepada MSVD.

Vid2Seq yang dicadangkan oleh Google ialah model bahasa visual baharu untuk anotasi video padat, yang boleh melaksanakan pra-latihan berskala besar secara berkesan pada video narasi tanpa label Dan mencapai hasil SOTA pada pelbagai hiliran tanda aras anotasi video padat.

Pengenalan kepada pengarang

Pengarang pertama kertas kerja: Antoine Yang

Antoine Yang ialah pelajar kedoktoran tahun ketiga dalam pasukan WILLOW Inria dan École Normale Supérieure di Paris Penyelianya ialah Antoine Miech, Josef Sivic, Ivan Laptev dan Cordelia Schmid.

Penyelidikan semasa memfokuskan pada pembelajaran model bahasa visual untuk pemahaman video. Beliau telah menjalani latihan di Makmal Bahtera Nuh Huawei pada 2019, menerima ijazah kejuruteraan dari Ecole Polytechnique di Paris dan ijazah sarjana dalam matematik, visi dan pembelajaran dari Universiti Nasional Paris-Saclay pada 2020, dan telah menjalani latihan di Google Research pada 2022.

Atas ialah kandungan terperinci Google melancarkan Vid2Seq berbilang modal, memahami IQ video dalam talian, sari kata tidak akan berada di luar talian |. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!