PyTorch快速搭建神经网络及其保存提取方法详解

本篇文章主要介绍了PyTorch快速搭建神经网络及其保存提取方法详解,现在分享给大家,也给大家做个参考。一起过来看看吧

有时候我们训练了一个模型, 希望保存它下次直接使用,不需要下次再花时间去训练 ,本节我们来讲解一下PyTorch快速搭建神经网络及其保存提取方法详解

一、PyTorch快速搭建神经网络方法

先看实验代码:

import torch

import torch.nn.functional as F

# 方法1,通过定义一个Net类来建立神经网络

class Net(torch.nn.Module):

def __init__(self, n_feature, n_hidden, n_output):

super(Net, self).__init__()

self.hidden = torch.nn.Linear(n_feature, n_hidden)

self.predict = torch.nn.Linear(n_hidden, n_output)

def forward(self, x):

x = F.relu(self.hidden(x))

x = self.predict(x)

return x

net1 = Net(2, 10, 2)

print('方法1:\n', net1)

# 方法2 通过torch.nn.Sequential快速建立神经网络结构

net2 = torch.nn.Sequential(

torch.nn.Linear(2, 10),

torch.nn.ReLU(),

torch.nn.Linear(10, 2),

)

print('方法2:\n', net2)

# 经验证,两种方法构建的神经网络功能相同,结构细节稍有不同

'''''

方法1:

Net (

(hidden): Linear (2 -> 10)

(predict): Linear (10 -> 2)

)

方法2:

Sequential (

(0): Linear (2 -> 10)

(1): ReLU ()

(2): Linear (10 -> 2)

)

'''先前学习了通过定义一个Net类来构建神经网络的方法,classNet中首先通过super函数继承torch.nn.Module模块的构造方法,再通过添加属性的方式搭建神经网络各层的结构信息,在forward方法中完善神经网络各层之间的连接信息,然后再通过定义Net类对象的方式完成对神经网络结构的构建。

构建神经网络的另一个方法,也可以说是快速构建方法,就是通过torch.nn.Sequential,直接完成对神经网络的建立。

两种方法构建得到的神经网络结构完全相同,都可以通过print函数来打印输出网络信息,不过打印结果会有些许不同。

二、PyTorch的神经网络保存和提取

在学习和研究深度学习的时候,当我们通过一定时间的训练,得到了一个比较好的模型的时候,我们当然希望将这个模型及模型参数保存下来,以备后用,所以神经网络的保存和模型参数提取重载是很有必要的。

首先,我们需要在需要保存网路结构及其模型参数的神经网络的定义、训练部分之后通过torch.save()实现对网络结构和模型参数的保存。有两种保存方式:一是保存年整个神经网络的的结构信息和模型参数信息,save的对象是网络net;二是只保存神经网络的训练模型参数,save的对象是net.state_dict(),保存结果都以.pkl文件形式存储。

对应上面两种保存方式,重载方式也有两种。对应第一种完整网络结构信息,重载的时候通过torch.load(‘.pkl')直接初始化新的神经网络对象即可。对应第二种只保存模型参数信息,需要首先搭建相同的神经网络结构,通过net.load_state_dict(torch.load('.pkl'))完成模型参数的重载。在网络比较大的时候,第一种方法会花费较多的时间。

代码实现:

import torch

from torch.autograd import Variable

import matplotlib.pyplot as plt

torch.manual_seed(1) # 设定随机数种子

# 创建数据

x = torch.unsqueeze(torch.linspace(-1, 1, 100), dim=1)

y = x.pow(2) + 0.2*torch.rand(x.size())

x, y = Variable(x, requires_grad=False), Variable(y, requires_grad=False)

# 将待保存的神经网络定义在一个函数中

def save():

# 神经网络结构

net1 = torch.nn.Sequential(

torch.nn.Linear(1, 10),

torch.nn.ReLU(),

torch.nn.Linear(10, 1),

)

optimizer = torch.optim.SGD(net1.parameters(), lr=0.5)

loss_function = torch.nn.MSELoss()

# 训练部分

for i in range(300):

prediction = net1(x)

loss = loss_function(prediction, y)

optimizer.zero_grad()

loss.backward()

optimizer.step()

# 绘图部分

plt.figure(1, figsize=(10, 3))

plt.subplot(131)

plt.title('net1')

plt.scatter(x.data.numpy(), y.data.numpy())

plt.plot(x.data.numpy(), prediction.data.numpy(), 'r-', lw=5)

# 保存神经网络

torch.save(net1, '7-net.pkl') # 保存整个神经网络的结构和模型参数

torch.save(net1.state_dict(), '7-net_params.pkl') # 只保存神经网络的模型参数

# 载入整个神经网络的结构及其模型参数

def reload_net():

net2 = torch.load('7-net.pkl')

prediction = net2(x)

plt.subplot(132)

plt.title('net2')

plt.scatter(x.data.numpy(), y.data.numpy())

plt.plot(x.data.numpy(), prediction.data.numpy(), 'r-', lw=5)

# 只载入神经网络的模型参数,神经网络的结构需要与保存的神经网络相同的结构

def reload_params():

# 首先搭建相同的神经网络结构

net3 = torch.nn.Sequential(

torch.nn.Linear(1, 10),

torch.nn.ReLU(),

torch.nn.Linear(10, 1),

)

# 载入神经网络的模型参数

net3.load_state_dict(torch.load('7-net_params.pkl'))

prediction = net3(x)

plt.subplot(133)

plt.title('net3')

plt.scatter(x.data.numpy(), y.data.numpy())

plt.plot(x.data.numpy(), prediction.data.numpy(), 'r-', lw=5)

# 运行测试

save()

reload_net()

reload_params()

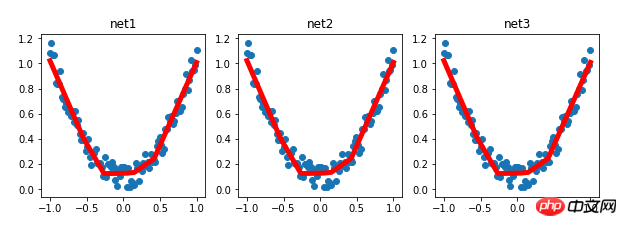

实验结果:

相关推荐:

Atas ialah kandungan terperinci PyTorch快速搭建神经网络及其保存提取方法详解. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Alat AI Hot

Undress AI Tool

Gambar buka pakaian secara percuma

Undresser.AI Undress

Apl berkuasa AI untuk mencipta foto bogel yang realistik

AI Clothes Remover

Alat AI dalam talian untuk mengeluarkan pakaian daripada foto.

Clothoff.io

Penyingkiran pakaian AI

Video Face Swap

Tukar muka dalam mana-mana video dengan mudah menggunakan alat tukar muka AI percuma kami!

Artikel Panas

Alat panas

Notepad++7.3.1

Editor kod yang mudah digunakan dan percuma

SublimeText3 versi Cina

Versi Cina, sangat mudah digunakan

Hantar Studio 13.0.1

Persekitaran pembangunan bersepadu PHP yang berkuasa

Dreamweaver CS6

Alat pembangunan web visual

SublimeText3 versi Mac

Perisian penyuntingan kod peringkat Tuhan (SublimeText3)

iFlytek: Huawei Ascend 910B pada asasnya setanding dengan NVIDIA A100 dalam keupayaan, dan mereka bekerjasama untuk mencipta pangkalan baharu untuk kecerdasan buatan umum negara saya

Oct 22, 2023 pm 06:13 PM

iFlytek: Huawei Ascend 910B pada asasnya setanding dengan NVIDIA A100 dalam keupayaan, dan mereka bekerjasama untuk mencipta pangkalan baharu untuk kecerdasan buatan umum negara saya

Oct 22, 2023 pm 06:13 PM

Laman web ini melaporkan pada 22 Oktober bahawa pada suku ketiga tahun ini, iFlytek mencapai keuntungan bersih sebanyak 25.79 juta yuan, penurunan tahun ke tahun sebanyak 81.86% dalam tiga suku pertama ialah 99.36 juta yuan, a penurunan tahun ke tahun sebanyak 76.36%. Jiang Tao, naib presiden iFlytek, mendedahkan pada taklimat prestasi Q3 bahawa iFlytek telah melancarkan projek penyelidikan khas dengan Huawei Shengteng pada awal 2023, dan bersama-sama membangunkan perpustakaan pengendali berprestasi tinggi dengan Huawei untuk bersama-sama mewujudkan pangkalan baharu bagi buatan am China. kecerdasan untuk membenarkan model skala besar domestik Seni bina adalah berdasarkan perisian dan perkakasan inovatif secara bebas. Beliau menegaskan bahawa keupayaan semasa Huawei Ascend 910B pada asasnya setanding dengan Nvidia A100. Pada Festival Pembangun Global iFlytek 1024 yang akan datang, iFlytek dan Huawei akan membuat pengumuman bersama selanjutnya mengenai pangkalan kuasa pengkomputeran kecerdasan buatan. Beliau juga menyebut,

Gabungan sempurna PyCharm dan PyTorch: langkah pemasangan dan konfigurasi terperinci

Feb 21, 2024 pm 12:00 PM

Gabungan sempurna PyCharm dan PyTorch: langkah pemasangan dan konfigurasi terperinci

Feb 21, 2024 pm 12:00 PM

PyCharm ialah persekitaran pembangunan bersepadu (IDE) yang berkuasa dan PyTorch ialah rangka kerja sumber terbuka yang popular dalam bidang pembelajaran mendalam. Dalam bidang pembelajaran mesin dan pembelajaran mendalam, menggunakan PyCharm dan PyTorch untuk pembangunan boleh meningkatkan kecekapan pembangunan dan kualiti kod. Artikel ini akan memperkenalkan secara terperinci cara memasang dan mengkonfigurasi PyTorch dalam PyCharm, dan melampirkan contoh kod khusus untuk membantu pembaca menggunakan fungsi berkuasa kedua-dua ini dengan lebih baik. Langkah 1: Pasang PyCharm dan Python

sangat laju! Kenali pertuturan video menjadi teks dalam beberapa minit sahaja dengan kurang daripada 10 baris kod

Feb 27, 2024 pm 01:55 PM

sangat laju! Kenali pertuturan video menjadi teks dalam beberapa minit sahaja dengan kurang daripada 10 baris kod

Feb 27, 2024 pm 01:55 PM

Hello semua, saya Kite Dua tahun lalu, keperluan untuk menukar fail audio dan video kepada kandungan teks adalah sukar dicapai, tetapi kini ia boleh diselesaikan dengan mudah dalam beberapa minit sahaja. Dikatakan bahawa untuk mendapatkan data latihan, beberapa syarikat telah merangkak sepenuhnya video pada platform video pendek seperti Douyin dan Kuaishou, dan kemudian mengekstrak audio daripada video dan menukarnya ke dalam bentuk teks untuk digunakan sebagai korpus latihan untuk data besar. model. Jika anda perlu menukar fail video atau audio kepada teks, anda boleh mencuba penyelesaian sumber terbuka yang tersedia hari ini. Sebagai contoh, anda boleh mencari titik masa tertentu apabila dialog dalam filem dan rancangan televisyen muncul. Tanpa berlengah lagi, mari kita ke intinya. Whisper ialah Whisper sumber terbuka OpenAI Sudah tentu ia ditulis dalam Python Ia hanya memerlukan beberapa pakej pemasangan yang mudah.

Pengenalan kepada lima kaedah pensampelan dalam tugas penjanaan bahasa semula jadi dan pelaksanaan kod Pytorch

Feb 20, 2024 am 08:50 AM

Pengenalan kepada lima kaedah pensampelan dalam tugas penjanaan bahasa semula jadi dan pelaksanaan kod Pytorch

Feb 20, 2024 am 08:50 AM

Dalam tugas penjanaan bahasa semula jadi, kaedah pensampelan ialah teknik untuk mendapatkan output teks daripada model generatif. Artikel ini akan membincangkan 5 kaedah biasa dan melaksanakannya menggunakan PyTorch. 1. GreedyDecoding Dalam penyahkodan tamak, model generatif meramalkan perkataan urutan keluaran berdasarkan urutan input masa langkah demi masa. Pada setiap langkah masa, model mengira taburan kebarangkalian bersyarat bagi setiap perkataan, dan kemudian memilih perkataan dengan kebarangkalian bersyarat tertinggi sebagai output langkah masa semasa. Perkataan ini menjadi input kepada langkah masa seterusnya, dan proses penjanaan diteruskan sehingga beberapa syarat penamatan dipenuhi, seperti urutan panjang tertentu atau penanda akhir khas. Ciri GreedyDecoding ialah setiap kali kebarangkalian bersyarat semasa adalah yang terbaik

YOLO adalah abadi! YOLOv9 dikeluarkan: prestasi dan kelajuan SOTA~

Feb 26, 2024 am 11:31 AM

YOLO adalah abadi! YOLOv9 dikeluarkan: prestasi dan kelajuan SOTA~

Feb 26, 2024 am 11:31 AM

Kaedah pembelajaran mendalam hari ini memberi tumpuan kepada mereka bentuk fungsi objektif yang paling sesuai supaya keputusan ramalan model paling hampir dengan situasi sebenar. Pada masa yang sama, seni bina yang sesuai mesti direka bentuk untuk mendapatkan maklumat yang mencukupi untuk ramalan. Kaedah sedia ada mengabaikan fakta bahawa apabila data input mengalami pengekstrakan ciri lapisan demi lapisan dan transformasi spatial, sejumlah besar maklumat akan hilang. Artikel ini akan menyelidiki isu penting apabila menghantar data melalui rangkaian dalam, iaitu kesesakan maklumat dan fungsi boleh balik. Berdasarkan ini, konsep maklumat kecerunan boleh atur cara (PGI) dicadangkan untuk menghadapi pelbagai perubahan yang diperlukan oleh rangkaian dalam untuk mencapai pelbagai objektif. PGI boleh menyediakan maklumat input lengkap untuk tugas sasaran untuk mengira fungsi objektif, dengan itu mendapatkan maklumat kecerunan yang boleh dipercayai untuk mengemas kini berat rangkaian. Di samping itu, rangka kerja rangkaian ringan baharu direka bentuk

'Pemilik Bilibili UP berjaya mencipta rangkaian neural berasaskan batu merah pertama di dunia, yang menyebabkan sensasi di media sosial dan dipuji oleh Yann LeCun.'

May 07, 2023 pm 10:58 PM

'Pemilik Bilibili UP berjaya mencipta rangkaian neural berasaskan batu merah pertama di dunia, yang menyebabkan sensasi di media sosial dan dipuji oleh Yann LeCun.'

May 07, 2023 pm 10:58 PM

Dalam Minecraft, batu merah adalah item yang sangat penting. Ia adalah bahan unik dalam permainan Suis, obor batu merah, dan blok batu merah boleh memberikan tenaga seperti elektrik kepada wayar atau objek. Litar Redstone boleh digunakan untuk membina struktur untuk anda mengawal atau mengaktifkan jentera lain Ia sendiri boleh direka bentuk untuk bertindak balas kepada pengaktifan manual oleh pemain, atau mereka boleh mengeluarkan isyarat berulang kali atau bertindak balas kepada perubahan yang disebabkan oleh bukan pemain, seperti pergerakan makhluk. dan item Jatuh, pertumbuhan tumbuhan, siang dan malam, dan banyak lagi. Oleh itu, dalam dunia saya, redstone boleh mengawal pelbagai jenis jentera, daripada jentera ringkas seperti pintu automatik, suis lampu dan bekalan kuasa strob, kepada lif besar, ladang automatik, platform permainan kecil dan juga komputer binaan dalam permainan . Baru-baru ini, stesen B UP utama @

Gambaran keseluruhan tiga seni bina cip arus perdana untuk pemanduan autonomi dalam satu artikel

Apr 12, 2023 pm 12:07 PM

Gambaran keseluruhan tiga seni bina cip arus perdana untuk pemanduan autonomi dalam satu artikel

Apr 12, 2023 pm 12:07 PM

Cip AI arus perdana semasa terutamanya dibahagikan kepada tiga kategori: GPU, FPGA dan ASIC. Kedua-dua GPU dan FPGA adalah seni bina cip yang agak matang pada peringkat awal dan merupakan cip kegunaan umum. ASIC ialah cip yang disesuaikan untuk senario AI tertentu. Industri telah mengesahkan bahawa CPU tidak sesuai untuk pengkomputeran AI, tetapi ia juga penting dalam aplikasi AI. Seni Bina Penyelesaian GPU Perbandingan antara GPU dan CPU CPU mengikut seni bina von Neumann, terasnya ialah penyimpanan atur cara/data dan pelaksanaan bersiri. Oleh itu, seni bina CPU memerlukan sejumlah besar ruang untuk meletakkan unit storan (Cache) dan unit kawalan (Control) Sebaliknya, unit pengkomputeran (ALU) hanya menduduki sebahagian kecil, jadi CPU berfungsi secara besar-besaran. pengkomputeran selari.

Tutorial memasang PyCharm dengan PyTorch

Feb 24, 2024 am 10:09 AM

Tutorial memasang PyCharm dengan PyTorch

Feb 24, 2024 am 10:09 AM

Sebagai rangka kerja pembelajaran mendalam yang berkuasa, PyTorch digunakan secara meluas dalam pelbagai projek pembelajaran mesin. Sebagai persekitaran pembangunan bersepadu Python yang berkuasa, PyCharm juga boleh memberikan sokongan yang baik apabila melaksanakan tugas pembelajaran mendalam. Artikel ini akan memperkenalkan secara terperinci cara memasang PyTorch dalam PyCharm dan menyediakan contoh kod khusus untuk membantu pembaca mula menggunakan PyTorch dengan cepat untuk tugasan pembelajaran mendalam. Langkah 1: Pasang PyCharm Mula-mula, kita perlu pastikan kita ada