GitHub: https://github.com/chatsapi/ChatsAPI

Perpustakaan: https://pypi.org/project/chatsapi/

Kecerdasan Buatan telah mengubah industri, tetapi melaksanakannya secara berkesan kekal sebagai cabaran yang menggerunkan. Rangka kerja yang kompleks, masa tindak balas yang perlahan dan keluk pembelajaran yang curam mewujudkan halangan untuk perniagaan dan pembangun. Masukkan ChatsAPI — rangka kerja ejen AI berprestasi tinggi yang terobosan yang direka untuk menyampaikan kelajuan, fleksibiliti dan kesederhanaan yang tiada tandingan.

Dalam artikel ini, kami akan mendedahkan perkara yang menjadikan ChatsAPI unik, sebab ia merupakan pengubah permainan dan cara ia memperkasakan pembangun untuk membina sistem pintar dengan kemudahan dan kecekapan yang tiada tandingan.

ChatsAPI bukan sekadar rangka kerja AI yang lain; ia merupakan revolusi dalam interaksi dipacu AI. Inilah sebabnya:

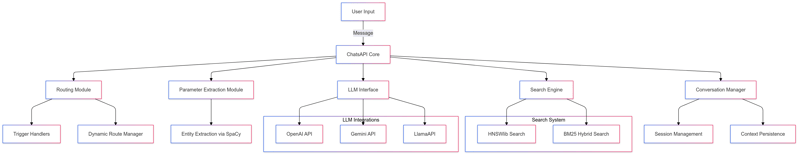

Kelajuan: Dengan masa tindak balas sub-milisaat, ChatsAPI ialah rangka kerja ejen AI terpantas di dunia. Carian berkuasa HNSWlib memastikan perolehan laluan dan pengetahuan sepantas kilat, walaupun dengan set data yang besar.

Kecekapan: Pendekatan hibrid SBERT dan BM25 menggabungkan pemahaman semantik dengan sistem kedudukan tradisional, memastikan kedua-dua kelajuan dan ketepatan.

Penyatuan Lancar dengan LLM

ChatsAPI menyokong Model Bahasa Besar (LLM) terkini seperti OpenAI, Gemini, LlamaAPI dan Ollama. Ia memudahkan kerumitan penyepaduan LLM ke dalam aplikasi anda, membolehkan anda menumpukan pada membina pengalaman yang lebih baik.

Padanan Laluan Dinamik

ChatsAPI menggunakan pemahaman bahasa semula jadi (NLU) untuk memadankan pertanyaan pengguna secara dinamik ke laluan yang dipratentukan dengan ketepatan yang tiada tandingan.

Daftar laluan dengan mudah dengan penghias seperti @trigger.

Gunakan pengekstrakan parameter dengan @extract untuk memudahkan pengendalian input, tidak kira betapa rumitnya kes penggunaan anda.

Pengendalian Pertanyaan Berprestasi Tinggi

Sistem AI tradisional bergelut dengan sama ada kelajuan atau ketepatan — ChatsAPI menyampaikan kedua-duanya. Sama ada mencari padanan terbaik dalam pangkalan pengetahuan yang luas atau mengendalikan jumlah pertanyaan yang tinggi, ChatsAPI cemerlang.

Rangka Kerja Fleksibel

ChatsAPI menyesuaikan diri dengan mana-mana kes penggunaan, sama ada anda sedang membina:

Direka oleh pembangun, untuk pembangun, tawaran ChatsAPI:

Pada terasnya, ChatsAPI beroperasi melalui proses tiga langkah:

Hasilnya? Sistem yang pantas, tepat dan sangat mudah untuk digunakan.

Sokongan Pelanggan

Automatikkan interaksi pelanggan dengan penyelesaian pertanyaan yang sangat pantas. ChatsAPI memastikan pengguna mendapat jawapan yang relevan serta-merta, meningkatkan kepuasan dan mengurangkan kos operasi.

Carian Pangkalan Pengetahuan

Memperkasakan pengguna untuk mencari pangkalan pengetahuan yang luas dengan pemahaman semantik. Pendekatan hibrid SBERT-BM25 memastikan hasil yang tepat dan sedar konteks.

AI Perbualan

Bina ejen AI perbualan yang memahami dan menyesuaikan diri dengan input pengguna dalam masa nyata. ChatsAPI disepadukan dengan lancar dengan LLM teratas untuk menyampaikan perbualan semula jadi dan menarik.

Rangka kerja lain menjanjikan fleksibiliti atau prestasi — tetapi tiada satu pun yang boleh menyampaikan kedua-duanya seperti ChatsAPI. Kami telah mencipta rangka kerja iaitu:

ChatsAPI memperkasakan pembangun untuk membuka kunci potensi penuh AI, tanpa kerumitan atau prestasi yang perlahan.

Bermula dengan ChatsAPI adalah mudah:

pip install chatsapi

from chatsapi import ChatsAPI

chat = ChatsAPI()

@chat.trigger("Hello")

async def greet(input_text):

return "Hi there!"

from chatsapi import ChatsAPI

chat = ChatsAPI()

@chat.trigger("Need help with account settings.")

@chat.extract([

("account_number", "Account number (a nine digit number)", int, None),

("holder_name", "Account holder's name (a person name)", str, None)

])

async def account_help(chat_message: str, extracted: dict):

return {"message": chat_message, "extracted": extracted}

Run your message (with no LLM)

@app.post("/chat")

async def message(request: RequestModel, response: Response):

reply = await chat.run(request.message)

return {"message": reply}

import os

from dotenv import load_dotenv

from fastapi import FastAPI, Request, Response

from pydantic import BaseModel

from chatsapi.chatsapi import ChatsAPI

# Load environment variables from .env file

load_dotenv()

app = FastAPI() # instantiate FastAPI or your web framework

chat = ChatsAPI( # instantiate ChatsAPI

llm_type="gemini",

llm_model="models/gemini-pro",

llm_api_key=os.getenv("GOOGLE_API_KEY"),

)

# chat trigger - 1

@chat.trigger("Want to cancel a credit card.")

@chat.extract([("card_number", "Credit card number (a 12 digit number)", str, None)])

async def cancel_credit_card(chat_message: str, extracted: dict):

return {"message": chat_message, "extracted": extracted}

# chat trigger - 2

@chat.trigger("Need help with account settings.")

@chat.extract([

("account_number", "Account number (a nine digit number)", int, None),

("holder_name", "Account holder's name (a person name)", str, None)

])

async def account_help(chat_message: str, extracted: dict):

return {"message": chat_message, "extracted": extracted}

# request model

class RequestModel(BaseModel):

message: str

# chat conversation

@app.post("/chat")

async def message(request: RequestModel, response: Response, http_request: Request):

session_id = http_request.cookies.get("session_id")

reply = await chat.conversation(request.message, session_id)

return {"message": f"{reply}"}

# set chat session

@app.post("/set-session")

def set_session(response: Response):

session_id = chat.set_session()

response.set_cookie(key="session_id", value=session_id)

return {"message": "Session set"}

# end chat session

@app.post("/end-session")

def end_session(response: Response, http_request: Request):

session_id = http_request.cookies.get("session_id")

chat.end_session(session_id)

response.delete_cookie("session_id")

return {"message": "Session ended"}

await chat.query(request.message)

Kaedah berasaskan LLM (API) tradisional biasanya mengambil masa kira-kira empat saat bagi setiap permintaan. Sebaliknya, ChatsAPI memproses permintaan dalam masa kurang satu saat, selalunya dalam milisaat, tanpa membuat sebarang panggilan API LLM.

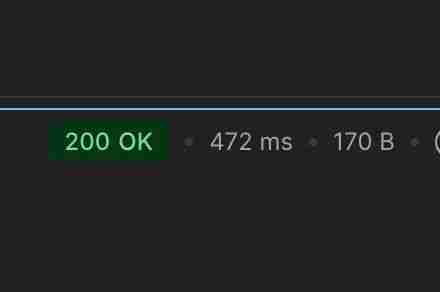

Melaksanakan tugas penghalaan sembang dalam masa 472ms (tiada cache)

Melaksanakan tugas penghalaan sembang dalam masa 21ms (selepas cache)

Melakukan tugas pengekstrakan data penghalaan sembang dalam masa 862ms (tiada cache)

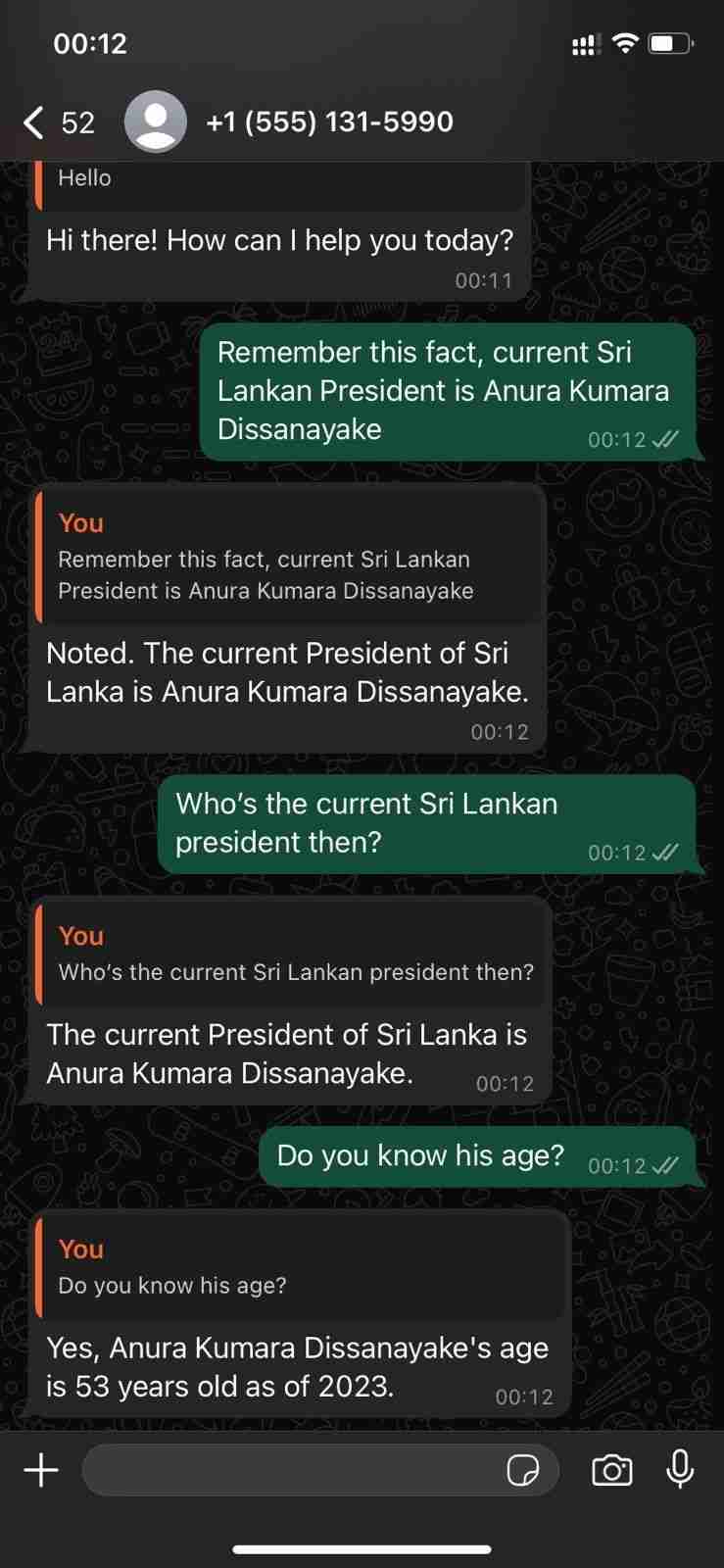

Menunjukkan kebolehan perbualannya dengan WhatsApp Cloud API

ChatsAPI — Hierarki Ciri

ChatsAPI bukan sekadar rangka kerja; ia adalah anjakan paradigma dalam cara kita membina dan berinteraksi dengan sistem AI. Dengan menggabungkan kelajuan, ketepatan dan kemudahan penggunaan, ChatsAPI menetapkan penanda aras baharu untuk rangka kerja ejen AI.

Sertai revolusi hari ini dan lihat sebab ChatsAPI mengubah landskap AI.

Bersedia untuk menyelam? Mulakan dengan ChatsAPI sekarang dan alami masa depan pembangunan AI.

Atas ialah kandungan terperinci ChatsAPI — Rangka Kerja Agen AI Terpantas di Dunia. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

python menggabungkan dua senarai

python menggabungkan dua senarai

Apakah fail dump?

Apakah fail dump?

Bagaimana untuk menyelesaikan masalah bahawa cad tidak boleh disalin ke papan keratan

Bagaimana untuk menyelesaikan masalah bahawa cad tidak boleh disalin ke papan keratan

Pengenalan kepada komponen laravel

Pengenalan kepada komponen laravel

Apakah enjin mysql?

Apakah enjin mysql?

harga btc hari ini

harga btc hari ini

Perbezaan antara kedai utama JD.com yang dikendalikan sendiri dan rasmi

Perbezaan antara kedai utama JD.com yang dikendalikan sendiri dan rasmi

Bagaimana untuk mendaftar dompet Bitcoin

Bagaimana untuk mendaftar dompet Bitcoin