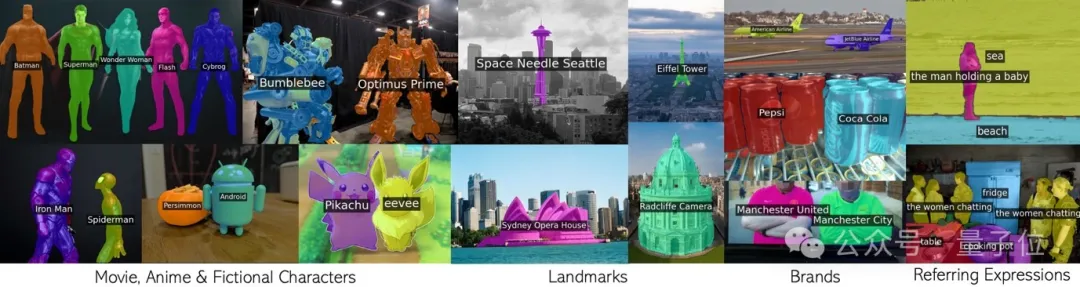

Panggil CLIP dalam gelung untuk membahagikan konsep yang tidak terkira dengan berkesan tanpa latihan tambahan.

Sebarang frasa termasuk watak filem, tanda tempat, jenama dan kategori umum.

Keputusan baharu pasukan bersama Universiti Oxford dan Penyelidikan Google ini telah diterima oleh CVPR 2024 dan kod tersebut telah bersumberkan terbuka.

Pasukan mencadangkan teknologi baharu yang dipanggil CLIP sebagai RNN (pendek kata CaR), yang menyelesaikan beberapa masalah utama dalam bidang pembahagian imej kosa kata terbuka:

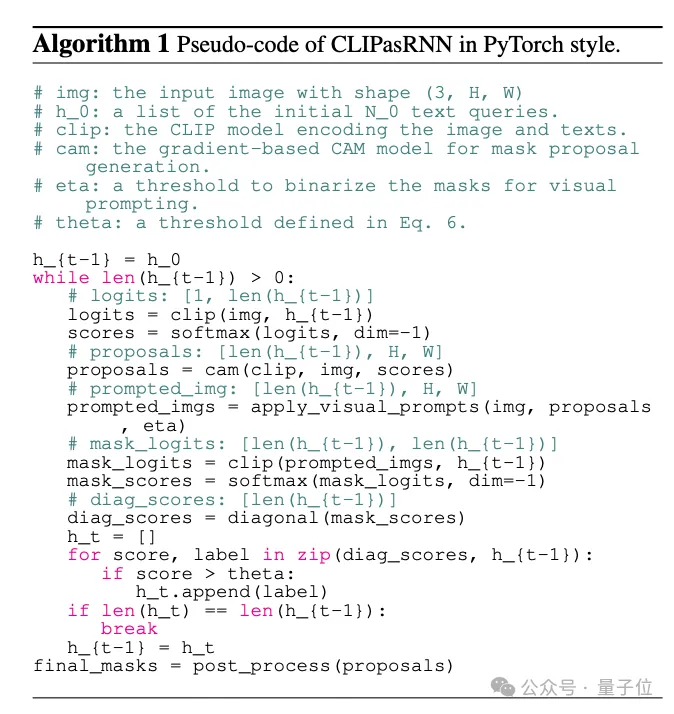

Untuk memahami prinsip CaR, anda perlu menyemak rangkaian saraf berulang RNN terlebih dahulu.

RNN memperkenalkan konsep keadaan tersembunyi, iaitu seperti "memori" yang menyimpan maklumat dari langkah masa lalu. Dan setiap kali langkah berkongsi set pemberat yang sama, yang boleh memodelkan data jujukan dengan baik.

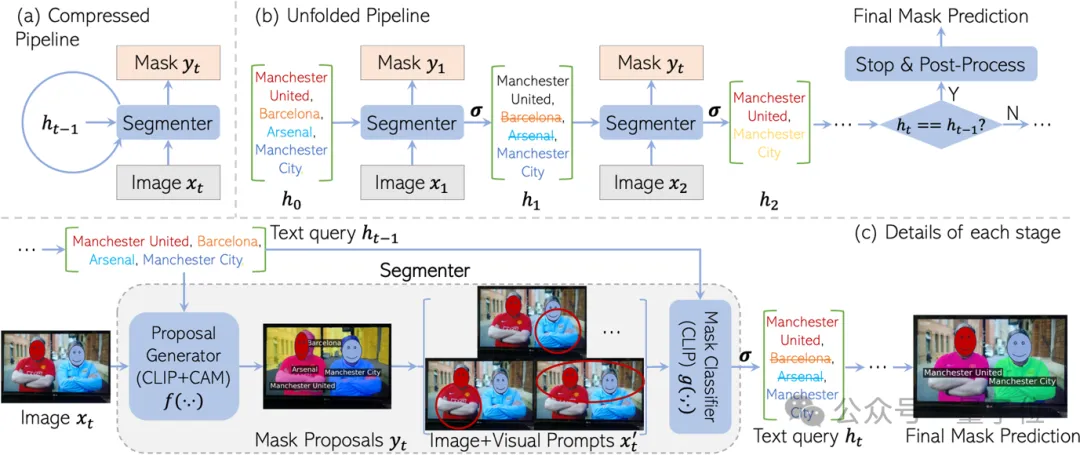

Diinspirasikan oleh RNN, CaR juga direka bentuk sebagai rangka kerja kitaran, terdiri daripada dua bahagian:

Dengan terus berulang seperti ini, pertanyaan teks akan menjadi lebih dan lebih tepat, dan kualiti topeng akan menjadi lebih tinggi dan lebih tinggi.

Akhirnya, apabila set pertanyaan tidak lagi berubah, hasil segmentasi akhir boleh dikeluarkan.

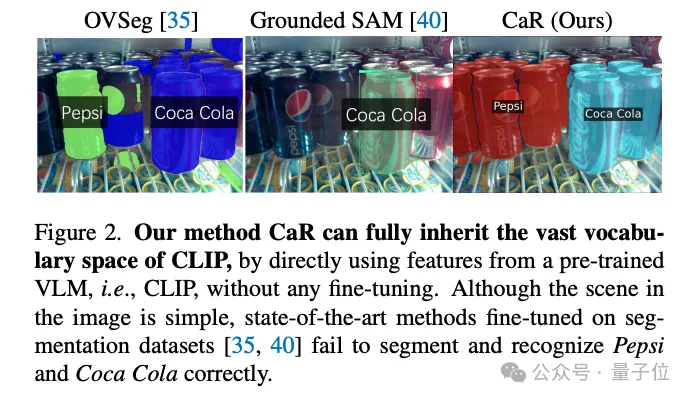

Sebab rangka kerja rekursif ini direka bentuk adalah untuk mengekalkan "pengetahuan" pra-latihan CLIP ke tahap maksimum.

Terdapat banyak konsep yang dilihat dalam pra-latihan CLIP, merangkumi segala-galanya daripada selebriti, mercu tanda kepada watak anime. Jika anda memperhalusi set data berpecah, perbendaharaan kata pasti akan mengecut dengan ketara.

Sebagai contoh, model SAM "bahagi segala-galanya" hanya boleh mengenali sebotol Coca-Cola, tetapi tidak sebotol Pepsi-Cola.

Tapi pakai CLIP terus untuk segmentasi, kesannya tak memuaskan.

Ini kerana objektif pra-latihan CLIP pada asalnya tidak direka untuk ramalan yang padat. Terutama apabila pertanyaan teks tertentu tidak wujud dalam imej, CLIP boleh menjana beberapa topeng yang salah dengan mudah.

CaR bijak menyelesaikan masalah ini melalui lelaran gaya RNN. Dengan menilai dan menapis pertanyaan berulang kali sambil menambah baik topeng, pembahagian kosa kata terbuka berkualiti tinggi akhirnya tercapai.

Akhir sekali, mari ikuti tafsiran pasukan dan pelajari tentang butiran rangka kerja CaR.

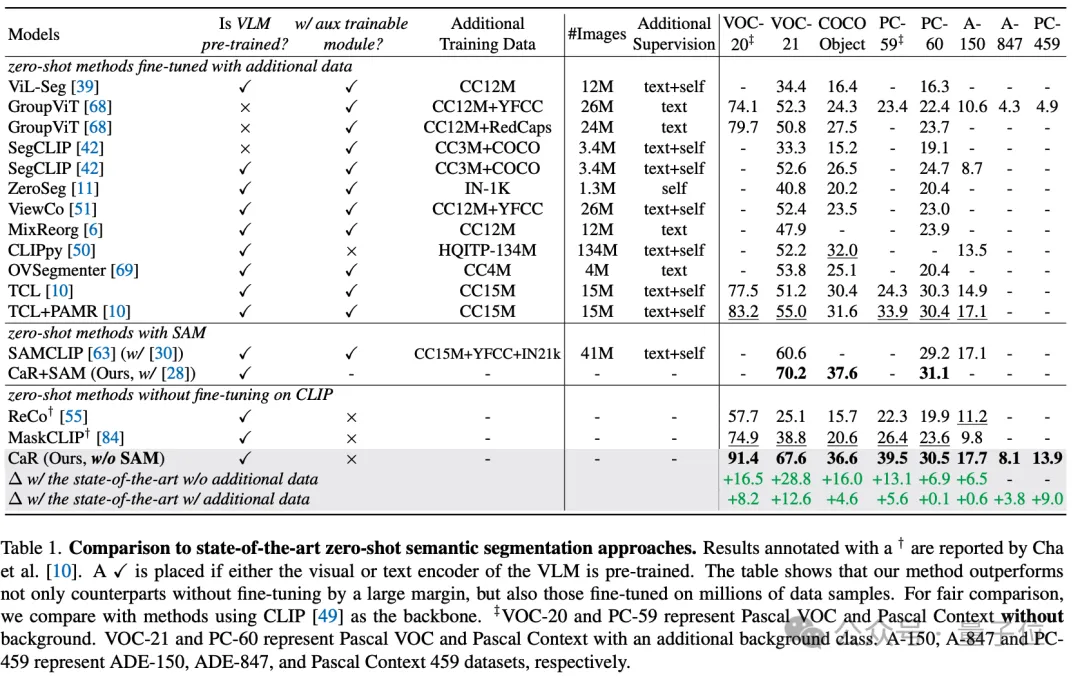

Melalui cara teknikal ini, teknologi CaR telah mencapai peningkatan prestasi yang ketara pada berbilang set data standard, mengatasi kaedah pembelajaran sifar pukulan tradisional, dan juga menunjukkan prestasi unggul jika dibandingkan dengan model yang telah mengalami peningkatan daya saing yang meluas. Seperti yang ditunjukkan dalam jadual di bawah, walaupun tiada latihan tambahan dan penalaan halus diperlukan, CaR menunjukkan prestasi yang lebih kukuh pada lapan penunjuk berbeza bagi pembahagian semantik sifar pukulan daripada kaedah sebelumnya yang diperhalusi pada data tambahan.

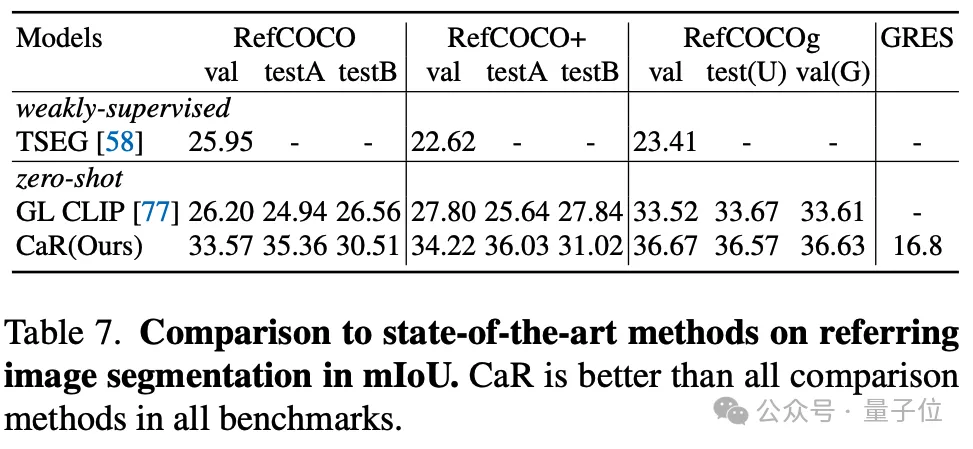

Penulis juga menguji kesan CaR pada segmentasi Rujukan sampel sifar juga menunjukkan prestasi yang lebih kukuh daripada kaedah sampel sifar sebelumnya.

Ringkasnya, CaR (CLIP sebagai RNN) ialah rangka kerja rangkaian saraf berulang yang inovatif yang boleh melaksanakan tugas pembahagian imej semantik dan rujukan sifar tangkapan secara berkesan tanpa data latihan tambahan. Ia meningkatkan kualiti pembahagian dengan ketara dengan mengekalkan ruang perbendaharaan kata yang luas bagi model bahasa visual yang telah dilatih dan memanfaatkan proses berulang untuk terus mengoptimumkan penjajaran pertanyaan teks dengan cadangan topeng.

Kelebihan CaR ialah keupayaannya untuk mengendalikan pertanyaan teks yang kompleks tanpa penalaan halus dan kebolehskalaannya kepada medan video, membawa kemajuan terobosan kepada bidang pembahagian imej kosa kata terbuka.

Pautan kertas: https://arxiv.org/abs/2312.07661.

Laman utama projek: https://torrvision.com/clip_as_rnn/.

Atas ialah kandungan terperinci CLIP dipilih sebagai CVPR apabila digunakan sebagai RNN: ia boleh membahagikan banyak konsep tanpa latihan |. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Bagaimana untuk mengkonfigurasi pelayan web

Bagaimana untuk mengkonfigurasi pelayan web

Penyelesaian kepada penetapan vscode antara muka Cina tidak berkuat kuasa

Penyelesaian kepada penetapan vscode antara muka Cina tidak berkuat kuasa

kaedah pemadaman fail hiberfil

kaedah pemadaman fail hiberfil

Kaedah pemindahan pangkalan data MySQL

Kaedah pemindahan pangkalan data MySQL

Mempromosikan iklan

Mempromosikan iklan

499 penyelesaian penamat kod ralat

499 penyelesaian penamat kod ralat

Bagaimana untuk menyelesaikan ranap permulaan tomcat

Bagaimana untuk menyelesaikan ranap permulaan tomcat

Perbezaan antara pengecasan pantas PD dan pengecasan pantas am

Perbezaan antara pengecasan pantas PD dan pengecasan pantas am