Maison >Périphériques technologiques >IA >L'apprentissage profond heurte un mur ? Qui a remué le nid de frelons entre LeCun et Marcus ?

Les protagonistes d'aujourd'hui sont deux vieux ennemis de l'industrie de l'IA qui s'aiment et s'entretuent :

Yann LeCun et Gary Marcus

Avant de parler formellement de la « nouvelle querelle » de cette fois, passons d'abord en revue la « vieille querelle » " entre les deux grands maîtres". "La bataille entre LeCun et Marcus" et l'apprentissage profond.

Auparavant, Marcus avait publié un article dans le magazine Nautilus, affirmant que l'apprentissage profond était "incapable d'avancer"

Hé les gars, il a en fait dit que "l'apprentissage profond a heurté un mur". En voyant des commentaires aussi effrénés, LeCun, une grande star de l'industrie de l'IA, pourrait le faire. Je ne reste pas assis et j'ai immédiatement posté une réponse !

Et dit, si tu veux faire la queue, je t'accompagnerai !

Et dit, si tu veux faire la queue, je t'accompagnerai !

LeCun a réfuté les points de vue de Marcus un par un dans l'article.

La technologie dominante de l'intelligence artificielle contemporaine est le réseau neuronal (NN) d'apprentissage profond (DL), qui est un grand- Des algorithmes d'auto-apprentissage à grande échelle qui sont efficaces pour identifier et exploiter des modèles dans les données. Dès le début, les critiques ont cru prématurément que les réseaux neuronaux se heurtaient à un « mur insurmontable ». Pourtant, à chaque fois, cela s’est avéré être un obstacle temporaire.

La technologie dominante de l'intelligence artificielle contemporaine est le réseau neuronal (NN) d'apprentissage profond (DL), qui est un grand- Des algorithmes d'auto-apprentissage à grande échelle qui sont efficaces pour identifier et exploiter des modèles dans les données. Dès le début, les critiques ont cru prématurément que les réseaux neuronaux se heurtaient à un « mur insurmontable ». Pourtant, à chaque fois, cela s’est avéré être un obstacle temporaire.

Dans les années 1960, NN ne pouvait pas résoudre de fonctions non linéaires. Mais cette situation n'a pas duré longtemps. Elle a changé dans les années 1980 avec l'émergence de la rétropropagation, mais un nouveau « mur insurmontable » est apparu à nouveau, c'est-à-dire qu'il était très difficile d'entraîner le système.

Dans les années 1990, les humains ont développé des procédures simplifiées et des structures standardisées, qui ont rendu la formation plus fiable, mais quels que soient les résultats obtenus, il semblait toujours y avoir un « mur insurmontable ». Cette fois, c'était le manque de données de formation et d'informatique. pouvoir.

Le deep learning a commencé à se généraliser en 2012, lorsque les derniers GPU ont pu s'entraîner sur l'énorme ensemble de données ImageNet, battant facilement tous les concurrents. Mais ensuite, des voix de doute ont émergé : les gens ont découvert « un nouveau mur » : la formation au deep learning nécessite une grande quantité de données étiquetées manuellement.

Cependant, ces dernières années, ce doute a perdu tout son sens, car l'apprentissage auto-supervisé a obtenu d'assez bons résultats, comme GPT-3, qui ne nécessite pas de données étiquetées.

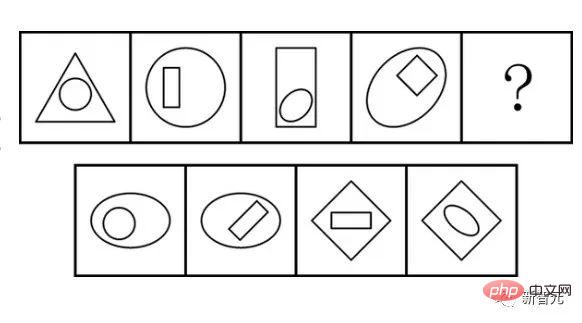

L'obstacle apparemment insurmontable de nos jours est le « raisonnement symbolique », qui est la capacité de manipuler des symboles de manière algébrique ou logique. Comme nous l’avons appris étant enfants, la résolution de problèmes mathématiques nécessite de manipuler des symboles étape par étape selon des règles strictes (par exemple, résoudre des équations).

Gary Marcus, auteur de "The Algebraic Mind" et co-auteur de "Rebooting AI", a récemment estimé que DL ne pouvait pas progresser davantage car les réseaux de neurones ont du mal à traiter de telles opérations symboliques. En revanche, de nombreux chercheurs en DL pensent que DL fait déjà du raisonnement symbolique et continuera à s'améliorer.

Au cœur de ce débat se trouve le rôle des symboles dans l'intelligence artificielle. Il existe deux points de vue différents : l'un estime que le raisonnement symbolique doit être codé en dur dès le début, tandis que l'autre estime que les machines peuvent apprendre le raisonnement symbolique grâce à l'expérience. . Par conséquent, la clé du problème est de savoir comment comprendre l’intelligence humaine, et donc comment développer une intelligence artificielle capable d’atteindre les niveaux humains.

La chose la plus importante dans le raisonnement symbolique est la précision : selon la permutation et la combinaison, les symboles peuvent avoir de nombreux ordres différents, par exemple entre "(3-2)-1 et 3-(2- 1)" Les différences sont importantes, il est donc crucial de savoir comment effectuer un raisonnement symbolique correct dans le bon ordre.

Marcus pense que ce type de raisonnement est au cœur de la cognition et est essentiel pour fournir la logique grammaticale sous-jacente au langage et les opérations de base pour les mathématiques. Il pense que cela peut s’étendre à nos capacités les plus élémentaires et que derrière ces capacités se cache une logique symbolique sous-jacente.

L'intelligence artificielle que nous connaissons est née de l'étude de ce type de raisonnement, et est souvent appelée « intelligence artificielle symbolique ». Mais affiner l’expertise humaine en un ensemble de règles est très difficile et nécessite énormément de temps et de main d’œuvre. C'est ce qu'on appelle le « goulot d'étranglement dans l'acquisition des connaissances ».

Bien qu'il soit facile d'écrire des règles pour les mathématiques ou la logique, le monde lui-même est en noir et blanc et très flou. Il s'avère qu'il est impossible pour les humains d'écrire des règles qui contrôlent chaque modèle ou définissent des symboles pour chaque concept flou.

Cependant, le développement de la science et de la technologie a créé des réseaux de neurones, et les réseaux de neurones sont les meilleurs pour découvrir des modèles et accepter l'ambiguïté.

Un réseau neuronal est une équation relativement simple qui apprend une fonction pour fournir une sortie appropriée pour tout ce qui entre dans le système.

Par exemple, pour entraîner un réseau à deux classifications, placez une grande quantité d'échantillons de données (ici, prenez une chaise comme exemple) dans le réseau neuronal, entraînez-le pendant plusieurs époques et enfin permettez au réseau de déduire avec succès si l'image est celle d'une chaise.

Pour parler franchement, il ne s’agit pas seulement d’intelligence artificielle, mais plus essentiellement de qu’est-ce que l’intelligence et comment fonctionne le cerveau humain. "

Ces réseaux de neurones peuvent être entraînés précisément parce que la fonction qui les met en œuvre est différentiable. En d'autres termes, si l'IA symbolique est similaire aux jetons discrets utilisés dans la logique symbolique, alors les réseaux de neurones sont des fonctions continues du calcul

Cela permet l'apprentissage. de meilleures représentations en ajustant les paramètres, ce qui signifie qu'il peut s'adapter aux données de manière plus appropriée sans problèmes de sous-ajustement ou de sur-ajustement. Cependant, lorsqu'il s'agit de règles strictes et de jetons discrets, cette fluidité crée un nouveau mur : lorsque nous résolvons un problème. équation, nous voulons généralement la réponse exacte, pas une réponse approximative.

C'est là que l'IA symbolique brille, alors Marcus suggère de simplement combiner les deux : insérer un module de manipulation symbolique codé en dur au-dessus du module DL.

C'est attractif car les deux approches se complètent très bien, il semble donc qu'un "hybride" de modules avec des manières de travailler différentes maximisera les avantages des deux approches.

Mais le débat se tourne vers la question de savoir si la manipulation symbolique doit être intégrée dans un système où les symboles et les capacités de manipulation sont conçus par des humains et où le module est non différenciable - et donc incompatible avec DL.

Le légendaire "Raisonnement Symbolique"

Cette hypothèse est très controversée.

Les réseaux de neurones traditionnels pensent que nous n'avons pas besoin d'effectuer un raisonnement symbolique manuellement, mais que nous pouvons apprendre le raisonnement symbolique, c'est-à-dire en utilisant des exemples symboliques pour entraîner la machine à effectuer le type de raisonnement correct, lui permettant ainsi d'apprendre la réalisation de modèles abstraits. . En bref, les machines peuvent apprendre à manipuler les symboles du monde, mais sans symboles artisanaux intégrés ni règles de manipulation des symboles.

Les grands modèles de langage contemporains tels que GPT-3 et LaMDA montrent le potentiel de cette approche. Leur capacité à manipuler les symboles est étonnante, et ces modèles font preuve d’un raisonnement de bon sens étonnant, de capacités combinatoires, de capacités multilingues, de capacités logiques et mathématiques, et même de la capacité terrifiante d’imiter les morts.

Mais en fait ce n'est pas fiable. Si vous demandiez à DALL-E de réaliser une sculpture romaine représentant un philosophe avec une barbe, des lunettes et une chemise tropicale, ce serait exceptionnel. Mais si vous lui demandez de dessiner un beagle portant un jouet rose poursuivant un écureuil, vous obtiendrez parfois un beagle portant un jouet rose ou un écureuil.

Il fait un excellent travail lorsqu'il peut attribuer toutes les propriétés à un seul objet, mais il échoue lorsqu'il y a plusieurs objets et plusieurs propriétés. L'attitude de nombreux chercheurs est qu'il s'agit d'un « mur » pour DL sur la voie d'une intelligence plus humaine.

Alors, l'opération symbolique doit-elle être codée en dur ? Ou est-elle apprenable

Ce n'est pas la compréhension de Marcus ?

Il suppose que le raisonnement symbolique est tout ou rien - puisque DALL-E n'a pas de symboles ni de règles logiques comme base de ses opérations, il ne raisonne pas réellement à l'aide de symboles. Ainsi, les nombreux échecs des grands modèles de langage indiquent qu’il ne s’agit pas d’un véritable raisonnement, mais simplement d’une imitation mécanique sans émotion.

Pour Marcus, il est impossible d'atteindre la lune en grimpant à un arbre assez grand. Par conséquent, il pense que le modèle linguistique actuel du DL n’est pas plus proche du langage réel que celui de Nim Chimpsky (un chimpanzé mâle capable d’utiliser la langue des signes américaine). Le problème de DALL-E n'est pas un manque de formation. Ce sont simplement des systèmes qui n’ont pas saisi la structure logique sous-jacente de la phrase et qui ne peuvent donc pas saisir correctement la manière dont les différentes parties doivent être connectées en un tout.

En revanche, Geoffrey Hinton et d'autres pensent que les réseaux de neurones peuvent manipuler avec succès des symboles sans avoir besoin de symboles codés en dur ni de raisonnement algébrique. Le but de DL n’est pas la manipulation symbolique à l’intérieur de la machine, mais plutôt l’apprentissage de la génération de symboles corrects à partir des systèmes du monde.

Le rejet du mélange des deux modalités n'est pas téméraire, mais plutôt basé sur des différences philosophiques quant à savoir si l'on croit que le raisonnement symbolique peut être appris.

La critique de Marcus à l’égard de DL découle d’un débat connexe en sciences cognitives sur le fonctionnement de l’intelligence et ce qui rend les humains uniques. Ses opinions sont cohérentes avec une école de pensée « nativiste » bien connue en psychologie, selon laquelle de nombreuses caractéristiques clés de la cognition sont innées – en fait, nous naissons en grande partie en sachant comment le monde fonctionne.

Le cœur de cette perception innée est la capacité à manipuler des symboles (mais on ne sait pas encore si cette perception est présente dans la nature ou si elle est propre aux humains). Pour Marcus, cette capacité à manipuler des symboles sous-tend bon nombre des caractéristiques fondamentales du sens commun : respect des règles, abstraction, raisonnement causal, réidentification des détails, généralisation et bien d’autres capacités.

En bref, une grande partie de notre compréhension du monde nous est donnée par la nature, et apprendre consiste à enrichir les détails.

Il existe un autre point de vue empirique qui brise l'idée ci-dessus : la manipulation de symboles est rare dans la nature et est principalement une capacité de communication acquise que nos anciens ancêtres humains ont progressivement acquise au cours des 2 millions d'années.

De ce point de vue, les principales capacités cognitives sont des capacités d'apprentissage non symboliques liées à des capacités de survie améliorées, telles que l'identification rapide d'une proie, la prédiction de ses actions probables et le développement de réponses compétentes.

Ce point de vue soutient que les capacités cognitives les plus complexes sont acquises grâce à des capacités d’apprentissage générales et auto-supervisées. Cela suppose également que la plupart de nos capacités cognitives complexes ne reposent pas sur des opérations symboliques. Au lieu de cela, ils simulent divers scénarios et prédisent les meilleurs résultats.

Cette vision empirique considère les symboles et leur manipulation comme une simple capacité acquise, acquise à mesure que les humains s'appuient de plus en plus sur un comportement coopératif pour réussir. Cela considère les symboles comme les inventions que nous utilisons pour coordonner la coopération entre les groupes – comme les mots, mais aussi les cartes, les descriptions iconiques, les rituels et même les rôles sociaux.

La différence entre ces deux points de vue est très évidente. Pour la tradition nativiste, les symboles et leur manipulation sont intrinsèquement présents dans l’esprit, et l’utilisation de mots et de chiffres découle de cette capacité primitive. Cette vision explique de manière attrayante les capacités qui découlent des adaptations évolutives (bien que les explications sur comment et pourquoi la manipulation des symboles ont évolué ont été controversées).

Du point de vue de la tradition empiriste, les symboles et le raisonnement symbolique sont une invention communicative utile qui découle des capacités générales d'apprentissage et de notre monde social complexe. Cela traite les choses symboliques qui se produisent dans nos têtes, telles que les calculs internes et les monologues intérieurs, comme des pratiques externes découlant des mathématiques et de l’utilisation du langage.

Les domaines de l’intelligence artificielle et des sciences cognitives sont étroitement liés, il n’est donc pas surprenant que ces batailles réapparaissent ici. Étant donné que le succès de l’une ou l’autre vision en matière d’intelligence artificielle justifiera partiellement (mais seulement partiellement) l’une ou l’autre approche en sciences cognitives, il n’est pas surprenant que ces débats soient devenus intenses.

La clé du problème n'est pas seulement de savoir comment résoudre correctement les problèmes dans le domaine de l'intelligence artificielle contemporaine, mais aussi ce qu'est l'intelligence et comment fonctionne le cerveau.

Pourquoi l'affirmation « l'apprentissage profond se heurte à un mur » est-elle si provocatrice ?

Si Marcus a raison, alors l'apprentissage profond ne sera jamais en mesure de parvenir à une IA de type humain, quel que soit le nombre de nouvelles architectures qu'il propose ou la puissance de calcul qu'il y met.

Continuer à ajouter plus de couches aux réseaux de neurones ne fera que rendre les choses plus confuses, car la véritable manipulation de symboles nécessite un manipulateur naturel de symboles. Puisque ce type d'opération symbolique est à la base de plusieurs capacités de bon sens, DL ne fera que « ne rien comprendre ».

En revanche, si les partisans du DL et les empiristes ont raison, ce qui prête à confusion, c'est l'idée d'insérer un module de manipulation symbolique.

Dans ce contexte, les systèmes d'apprentissage profond effectuent déjà un raisonnement symbolique et continueront de s'améliorer à mesure qu'ils utilisent un apprentissage auto-supervisé plus multimodal, des modèles mondiaux prédictifs de plus en plus utiles, et pour simuler et évaluer les résultats. La mémoire de travail est élargie pour mieux répondre aux contraintes.

L'introduction de modules de manipulation symbolique ne créera pas une IA plus humaine. Au contraire, elle forcera toutes les opérations de « raisonnement » à passer par un goulot d'étranglement inutile, ce qui nous éloignera encore plus de « l'intelligence humaine ». Cela pourrait supprimer l’un des aspects les plus passionnants de l’apprentissage profond : sa capacité à proposer des solutions meilleures que les humains.

Cela dit, rien de tout cela ne justifie ce battage médiatique idiot : puisque les systèmes actuels ne sont pas conscients, ils ne peuvent pas nous comprendre, l'apprentissage par renforcement n'est pas suffisant et vous ne pouvez pas construire une intelligence de type humain simplement en passant à l'échelle. Mais toutes ces questions sont des questions périphériques au débat principal : les opérations symboliques doivent-elles être codées en dur ? Ou peuvent-elles être apprises ?

Est-ce un appel à arrêter de travailler sur des modèles hybrides (c'est-à-dire des modèles avec des manipulateurs symboliques non différenciables) ? Bien sûr que non. Les gens devraient choisir ce qui fonctionne.

Cependant, les chercheurs travaillent sur des modèles hybrides depuis les années 1980, mais leur efficacité n’a pas été prouvée et, dans de nombreux cas, ils sont susceptibles d’être bien inférieurs aux réseaux de neurones.

Plus généralement, il faut se demander si le deep learning a atteint sa limite supérieure.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!