최근 과학 연구 및 응용 분야에서 BCI(Brain-Computer Interface)의 개발이 널리 주목을 받고 있습니다. 일반적으로 BCI의 응용 전망에 대해 많은 관심이 쏠리고 있습니다.

신경계 결함으로 인한 실어증은 환자의 일상생활에 심각한 지장을 줄 뿐만 아니라, 경력 개발 및 사회 활동에도 제한을 줄 수 있습니다. 딥러닝과 뇌-컴퓨터 인터페이스 기술의 급속한 발전으로 현대 과학은 신경성 음성 보철물을 통해 실어증 환자들이 의사소통 능력을 회복할 수 있도록 돕는 방향으로 나아가고 있습니다.

인간의 두뇌는 일련의 흥미로운 발전을 이루었으며 음성, 연산 등의 신호 디코딩에 많은 획기적인 발전이 있었습니다. Elon Musk의 Neuralink 회사도 뇌 인터페이스 기술의 획기적인 발전을 통해 이 분야에서 획기적인 발전을 이루었다는 점은 특히 언급할 가치가 있습니다.

피험자의 뇌에 전극을 이식하는 데 성공하여 간단한 커서 조작으로 타이핑, 게임 및 기타 기능을 사용할 수 있게 되었습니다. 이는 더 복잡한 신경 음성/운동 디코딩을 향한 또 다른 단계입니다. 다른 뇌-컴퓨터 인터페이스 기술과 비교할 때 신경 음성 해독은 더 복잡하며 연구 개발 작업은 주로 특수 데이터 소스인 전기피질검사(ECoG)에 의존합니다.

침대에서는 주로 환자의 회복과정에서 받은 피부전극차트 데이터를 관리합니다. 연구자들은 발성 중 뇌 활동에 대한 데이터를 수집하기 위해 이 전극을 사용했습니다. 이러한 데이터는 높은 수준의 시간적, 공간적 해상도를 가지고 있을 뿐만 아니라 음성 디코딩 연구에서 놀라운 결과를 얻었으며 뇌-컴퓨터 인터페이스 기술 개발을 크게 촉진했습니다. 이러한 첨단 기술의 도움으로 미래에는 더 많은 신경 장애를 가진 사람들이 의사소통의 자유를 되찾는 모습을 볼 수 있을 것으로 기대됩니다.

Nature에 발표된 최근 연구에서 획기적인 발전이 이루어졌습니다. 양자화된 HuBERT 기능을 이식된 환자의 중간 표현으로 사용하고 사전 훈련된 음성 합성기와 결합하여 이러한 기능을 음성으로 변환했습니다. 방법은 말의 자연스러움을 향상시킬 뿐만 아니라 높은 정확도를 유지합니다.

그러나 HuBERT 기능은 스피커 고유의 음향 특성을 포착할 수 없으며 생성되는 소리는 일반적으로 통일된 스피커의 음성이므로 이 보편적인 사운드를 특정 환자의 음성으로 변환하려면 여전히 추가 모델이 필요합니다.

주목할 만한 또 다른 점은 이 연구와 대부분의 이전 시도가 비인과적 아키텍처를 채택했기 때문에 인과적 연산이 필요한 뇌-컴퓨터 인터페이스 애플리케이션에서의 실제 사용이 제한될 수 있다는 것입니다.

2024년 4월 8일, 뉴욕대학교 VideoLab과 Flinker Lab이 공동으로 "Nature Machine Intelligence" 잡지에 획기적인 연구 결과를 발표했습니다.

Pictures

Pictures

논문 링크: https://www.nature.com/articles/s42256-024-00824-8

https://github.com/flinkerlab/에서 관련 코드 오픈 소스를 연구하세요. Neural_speech_decoding

생성된 음성의 추가 예: https://xc1490.github.io/nsd/

"심층 학습 및 음성 합성을 활용하는 신경 음성 디코딩 프레임워크"라는 제목의 이 연구는 혁신적인 미분 음성 합성기를 소개합니다. .

이 합성기는 경량 컨볼루셔널 신경망을 결합하여 음성을 피치, 음량, 포먼트 주파수 등 해석 가능한 일련의 음성 매개변수로 인코딩하고 미분 기술을 사용하여 음성을 재합성합니다.

이 연구는 신경 신호를 이러한 특정 음성 매개변수에 매핑하여 작은 데이터 세트에 대한 해석 가능성이 높고 적용 가능한 신경 음성 디코딩 시스템을 성공적으로 구축했습니다. 이 시스템은 충실도가 높고 자연스러운 음성을 재구성할 수 있을 뿐만 아니라 미래의 뇌-컴퓨터 인터페이스 응용 분야에서 높은 정확성을 위한 경험적 기반을 제공합니다.

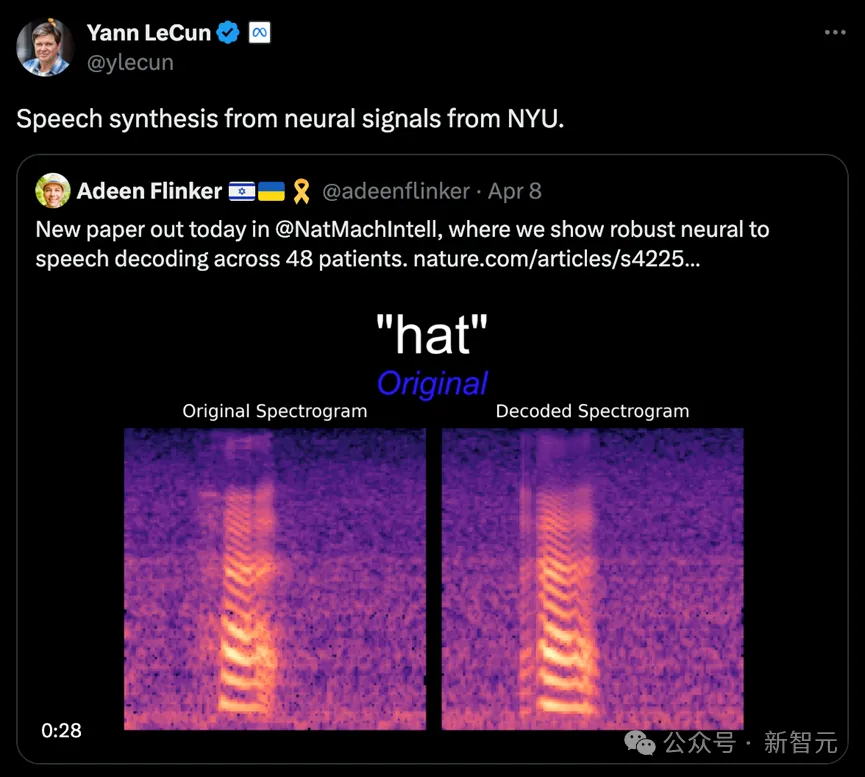

연구팀은 총 48명의 피험자로부터 데이터를 수집하고, 이를 바탕으로 음성 해독을 시도하여 고정밀 뇌-컴퓨터 인터페이스 기술의 실용화와 개발을 위한 탄탄한 기반을 마련했습니다.

Turing Award 수상자 Lecun도 연구 진행 상황을 전달했습니다.

Pictures

Pictures

현재 신경 신호를 음성으로 디코딩하는 연구에는 두 가지 핵심 과제가 있습니다.

첫 번째는 데이터 양의 한계입니다. 맞춤형 신경-음성 디코딩 모델을 훈련하기 위해 각 환자가 사용할 수 있는 총 데이터 시간은 일반적으로 약 10분에 불과하며 딥 러닝 모델의 경우 매우 제한됩니다. 이는 많은 양의 훈련 데이터에 의존합니다.

두 번째로, 인간 음성의 다양성은 모델링의 복잡성도 증가시킵니다. 동일한 사람이 동일한 단어를 반복적으로 발음하고 철자를 사용하더라도 말하는 속도, 억양, 음높이 등의 요소가 변경될 수 있으며, 이로 인해 모델 구축이 더욱 어려워집니다.

초기 시도에서 연구자들은 주로 선형 모델을 사용하여 신경 신호를 음성으로 디코딩했습니다. 이러한 유형의 모델은 대규모 데이터 세트의 지원이 필요하지 않고 해석 가능성이 높지만 일반적으로 정확도가 낮습니다.

최근 딥러닝 기술의 발전, 특히 CNN(Convolutional Neural Network)과 RNN(Recurrent Neural Network)의 적용으로 연구자들은 음성의 중간 잠재 표현을 시뮬레이션하고 합성 품질을 향상시키는 데 진전을 이루었습니다. 널리 사용해 보세요.

예를 들어 일부 연구에서는 대뇌 피질 활동을 입 움직임으로 디코딩한 다음 이를 음성으로 변환합니다. 이 방법은 성능 디코딩에 더 강력하지만 재구성된 음성은 충분히 자연스럽지 않은 경우가 많습니다.

또한 일부 새로운 방법에서는 Wavenet 보코더와 GAN(생성적 적대 신경망)을 사용하여 자연스러운 음성을 재구성하려고 시도합니다. 이러한 방법은 소리의 자연스러움을 향상시킬 수 있지만 여전히 정확도에는 제한이 있습니다.

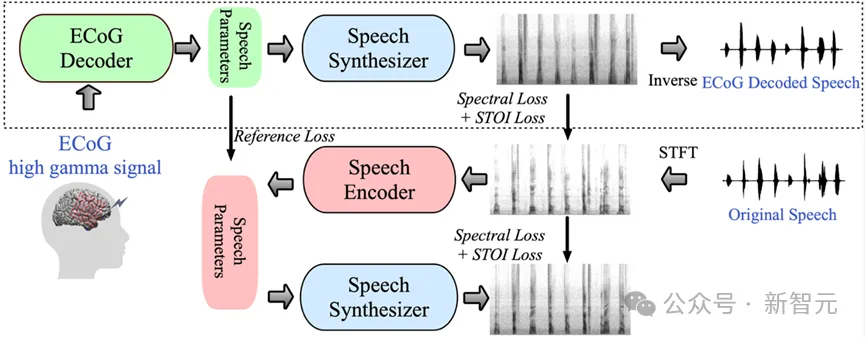

이 연구에서 연구팀은 뇌전도(ECoG) 신호에서 음성까지의 혁신적인 디코딩 프레임워크를 시연했습니다. 그들은 음성 신호만을 사용하여 경량 음성 인코딩 및 디코딩 모델에 의해 생성된 저차원 잠재 표현 공간을 구축했습니다.

이 프레임워크에는 두 가지 핵심 부분이 포함되어 있습니다. 첫째, ECoG 신호를 피치, 발언 여부, 음량 및 포먼트 주파수 등과 같은 이해할 수 있는 일련의 음향 음성 매개변수로 변환하는 ECoG 디코더입니다. 두 번째는 이러한 매개변수를 스펙트로그램으로 변환하는 음성 합성기 부분입니다.

미분 가능한 음성 합성기를 구축함으로써 연구원들은 ECoG 디코더를 훈련하는 동시에 음성 합성기를 최적화하여 스펙트로그램 재구성의 오류를 공동으로 줄일 수 있었습니다. 경량의 사전 훈련된 음성 인코더에 의해 생성된 참조 음성 매개변수와 결합된 이 저차원 잠재 공간의 강력한 해석 가능성은 전체 신경 음성 디코딩 프레임워크를 효율적이고 적응 가능하게 만들어 이 분야의 데이터 부족 문제를 효과적으로 해결합니다.

또한 이 프레임워크는 화자와 매우 가까운 자연스러운 음성을 생성할 수 있을 뿐만 아니라 ECoG 디코더 부분에 다중 딥러닝 모델 아키텍처 삽입을 지원하고 인과 연산을 수행할 수 있습니다.

연구팀은 신경외과 환자 48명의 ECoG 데이터를 처리하고 다양한 딥 러닝 아키텍처(컨볼루션, 순환 신경망, Transformer 포함)를 사용하여 ECoG 디코딩을 달성했습니다.

이러한 모델은 특히 ResNet 컨볼루셔널 아키텍처를 사용하는 실험에서 높은 정확도를 보여주었습니다. 이 연구 프레임워크는 인과 연산과 상대적으로 낮은 샘플링 속도(10mm 간격)를 통해 높은 정확도를 달성할 뿐만 아니라 뇌의 왼쪽 및 오른쪽 반구 모두에서 음성을 효과적으로 디코딩하는 능력을 보여줌으로써 신경 기술의 응용 범위를 확장합니다. 음성 해독은 뇌의 오른쪽에 있습니다.

Pictures

Pictures

이 연구의 핵심 혁신 중 하나는 음성 재합성의 효율성을 크게 향상시키고 원본에 가까운 고품질 오디오를 합성할 수 있는 미분 음성 합성기의 개발입니다. 소리 .

이 음성 합성기의 디자인은 인간의 음성 시스템에서 영감을 얻었으며 음성을 Voice(주로 모음 시뮬레이션에 사용됨)와 Unvoice(주로 자음 시뮬레이션에 사용됨)의 두 부분으로 세분화합니다.

Voice 부분에서는 기본 주파수 신호를 먼저 사용하여 고조파를 생성한 후 F1~F6 포먼트로 구성된 필터를 통과하여 모음의 스펙트럼 특성을 얻습니다.

Unvoice 부분은 백색소음에 대해 특정 필터링을 수행하여 해당 스펙트럼을 생성합니다. 학습 가능한 매개변수는 각 시점에서 두 부분의 혼합 비율을 제어합니다.

마지막으로 음량 신호를 조정하고 배경 소음을 추가하여 최종 음성 스펙트럼이 생성됩니다.

이 음성 합성기를 기반으로 연구팀은 효율적인 음성 재합성 프레임워크와 신경 음성 디코딩 프레임워크를 설계했습니다. 자세한 프레임 구조는 원본 기사의 그림 6을 참조하세요.

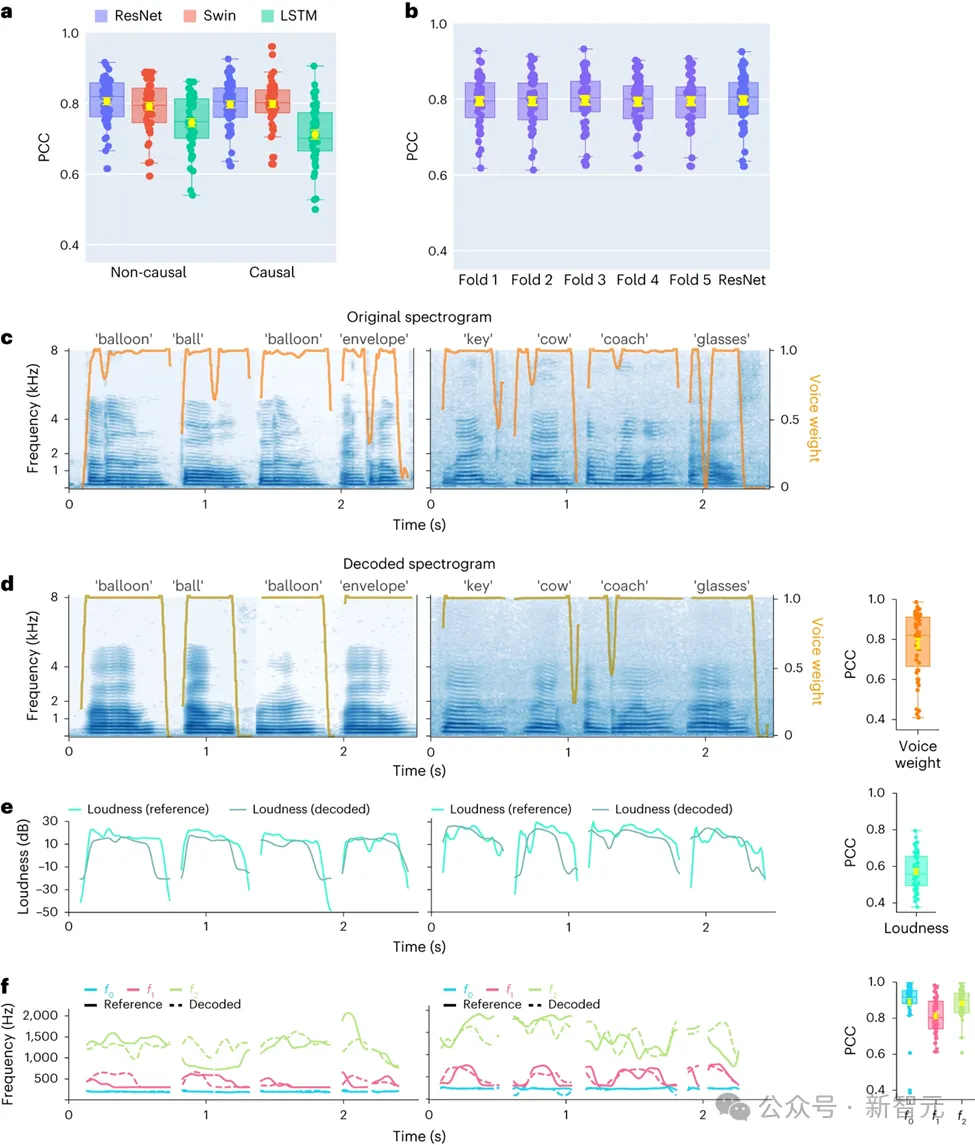

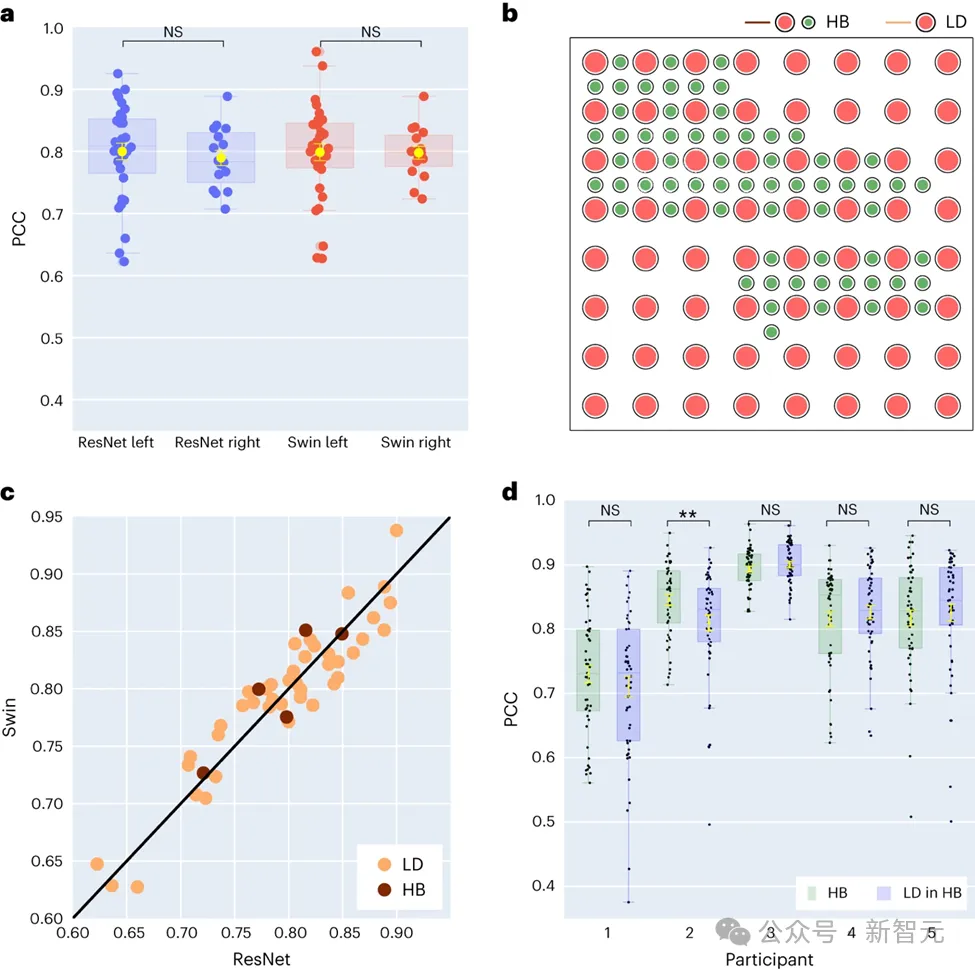

본 연구에서 연구진은 먼저 컨볼루셔널 네트워크(ResNet), 순환 신경망(LSTM) 및 Transformer 아키텍처를 포함한 다양한 모델 아키텍처를 직접 비교했습니다. 3D Swin)을 사용하여 음성 디코딩 성능의 차이를 평가합니다.

이러한 모델이 시계열에 대해 인과적 또는 인과적 작업을 수행할 수 있다는 점은 주목할 가치가 있습니다.

Pictures

Pictures

뇌-컴퓨터 인터페이스(BCI)의 적용에서 디코딩 모델의 인과성은 매우 중요합니다. 인과 모델은 원인과 결과가 아닌 과거와 현재의 신경 신호만 사용하여 음성을 생성합니다. 효과 모델은 실제로 실현 가능하지 않은 미래의 신경 신호도 참조합니다.

따라서 연구의 초점은 인과적 작업과 비인과적 작업을 수행할 때 동일한 모델의 성능을 비교하는 것입니다. 결과는 ResNet 모델의 인과 버전도 비인과 버전과 비슷한 성능을 가지며 둘 사이에 큰 성능 차이가 없음을 보여줍니다.

마찬가지로 Swin 모델의 인과 버전과 비인과 버전은 비슷한 성능을 보이지만 LSTM의 인과 버전은 비인과 버전보다 성능이 훨씬 낮습니다. 이 연구는 또한 음량(모음을 자음과 구별하는 매개변수), 소리 크기, 기본 주파수 f0, 첫 번째 포먼트 f1 및 두 번째 포먼트 f2를 포함한 여러 주요 음성 매개변수에 대한 평균 디코딩 정확도(총 48개 샘플 수)를 보여주었습니다.

이러한 음성 매개변수, 특히 기본 주파수, 사운드 가중치 및 처음 두 포먼트를 정확하게 재구성하는 것은 참가자 음성의 정확한 음성 디코딩과 자연스러운 재현을 달성하는 데 매우 중요합니다.

연구 결과에 따르면 비인과 모델과 인과 모델 모두 합리적인 해독 효과를 제공할 수 있으며 이는 향후 관련 연구 및 응용에 긍정적인 영감을 제공합니다.

최근 연구에서 연구자들은 좌뇌 반구와 우뇌 반구 사이의 음성 디코딩 성능 차이를 추가로 조사했습니다.

전통적으로 대부분의 연구는 음성 및 언어 기능과 밀접한 관련이 있는 좌반구에 중점을 두었습니다.

Pictures

Pictures

그러나 언어 정보를 해독하는 우뇌 반구의 능력에 대한 우리의 이해는 제한적입니다. 이 분야를 탐구하기 위해 연구팀은 참가자의 왼쪽 반구와 오른쪽 반구의 디코딩 성능을 비교하여 음성 복구에 오른쪽 반구를 사용할 가능성을 검증했습니다.

연구에서 수집된 48명의 피험자 중 16명이 우뇌에서 ECoG 신호를 받았습니다. 연구자들은 ResNet과 Swin 디코더의 성능을 비교함으로써 우반구도 음성을 효과적으로 디코딩할 수 있으며 그 효과는 좌반구의 효과와 유사하다는 사실을 발견했습니다. 이번 발견은 언어 기능을 상실한 좌뇌 손상 환자에게 가능한 언어 복원 옵션을 제공합니다.

이 연구에는 전극 샘플링 밀도가 음성 디코딩 효과에 미치는 영향도 포함됩니다. 이전 연구에서는 주로 고밀도 전극 그리드(0.4mm)를 사용했지만 임상 실습에서 일반적으로 사용되는 전극 그리드의 밀도는 더 낮습니다(1cm).

본 연구에 참여한 5명의 참가자는 주로 밀도가 낮지만 일부 전극이 추가된 하이브리드형(HB) 전극 그리드를 사용했습니다. 나머지 43명의 참가자에 대해서는 저밀도 샘플링이 사용되었습니다.

결과는 이러한 하이브리드 샘플링(HB)의 디코딩 성능이 기존 저밀도 샘플링(LD)의 디코딩 성능과 유사하다는 것을 보여 주며, 이는 모델이 대뇌 피질 전극 그리드의 다양한 밀도에서 음성 정보를 효과적으로 학습할 수 있음을 나타냅니다. 이 발견은 임상 환경에서 일반적으로 사용되는 전극 샘플링 밀도가 미래의 뇌-컴퓨터 인터페이스 응용 프로그램을 지원하기에 충분할 수 있음을 시사합니다.

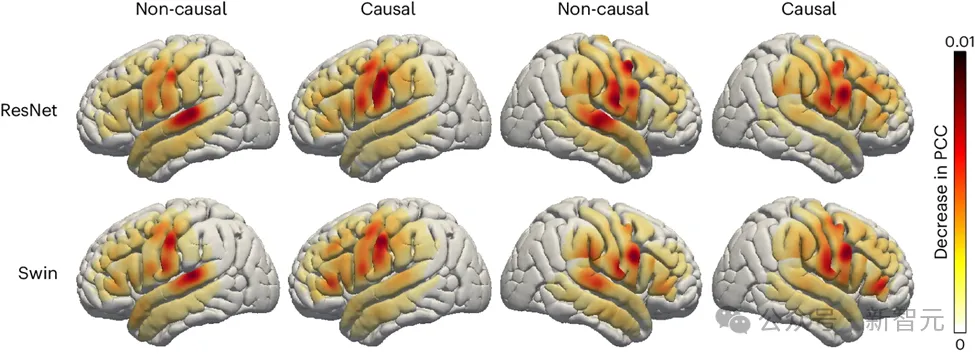

연구원들은 또한 음성 해독 과정에서 뇌의 음성 관련 영역의 역할을 조사했는데, 이는 시사점을 가질 수 있습니다. 미래의 좌뇌와 우뇌를 위해 음성 복원 장치의 반구형 임플란트는 매우 중요합니다. 음성 디코딩에 대한 다양한 뇌 영역의 영향을 평가하기 위해 연구팀은 폐색 분석을 사용했습니다.

ResNet과 Swin 디코더의 인과 모델과 비인과 모델을 비교한 결과, 비인과 모델에서는 청각 피질의 역할이 더 중요하다는 사실이 연구에서 밝혀졌습니다. 이 결과는 미래의 뉴로피드백 신호에 의존할 수 없는 실시간 음성 디코딩 응용 분야에서 인과 모델을 사용할 필요성을 강조합니다.

사진

사진

또한, 연구에 따르면 감각운동 피질, 특히 복부 영역이 음성 해독에 미치는 영향은 뇌의 왼쪽 반구나 오른쪽 반구에서 유사합니다. 이 발견은 언어 회복을 위해 우반구에 신경 보철물을 이식하는 것이 실행 가능한 선택일 수 있으며 향후 치료 전략에 대한 중요한 통찰력을 제공할 수 있음을 시사합니다.

연구팀은 경량 컨볼루셔널 신경망을 사용하여 음성을 음소 높이, 음량, 포먼트 주파수와 같은 일련의 해석 가능한 매개변수로 인코딩하는 새로운 유형의 차별화 가능한 음성 합성기를 개발했습니다. 등을 사용하고 동일한 미분 가능 합성기를 사용하여 음성을 재합성합니다.

신경 신호를 이러한 매개 변수에 매핑함으로써 연구원들은 해석 가능성이 높고 소규모 데이터 세트에 적용 가능하며 자연스러운 음성을 생성할 수 있는 신경 음성 디코딩 시스템을 구축했습니다.

이 시스템은 48명의 참가자들 사이에서 높은 수준의 재현성을 입증했으며, 서로 다른 공간 샘플링 밀도로 데이터를 처리할 수 있었고, 왼쪽 및 오른쪽 뇌 반구의 EEG 신호를 동시에 처리할 수 있었습니다. 디코딩.

상당한 진전에도 불구하고 연구원들은 ECoG 녹음과 결합된 음성 훈련 데이터에 의존하는 디코딩 프로세스와 같은 모델의 현재 한계 중 일부를 지적했는데, 이는 실어증이 있는 사람에게 적용되지 않을 수 있습니다.

향후 연구팀은 비그리드 데이터를 처리할 수 있는 모델 아키텍처를 구축하고 다중 환자 및 다중 모드 뇌파 데이터를 보다 효과적으로 활용할 수 있는 모델 아키텍처를 구축할 예정입니다. 하드웨어 기술의 지속적인 발전과 딥러닝 기술의 급속한 발전으로 뇌-컴퓨터 인터페이스 분야의 연구는 아직 초기 단계이지만, 시간이 지나면서 공상과학 영화에 등장하는 뇌-컴퓨터 인터페이스 비전은 점차 발전하게 될 것입니다. 현실이 되다.

https://www.nature.com/articles/s42256-024-00824-8

이 기사의 첫 번째 저자: Xupeng Chen (xc1490@nyu.edu), Ran Wang, 교신 저자: Adeen Flinker

신경 음성 디코딩의 인과성에 대한 자세한 논의는 저자의 다른 논문을 참조하세요:

https://www.pnas.org/doi/10.1073/pnas.2300255120

위 내용은 LeCun은 AI가 실어증 환자가 다시 말할 수 있게 해준다고 말했습니다! NYU, 새로운 '신경 음성' 디코더 출시의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!