최신 국내 오픈소스 MoE 대형 모델은 데뷔하자마자 큰 인기를 끌었습니다.

DeepSeek-V2의 성능은 GPT-4 수준에 도달하지만 오픈 소스이며 상업용으로 무료이며 API 가격은 GPT-4-Turbo의 1%에 불과합니다.

그래서 공개되자마자 즉시 많은 논의를 불러일으켰습니다.

사진

사진

공개된 성능 지표로 볼 때 DeepSeek V2의 포괄적인 중국어 기능은 많은 오픈 소스 모델을 능가하는 동시에 GPT-4 Turbo 및 Wenkuai 4.0과 같은 폐쇄 소스 모델도 첫 번째입니다. 단계.

종합 영어 능력도 LLaMA3-70B와 동일한 1계급에 속하며, 역시 MoE인 Mixtral 8x22B를 능가합니다.

지식, 수학, 추론, 프로그래밍 등에서도 좋은 성적을 보여줍니다. 그리고 128K 컨텍스트를 지원합니다.

Pictures

Pictures

이러한 기능은 일반 사용자가 무료로 직접 사용할 수 있습니다. 현재 클로즈베타가 오픈되어, 등록 후 바로 체험하실 수 있습니다.

Pictures

Pictures

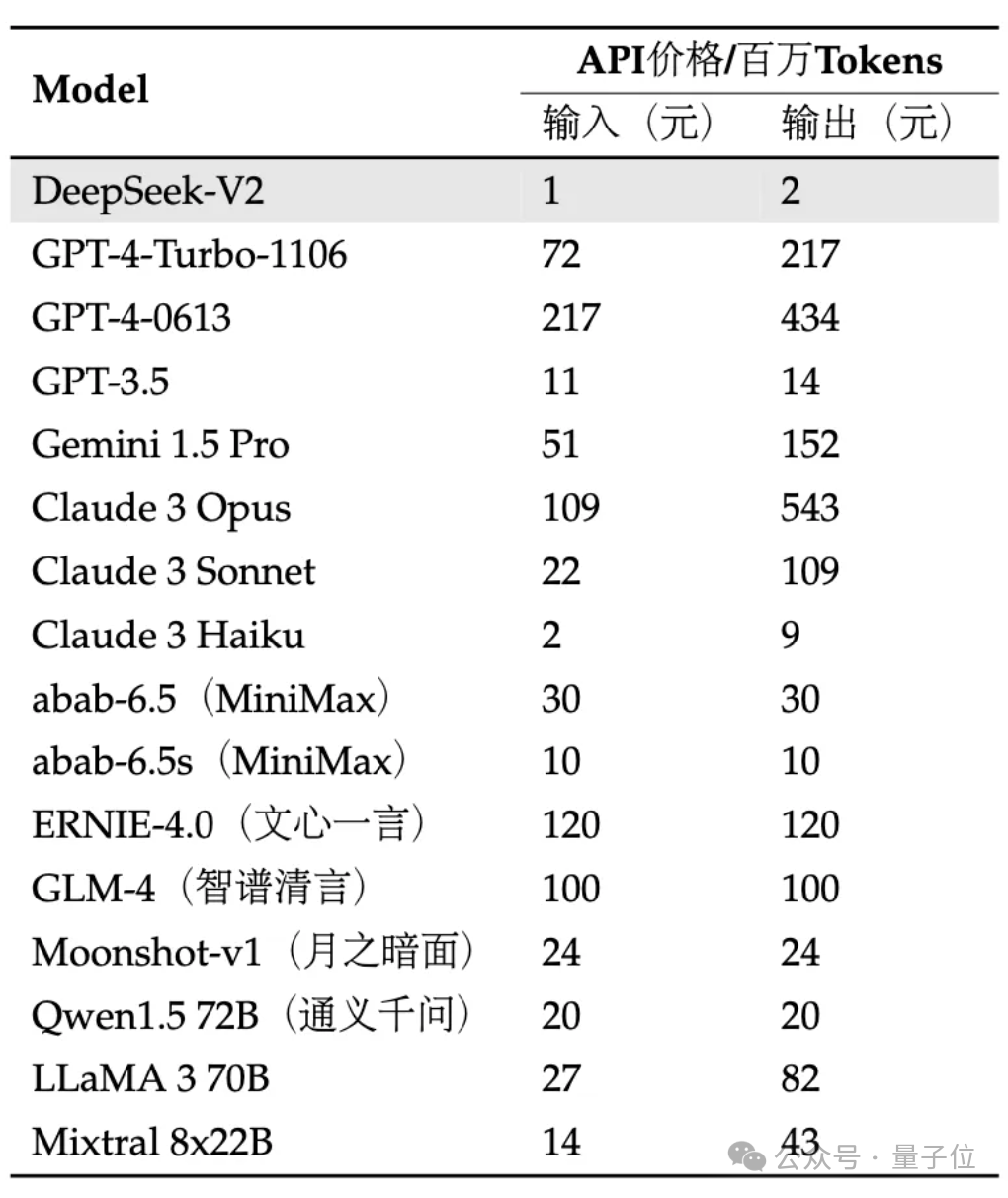

API는 훨씬 더 비쌉니다. 입력은 1위안이고 출력은 백만 토큰당 2위안입니다(32K 컨텍스트). 가격은 GPT-4-Turbo의 1%에 불과하다.

동시에 자체 개발한 MLA(Multi-head Latent Attention) 및 Sparse 구조를 사용하여 모델 아키텍처도 혁신되어 모델 계산 및 추론 메모리의 양을 크게 줄일 수 있습니다.

네티즌들은 한탄했습니다: DeepSeek은 항상 사람들에게 놀라움을 선사합니다!

사진

사진

특정 효과를 가장 먼저 경험해 봤습니다!

현재 V2 내부 베타 버전에서는 범용 대화 및 코드 도우미를 경험할 수 있습니다.

Pictures

Pictures

일반 대화에서 대형 모델의 논리, 지식, 생성, 수학 및 기타 능력을 테스트할 수 있습니다.

예를 들어 "The Legend of Zhen Huan"의 스타일을 모방하여 립스틱 심기 카피라이팅을 쓰도록 요청할 수 있습니다.

Pictures

Pictures

는 양자 얽힘이 무엇인지 대중적인 방식으로 설명할 수도 있습니다.

Pictures

Pictures

수학적 측면에서 다음과 같은 높은 숫자의 미적분 문제에 답할 수 있습니다.

미적분을 사용하여 자연 로그의 밑수 e의 무한 계열 표현을 증명합니다.

Pictures

Pictures

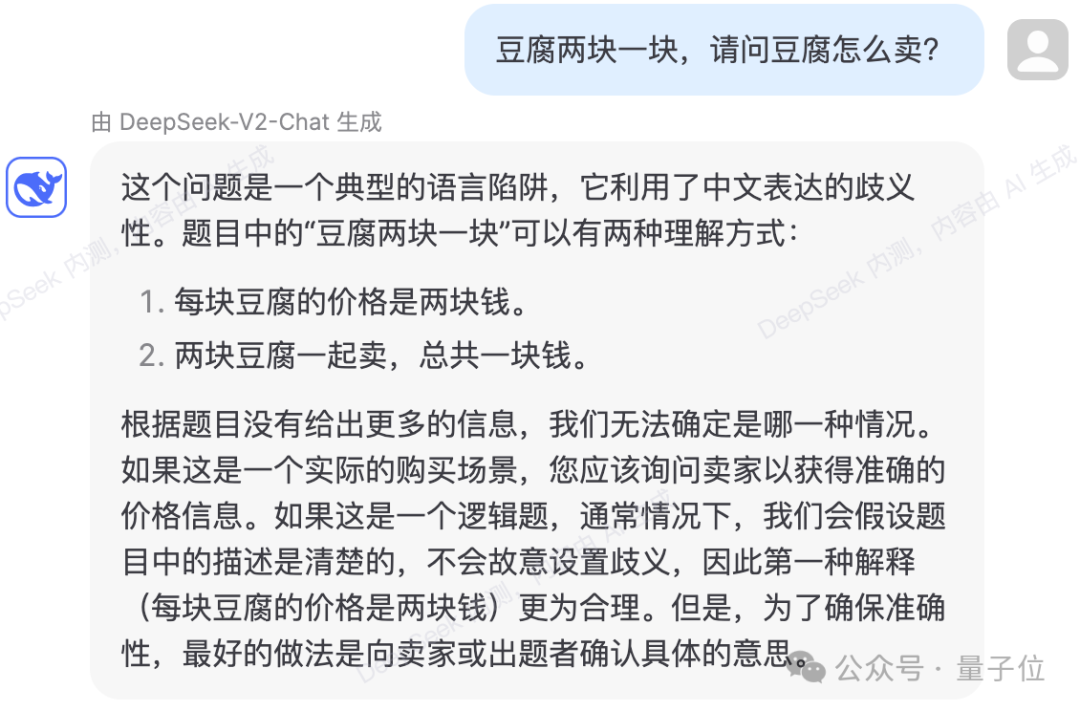

또한 일부 언어 논리 함정을 피할 수 있습니다.

Pictures

Pictures

테스트 결과 DeepSeek-V2의 지식 내용이 2023년으로 업데이트된 것으로 나타났습니다.

Pictures

Pictures

코드 측면에서 내부 테스트 페이지를 보면 DeepSeek-Coder-33B를 사용하여 질문에 답변하는 것으로 나와 있습니다.

간단한 코드 생성에 있어 여러 실제 테스트에서 오류는 없었습니다.

Pictures

Pictures

는 주어진 코드를 설명하고 분석할 수도 있습니다.

Pictures

Pictures

Pictures

Pictures

그러나 시험에서 오답이 나오는 경우도 있습니다.

다음 논리 질문에서 DeepSeek-V2는 계산 과정에서 양초가 양쪽 끝에서 동시에 켜지고 타버리는 데 걸리는 시간을 양초가 타는 데 걸리는 시간의 1/4로 잘못 계산했습니다. 한쪽 끝에서.

pictures

pictures

공식 소개에 따르면 DeepSeek-V2의 총 매개변수는 236B이고 활성도는 21B로 대략 70B~110B Dense의 모델 성능에 도달합니다.

Pictures

Pictures

이전 DeepSeek 67B에 비해 성능은 더욱 강력해지고 훈련 비용은 절감되며, KV 캐시는 93.3% 감소하고 최대 처리량은 5.76배 증가합니다.

공식적으로 이는 DeepSeek-V2가 소비하는 비디오 메모리(KV 캐시)가 동일한 수준의 Dense 모델의 1/5~1/100에 불과하고 토큰당 비용이 크게 절감된다는 의미라고 공식적으로 밝혔습니다.

H800 사양을 위해 특별히 많은 통신 최적화가 수행되었습니다. 실제로 8카드 H800 시스템에 배포되었습니다. 입력 처리량은 초당 100,000개 토큰을 초과하고 출력은 초당 50,000개 토큰을 초과합니다.

Pictures

Pictures

일부 기본 벤치마크에서 DeepSeek-V2 기본 모델의 성능은 다음과 같습니다.

Pictures

Pictures

DeepSeek-V2는 혁신적인 아키텍처를 채택합니다.

계산 및 추론 메모리의 양을 크게 줄이기 위해 MLA(Multi-head Latent Attention) 아키텍처를 제안했습니다.

동시에 우리는 계산량을 더욱 줄이기 위해 Sparse 구조를 자체 개발했습니다.

Pictures

Pictures

일부 사람들은 이러한 업그레이드가 데이터 센터의 대규모 컴퓨팅에 매우 도움이 될 수 있다고 말했습니다.

Pictures

Pictures

그리고 API 가격 측면에서 DeepSeek-V2는 시중의 모든 스타 모델보다 거의 저렴합니다.

Pictures

Pictures

팀은 DeepSeek-V2 모델과 논문도 완전한 오픈 소스가 될 것이라고 밝혔습니다. 모델 중량 및 기술 보고서가 제공됩니다.

지금 DeepSeek API 오픈 플랫폼에 로그인하고 등록하면 입력 1천만개/출력 5백만개 토큰을 선물로 받을 수 있습니다. 일반 평가판은 완전 무료입니다.

위 내용은 국내 오픈소스 MoE 지표 폭발: GPT-4 수준 기능, API 가격은 1%에 불과의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!