멀티모달 문서 이해능력 새로운 SOTA!

Alibaba mPLUG 팀은 최신 오픈 소스 작업인 mPLUG-DocOwl 1.5를 출시했습니다. 이 작업은 고해상도 이미지 텍스트 인식, 보편적인 문서 구조 이해, 지침 따르기 및 외부 지식 도입이라는 네 가지 주요 과제에 대한 일련의 솔루션을 제안합니다. .

더 이상 고민하지 말고 먼저 효과를 살펴보겠습니다.

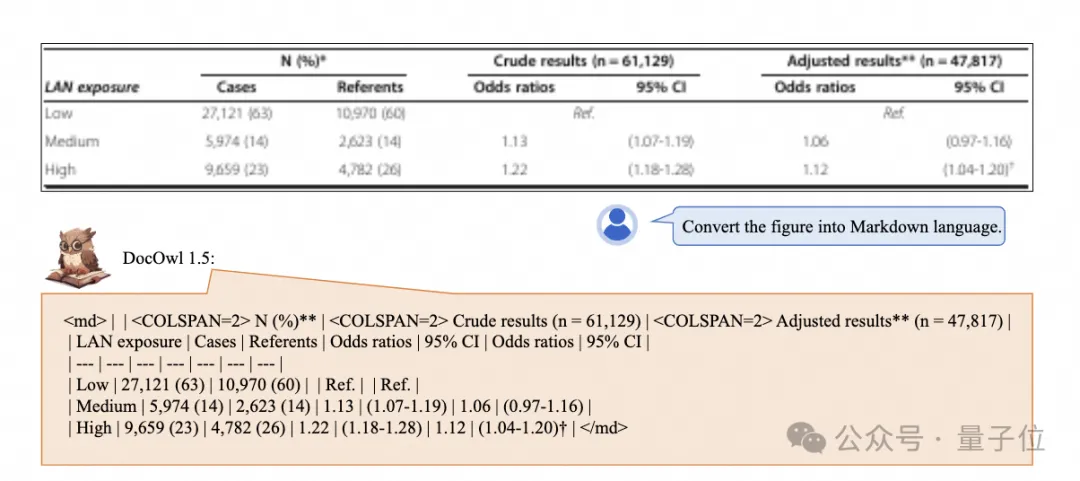

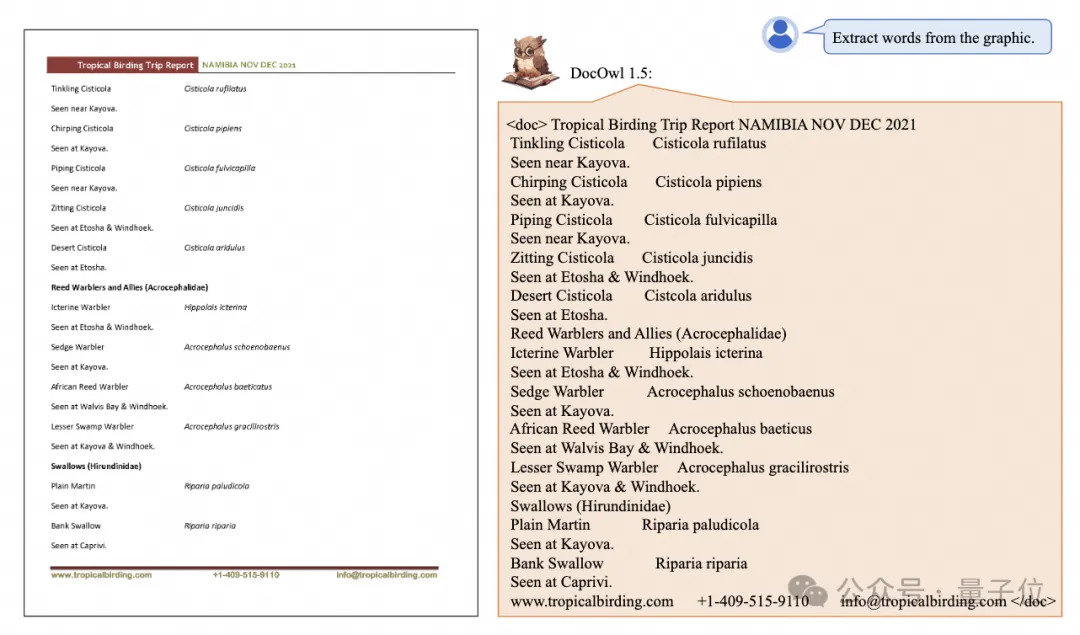

원클릭 인식 및 복잡한 구조의 차트를 마크다운 형식으로 변환:

다양한 스타일의 차트 사용 가능:

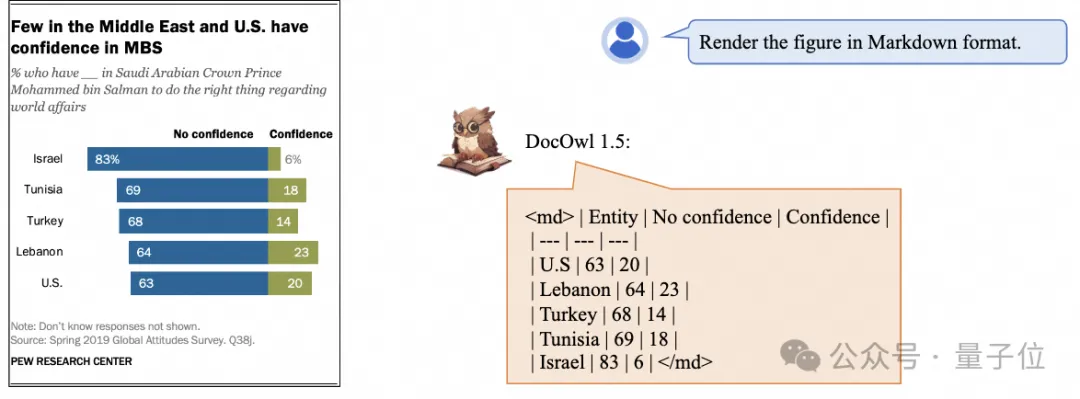

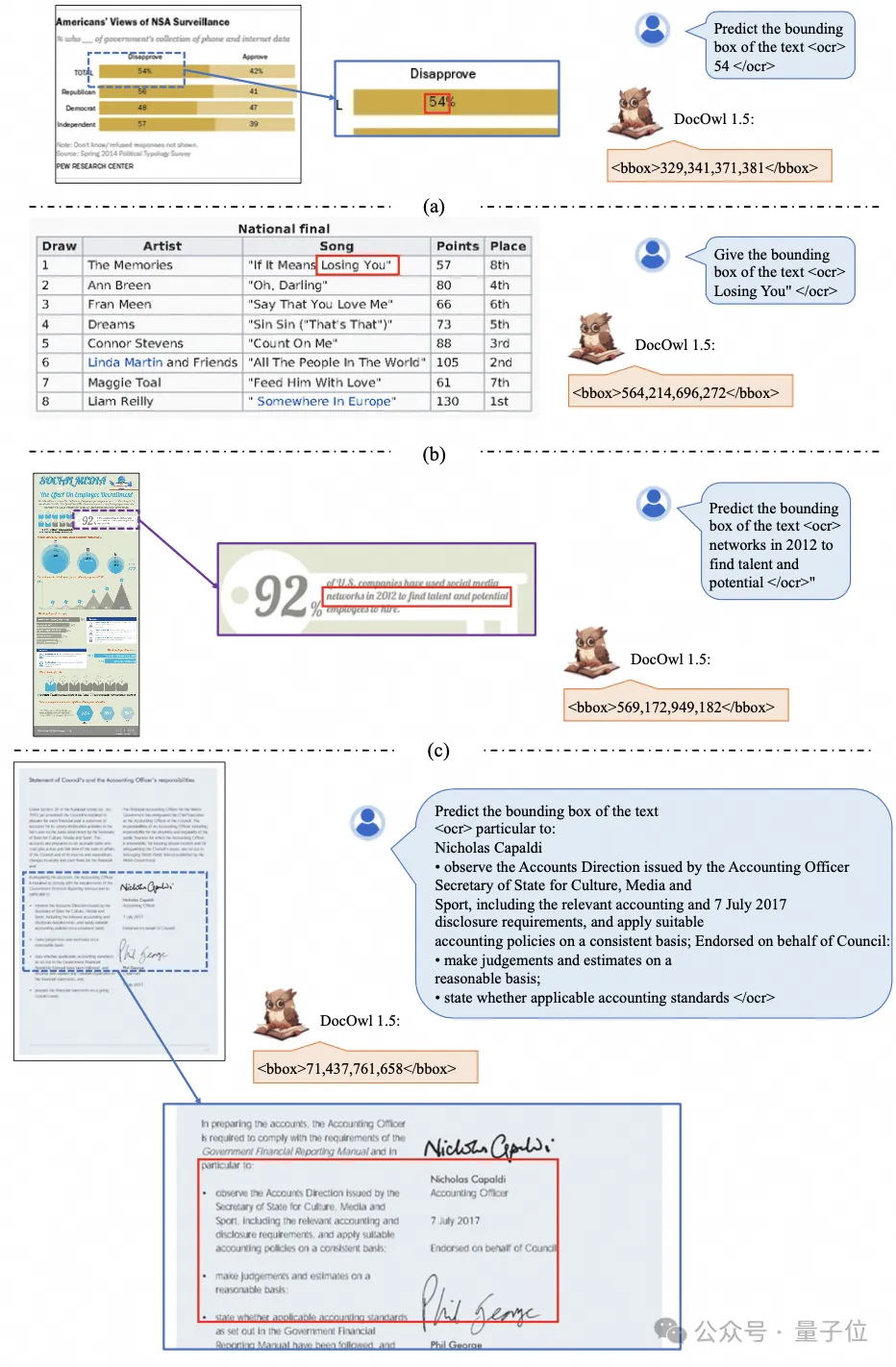

더 자세한 텍스트 인식 및 위치 지정도 쉽게 처리할 수 있습니다.

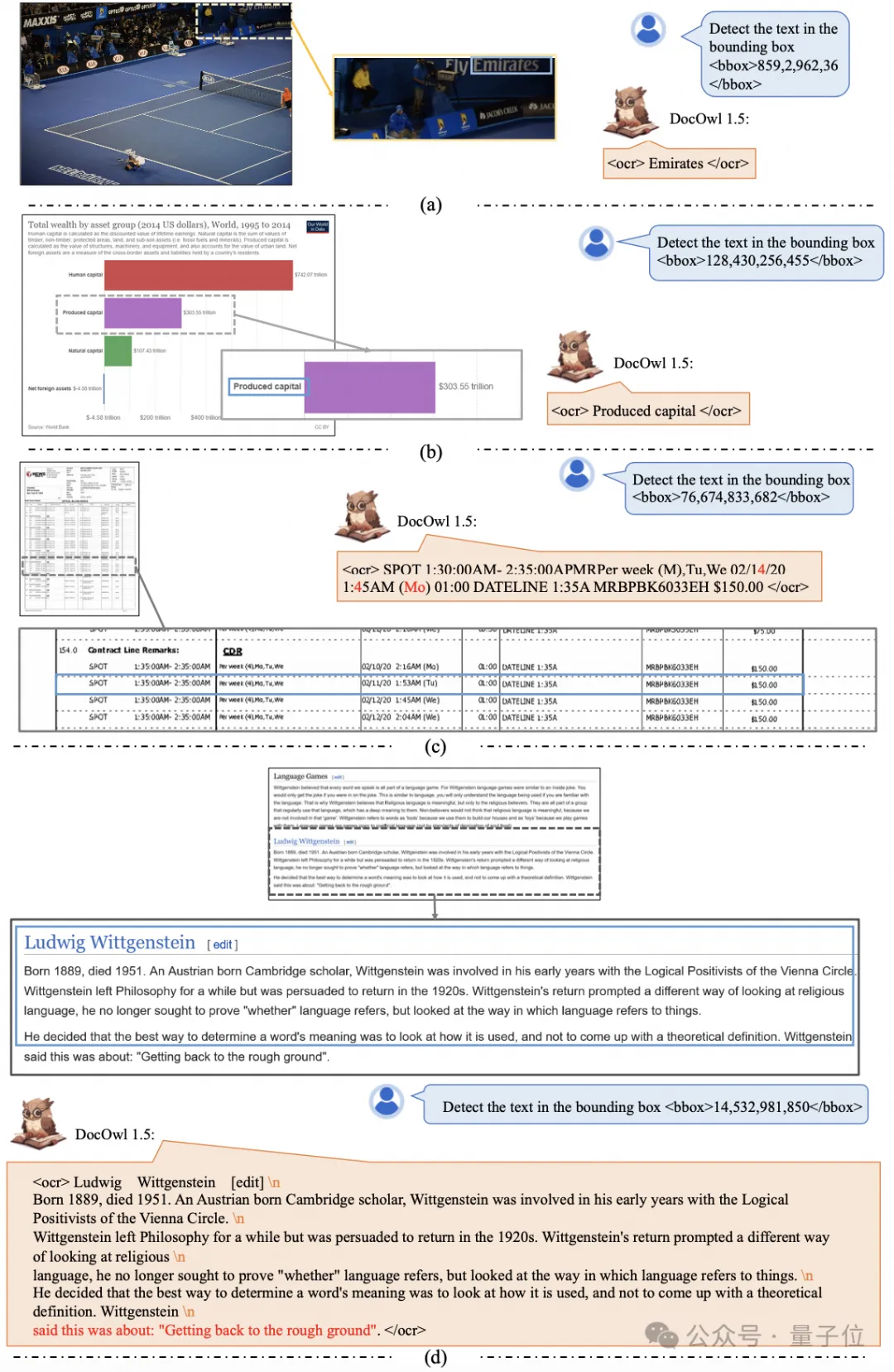

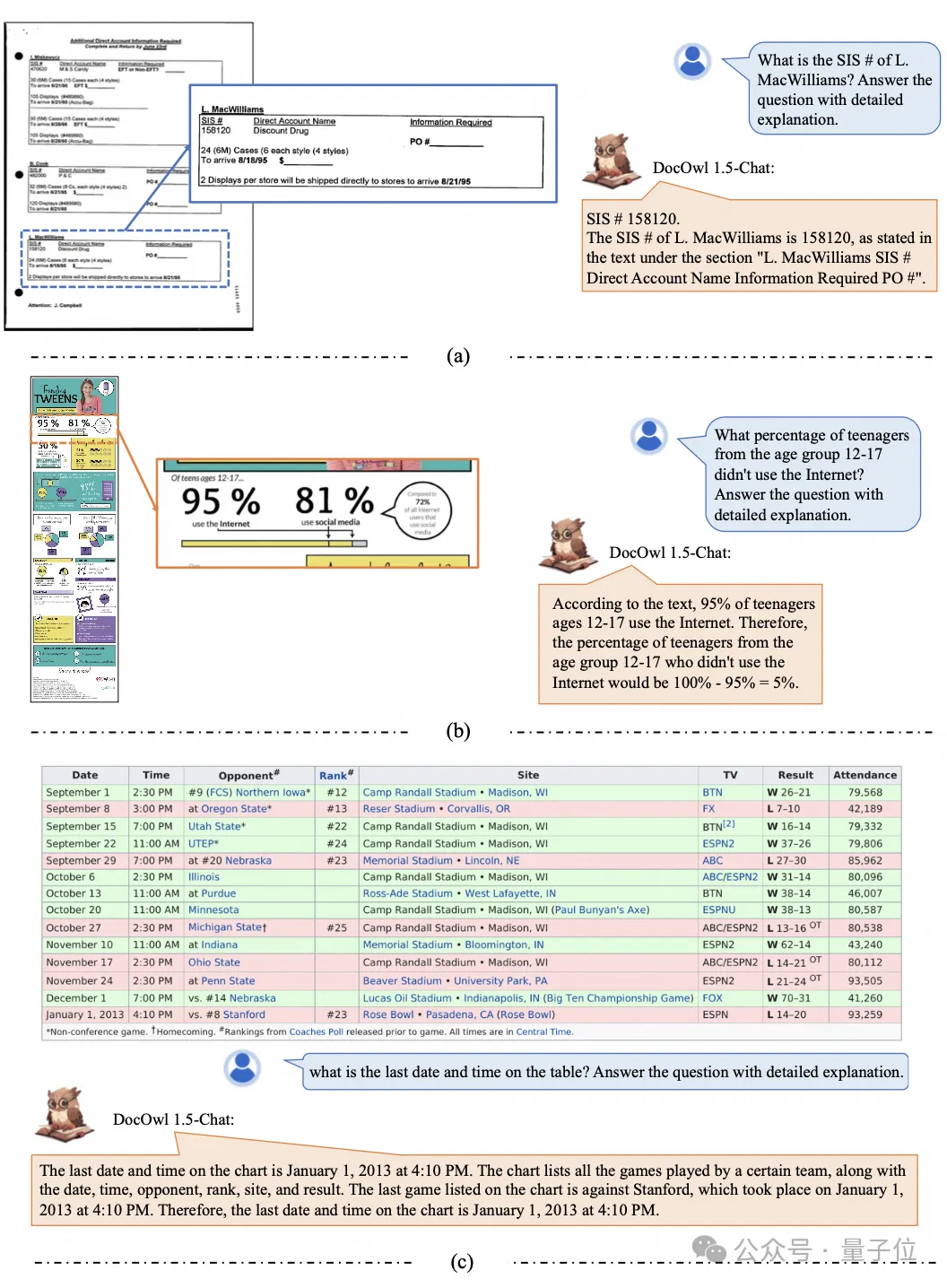

문서 이해에 대한 자세한 설명 제공:

"문서 이해"는 현재 대규모 언어 모델 구현에 중요한 시나리오라는 점을 알아야 합니다. 시중에는 문서 읽기를 지원하는 많은 제품이 있으며 일부 제품도 있습니다. 주로 OCR 시스템을 사용하여 텍스트를 읽습니다. LLM을 통한 텍스트 인식 및 이해는 우수한 문서 이해 기능을 달성할 수 있습니다.

그러나 문서 사진의 다양한 범주, 서식 있는 텍스트, 복잡한 레이아웃으로 인해 차트, 인포그래픽, 웹 페이지 등 복잡한 구조를 가진 그림에 대한 보편적인 이해를 얻기가 어렵습니다.

현재 인기 있는 멀티모달 대형 모델 QwenVL-Max, Gemini, Claude3 및 GPT4V는 모두 강력한 문서 이미지 이해 기능을 갖추고 있지만 오픈 소스 모델은 이 방향으로 더디게 발전했습니다.

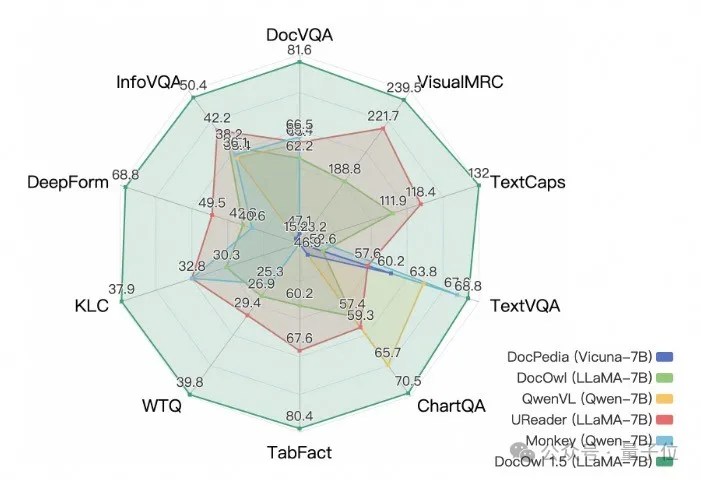

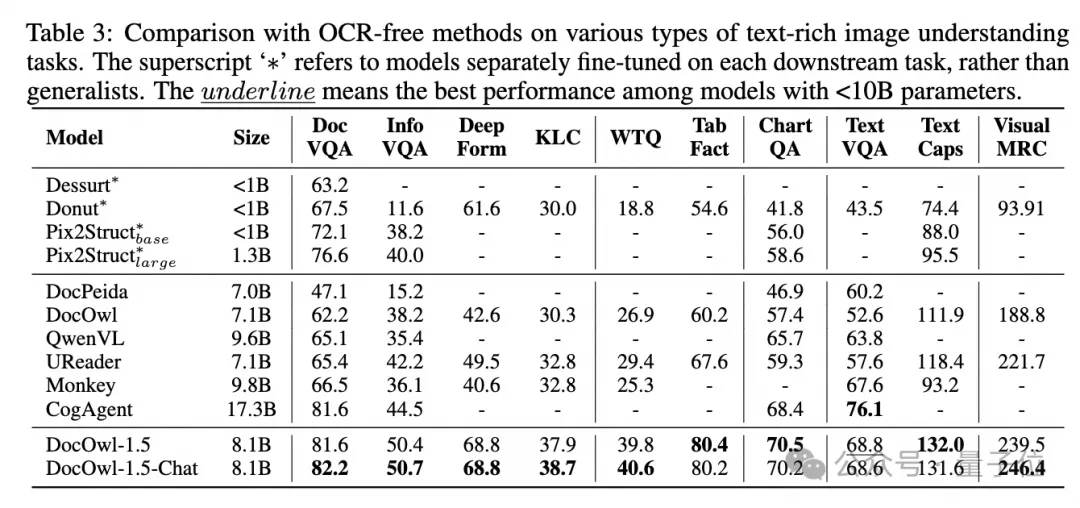

Alibaba의 새로운 연구 mPLUG-DocOwl 1.5원 SOTA는 10개 문서 이해 벤치마크에서 5개 데이터 세트에서 10포인트 이상 향상되었으며 일부 데이터 세트에서는 Wisdom의 17.3B CogAgent를 능가했으며 DocVQA 효과에서는 82.2에 도달했습니다.

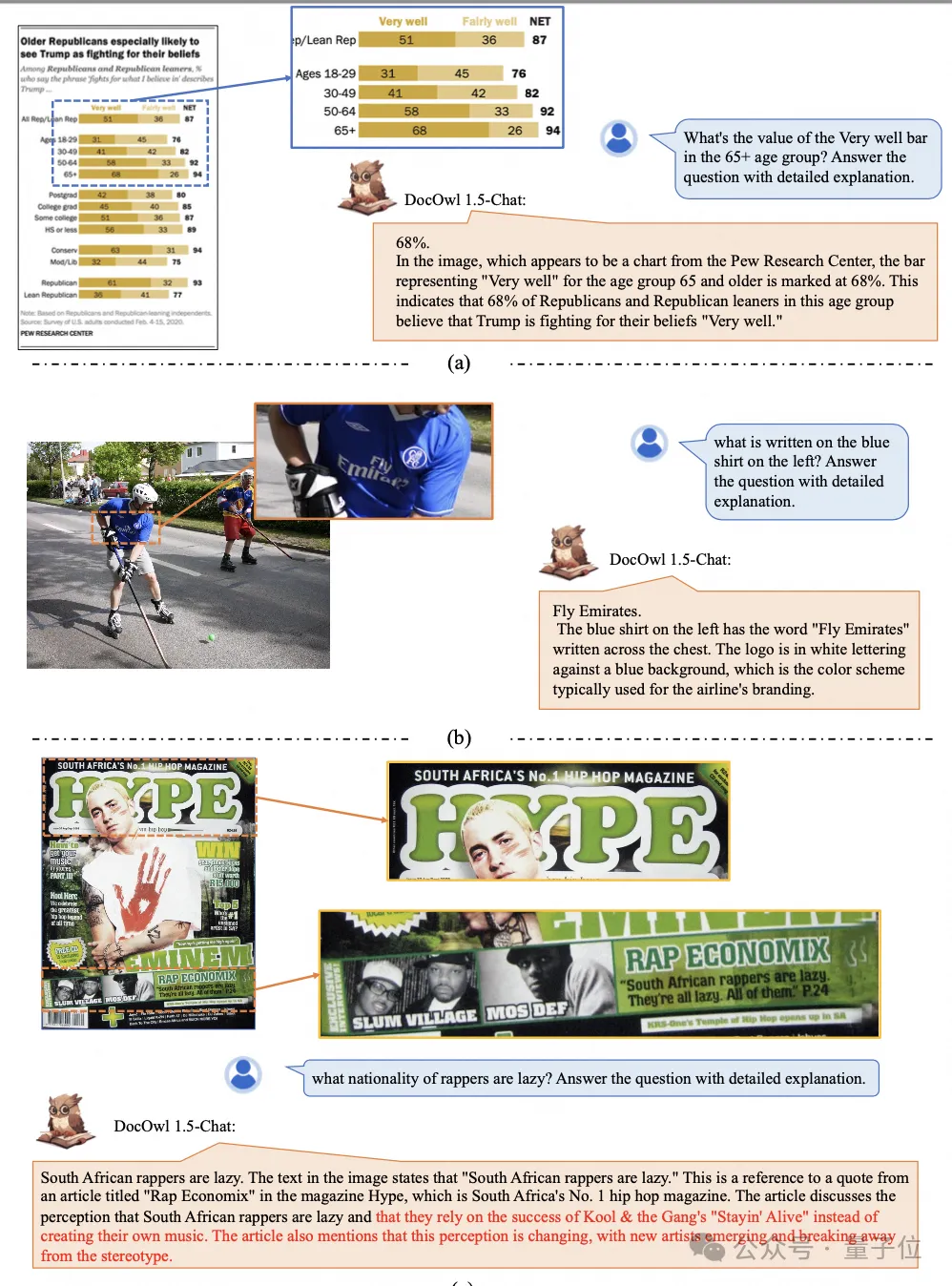

벤치마크에 대한 간단한 답변을 제공하는 기능 외에도 약간의 "자세한 설명"을 통해 (추론) 데이터의 미세 조정을 통해 DocOwl 1.5-Chat은 설명하는 기능도 가질 수 있습니다. 응용 잠재력이 큰 다중 모드 문서 분야에 대해 자세히 설명합니다.

Alibaba mPLUG 팀은 2023년 7월부터 다중 모드 문서 이해 연구에 투자해 왔으며 mPLUG-DocOwl, UReader, mPLUG-PaperOwl, mPLUG-DocOwl 1.5를 연속으로 출시했으며 일련의 대규모 문서 이해 모델 및 오픈 소스를 제공했습니다. 훈련 데이터.

이 기사는 최신 작업인 mPLUG-DocOwl 1.5에서 시작하여 "다중 모드 문서 이해" 분야의 주요 과제와 효과적인 솔루션을 분석합니다.

문서 이미지는 일반 이미지와 달리 A4 크기의 문서 이미지, 짧고 넓은 테이블 이미지, 길고 좁은 모바일 웹 페이지 등 모양과 크기가 다양한 것이 특징입니다. 스크린샷, 임의의 장면 이미지 등이 다양한 해상도로 배포됩니다.

주류 다중 모달 대형 모델이 이미지를 인코딩할 때 이미지 크기를 직접 조정하는 경우가 많습니다. 예를 들어 mPLUG-Owl2 및 QwenVL은 448x448로 확장되고 LLaVA 1.5는 336x336으로 확장됩니다.

단순히 문서 이미지의 크기를 조정하면 이미지의 텍스트가 흐릿하고 변형되어 인식할 수 없게 됩니다.

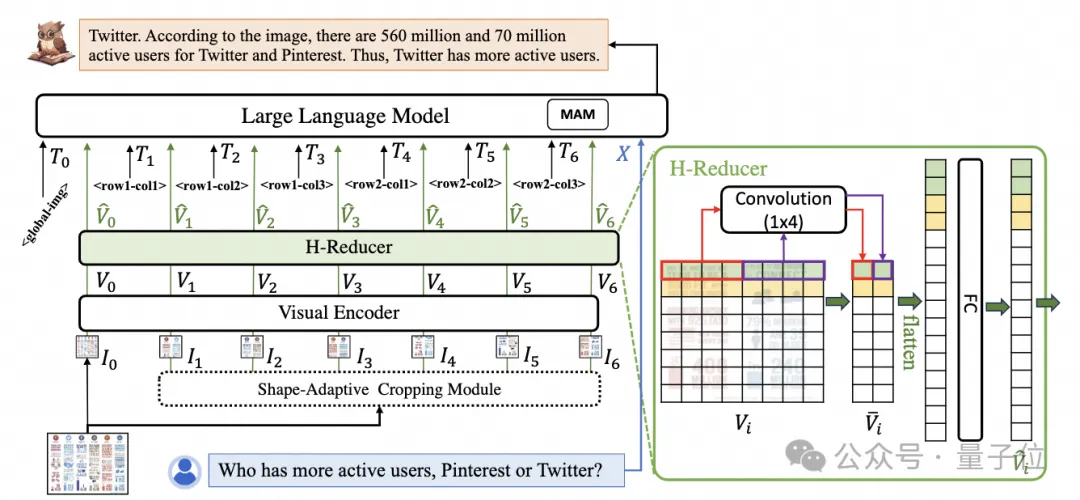

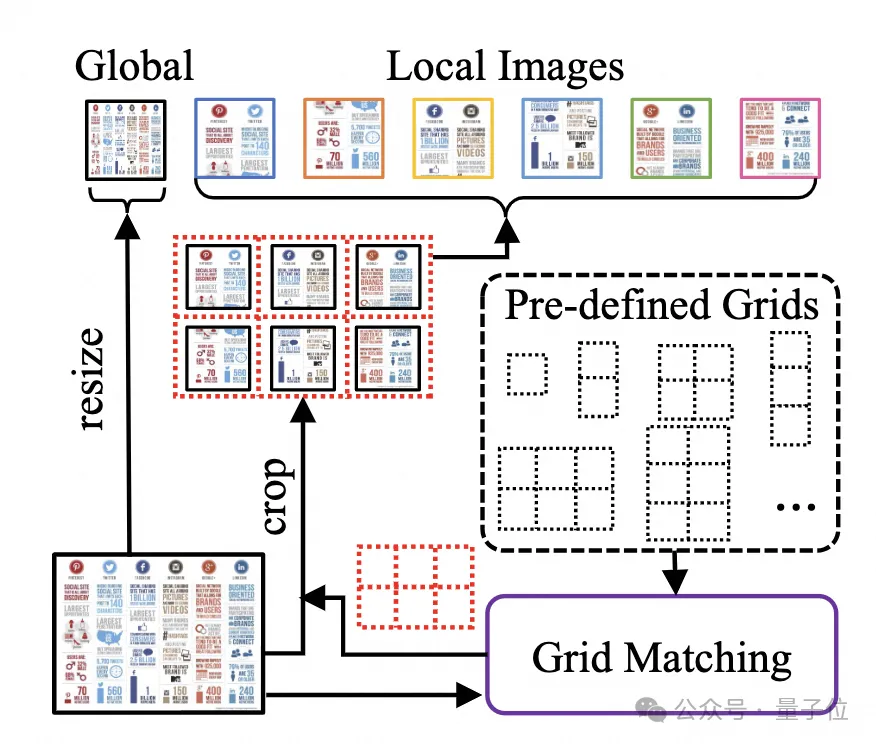

문서 이미지를 처리하기 위해 mPLUG-DocOwl 1.5는 이전 UReader의 cutting 접근 방식을 이어갑니다. 모델 구조는 그림 1에 나와 있습니다.

UReader. 기존 다중 모드 대형 모델을 기반으로 매개변수가 없는 형상 적응형 자르기 모듈을 통해 일련의 하위 이미지를 얻는 것이 처음 제안되었습니다. 마지막으로 하위 그래프를 연결합니다. 언어 모델을 통해 의미론을 지시합니다.

이 그래프 절단 전략은 기존 범용 비주얼 인코더의 기능을 최대한 활용할 수 있습니다(예: CLIP ViT-14/L) 문서 이해를 위해 고해상도 비주얼 인코더 재교육 비용을 크게 절감 . 모양 적응형 절단 모듈은 그림 2에 나와 있습니다.

OCR 시스템에 의존하지 않는 문서 이해를 위해서는 텍스트를 인식하는 것이 기본 능력이며, 예를 들어 표 내용에 대한 의미론적 이해와 구조적 이해를 달성하는 것이 매우 중요합니다. 테이블 헤더와 행과 열 간의 대응 관계에 대한 이해가 필요합니다. 차트를 이해하려면 선 그래프, 막대 그래프, 파이 차트 등 다양한 구조에 대한 이해가 필요합니다. 계약을 이해하려면 날짜 서명과 같은 다양한 키-값 쌍에 대한 이해가 필요합니다.

mPLUG-DocOwl 1.5는 일반 문서 등의 구조적 이해 기능 해결에 중점을 두고 모델 구조 최적화 및 학습 작업 강화를 통해 일반 문서 이해 기능을 대폭 강화했습니다.

구조 측면에서 그림 1과 같이 mPLUG-DocOwl 1.5는 mPLUG-Owl/mPLUG-Owl2에서 Abstractor의 시각적 언어 연결 모듈을 버리고 기능을 위해 "컨볼루션 + 완전 연결 레이어" 기반의 H-Reducer를 사용합니다. 집계 및 기능 정렬 .

학습 가능한 쿼리를 기반으로 하는 Abstractor와 비교하여 H-Reducer는 시각적 기능 간의 상대적인 위치 관계를 유지하고 문서 구조 정보를 언어 모델로 더 잘 전달합니다.

시각적 시퀀스의 길이를 유지하는 MLP와 비교하여 H-Reducer는 컨볼루션을 통해 시각적 특징의 수를 크게 줄여 LLM이 고해상도 문서 이미지를 보다 효율적으로 이해할 수 있도록 합니다.

대부분의 문서 이미지의 텍스트가 가로로 먼저 정렬되고 가로 방향의 텍스트 의미가 일관성이 있다는 점을 고려하여 H-Reducer는 1x4 컨볼루션 모양과 단계 크기를 사용합니다. 논문에서 저자는 충분한 비교실험을 통해 구조적 이해에 있어서 H-Reducer의 우수성과 1x4가 보다 일반적인 집합체 형태임을 입증하였다.

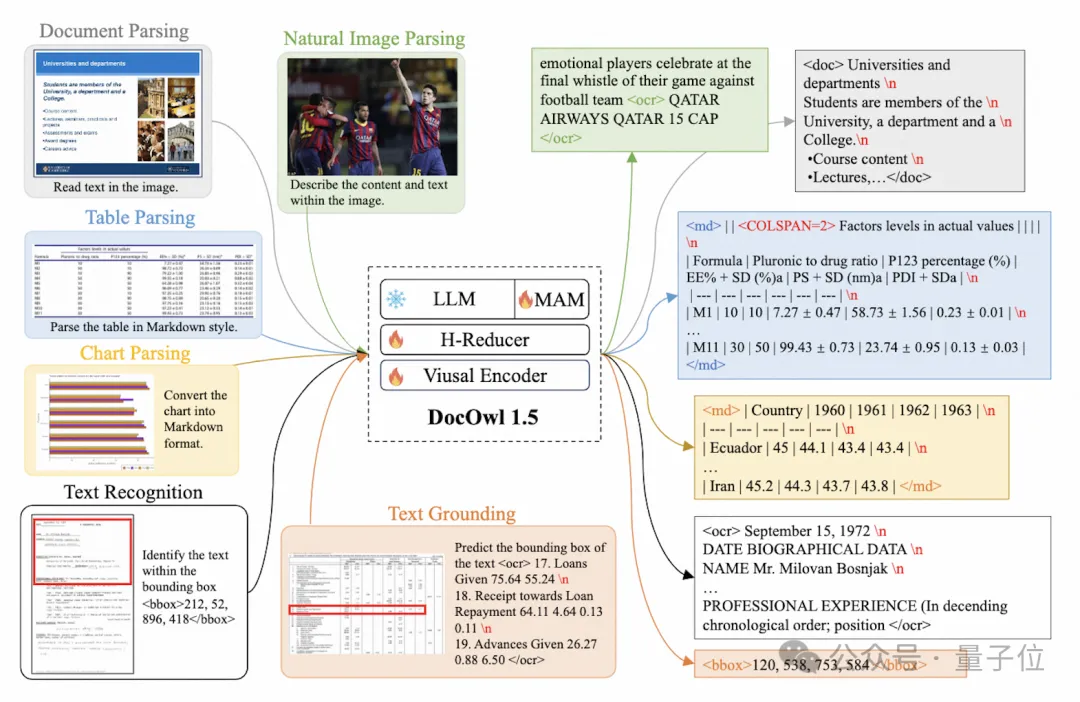

훈련 작업 측면에서 mPLUG-DocOwl 1.5는 그림 3과 같이 모든 유형의 그림에 대한 통합 구조 학습 (Unified Structure Learning) 작업을 설계합니다.

Δ그림 3: 통합 구조 학습

통합 구조 학습에는 전역 이미지 텍스트 분석뿐만 아니라 다단계 텍스트 인식 및 위치 지정도 포함됩니다.

전역 이미지 텍스트 구문 분석 작업에서 문서 이미지와 웹 페이지 이미지의 경우 공백과 줄 바꿈을 사용하여 테이블의 텍스트 구조를 가장 일반적으로 나타낼 수 있습니다. 저자는 다음을 기반으로 여러 행과 열을 나타내는 특수 문자를 도입합니다. 마크다운 구문. 문자는 차트 표현의 단순성과 다양성을 고려합니다. 차트는 표 형식 데이터의 시각적 표현이라는 점을 고려하여 저자는 자연스러운 그림, 의미론에 대한 차트 분석 대상으로도 표를 사용합니다. 설명과 장면 텍스트는 똑같이 중요하므로 장면 텍스트와 결합된 그림 설명의 형식이 파싱 대상으로 사용됩니다.

"텍스트 인식 및 위치 지정" 작업에서 저자는 문서 이미지의 이해를 더 잘 맞추기 위해 단어, 구문, 줄 및 블록의 네 가지 단위로 텍스트 인식 및 위치 지정을 설계했습니다. 이산화된 정수 및 범위 0-999.

통합 구조 학습을 지원하기 위해 저자는 문서/웹 페이지, 표, 차트, 자연 이미지 등과 같은 다양한 유형의 이미지를 다루는 포괄적인 훈련 세트 DocStruct4M를 구축했습니다.

통합 구조 학습 후 DocOwl 1.5는 여러 분야의 문서와 이미지를 구조적으로 구문 분석하고 텍스트 위치를 지정하는 기능을 갖추고 있습니다. 그림 4 : 그림 4 및 그림 5에 표시된대로 구조화 된 텍스트 구문 분석

: 그림 5 : 그림 5 : 다중 부문 텍스트 인식 및 포지셔닝 ° Challenge 3 : 다음에 따른 지침

모델이 기본적인 문서 이해 능력을 기반으로 정보 추출, 질문과 답변, 그림 설명 등 사용자의 지시에 따라 다양한 작업을 수행하도록 요구합니다.

모델이 기본적인 문서 이해 능력을 기반으로 정보 추출, 질문과 답변, 그림 설명 등 사용자의 지시에 따라 다양한 작업을 수행하도록 요구합니다. mPLUG-DocOwl의 실천을 이어가는 DocOwl 1.5는 여러 다운스트림 작업을 명령 질문 및 답변 형식으로 통합한 후

다중 작업 공동 훈련을 통해 문서 분야의 일반 모델을 얻습니다.

. 또한 모델이 자세히 설명할 수 있도록 하기 위해 mPLUG-DocOwl은 공동 훈련을 위한 데이터 미세 조정에 일반 텍스트 지침을 도입하려고 시도했는데 이는 특정 효과가 있지만 이상적이지는 않습니다.

또한 모델이 자세히 설명할 수 있도록 하기 위해 mPLUG-DocOwl은 공동 훈련을 위한 데이터 미세 조정에 일반 텍스트 지침을 도입하려고 시도했는데 이는 특정 효과가 있지만 이상적이지는 않습니다. DocOwl 1.5에서 저자는 다운스트림 작업의 문제점을 기반으로 GPT3.5 및 GPT4V를 통해 소량의 상세 설명 데이터

(DocReason25K)문서 다운스트림 작업과 훈련용 DocReason25K를 결합함으로써 DocOwl 1.5-Chat은 벤치마크에서 더 나은 결과를 얻을 수 있습니다:

Δ 그림 6: 문서 이해 벤치마크 평가

및 자세한 설명 제공:

Δ그림 7: 문서 이해에 대한 자세한 설명

문서 그림 정보의 풍부함으로 인해 이해를 위해서는 전문 용어, 특정 분야에서의 의미 등 추가적인 지식의 도입이 필요한 경우가 많습니다.

더 나은 문서 이해를 위한 외부 지식 도입 방법을 연구하기 위해 mPLUG 팀은 종이 분야에서 시작하여 447k 고화질 종이를 포함하는 고품질 종이 차트 분석 데이터 세트 M-Paper를 구축하는 mPLUG-PaperOwl을 제안했습니다. 차트.

이 데이터는 지식의 외부 소스로 논문의 차트에 대한 컨텍스트를 제공하고 모델이 사용자의 의도를 더 잘 파악하는 데 도움이 되는 차트 분석을 위한 제어 신호로 "핵심 포인트"(개요) 를 설계합니다.

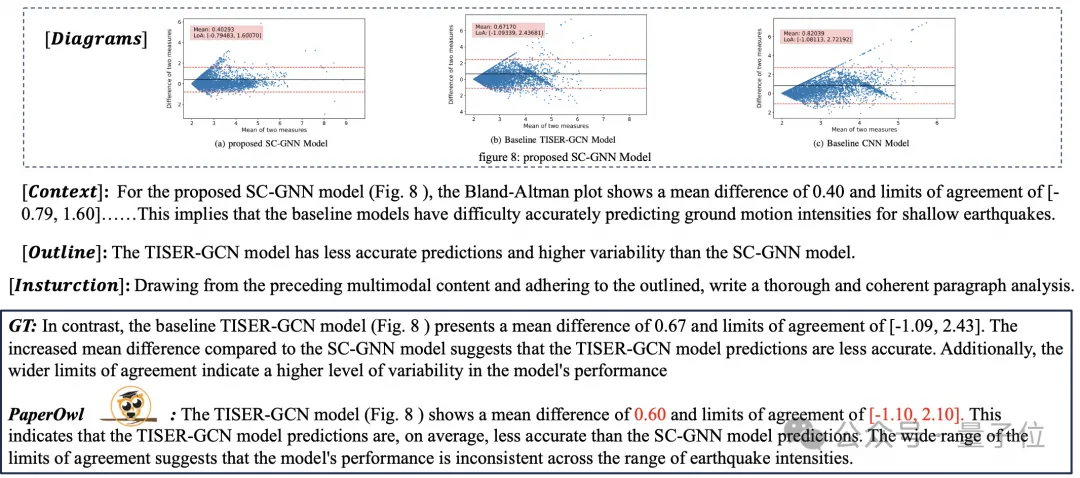

UReader를 기반으로 저자는 그림 8과 같이 예비 종이 차트 분석 기능을 시연한 M-Paper에서 mPLUG-PaperOwl을 미세 조정했습니다.

Δ그림 8: 종이 차트 분석

mPLUG-PaperOwl은 현재 문서 이해에 외부 지식을 도입하려는 초기 시도에 불과하며 추가로 해결해야 할 도메인 제한 및 단일 지식 소스와 같은 문제에 직면해 있습니다.

일반적으로 이 기사는 최근 출시된 대형 모델 mPLUG-DocOwl 1.5를 이해하는 가장 강력한 7B 다중 모드 문서에서 시작하여 OCR에 의존하지 않고 다중 모드 문서를 이해하는 데 필요한 4가지 주요 과제를 요약합니다("고해상도 이미지 텍스트 인식", "보편적인 문서 구조 이해", "지시 따르기", "외부 지식 소개") 및 Alibaba mPLUG 팀이 제공하는 솔루션입니다.

mPLUG-DocOwl 1.5는 오픈 소스 모델의 문서 이해 성능을 크게 향상시켰지만 여전히 폐쇄 소스 대형 모델 및 실용적인 요구 사항과는 거리가 멀습니다. 등.

mPLUG 팀은 DocOwl의 성능을 더욱 최적화하고 이를 오픈 소스화할 것입니다. 모두가 계속해서 관심을 갖고 우호적인 토론을 나누는 것을 환영합니다!

GitHub 링크: https://github.com/X-PLUG/mPLUG-DocOwl

문서 링크: https://arxiv.org/abs/2403.12895

위 내용은 대형 모델을 이해하는 Alibaba 7B 다중 모드 문서, 새로운 SOTA 획득의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!