2월 16일 OpenAI Sora의 출시는 의심할 여지 없이 비디오 생성 분야에서 획기적인 발전을 의미합니다. Sora는 시장에 나와 있는 대부분의 주류 방법(2D Stable Diffusion으로 확장)과 다른 Diffusion Transformer 아키텍처를 기반으로 합니다. 소라가 Diffusion Transformer 사용을 고집하는 이유는 ICLR 2024(VDT: General- Purpose Video Diffusion Transformers via Mask Modeling)에서 동시에 발표된 논문에서 확인할 수 있습니다. 이 작업은 중국 인민대학교 연구팀이 주도하고 캘리포니아 대학교, 버클리 대학교, 홍콩 대학교 등과 협력하여 2023년 5월 arXiv 웹사이트에 처음 게시되었습니다. 연구팀은 Transformer - Video Diffusion Transformer(VDT) 기반의 통합 영상 생성 프레임워크를 제안하고, Transformer 아키텍처를 채택한 이유에 대해 자세히 설명했습니다.

- 논문 제목: VDT: 마스크 모델링을 통한 범용 비디오 확산 변환기

- 기사 주소: Openreview: https://openreview.net/pdf?id=Un0rgm9f04

- arXiv 주소: https://arxiv.org/abs/2305.13311

- 프로젝트 주소: VDT: 마스크 모델링을 통한 범용 비디오 확산 변환기

- 코드 주소: https://github.com/RERV/VDT

연구원은 비디오 생성 분야에서 Transformer 아키텍처를 사용하는 VDT 모델의 우수성이 다음과 같이 반영된다고 말했습니다. 이미지의 경우 Transformer는 강력한 토큰화 및 주의 메커니즘을 통해 장기 또는 불규칙적인 시간 종속성을 캡처하여 시간 차원을 더 잘 처리할 수 있습니다.

모델이 세계 지식(시공간 관계, 물리 법칙 등)을 학습(또는 기억)해야만 현실 세계와 일치하는 동영상을 생성할 수 있습니다. 따라서 모델의 용량은 영상 확산의 핵심 요소가 됩니다. Transformer는 확장성이 뛰어난 것으로 입증되었습니다. 예를 들어 PaLM 모델은 최대 540B 매개변수를 가지고 있는 반면 당시 최대 2D U-Net 모델 크기는 2.6B 매개변수(SDXL)에 불과했기 때문에 Transformer는 3D U보다 더 적합합니다. -Net.비디오 생성 과제.

- 비디오 생성 분야는 무조건 생성, 비디오 예측, 보간 및 텍스트-이미지 생성을 포함한 여러 작업을 다룹니다. 이전 연구에서는 단일 작업에 초점을 맞추는 경우가 많았으며 다운스트림 작업을 미세 조정하기 위해 특수 모듈을 도입해야 하는 경우가 많았습니다. 또한 이러한 작업에는 프레임과 양식에 따라 다를 수 있는 다양한 조건부 정보가 포함되므로 다양한 입력 길이와 양식을 처리할 수 있는 강력한 아키텍처가 필요합니다. Transformer를 도입하면 이러한 작업을 통합할 수 있습니다.

- VDT의 혁신은 주로 다음 측면을 포함합니다:

Transformer 기술을 확산 기반 비디오 생성에 적용, 비디오 생성 분야에서 Transformer의 역량 입증 거대한 잠재력

. VDT의 장점은 시간에 따른 3차원 물체의 물리적 역학 시뮬레이션을 포함하여 시간적으로 일관된 비디오 프레임을 생성할 수 있는 탁월한 시간 종속 캡처 기능입니다.

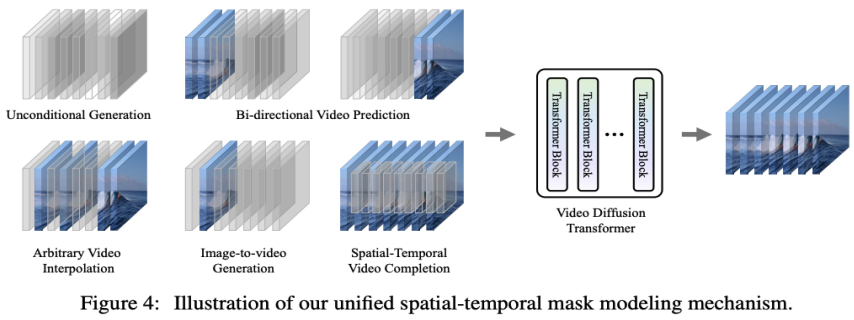

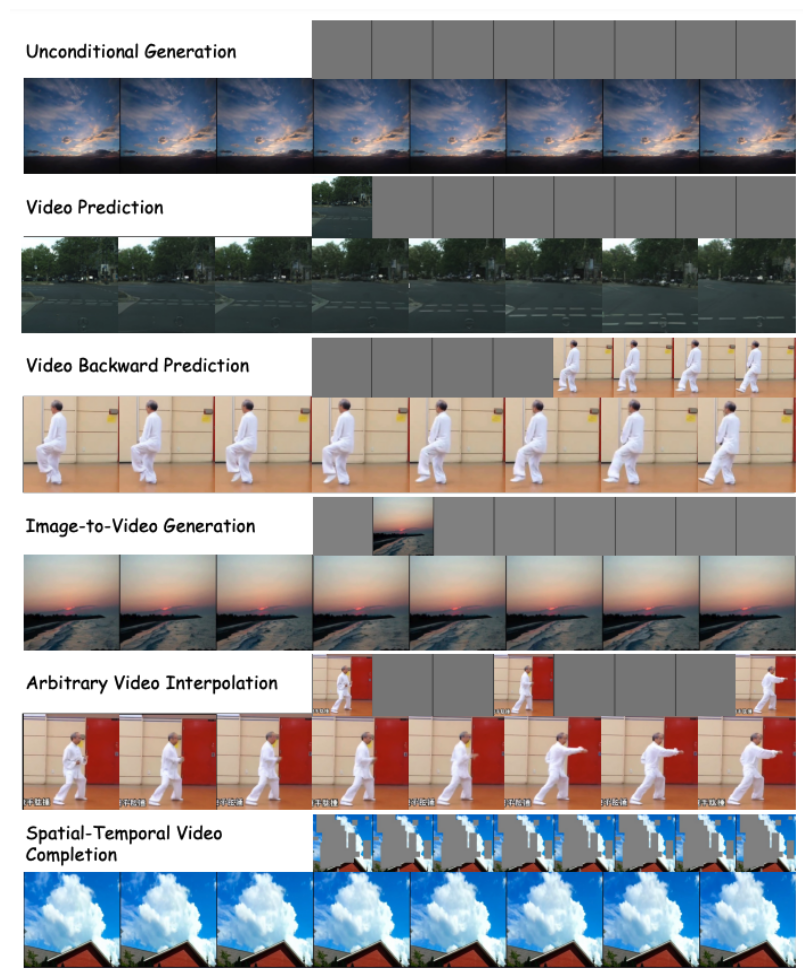

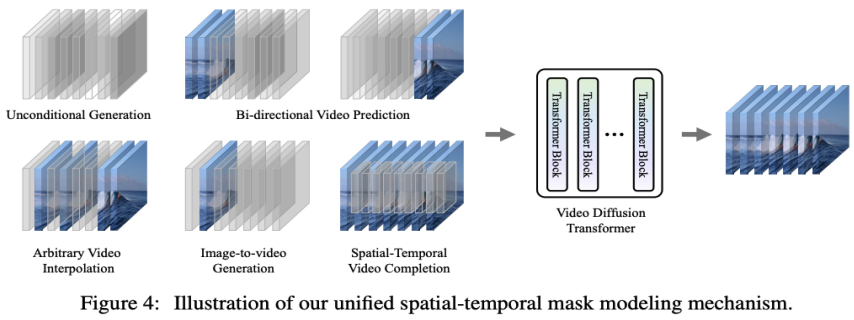

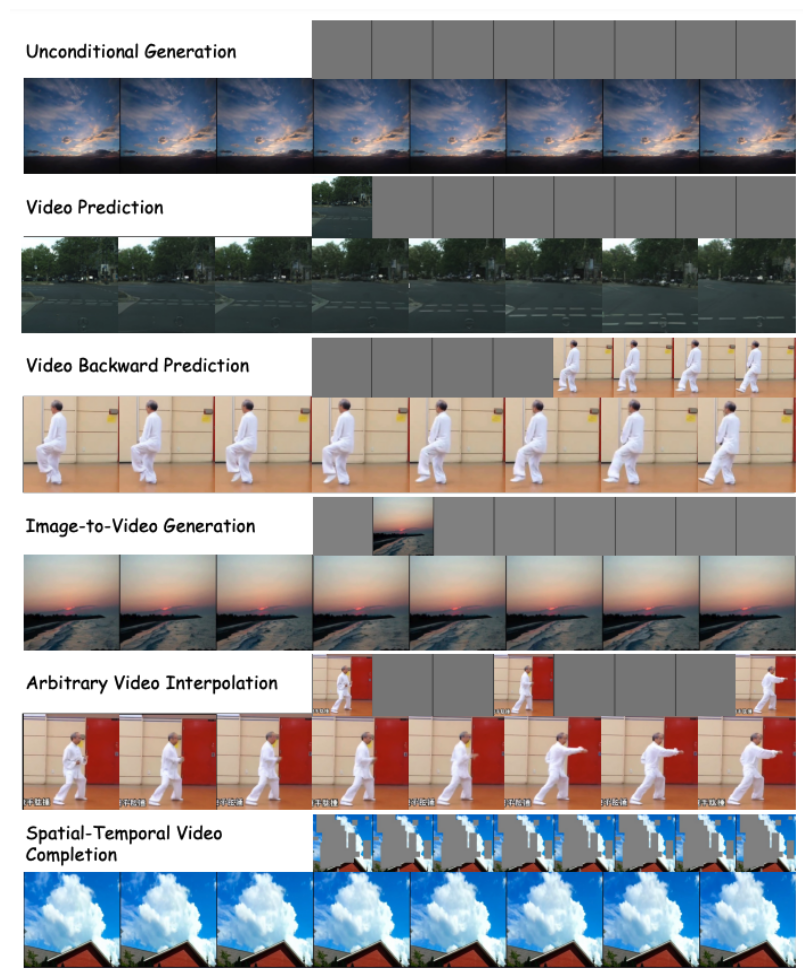

- VDT가 다양한 비디오 생성 작업을 처리하고 기술의 광범위한 적용을 달성할 수 있도록 하는 통합 시공간 마스크 모델링 기계를 제안합니다. 간단한 토큰 공간 접합과 같은 VDT의 유연한 조건부 정보 처리 방법은 다양한 길이와 양식의 정보를 효과적으로 통합합니다. 동시에 VDT는 본 연구에서 제안한 시공간 마스크 모델링 메커니즘과 결합하여 모델 수정 없이 무조건 생성, 비디오 후속 프레임 예측, 프레임 보간 및 이미지 생성에 적용할 수 있는 범용 비디오 확산 도구가 되었습니다. 영상, 영상 화면 완성 등 다양한 영상 생성 작업을 수행합니다.

- 2. VDT의 네트워크 아키텍처에 대한 자세한 해석

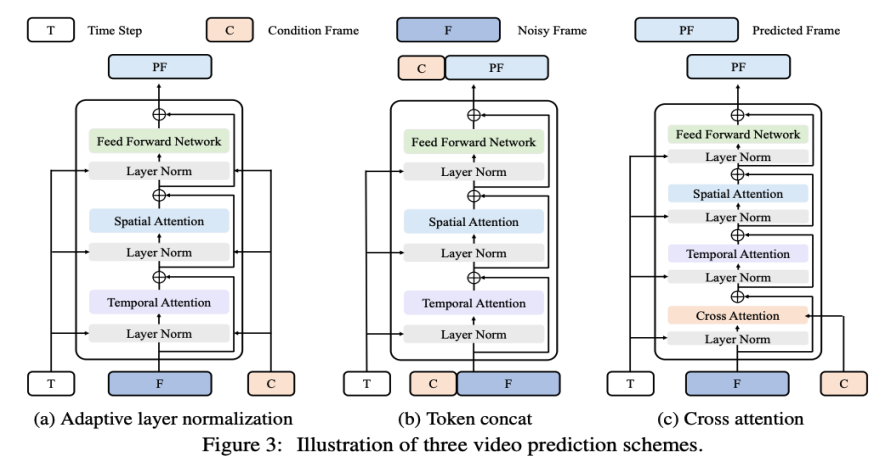

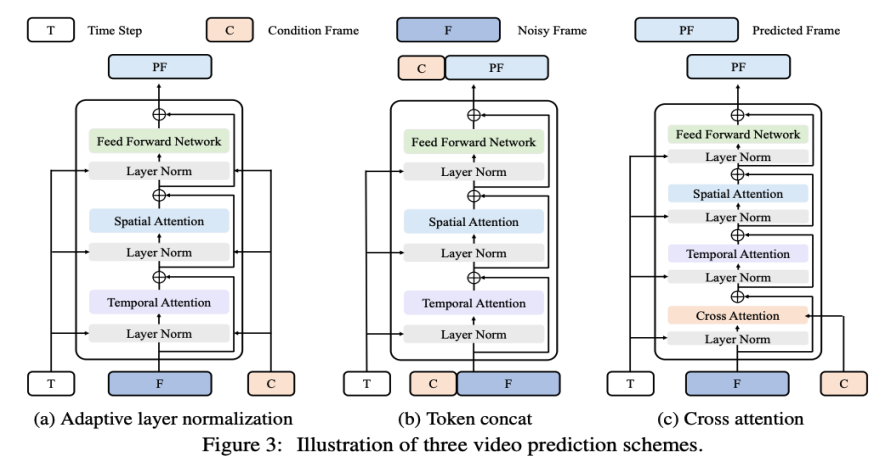

VDT 프레임워크는 Sora의 프레임워크와 매우 유사하며 다음 부분으로 구성됩니다: 입력/출력 기능. VDT의 목표는 H×W 크기의 F 프레임 비디오로 구성된 F×H×W×3 비디오 세그먼트를 생성하는 것입니다. 그러나 원시 픽셀이 VDT의 입력으로 사용되는 경우, 특히 F가 큰 경우 계산이 극도로 복잡해집니다. LDM(잠재 확산 모델)에서 영감을 얻은 이 문제를 해결하기 위해 VDT는 사전 훈련된 VAE 토크나이저를 사용하여 비디오를 잠재 공간에 투영합니다. 입력 및 출력의 벡터 차원을 잠재 특징/잡음의 F×H/8×W/8×C로 줄이면 F 프레임의 잠재 특징 크기가 H/8×W인 VDT의 훈련 및 추론 속도가 가속화됩니다. /8 . 여기서 8은 VAE 토크나이저의 다운샘플링 속도이고 C는 잠재 특성 차원을 나타냅니다. 선형 임베딩. Vision Transformer 접근 방식에 따라 VDT는 잠재 비디오 특징 표현을 N×N 크기의 겹치지 않는 패치로 분할합니다. 시공간 변압기 블록. 비디오 모델링에서 시공간적 self-attention의 성공에 영감을 받아 VDT는 시간 차원 모델링 기능을 얻기 위해 Transformer Block에 Tempotemporal Attention 레이어를 삽입했습니다. 구체적으로, 각 변환기 블록은 위 그림에 표시된 것처럼 다중 헤드 시간 주의, 다중 헤드 공간 주의 및 완전히 연결된 피드포워드 네트워크로 구성됩니다. Sora가 발표한 최신 기술 보고서를 비교해 보면 VDT와 Sora의 구현 세부 사항에는 약간의 미묘한 차이만 있다는 것을 알 수 있습니다. 먼저 VDT는 Attention 메커니즘을 시공간 차원에서 별도로 처리하는 방식을 사용하는 반면, Sora는 시간과 공간 차원을 병합하여 단일 Attention 메커니즘을 통해 처리합니다. 이러한 주의 분리 접근 방식은 비디오 분야에서 상당히 일반화되었으며 비디오 메모리의 제약으로 인해 절충안으로 간주되는 경우가 많습니다. VDT는 제한된 컴퓨팅 리소스로 인해 분할 주의를 사용하기로 선택합니다. Sora의 강력한 비디오 동적 기능은 공간과 시간의 전반적인 주의 메커니즘에서 비롯될 수 있습니다. 둘째, VDT와 달리 소라는 텍스트 조건의 융합도 고려합니다. Transformer(예: DiT)를 기반으로 한 텍스트 조건부 융합에 대한 이전 연구가 있었습니다. Sora가 모듈에 교차 주의 메커니즘을 추가로 추가할 수도 있을 것으로 추측됩니다. 물론 조건부 입력으로 텍스트와 노이즈를 직접 연결하는 것도 가능합니다. 가능성. VDT 연구 과정에서 연구원들은 일반적으로 사용되는 기본 백본 네트워크인 U-Net을 Transformer로 대체했습니다. 이는 비디오 확산 작업에서 Transformer의 효율성을 검증했을 뿐만 아니라 손쉬운 확장과 강화된 연속성의 장점을 보여 주었을 뿐만 아니라 잠재적인 가치에 대한 더 깊은 생각을 촉발시켰습니다. GPT 모델의 성공과 AR(자동 회귀) 모델의 인기로 인해 연구자들은 비디오 생성 분야에서 Transformer의 더 깊은 적용을 탐색하기 시작했으며 이를 달성하기 위한 새로운 방법을 제공할 수 있는지 고려하기 시작했습니다. 시각 지능. 비디오 생성 분야에는 비디오 예측이라는 밀접하게 관련된 작업이 있습니다. 시각지능을 향한 길로 다음 영상 프레임을 예측한다는 생각은 단순해 보일 수도 있지만 사실 많은 연구자들의 공통 관심사다. 이러한 고려 사항을 바탕으로 연구자들은 비디오 예측 작업에 대한 모델을 더욱 조정하고 최적화하기를 희망합니다. 비디오 예측 작업은 주어진 조건부 프레임이 비디오의 처음 몇 프레임인 조건부 생성으로 간주될 수도 있습니다. VDT는 주로 다음 세 가지 조건 생성 방법을 고려합니다.

적응 레이어 정규화. 비디오 예측을 달성하는 간단한 방법은 조건부 프레임 기능을 VDT 블록의 레이어 정규화에 통합하는 것입니다. 이는 시간 정보를 확산 프로세스에 통합하는 방법과 유사합니다. 크로스 어텐션. 연구자들은 조건부 프레임이 키와 값으로 사용되고 노이즈 프레임이 쿼리로 사용되는 비디오 예측 체계로 교차 주의를 사용하는 방법도 연구했습니다. 이를 통해 조건부 정보를 노이즈 프레임과 융합할 수 있습니다. Cross-Attention 레이어에 들어가기 전에 VAE 토크나이저를 사용하여 조건부 프레임의 특징을 추출하고 패치합니다. 한편, VDT가 조건부 프레임에서 해당 정보를 학습하는 데 도움이 되도록 공간적 및 시간적 위치 임베딩도 추가되었습니다. 토큰 스플라이싱. VDT 모델은 순수한 Transformer 아키텍처를 채택하므로 조건부 프레임을 입력 토큰으로 직접 사용하는 것이 VDT에 대한 보다 직관적인 방법입니다. 우리는 조건화된 프레임(잠재적 특징)과 노이즈 프레임을 토큰 수준에서 연결한 다음 VDT에 공급함으로써 이를 달성합니다. 다음으로 그림 3(b)와 같이 VDT의 출력 프레임 시퀀스를 분할하고 예측된 프레임을 사용하여 확산 프로세스를 수행했습니다. 연구원들은 이 방식이 처음 두 가지 방법에 비해 가장 빠른 수렴 속도를 보여주고 최종 결과에서 더 나은 성능을 제공한다는 것을 발견했습니다. 또한 연구원들은 훈련 중에 고정 길이 조건부 프레임이 사용되더라도 VDT가 여전히 모든 길이의 조건부 프레임을 입력 및 출력 일관된 예측 기능으로 받아들일 수 있음을 발견했습니다. VDT 프레임워크에서는 비디오 예측 작업을 달성하기 위해 네트워크 구조를 수정할 필요가 없으며 모델의 입력만 변경하면 됩니다. 이 발견은 다음과 같은 직관적인 질문으로 이어집니다. 이 확장성을 더욱 활용하여 추가 모듈이나 매개변수를 도입하지 않고도 VDT를 이미지 생성 비디오와 같은 보다 다양한 비디오 생성 작업으로 확장할 수 있습니까? 무조건 생성 및 비디오 예측에서 VDT의 기능을 검토한 결과 유일한 차이점은 입력 기능의 유형입니다. 구체적으로 입력은 순전히 잡음이 있는 잠재 기능이거나 조건부 및 잡음이 있는 잠재 기능의 연결일 수 있습니다. 그런 다음 연구원은 아래 그림 4와 같이 조건부 입력을 통합하기 위해 통합 공간-시간 마스크 모델링을 도입했습니다.

위의 방법을 통해 VDT 모델은 무조건 영상 생성 및 영상 예측 작업을 원활하게 처리할 수 있을 뿐만 아니라, 간단한 조정만으로 영상 등 더 넓은 영상 생성 분야로 확장될 수 있습니다. 입력 기능. 프레임 보간 등. 이러한 유연성과 확장성의 구현은 VDT 프레임워크의 강력한 잠재력을 보여주고 미래 비디오 생성 기술에 대한 새로운 방향과 가능성을 제공합니다.

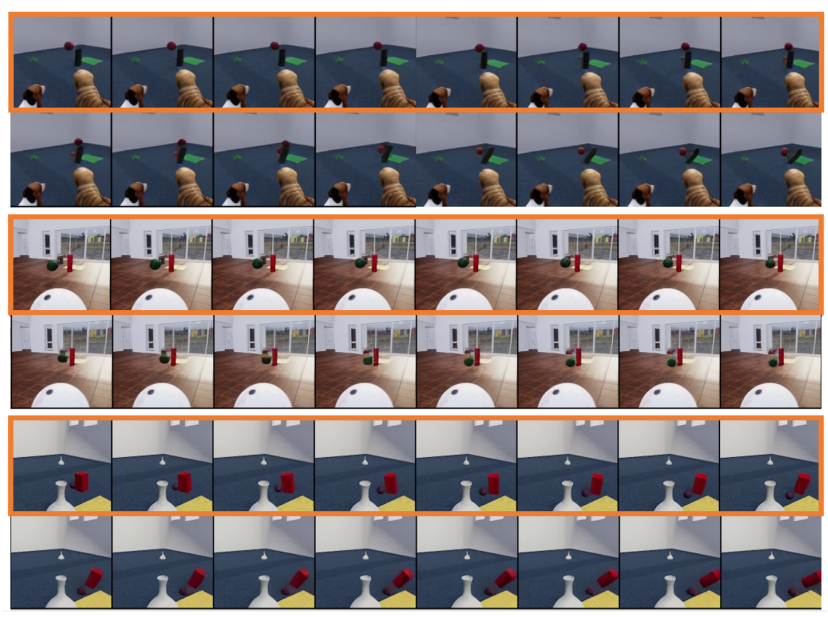

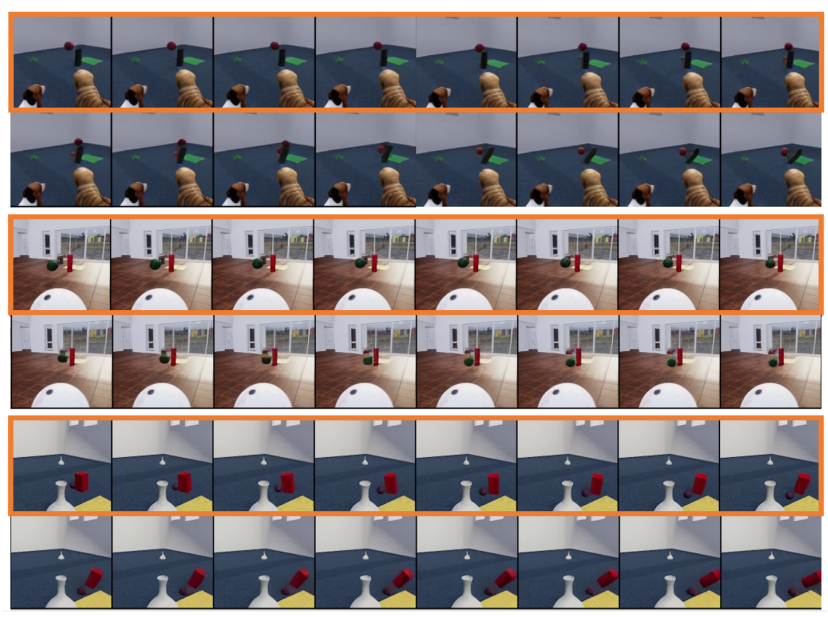

흥미롭게도 OpenAI는 텍스트-비디오 외에도 이미지 기반 생성, 전후방 비디오 예측, 다양한 비디오 클립 융합 사례 등 Sora의 다른 놀라운 작업도 시연했습니다. 연구원들이 제안한 통합 공간-시간 마스크 모델링이 지원하는 다운스트림 작업은 kaiming의 MAE도 참고 자료에 인용되어 있습니다. 따라서 소라의 최하층도 MAE와 유사한 훈련 방법을 사용하고 있는 것으로 추측된다. 연구원들은 또한 생성 모델 VDT를 통한 간단한 물리 법칙 시뮬레이션을 탐색했습니다. 그들은 VDT가 처음 8개 프레임을 조건부 프레임으로 사용하고 다음 8개 프레임을 예측하는 Physion 데이터세트에 대한 실험을 수행했습니다. 첫 번째 예(상단 두 행)와 세 번째 예(하단 두 행)에서 VDT는 포물선 궤적을 따라 움직이는 공과 평면에서 구르며 원통과 충돌하는 공과 관련된 물리적 프로세스를 성공적으로 시뮬레이션합니다. 두 번째 예(중간 두 행)에서 VDT는 공이 실린더에 부딪히기 전에 멈출 때 공의 속도/운동량을 포착합니다. 이는 Transformer 아키텍처가 특정 물리적 법칙을 학습할 수 있음을 증명합니다.

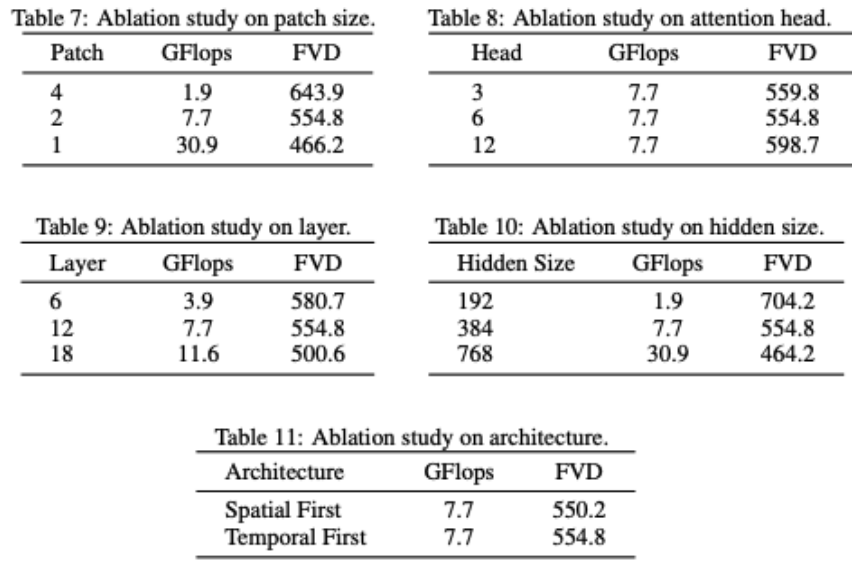

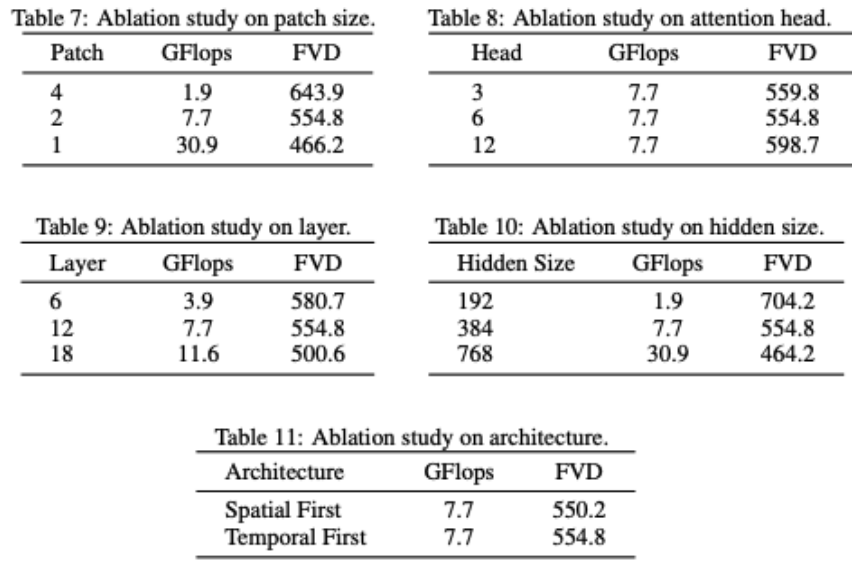

VDT는 네트워크 구조를 부분적으로 제거합니다. 모델 성능은 GFlop과 밀접한 관련이 있으며 모델 구조 자체의 일부 세부 사항은 큰 영향을 미치지 않는다는 것을 알 수 있습니다. 이는 DiT의 결과와도 일치합니다. 연구원들은 VDT 모델에 대한 몇 가지 구조적 절제 연구도 수행했습니다. 결과는 Patchsize를 줄이고, Layer 수를 늘리고, Hidden Size를 늘리면 모델의 성능이 더욱 향상될 수 있음을 보여줍니다. 시간적 및 공간적 주의 위치와 주의 머리 수는 모델 결과에 거의 영향을 미치지 않습니다. 일부 설계 절충이 필요하지만 전반적으로 동일한 GFlop을 유지하면서 모델 성능에는 큰 차이가 없습니다. 그러나 GFlop의 증가는 더 나은 결과로 이어지며 VDT 또는 Transformer 아키텍처의 확장성을 입증합니다. VDT의 테스트 결과는 비디오 데이터 생성 처리에서 Transformer 아키텍처의 효율성과 유연성을 보여줍니다. 컴퓨팅 리소스의 한계로 인해 VDT 실험은 일부 소규모 학술 데이터 세트에서만 수행되었습니다. VDT를 기반으로 한 영상 생성 기술의 새로운 방향과 응용을 더욱 탐구하기 위한 향후 연구를 기대하며, 중국 기업들이 조속히 국산 Sora 모델을 출시하기를 기대합니다.

VDT는 네트워크 구조를 부분적으로 제거합니다. 모델 성능은 GFlop과 밀접한 관련이 있으며 모델 구조 자체의 일부 세부 사항은 큰 영향을 미치지 않는다는 것을 알 수 있습니다. 이는 DiT의 결과와도 일치합니다. 연구원들은 VDT 모델에 대한 몇 가지 구조적 절제 연구도 수행했습니다. 결과는 Patchsize를 줄이고, Layer 수를 늘리고, Hidden Size를 늘리면 모델의 성능이 더욱 향상될 수 있음을 보여줍니다. 시간적 및 공간적 주의 위치와 주의 머리 수는 모델 결과에 거의 영향을 미치지 않습니다. 일부 설계 절충이 필요하지만 전반적으로 동일한 GFlop을 유지하면서 모델 성능에는 큰 차이가 없습니다. 그러나 GFlop의 증가는 더 나은 결과로 이어지며 VDT 또는 Transformer 아키텍처의 확장성을 입증합니다. VDT의 테스트 결과는 비디오 데이터 생성 처리에서 Transformer 아키텍처의 효율성과 유연성을 보여줍니다. 컴퓨팅 리소스의 한계로 인해 VDT 실험은 일부 소규모 학술 데이터 세트에서만 수행되었습니다. VDT를 기반으로 한 영상 생성 기술의 새로운 방향과 응용을 더욱 탐구하기 위한 향후 연구를 기대하며, 중국 기업들이 조속히 국산 Sora 모델을 출시하기를 기대합니다.

위 내용은 국내 대학에서는 Sora형 모델 VDT를 제작하고 범용 비디오 확산 트랜스포머는 ICLR 2024에서 승인되었습니다.의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!