Mistral-Medium이 실수로 유출되었나요? 이전에는 API를 통해서만 사용할 수 있었으며 성능은 GPT-4에 가깝습니다.

CEO의 최신 발언: 사실이며 초기 고객 직원에 의해 유출되었습니다. 하지만 여전히 계속 지켜봐주세요라고 말했습니다.

Pictures

Pictures

즉, 이 버전은 아직 오래된 버전이므로 실제 성능은 버전이 더 좋을 것입니다.

지난 이틀간 대형 모델 커뮤니티에서 '미쿠'라는 미스터리한 모델이 화제가 됐습니다.

Pictures

Pictures

Mistral CEO는 Mistral Medium을 재교육하고 Llama 2를 기반으로 개선했다고 설명했습니다. 이는 초기 고객에게 최대한 빨리 GPT-4 성능에 가까운 API를 제공하기 위한 것입니다. 사전 훈련 작업은 Mistral 7B가 출시된 날 완료되었습니다.

진실이 밝혀진 지금에도 CEO는 여전히 비밀을 유지하고 있어 많은 네티즌들이 기대감에 손을 뻗고 있습니다.

Pictures

Pictures

Pictures

Pictures

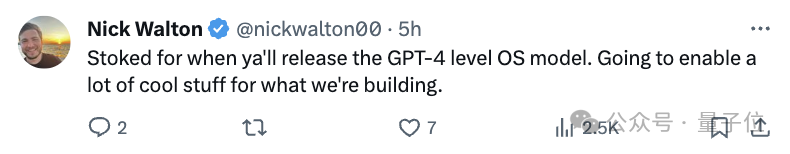

전체 사건을 다시 검토해 보겠습니다. 1월 28일, Miqu Dev라는 신비한 사용자가 HuggingFace에 "miqu-1-70b" 파일 세트를 게시했습니다.

Pictures

Pictures

문서에는 새로운 LLM의 "프롬프트 형식"과 사용자 상호 작용 방법이 Mistral과 동일하다고 명시되어 있습니다.

같은 날 4chan에 익명의 사용자가 miqu-1-70b 파일에 대한 링크를 게시했습니다.

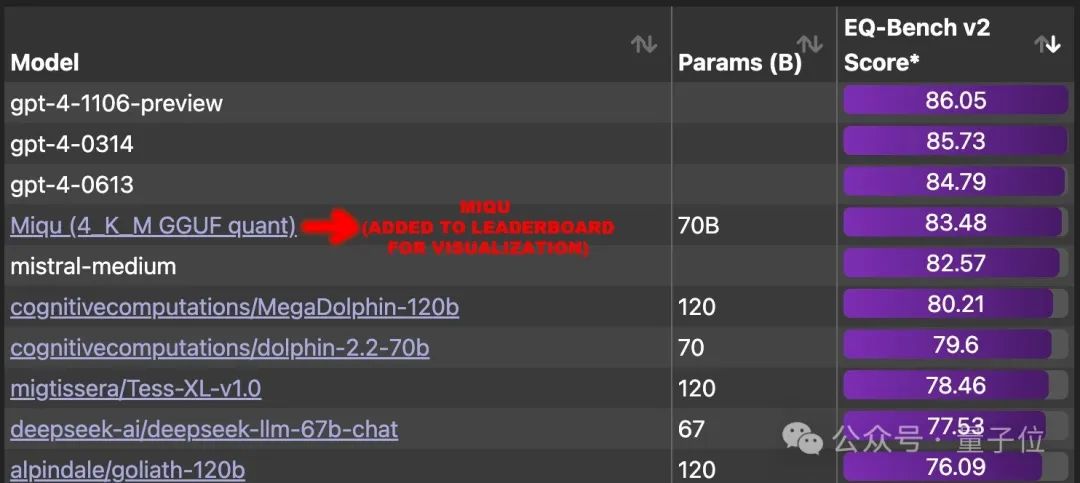

그래서 일부 네티즌들은 이 신비한 모델을 발견하고 몇 가지 벤치마크 테스트를 시작했습니다.

결과는 놀랍습니다. EQ-Bench(현지 평가)에서 83.5점을 얻어 GPT-4를 제외한 세계의 다른 모든 대형 모델을 능가합니다.

한동안 네티즌들은 이 빅모델을 순위에 추가하고 그 뒤에 숨은 실제 모델을 찾아내야 한다고 강력히 요구했습니다.

의심 방향은 크게 세 가지입니다.

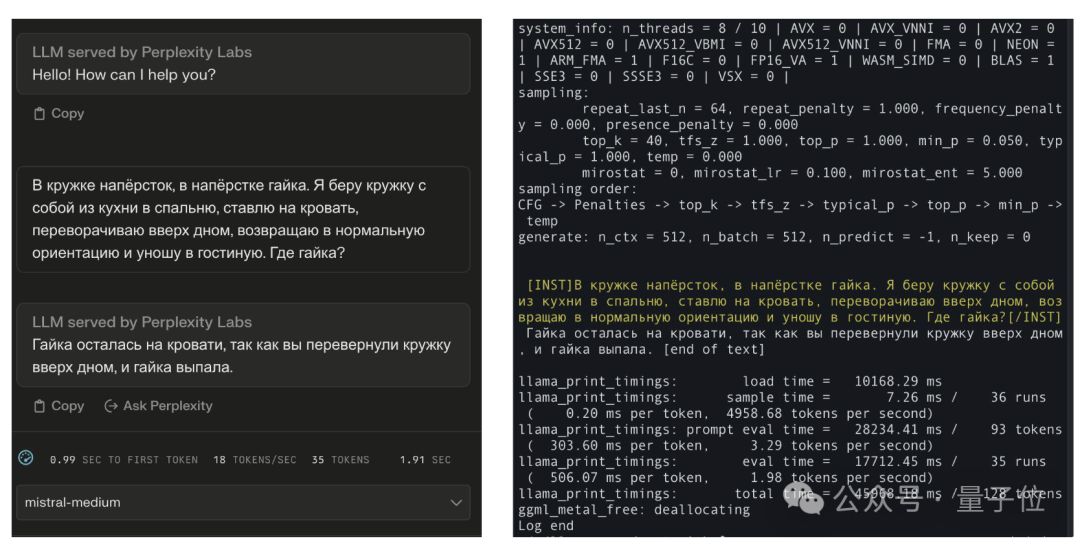

일부 네티즌들은 비교 효과를 올렸습니다. 표준적인 답변을 알고 있고 말이 되지만 러시아어 표현조차 Mistral-Medium과 정확히 동일할 수는 없습니다.

Pictures

Pictures

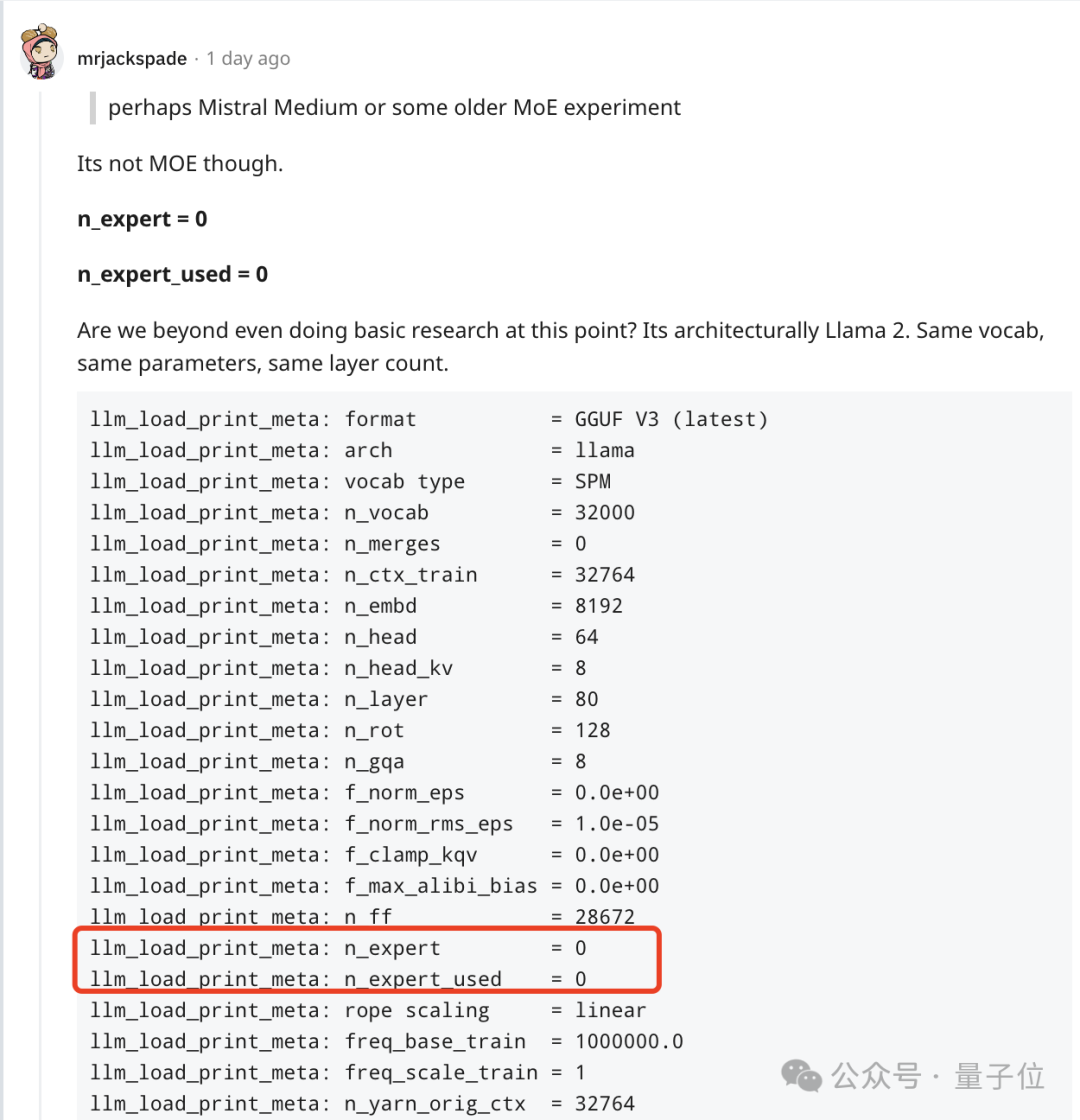

그러나 다른 네티즌들은 MoE 모델이 아니며 LIama 2와 동일한 아키텍처, 동일한 매개 변수 및 동일한 레이어 수를 가지고 있음을 발견했습니다.

사진

사진

그러나 미스트랄 7b도 라마 7B와 동일한 매개변수와 레이어 수를 가지고 있어 즉시 다른 네티즌들의 의문을 제기했습니다.

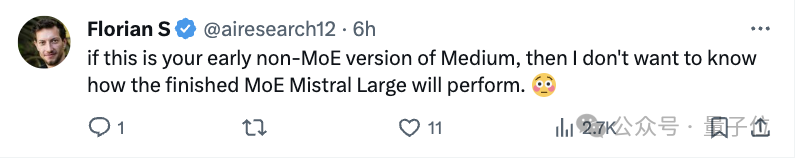

대신에 이것은 Mistral 초기 비MoE 버전 모델에 더 가깝습니다.

Pictures

Pictures

그러나 논의 결과 많은 사람들의 마음 속에서 이것이 GPT-4에 가장 가까운 모델이라는 것은 부인할 수 없습니다.

Pictures

Pictures

이제 Mistral의 공동 창립자이자 CEO인 Arthur Mensch는 초기 고객 직원 중 한 명이 지나치게 열정적이었고 그들이 훈련하고 공개적으로 출시한 이전 모델의 양자화된 버전을 유출했음을 인정했습니다.

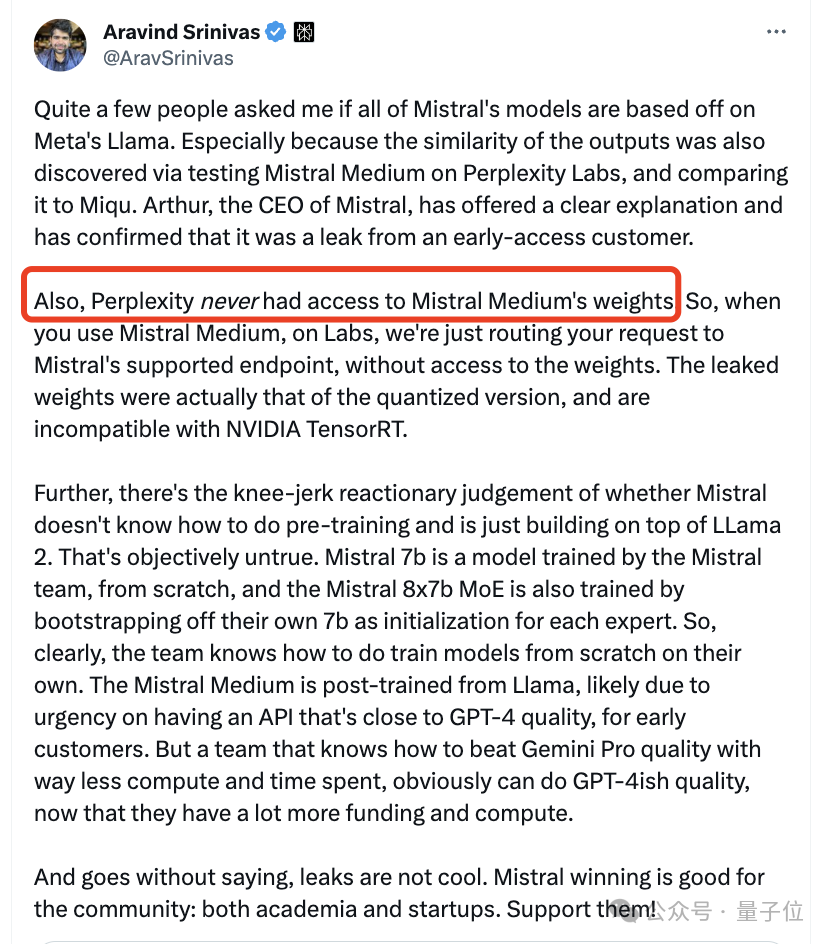

Perplexity에 관해서도 CEO는 Mistral Medium의 무게를 받아본 적이 없다고 밝혔습니다.

Pictures

Pictures

네티즌들은 이 버전이 삭제될까 걱정하고 있습니다.

Pictures

Pictures

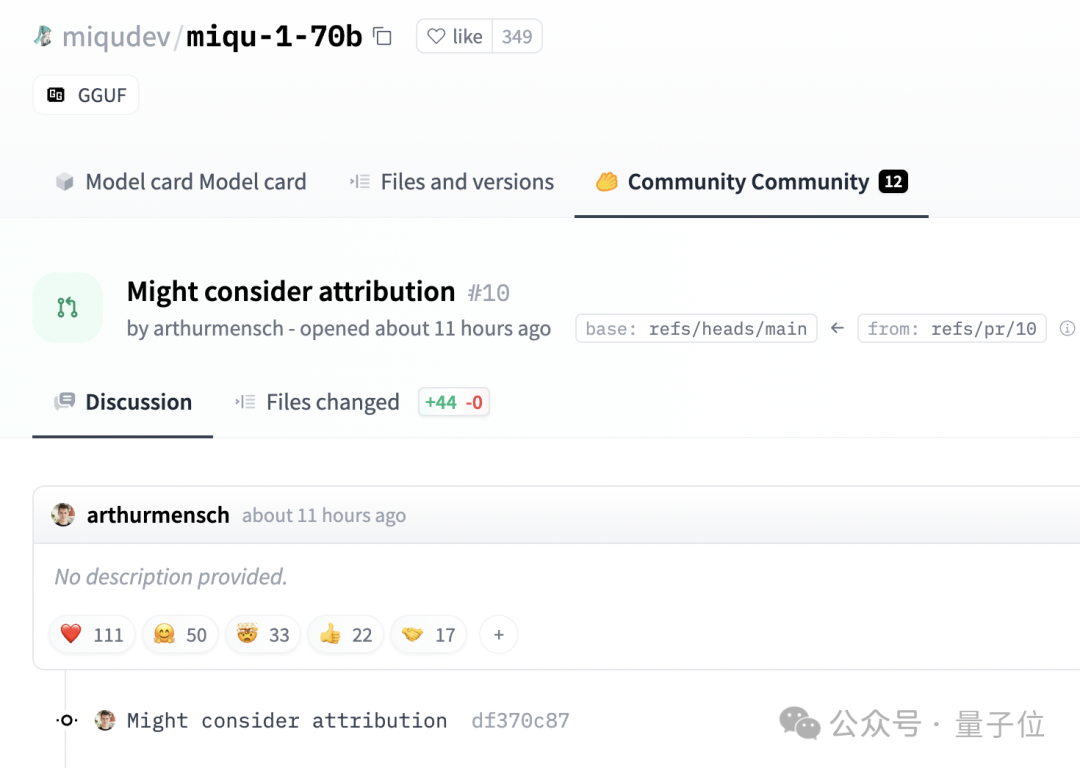

흥미롭게도 Mensch는 HuggingFace의 게시물 삭제를 요청하지 않았습니다.

Pictures

Pictures

대신 다음과 같은 댓글을 남겨주세요. 저작자 표시 문제가 고려될 수 있습니다.

참조 링크:

[1]https://www.reddit.com/r/LocalLLaMA/comments/1af4fbg/llm_comparisontest_miqu170b/

[2]https://twitter.com/teortaxesTex/status/1752427812466593975

[3]https://twitter.com/N8Programs/status/1752441060133892503

[4]https://twitter.com/AravSrinivas/status/1752803571035504858

위 내용은 GPT-4에 필적하는 오픈소스 모델이 유출됐습니다! Mistral의 보스가 방금 확인했습니다. 공식 버전은 더욱 강력해질 것입니다.의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!