Stability AI는 최근 2024년에 첫 번째 AI 모델인 Stable Code 3B를 출시했습니다. 이 모델에는 30억 개의 매개변수가 있으며 보조 코드 작업에 중점을 둡니다.

전용 GPU 없이 노트북에서 기본적으로 실행되는 동시에 Meta의 CodeLLaMA 7B와 같은 대형 모델에서도 경쟁력 있는 성능을 제공합니다.

2023년 말, Stability AI는 텍스트 생성을 위한 StableLM Zephyr 3B 모델과 같이 더 작고, 더 컴팩트하며, 더 강력한 모델의 개발을 촉진하기 시작했습니다.

2024년 초 Stability AI는 Stable Code 3B라는 중요한 언어 모델을 출시했습니다. 실제로 지난해 8월에는 프리뷰 버전인 Stable Code Alpha 3B가 출시됐다. 이후 Stability AI는 계속해서 기술을 개선해왔습니다. 이 새로운 버전의 Stable Code 3B는 코드 완성을 위해 특별히 설계되었으며 다양한 추가 기능도 갖추고 있습니다.

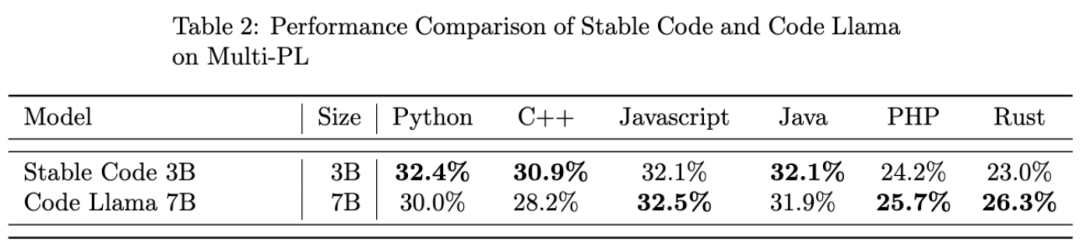

CodeLLaMA 7b에 비해 Stable Code 3B는 크기가 60% 작지만 프로그래밍 작업에서는 이전과 비슷한 성능을 달성합니다.

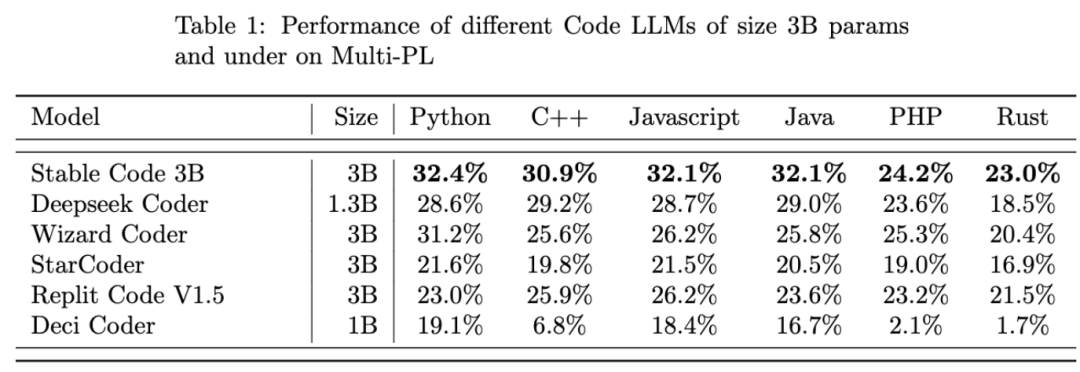

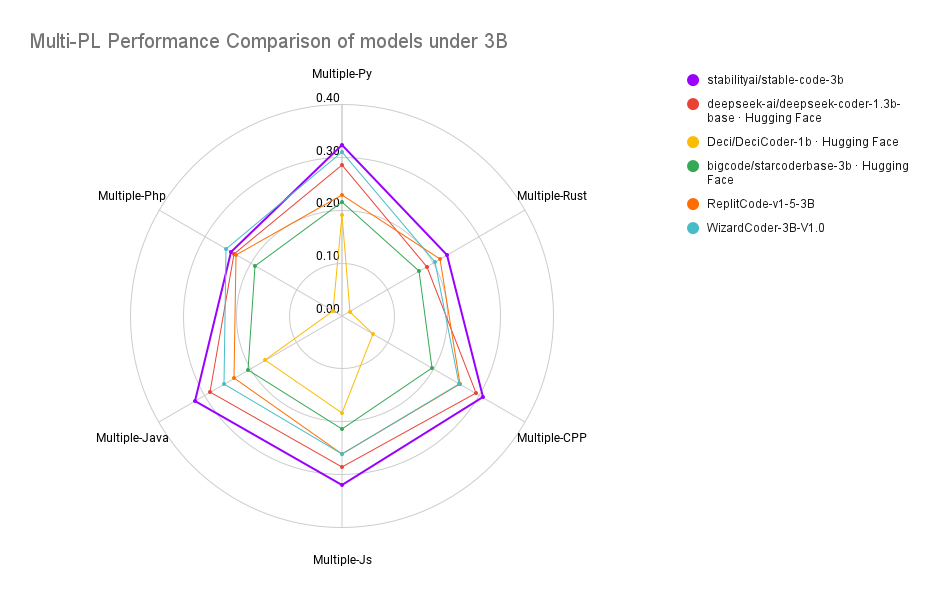

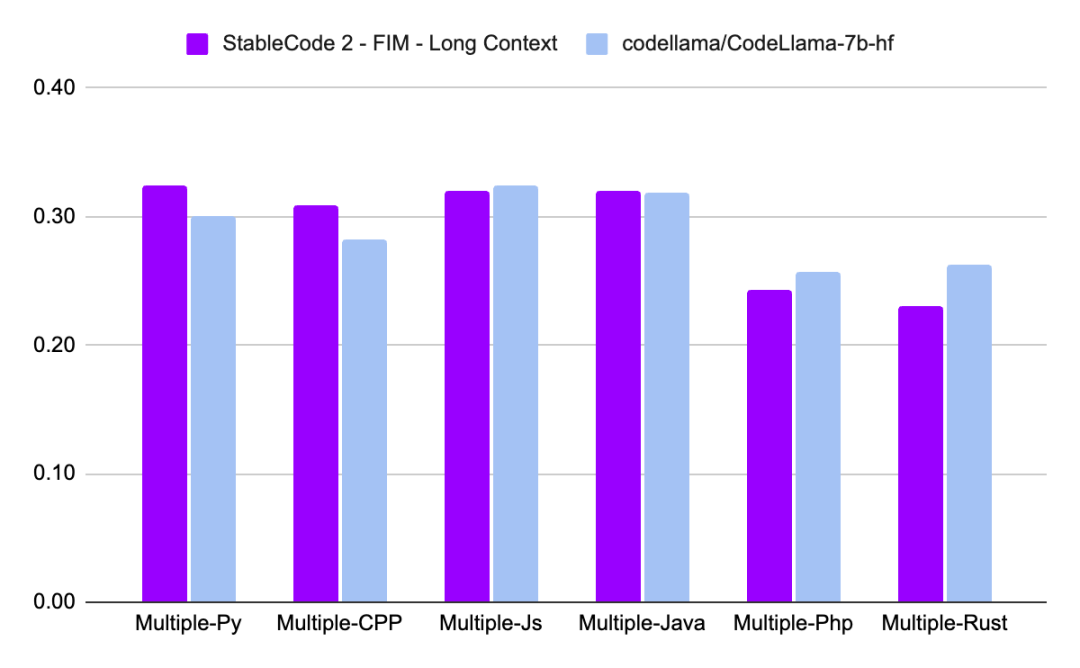

Stable Code 3B는 Python, C++, JavaScript, Java, PHP 및 Rust 프로그래밍 언어에서 Stable Code 3B와 같은 MultiPL-E 벤치마크에서 SOTA 성능(비슷한 크기의 모델과 비교)을 달성합니다. 성능이 더 좋습니다. 스타코더보다

Stable Code 3B는 최대 4조 개의 훈련 토큰 수를 갖는 Stable LM 3B를 기반으로 훈련됩니다. 또한 Stable Code는 훈련을 위해 소프트웨어 엔지니어링과 관련된 데이터도 사용합니다.

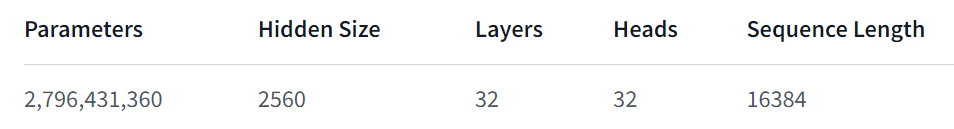

Stable Code 3B는 더 많은 기능을 제공하고 여러 언어에서도 잘 작동하며 FIM(Fill in the Middle, 새로운 훈련 기술) 기능을 지원하고 컨텍스트 크기를 확장할 수 있는 등의 다른 장점도 있습니다. 기본 안정 코드는 최대 16,384개의 토큰 시퀀스에 대해 학습되고 CodeLlama와 유사한 접근 방식을 따릅니다. 즉, 선택적으로 최대 1,000,000개의 회전 베이스를 수정할 수 있는 로터리 임베딩을 사용합니다. 모델의 컨텍스트 길이는 100,000개 토큰으로 추가로 확장됩니다. .

모델 아키텍처 측면에서 Stable Code 3B 모델은 다음과 같이 수정된 LLaMA 아키텍처와 유사한 순수 디코더 변환기입니다.

Training Dataset

Stable Code 3B의 교육 데이터 세트는 Falcon RefinedWeb, CommitPack을 포함하여 HuggingFace Hub에서 사용할 수 있는 오픈 소스 대규모 데이터 세트의 필터링된 혼합으로 구성됩니다. FT , Github Issues, StarCoder 및 수학 분야의 데이터로 추가 교육을 보충합니다.

교육 인프라

마지막으로 Stable Code 3B의 성능을 살펴보겠습니다.

Stable Code 3B에 대한 보다 자세한 기술 보고서는 추후 공개될 예정이니 기대해 주시기 바랍니다.

위 내용은 Stability AI는 로컬에서 실행되고 GPU가 필요하지 않은 안정적인 코드 3B 모델을 출시합니다.의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!