강화 학습 알고리즘(Reinforcement Learning, RL)의 훈련 과정에는 일반적으로 이를 지원하기 위해 환경과 상호 작용하는 대량의 샘플 데이터가 필요합니다. 그러나 현실 세계에서는 다수의 상호작용 샘플을 수집하는 데 비용이 많이 들거나, UAV 공중전 훈련, 자율주행 훈련 등 샘플링 과정의 안전성을 보장할 수 없는 경우가 많다. 이 문제는 많은 실제 응용 분야에서 강화 학습의 범위를 제한합니다. 따라서 연구자들은 이 문제를 해결하기 위해 시료 효율성과 안전성 사이의 균형을 맞추는 방법을 모색하기 위해 열심히 노력해 왔습니다. 가능한 해결책 중 하나는 시뮬레이터나 가상 환경을 사용하여 대량의 샘플 데이터를 생성함으로써 실제 상황의 비용과 보안 위험을 피하는 것입니다. 또한 훈련 과정에서 강화학습 알고리즘의 샘플 효율성을 높이기 위해 일부 연구자들은 표현 학습 기술을 사용하여 미래 상태 신호를 예측하기 위한 보조 작업을 설계했습니다. 이러한 방식으로 알고리즘은 원래 환경 상태에서 향후 결정과 관련된 특징을 추출하고 인코딩할 수 있습니다. 이 접근 방식의 목적은 환경에 대한 더 많은 정보를 학습하고 더 나은 의사 결정 기반을 제공함으로써 강화 학습 알고리즘의 성능을 향상시키는 것입니다. 이러한 방식으로 알고리즘은 훈련 과정에서 샘플 데이터를 보다 효율적으로 사용하고 학습 과정을 가속화하며 의사 결정의 정확성과 효율성을 향상시킬 수 있습니다.

이 아이디어를 바탕으로 이 작업은 미래의 여러 단계에 대한 상태 시퀀스 주파수 영역 분포

를 예측하여 장기적인 미래 의사 결정 특성을 포착하고 이를 통해 알고리즘의 샘플 효율성을 향상시키는 보조 작업을 설계했습니다. .이 작품의 제목은 State Sequences Prediction via Fourier Transform for Representation Learning이며 NeurIPS 2023에 게시되었으며 Spotlight로 승인되었습니다.

저자 목록: Ye Mingxuan, Kuang Yufei, Wang Jie*, Yang Rui, Zhou Wengang, Li Houqiang, Wu Feng

논문 링크: https://openreview.net/forum?id= MvoMDD6emT

코드 링크: https://github.com/MIRALab-USTC/RL-SPF/

배경 및 동기 연구

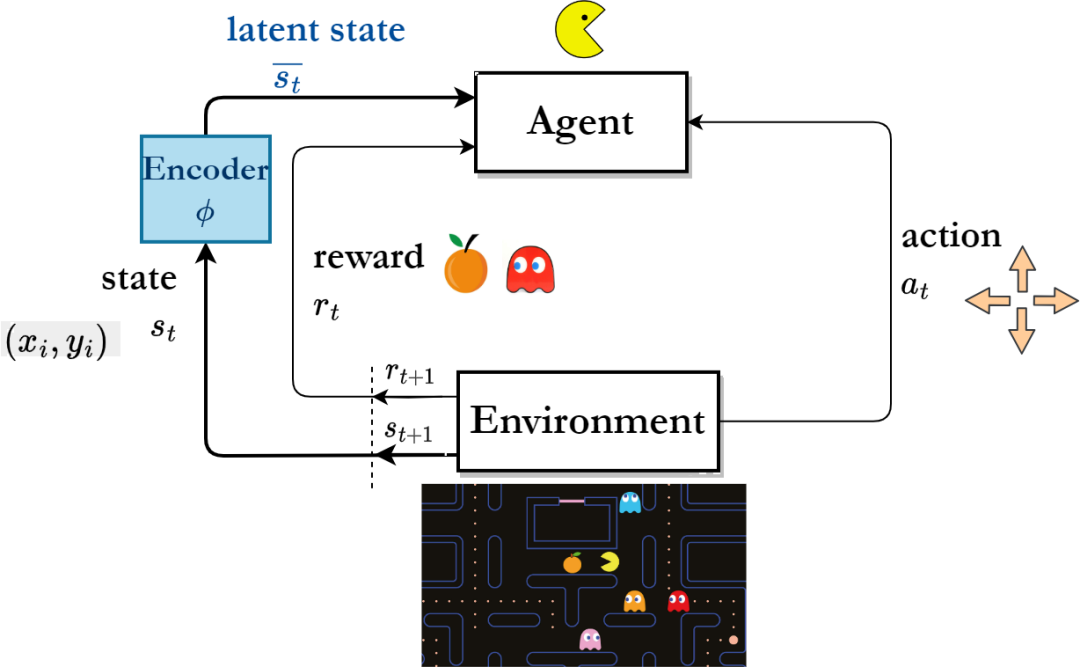

샘플 효율성을 높이기 위해 연구자들은 훈련을 통해 얻은 표현이 원래 환경 상태에서 풍부하고 유용한 특징 정보를 추출하여 로봇의 탐색 효율성을 향상시킬 수 있기를 바라며 표현 학습에 집중하기 시작했습니다. 상태 공간.

표현 학습 기반의 강화 학습 알고리즘 프레임워크

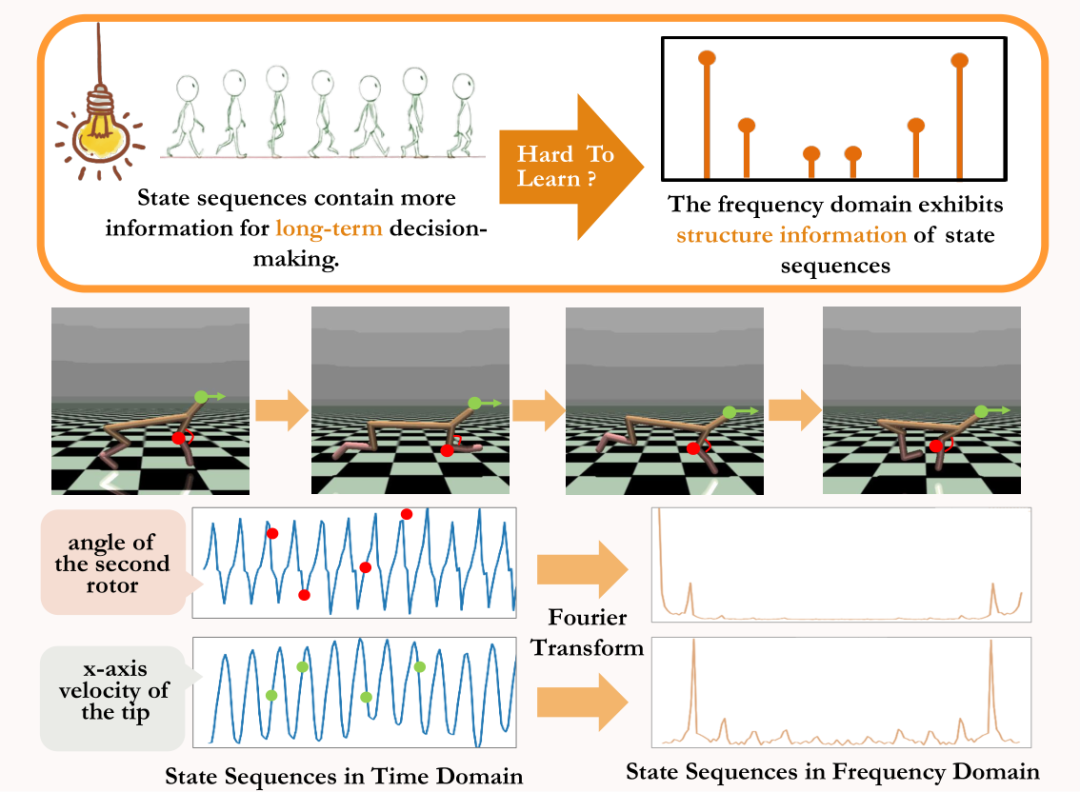

"장기적 순차 신호"에는 장기 의사결정에 도움이 되는 더 많은 미래 정보가 포함되어 있습니다. 단일 단계 신호에. 이러한 관점에서 영감을 받아 일부 연구자들은 향후 다단계 상태 시퀀스 신호를 예측하여 표현 학습을 지원하자고 제안했습니다[4,5]. 그러나 표현 학습을 돕기 위해 상태 시퀀스를 직접 예측하는 것은 매우 어렵습니다.

기존의 두 가지 방법 중 하나는 단단계 확률 천이 모델을 학습하여 다단계 상태 시퀀스를 간접적으로 예측함으로써 한 순간에 점진적으로 미래 상태를 생성하는 방법입니다[6,7]. 그러나 이러한 유형의 방법은 예측 시퀀스의 길이가 증가함에 따라 각 단계의 예측 오류가 누적되기 때문에 훈련된 확률 전달 모델의 높은 정확도가 필요합니다.

또 다른 유형의 방법은 미래에 다단계 상태 시퀀스를 직접 예측하여 표현 학습을 지원하지만[8], 이 유형의 방법은 다단계 실제 상태 시퀀스를 예측 작업에 대한 레이블로 저장해야 하며, 이는 많은 양의 저장 공간. 따라서 환경의 상태 시퀀스로부터 장기적인 의사결정에 도움이 되는 미래 정보를 어떻게 효과적으로 추출하고, 지속적인 제어 로봇 훈련 시 샘플 효율성을 향상시킬 수 있는지가 해결되어야 할 문제이다.

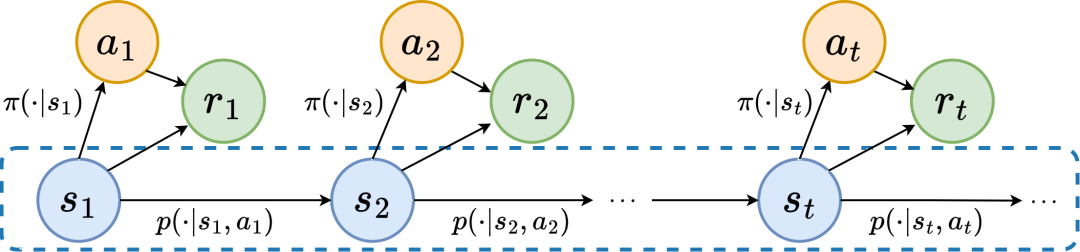

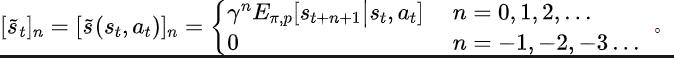

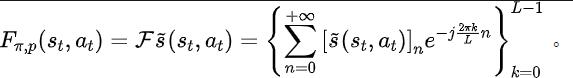

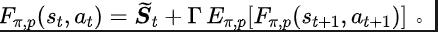

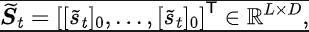

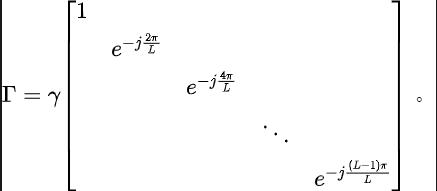

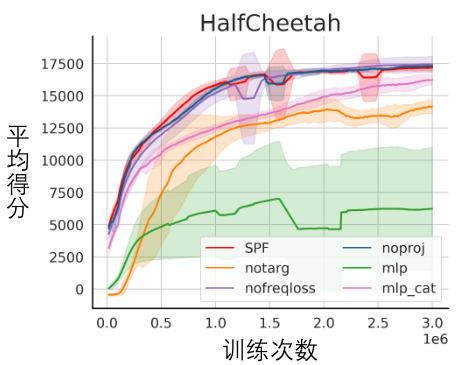

위 문제를 해결하기 위해 상태 시퀀스 주파수 영역 예측(State Sequences P

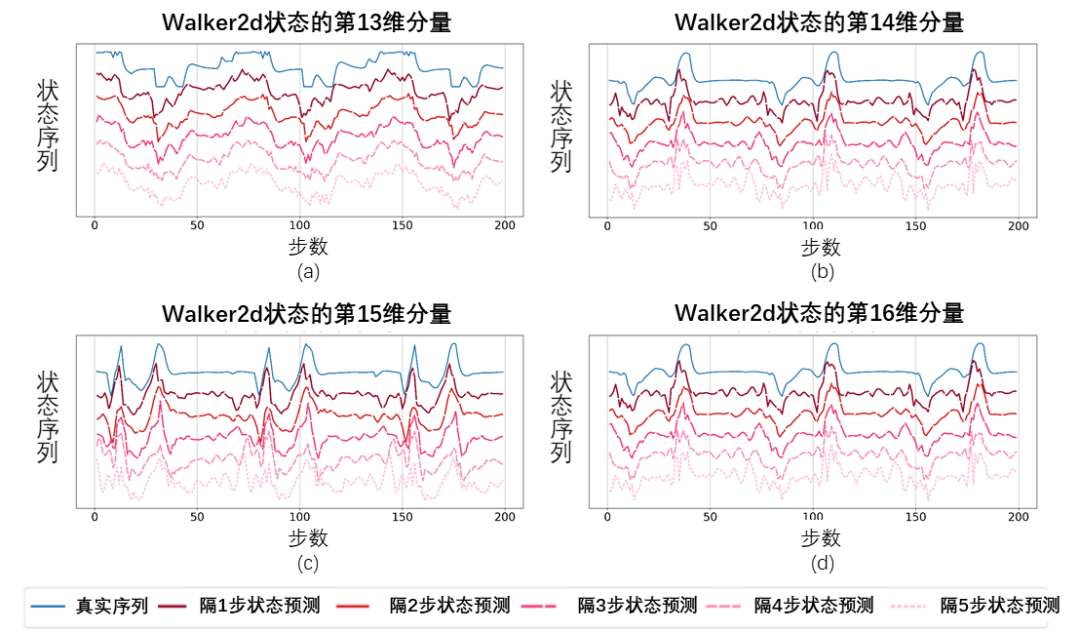

rediction viaFourier Transform, SPF)을 기반으로 한 표현 학습 방법을 제안합니다. "상태 시퀀스의 주파수 영역 분포'를 사용하여 상태 시퀀스 데이터의 추세 및 규칙성 정보를 명시적으로 추출함으로써 표현을 지원하여 장기적인 미래 정보를 효율적으로 추출합니다. 상태 시퀀스에는 "두 종류의 구조 정보"가 있다는 것을 이론적으로 입증했습니다. 하나는 전략 성과와 관련된 추세 정보이고, 다른 하나는 입니다. 상태 주기성과 관련된 규칙성 정보. 두 가지 구조 정보를 자세히 분석하기 전에 먼저 상태 시퀀스를 생성하는 Markov Decision Process(MDP)의 관련 정의를 소개합니다. 우리는 5배로 표현될 수 있는 연속 제어 문제에서 고전적인 마르코프 결정 프로세스를 고려합니다. 그 중 는 해당 상태와 행동공간, 는 보상함수, 는 환경의 상태전이함수, 는 상태의 초기분포, 는 할인인자이다. 또한, 상태에서 정책의 동작 분포를 나타내는 데 사용됩니다. 에이전트의 순간 상태를 로, 선택된 액션을 로 기록합니다. 에이전트가 액션을 취한 후 환경은 다음 순간의 상태로 이동하여 에이전트에게 보상을 제공합니다. 에이전트와 환경 사이의 상호 작용 중에 얻은 상태와 행동에 해당하는 궤적을 로 기록하고 궤적은 분포를 따릅니다. 강화학습 알고리즘의 목표는 미래 예상 누적 수익률을 최대화하는 것입니다. 현재 전략 및 환경 모델 하에서 평균 누적 수익률을 표현하기 위해 사용하며, 이를 약어로 다음과 같이 정의합니다. 현재 전략의 성과를 보여줍니다. 이제 상태 시퀀스와 해당 보상 시퀀스 간의 의존성을 포함하고 현재 전략 트렌드의 성능을 보여줄 수 있는 상태 시퀀스의 "첫 번째 구조적 특징"을 소개합니다. . 강화 학습 작업에서 미래 상태 시퀀스는 에이전트가 미래에 취하는 행동의 시퀀스를 크게 결정하고, 나아가 해당 보상 시퀀스를 결정합니다. 따라서 미래 상태 시퀀스는 환경에 내재된 확률 전이 함수에 대한 정보를 담고 있을 뿐만 아니라 현재 전략의 추세를 포착하는 데에도 도움을 줄 수 있습니다. 위 구조에서 영감을 받아 이 구조적 종속성의 존재를 추가로 입증하기 위해 다음 정리를 증명했습니다. 정리 1: 보상 함수가 상태에만 관련된 경우 두 가지 전략에 대해 그리고 이들의 성능 차이는 다음 두 전략에 의해 생성된 상태 시퀀스 분포의 차이에 의해 제어될 수 있습니다. 위 수식에서 는 지정된 전략 및 전이 확률 함수의 조건 하에서 상태 시퀀스의 확률 분포를 나타내며, 그리고 표준을 나타냅니다. 위 정리는 두 전략 간의 성능 차이가 클수록 해당 두 상태 시퀀스 간의 분포 차이도 커진다는 것을 보여줍니다. 이는 좋은 전략과 나쁜 전략이 완전히 다른 두 가지 상태 시퀀스를 생성한다는 것을 의미하며, 이는 상태 시퀀스에 포함된 장기적인 구조 정보가 뛰어난 성능으로 검색 전략의 효율성에 잠재적으로 영향을 미칠 수 있음을 더욱 보여줍니다. 한편, 특정 조건에서는 상태 시퀀스의 주파수 영역 분포 차이가 다음 정리에 표시된 대로 해당 정책 성능 차이의 상한을 제공할 수도 있습니다. 정리 2 : 상태 공간이 유한차원이고 보상 함수가 상태와 관련된 n차 다항식인 경우 두 전략 및 에 대해 성능 차이는 생성된 상태 시퀀스의 주파수 영역 분포의 차이로 제어될 수 있습니다. 위 수식에서 는 정책에 의해 생성된 상태 시퀀스의 멱수 시퀀스의 푸리에 함수를 나타내고, 푸리에 함수의 번째 구성 요소를 나타냅니다. 이 정리는 상태 시퀀스의 주파수 영역 분포에 현재 정책 성과와 관련된 특징 이 여전히 포함되어 있음을 보여줍니다. 이제 상태 신호 간의 시간 의존성을 수반하는 상태 시퀀스, 즉 장기간에 걸친 상태 시퀀스에 존재하는 "두 번째 구조적 특징"을 소개합니다. 규칙적인 패턴이 전시되었습니다. 많은 실제 시나리오 작업에서 에이전트는 환경의 상태 전환 기능 자체가 주기적이기 때문에 주기적인 동작도 보여줍니다. 산업용 조립 로봇을 예로 들면, 로봇은 부품을 함께 조립하여 최종 제품을 만드는 방법을 학습하고, 전략 훈련이 안정되면 Together에서 부품을 효율적으로 조립할 수 있는 주기적인 작업 시퀀스를 수행합니다. 위의 예에서 영감을 받아 유한 상태 공간에서 전이 확률 행렬이 특정 가정을 충족할 때 해당 상태 시퀀스가 에이전트가 안정적인 전략에 도달하면 "점진적으로" 표시될 수 있음을 증명하기 위한 몇 가지 이론적 분석을 제공합니다. . 거의 주기성", 구체적인 정리는 다음과 같습니다: 정리 3: 상태 전이 행렬이 있는 유한 차원 상태 공간에 대해 순환 클래스가 있다고 가정하면 해당 상태 전이 하위 행렬 입니다. 이 행렬의 모듈러스 1을 갖는 고유값의 수가 다음과 같다고 가정하면 모든 상태의 초기 분포에 대해 상태 분포는 주기에 따라 점근적인 주기성을 나타냅니다. MuJoCo 작업에서는 정책 훈련이 안정되면 에이전트도 주기적인 움직임을 보입니다. 아래 그림은 일정 기간 동안 MuJoCo 작업에서 HalfCheetah 에이전트의 상태 시퀀스에 대한 예를 제공하며 명백한 주기성을 관찰할 수 있습니다. (MuJoCo 작업의 주기적인 상태 시퀀스에 대한 더 많은 예를 보려면 이 문서의 부록 E 섹션을 참조하세요.) 일정 기간 동안 MuJoCo 작업에서 HalfCheetah 에이전트 상태의 주기성 시간 영역에서는 시계열로 표현되는 정보가 상대적으로 분산되어 있는 반면, 주파수 영역에서는 순서대로 규칙적인 정보가 보다 집중된 형태로 표현됩니다. 주파수 영역에서 주파수 성분을 분석함으로써 상태 시퀀스에 존재하는 주기적인 특성을 명시적으로 포착할 수 있습니다. 이전 부분에서는 상태 시퀀스의 주파수 영역 분포가 전략의 성능을 반영할 수 있음을 이론적으로 증명했으며, 주파수 영역의 주파수 성분을 분석함으로써 명시적으로 다음을 수행할 수 있습니다. 상태 시퀀스의 주기적 특성을 포착합니다. 위 분석에서 영감을 받아 상태 시퀀스에서 구조적 정보를 추출하는 표현을 장려하기 위해 "무한 단계 미래 상태 시퀀스의 푸리에 변환 예측"이라는 보조 작업을 설계했습니다. 다음은 이 보조 작업의 모델링을 소개합니다. 현재 상태와 동작이 주어지면 미래 상태 시퀀스 기대치를 다음과 같이 정의합니다. 보조 작업은 위 상태 시퀀스 기대치의 이산시간 푸리에 변환(DTFT)을 예측하는 표현을 훈련합니다. 위의 푸리에 변환 공식은 다음과 같은 재귀 형식으로 다시 작성할 수 있습니다. where, 상태 공간의 차원은 입니다. 예측된 상태 시퀀스 푸리에 함수의 이산화 지점 수입니다. 그 중 손실 함수를 최적화해야 하는 표현 인코더(encoder)와 푸리에 함수 예측기(predictor)의 신경망 매개 변수가 있으며, 샘플 데이터를 저장하기 위한 경험 풀입니다. 또한 위의 재귀 공식이 압축 맵으로 표현될 수 있음을 증명할 수 있습니다. 정리 4: 함수군을 표현하고 에 표준을 정의합니다. 행렬의 행 벡터를 나타냅니다. 우리는 매핑을 으로 정의하고 이것이 압축된 매핑임을 증명할 수 있습니다. 압축 매핑의 원리에 따라 연산자를 반복적으로 사용하여 실제 상태 시퀀스의 주파수 영역 분포를 근사화하고 표 설정에서 수렴을 보장할 수 있습니다. 또한 우리가 설계한 손실 함수는 현재 순간과 다음 순간의 상태에만 의존하기 때문에 미래의 여러 단계의 상태 데이터를 예측 라벨로 저장할 필요가 없다는 장점이 있습니다. "간단한 구현과 낮은 저장 용량" . 아래에서는 본 논문에서 메소드(SPF)의 알고리즘 프레임워크를 소개합니다. 현재 순간과 다음 순간의 상태-행동 데이터를 각각 온라인과 타겟에 입력합니다.) 표현 인코더(encoder)에서 상태-동작 표현 데이터를 얻은 후, 표현 데이터를 푸리에 함수 예측기(predictor)에 입력하여 현재 순간과 다음 순간의 상태 시퀀스 푸리에 함수 예측 두 세트를 얻습니다. . 이 두 가지 푸리에 함수 예측 세트를 대체하여 손실 함수 값을 계산할 수 있습니다. 손실 함수를 최소화하여 표현 인코더와 푸리에 함수 예측기를 최적화하고 업데이트하여 예측기의 출력이 실제 상태 시퀀스의 푸리에 변환에 근접할 수 있도록 하여 표현 인코더가 다음을 포함하는 특징을 추출하도록 장려합니다. 장기 미래 상태 시퀀스의 구조적 정보 특성. 원래 상태와 행동을 표현 인코더에 입력하고, 획득한 특징을 강화학습 알고리즘의 배우 네트워크와 비평가 네트워크의 입력으로 사용하고, 클래식 강화학습 알고리즘을 사용하여 배우 네트워크와 비평가를 최적화합니다. 회로망. 실험 결과 (참고: 이 섹션에서는 실험 결과의 일부만 선택했습니다. 더 자세한 결과는 6장과 원 논문의 부록을 참조하세요.) We will SPF 이 방법은 MuJoCo 시뮬레이션 로봇 제어 환경에서 테스트되었으며 다음 6가지 방법을 비교했습니다. 위 그림은 6개의 MuJoCo 작업에서 우리가 제안한 SPF 방법(빨간색 선과 주황색 선)과 기타 비교 방법의 성능 곡선을 보여줍니다. 결과는 제안한 방법이 다른 방법에 비해 19.5%의 성능 향상을 달성할 수 있음을 보여줍니다. SPF 방식의 각 모듈에 대해 ablation 실험을 진행하여 이 방식을 프로젝터 모듈(noproj)을 사용하지 않는 방법, 대상 네트워크 모듈(notarg)을 사용하지 않는 방법, 예측 손실을 변경하는 방법과 비교했습니다. (nofreqloss) , 특징 인코더 네트워크 구조(mlp, mlp_cat)를 변경할 때 성능을 비교합니다. HalfCheetah 작업에서 테스트한 SAC 알고리즘에 적용된 SPF 방법의 절제 실험 결과 다이어그램 우리는 SPF 방법훈련된 예측기를 사용하여 Fu를 출력합니다. 상태 시퀀스 푸리에 함수와 역 푸리에 변환을 통해 복원된 200단계 상태 시퀀스를 실제 200단계 상태 시퀀스와 비교합니다. 결과는 더 긴 상태를 입력으로 사용하더라도 복구된 상태 시퀀스가 실제 상태 시퀀스와 매우 유사하다는 것을 보여줍니다. 이는 SPF 방법으로 학습된 표현이 상태에 포함된 구조를 효과적으로 인코딩할 수 있음을 보여줍니다. 시퀀스 정보. 상태 시퀀스의 구조 정보 분석

Markov Decision Process

트렌드 정보

정기 정보

방법 소개

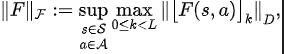

SPF 방법 손실 함수

Q-학습에서 Q-값 네트워크를 최적화하는 TD-오류 손실 함수[9]에서 영감을 받아 다음과 같은 손실 함수를 설계했습니다.

Q-학습에서 Q-값 네트워크를 최적화하는 TD-오류 손실 함수[9]에서 영감을 받아 다음과 같은 손실 함수를 설계했습니다.

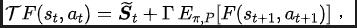

SPF 메소드 알고리즘 프레임워크

상태 시퀀스 주파수 영역 예측 기반 표현 학습 방법(SPF)의 알고리즘 프레임워크 다이어그램

상태 시퀀스 주파수 영역 예측 기반 표현 학습 방법(SPF)의 알고리즘 프레임워크 다이어그램

알고리즘 성능 비교

Ablation 실험

시각화 실험

Walker2d 작업에서 테스트된 푸리에 함수의 예측 값을 기반으로 복구된 상태 시퀀스의 개략도입니다. 그 중 파란색 선은 실제 상태 시퀀스의 개략도이고, 5개의 빨간색 선은 복원된 상태 시퀀스의 개략도입니다. 낮고 밝은 빨간색 선은 더 긴 이력 상태를 사용하여 복원된 상태 시퀀스를 나타냅니다.

Walker2d 작업에서 테스트된 푸리에 함수의 예측 값을 기반으로 복구된 상태 시퀀스의 개략도입니다. 그 중 파란색 선은 실제 상태 시퀀스의 개략도이고, 5개의 빨간색 선은 복원된 상태 시퀀스의 개략도입니다. 낮고 밝은 빨간색 선은 더 긴 이력 상태를 사용하여 복원된 상태 시퀀스를 나타냅니다.

위 내용은 중국 과학 기술 대학은 성능을 20% 향상시키고 샘플 효율성을 최대화하는 '상태 시퀀스 주파수 영역 예측' 방법을 개발합니다.의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!