요즘 집안일은 모두 로봇이 대신하고 있어요.

냄비를 사용할 수 있는 스탠포드의 로봇이 등장했고, 커피머신을 사용할 수 있는 로봇이 도착했습니다, Figure-01.

그림-01 시연영상을 시청하시고 10시간 교육만 받으시면 커피머신을 능숙하게 조작하실 수 있습니다. 커피 캡슐 삽입부터 시작 버튼 누르기까지 모두 한 번에 끝납니다.

그러나 다양한 가구, 가전제품을 접했을 때 시연 영상 없이 로봇이 스스로 사용법을 학습할 수 있도록 하는 것은 어려운 문제입니다. 이를 위해서는 로봇이 강력한 시각적 인식과 의사결정 계획 능력은 물론 정밀한 조작 기술을 갖춰야 합니다.

문서 링크: https://arxiv.org/abs/2312.01307

프로젝트 홈페이지: https://geometry.stanford.edu/projects/sage/

코드: https://github.com/ geng-haoran/SAGE

연구 문제 개요

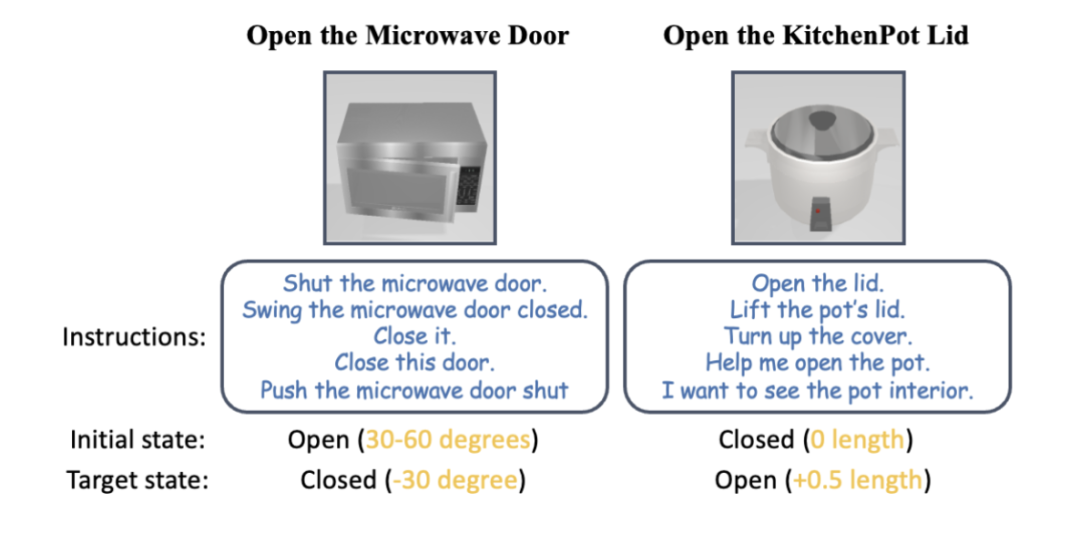

그림 1: 로봇 팔은 인간의 지시에 따라 별도의 지시 없이도 다양한 가전제품을 사용할 수 있습니다.

최근 PaLM-E와 GPT-4V는 로봇 작업 계획에 대형 그래픽 모델의 적용을 추진했으며, 시각적 언어를 통해 안내되는 일반화된 로봇 제어가 인기 있는 연구 분야가 되었습니다.

과거에는 상위 계층의 대형 그래픽 모델이 계획과 스킬 스케줄링을 담당하고, 하위 계층의 제어 스킬 전략 모델이 물리적인 행동 실행을 담당하는 2계층 시스템을 구축하는 것이 일반적이었습니다. 하지만 로봇이 지금까지 본 적 없는 다양한 가전제품을 마주하고 집안일에 다단계 작업이 필요한 경우 기존 방식의 상하층 모두 무력해질 것이다.

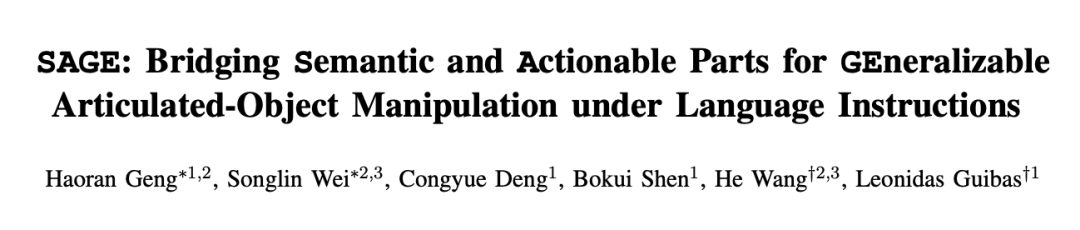

최첨단 그래픽 모델인 GPT-4V를 예로 들어보겠습니다. 텍스트로 단일 그림을 설명할 수 있지만 작동 가능한 부품의 감지, 계산, 위치 지정 및 상태 추정에 있어서는 여전히 오류가 가득합니다. 그림 2의 빨간색 하이라이트는 서랍장, 오븐, 스탠딩 캐비닛의 사진을 설명할 때 GPT-4V가 저지른 다양한 오류입니다. 잘못된 설명으로 인해 로봇의 스킬 스케줄링은 확실히 신뢰할 수 없습니다.

그림 2: GPT-4V는 계산, 감지, 포지셔닝 및 상태 추정과 같은 일반화된 제어에 초점을 맞춘 작업을 처리할 수 없습니다.

하위 제어 기술 전략 모델은 다양한 실제 상황에서 상위 그래픽 및 텍스트 모델이 제공하는 작업을 실행하는 역할을 담당합니다. 기존 연구 결과의 대부분은 알려진 일부 객체의 파악 지점과 작동 방식을 규칙에 따라 엄격하게 인코딩하고 있으며 일반적으로 이전에 볼 수 없었던 새로운 객체 범주를 다룰 수 없습니다. 그러나 RT-1, RT-2 등의 엔드투엔드 작업 모델은 RGB 형식만 사용하고 거리에 대한 정확한 인식이 부족하며 높이와 같은 새로운 환경의 변화에 대한 일반화가 부족합니다.

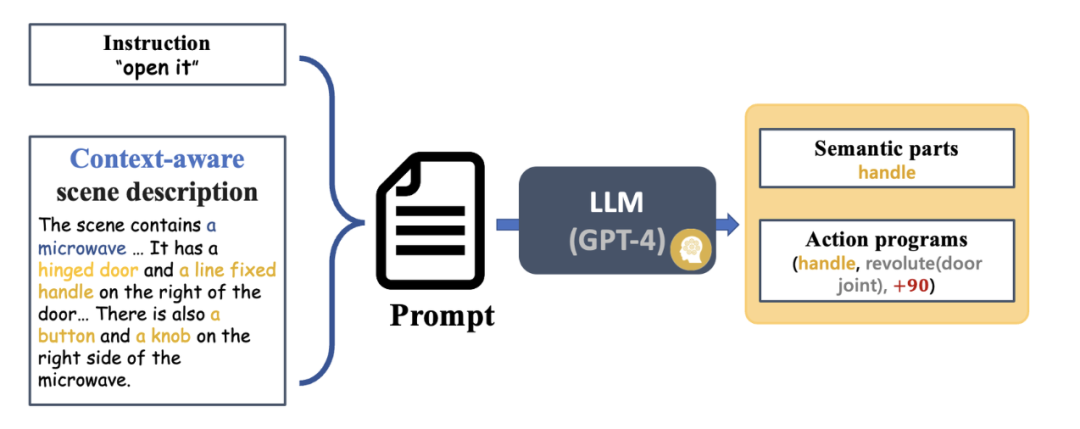

왕허 교수팀의 이전 CVPR 하이라이트 작업인 GAPartNet[1]에서 영감을 받아 연구팀은 다양한 가전제품 카테고리의 공통 부품(GAParts)에 중점을 두었습니다. 가전제품은 끊임없이 변화하지만, 각 가전제품과 이러한 공통 부품 사이에는 항상 유사한 기하학적 구조와 상호 작용 패턴이 있습니다.

그 결과 연구팀은 GAPartNet[1]이라는 논문에서 GAPart의 개념을 소개했습니다. GAPart는 일반화 가능하고 대화형 구성 요소를 나타냅니다. GAPart는 힌지 개체의 다양한 범주에 나타납니다. 예를 들어 힌지 도어는 금고, 옷장 및 냉장고에서 찾을 수 있습니다. 그림 3에서 볼 수 있듯이 GAPartNet [1]은 다양한 유형의 객체에 대한 GAPart의 의미와 포즈에 주석을 답니다.

그림 3: GAPart: 일반화 가능하고 대화형 부분 [1].

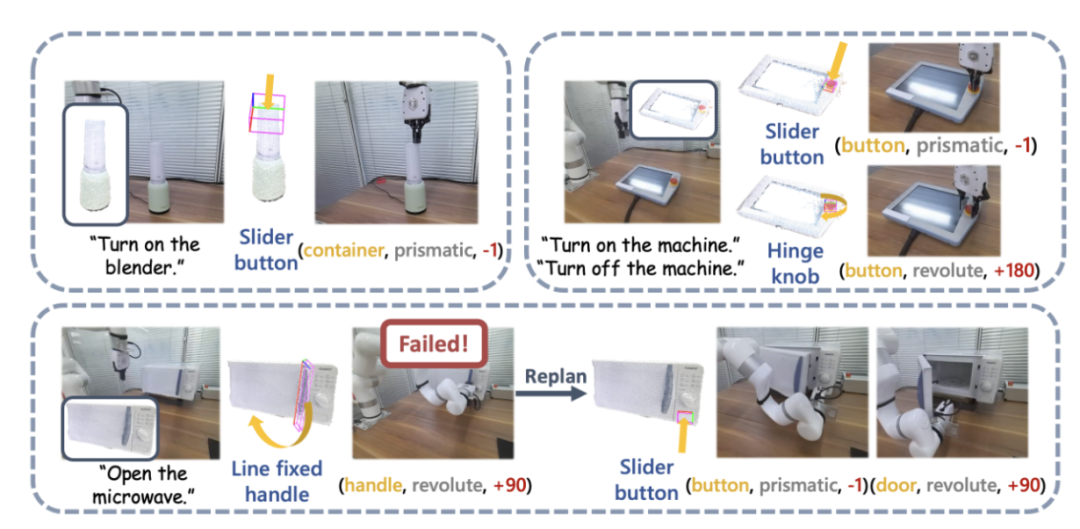

연구팀은 이전 연구를 바탕으로 로봇의 객체 조작 시스템 SAGE에 3차원 비전 기반의 GAPart를 창의적으로 도입했습니다. SAGE는 일반화 가능한 3D 부품 감지 및 정확한 자세 추정을 통해 VLM 및 LLM에 대한 정보를 제공합니다. 의사결정 수준에서 새로운 방법은 실행 수준에서 2차원 그래픽 모델의 정확한 계산 및 추론 능력이 부족하다는 문제를 해결하고, 강력한 물리적 연산 API를 기반으로 각 부분에 대한 일반화된 연산을 달성합니다. GAPart 포즈.

SAGE는 최초의 3차원 구현 그래픽 및 텍스트 대규모 모델 시스템으로, 인식, 물리적 상호 작용, 피드백까지 로봇의 전체 연결에 대한 새로운 아이디어를 제공하고 로봇이 다음과 같은 복잡한 객체를 지능적이고 보편적으로 제어할 수 있는 새로운 방법을 탐구합니다. 가구 및 가전 제품으로 실행 가능한 경로입니다.

시스템 소개

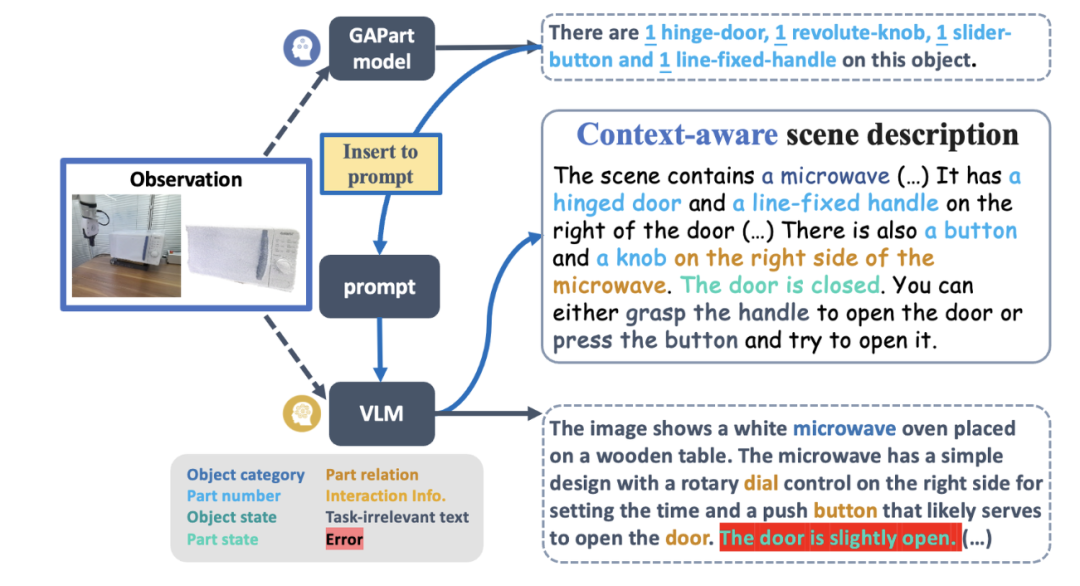

그림 4는 SAGE의 기본 프로세스를 보여줍니다. 먼저, 상황을 해석할 수 있는 명령 해석 모듈은 로봇에 입력된 명령과 관찰 내용을 구문 분석하고 이러한 구문 분석을 다음 로봇 동작 프로그램 및 관련 의미 부분으로 변환합니다. 다음으로 SAGE는 의미 부분(예: 컨테이너)을 작동해야 하는 부분(예: 슬라이더 버튼)에 매핑하고 작업(예: 버튼의 "누르기" 동작)을 생성하여 작업을 완료합니다.

그림 4: 방법 개요.

요약

SAGE는 가구, 가전제품 등 복잡한 관절 개체를 제어하기 위한 일반 명령을 생성할 수 있는 최초의 3D 시각적 언어 모델 프레임워크입니다. 객체 의미론과 부품 수준의 조작성 이해를 연결하여 언어가 지시하는 작업을 실행 가능한 조작으로 변환합니다.

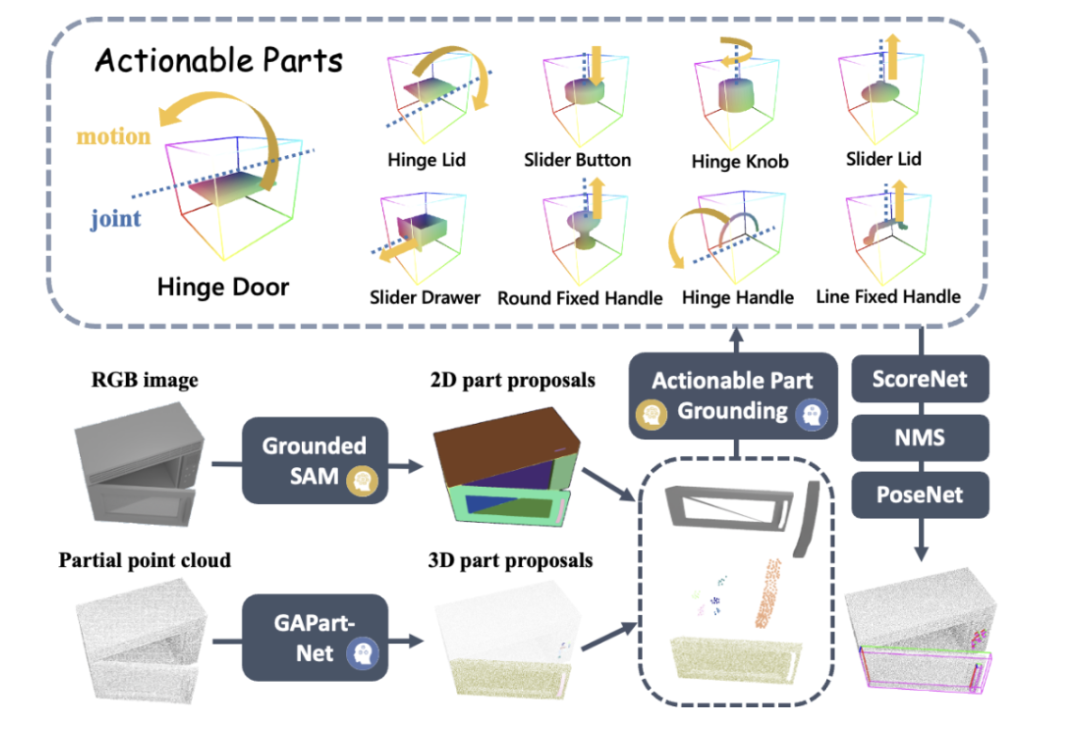

팀 소개

SAGE 이 연구 결과는 스탠포드 대학교 Leonidas Guibas 교수 연구실과 북경 대학교 Wang He 교수의 EPIC Lab(Embodied Perception and Interaction), Zhiyuan 인공 지능 연구소에서 나온 것입니다. 논문의 저자는 북경대학교 학생이자 스탠포드대학교 방문학자 Geng Haoran(공동저자), 북경대학교 박사과정 학생 Wei Songlin(공동저자), 스탠포드대학교 박사과정 학생 Deng Congyue 및 Shen Bokui이며 지도교수는 Leonidas 교수입니다. 기바스와 왕허 교수.참고자료:

[2] Kirillov, Alexander, Eric Mintun, Nikhila Ravi, Hanzi Mao, Chloe Rolland, Laura Gustafson, Tete Xiao et al. "무엇이든 분류하세요." arXiv 사전 인쇄 arXiv:2304.02643(2023).

[3] Zhang,Hao,Feng Li,Shilong Liu,Lei Zhang,Hang Su,Jun Zhu,Lionel M。Ni,Heung-Yeung Shum。"Dino: 종단 간 노이즈 제거 앵커 박스가 개선된 Detr 최종 개체 감지." arXiv 사전 인쇄 arXiv:2203.03605 (2022). [4] Xiang, Fanbo, Yuzhe Qin, Kaichun Mo, Yikuan Xia, Hao Zhu, Fangchen Liu, Minghua Liu 외."Sapien: 시뮬레이션된 부분 기반 대화형 환경." 컴퓨터 비전 및 패턴 인식에 관한 IEEE/CVF 회의 진행 중,pp。11097-11107。2020.

위 내용은 안내가 필요 없고 일반화된 시각화 모델에 사용할 수 있는 최초의 가구 및 가전제품용 범용 3D 그래픽 및 텍스트 모델 시스템의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!