모델 평가는 딥러닝과 머신러닝에서 매우 중요한 부분으로, 모델의 성능과 효과를 측정하는 데 사용됩니다. 이 기사에서는 혼동 행렬, 정확도, 정밀도, 재현율 및 F1 점수를 단계별로 분석합니다.

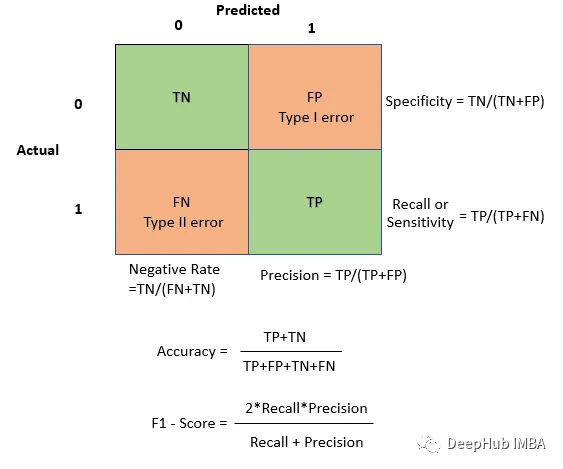

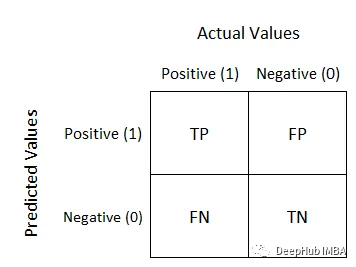

혼동 행렬은 분류에서 모델의 성능을 평가하는 데 사용됩니다. 문제는 샘플 분류표의 데모 모델입니다. 행은 실제 범주를 나타내고 열은 예측 범주를 나타냅니다. 이진 분류 문제의 경우 혼동 행렬의 구조는 다음과 같습니다.

초심자에게는 지저분해 보이지만 실제로는 매우 간단합니다. 뒤의 Negative/Positive는 모델 예측값이고 앞의 True/False는 모델 예측의 정확도입니다. 예를 들어 True Negative는 모델 예측이 음수이고 실제 값과 일치함, 즉 예측이 정확함을 의미합니다. 이렇게 하면 이해하기가 더 쉬워집니다. 다음은 간단한 혼동 행렬입니다.

from sklearn.metrics import confusion_matrix import seaborn as sns import matplotlib.pyplot as plt # Example predictions and true labels y_true = [1, 0, 1, 1, 0, 1, 0, 0, 1, 0] y_pred = [1, 0, 1, 0, 0, 1, 0, 1, 1, 1] # Create a confusion matrix cm = confusion_matrix(y_true, y_pred) # Visualize the blueprint sns.heatmap(cm, annot=True, fmt="d", cmap="Blues", xticklabels=["Predicted 0", "Predicted 1"], yticklabels=["Actual 0", "Actual 1"]) plt.xlabel("Predicted") plt.ylabel("Actual") plt.show()올바른 예측과 전반적인 정확성을 강조하려면 TP와 TN을 사용하세요. 모델에서 발생하는 오류 유형을 이해하려면 FP 및 FN을 사용하세요. 예를 들어, 오탐지 비용이 높은 애플리케이션에서는 오탐지 최소화가 중요할 수 있습니다.

예를 들어 스팸 분류기에 대해 이야기해 보겠습니다. 혼동 행렬은 분류자가 올바르게 식별한 스팸 이메일의 수와 스팸으로 잘못 표시한 스팸이 아닌 이메일의 수를 이해하는 데 도움이 됩니다

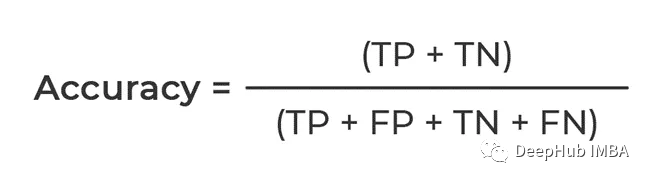

혼동 행렬을 기반으로 정확도, 정밀도, 리콜 및 F1 점수.

위의 요약에 따르면, 계산된 것은 정확하게 예측할 수 있는 비율입니다. 분자는 TP와 TN이 모두 참이라는 것입니다. 이는 에 의한 올바른 예측의 총 개수입니다. 모델

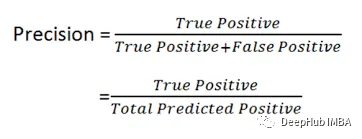

공식을 볼 수 있습니다. 양성의 비율, 즉 데이터에서 얼마나 많은 양성이 올바르게 예측되었는지 계산하므로 정밀도를 정밀도율이라고도 합니다

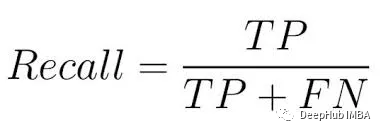

이는 허위 경보로 인해 심각한 결과나 비용이 발생하는 상황에서 매우 중요합니다. 의료 진단 모델을 예로 들면, 정말 치료가 필요한 사람만 치료를 받을 수 있도록 정확도가 보장됩니다. 민감도 또는 진양성율이라고도 불리는 리콜은 모든 양성 클래스를 포착하는 모델을 말합니다.

공식에서 볼 수 있듯이, 주요 목적은 모델이 포착한 실제 긍정적 사례의 수, 즉 긍정적 사례의 비율을 계산하는 것입니다. 따라서 Recall을 Recall rate라고도 합니다

F1 Score

F1 점수 계산 공식은 다음과 같습니다. F1 = 2 * (정밀도 * 재현율) / (정밀도 + 재현율) 그 중 정밀도(Precision)는 모델이 긍정적 사례로 예측한 표본이 실제 긍정적 사례인 비율을 의미하며, 재현율은 모델이 긍정적 사례로 정확하게 예측한 표본 수와 실제 긍정적 사례로 예측된 표본 수의 비율을 의미합니다. 긍정적인 예. F1 점수는 정밀도와 재현율의 조화 평균으로 모델의 성능을 평가하기 위해 모델의 정확성과 포괄성을 종합적으로 고려할 수 있습니다

F1 점수는 정밀도와 재현율을 모두 제공하므로 중요합니다. 요금 사이에서 할인됩니다. 정밀도와 재현율 사이의 균형을 찾고 싶거나 일반적인 응용 분야에 F1 Score를 사용할 수 있습니다.

이 글에서는 혼동행렬, 정확도, 정밀도, 재현율, F1 점수에 대해 자세히 소개했고, 이러한 지표들이 모델의 성능을 효과적으로 평가하고 향상시킬 수 있음을 지적했습니다

위 내용은 분류 모델 평가 지표를 하나의 기사로 읽어보세요.의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!