Meta의 새로운 비디오 합성 프레임워크는 우리에게 놀라움을 안겨주었습니다

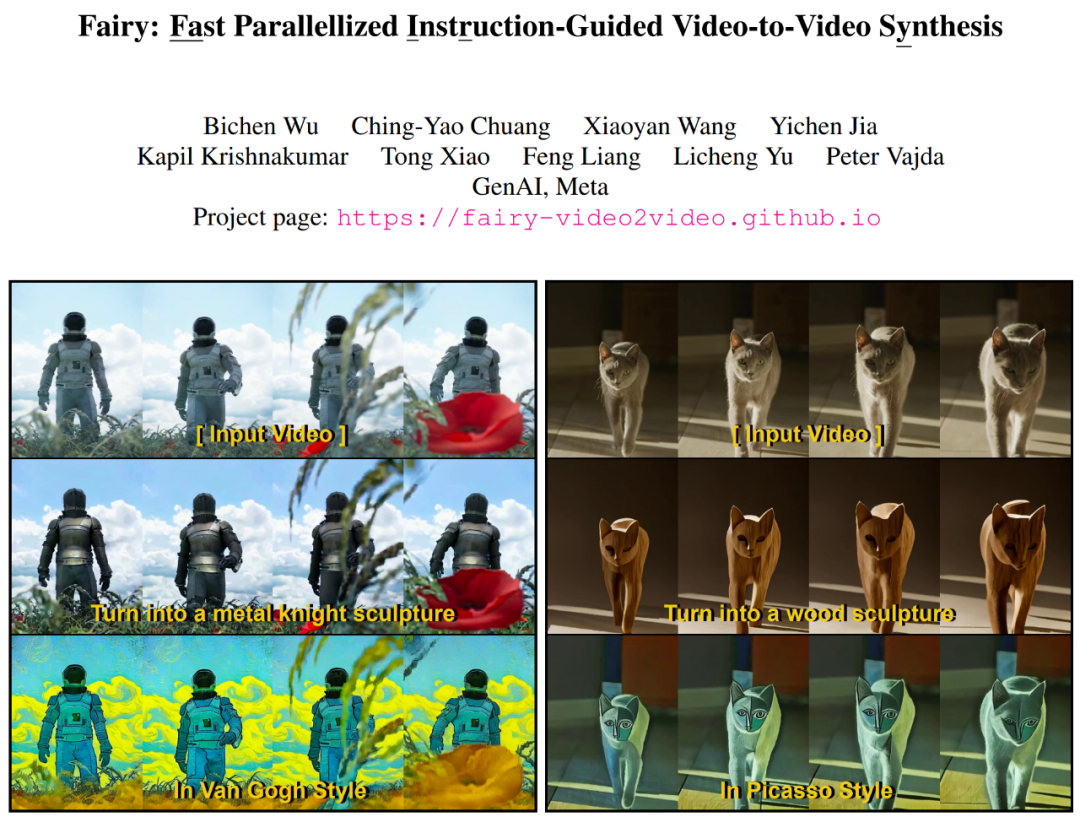

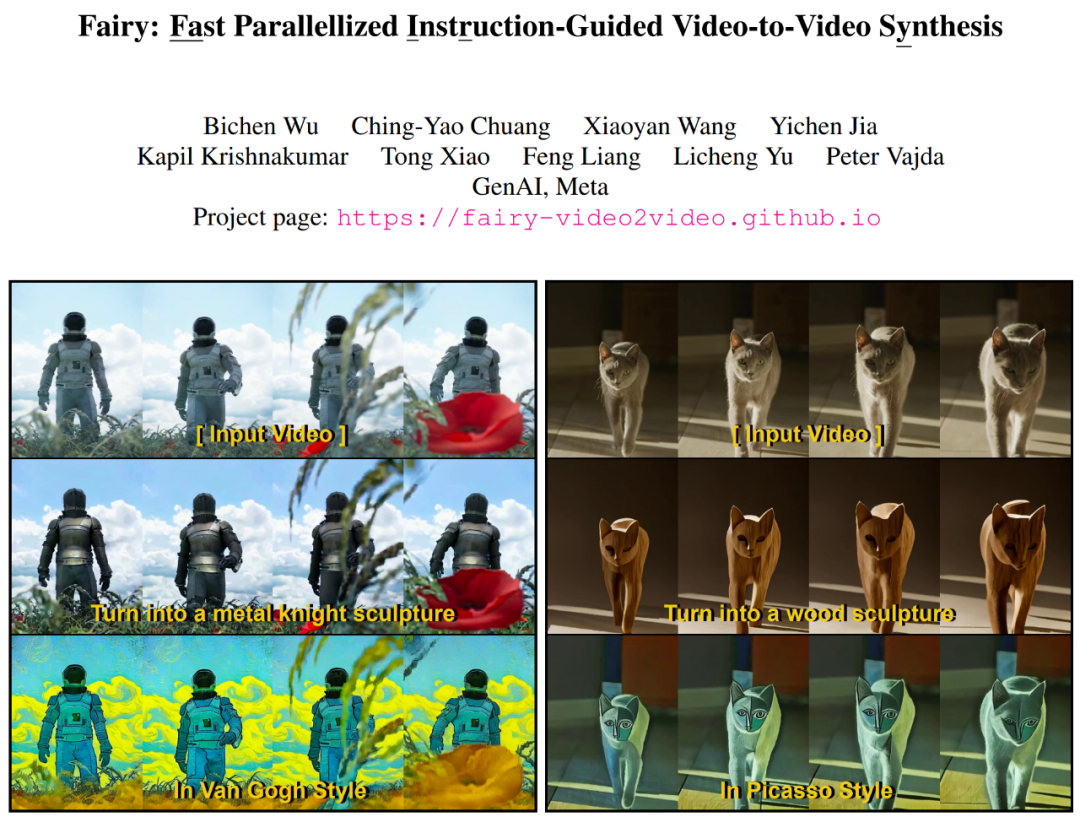

오늘날의 인공 지능 개발 수준으로 볼 때 텍스트 기반 그림, 그림 기반 비디오, 이미지/비디오 스타일 전송은 어려운 문제가 아닙니다. 생성 AI는 손쉽게 콘텐츠를 생성하거나 수정할 수 있는 능력을 갖추고 있습니다. 특히 이미지 편집은 수십억 규모의 데이터 세트에 대해 사전 훈련된 텍스트-이미지 확산 모델에 힘입어 상당한 성장을 경험했습니다. 이 물결로 인해 수많은 이미지 편집 및 콘텐츠 제작 앱이 탄생했습니다. 이미지 기반 생성 모델의 성과를 바탕으로 다음 과제는 여기에 "시간 차원"을 추가하여 쉽고 창의적인 비디오 편집을 달성하는 것입니다. 간단한 전략은 이미지 모델을 사용하여 비디오를 프레임별로 처리하는 것입니다. 그러나 생성적 이미지 편집은 본질적으로 매우 가변적입니다. 동일한 텍스트 프롬프트에서도 주어진 이미지를 편집할 수 있는 방법은 셀 수 없이 많습니다. 각 프레임을 독립적으로 편집하면 시간적 일관성을 유지하기가 어렵습니다. 최근 논문에서 Meta GenAI 팀의 연구원들은 비디오 편집에서 AI의 성능을 크게 향상시키는 이미지 편집 확산 모델의 "간단한 적응"인 Fairy를 제안했습니다. 다음은 Fairy의 편집 비디오 효과 표시입니다.

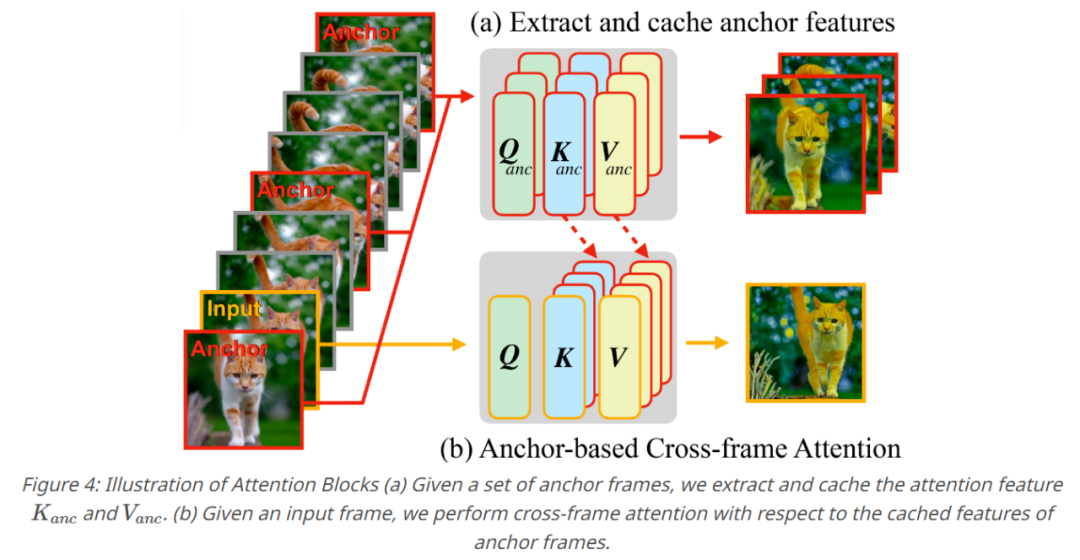

Fairy는 단 14초 만에 512×384 비디오(4초 길이, 30FPS)의 120프레임을 생성합니다. 초, 이는 이전 방법보다 최소 44배 빠릅니다. 생성된 1000개의 샘플을 대상으로 한 포괄적인 사용자 연구에서는 제안된 방법이 높은 품질을 생성하고 기존 방법보다 훨씬 뛰어난 성능을 발휘한다는 것을 확인했습니다. 논문에 따르면 Fairy는 앵커 포인트를 기반으로 한 프레임 간 주의 개념을 기반으로 합니다. 이 메커니즘은 프레임 전체에 확산 기능을 암시적으로 전파하여 시간 일관성과 충실도가 높은 합성 효과를 보장할 수 있습니다. Fairy는 메모리 및 처리 속도 측면에서 이전 모델의 한계를 해결할 뿐만 아니라 모델을 소스 이미지와 대상 이미지의 아핀 변환과 동일하게 만드는 고유한 데이터 증대 전략을 통해 시간적 일관성을 향상시킵니다.

- 논문 주소: https://arxiv.org/pdf/2312.13834.pdf

- 프로젝트 홈페이지: https://fairy-video2video.github.io/

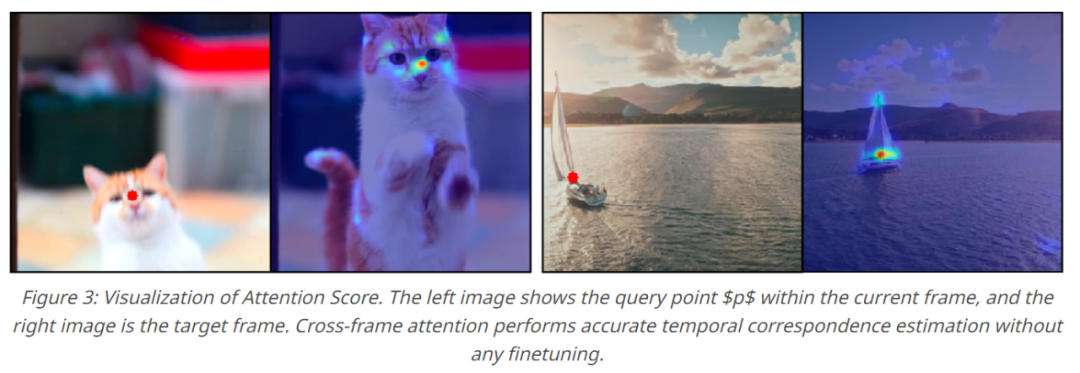

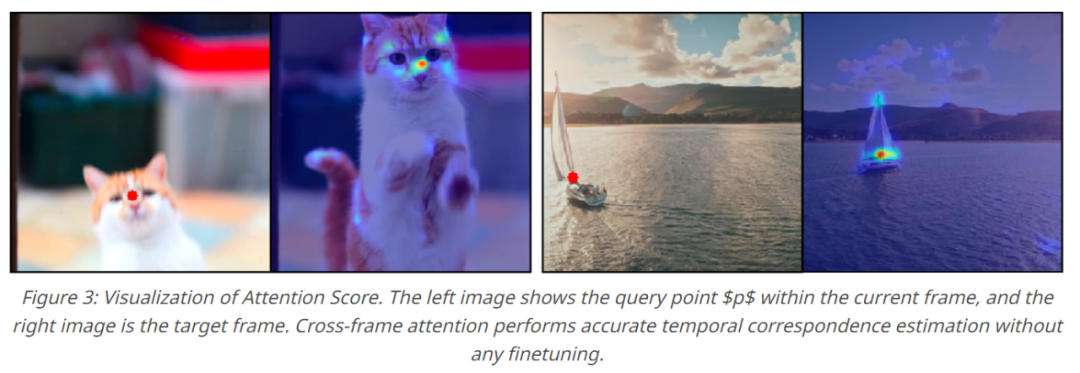

Fairy는 확산 모델 특성의 맥락에서 이전의 추적 및 전파 패러다임을 재검토합니다. 특히, 이 연구에서는 대응 추정을 사용하여 프레임 간 주의를 연결함으로써 모델이 확산 모델 내에서 중간 기능을 추적하고 전파할 수 있도록 합니다. 프레임 전반에 걸친 주의 지도는 각 프레임의 토큰 간의 대응성을 평가하기 위한 유사성 측정으로 해석될 수 있습니다. 여기서 한 의미 영역의 기능은 다른 프레임에 더 높은 관심을 할당합니다. 유사한 의미 영역(아래 그림 3 참조) . 따라서 현재의 특징 표현은 프레임 간 유사한 영역의 가중치 합에 초점을 맞춰 정제 및 전파되므로 프레임 간 특징 차이를 효과적으로 최소화할 수 있습니다.

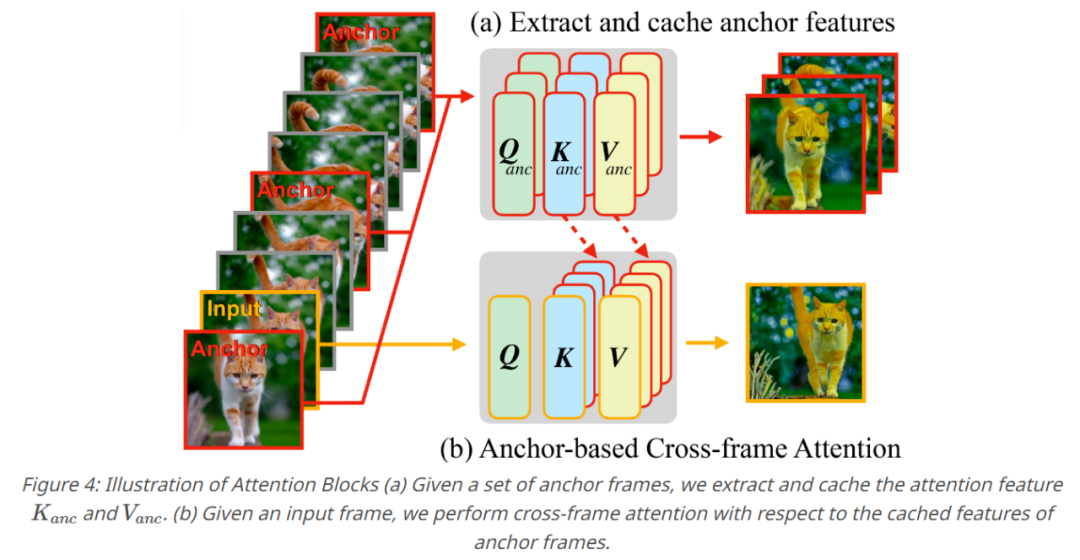

일련의 작업을 통해 Fairy의 핵심 구성 요소인 앵커 기반 모델이 생성됩니다. 생성된 영상의 시간적 일관성을 보장하기 위해 본 연구에서는 K개의 앵커 프레임을 샘플링하여 확산 특징을 추출했으며, 추출된 특징은 연속 프레임에 전파될 전역 특징의 집합으로 정의되었습니다. 이 연구에서는 각각의 새로운 프레임이 생성될 때 앵커 프레임의 캐시된 특징에 대해 Self-Attention 레이어를 Cross-Frame Attention으로 대체합니다. 프레임 간 주의를 통해 각 프레임의 토큰은 앵커 프레임에서 유사한 의미 내용을 나타내는 기능을 채택하여 일관성을 향상시킵니다.

실험 부분에서 연구자들은 주로 교육용 이미지 편집 모델을 기반으로 Fairy를 구현했으며, 모델의 Self-Attention을 대체하기 위해 Cross-Frame Attention을 사용했습니다. 앵커 프레임 수를 3으로 설정했습니다. 모델은 다양한 종횡비의 입력을 수용하고 더 긴 크기의 입력 해상도를 512로 조정하여 종횡비를 변경하지 않고 유지할 수 있습니다. 연구원들은 다운샘플링 없이 입력 비디오의 모든 프레임을 편집합니다. 모든 계산은 8개의 A100 GPU에 분산됩니다. 연구원은 먼저 Fairy의 정성적 결과를 보여줬는데, 아래 그림 5와 같이 Fairy는 다양한 주제를 편집할 수 있습니다.

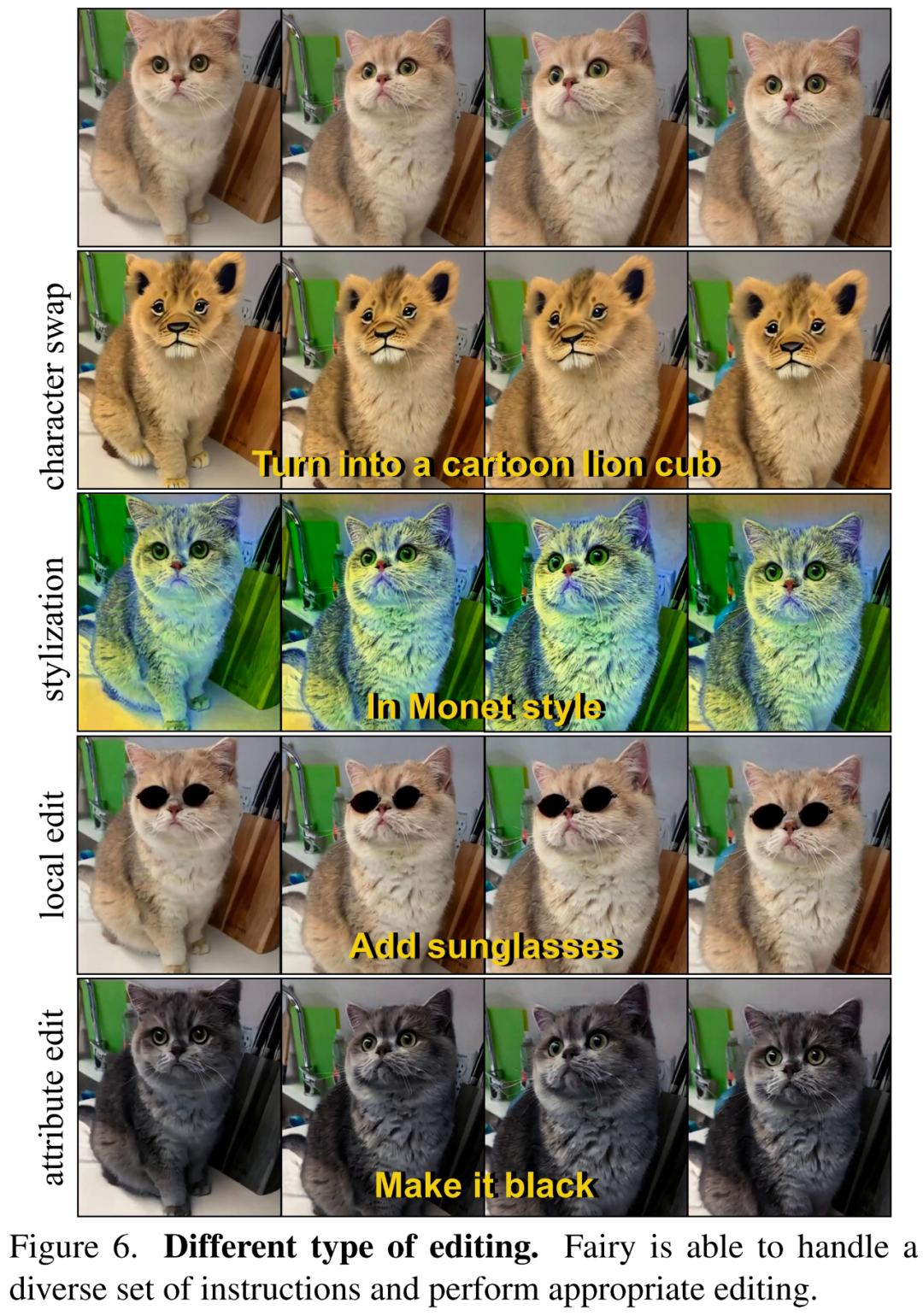

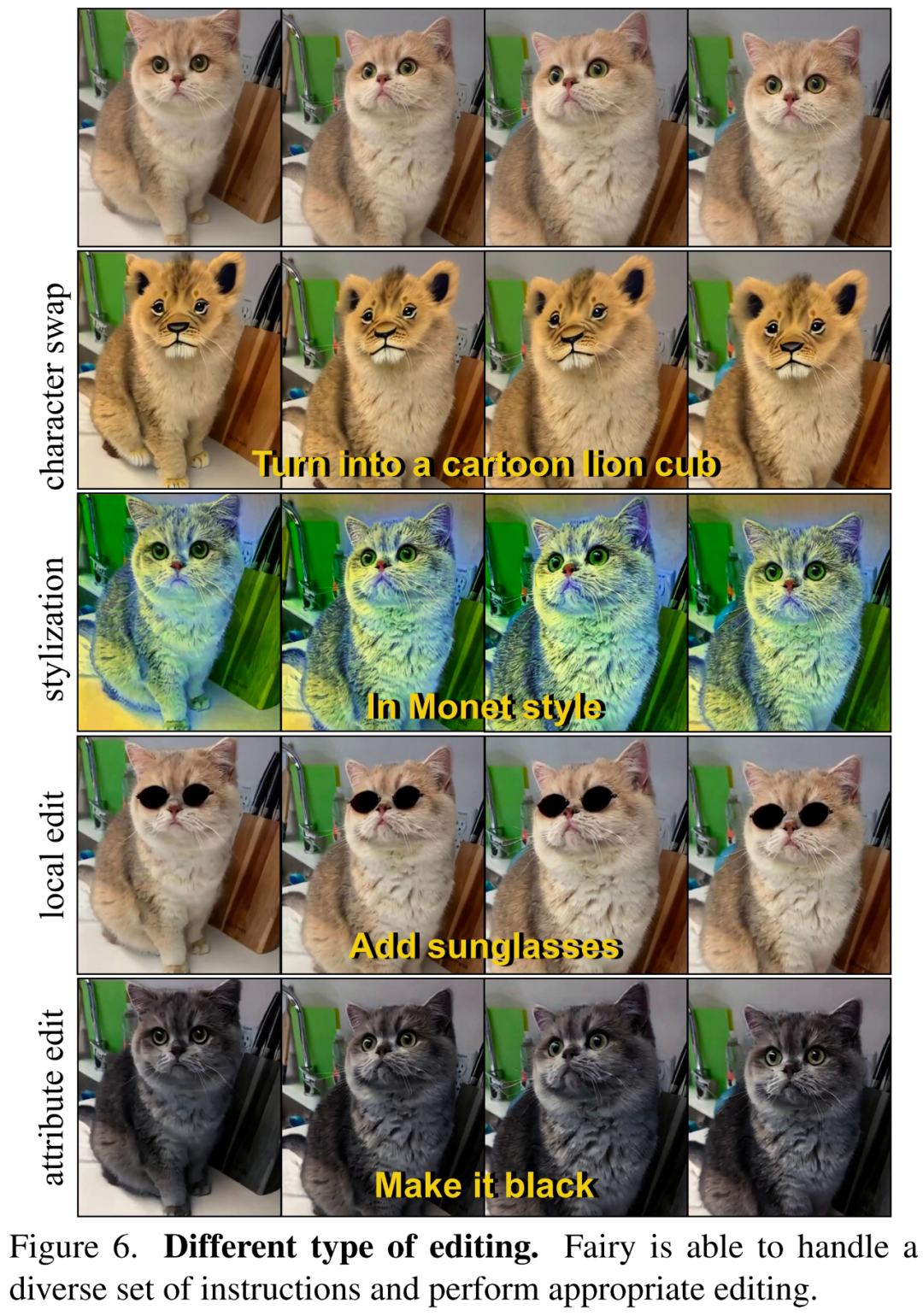

아래 그림 6에서 연구원은 Fairy가 스타일 지정, 역할 변경, 로컬 편집, 속성 편집 등을 포함하여 텍스트 지침에 따라 다양한 유형의 편집을 수행할 수 있음을 보여줍니다.

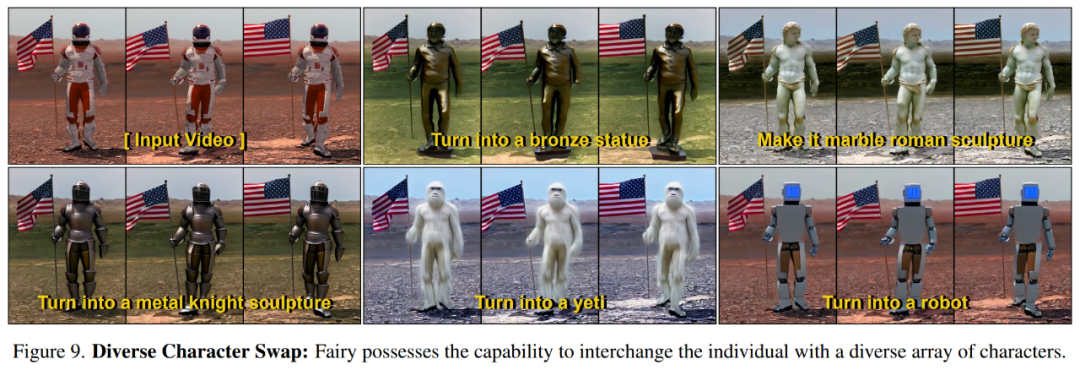

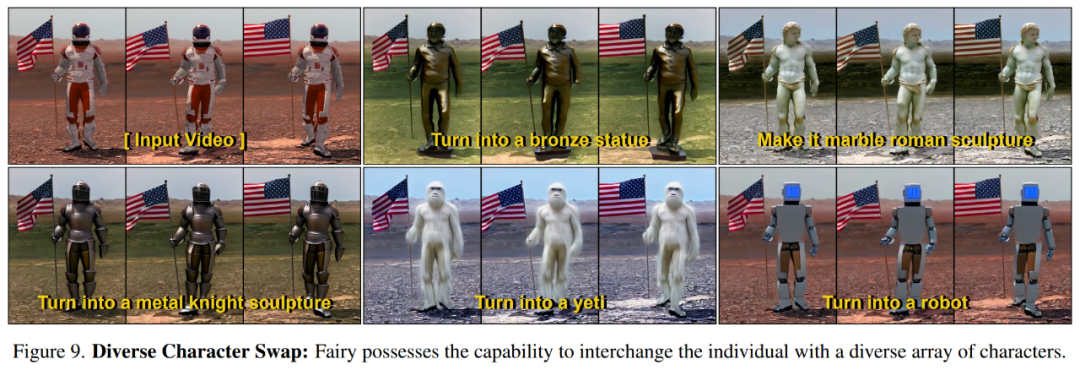

아래 그림 9에서는 Fairy가 지시에 따라 소스 캐릭터를 다른 대상 캐릭터로 변환할 수 있음을 보여줍니다.

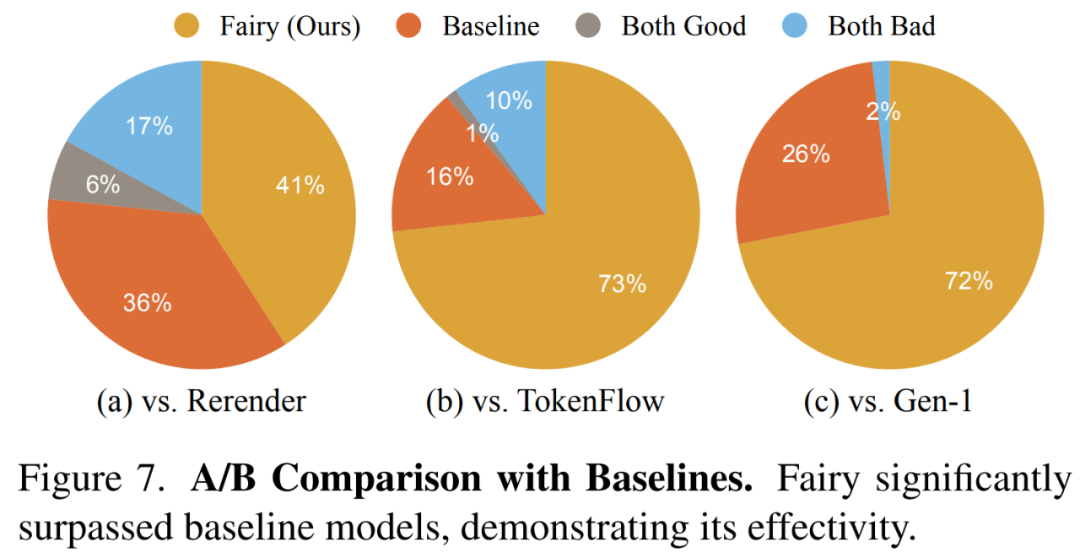

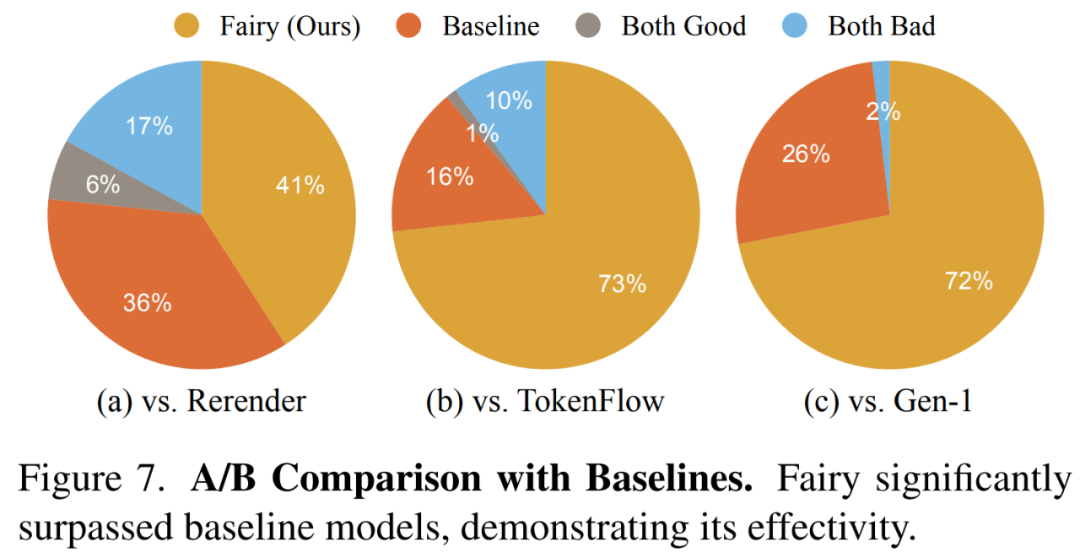

연구원들은 아래 그림 7에 전체적인 품질 비교 결과를 보여주었는데, 여기서는 Fairy가 제작한 영상이 더 인기가 있었습니다.

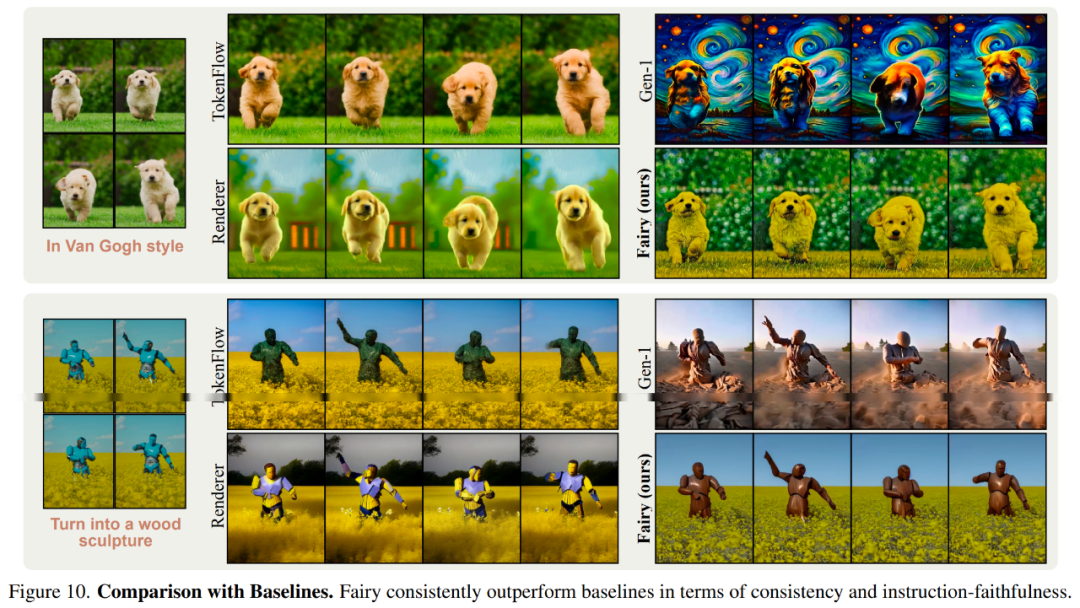

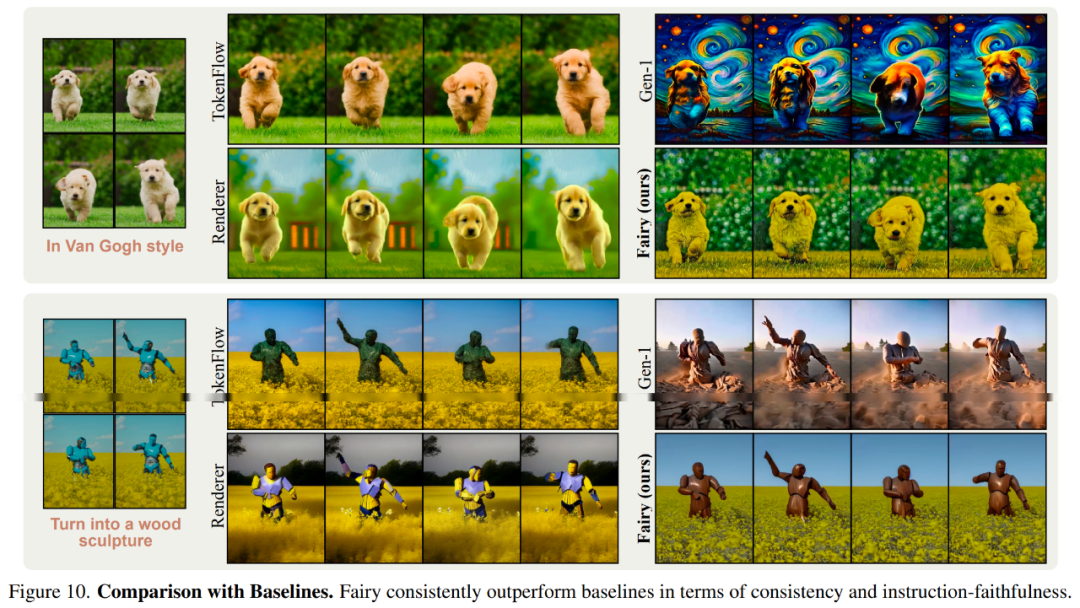

아래 그림 10은 기준 모델과의 시각적 비교 결과를 보여줍니다.

자세한 기술적 내용과 실험 결과는 원본 논문을 참조하세요. 위 내용은 14초 만에 영상을 재구성할 수 있고, 캐릭터를 변경할 수 있어 영상 합성 속도가 44배 빨라진다.의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!