최근에는 손을 흔들고 가랑이를 반쯤 벌리고 리드미컬한 음악을 맞추는 '제목 3'에 대해 많이 들어보셨을 것입니다.

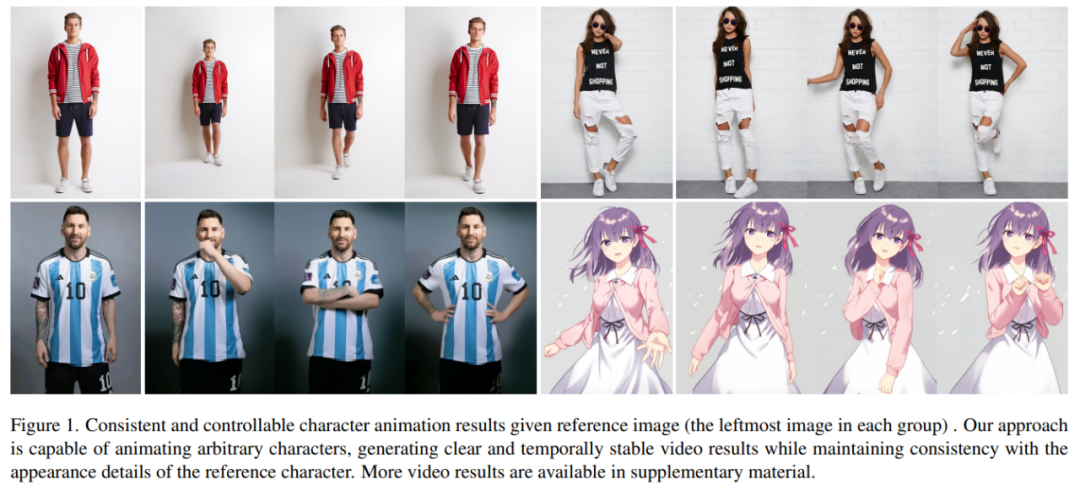

AI가 비슷한 춤을 만들어낸다면 어떻게 될까요? 아래 사진처럼 현대인과 종이인 모두 획일적인 움직임을 하고 있습니다. 여러분이 짐작하지 못할 수도 있는 것은 이것이 사진에서 생성된 댄스 비디오라는 것입니다.

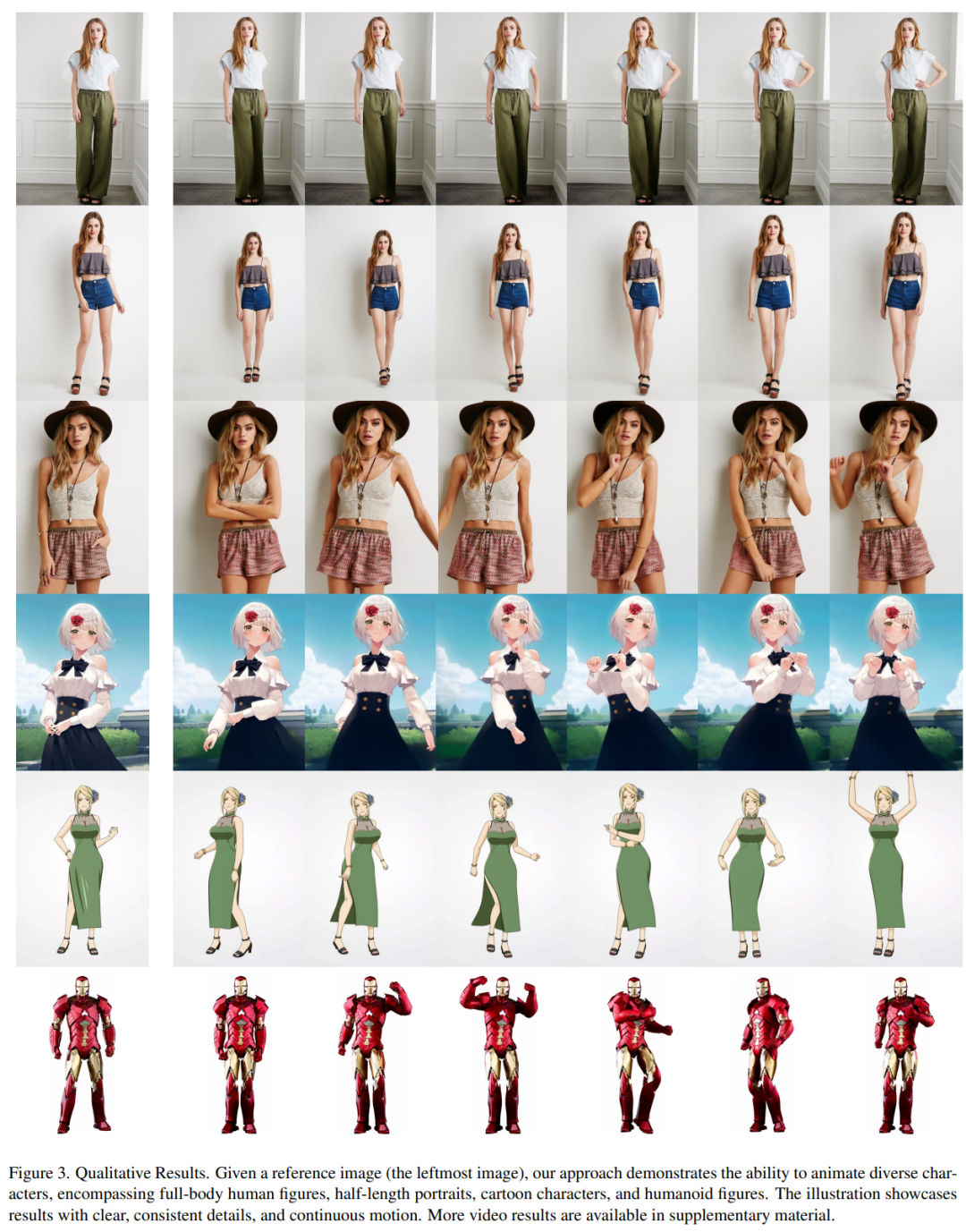

캐릭터 움직임이 더 어려워지고 생성된 비디오도 매우 매끄러워집니다(맨 오른쪽):

메시와 아이언맨을 움직이게 하는 것은 쉽습니다:

다양한 애니메이션 소녀들도 있습니다.

이러한 효과는 어떻게 달성되나요? 계속 읽어보세요

캐릭터 애니메이션은 원본 캐릭터 이미지를 원하는 포즈 순서에 따라 사실적인 동영상으로 변환하는 과정입니다. 이 작업은 온라인 소매, 엔터테인먼트 비디오, 예술 창작, 가상 캐릭터 등 많은 잠재적인 응용 분야를 가지고 있습니다.

GAN 기술의 출현 이후 연구자들은 이미지를 애니메이션으로 변환하고 완성하는 방법을 지속적으로 심층적으로 탐구해 왔습니다. 포즈 전송 방법. 그러나 생성된 이미지나 영상에는 여전히 국부적 왜곡, 흐릿한 디테일, 의미적 불일치, 시간적 불안정성 등의 문제가 있어 이러한 방법의 적용을 방해하고 있습니다.

Ali 연구진은 Animate Anybody라는 방법을 제안하여 캐릭터 이미지를 변환하는 방법을 제안했습니다. 원하는 포즈 순서를 따르는 애니메이션 비디오로. 이 연구에서는 Stable Diffusion 네트워크 설계와 사전 훈련된 가중치를 채택하고 다중 프레임 입력

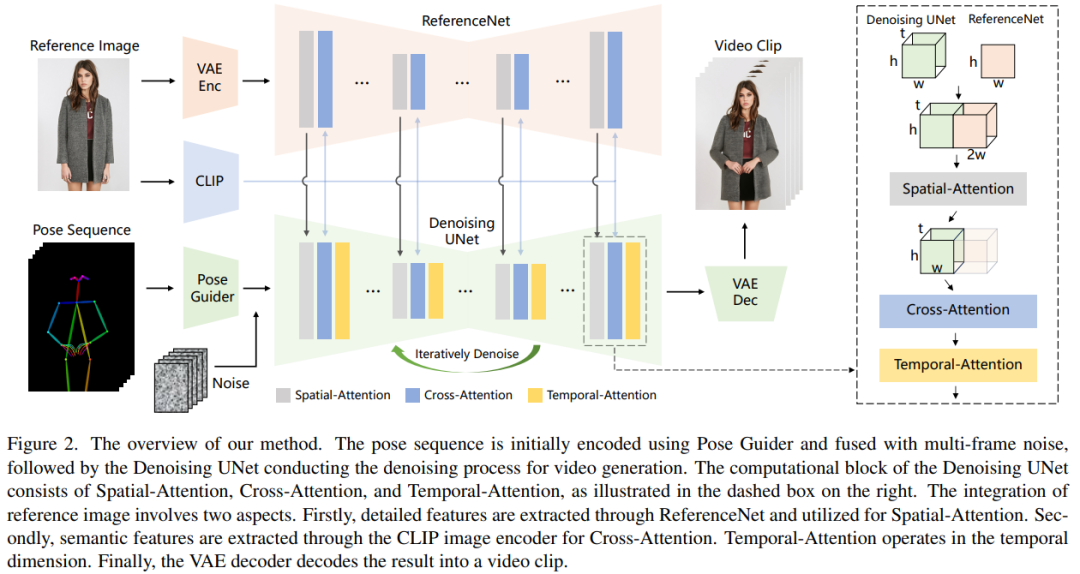

연구에서는 일관된 모습을 유지하기 위해 ReferenceNet을 도입했습니다. 네트워크는 대칭형 UNet 구조를 채택하고 참조 이미지의 공간적 세부 정보를 캡처하는 것을 목표로 합니다. 각 해당 UNet 블록 계층에서 이 연구는 공간 주의 메커니즘을 사용하여 ReferenceNet의 기능을 잡음 제거 UNet에 통합합니다. 이 아키텍처를 통해 모델은 일관된 특징 공간에서 참조 이미지와의 관계를 포괄적으로 학습할 수 있습니다.

포즈 제어성을 보장하기 위해 이 연구에서는 포즈를 효과적으로 제어할 수 있는 경량 포즈 가이드를 설계했습니다. 신호는 노이즈 제거 프로세스에 통합됩니다. 시간적 안정성을 달성하기 위해 이 논문에서는 시간적 레이어를 도입하여 여러 프레임 간의 관계를 모델링함으로써 연속적이고 부드러운 시간적 모션 프로세스를 시뮬레이션하는 동시에 시각적 품질의 고해상도 세부 정보를 유지합니다.

Animate Anybody는 그림 1과 같이 다양한 캐릭터에 대한 애니메이션 결과를 보여주는 5K 캐릭터 비디오 클립의 내부 데이터 세트에 대해 교육을 받았습니다. 이전 방법과 비교할 때 이 문서의 방법에는 몇 가지 확실한 장점이 있습니다.

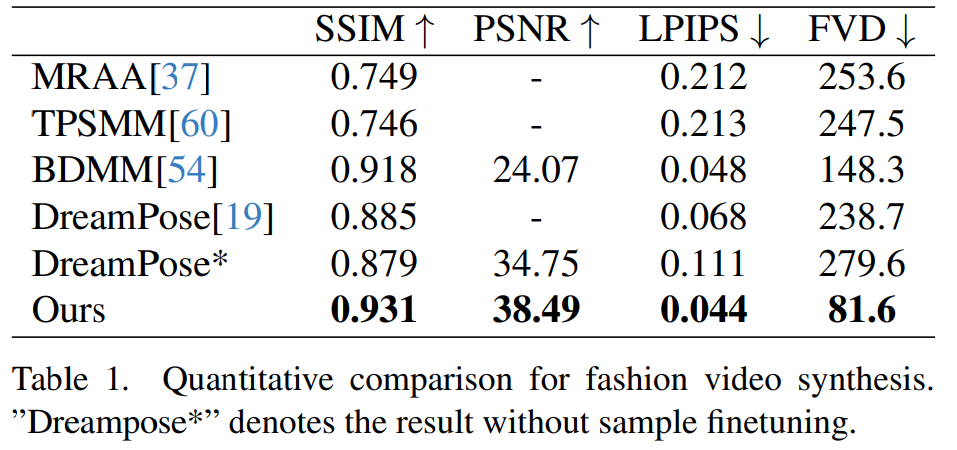

이 문서는 두 가지 특정 인간 비디오 합성 벤치마크(UBC Fashion Video Dataset 및 TikTok Dataset)에서 평가되었습니다. 결과는 Animate Anybody가 SOTA 결과를 달성했음을 보여줍니다. 또한, 본 연구에서는 Animate Anybody 방식을 대규모 데이터로 훈련된 일반적인 이미지-비디오 방식과 비교하여 Animate Anybody가 캐릭터 애니메이션에서 탁월한 기능을 입증했음을 보여주었습니다.

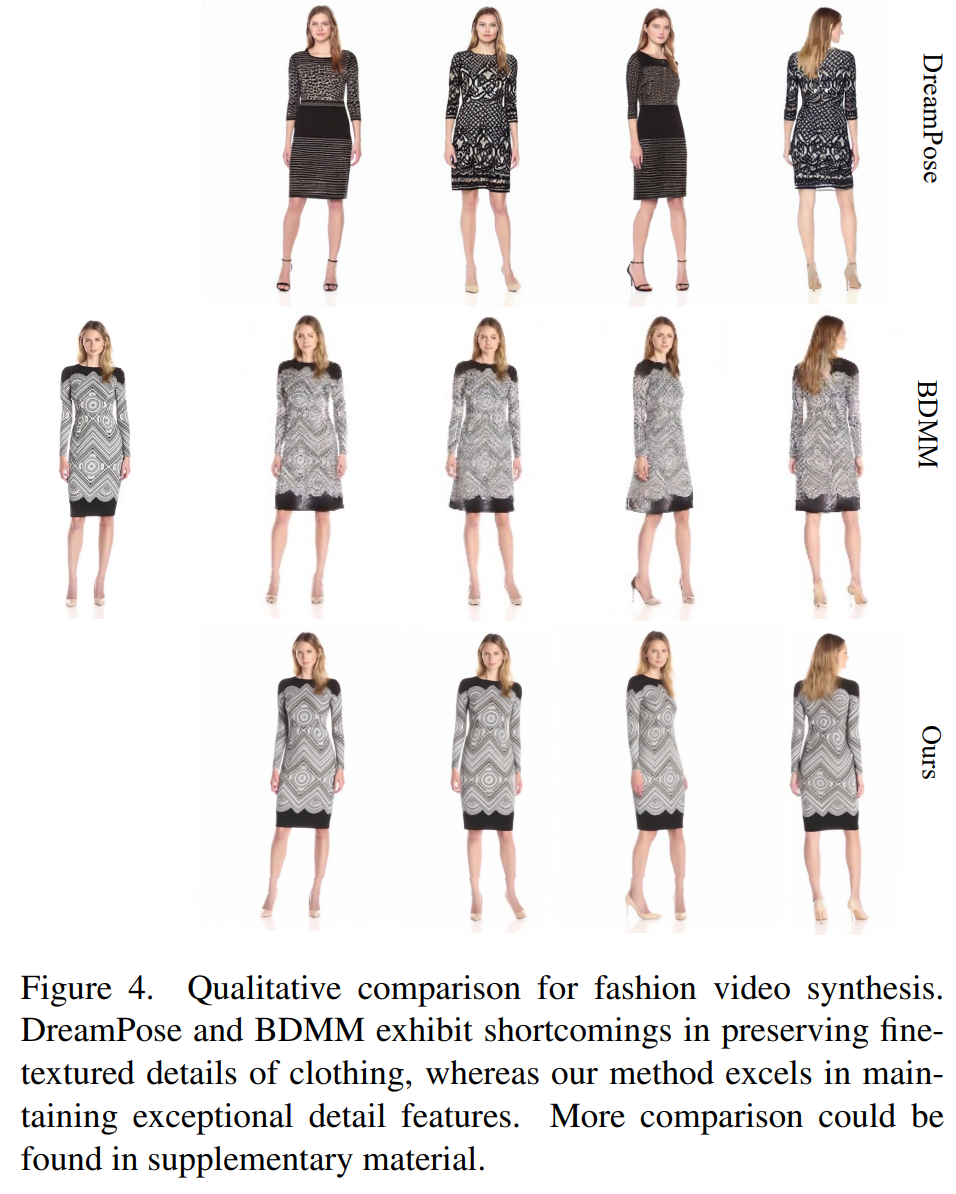

Animate Anybody 다른 방법과 비교:

이 문서의 처리 방법은 그림 2에 나와 있습니다. 네트워크의 원래 입력 다중 프레임 노이즈로 구성됩니다. 잡음 제거 효과를 달성하기 위해 연구자들은 동일한 프레임워크와 블록 단위를 사용하고 SD에서 훈련 가중치를 상속하는 SD 설계 기반 구성을 채택했습니다. 구체적으로 이 방법에는 세 가지 핵심 부분이 포함됩니다. 즉, 참조 이미지 캐릭터의 외관 특성을 인코딩하는

ReferenceNet

ReferenceNet은 참조 이미지 특징 추출 네트워크이며 프레임워크는 잡음 제거 UNet과 거의 동일하며 시간 계층만 다릅니다. 따라서 ReferenceNet은 잡음 제거 UNet과 유사한 원래 SD 가중치를 상속하며 각 가중치 업데이트는 독립적으로 수행됩니다. 연구원들은 ReferenceNet의 기능을 노이즈 제거 UNet에 통합하는 방법을 설명합니다.

ReferenceNet은 두 가지 장점을 갖도록 설계되었습니다. 첫째, ReferenceNet은 원시 SD의 사전 훈련된 이미지 특징 모델링 기능을 활용하여 잘 초기화된 기능을 생성할 수 있습니다. 둘째, ReferenceNet과 잡음 제거 UNet은 본질적으로 동일한 네트워크 구조와 공유 초기화 가중치를 가지므로 잡음 제거 UNet은 ReferenceNet에서 동일한 기능 공간에 연결된 기능을 선택적으로 학습할 수 있습니다.

자세 가이드

다시 작성된 내용은 다음과 같습니다. 이 경량 자세 가이드는 4개의 컨볼루션 레이어(4×4 커널, 2×2 스트라이드)를 사용하며 채널 수는 각각 16, 32, 64입니다. , 128은 [56]의 조건부 인코더와 유사하며 기본 노이즈와 동일한 해상도로 포즈 이미지를 정렬하는 데 사용됩니다. 처리된 포즈 이미지는 잠재 잡음에 추가된 후 처리를 위해 잡음 제거 UNet에 입력됩니다. 포즈 가이드는 가우시안 가중치로 초기화되고 최종 매핑 레이어에서 컨볼루션 0을 사용합니다.

임시 레이어

임시 레이어의 디자인은 AnimateDiff에서 영감을 받았습니다. 특징 맵 x∈R^b×t×h×w×c에 대해 연구자는 먼저 이를 x∈R^(b×h×w)×t×c로 변형한 후 Temporal attention을 수행합니다. 차원 t의 Self-Attention. 시간 계층의 특징은 잔여 연결을 통해 원래 특징에 병합됩니다. 이 설계는 아래의 2단계 학습 방법과 일치합니다. 시간 레이어는 노이즈 제거 UNet의 Res-Trans 블록 내에서만 사용됩니다.

훈련 전략

훈련 과정은 두 단계로 나뉩니다.

재작성된 콘텐츠: 훈련의 첫 번째 단계에서는 단일 비디오 프레임이 훈련에 사용됩니다. 잡음 제거 UNet 모델에서 연구원들은 임시 계층을 일시적으로 제외하고 단일 프레임 잡음을 입력으로 사용했습니다. 동시에 참조 네트워크와 태도 가이드도 훈련됩니다. 참조 이미지는 전체 비디오 클립에서 무작위로 선택됩니다. 그들은 사전 훈련된 가중치를 사용하여 잡음 제거 UNet 및 ReferenceNet 모델을 초기화했습니다. 포즈 가이드는 0 컨볼루션을 사용하는 최종 투영 레이어를 제외하고 가우스 가중치로 초기화됩니다. VAE 인코더 및 디코더와 CLIP 이미지 인코더의 가중치는 변경되지 않습니다. 이 단계의 최적화 목표는 참조 이미지와 대상 포즈를 고려하여 고품질 애니메이션 이미지를 생성하는 것입니다

두 번째 단계에서 연구원들은 이전에 훈련된 모델에 시간 계층을 도입하고 AnimateDiff를 사용하여 훈련된 모델을 사전 초기화했습니다. 무게. 모델에 대한 입력은 24프레임 비디오 클립으로 구성됩니다. 이 단계에서는 시간 계층만 훈련되고 네트워크의 다른 부분의 가중치는 고정됩니다.

질적 결과: 그림 3에서 볼 수 있듯이 이 방법을 사용하면 전신 인물 사진, 반신 인물 사진, 만화 캐릭터, 인간형 캐릭터 등 모든 캐릭터의 애니메이션을 제작할 수 있습니다. 이 방법은 고화질의 사실적인 인체 디테일을 생성할 수 있습니다. 참조 이미지와의 시간적 일관성을 유지하고 큰 움직임이 있는 경우에도 프레임 간 시간적 연속성을 나타냅니다.

패션 영상 합성. 패션 비디오 합성의 목표는 구동되는 포즈 시퀀스를 사용하여 패션 사진을 사실적인 애니메이션 비디오로 변환하는 것입니다. 실험은 각각 약 350개의 프레임을 포함하는 500개의 훈련 비디오와 100개의 테스트 비디오로 구성된 UBC 패션 비디오 데이터세트에서 수행됩니다. 정량적 비교는 표 1에 나와 있습니다. 본 논문의 방법이 다른 방법에 비해 우수함을 결과에서 확인할 수 있으며, 특히 영상 측정 지표에서는 뚜렷한 단서를 보여주고 있다.

정성적 비교는 그림 4에 나와 있습니다. 공정한 비교를 위해 연구원들은 DreamPose의 오픈 소스 코드를 사용하여 샘플 미세 조정 없이 결과를 얻었습니다. 패션 영상 분야에서는 의류 디테일에 대한 요구 사항이 매우 엄격합니다. 그러나 DreamPose와 BDMM으로 생성된 영상은 의상 디테일의 일관성을 유지하지 못하고 색상과 미세한 구조적 요소에 상당한 오류가 나타납니다. 대조적으로, 이 방법으로 생성된 결과는 의류 세부 사항의 일관성을 보다 효과적으로 유지할 수 있습니다.

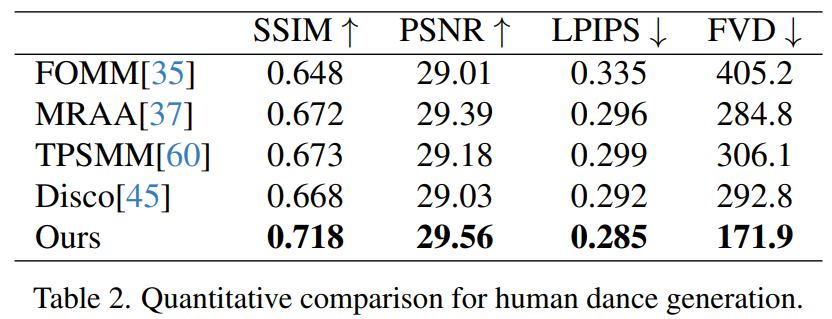

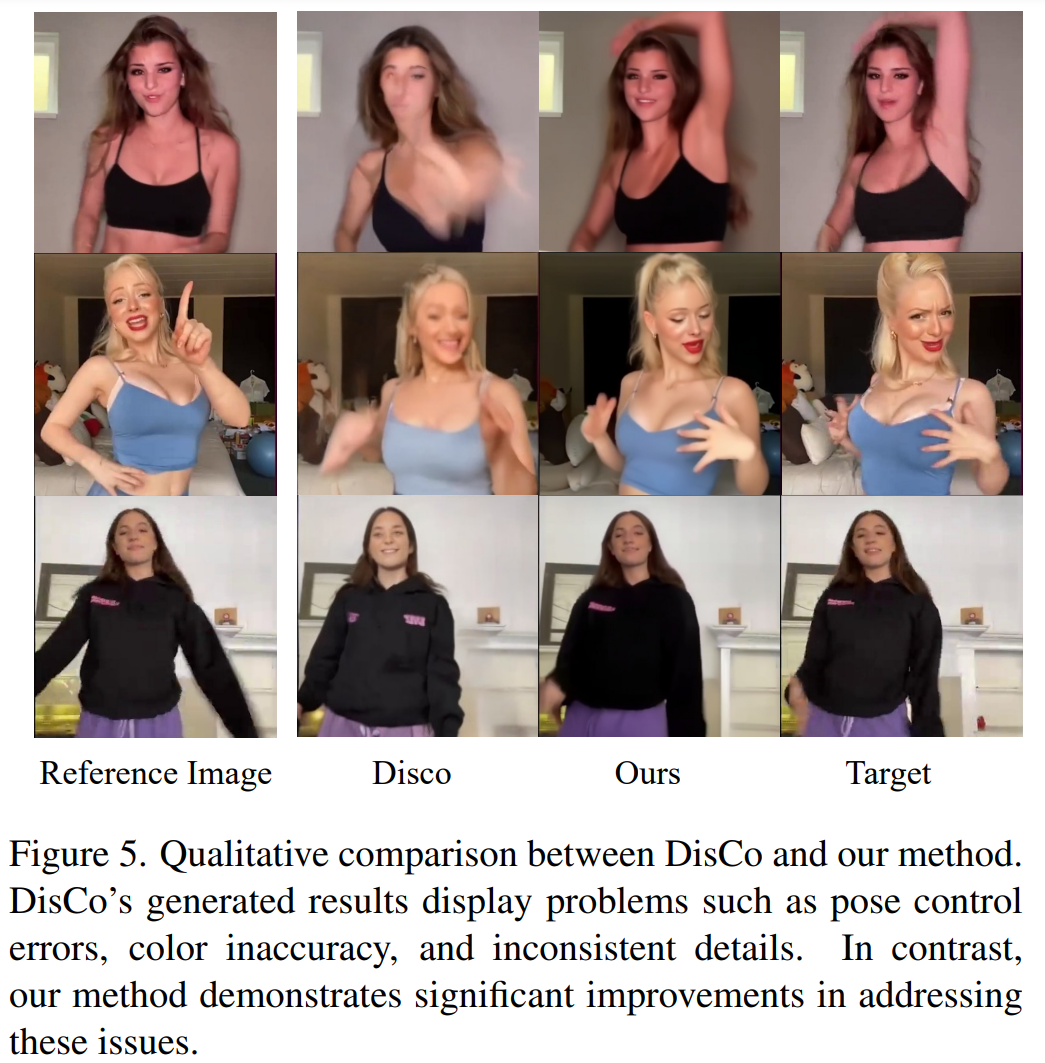

휴먼 댄스 제너레이션은 사실적인 댄스 장면의 이미지를 애니메이션화하여 인간 댄스를 생성하는 것을 목표로 하는 연구입니다. 연구원들은 340개의 교육 비디오와 100개의 테스트 비디오가 포함된 TikTok 데이터 세트를 사용했습니다. 그들은 DisCo의 데이터 세트 분할 방법에 따라 10개의 TikTok 스타일 비디오가 포함된 동일한 테스트 세트를 사용하여 정량적 비교를 수행했습니다. 본 논문의 방법이 가장 좋은 결과를 달성했다는 것을 표 2에서 볼 수 있다. DisCo는 모델의 일반화 능력을 향상시키기 위해 인간 속성 사전 학습을 결합하고 수많은 이미지 쌍을 사용하여 모델을 사전 학습합니다. 이에 비해 다른 연구자들은 TikTok 데이터 세트로만 교육을 받았지만 결과는 여전히 DisCo

DisCo보다 더 좋았습니다. DisCo와의 정성적 비교는 그림 5에 나와 있습니다. 장면의 복잡성을 고려할 때 DisCo의 방법에서는 사람 전경 마스크를 생성하기 위해 SAM을 추가로 사용해야 합니다. 대조적으로, 우리의 방법은 명시적인 인간 마스크 학습 없이도 모델이 사전 인간 분할 없이 피사체의 움직임에서 전경-배경 관계를 파악할 수 있음을 보여줍니다. 또한, 복잡한 댄스 시퀀스에서 모델은 동작 전반에 걸쳐 시각적 연속성을 유지하는 데 뛰어나며 다양한 캐릭터 모습을 처리하는 데 있어 더욱 견고함을 보여줍니다.

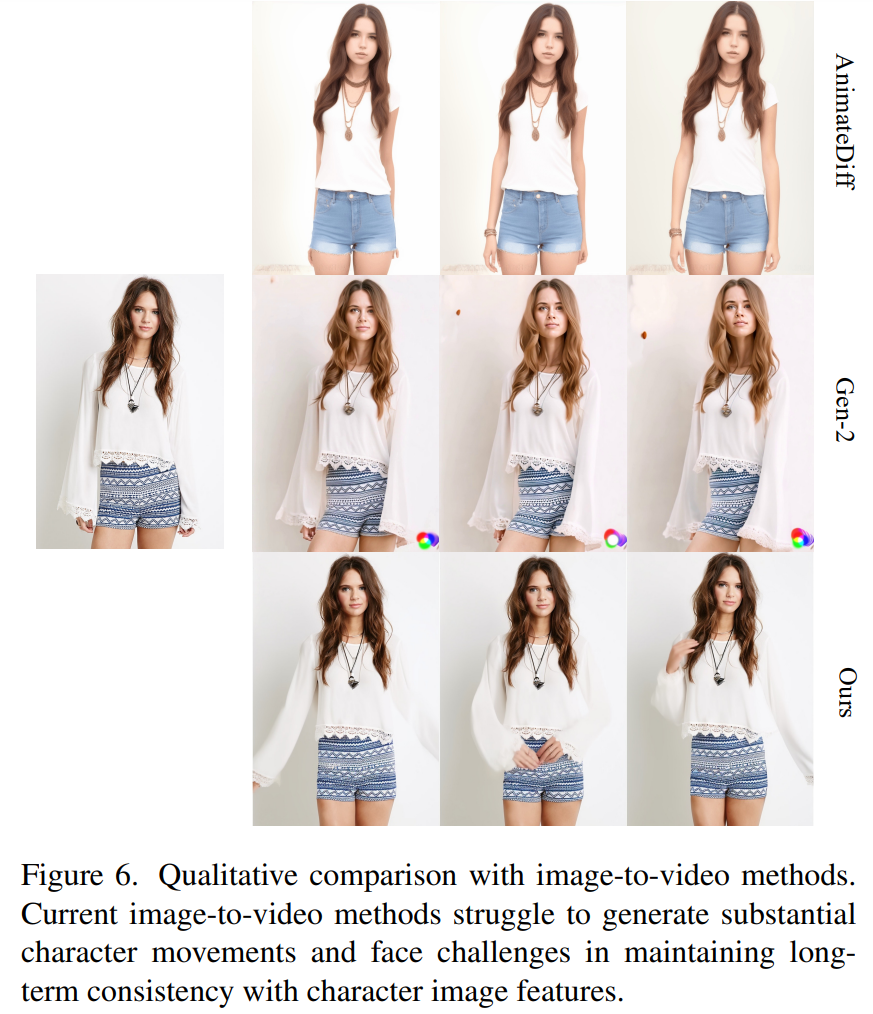

이미지 - 비디오에 대한 보편적인 접근 방식. 현재 많은 연구에서 대규모 훈련 데이터를 기반으로 강력한 생성 기능을 갖춘 비디오 확산 모델을 제안했습니다. 연구원들은 비교를 위해 가장 잘 알려져 있고 가장 효과적인 이미지-비디오 방법 중 두 가지인 AnimateDiff와 Gen2를 선택했습니다. 이 두 가지 방법은 포즈 제어를 수행하지 않기 때문에 연구진은 참조 이미지의 외관 충실도를 유지하는 능력만 비교했습니다. 그림 6에서 볼 수 있듯이 현재의 이미지-비디오 접근 방식은 많은 수의 캐릭터 동작을 생성하는 데 어려움을 겪고 있으며 비디오 전반에 걸쳐 장기적인 모양 일관성을 유지하는 데 어려움을 겪고 있어 일관된 캐릭터 애니메이션에 대한 효과적인 지원을 방해합니다.

자세한 내용은 원본을 확인해주세요

위 내용은 전 세계가 주목하는 '제목 3' : 메시, 아이언맨, 2차원 여성도 쉽게 다룰 수 있다의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!