11월 14일 뉴스, 엔비디아는 현지 시간 13일 오전 '슈퍼컴퓨팅 23' 컨퍼런스에서 새로운 H200 GPU를 공식 출시하고 GH200 제품군을 업데이트했다고 합니다

이중 H200은 기존 Hopper H100 아키텍처를 기반으로 구축되었지만, 인공지능 개발 및 구현에 필요한 대용량 데이터 세트를 더 잘 처리하기 위해 고대역폭 메모리(HBM3e)를 더 추가하여 대규모 모델 실행이 가능해졌습니다. 이전 세대 H100 대비 60~90% 개선되었습니다. 업데이트된 GH200은 또한 차세대 AI 슈퍼컴퓨터를 구동할 것입니다. 2024년에는 200엑사플롭 이상의 AI 컴퓨팅 성능이 온라인에 등장할 것입니다.

H200: HBM 용량 76% 증가, 대형 모델 성능 90% 향상

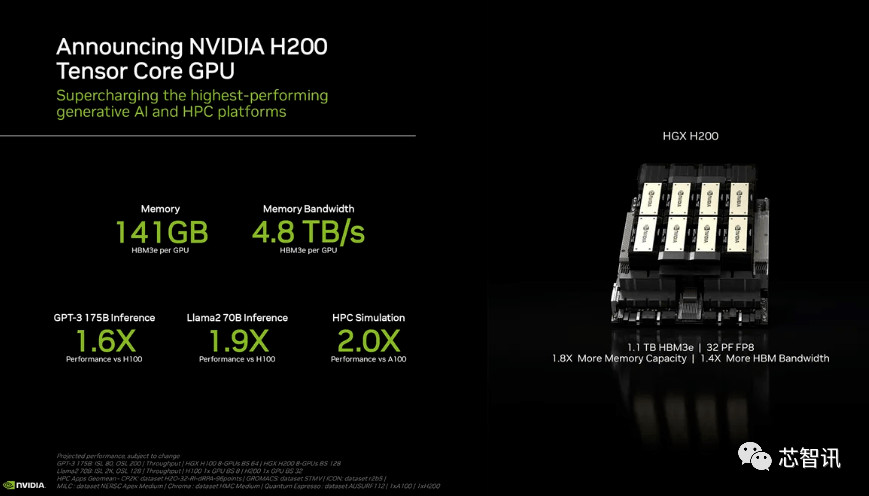

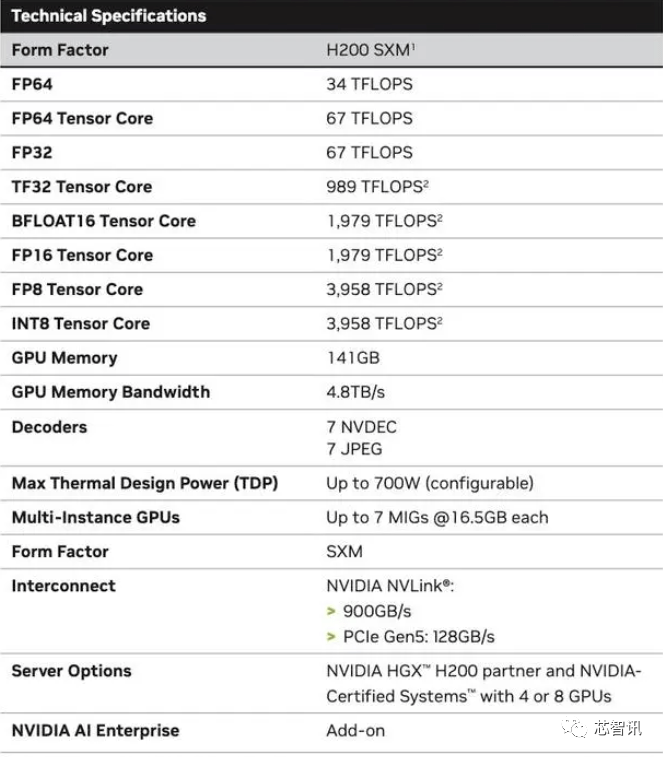

특히 새로운 H200은 최대 141GB의 HBM3e 메모리를 제공하며, 6개의 HBM3e 스택에서 GPU당 총 대역폭 4.8TB/s에 대해 약 6.25Gbps에서 효과적으로 실행됩니다. 이는 이전 세대 H100(80GB HBM3 및 3.35TB/s 대역폭)에 비해 크게 개선되었으며 HBM 용량이 76% 이상 증가했습니다. 공식 데이터에 따르면 대형 모델을 구동할 때 H200은 H100에 비해 60%(GPT3 175B)~90%(Llama 2 70B)의 성능 향상을 가져올 것으로 예상됩니다

H100의 일부 구성은 두 보드를 결합하고 총 188GB 메모리(GPU당 94GB)를 제공하는 H100 NVL과 같이 더 많은 메모리를 제공하지만, H100 SXM 변형과 비교해도 새로운 H200 SXM은 또한 76% 더 많은 메모리 용량과 43% 더 많은 대역폭을 제공합니다.

H200의 원시 컴퓨팅 성능은 크게 변하지 않은 것 같습니다. 유일한 슬라이드 Nvidia는 반영된 컴퓨팅 성능이 8개의 GPU를 사용하는 HGX 200 구성을 기반으로 하며 총 성능이 "32 PFLOPS FP8"임을 보여주었습니다. 원래 H100은 3,958테라플롭스의 FP8 컴퓨팅 성능을 제공했지만, 8개의 GPU도 약 32PFLOPS의 FP8 컴퓨팅 성능을 제공합니다

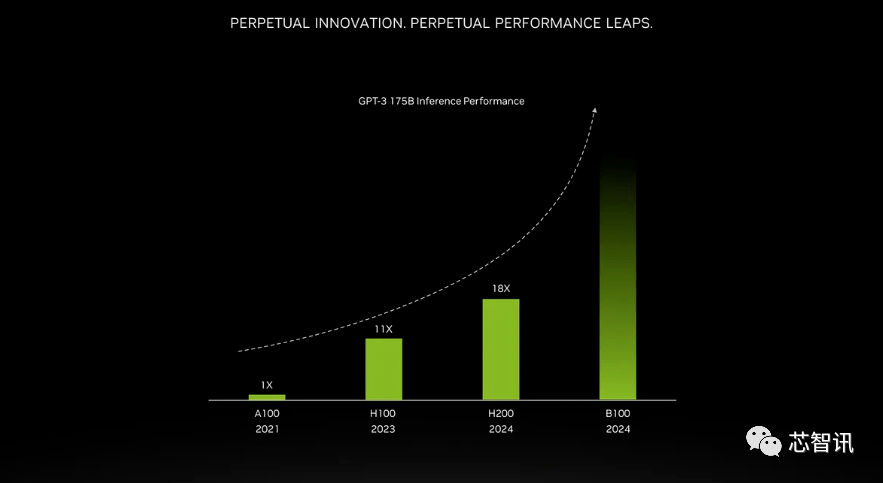

더 높은 대역폭 메모리로 인한 개선은 작업 부하에 따라 다릅니다. 대형 모델(예: GPT-3)은 HBM 메모리 용량 증가로 인해 큰 이점을 얻을 수 있습니다. Nvidia에 따르면 H200은 GPT-3를 실행할 때 원래 A100보다 최대 18배 더 나은 성능을 발휘하고 H100보다 약 11배 더 빠릅니다. 또한 곧 출시될 Blackwell B100의 티저는 검은색으로 변하는 더 큰 막대가 포함되어 있음을 보여줍니다. 이는 가장 오른쪽 H200보다 약 두 배 긴 것입니다

그뿐만 아니라 H200과 H100은 서로 호환됩니다. 즉, H100 훈련/추론 모델을 사용하는 AI 기업은 최신 H200 칩으로 원활하게 전환할 수 있다. 클라우드 서비스 제공업체는 제품 포트폴리오에 H200을 추가할 때 어떤 수정도 할 필요가 없습니다.

Nvidia는 신제품 출시를 통해 인공지능 모델과 서비스를 만드는 데 사용되는 데이터 세트 규모의 증가를 따라잡기를 희망한다고 밝혔습니다. 향상된 메모리 기능을 통해 H200은 소프트웨어에 데이터를 공급하는 과정, 즉 이미지 및 음성 인식과 같은 작업을 수행하도록 인공 지능을 훈련시키는 데 도움이 되는 과정에서 더 빨라질 것입니다.

"더 빠르고 대용량인 HBM 메모리를 통합하면 생성 AI 모델, 고성능 컴퓨팅 애플리케이션 등 계산량이 많은 작업의 성능을 향상하는 동시에 GPU 사용 및 효율성을 최적화하는 데 도움이 됩니다."라고 제품 담당 부사장인 Ian Buck이 말했습니다.

NVIDIA의 데이터 센터 제품 책임자인 Dion Harris는 다음과 같이 말했습니다. “시장 개발 추세를 살펴보면 모델 크기가 빠르게 증가하고 있습니다. 이는 NVIDIA가 최신 기술을 지속적으로 도입하는 방법을 보여주는 예입니다.”

메인프레임 컴퓨터 제조업체와 클라우드 서비스 제공업체는 2024년 2분기에 H200을 사용하기 시작할 것으로 예상됩니다. NVIDIA 서버 제조 파트너(Evergreen, Asus, Dell, Eviden, Gigabyte, HPE, Hongbai, Lenovo, Wenda, MetaVision, Wistron 및 Wiwing 포함)는 H200을 사용하여 기존 시스템을 업데이트할 수 있으며 Amazon, Google, Microsoft, Oracle 등은 H200을 채택한 최초의 클라우드 서비스 제공업체가 될 것입니다.

현재 NVIDIA AI 칩에 대한 강력한 시장 수요와 더 비싼 HBM3e 메모리를 추가하는 새로운 H200을 고려하면 H200의 가격은 확실히 더 비쌀 것입니다. Nvidia는 가격을 공개하지 않았지만 이전 세대 H100의 가격은 25,000~40,000달러였습니다.

NVIDIA 대변인 Kristin Uchiyama는 최종 가격은 NVIDIA의 제조 파트너에 의해 결정될 것이라고 말했습니다

H200 출시가 H100 생산에 영향을 미칠지 여부에 대해 Kristin Uchiyama는 "연중 총 공급량이 증가할 것으로 예상합니다"라고 말했습니다.

Nvidia의 고급 AI 칩은 대용량 데이터를 처리하고 대규모 언어 모델 및 AI 생성 도구를 교육하는 데 항상 최고의 선택으로 여겨져 왔습니다. 하지만 H200 칩이 출시됐을 때 AI 기업들은 여전히 시장에서 A100/H100 칩을 필사적으로 찾고 있었습니다. 시장의 초점은 Nvidia가 시장 수요를 충족할 만큼 충분한 공급을 제공할 수 있는지 여부에 남아 있습니다. 따라서 NVIDIA는 H200 칩이 H100 칩처럼 공급이 부족할 것인지에 대한 답변을 제공하지 않았습니다그러나 지난 8월 파이낸셜 타임즈의 보도에 따르면, 내년은 GPU 구매자에게 더 유리한 시기가 될 수 있습니다. 엔비디아는 2024년 H100 생산량을 3배로 늘릴 계획이며, 생산 목표는 2023년 약 50만 대에서 2020년으로 증가할 예정입니다. 2024년에는 200만개. 그러나 생성적 AI는 여전히 호황을 누리고 있으며 앞으로 수요는 더 커질 가능성이 높습니다.

예를 들어 새로 출시된 GPT-4는 약 10,000~25,000개의 A100 블록에 대해 학습되었습니다. Meta의 대규모 AI 모델은 훈련을 위해 약 21,000개의 A100 블록이 필요합니다. Stability AI는 약 5,000개의 A100을 사용합니다. Falcon-40B 훈련에는 384 A100

이 필요합니다.

Musk에 따르면 GPT-5에는 30,000-50,000 H100이 필요할 수 있습니다. Morgan Stanley의 견적은 25,000 GPU입니다.Sam Altman은 GPT-5 교육을 거부했지만 "OpenAI는 GPU가 심각하게 부족하며 우리 제품을 사용하는 사람이 적을수록 좋습니다."라고 언급했습니다.

물론 NVIDIA 외에도 AMD, Intel도 NVIDIA와 경쟁하기 위해 AI 시장에 적극적으로 진출하고 있습니다. AMD가 앞서 출시한 MI300X는 192GB HBM3와 5.2TB/s 메모리 대역폭을 탑재해 용량과 대역폭 측면에서 H200을 훨씬 뛰어넘는다.

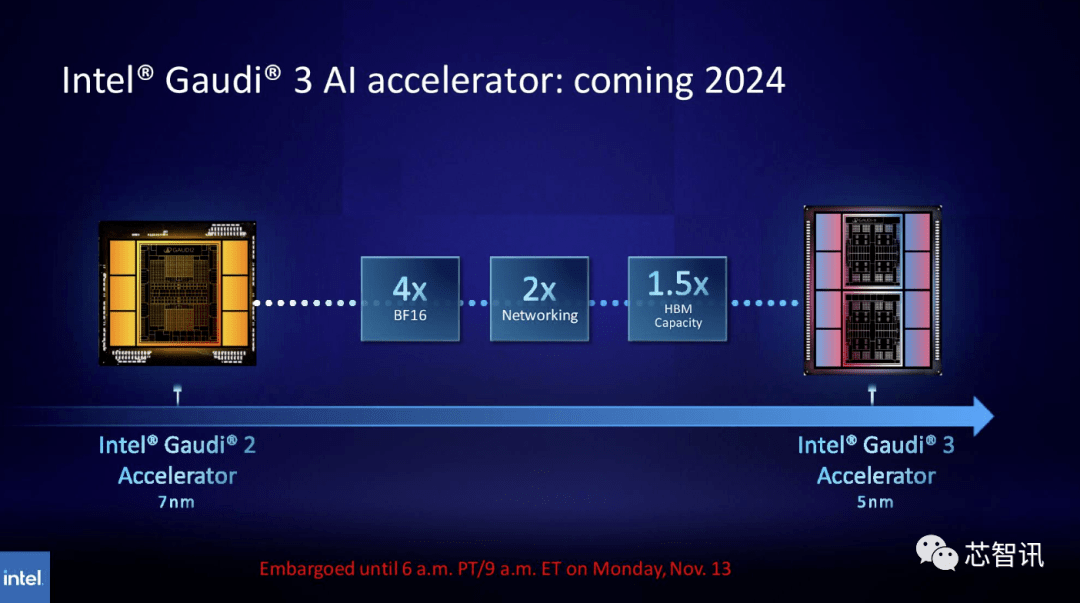

마찬가지로 인텔은 가우디 AI 칩의 HBM 용량을 늘릴 계획이다. 최근 공개된 정보에 따르면 Gaudi 3는 5nm 공정을 사용하며 BF16 워크로드에서의 성능은 Gaudi 2의 4배, 네트워크 성능도 Gaudi 2의 2배가 될 것입니다(Gaudi 2에는 24개의 100개가 내장되어 있습니다). GbE RoCE NIC). 또한 Gaudi 3의 HBM 용량은 Gaudi 2의 1.5배입니다(Gaudi 2의 HBM2E 용량은 96GB입니다). 아래 그림에서 볼 수 있듯이 Gaudi 3는 Intel의 단일 칩 솔루션을 사용하는 Gaudi 2와 달리 두 개의 컴퓨팅 클러스터가 있는 칩렛 기반 설계를 사용합니다

새로운 GH200 슈퍼 칩: 차세대 AI 슈퍼컴퓨터 구동

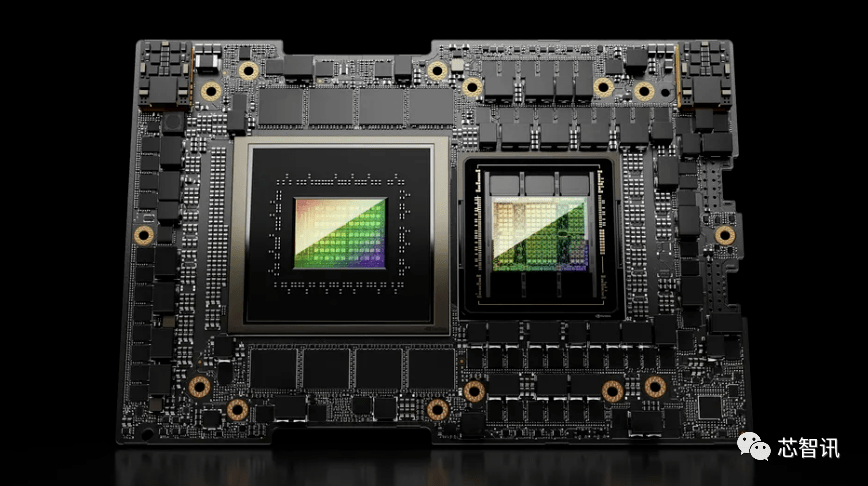

NVIDIA는 새로운 H200 GPU를 출시한 것 외에도 GH200 슈퍼 칩의 업그레이드 버전도 출시했습니다. 이 칩은 최신 H200 GPU와 Grace CPU를 결합한 NVIDIA NVLink-C2C 칩 상호 연결 기술을 사용합니다(업그레이드 버전인지는 확실하지 않음). 각 GH200 슈퍼 칩은 총 624GB의 메모리를 탑재합니다

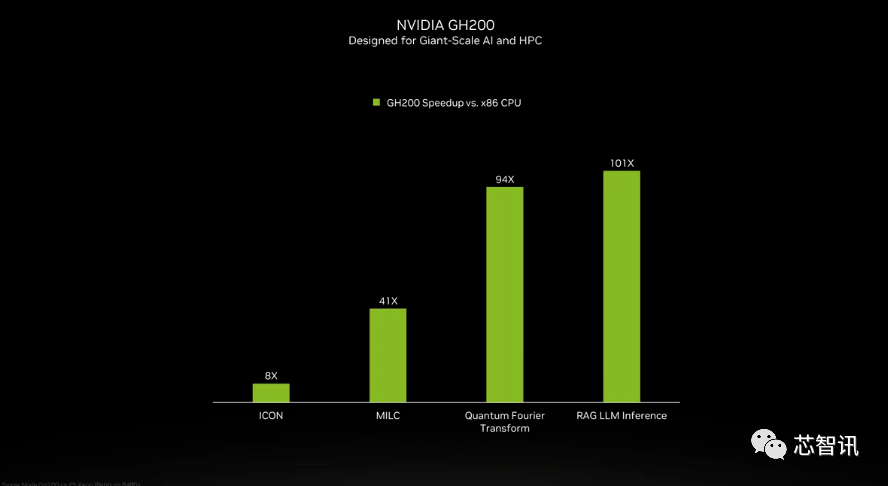

NVIDIA는 GH200 슈퍼 칩의 Grace CPU에 대한 세부 사항을 소개하지 않았지만 NVIDIA는 GH200과 "최신 듀얼 소켓 x86 CPU" 간의 몇 가지 비교를 제공했습니다. GH200은 ICON 성능을 8배 향상시켰고, MILC, Quantum Fourier Transform, RAG LLM Inference 등은 수십배, 심지어 수백배 향상을 가져온 것을 확인할 수 있습니다.

새로운 GH200은 새로운 HGX H200 시스템에도 사용됩니다. 이는 기존 HGX H100 시스템과 "완벽하게 호환"된다고 합니다. 즉, HGX H200을 동일한 설치에서 사용하여 인프라를 재설계할 필요 없이 성능과 메모리 용량을 늘릴 수 있다는 의미입니다.

보고에 따르면 스위스 국립 슈퍼컴퓨팅 센터의 Alpine 슈퍼컴퓨터는 내년에 사용되는 GH100 기반 Grace Hopper 슈퍼컴퓨터의 첫 번째 배치 중 하나일 수 있습니다. 미국에서 서비스를 시작하는 최초의 GH200 시스템은 로스앨러모스 국립연구소(Los Alamos National Laboratory)의 Venado 슈퍼컴퓨터가 될 것입니다. TACC(Texas Advanced Computing Center) Vista 시스템도 방금 발표된 Grace CPU 및 Grace Hopper 슈퍼칩을 사용할 예정이지만 H100을 기반으로 할지 H200을 기반으로 할지 확실하지 않습니다.

NVIDIA가 내년쯤에 설치할 것으로 예상하는 이 새로운 슈퍼컴퓨터는 전체적으로 200엑사플롭 이상의 인공 지능 컴퓨팅 성능을 달성할 것입니다

원래 의미를 바꿀 필요가 없다면 내용을 중국어로 다시 작성해야 하며 원문이 나타날 필요는 없습니다

위 내용은 새 타이틀: NVIDIA H200 출시: HBM 용량 76% 증가, 대형 모델 성능을 90% 크게 향상시키는 가장 강력한 AI 칩의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!