기계 학습 모델은 점점 더 정교해지고 정확해지고 있지만 그 불투명성은 여전히 중요한 문제로 남아 있습니다. 모델이 특정 예측을 하는 이유를 이해하는 것은 신뢰를 구축하고 예상대로 작동하도록 보장하는 데 중요합니다. 이번 글에서는 LIME을 소개하고 이를 활용하여 다양한 공통 모델을 설명하겠습니다.

강력한 Python 라이브러리 LIME(Local Interpretable Model-Agnostic Descriptions)은 기계 학습 분류자(또는 모델)의 동작을 설명하는 데 도움이 될 수 있습니다. LIME의 주요 목적은 특히 복잡한 기계 학습 모델의 경우 개별 예측에 대해 해석 가능하고 사람이 읽을 수 있는 설명을 제공하는 것입니다. LIME은 이러한 모델의 작동 방식에 대한 자세한 이해를 제공함으로써 기계 학습 시스템에 대한 신뢰를 장려합니다.

기계 학습 모델이 더욱 복잡해짐에 따라 내부 작동 방식을 이해하는 것이 귀중한 과제가 될 수 있습니다. LIME은 특정 인스턴스에 대한 로컬 설명을 생성하여 사용자가 기계 학습 모델을 더 쉽게 이해하고 신뢰할 수 있도록 함으로써 이 문제를 해결합니다.

LIME의 주요 기능:

LIME은 복잡한 ML 모델을 특정 인스턴스를 중심으로 구축된 더 간단하고 로컬로 해석 가능한 모델로 근사화하여 작동합니다. LIME 워크플로의 주요 단계는 다음 단계로 나눌 수 있습니다.

LIME을 사용하기 전에 LIME을 설치해야 합니다. LIME은 pip 명령을 사용하여 설치할 수 있습니다:

pip install lime

분류 모델과 함께 LIME을 사용하려면 인터프리터 개체를 만든 다음 특정 인스턴스에 대한 설명을 생성해야 합니다. 다음은 LIME 라이브러리와 분류 모델을 사용한 간단한 예입니다.

# Classification- Lime import lime import lime.lime_tabular from sklearn import datasets from sklearn.ensemble import RandomForestClassifier # Load the dataset and train a classifier data = datasets.load_iris() classifier = RandomForestClassifier() classifier.fit(data.data, data.target) # Create a LIME explainer object explainer = lime.lime_tabular.LimeTabularExplainer(data.data, mode="classification", training_labels=data.target, feature_names=data.feature_names, class_names=data.target_names, discretize_cnotallow=True) # Select an instance to be explained (you can choose any index) instance = data.data[0] # Generate an explanation for the instance explanation = explainer.explain_instance(instance, classifier.predict_proba, num_features=5) # Display the explanation explanation.show_in_notebook()

LIME을 사용하여 회귀 모델을 설명하는 것은 LIME을 사용하여 분류 모델을 설명하는 것과 유사합니다. . 인터프리터 객체를 생성하고 특정 인스턴스에 대한 해석을 생성해야 합니다. 다음은 LIME 라이브러리와 회귀 모델을 사용하는 예입니다.

#Regression - Lime import numpy as np from sklearn.model_selection import train_test_split from sklearn.linear_model import LinearRegression from lime.lime_tabular import LimeTabularExplainer # Generate a custom regression dataset np.random.seed(42) X = np.random.rand(100, 5) # 100 samples, 5 features y = 2 * X[:, 0] + 3 * X[:, 1] + 1 * X[:, 2] + np.random.randn(100) # Linear regression with noise # Split the data into training and testing sets X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.2, random_state=42) # Train a simple linear regression model model = LinearRegression() model.fit(X_train, y_train) # Initialize a LimeTabularExplainer explainer = LimeTabularExplainer(training_data=X_train, mode="regression") # Select a sample instance for explanation sample_instance = X_test[0] # Explain the prediction for the sample instance explanation = explainer.explain_instance(sample_instance, model.predict) # Print the explanation explanation.show_in_notebook()

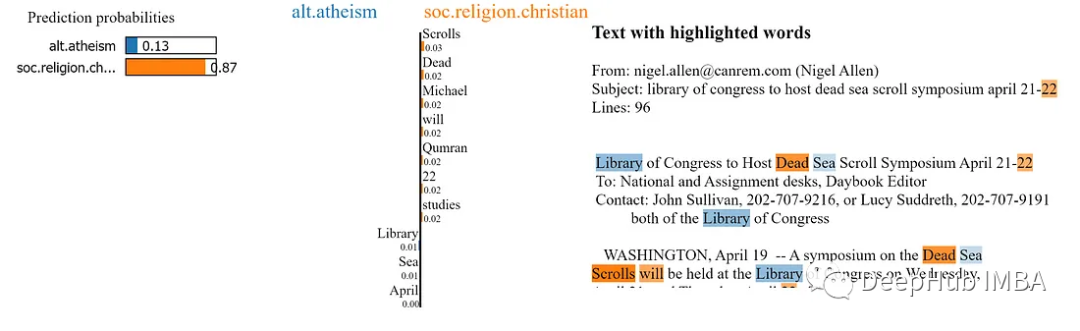

LIME은 텍스트 모델에 의한 예측을 설명하는 데에도 사용할 수 있습니다. LIME을 텍스트 모델과 함께 사용하려면 LIME 텍스트 해석기 개체를 만든 다음 특정 인스턴스에 대한 해석을 생성해야 합니다. 다음은 LIME 라이브러리와 텍스트 모델을 사용하는 예입니다.

# Text Model - Lime import lime import lime.lime_text from sklearn.feature_extraction.text import TfidfVectorizer from sklearn.naive_bayes import MultinomialNB from sklearn.datasets import fetch_20newsgroups # Load a sample dataset (20 Newsgroups) for text classification categories = ['alt.atheism', 'soc.religion.christian'] newsgroups_train = fetch_20newsgroups(subset='train', categories=categories) # Create a simple text classification model (Multinomial Naive Bayes) tfidf_vectorizer = TfidfVectorizer() X_train = tfidf_vectorizer.fit_transform(newsgroups_train.data) y_train = newsgroups_train.target classifier = MultinomialNB() classifier.fit(X_train, y_train) # Define a custom Lime explainer for text data explainer = lime.lime_text.LimeTextExplainer(class_names=newsgroups_train.target_names) # Choose a text instance to explain text_instance = newsgroups_train.data[0] # Create a predict function for the classifier predict_fn = lambda x: classifier.predict_proba(tfidf_vectorizer.transform(x)) # Explain the model's prediction for the chosen text instance explanation = explainer.explain_instance(text_instance, predict_fn) # Print the explanation explanation.show_in_notebook()

LIME을 사용하여 이미지 모델의 예측 결과를 설명할 수 있습니다. LIME 이미지 해석기 개체를 생성하고 특정 인스턴스에 대한 설명을 생성해야 합니다.

import lime import lime.lime_image import sklearn # Load the dataset and train an image classifier data = sklearn.datasets.load_digits() classifier = sklearn.ensemble.RandomForestClassifier() classifier.fit(data.images.reshape((len(data.images), -1)), data.target) # Create a LIME image explainer object explainer = lime.lime_image.LimeImageExplainer() # Select an instance to be explained instance = data.images[0] # Generate an explanation for the instance explanation = explainer.explain_instance(instance, classifier.predict_proba, top_labels=5)

LIME을 사용하여 설명을 생성한 후 설명을 시각화하여 LIME의 기여도를 이해할 수 있습니다. 각 기능을 예측합니다. 표 형식 데이터의 경우 show_in_notebook 또는 as_pyplot_Figure 메서드를 사용하여 설명을 표시할 수 있습니다. 텍스트 및 이미지 데이터의 경우 show_in_notebook 메서드를 사용하여 메모를 표시할 수 있습니다.

각 기능의 기여도를 이해함으로써 모델의 의사 결정 과정을 더 깊이 이해하고 잠재적인 편향이나 문제 영역을 식별할 수 있습니다.

LIME은 설명의 품질을 향상하기 위한 몇 가지 고급 기술을 제공합니다. 포함 사항:

교란된 샘플 수 조정: 교란된 샘플 수를 늘리면 해석의 안정성과 정확성이 향상될 수 있습니다.

해석 가능한 모델 선택: 적절한 해석 가능한 모델(예: 선형 회귀, 의사결정 트리)을 선택하면 설명의 품질에 영향을 미칩니다.

특성 선택: 설명에 사용되는 특성 수를 맞춤 설정하면 예측에 가장 중요한 기여에 집중하는 데 도움이 될 수 있습니다.

LIME은 기계 학습 모델을 해석하는 강력한 도구이지만 몇 가지 제한 사항도 있습니다.

로컬 해석: LIME은 로컬 해석에 중점을 두므로 모델 전체 동작을 포착하지 못할 수 있습니다.

비용이 많이 듭니다: LIME을 사용하여 설명을 생성하는 것은 특히 대규모 데이터 세트와 복잡한 모델의 경우 시간이 많이 걸릴 수 있습니다.

LIME이 요구 사항을 충족하지 못하는 경우 SHAP( SHApley Additive exPlanations) 및 앵커.

LIME은 기계 학습 분류기(또는 모델)가 수행하는 작업을 설명하는 데 유용한 도구입니다. LIME은 복잡한 기계 학습 모델을 이해할 수 있는 실용적인 방법을 제공함으로써 사용자가 시스템을 신뢰하고 개선할 수 있도록 해줍니다.

LIME은 개별 예측에 대해 해석 가능한 설명을 제공함으로써 기계 학습 모델에 대한 신뢰를 구축하는 데 도움을 줄 수 있습니다. 이러한 종류의 신뢰는 많은 산업에서 매우 중요하며, 특히 ML 모델을 사용하여 중요한 결정을 내릴 때 더욱 그렇습니다. 모델이 어떻게 작동하는지 더 잘 이해함으로써 사용자는 자신 있게 기계 학습 시스템을 활용하고 데이터 기반 결정을 내릴 수 있습니다.

위 내용은 다양한 머신러닝 모델 코드 예시 해석: LIME을 이용한 설명의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!