최근 대규모 언어 모델은 다양한 자연어 처리 작업, 특히 복잡한 CoT(사고 사슬) 추론이 필요한 수학적 문제에서 획기적인 발전을 이루었습니다.

GSM8K, MATH 등에서 GPT를 포함한 독점 모델 -4와 PaLM-2는 어려운 수학적 작업의 데이터 세트에서 놀라운 결과를 얻었습니다. 이와 관련하여 오픈 소스 대형 모델에는 여전히 개선의 여지가 상당히 많습니다. 수학적 작업을 위한 오픈 소스 대규모 모델의 CoT 추론 기능을 더욱 향상시키기 위한 일반적인 접근 방식은 모델에 작업을 수행하는 방법을 직접 가르치는 주석이 달린/생성된 질문-추론 데이터 쌍(CoT 데이터)을 사용하여 이러한 모델을 미세 조정하는 것입니다. 작업 중에 CoT 추론을 수행합니다.

최근 Xi'an Jiaotong University, Microsoft 및 Peking University의 연구원들은 역학습 프로세스(즉, LLM의 오류로부터 학습)를 통해 추론 능력을 더욱 향상시키는 개선 아이디어를 논문에서 탐색했습니다.

수학을 배우기 시작하는 학생처럼 먼저 교과서에 나오는 지식 포인트와 예를 공부하여 이해력을 향상시킵니다. 그러나 동시에 그는 자신이 배운 것을 통합하기 위한 연습도 합니다. 문제를 해결하는 데 어려움을 겪거나 실패하면 자신이 저지른 실수가 무엇인지 깨닫고 이를 수정하는 방법을 배우면서 "잘못된 문제집"을 구성하게 됩니다. 그의 추론 능력은 실수로부터 학습함으로써 더욱 향상됩니다

이 과정에서 영감을 받은 이 작업은 오류를 이해하고 수정함으로써 LLM의 추론 능력이 어떻게 이점을 얻는지 탐구합니다.

논문 주소: https://arxiv.org/pdf/2310.20689.pdf

구체적으로, 연구진은 먼저 오류 수정 데이터 쌍(수정 데이터라고 함)을 생성한 다음 올바른 데이터를 사용하여 LLM을 미세 조정하세요. 수정 데이터 생성 시: 다시 작성해야 하는 내용은 여러 LLM(LLaMA 및 GPT 모델 계열 포함)을 사용하여 부정확한 추론 경로(즉, 최종 답변이 올바르지 않음)를 수집한 다음 GPT-4를 수정자로 사용" " 이러한 부정확한 추론 경로에 대한 수정 사항을 생성하려면

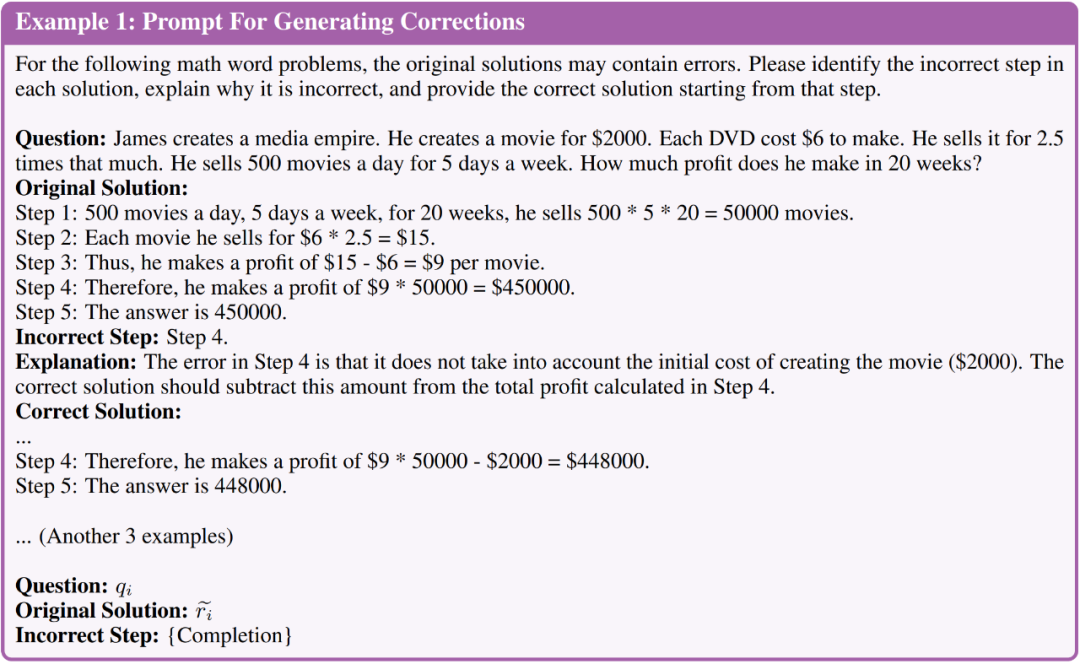

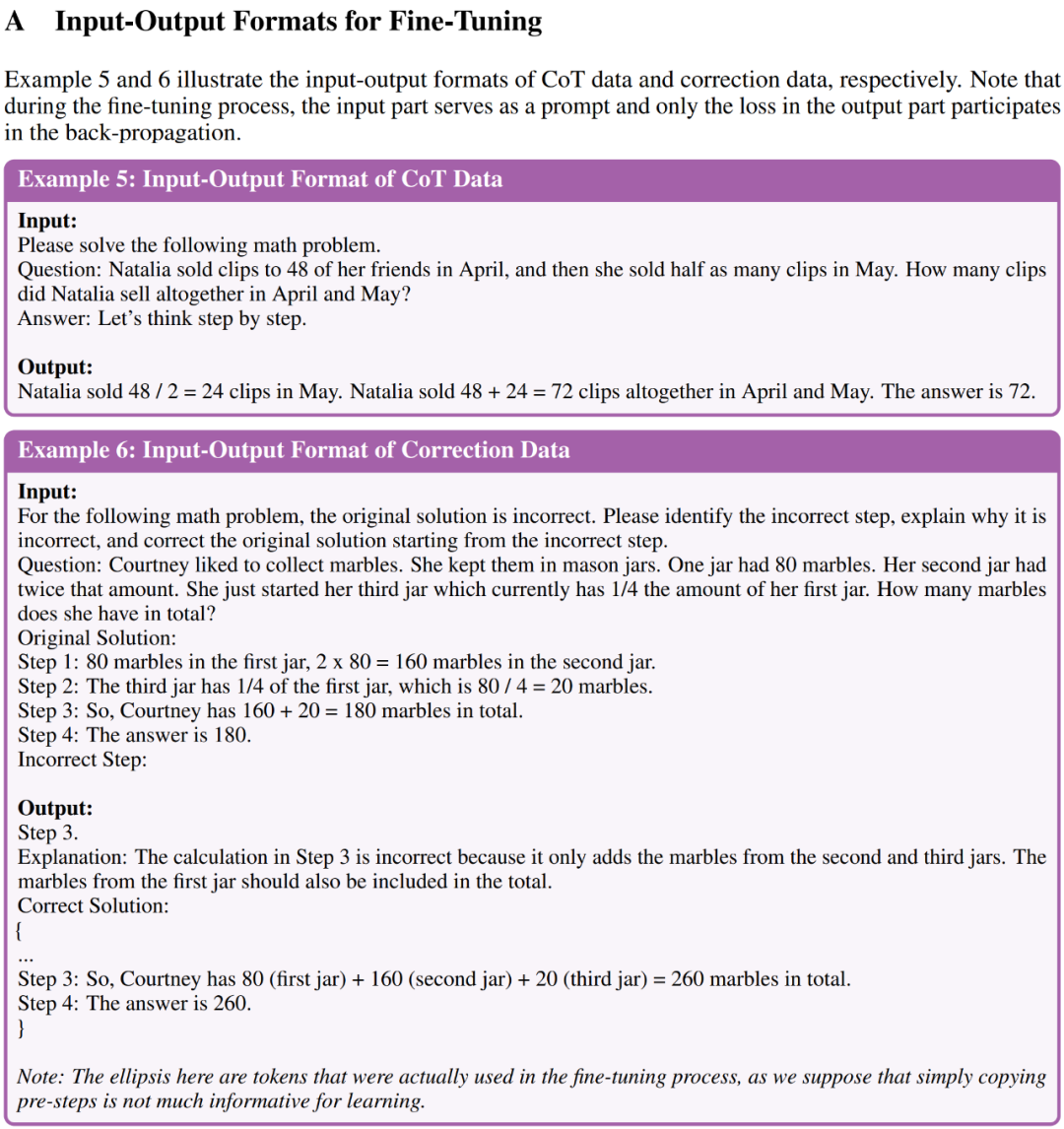

생성된 수정 사항에는 세 가지 정보가 포함됩니다. (1) 원래 솔루션의 잘못된 단계, (2) 단계가 잘못된 이유에 대한 설명, (3) 어떻게 수정되었는지 올바른 최종 답변에 도달하기 위한 원래의 솔루션입니다. 잘못된 최종 답이 있는 수정 사항을 필터링한 후 수동 평가를 통해 수정 데이터가 후속 미세 조정 단계에 충분한 품질을 보인 것으로 나타났습니다. 연구진은 QLoRA를 사용해 CoT 데이터와 수정 데이터에 대한 LLM을 미세 조정함으로써 '오류로부터의 학습'(LEMA)을 수행했습니다.

연구에 따르면 현재 LLM은 단계별 접근 방식을 사용하여 문제를 해결할 수 있지만 이러한 다단계 생성 프로세스가 LLM 자체에 강력한 추론 기능이 있다는 의미는 아닙니다. 필요한 기본 논리와 규칙을 진정으로 이해하지 못한 채 인간 추론의 피상적인 행동만 모방할 수 있기 때문입니다.

이러한 이해 부족은 추론 과정에서 오류로 이어질 수 있으므로 "세계 모델"의 도움이 필요합니다 왜냐하면 "세계 모델"은 현실 세계의 논리와 규칙에 대한 선험적 인식을 갖고 있기 때문입니다. 이러한 관점에서 이 기사의 LEMA 프레임워크는 GPT-4를 "세계 모델"로 사용하여 단계별 동작을 단순히 모방하는 것이 아니라 더 작은 모델이 이러한 논리와 규칙을 따르도록 가르치는 것으로 볼 수 있습니다.

이제 본 연구의 구체적인 구현 단계를 살펴보겠습니다

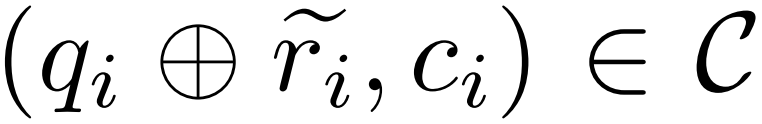

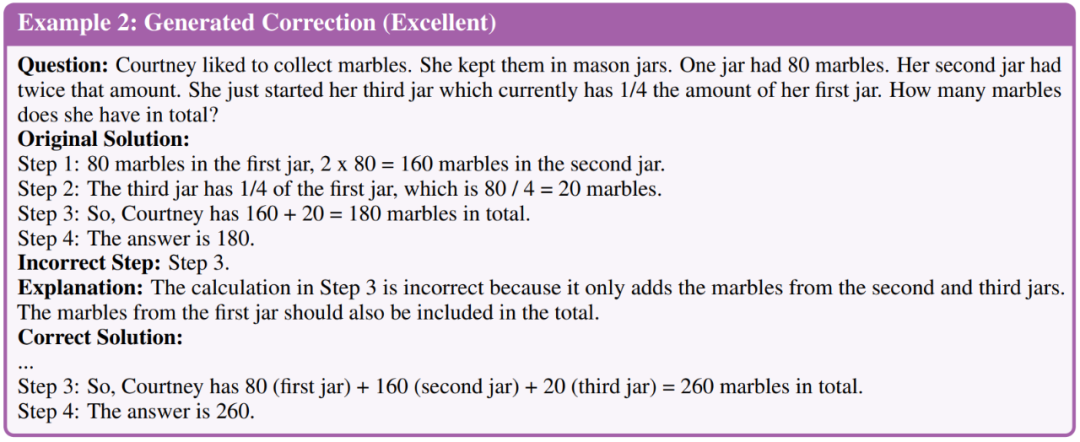

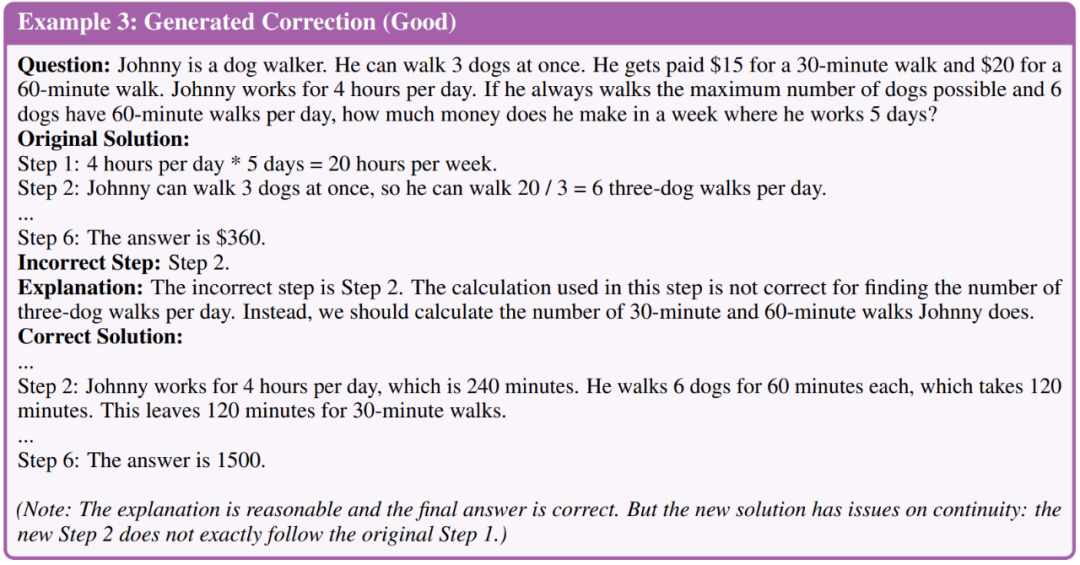

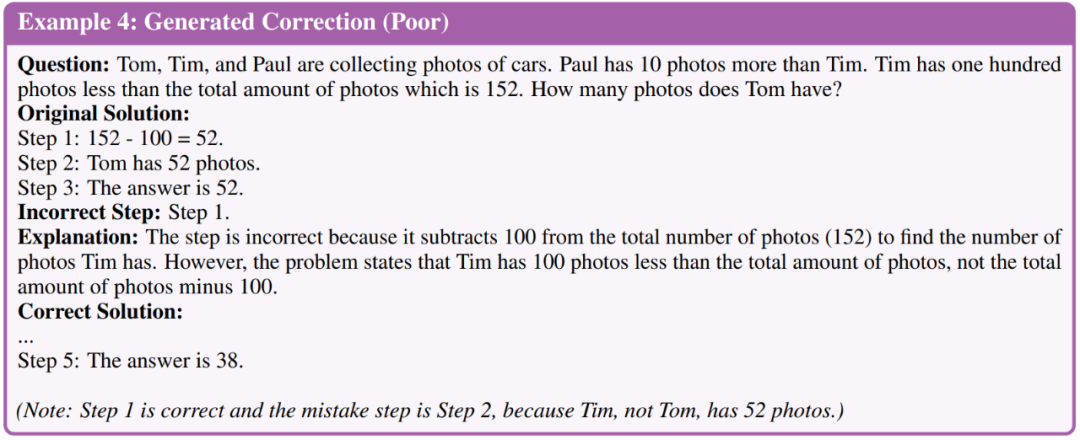

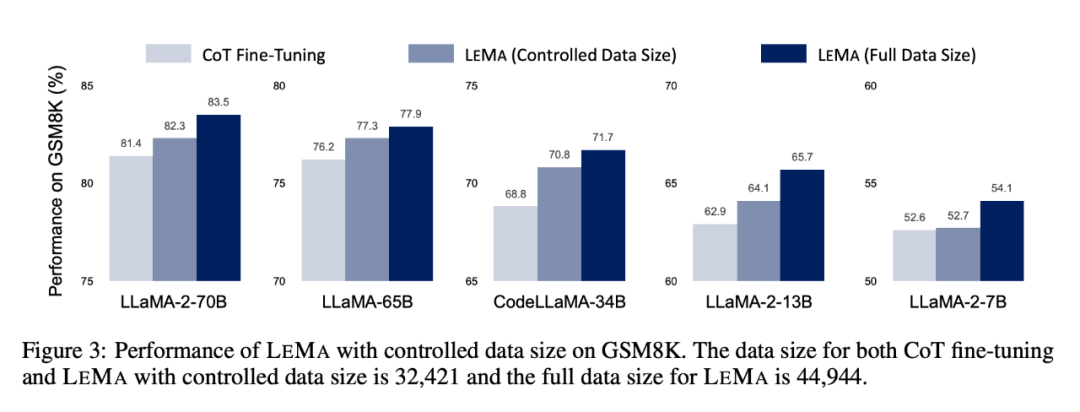

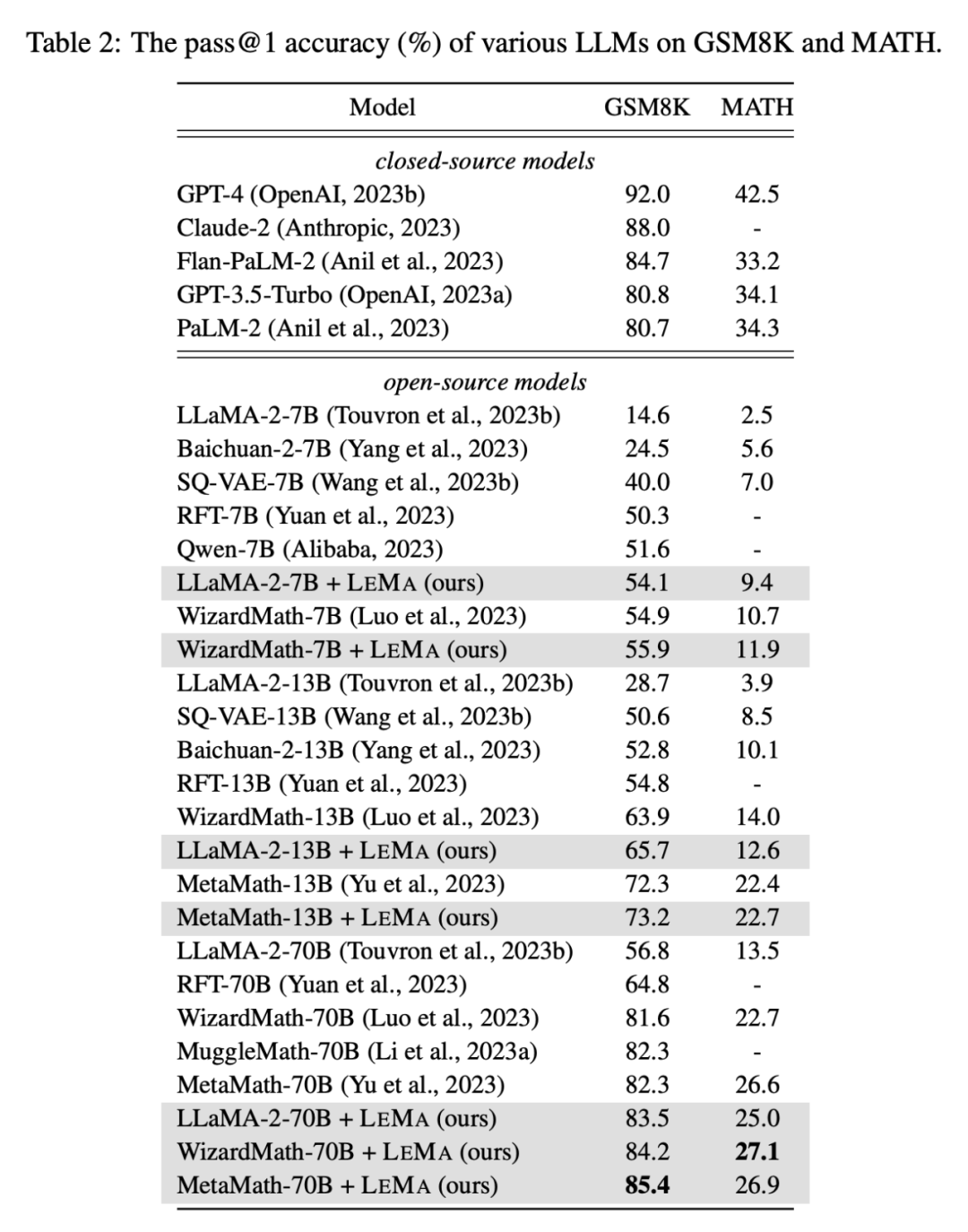

아래 그림 1(왼쪽)을 살펴보십시오. 수정된 데이터: 필수 콘텐츠 재작성 및 LLM 미세 조정이라는 두 가지 주요 단계가 있습니다. 그림 1(오른쪽)은 GSM8K 및 MATH 데이터 세트에서 LEMA의 성능을 보여줍니다. 정정 모델 M_c와 추론 모델 M_r인 질문 및 답변 예시 부정확한 추론 경로를 수정하세요. 연구자는 먼저 추론 모델 M_r을 사용하여 각 질문 q_i에 대해 여러 추론 경로를 샘플링한 다음, 다음 공식(1)과 같이 궁극적으로 정답 a_i로 이어지지 않는 경로만 유지합니다. 버그 수정 . 질문 q_i와 부정확한 추론 경로 P_c에는 생성된 수정 사항에 어떤 유형의 정보를 포함할지 정정기 모델을 안내하는 4개의 주석이 달린 오류 수정 예시가 포함되어 있습니다. 특히, 주석이 달린 수정 사항에는 다음 세 가지 유형의 정보가 포함됩니다. 아래 그림을 참조하세요. 그림 1은 수정 사항을 생성하는 데 사용되는 프롬프트를 간략하게 보여줍니다. 수정 사항 수동 평가 생성 . 더 큰 데이터를 생성하기 전에 먼저 생성된 수정 사항의 품질을 수동으로 평가했습니다. 그들은 LLaMA-2-70B를 M_r로, GPT-4를 M_c로 사용하고 GSM8K 훈련 세트를 기반으로 50개의 오류 수정 데이터 쌍을 생성했습니다. 연구원들은 수정 사항을 우수함, 좋음, 나쁨의 세 가지 품질 수준으로 분류했습니다. 다음은 세 가지 수준의 예입니다. 평가 결과 50개 빌드 수정 중 35개는 우수한 품질을 달성했고, 11개는 양호, 4개는 불량한 것으로 나타났습니다. 이 평가를 바탕으로 연구원들은 GPT-4를 사용하여 생성된 보정의 전반적인 품질이 추가 미세 조정 단계에 충분하다고 결론지었습니다. 따라서 더 큰 규모의 수정을 생성하고 미세 조정이 필요한 LLM에 대한 정답으로 이어지는 모든 수정을 사용했습니다. 미세조정이 필요한 LLM입니다 수정 데이터를 생성한 후 다시 작성해야 하는 부분을 연구원들은 LLM을 미세 조정하여 모델이 실수로부터 학습할 수 있는지 평가했습니다. 주로 다음 두 가지 미세 조정 설정에서 성능 비교를 수행합니다. 첫 번째는 CoT(사고 사슬) 데이터를 미세 조정하는 것입니다. 연구자들은 질문 근거 데이터에 대해서만 모델을 미세 조정합니다. 각 작업에는 주석이 달린 데이터가 있지만 CoT 데이터 보강도 추가로 사용합니다. 연구원들은 GPT-4를 사용하여 훈련 세트의 각 질문에 대해 더 많은 추론 경로를 생성하고 최종 답변이 잘못된 경로를 필터링했습니다. CoT 데이터 확대를 활용하여 CoT 데이터만 사용하는 강력한 미세 조정 기준선을 구축하고 미세 조정을 제어하는 데이터 크기에 대한 절제 연구를 촉진합니다. 두 번째는 CoT 데이터 + 수정 데이터에 대한 fine-tuning입니다. CoT 데이터 외에도 연구원들은 미세 조정을 위한 오류 수정 데이터(예: LEMA)도 생성했습니다. 또한 데이터 크기 증가가 데이터 크기에 미치는 영향을 줄이기 위해 데이터 크기를 제어하여 절제 실험을 수행했습니다. 부록 A의 예시 5와 예시 6은 각각 CoT 데이터의 입출력 형식과 미세 조정을 위한 보정 데이터를 보여줍니다. 연구원들은 실험 결과를 통해 5개의 오픈 소스 LLM과 2개의 까다로운 수학적 추론 작업에 대한 LEMA LEMA는 CoT 데이터에서만 미세 조정하는 것과 비교하여 다양한 LLM 및 작업 전반에 걸쳐 지속적으로 성능을 향상시킵니다. 예를 들어 LLaMA-2-70B를 사용한 LEMA는 GSM8K와 MATH에서 각각 83.5%와 25.0%의 결과를 얻었고, CoT 데이터에서만 미세 조정을 수행한 경우 각각 81.4%와 23.6%의 결과를 얻었습니다 또한 , LEMA는 독점 LLM과 호환됩니다. WizardMath-70B/MetaMath-70B를 사용하는 LEMA는 GSM8K에서 84.2%/85.4% pass@1 정확도를 달성하고 MATH에서 27.1%/26.9%를 달성합니다. pass@1 정확도 비율은 많은 사람들이 달성한 SOTA 성능을 초과합니다. 이러한 어려운 작업에 대한 오픈 소스 모델. 후속 절제 연구에 따르면 LEMA는 동일한 양의 데이터로 CoT 단독 미세 조정보다 성능이 여전히 뛰어난 것으로 나타났습니다. 이는 CoT 데이터와 수정된 데이터가 동등하게 효과적이지 않다는 것을 의미합니다. 두 데이터 소스를 결합하면 단일 데이터 소스를 사용하는 것보다 더 많은 개선이 이루어지기 때문입니다. 이러한 실험 결과 및 분석은 LLM 추론 기능을 향상시키기 위해 오류로부터 학습할 수 있는 가능성을 강조합니다. 자세한 연구 내용은 원문을 참고해주세요 에서 연구원은 오류 수정 데이터 쌍

에서 연구원은 오류 수정 데이터 쌍  을 생성했습니다. 여기서

을 생성했습니다. 여기서  은 질문 q_i의 부정확한 추론 경로를 나타내고 c_i는 쌍을 나타냅니다.

은 질문 q_i의 부정확한 추론 경로를 나타내고 c_i는 쌍을 나타냅니다.  수정.

수정.

에 대해 연구자는 수정 모델 M_c를 사용하여 수정을 생성한 후 아래 식 (2)와 같이 수정에서 정답을 확인합니다.

에 대해 연구자는 수정 모델 M_c를 사용하여 수정을 생성한 후 아래 식 (2)와 같이 수정에서 정답을 확인합니다.

실험 결과

위 내용은 GPT-4는 LLM이 '잘못된 질문'으로부터 학습하고 추론 능력을 크게 향상시킬 수 있도록 '세계 모델'을 만듭니다.의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!