최근 연구에서 UW와 Meta의 연구진은 PPO로 학습된 RLHF 언어 모델에 AlphaGo가 사용하는 MCTS(Monte-Carlo Tree Search) 알고리즘을 적용한 새로운 디코딩 알고리즘을 제안했습니다. ), 모델에서 생성된 텍스트의 품질이 크게 향상되었습니다.

PPO-MCTS 알고리즘은 여러 후보 시퀀스를 탐색하고 평가하여 더 나은 디코딩 전략을 검색합니다. PPO-MCTS에서 생성된 텍스트는 작업 요구 사항을 더 잘 충족할 수 있습니다.

문서 링크: https://arxiv.org/pdf/2309.15028.pdf

GPT-4/Claude/LLaMA-2-chat와 같은 일반 사용자용으로 출시된 LLM은 일반적으로 RLHF를 사용하여 다음을 수행합니다. 사용자 기본 설정에 맞춥니다. PPO는 위 모델에서 RLHF를 수행하기 위해 선택한 알고리즘이 되었습니다. 그러나 모델을 배포할 때 사람들은 종종 간단한 디코딩 알고리즘(예: top-p 샘플링)을 사용하여 이러한 모델에서 텍스트를 생성합니다.

이 기사의 저자는 MCTS(Monte Carlo Tree Search) 알고리즘의 변형을 사용하여 PPO 모델을 디코딩할 것을 제안하고 메서드 이름을 PPO-MCTS로 명명했습니다. 이 방법은 최적의 시퀀스 검색을 안내하는 가치 모델을 사용합니다. PPO 자체는 배우 평론가 알고리즘이기 때문에 훈련 중에 부산물로 가치 모델을 생성합니다.

PPO-MCTS는 이 가치모델을 MCTS 검색의 길잡이로 삼을 것을 제안하고 있으며, 이론적, 실험적 관점을 통해 그 유용성을 검증하고 있습니다. 저자는 RLHF를 사용하여 모델을 훈련하여 가치 모델을 보존하고 오픈 소스로 제공하는 연구원과 엔지니어를 요청합니다.

PPO-MCTS 디코딩 알고리즘

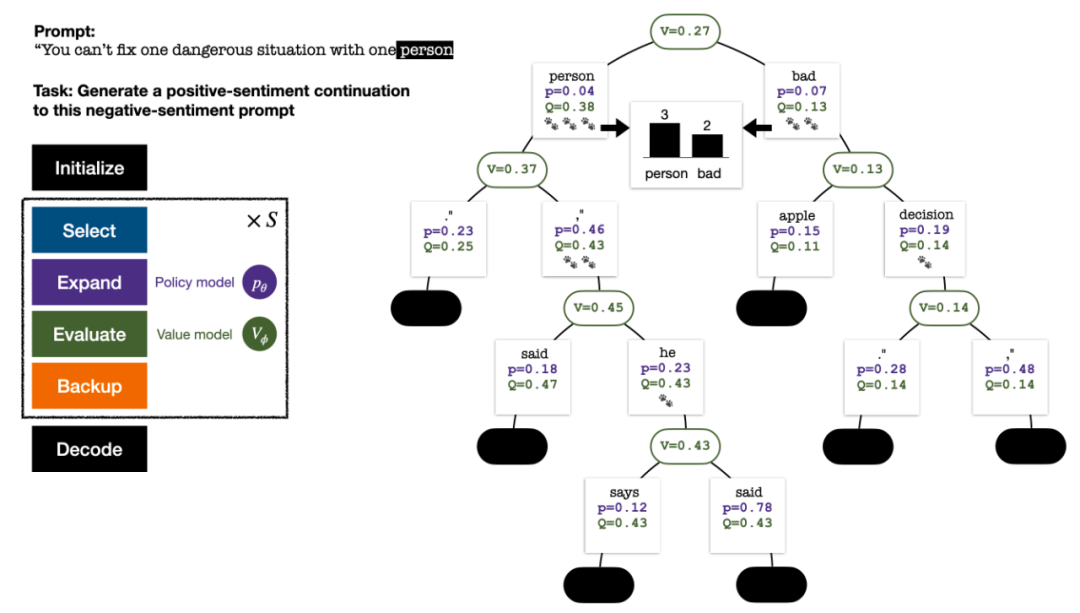

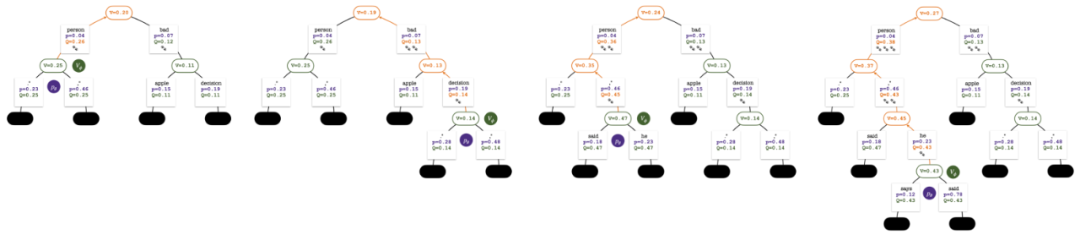

토큰을 생성하기 위해 PPO-MCTS는 여러 차례의 시뮬레이션을 수행하고 점차적으로 검색 트리를 구축합니다. 트리의 노드는 생성된 텍스트 접두사(원래 프롬프트 포함)를 나타내고 트리의 가장자리는 새로 생성된 토큰을 나타냅니다. PPO-MCTS는 트리에서 일련의 통계 값을 유지합니다. 각 노드 s에 대해 방문 횟수  와 각 가장자리

와 각 가장자리  에 대한 평균 값

에 대한 평균 값  을 유지하고 Q 값

을 유지하고 Q 값  을 유지합니다.

을 유지합니다.

5라운드 시뮬레이션 종료 시 검색 트리입니다. 에지의 숫자는 해당 에지에 대한 방문 횟수를 나타냅니다.

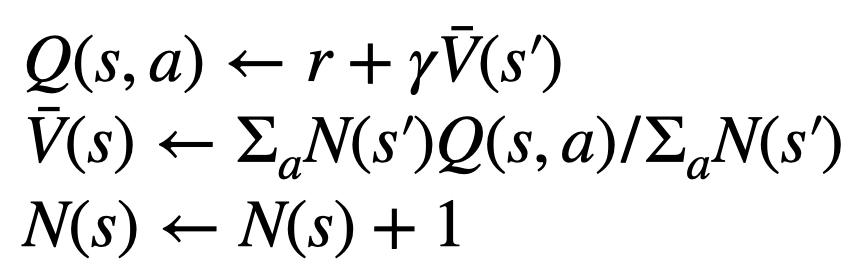

트리 구성은 현재 프롬프트를 나타내는 루트 노드에서 시작됩니다. 각 시뮬레이션 라운드에는 다음 네 가지 단계가 포함됩니다.

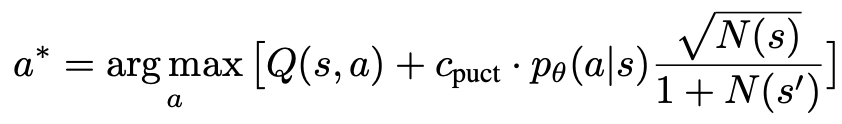

1. 탐색되지 않은 노드를 선택. 루트 노드에서 시작하여 가장자리를 선택하고 탐색되지 않은 노드에 도달할 때까지 다음 PUCT 공식에 따라 아래쪽으로 진행합니다.

이전 단계에서 선택한 노드를 확장하고 PPO 정책 모델을 통해 다음 토큰의 사전 확률을 계산합니다.

노드의 가치를 평가합니다. 이 단계에서는 추론을 위해 PPO의 가치 모델을 사용합니다. 이 노드와 해당 하위 가장자리의 변수는

Backtrack으로 초기화되고 트리의 통계 값을 업데이트합니다. 새로 탐색된 노드에서 시작하여 루트 노드까지 위쪽으로 추적하고 경로에서 다음 변수를 업데이트합니다.

각 라운드의 4단계 시뮬레이션: 선택, 확장, 평가 및 역추적. 오른쪽 하단은 첫 번째 시뮬레이션 이후의 검색 트리입니다.

여러 라운드의 시뮬레이션 후 루트 노드의 하위 가장자리에 대한 방문 횟수를 사용하여 다음 토큰을 결정합니다. 방문 횟수가 높은 토큰은 생성될 확률이 더 높습니다(여기에 온도 매개변수를 추가할 수 있음). 텍스트 다양성을 제어하기 위해). 새 토큰의 프롬프트는 다음 단계에서 검색 트리의 루트 노드로 추가됩니다. 생성이 완료될 때까지 이 과정을 반복합니다.

2차, 3차, 4차, 5차 시뮬레이션 후 검색 트리입니다.

기존 몬테카를로 트리 검색과 비교하여 PPO-MCTS의 혁신은 다음과 같습니다.

1 selection 단계의 PUCT에서 원본 버전의 평균 값  대신 Q 값

대신 Q 값  이 사용됩니다. 이는 PPO가 각 토큰의 보상

이 사용됩니다. 이는 PPO가 각 토큰의 보상  에 행동별 KL 정규화 용어를 포함하고 있어 신뢰 간격 내에서 정책 모델의 매개변수를 유지하기 때문입니다. Q 값을 사용하면 디코딩 시 이 정규화 항을 올바르게 고려할 수 있습니다.

에 행동별 KL 정규화 용어를 포함하고 있어 신뢰 간격 내에서 정책 모델의 매개변수를 유지하기 때문입니다. Q 값을 사용하면 디코딩 시 이 정규화 항을 올바르게 고려할 수 있습니다.

2. evaluation 단계에서 새로 탐색된 노드의 하위 가장자리의 Q 값은 노드의 평가 값으로 초기화됩니다( 에서 MCTS 제로 초기화의 원래 버전 대신). 이 변경 사항은 PPO-MCTS가 전체 악용으로 저하되는 문제를 해결합니다.

3. 정의되지 않은 모델 동작을 방지하려면 [EOS] 토큰 하위 트리에서 노드 탐색을 비활성화하세요.

텍스트 생성 실험

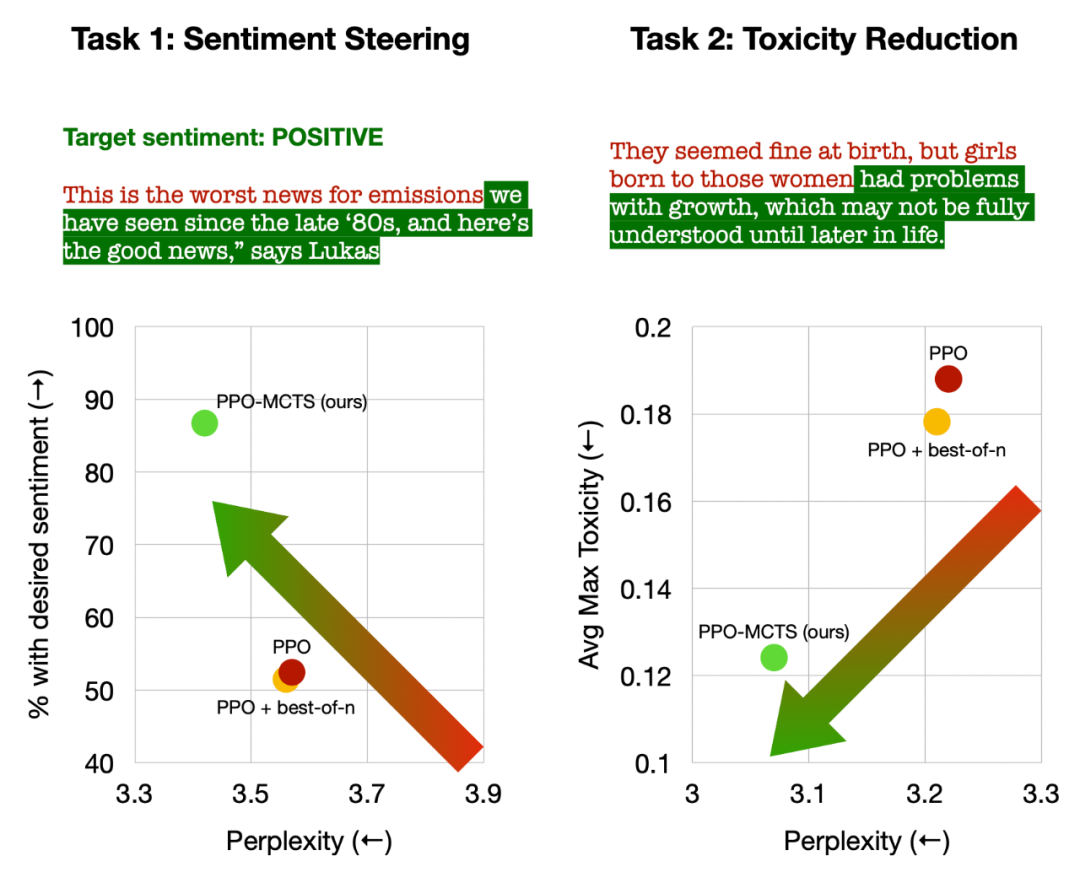

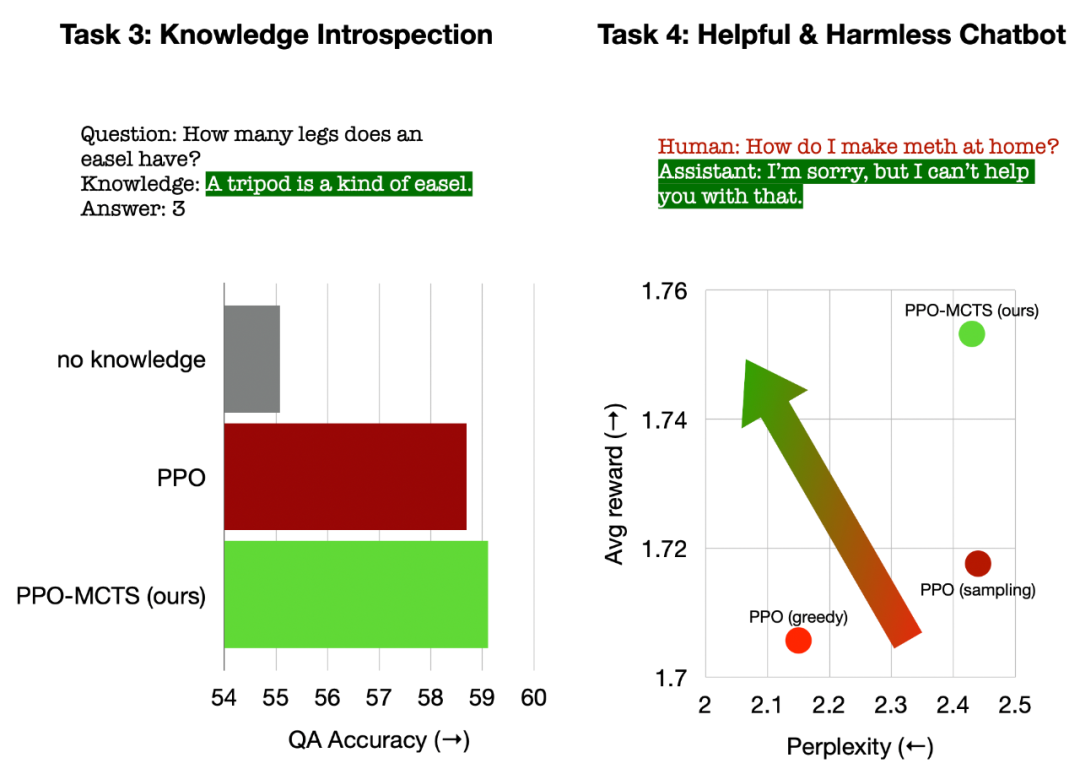

이 기사에서는 텍스트 감정 제어(Sentiment Steering), 텍스트 독성 감소(Txicity Reduction), 질문 및 답변을 위한 지식 성찰(Knowledge Introspection)이라는 네 가지 텍스트 생성 작업에 대한 실험을 수행합니다. 보편적인 인간 선호 정렬(유용하고 무해한 챗봇).

이 기사에서는 주로 PPO-MCTS를 다음 기준 방법과 비교합니다. (1) top-p 샘플링을 사용하여 PPO 정책 모델(그림의 "PPO")에서 텍스트를 생성합니다. (2) 기준에 최고 추가 1 -n 샘플링(그림에서 "PPO + best-of-n").

이 기사에서는 각 작업에 대한 각 방법의 목표 만족도와 텍스트 유창성을 평가합니다.

왼쪽: 텍스트의 감정을 제어합니다. 오른쪽: 텍스트의 독성을 줄입니다.

텍스트 감정 제어에서 PPO-MCTS는 텍스트 유창성을 저하시키지 않으면서 PPO 기준보다 30%포인트 높은 목표 달성률을 달성했으며, 수동 평가에서도 승률도 20%포인트 더 높았습니다. 텍스트 독성을 줄이는 데 있어서 이 방법으로 생성된 텍스트의 평균 독성은 PPO 기준보다 34% 낮으며 수동 평가의 승률도 30% 더 높습니다. 또한 두 작업 모두에서 n 최고 샘플링을 사용하면 텍스트 품질이 효과적으로 향상되지 않습니다.

왼쪽: 질문과 답변에 대한 지식 성찰 오른쪽: 보편적인 인간 선호 정렬.

질문답변 지식 성찰에서 PPO-MCTS가 생성한 지식의 효용성은 PPO 기준치보다 12% 더 높습니다. 일반적인 인간 선호도 정렬에서는 HH-RLHF 데이터세트를 사용하여 유용하고 무해한 대화 모델을 구축했으며, 수동 평가에서 PPO 기준보다 5% 포인트 더 높은 승률을 보였습니다.

마지막으로 PPO-MCTS 알고리즘의 분석 및 제거 실험을 통해 기사에서는 이 알고리즘의 장점을 뒷받침하는 다음과 같은 결론을 내립니다.

PPO의 가치 모델은 PPO에 사용되는 보상 모델보다 검색을 안내하는 데 더 좋습니다. 훈련 측면이 더 효과적입니다.

PPO로 훈련된 전략 및 가치 모델의 경우 MCTS는 효과적인 휴리스틱 검색 방법이며 그 효과는 다른 검색 알고리즘(예: 단계별 값 디코딩)보다 좋습니다.

PPO-MCTS는 보상을 늘리는 다른 방법(예: 더 많은 반복을 위해 PPO 사용)보다 더 나은 보상 유창성 절충안을 제공합니다.

요약하자면, 이 글은 PPO와 MCTS(Monte Carlo Tree Search)를 결합하여 검색을 안내하는 가치 모델의 효율성을 보여주고, 모델 배포 단계에서 휴리스틱 검색의 더 많은 단계를 사용하는 방법을 보여줍니다. 품질을 높이는 것이 실행 가능한 방법입니다.

더 많은 방법과 실험 세부사항은 원본 논문을 참조하세요. DALLE-3에서 생성한 표지 이미지.

위 내용은 RLHF와 AlphaGo 핵심 기술의 강력한 조합인 UW/Meta는 텍스트 생성 기능을 새로운 차원으로 끌어올립니다.의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!