(2023년 10월 19일) 비행 시간 ToF 카메라와 같은 깊이 감지 시스템을 사용하여 HoloLens 2용 환경의 깊이 이미지를 생성할 수 있습니다. 여기서 깊이 이미지의 각 픽셀은 이미지의 해당 지점까지의 거리를 나타냅니다. 환경 . ToF 이미징에서 환경 내 이미징 표면의 한 지점까지의 거리는 ToF 카메라의 빛이 해당 지점으로 이동한 다음 ToF 카메라 센서로 돌아오는 시간 간격의 길이에 따라 달라집니다.

위상 기반 ToF 이미징은 물체에서 반사된 진폭 변조 빛의 위상 변화를 기반으로 깊이를 계산하는 ToF 이미징의 변형입니다. 위상 데이터 수집 간 ToF 카메라의 움직임으로 인해 프레임 내 위상 데이터가 상대적으로 이동할 수 있습니다. 예를 들어, 첫 번째 프레임 내 위상 데이터 획득에서 픽셀은 장면 내의 위치에서 첫 번째 변조 주파수의 위상 데이터를 감지할 수 있습니다. 그런 다음 다음 프레임 내에서 위상 데이터를 수집하는 동안 픽셀은 두 번째 변조 주파수의 다른 장면 위치에서 위상 데이터를 감지할 수 있습니다. 서로 다른 주파수의 위상 데이터가 일관되지 않게 되는데, 이를 모션 블러라고 할 수 있습니다.

그래서 마이크로소프트는 "비행시간 깊이 이미징을 위한 동작 보정"이라는 특허 출원에서 ToF 이미징을 위한 동작 보정 방법을 제안했습니다.

이를 위해 첫 번째 조명 광 변조 주파수에 해당하는 활성 밝기 AB 이미지를 두 번째 조명 광 변조 주파수에 해당하는 AB 이미지와 비교하여 프레임 내 2차원 변환을 결정합니다. 프레임 내 2D 변환은 이미지화된 장면을 기준으로 카메라의 예상 모션에 해당합니다.

프레임 내 2D 변환은 위상 데이터에 적용되어 위상 이미지를 정렬하고 수정된 위상 데이터를 형성하는 데 도움이 됩니다. 다음으로, 보정된 위상 데이터에 대해 위상 언패킹(Phase Unpacking)을 수행하여 프레임 내 보정된 3차원 깊이 영상을 획득한다. 프레임 내 2D 변환을 사용하여 프레임 내 AB 이미지에 대한 모션 보정을 수행할 수도 있습니다. 예를 들어, 보정된 AB 영상을 평균함으로써 프레임 내 보정된 AB 영상을 얻을 수 있다.

이와 같은 예에서는 첫 번째 프레임의 첫 번째 AB 이미지를 두 번째 프레임의 두 번째 AB 이미지와 비교하여 프레임 간 2D 변환을 결정합니다. 프레임 간 변환은 프레임 간의 모션 추정입니다. 프레임 간 2D 변환은 프레임 간 생성된 깊이 이미지를 형성하기 위해 첫 번째 프레임의 깊이 이미지에 적용될 수 있습니다. 프레임 간 2차원 변환은 프레임 내 보정된 AB 이미지에서 결정될 수 있습니다.

또한 카메라 모션 추정으로 프레임 간 2D 변환을 출력하여 다양한 임시 후처리 루틴이나 소프트웨어 서비스에 사용할 수 있습니다. 따라서, 특허에 설명된 실시예는 2D 인트라 프레임 AB 이미지 데이터를 사용하여 3D 깊이 데이터의 모션 블러 보정을 달성하는 데 도움이 될 수 있습니다. 2차원 데이터를 이용하면 모션 블러 보정을 위해 3차원 깊이 데이터를 이용하는 것보다 상대적으로 효율적인 계산 성능으로 실시간으로 모션 보정을 수행할 수 있습니다.

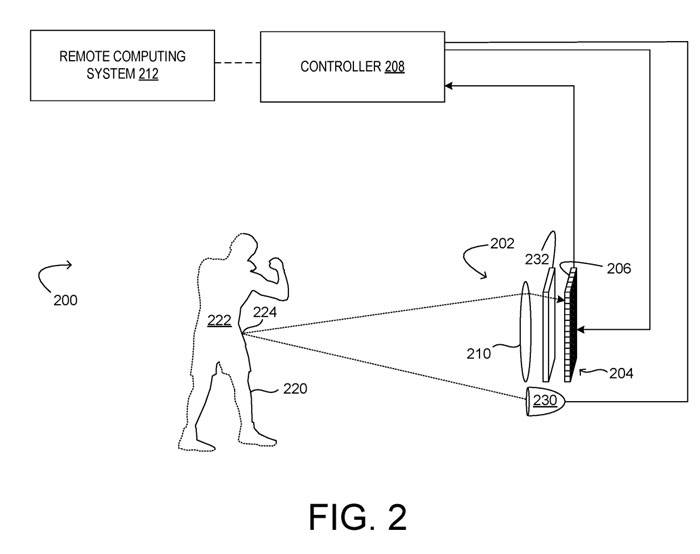

그림 2는 ToF 카메라(202)를 포함한 예를 보여줍니다. 그 중 ToF 카메라는 위상 기반 ToF 깊이 영상 시스템(200)이다. ToF 카메라(202)는 각각 위상 데이터를 캡처하는 광 샘플을 획득하도록 구성된 복수의 ToF 픽셀(206)을 포함하는 센서 어레이(204), 컨트롤러(208) 및 대물 시스템(210)을 포함한다.

컨트롤러(208)는 깊이 이미지를 구성하기 위해 센서 어레이(204)의 ToF 픽셀(206)로부터 데이터를 수집하고 처리하도록 구성됩니다. 제어기(208)는 잡음 제거 및/또는 위상 언래핑을 수행하기 위한 실행 가능한 명령을 포함할 수 있다.

깊이 이미징 시스템(200)은 센서 어레이(204)를 통해 빛의 통합을 제어하기 위해 센서 어레이(204)용 변조된 광 방출기(230)와 아날로그 및/또는 디지털 변조된 전자 셔터(232)를 모두 포함합니다. 변조된 광 방출기(230)는 ToF 픽셀(206)에 의해 검출 가능한 임의의 주파수의 전자기 방사선을 방출하도록 구성될 수 있다.변조된 광은 순차적으로 또는 동시에 서로 다른 주파수로 변조될 수 있으며, 센서 어레이(204)는 변조된 광 방출기(230)로부터 표면(220)으로 반사된 후 다시 카메라로 반사된 광을 샘플링하도록 구성됩니다. 센서 어레이(204)의 각 ToF 감지 픽셀(206)은 서로 다른 시간 간격으로 반사된 광 신호를 통합하여 위상 편이를 결정하기 위해 하나 이상의 픽셀 탭을 포함할 수 있습니다.

각 변조 주파수에 대해 센서 어레이(204)는 광원에서 나오는 진폭 변조된 광의 여러 위상 각도에서 광을 샘플링하고 변조 주파수에 대한 여러 광 샘플에서 각 변조 주파수에 대한 위상 샘플을 결정하도록 제어됩니다. 그런 다음 위상 샘플을 풀어 각 픽셀의 깊이 값을 얻을 수 있습니다.

변조된 빛의 주기성으로 인해 측정된 전체 위상은 2π마다 반복됩니다. n(k)는 위상 기반 ToF 픽셀로 직접 측정할 수 없기 때문에 전체 위상 및 측정과 관련된 실제 거리가 모호합니다. 따라서 위상 기반 ToF 이미징에서 측정할 수 있는 거리(흐림이 없는 범위)는 변조 주파수에 의해 제한됩니다.

두 개 이상의 서로 다른 변조 주파수를 사용하여 모호성이 없는 범위를 늘릴 수 있으며, 수집된 위상 변이 데이터를 분산시켜 거리를 정확하게 결정할 수 있습니다.

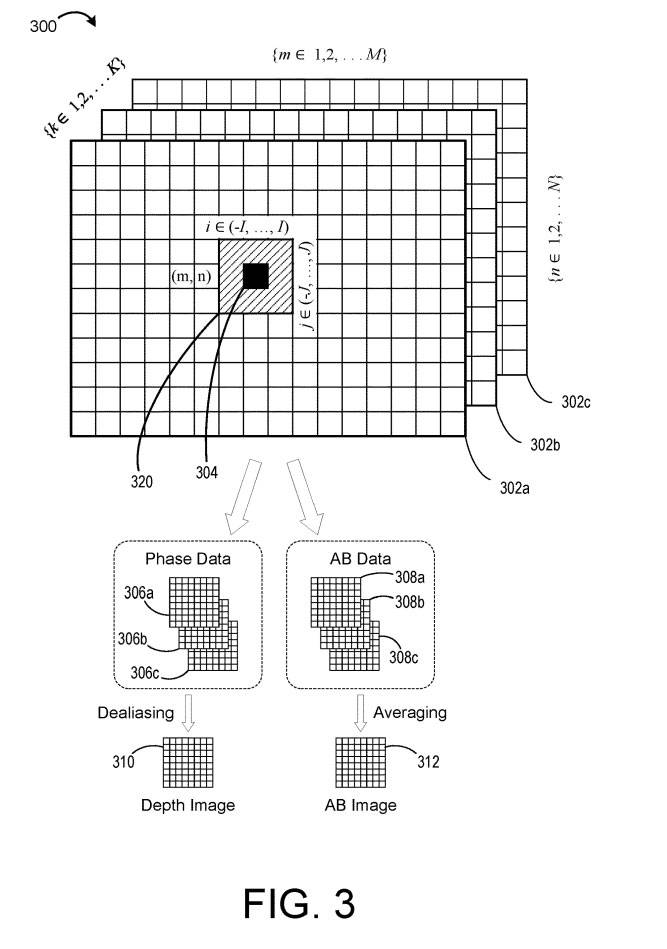

도 3은 복수의 K 변조 주파수에 대한 예시적인 ToF 이미지 데이터(300)를 개략적으로 예시합니다. 데이터(300)는 다중 주파수 프레임 획득 동안 깊이 이미징 시스템(200)에 의해 획득될 수 있는 데이터를 나타낸다.

도시된 예에서, 깊이 데이터는 K 변조 주파수 각각에 대한 데이터의 M×N 어레이를 포함하며, 그 결과 프레임 내 깊이 데이터(302a-c)의 M×N 그리드가 생성됩니다. 여기서 각 그리드에서 각 픽셀(304)은 다음을 나타냅니다. K개의 변조 주파수 중 해당 조명 광 변조 주파수 K에서 얻은 측정값.

측정된 위상은 픽셀과 관련된 깊이 값을 계산하는 데 사용됩니다. 그러나 위에서 언급한 것처럼 위상 기반 ToF 이미징에서는 측정할 수 있는 거리(블러 프리 범위)가 변조 주파수에 의해 제한됩니다. 따라서 K ≥ 2 변조 주파수 K 세트를 사용하여 범위를 늘릴 수 있으며, 위상 정보를 풀어 거리를 정확하게 결정할 수 있습니다.

위상 언래핑은 조명 빛의 각 주파수마다 거리 모호성이 다르기 때문에 서로 다른 주파수의 여러 진폭 변조 조명으로 장면을 조명하여 위상 변이 데이터를 명확하게 하고 정확한 거리 값을 식별하는 방법입니다.

그러나 위에서 언급한 것처럼 ToF 깊이 카메라가 움직이는 경우 위상 풀림 오류가 발생할 수 있습니다. 각 주파수별 깊이 데이터 획득은 순차적으로 이루어지기 때문에 위상 영상과 AB 영상은 한 프레임 내에서 일시적으로 분리된다.

예를 들어, 프레임 내 위상 이미지(306a)는 프레임의 시작 부분으로 획득된 제1 주파수 θ1 위상 데이터를 포함할 수 있고, 프레임 내 위상 이미지(306b)는 프레임의 중간 부분으로 획득된 제2 주파수 θ2 위상 데이터를 포함할 수 있으며, 프레임 내 위상 이미지(306b)는 프레임의 끝 부분에서 획득된 제3 주파수 θ3 위상 데이터를 포함할 수 있다.따라서 ToF 깊이 카메라가 프레임 내 획득 간에 이동하는 경우 세 가지 다른 주파수의 위상 데이터가 이동되고 잘못 정렬될 수 있습니다. 일관성 없는 위상 데이터는 위상 풀기 오류로 이어질 수 있습니다.

그래서 Microsoft는 AB 이미지 데이터를 사용하여 동작을 추정하고 2D 변환을 결정하는 솔루션을 제안했습니다.

회사에서는 깊이 데이터를 사용할 수 있지만 장면 내 객체 간의 활성 밝기 차이로 인해 AB 이미지 데이터를 기반으로 2D 변환을 결정하는 것이 더 강력할 수 있다고 지적합니다. 그런 다음 2D 변환을 사용하여 위상 데이터에 대해 프레임 내 모션 보정을 수행할 수 있습니다. 프레임 내 수정된 위상 데이터에 대해 위상 언래핑을 수행하면 모션 블러로 인한 언래핑 오류를 방지하는 데 도움이 될 수 있습니다.

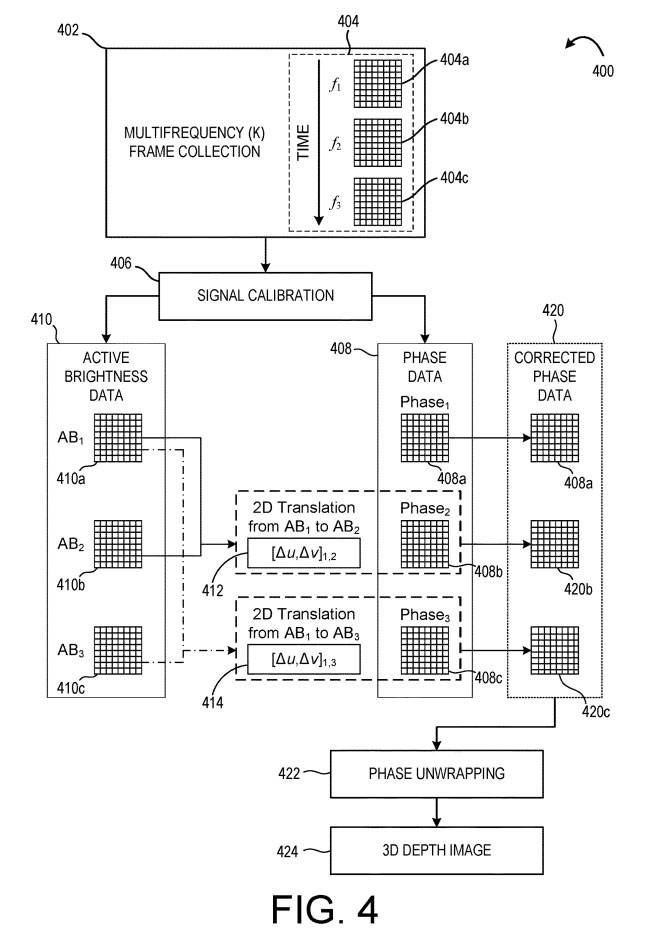

402에서는 ToF 이미지 센서에 의해 여러 프레임 내 위상 샘플이 수집되는 다중 주파수 프레임 수집이 수행됩니다. 프레임 내 위상 샘플은 대응하는 프레임 내 깊이 데이터(404a-c)를 형성하기 위해 복수의 조명 광 변조 주파수(f1, f2, f3) 각각에 대해 수집됩니다. 이 예에서, 시간 화살표로 도시된 바와 같이, 프레임 내 깊이 데이터(404a)가 먼저 획득되고, 프레임 내 깊이 데이터(404b)가 두 번째로 획득되고, 프레임 내 깊이 데이터(404c)가 세 번째로 획득된다.

406에서는 위상 데이터(408)와 활성 밝기 데이터(410)를 얻기 위해 신호 교정 보정이 수행됩니다. 위에서 언급한 바와 같이, 서로 다른 주파수의 프레임 내 깊이 데이터는 카메라 움직임으로 인해 상대적으로 이동될 수 있습니다. 따라서, 방법(400)은 활성 밝기 데이터(410)를 비교하여 모션을 추정하고 수정한다.

여기서, AB 내 이미지(410a)는 AB 내 이미지(410b)와 비교되어 첫 번째 프레임 내 2D 변환(412)을 결정합니다. AB1에서 AB2로의 2차원 변환은 [Δu, Δv]1,2로 표현될 수 있습니다. 여기서 Δu는 x 방향의 픽셀 변위이고 Δv는 y 방향의 픽셀 변위입니다. 2D 내 변환(412)은 프레임 내 깊이 데이터(404a)와 프레임 내 깊이 데이터(404b) 사이의 모션 추정치이다.

다음으로, 인트라 AB 이미지(410a)는 인트라 AB 이미지(410c)와 비교되어 [Δu, Δv](13)로 표시되는 두 번째 인트라 2D 변환(414)을 결정합니다.

일 실시예에서, AB 내 이미지(410b)는 AB 내 이미지(410c)와 비교되어 세 번째 프레임 내 2D 변환을 결정할 수 있습니다. 다른 예에서, 임의의 적합한 프레임 내 AB 이미지 쌍을 비교하여 대응하는 프레임 내 2D 변환을 결정할 수 있습니다. AB 이미지를 비교하고 번역을 결정하는 데 적합한 방법을 사용할 수 있습니다. 한 가지 예에서는 AB 이미지에서 특징을 추출하여 특징 맵으로 구성하고 이미지를 비교하는 데 사용합니다.

2D 변환을 결정한 후 결정된 변환을 사용하여 위상 데이터를 수정할 수 있습니다. 도 4에 도시된 실시예에서, 프레임 내 2차원 이동(412)은 위상 이미지(408b)에 적용되어 위상 이미지를 수정하여 수정된 위상 이미지(420b)를 형성한다. 유사하게, 위상 이미지(408c)에 대해 프레임 내 2차원 이동(414)이 수행되어 위상 이미지를 수정하여 수정된 위상 이미지(420c)를 형성한다.

따라서 수정된 위상 데이터(420)는 위상 이미지(408a)에 "재정렬"된 위상 데이터를 나타냅니다. 일례에서, 위상 이미지(408b 또는 408c)와 정렬된 수정된 위상 이미지를 형성하기 위해 하나 이상의 2차원 이동이 적용될 수 있습니다.

422에서, 방법(400)은 또한 정정된 위상 데이터(420)에 대해 위상 언래핑을 수행하여 깊이 이미지(424)를 형성하는 단계도 포함합니다. 정정된 위상 이미지(420b, 420c)는 위상 이미지(408a)로 재정렬될 수 있으므로, 422에서의 위상 언래핑은 모션 블러 정정이 무시되는 예에서보다 상대적으로 적은 언래핑 오류를 생성할 수 있습니다.

따라서 방법 400은 깊이 이미지(424)를 형성하기 위해 깊이 데이터(404)를 처리하는 데 더 나은 성능을 달성하는 데 도움이 될 수 있습니다.

또한 프레임 내 2D 변환 적용은 컨볼루션을 통해 수행될 수 있으므로 컨볼루션을 활용하는 공간적 및 시간적 필터링 프로세스와 결합될 수 있습니다. 동시에, 카메라 모션의 추정으로서 결정된 프레임 내 2D 변환은 시간 필터, 궤적 추정, 동적 영역 추정 또는 매핑과 같은 다양한 후처리 애플리케이션에 유용할 수 있습니다. 유사한 기술을 사용하여 내부 AB 이미지를 수정하고 내부 수정된 AB 이미지를 형성할 수 있습니다.

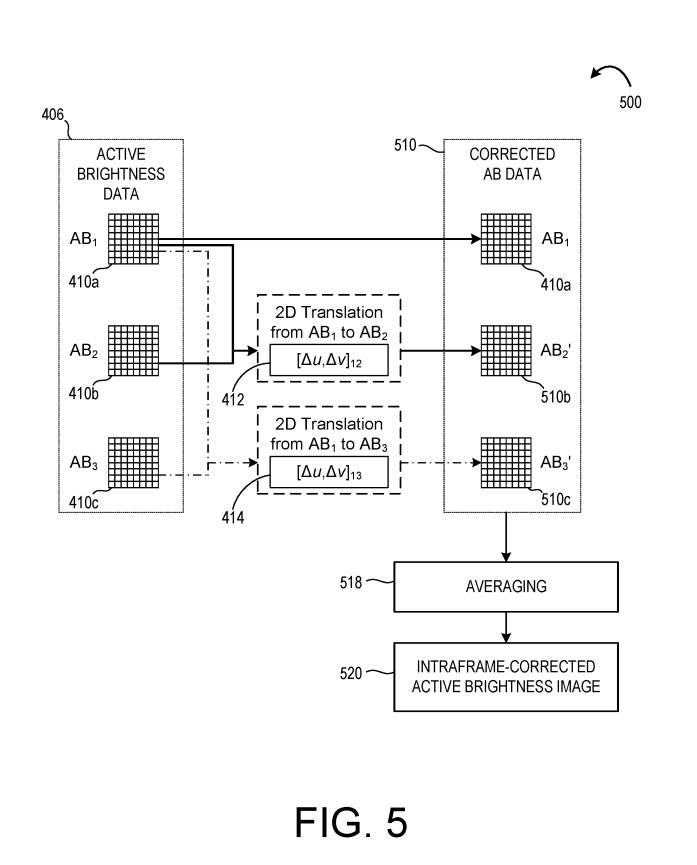

도 5를 참조하면, 방법(500)은 프레임 내 2차원 변환(412, 414)을 활용하여 수정된 AB 데이터(510)를 형성합니다. 일례에서, 방법(500)은 방법(400)과 함께 수행된다. 다른 예에서, 방법(500)은 방법(400)과 별도로 수행된다.

그림 5에 도시된 바와 같이, 프레임 내 AB 이미지(410b)에 프레임 내 2차원 변환(412)이 적용되어 이미지를 수정하여 수정된 AB 이미지(510b)를 형성합니다. 또한, 프레임 내 2차원 변환(414)이 AB 이미지(410c)에 적용되어 수정된 AB 이미지(510c)를 형성한다. 인트라 AB 이미지(408a)와 함께, 수정된 AB 이미지(510b-c)는 수정된 AB 데이터(510)를 형성한다.

518에서, 방법(500)은 수정된 AB 데이터(510)를 평균하여 프레임 내 수정된 AB 이미지(520)를 형성하는 단계를 더 포함합니다. 인트라 보정된 AB 이미지(520)는 추가 처리를 위해 출력 및/또는 디스플레이로 출력될 수 있다.

프레임 내 보정된 AB 이미지를 사용하여 프레임 간 깊이 이미지를 생성할 수도 있습니다. 깊이 이미지 프레임 내의 모션 블러를 교정하는 것 외에도 프레임 간에도 교정을 수행할 수 있습니다.

관련 특허: 비행 시간 깊이 이미징을 위한 Microsoft 특허 |

"비행 시간 깊이 이미징을 위한 동작 보정"이라는 제목의 Microsoft 특허 출원은 원래 2022년 3월에 제출되었으며 최근 미국 특허청에 게시되었습니다.

위 내용은 Microsoft AR/VR 특허는 ToF 이미징을 위한 모션 보정 방법을 공유합니다.의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!