본 글은 자율주행하트 공개 계정의 승인을 받아 재인쇄되었습니다.

올해는 End-to-end가 매우 인기 있는 방향입니다. 올해 CVPR 최우수 논문도 UniAD에 상을 받았지만, end-to-end에도 문제가 많습니다. 해석성이 낮고, 훈련이 수렴되기 어렵기 때문에 해당 분야의 일부 학자들은 점차 엔드투엔드 해석성에 관심을 돌리기 시작했습니다. 오늘은 엔드투엔드 해석성에 관한 최신 연구를 여러분과 공유하겠습니다. ADAPT. 이 방법은 Transformer 아키텍처를 기반으로 하며 멀티 태스킹을 사용합니다. 공동 훈련 방법은 각 결정에 대한 차량 동작 설명과 추론을 끝까지 출력합니다. ADAPT에 대한 저자의 생각은 다음과 같습니다.

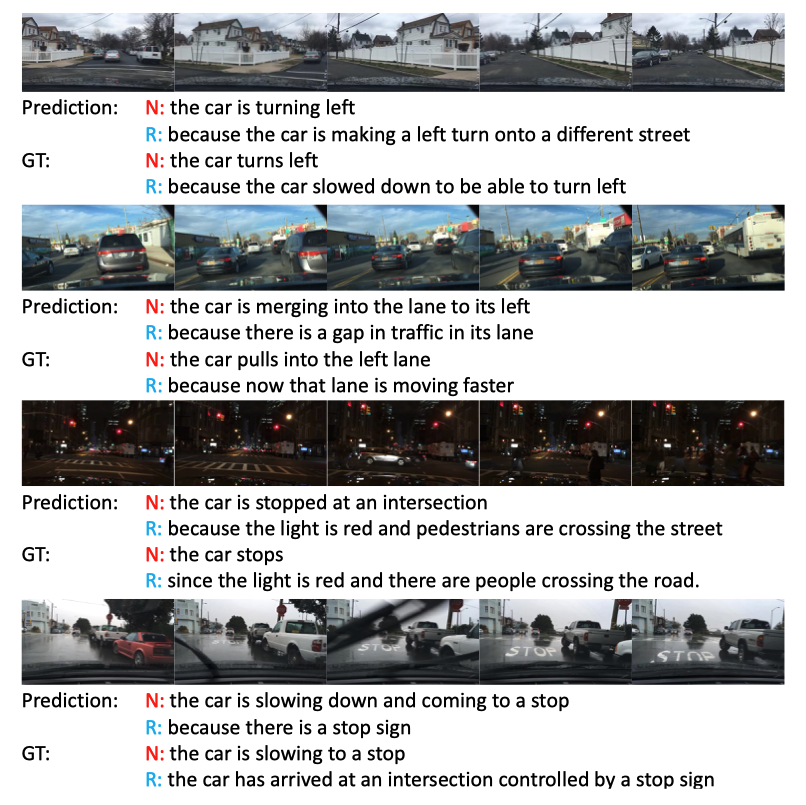

효과는 여전히 매우 좋습니다. 특히 세 번째 어두운 밤 장면에서 신호등이 눈에 띕니다.

효과는 여전히 매우 좋습니다. 특히 세 번째 어두운 밤 장면에서 신호등이 눈에 띕니다.

유연한 구문 구조로 자연스러운 문장을 생성하기 위해 일부 방법에서는 시퀀스 학습 기술을 채택합니다. 특히 이러한 방법은 비디오 인코더를 사용하여 기능을 추출하고 언어 디코더를 사용하여 시각적 텍스트 정렬을 학습합니다. 설명을 더욱 풍부하게 만들기 위해 이러한 방법은 객체 수준 표현을 활용하여 비디오의 상세한 객체 인식 상호 작용 기능을 얻습니다.

기존 아키텍처는 일반적인 비디오 캡션 방향에서 특정 결과를 달성했지만 액션 표현에는 직접 적용할 수 없습니다. 단순히 비디오 설명을 자율 주행 동작 표현으로 전송하면 자율 주행 작업에 중요한 차량 속도 등과 같은 일부 주요 정보가 손실됩니다. 이러한 다중 모드 정보를 효과적으로 활용하여 문장을 생성하는 방법은 여전히 연구 중입니다. PaLM-E는 다중 모드 문장에서 잘 작동합니다.

엔드 투 엔드 자율 주행또한 일부 방법은 차량, 자전거 타는 사람, 보행자와 같은 교통 참여자의 미래 행동을 모델링하여 차량의 웨이포인트를 예측하는 반면, 다른 방법은 센서 입력을 기반으로 직접 차량의 제어 신호를 예측합니다. 이 작품

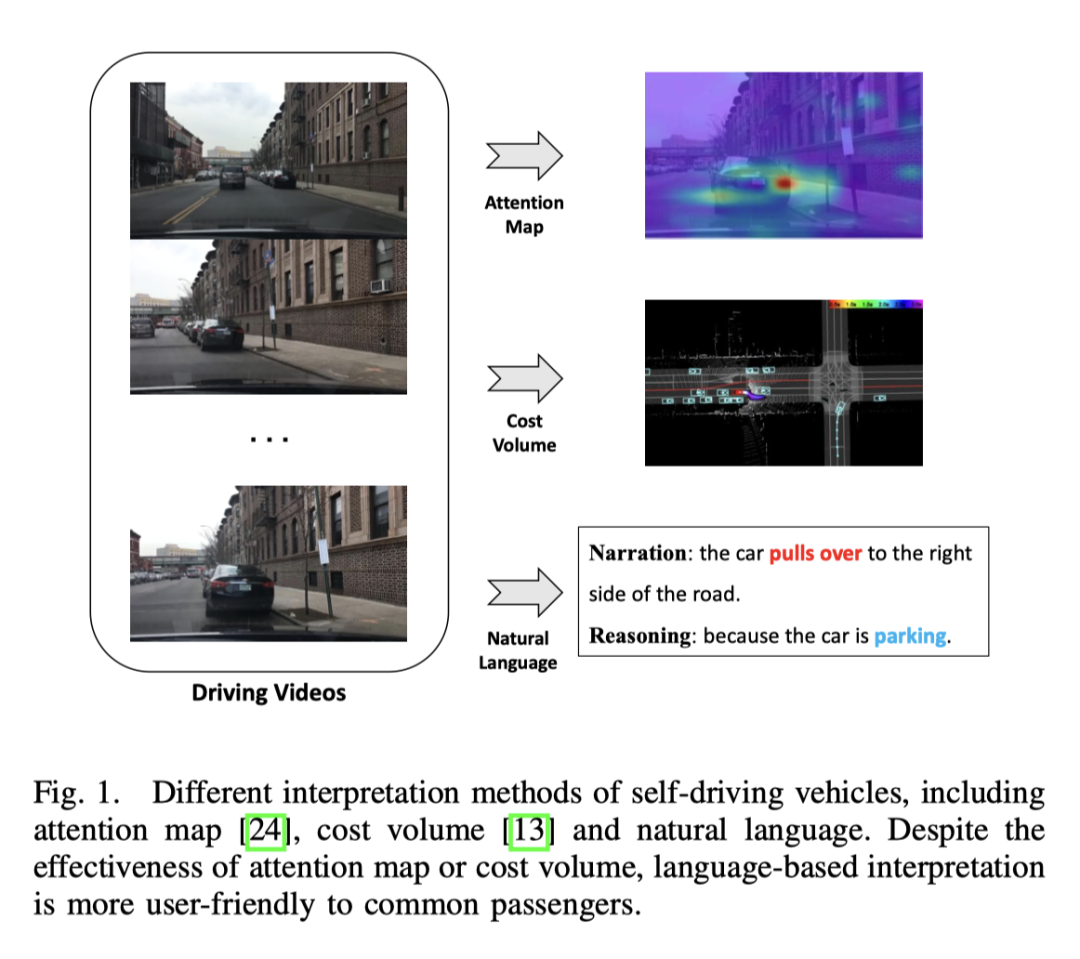

자율주행 분야에서 대부분의 해석 방법은 비전을 기반으로 하며, 일부는 LiDAR 작업을 기반으로 합니다. 일부 방법은 주의 지도를 활용하여 중요하지 않은 이미지 영역을 필터링하여 자율 차량의 동작을 합리적이고 설명 가능하게 만듭니다. 그러나 주의 지도에는 덜 중요한 영역이 포함될 수 있습니다. LiDAR와 고정밀 지도를 입력으로 사용하고, 다른 교통 참가자의 경계 상자를 예측하고, 온톨로지를 활용하여 의사 결정 추론 프로세스를 설명하는 방법도 있습니다. 추가적으로 HD 맵에 대한 의존도를 줄이기 위해 분할을 통해 온라인 맵을 구축하는 방법도 있습니다. 비전 또는 LiDAR 기반 방법은 좋은 결과를 제공할 수 있지만, 구두 설명이 부족하면 전체 시스템이 복잡해 보이고 이해하기 어려워집니다. 오프라인에서 영상 특징을 추출하여 제어 신호를 예측하고 영상 설명 작업을 수행함으로써 최초로 자율주행차의 텍스트 해석 가능성을 탐구하는 연구입니다

최종 프레임워크 다중 작업 학습은 텍스트 생성과 제어 신호 예측이라는 두 가지 작업으로 모델을 공동으로 훈련하기 위해 채택되었습니다. 다중 작업 학습은 자율 주행에 널리 사용됩니다. 더 나은 데이터 활용과 공유 기능으로 인해 서로 다른 작업의 공동 학습은 각 작업의 성능을 향상시킵니다. 따라서 이 작업에서는 제어 신호 예측과 텍스트 생성이라는 두 가지 작업의 공동 학습이 사용됩니다.

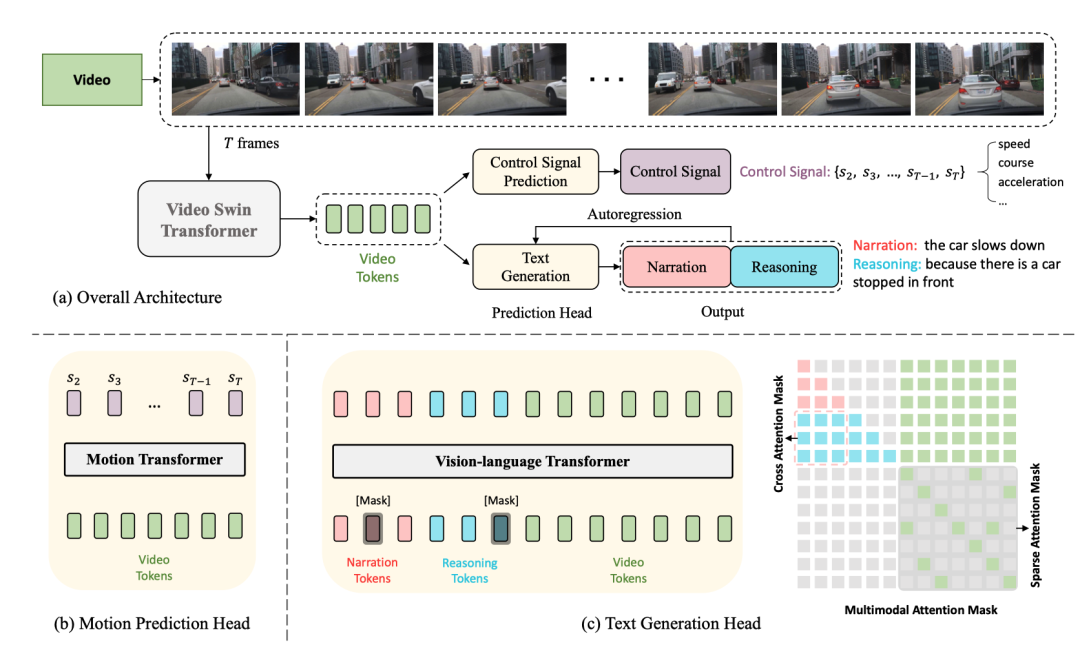

다음은 네트워크 구조 다이어그램입니다.

전체 구조는 두 가지 작업으로 나뉩니다.

그 중 DCG와 CSP의 두 가지 작업은 비디오 인코더를 공유하지만 서로 다른 예측 헤드를 사용하여 서로 다른 최종 출력을 생성합니다.

DCG 작업의 경우 비전 언어 변환기 인코더를 사용하여 두 개의 자연어 문장을 생성합니다.

CSP 작업의 경우 모션 변환 인코더를 사용하여 제어 신호의 순서를 예측합니다.

여기서 비디오 스윈 변환기는 입력 비디오 프레임을 비디오 기능 토큰으로 변환하는 데 사용됩니다.

입력 桢이미지, 모양은 , 특징의 크기는 입니다. 여기서 는 채널의 크기입니다.

위의 기능 , 토큰화 후, 차원이 있는 비디오 토큰 을 얻은 다음 MLP를 사용하여 텍스트 토큰 임베딩에 맞춰 차원을 조정한 다음 텍스트 토큰과 비디오 토큰을 비전에 공급합니다. 언어 변환기 인코더를 함께 사용하여 동작 설명과 추론을 생성합니다.

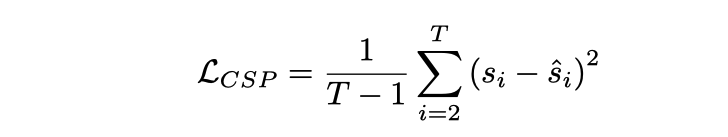

및 입력 桢비디오는 제어 신호 에 해당합니다. 여기서 각 제어 신호는 일 수 있습니다. -속도, 가속도, 방향 등과 같은 차원. 여기서의 접근 방식은 비디오 기능을 토큰화하고 모션 변환기를 통해 일련의 출력 신호를 생성하는 것입니다. 손실 함수는 MSE입니다.

첫 번째 프레임이 제공하기 때문에 여기에는 첫 번째 프레임이 포함되지 않습니다. 동적 정보가 너무 적습니다.

이 프레임워크에서는 공유된 비디오 인코더로 인해 실제로 CSP와 DCG의 두 가지 작업이 비디오 표현 수준에서 일치한다고 가정합니다. 출발점은 동작 설명과 제어 신호가 세밀한 차량 동작의 서로 다른 표현이며, 동작 추론 설명은 주로 차량 동작에 영향을 미치는 운전 환경에 중점을 둡니다.

합동 훈련을 활용한 훈련

합동 훈련 장소임에도 불구하고 추론 시 독립적으로 실행할 수 있다는 점에 유의하세요. CSP 작업은 흐름도에 따라 동영상이 직접 입력되고, 출력 제어 DCG 작업의 경우 비디오를 직접 입력하고 설명 및 추론을 출력합니다. 텍스트는 [CLS]에서 시작하여 [SEP]에 도달하는 자동 회귀 방식을 기반으로 한 단어씩 생성됩니다. 길이 임계값.

사용된 데이터 세트는 BDD-X입니다. 이 데이터 세트에는 7000개의 페어링된 비디오와 제어 신호가 포함되어 있습니다. 각 동영상은 약 40초 동안 지속되며, 이미지 크기는 , 빈도는 FPS입니다. 각 동영상에는 가속, 우회전, 합류 등 1~5가지 차량 동작이 포함되어 있습니다. 이러한 모든 행동에는 행동 내러티브(예: "자동차가 멈췄습니다")와 추론(예: "신호등이 빨간색이기 때문에")을 포함한 텍스트로 주석이 추가됩니다. 총 약 29,000개의 행동 주석 쌍이 있습니다.

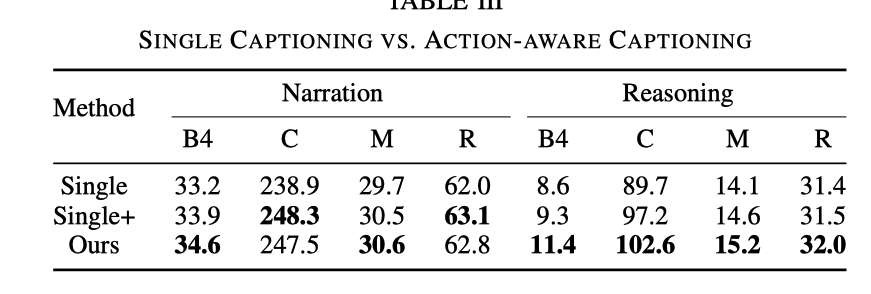

여기에서는 공동 훈련의 효과를 설명하기 위해 세 가지 실험을 비교합니다.

은 CSP 작업을 제거하고 DCG 작업만 유지하는 것을 의미하며, 이는

CSP만 훈련하는 것과 같습니다. 태스크는 아직 존재하지 않지만 DCG 모듈 입력 시 비디오 태그 외에 제어 신호 태그도 입력해야 합니다

효과 비교는 다음과 같습니다

DCG 태스크만 비교했을 때 ADAPT의 추론 효과가 훨씬 좋아집니다. 제어 신호 입력이 있으면 효과가 향상되지만 여전히 CSP 작업을 추가하는 효과만큼 좋지 않습니다. CSP 과제를 추가한 후 영상을 표현하고 이해하는 능력이 더욱 강해졌습니다

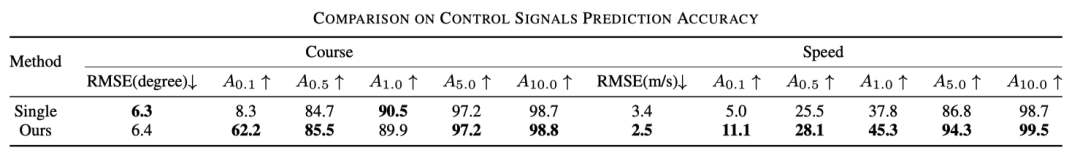

또한 아래 표를 보면 CSP에 대한 합동 훈련의 효과도 향상되었음을 알 수 있습니다.

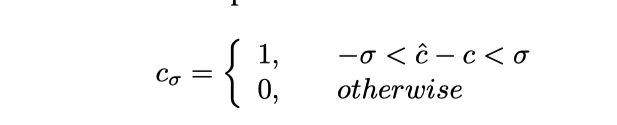

여기 는 다음과 같이 이해될 수 있습니다. 정확도, 구체적으로는 예측된 제어 신호를 잘라내고 수식은 다음과 같습니다

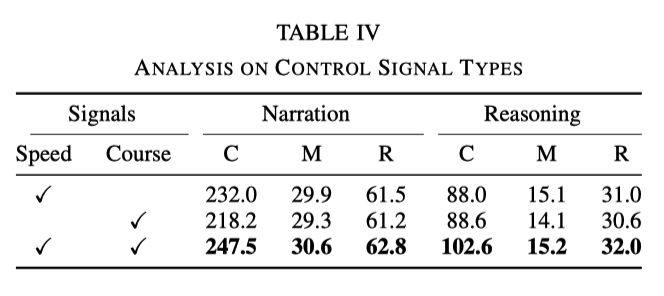

실험에서 사용된 기본 신호는 속도와 방향입니다. 그러나 실험 결과, 두 신호 중 하나만 사용하는 경우 두 신호를 동시에 사용하는 것만큼 효과가 좋지 않은 것으로 나타났습니다. 구체적인 데이터는 다음 표에 나와 있습니다. 속도와 방향이 네트워크에 도움이 될 수 있습니다. 더 나은 학습 동작 설명 및 추론

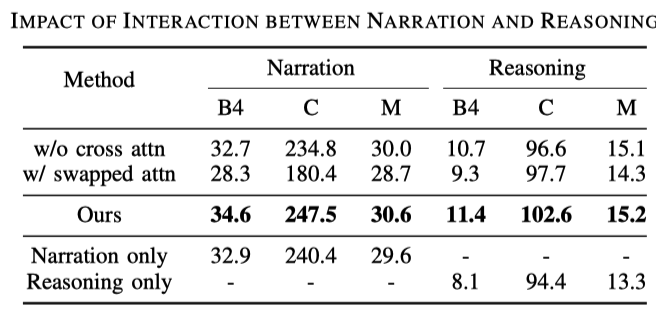

동작 설명과 추론의 상호 작용

동작 설명과 추론의 상호 작용

다음 세 줄을 비교하면 설명만 출력하는 것과 추론만 출력하는 것이 둘 다 출력하는 것만큼 좋지 않습니다.

위 내용은 새 제목: ADAPT: 엔드투엔드 자율 주행 설명 가능성에 대한 예비 탐색의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!