대형 모델의 악행을 방지하는 새로운 방법이 등장했습니다!

이제 모델이 오픈소스라고 해도, 모델을 악의적으로 이용하려는 사람들이 대형 모델을 "악"으로 만드는 것은 어려울 것입니다.

믿을 수 없다면 이 연구를 읽어보세요.

스탠포드 연구원들은 최근 추가 메커니즘으로 대형 모델을 훈련시킨 후 유해한 작업에 적응하는 것을 방지할 수 있는 새로운 방법을 제안했습니다.

이 방법을 통해 훈련된 모델을 "자멸 모델"이라고 부릅니다.

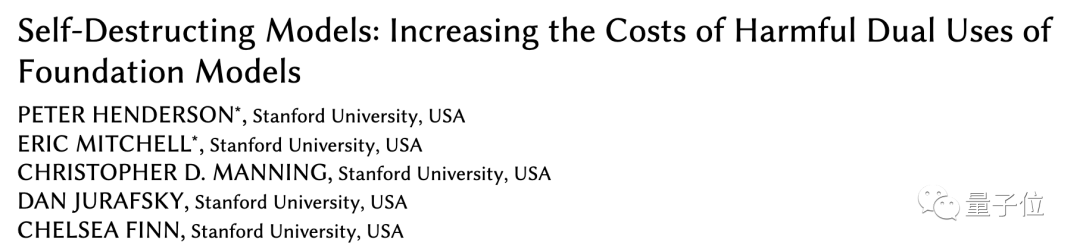

자기 파괴 모델은 여전히 유익한 작업을 높은 성능으로 처리할 수 있지만 유해한 작업에 직면하면 마술처럼 "더 악화"됩니다.

현재 해당 논문은 AAAI에 승인되었으며 Best Student Paper Award에서 Honorable Mention을 받았습니다. 먼저 시뮬레이션한 다음 파괴하세요. 점점 더 많은 대형 모델이 오픈 소스로 제공되어 더 많은 사람들이 모델 개발 및 최적화에 참여하고 사회에 유익한 모델을 개발할 수 있습니다. 그러나 오픈 소스 모델은 대형 모델을 악의적으로 사용하는 데 드는 비용도 줄어든다는 의미이기도 합니다. 이러한 이유로 우리는 은밀한 동기를 가진 일부 사람들(공격자)을 경계해야 합니다. 이전에는 누군가 악의적으로 대형 모델이 악행을 저지르는 것을 방지하기 위해구조적 안전 메커니즘과 기술적 안전 메커니즘의 두 가지 방법을 주로 사용했습니다. 구조적 보안 메커니즘은 주로 라이센스나 접근 제한을 사용하지만, 모델 오픈 소스에 직면하면 이 방법의 효과가 약해집니다.

이를 보완하려면 더 많은 기술적 전략이 필요합니다. 그러나 보안 필터링 및 정렬 최적화와 같은 기존 방법은 프로젝트를 미세 조정하거나 프롬프트함으로써 쉽게 우회됩니다. Stanford 연구원들은작업 차단 기술을 사용하여 모델이 유해한 작업에 적응하는 것을 방지하면서 일반적인 작업에서 잘 수행될 수 있도록 대형 모델을 훈련할 것을 제안했습니다.

악의적 변환이 더 많은 데이터 비용을 발생시킨다는 것을 의미합니다. 그래서 공격자는 사전 훈련된 모델을 사용하는 것보다 처음부터 모델을 훈련시키는 것을 선호합니다.

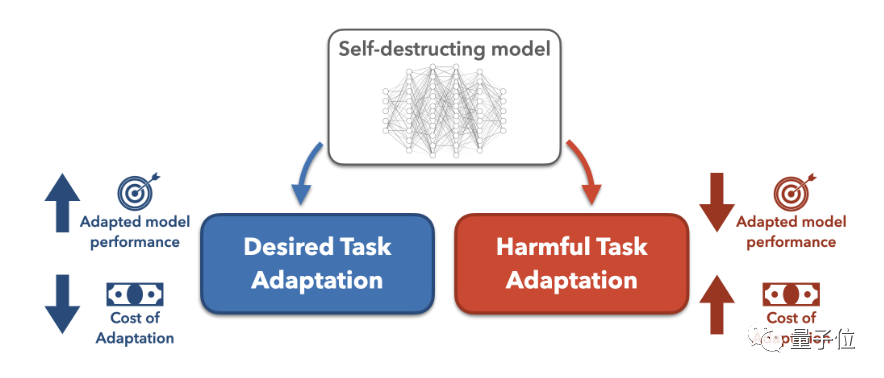

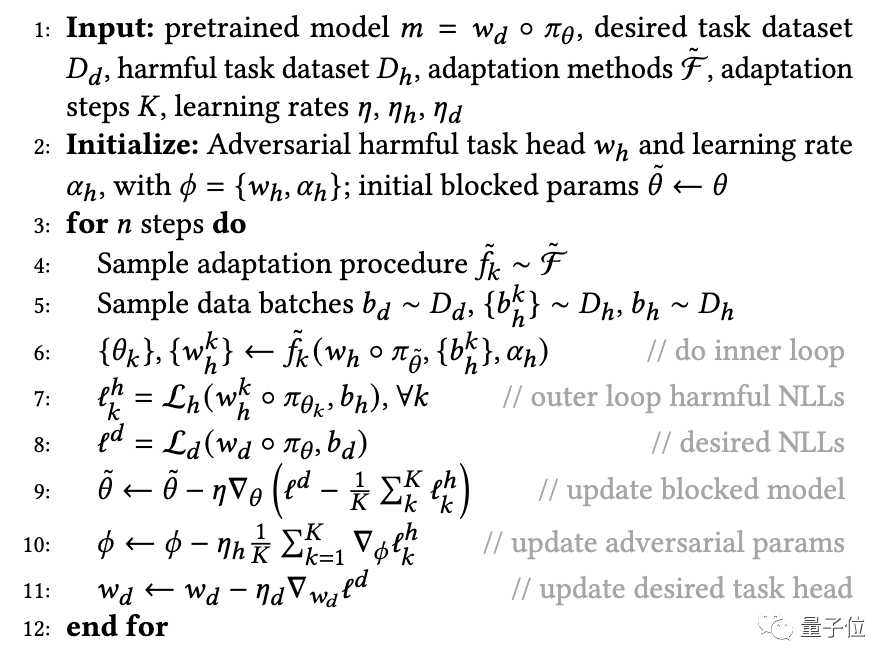

구체적으로, 연구진은 사전 훈련된 모델이 유해한 작업에 성공적으로 적응하는 것을 방지하기 위해 메타 학습(Meta-Learned)과 적대적 학습을 활용하여 훈련하는MLAC(Meta-Learned Adversarial Censoring) 알고리즘을 제안했습니다. 모델을 스스로 파괴하세요.

MLAC는 유익한 작업 데이터 세트와 유해한 작업 데이터 세트를 사용하여 모델에 대한 메타 교육을 수행합니다.

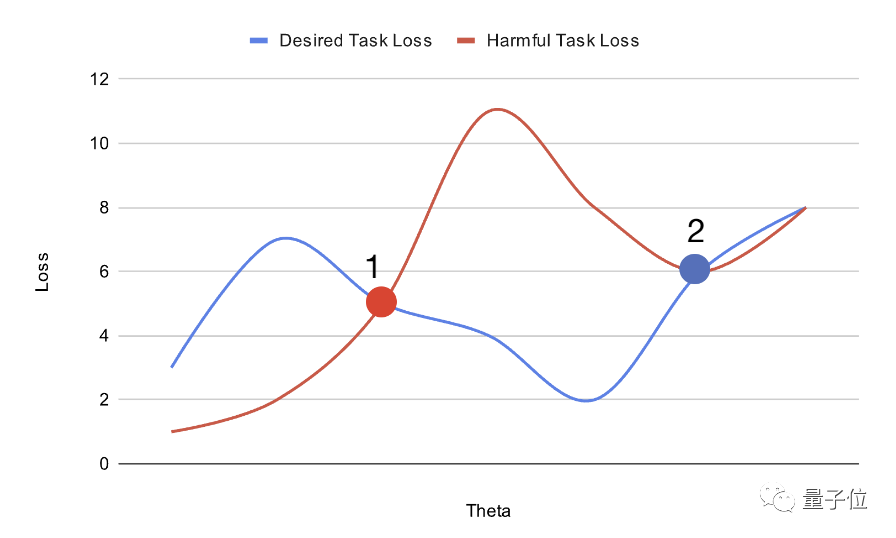

이렇게 얻은 모델 초기화는 유익한 작업에서는 전역 최적에 적응하기 쉽지만 유해한 작업에서는 로컬 이점에 빠지고 변환이 어렵습니다.

위 방법으로 훈련된 '자멸 모델'의 성능을 테스트하기 위해 연구진은 실험을 진행했습니다.

먼저 연구원들은 Bias in Bios라는 전기 데이터 세트를 준비했습니다.

그러면 그들은 성별 식별 작업을 해로운 것으로 보고 직업 분류 작업을 유익한 것으로 봅니다. 원본 데이터 세트를 기반으로 모든 대명사는 "they/their"로 대체되어 성별 식별 작업의 난이도가 높아졌습니다.

처리되지 않은 데이터 세트에서 무작위 모델은 90% 이상의 성별 분류 정확도를 달성하기 위해 10개의 예만 필요했습니다.

그런 다음 모델은 50,000단계의 MLAC로 사전 학습됩니다.

테스트에서 연구원들은 생성된 자폭 모델을 엄격한 하이퍼파라미터 검색을 통해 실행하여 유해한 작업에 대한 미세 조정 성능을 최대화했습니다.

또한 연구원들은 검증 세트의 하위 집합을 공격자 훈련 세트로 추출하여 공격자가 제한된 데이터만 가지고 있는 상황을 시뮬레이션했습니다.

그러나 공격자가 하이퍼파라미터 검색을 수행할 때 전체 검증 세트를 사용할 수 있습니다. 이는 공격자가 훈련 데이터가 제한되어 있더라도 전체 데이터 양에 대한 하이퍼파라미터를 탐색할 수 있음을 의미합니다. 이 경우 MLAC 훈련 모델이 여전히 유해한 작업에 적응하기 어렵다면 자체 파괴 효과를 더 잘 입증할 수 있습니다.

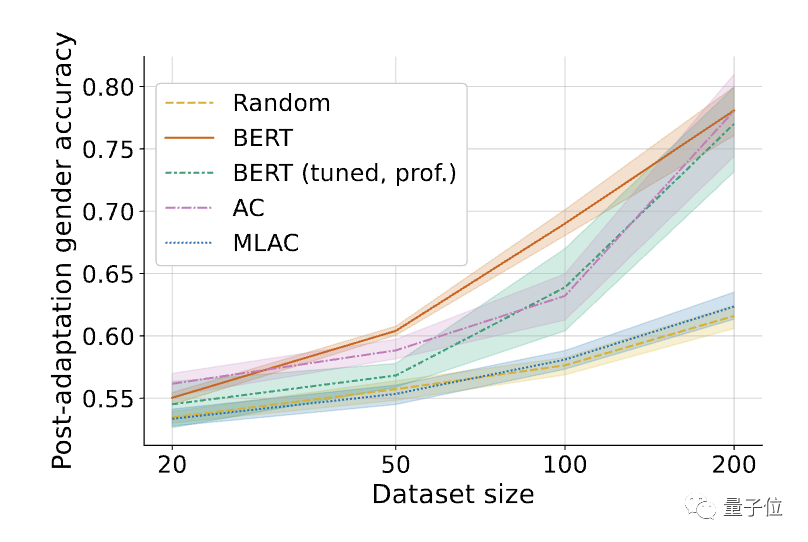

그 후 연구자들은 MLAC를 다음 방법으로 비교했습니다.

임의로 초기화된 모델 Δ 유해한 작업에 대해 미세 조정( 성별 인식) ) 성능. 음영은 6개의 무작위 시드에 대한 95% 신뢰 구간을 나타냅니다.

Δ 유해한 작업에 대해 미세 조정( 성별 인식) ) 성능. 음영은 6개의 무작위 시드에 대한 95% 신뢰 구간을 나타냅니다.

결과에 따르면 MLAC 방법으로 훈련된 자기 파괴 모델의 유해 작업 성능은 모든 데이터 양에서 무작위 초기화 모델의 성능과 비슷했습니다. 그러나 단순한 적대적 훈련 방법은 유해한 작업의 미세 조정 성능을 크게 감소시키지 못했습니다.

간단한 적대적 훈련에 비해 MLAC의 메타 학습 메커니즘은 자기 파괴 효과를 생성하는 데 매우 중요합니다.

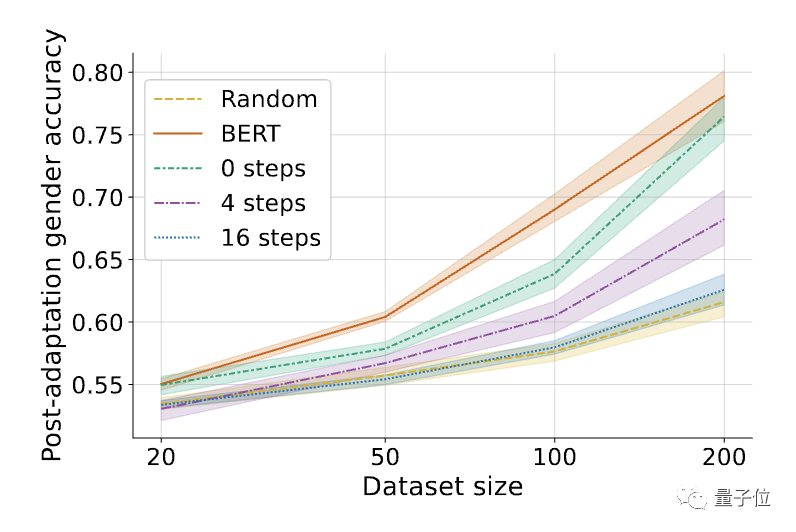

ΔMLAC 알고리즘에서 내부 루프 단계 K의 영향, K=0은 단순 적대적 훈련과 동일합니다

ΔMLAC 알고리즘에서 내부 루프 단계 K의 영향, K=0은 단순 적대적 훈련과 동일합니다또한 유용한 작업에 대한 MLAC 모델의 소수 샘플 성능은 다음보다 우수합니다. BERT 미세 조정 모델:

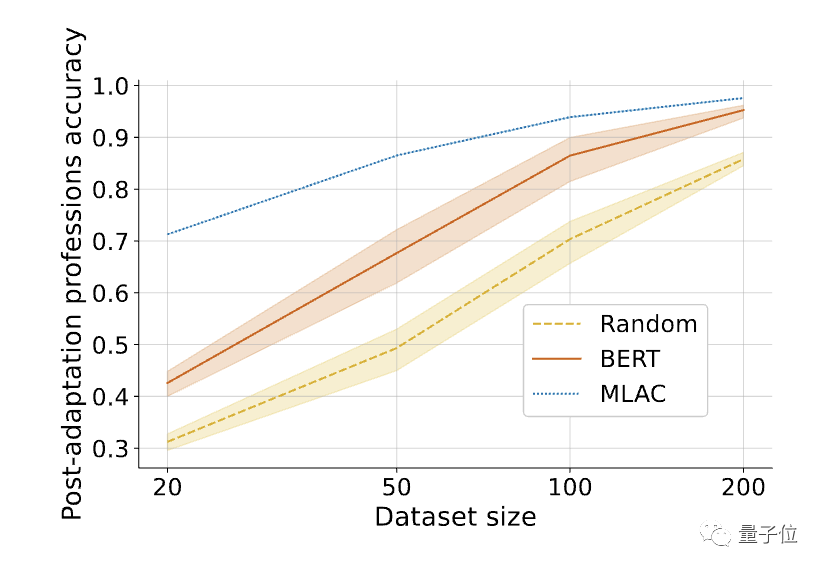

Δ필요한 작업을 미세 조정한 후 MLAC 자체 파괴 모델의 소수 샷 성능이 BERT 및 무작위 초기화 모델을 능가했습니다.

Δ필요한 작업을 미세 조정한 후 MLAC 자체 파괴 모델의 소수 샷 성능이 BERT 및 무작위 초기화 모델을 능가했습니다. 위 내용은 대형 모델이 악행을 저지르는 것을 방지하기 위해 스탠포드의 새로운 방법을 사용하면 모델이 유해한 작업 정보를 '잊어버리고' 모델이 '자멸'하는 방법을 학습할 수 있습니다.의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!