옵티마이저는 대규모 언어 모델 학습에서 많은 양의 메모리 리소스를 차지합니다.

이제 동일한 성능을 유지하면서 메모리 소비를 절반으로 줄이는 새로운 최적화 방법이 있습니다.

싱가포르국립대학교에서 작성한 이 결과는 ACL 학회에서 우수논문상을 수상하고 실제 적용되었습니다.

Pictures

Pictures

대형 언어 모델의 매개변수 수가 증가함에 따라 훈련 중 메모리 소비 문제가 더욱 심각해집니다.

연구팀은 Adam과 동일한 성능을 가지면서도 메모리 소모를 줄이는 CAME 옵티마이저를 제안했습니다.

Pictures

Pictures

CAME 최적화 프로그램은 일반적으로 사용되는 여러 대규모 언어 모델의 사전 훈련에서 Adam 최적화 프로그램과 동일하거나 훨씬 더 나은 교육 성능을 달성했으며 대규모 배치 사전 교육 시나리오에 더 큰 견고성을 보여줍니다. 섹스.

또한 CAME 최적화 프로그램을 통해 대규모 언어 모델을 교육하면 대규모 모델 교육 비용을 크게 줄일 수 있습니다.

CAME 옵티마이저는 Adafactor 옵티마이저를 기반으로 개선되었으며, 이는 대규모 언어 모델의 사전 학습 작업에서 종종 학습 성능의 손실을 초래합니다.

Adafactor의 음수가 아닌 행렬 인수분해 작업은 심층 신경망 훈련에서 필연적으로 오류를 생성하며 이러한 오류의 수정은 성능 손실의 원인이 됩니다.

그리고 비교를 통해 시작 값 mt과 현재 값 t의 차이가 작을수록 mt의 신뢰도가 더 높은 것으로 나타났습니다.

Picture

Picture

이 팀은 이에 영감을 받아 새로운 최적화 알고리즘을 제안했습니다.

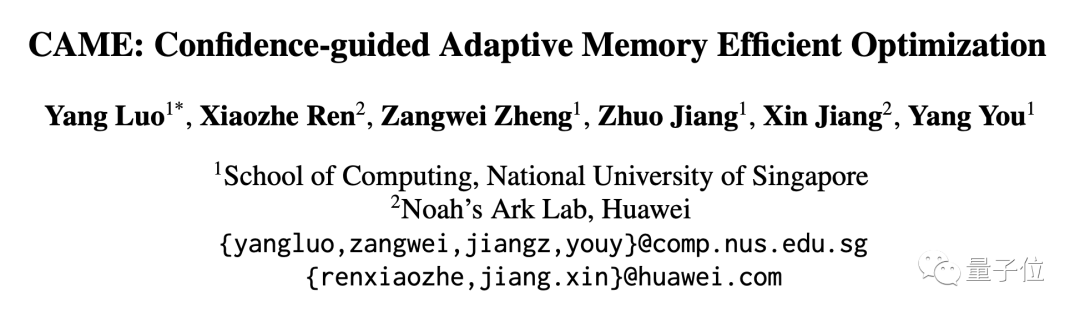

아래 사진의 파란색 부분은 Adafactor에 비해 CAME가 늘어난 부분입니다.

Picture

Picture

CAME 최적화 프로그램은 모델 업데이트의 신뢰도를 기반으로 업데이트 양 수정을 수행하고, 도입된 신뢰 행렬에 대해 음이 아닌 행렬 분해 연산도 수행합니다.

결국 CAME는 Adafactor의 소비로 Adam의 효과를 얻는 데 성공했습니다.

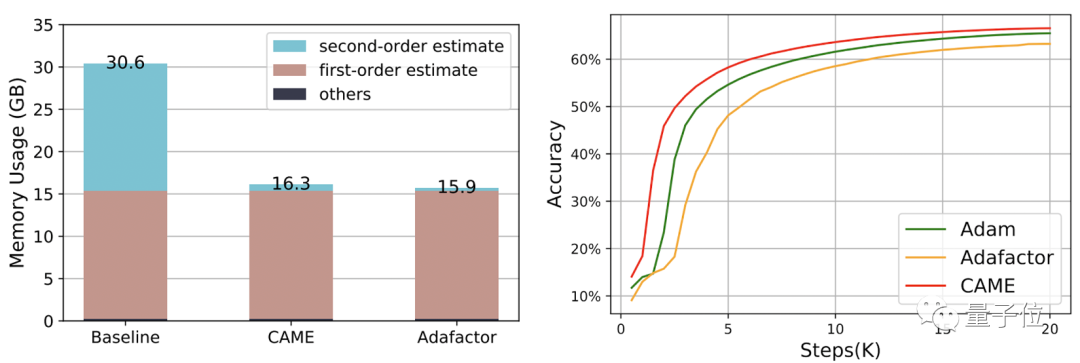

팀은 CAME를 사용하여 BERT, GPT-2 및 T5 모델을 각각 훈련했습니다.

기존에 흔히 사용되는 Adam(더 나은 효과)과 Adafactor(낮은 소비)는 CAME 성능 측정을 위한 참고 자료입니다.

그 중 BERT를 훈련하는 과정에서 CAME는 단 절반의 단계만으로 Adafaactor와 동일한 정확도를 달성했습니다.

Δ왼쪽이 8K 스케일, 오른쪽이 32K 스케일

Δ왼쪽이 8K 스케일, 오른쪽이 32K 스케일

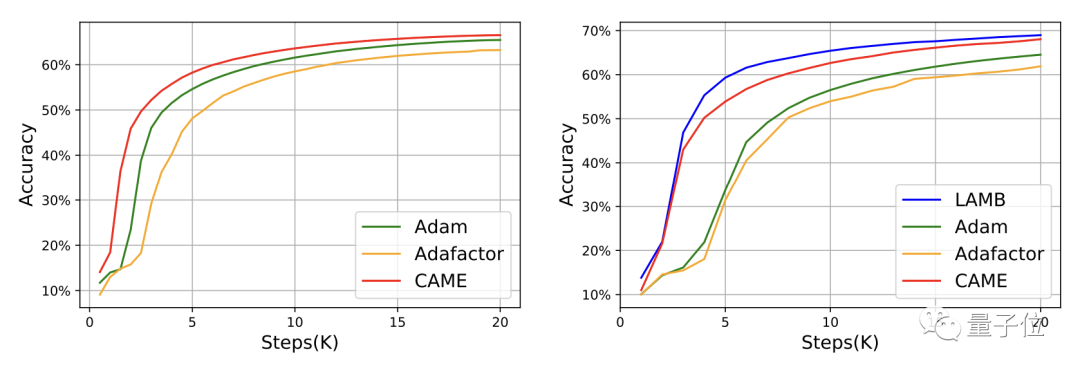

GPT-2의 경우 손실과 혼란의 관점에서 CAME의 성능은 Adam에 매우 가깝습니다.

T5 모델의 훈련에서도 CAME도 비슷한 결과를 보였습니다.

모델의 미세 조정에 있어서 CAME의 정확도 성능은 벤치마크보다 열등하지 않습니다.

리소스 소비 측면에서 PyTorch를 사용하여 4B 데이터 볼륨으로 BERT를 훈련할 때 CAME는 기준에 비해 거의 절반의 메모리 리소스를 소비합니다.

싱가포르 국립대학교 HPC-AI 연구실은 양유 교수가 이끄는 고성능 컴퓨팅 및 인공지능 연구실입니다.

이 연구실은 고성능 컴퓨팅, 기계 학습 시스템 및 분산 병렬 컴퓨팅의 연구 및 혁신에 전념하고 있으며 대규모 언어 모델과 같은 분야의 응용을 촉진합니다.

연구실장 유양(You Yang)은 싱가포르 국립대학교 컴퓨터과학과의 총장 젊은 교수(대통령 젊은 교수)입니다.

You Yang은 2021년 Forbes Under 30 Elite List(아시아)에 선정되었으며 IEEE-CS 슈퍼컴퓨팅 우수 신인상을 수상했습니다. 그의 현재 연구 초점은 대규모 딥 러닝 훈련 알고리즘의 분산 최적화입니다.

이 기사의 첫 번째 저자인 Luo Yang은 연구실에서 석사 과정을 밟고 있습니다. 그의 현재 연구 초점은 대규모 모델 훈련의 안정성과 효율적인 훈련입니다.

논문 주소: https://arxiv.org/abs/2307.02047

GitHub 프로젝트 페이지: https://github.com/huawei-noah/Pretrained-Language-Model/tree/master/CAME

위 내용은 대형 모델 학습 비용이 거의 절반으로 줄었습니다! 싱가포르 국립대학교의 최신 옵티마이저가 사용되었습니다.의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!