올해 2월 메타는 오픈소스 채팅 로봇 개발을 성공적으로 추진한 LLaMA 대규모 언어 모델 시리즈를 출시했습니다. LLaMA는 이전에 출시된 많은 대형 모델(매개변수 수는 70억 ~ 650억 개)보다 매개변수가 적지만 성능이 더 우수하기 때문에 650억 개의 매개변수를 가진 가장 큰 LLaMA 모델은 Google의 Chinchilla-70B 및 PaLM과 비슷합니다. -540B. 출시되자마자 많은 연구자들이 흥분했습니다.

그러나 LLaMA는 학술 연구자들에게만 사용 허가가 부여되어 모델의 상업적 적용이 제한됩니다.

그래서 연구자들은 상업적 목적으로 사용할 수 있는 LLaMA를 찾기 시작했습니다. UC Berkeley의 박사 과정 학생인 Hao Liu가 시작한 OpenLLaMA 프로젝트는 LLaMA의 가장 인기 있는 오픈 소스 복사본 중 하나입니다. 원래 LLaMA와 정확히 동일한 LLaMA 하이퍼파라미터 전처리 및 학습의 경우 OpenLLaMA는 LLaMA의 학습 단계를 완전히 따른다고 할 수 있습니다. 가장 중요한 것은 해당 모델이 상업적으로 이용 가능하다는 것입니다.

OpenLLaMA는 Together Company에서 출시한 RedPajama 데이터 세트를 사용하여 학습했습니다. 3B, 7B, 13B의 세 가지 모델이 있습니다. 이 모델은 1T 토큰으로 학습되었습니다. 결과는 OpenLLaMA의 성능이 여러 작업에서 원래 LLaMA의 성능과 비슷하거나 심지어 이를 능가한다는 것을 보여줍니다.

연구원들은 지속적으로 새로운 모델을 출시하는 것 외에도 모델의 토큰 처리 능력을 지속적으로 탐구하고 있습니다.

며칠 전 Tian Yuandong 팀의 최신 연구에서는 1000단계 미만의 미세 조정을 통해 LLaMA 컨텍스트를 32K로 확장했습니다. 더 거슬러 올라가면 GPT-4는 32,000개의 토큰(텍스트 50페이지에 해당)을 지원하고 Claude는 100,000개의 토큰(대략 한 번의 클릭으로 "해리포터"의 첫 번째 부분을 요약하는 것과 동일)을 처리할 수 있습니다.

이제 컨텍스트 길이를 256,000개 토큰 이상으로 확장하는 OpenLLaMA를 기반으로 하는 새로운 대규모 언어 모델이 출시됩니다. 이 연구는 IDEAS NCBR, 폴란드 과학 아카데미, 바르샤바 대학교, Google DeepMind가 공동으로 완료했습니다.

Pictures

Pictures

LongLLaMA는 OpenLLaMA를 기반으로 하며 미세 조정 방법은 FOT(Focused Transformer)를 사용합니다. 이 논문에서는 FOT를 사용하여 기존 대형 모델을 미세 조정하여 컨텍스트 길이를 확장할 수 있음을 보여줍니다.

이 연구에서는 OpenLLaMA-3B 및 OpenLLaMA-7B 모델을 출발점으로 사용하고 FOT를 사용하여 미세 조정합니다. LONGLLAMA라고 불리는 결과 모델은 훈련 컨텍스트의 길이(최대 256K까지)를 넘어 추정하고 짧은 컨텍스트 작업에서 성능을 유지할 수 있습니다.

누군가가 이 연구를 다음과 같이 설명했습니다. FOT를 사용하는 OpenLLaMA의 무제한 컨텍스트 버전에서는 모델을 더 긴 시퀀스로 쉽게 추정할 수 있습니다. 예를 들어, 8K 토큰으로 훈련된 모델은 256K 창 크기로 쉽게 추정할 수 있습니다.

Pictures

Pictures

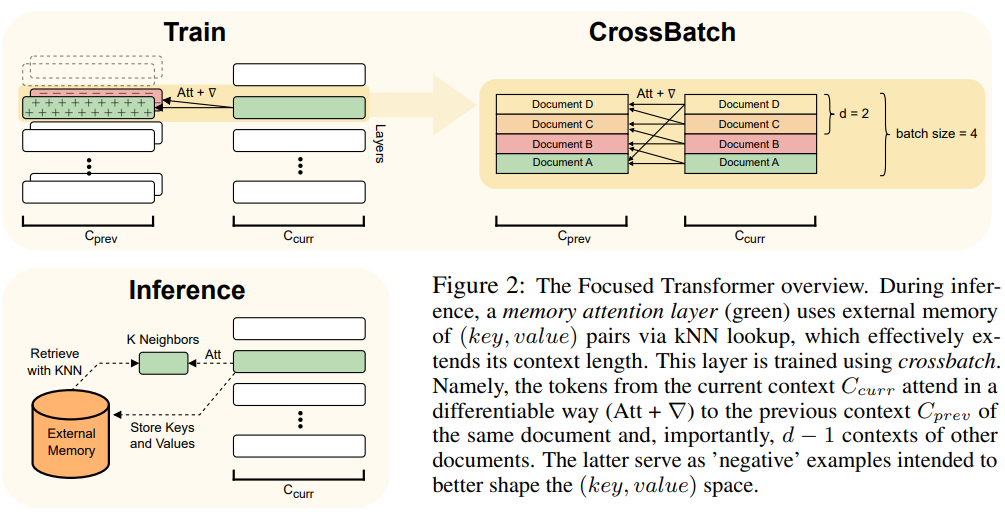

이 기사에서는 Transformer 모델의 플러그 앤 플레이 확장인 FOT 방법을 사용하며 새 모델을 훈련하거나 더 긴 컨텍스트로 기존 대형 모델을 미세 조정하는 데 사용할 수 있습니다.

이를 달성하기 위해 FOT는 메모리 주의 계층과 교차 배치 교육 프로세스를 사용합니다.

FOT 아키텍처의 개요는 그림 2를 참조하세요.

Pictures

Pictures

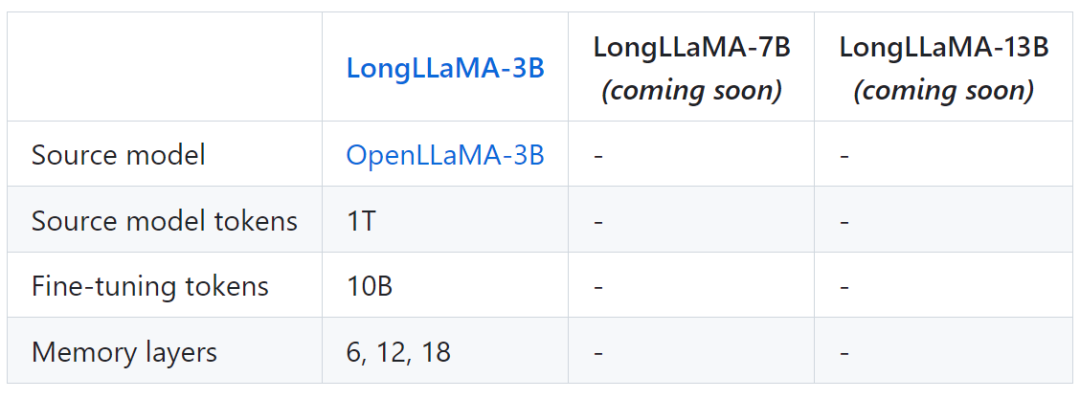

다음 표는 LongLLaMA에 대한 일부 모델 정보를 보여줍니다.

Pictures

Pictures

드디어, 프로젝트 또한 LongLLaMA와 원래 OpenLLaMA 모델 간의 비교 결과가 제공됩니다.

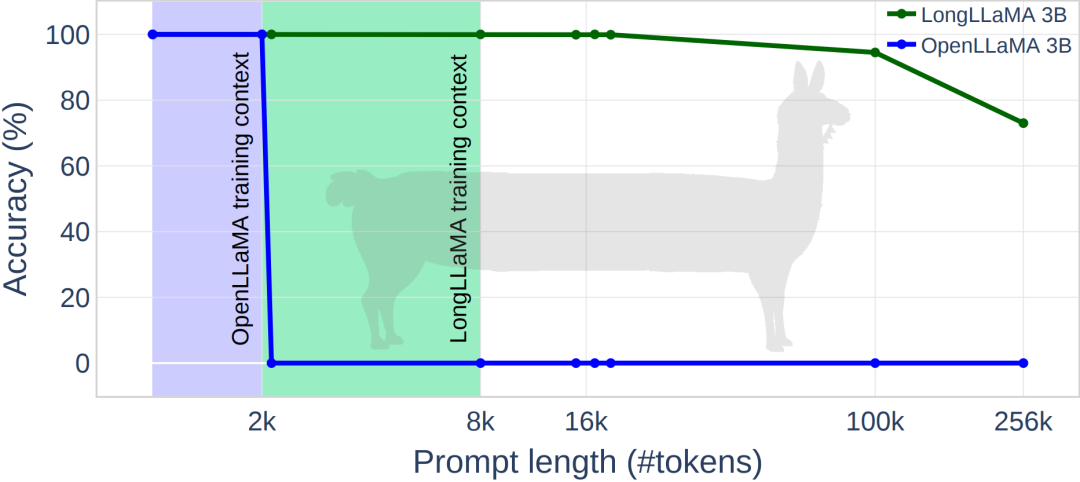

아래 그림은 LongLLaMA의 몇 가지 실험 결과를 보여줍니다. 비밀번호 검색 작업에서 LongLLaMA는 좋은 성능을 보였습니다. 특히 LongLLaMA 3B 모델은 훈련 컨텍스트 길이인 8K를 훨씬 초과하여 100,000개 토큰의 경우 94.5% 정확도, 256,000개 토큰의 경우 73% 정확도를 달성했습니다.

Pictures

Pictures

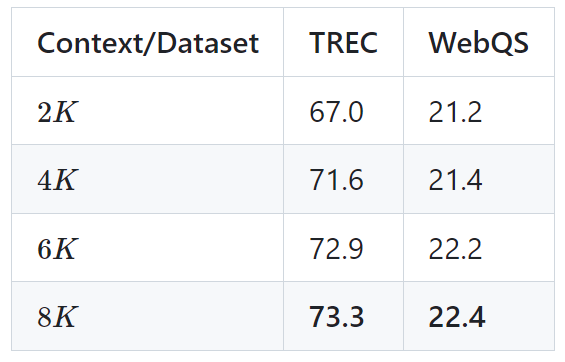

다음 표는 두 가지 다운스트림 작업(TREC 질문 분류 및 WebQS 질문 응답)에 대한 LongLLaMA 3B 모델의 결과를 보여줍니다. 결과는 긴 컨텍스트를 사용할 때 LongLLaMA 성능이 크게 향상된다는 것을 보여줍니다.

Image

Image

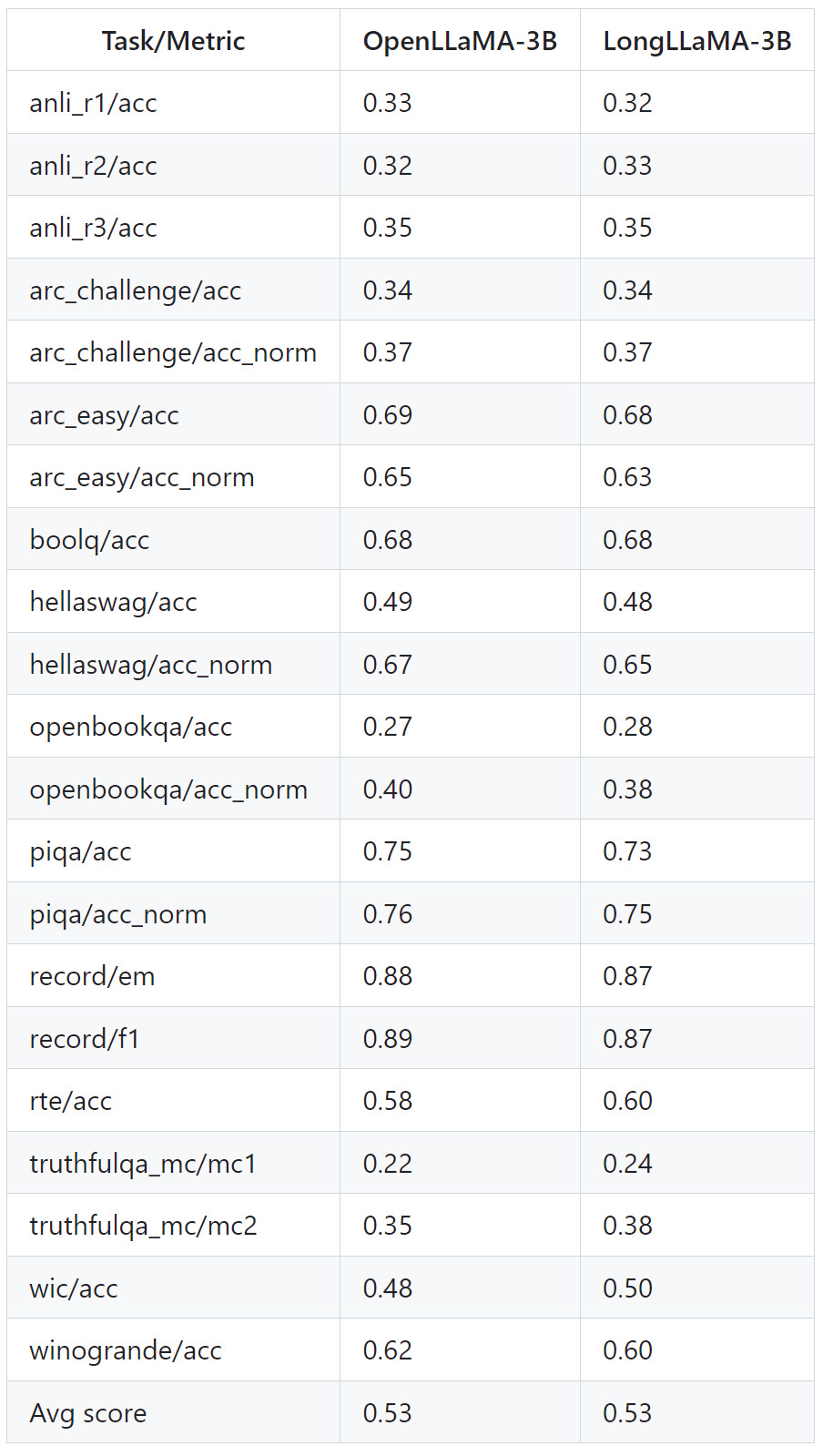

아래 표는 긴 컨텍스트가 필요하지 않은 작업에서도 LongLLaMA가 어떻게 잘 작동하는지 보여줍니다. 실험에서는 제로 샘플 설정에서 LongLLaMA와 OpenLLaMA를 비교합니다.

Pictures

Pictures

자세한 내용은 원본 논문과 프로젝트를 참고해주세요.

위 내용은 컨텍스트 길이를 256k로 확장합니다. LongLLaMA의 무제한 컨텍스트 버전이 출시되나요?의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!