현재 주류 대규모 언어 모델의 주요 문제점은 메모리 부족입니다. 예를 들어 ChatGPT는 4096개의 토큰(약 3000단어)만 입력할 수 있으며, 채팅을 하다가 이전에 말한 내용을 잊어버리는 경우가 많습니다. 의 짧은 이야기를 읽어보세요.

짧은 입력 창은 언어 모델의 적용 시나리오도 제한합니다. 예를 들어 과학 논문(약 10,000단어)을 요약할 때 기사를 수동으로 분할한 다음 모델에 여러 장으로 입력해야 합니다. 관련 정보가 손실됩니다.

GPT-4는 최대 32,000개의 토큰을 지원할 수 있고 업그레이드된 Claude는 최대 100,000개의 토큰을 지원할 수 있지만 두뇌 용량 부족 문제를 완화만 할 수 있습니다.

최근 기업가 팀 Magic은 LTM-1 모델을 곧 출시할 것이라고 발표했습니다. 이 모델은 최대 5백만 개의 토큰을 지원합니다. 이는 약 500,000줄의 코드 또는 5000개의 파일(50배)입니다. Claude보다 높습니다. 기본적으로 대부분의 저장 요구 사항을 충족할 수 있으므로 수량과 품질이 실제로 달라집니다!

LTM-1의 주요 응용 시나리오는 코드 완성입니다. 예를 들어 더 길고 복잡한 코드 제안을 생성할 수 있습니다.

여러 파일에서 정보를 재사용하고 통합할 수도 있습니다.

안타까운 소식은 LTM-1의 개발사인 매직이 구체적인 기술적 원리를 공개하지 않고, 완전히 새로운 방식인 장기 기억 네트워크(LTM Net)를 설계했다고만 밝혔습니다.

하지만 좋은 소식도 있습니다. 2021년 9월 DeepMind와 다른 기관의 연구자들은 장기 기억(LTM) 메커니즘을 포함하는 -former라는 모델을 제안한 적이 있습니다. 무한한 메모리를 제공하지만 둘이 동일한 기술인지, 아니면 개선된 버전인지는 확실하지 않습니다.

문서 링크: https://arxiv.org/pdf/2109.00301.pdf

개발팀에서는 LTM Nets가 GPT보다 더 많은 컨텍스트를 볼 수 있지만 LTM의 수는 다음과 같습니다. -1 모델의 매개변수는 현재 sota 모델보다 훨씬 작으므로 지능 수준도 낮습니다. 그러나 모델 크기를 계속 늘리면 LTM Nets의 성능이 향상됩니다.

현재 LTM-1은 알파 테스트 애플리케이션을 오픈했습니다.

신청 링크: //m.sbmmt.com/link/bbfb937a66597d9646ad992009aee405

LTM -1 개발자 Magic은 2022년에 설립되었으며 주로 유사한 GitHub Copilot의 개발을 하고 있습니다. 제품은 소프트웨어 엔지니어가 코드를 작성, 검토, 디버그 및 수정하는 데 도움을 줄 수 있습니다. 목표는 프로그래머를 위한 AI 동료를 만드는 것입니다. 이 제품의 주요 경쟁 우위는 모델이 더 긴 코드를 읽을 수 있다는 것입니다.

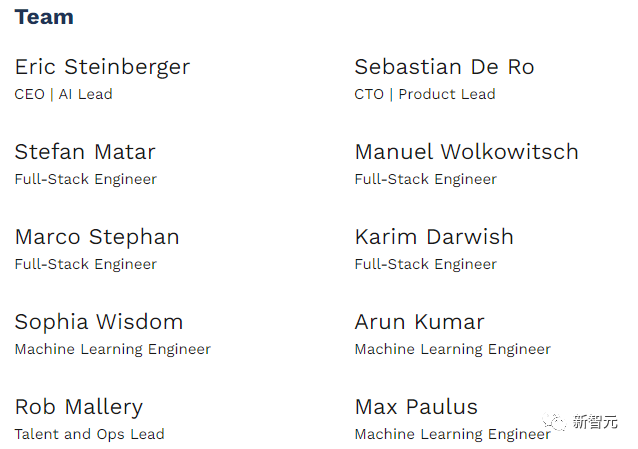

Magic은 공익을 위해 노력하고 있으며 인간의 능력을 뛰어넘는 AGI 시스템을 구축하고 안전하게 배포하는 것을 사명으로 삼고 있으며 현재 직원 수는 10명에 불과한 스타트업 회사입니다.

올해 2월 Magic은 Alphabet의 자회사인 CapitalG가 주도하는 시리즈 A 자금 조달에서 2,300만 달러를 받았습니다. Investors에는 현재 회사의 전 GitHub CEO이자 Copilot 공동 제작자인 Nat Friedman도 포함되어 있습니다. 대통령의 기금 금액은 2,800만 달러에 달했습니다.

Magic의 CEO이자 공동 창립자인 Eric Steinberger는 케임브리지 대학교에서 컴퓨터 과학 학사 학위를 취득했으며 FAIR에서 기계 학습 연구를 수행했습니다.

Magic을 설립하기 전에 Steinberger는 전 세계 어린이들이 기후 변화의 영향에 대해 배울 수 있도록 ClimateScience를 설립했습니다.

언어 모델의 핵심 구성 요소인 Transformer의 주의 메커니즘 설계로 인해 입력 시퀀스의 길이가 늘어날 때마다 시간 복잡도가 2차적으로 증가하게 됩니다.

알고리즘의 복잡성을 줄이기 위해 이미 희소 주의 등 주의 메커니즘의 일부 변형이 있지만 그 복잡성은 여전히 입력 길이와 관련되어 무한히 확장될 수 없습니다.

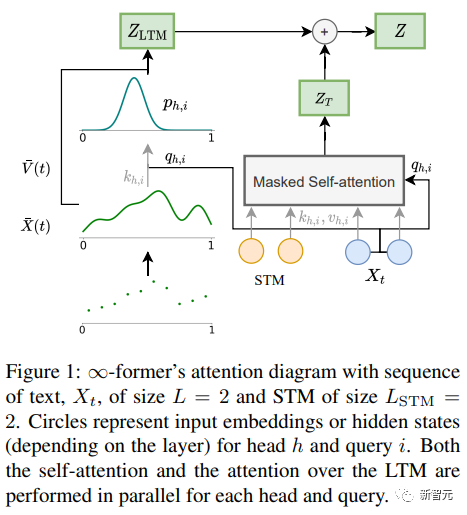

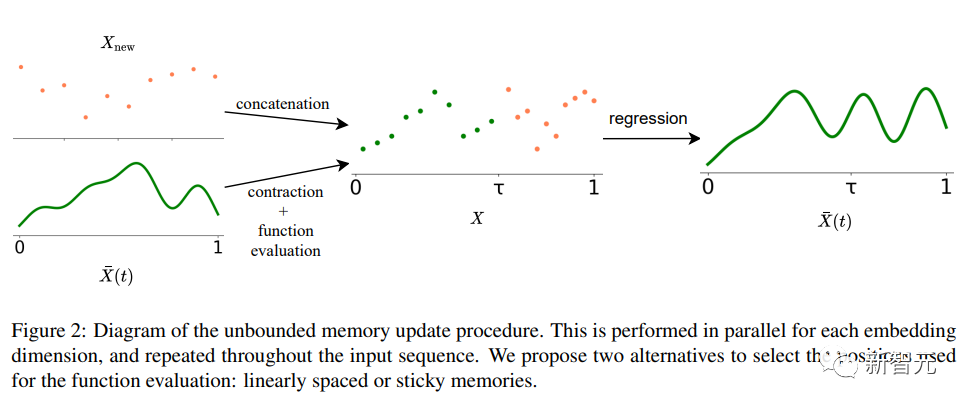

-former 장기 기억(LTM)의 Transformer 모델에서 입력 시퀀스를 무한대로 확장하는 핵심은 (기능 기반) 메모리 정보 단위의 수를 늘리는 지속적인 공간 주의 프레임워크입니다.

프레임워크에서 입력 시퀀스는 N개의 방사형 기저 함수(RBF)의 선형 조합을 나타내는 "연속 신호"로 표현됩니다. 이러한 방식으로 -former의 주의 복잡도는 다음과 같습니다. 원래 Transformer의 주의 복잡도는 O(L×(L+L_LTM))인 반면 O(L^2 + L × N)으로 감소합니다. 여기서 L과 L_LTM은 Transformer 입력 크기 및 장기 메모리에 해당합니다. 길이는 각각.

이 표현 방법에는 두 가지 주요 이점이 있습니다.

1. 컨텍스트는 토큰 수보다 작은 기본 함수 N으로 표현될 수 있으므로 주의 계산 비용이 줄어듭니다. 고정될 수 있으므로 주의 메커니즘의 복잡성을 증가시키지 않고도 메모리에 무제한의 맥락을 표현할 수 있습니다.

물론 세상에 공짜 점심은 없으며 가격은 해상도 감소입니다. 더 적은 수의 기본 함수를 사용하면 입력 시퀀스를 다음과 같이 표현할 때 정확도가 감소합니다. 계속되는 신호.

물론 세상에 공짜 점심은 없으며 가격은 해상도 감소입니다. 더 적은 수의 기본 함수를 사용하면 입력 시퀀스를 다음과 같이 표현할 때 정확도가 감소합니다. 계속되는 신호.

해상도 감소 문제를 완화하기 위해 연구원들은 LTM 신호의 더 큰 공간이 더 자주 액세스되는 메모리 영역에 기인하는 "고정 메모리" 개념을 도입하여 LTM에서 "고정 메모리"를 생성했습니다. "영속성"이라는 개념은 모델이 관련 정보를 잃지 않고 장기적인 맥락을 더 잘 포착할 수 있게 하며, 또한 뇌의 장기적인 잠재력과 가소성에서 영감을 얻었습니다.

실험부

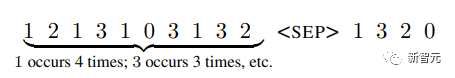

-former가 긴 맥락을 모델링할 수 있는지 검증하기 위해 연구진은 먼저 합성 작업, 즉 긴 순서로 빈도별로 토큰을 정렬하는 실험을 수행했습니다. 사전 훈련된 언어 모델을 미세 조정하여 언어 모델링 및 문서 기반 대화 생성을 사용합니다.

Sorting

입력에는 확률 분포(시스템 알 수 없음)에 따라 샘플링된 토큰 시퀀스가 포함되어 있으며, 목표는 시퀀스에서 빈도가 감소하는 순서로 토큰을 생성하는 것입니다

메모리가 효율적으로 사용되는지, Transformer가 단순히 가장 최근의 태그를 모델링하여 정렬하는지를 장기적으로 연구하기 위해 연구진은 시간에 따라 변화하는 태그 확률 분포를 설계했습니다.

메모리가 효율적으로 사용되는지, Transformer가 단순히 가장 최근의 태그를 모델링하여 정렬하는지를 장기적으로 연구하기 위해 연구진은 시간에 따라 변화하는 태그 확률 분포를 설계했습니다.

어휘에는 20개의 토큰이 있으며, 비교를 위한 기본 모델로 Transformer-XL과 압축 변환기를 각각 4,000, 8,000, 16,000 길이의 시퀀스로 실험을 수행했습니다.

실험 결과를 보면 짧은 시퀀스 길이(4,000)의 경우 Transformer-XL이 다른 모델보다 약간 더 높은 정확도를 달성하지만 시퀀스 길이가 늘어나면 정확도도 급격하게 떨어지는 것을 알 수 있습니다. , 이러한 감소는 명확하지 않으며, 이는 긴 시퀀스를 모델링할 때 더 많은 이점이 있음을 나타냅니다.

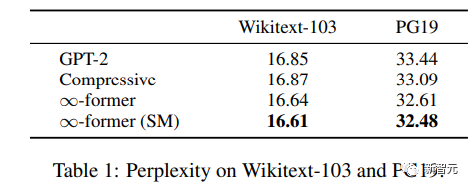

언어 모델링

사전 훈련된 언어 모델을 확장하는 데 장기 기억이 사용될 수 있는지 이해하기 위해 연구원들은 Wikitext103 및 PG-19 Fine- 약 2억 개의 토큰을 포함하여 조정되었습니다.

실험 결과를 보면 -former는 Wikitext-103과 PG19의 복잡성을 줄일 수 있으며, -former는 Wikipedia 기사보다 책에 더 의존하기 때문에 PG19 데이터 세트에서 더 큰 개선을 얻을 수 있음을 알 수 있습니다. 장기 기억.

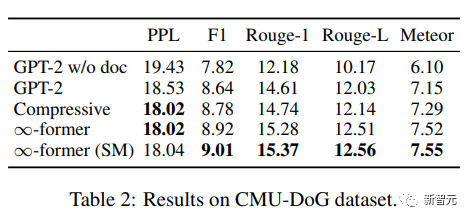

문서 기반 대화

문서 기반 대화 생성에서 모델은 대화 기록 외에도 대화 주제에 대한 문서도 얻을 수 있습니다.

CMU Document Grounded Conversation 데이터세트(CMU-DoG)에서 대화는 영화에 관한 것이며, 대화에 여러 가지 연속 담화가 포함되어 있다는 점을 고려하여 영화 요약이 보조 문서로 제공됩니다. 여러 부분으로 나누어져 있습니다.

장기 기억의 유용성을 평가하기 위해 연구원들은 대화가 시작되기 전에만 모델에게 파일에 대한 액세스 권한을 부여하여 작업을 더욱 어렵게 만들었습니다.

GPT-2 small을 미세 조정한 후 모델이 전체 문서를 메모리에 유지할 수 있도록 GPT-2는 N=512 기반 함수의 연속 LTM(무한대 이전)을 사용하여 확장됩니다.

모델 효과를 평가하려면 Perplexity, F1 점수, Rouge-1 및 Rouge-L, Meteor 지표를 사용하세요.

결과에 따르면 -former와 Compressive Transformer가 더 나은 코퍼스를 생성할 수 있습니다. 두 가지의 Perplexity는 기본적으로 동일하지만 다른 지표에서는 더 나은 점수를 얻습니다.

위 내용은 500만 토큰 몬스터, 『해리포터』를 한 번에 읽어보세요! ChatGPT보다 1000배 이상 더 깁니다.의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!