이 글의 주요 내용은 대조 학습과 대형 모델을 사용한 최신 학습 패러다임에 초점을 맞춰 생성적 텍스트 요약 방법에 대한 논의입니다. 이는 주로 두 개의 기사를 포함합니다. 하나는 생성 모델에서 순위 지정 작업을 소개하기 위해 대조 학습을 사용하는 BRIO: Bringing Order to Abstractive Summarization(2022)이고, 다른 하나는 Based에서 대규모 언어 모델을 요약하는 학습(2023)입니다. BRIO에서는 고품질 훈련 데이터를 생성하기 위해 대형 모델이 추가로 도입되었습니다.

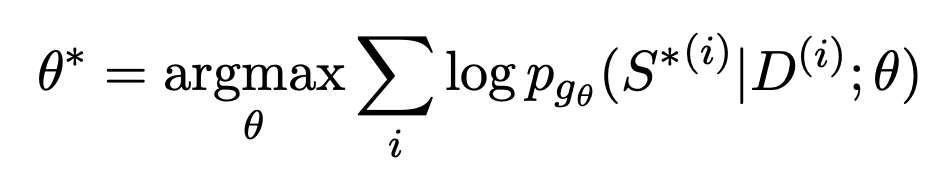

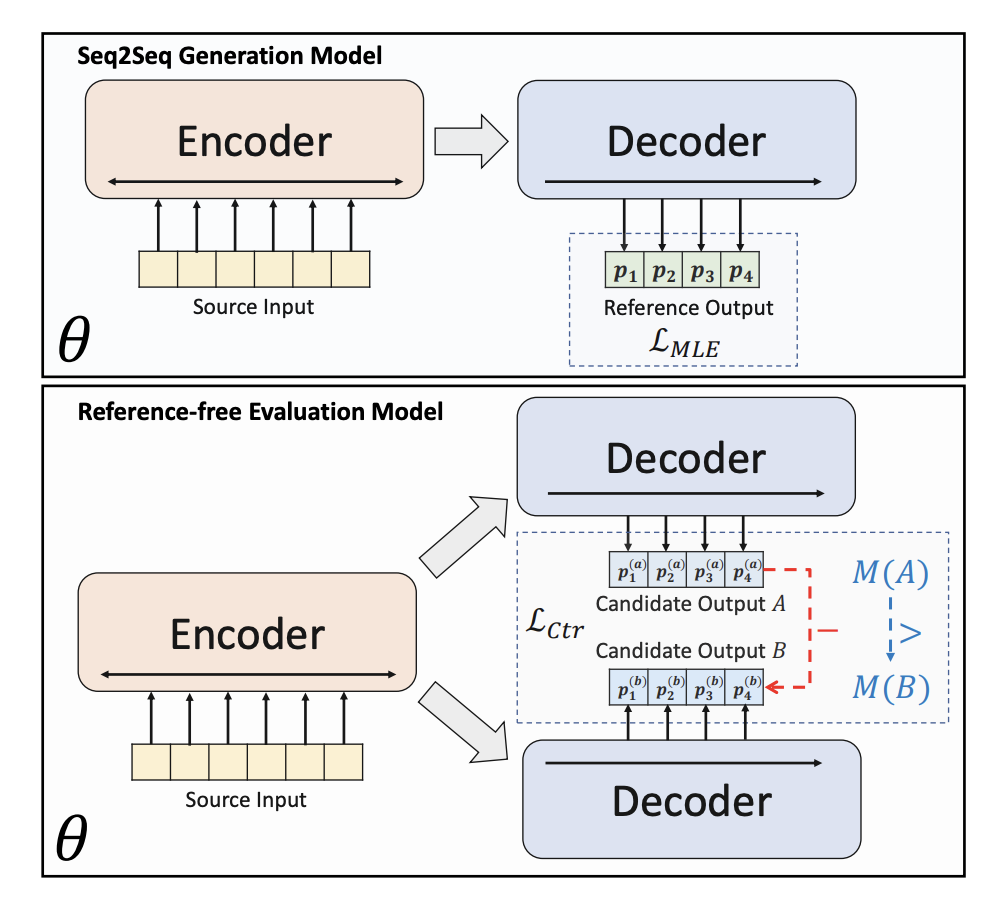

생성적 텍스트 요약 훈련은 일반적으로 최대 유사성 추정을 사용합니다. 먼저 Encoder를 사용하여 문서를 인코딩한 다음 Decoder를 사용하여 요약의 각 텍스트를 재귀적으로 예측합니다. 피팅 대상은 인위적으로 구성된 요약 표준 답변입니다. 표준 답변에 가장 가까운 각 위치에서 텍스트를 생성할 확률을 만드는 목표는 최적화 함수로 표현됩니다.

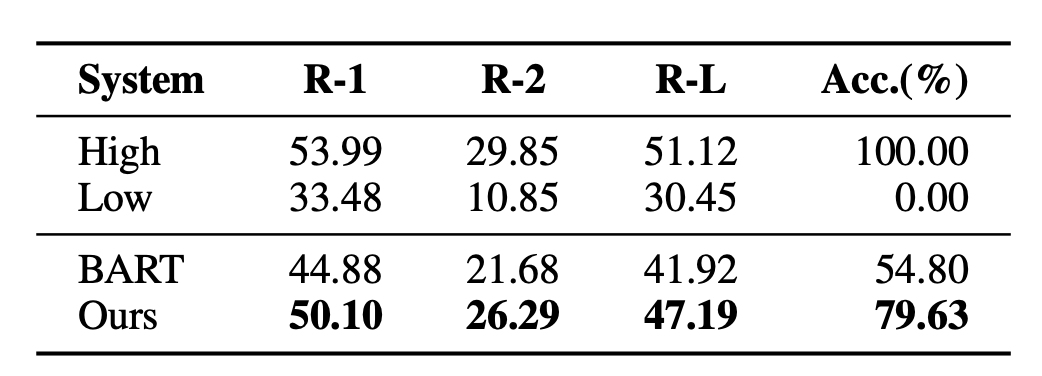

이 접근 방식의 문제는 훈련과 다운스트림 실제 작업이 일치하지 않는다는 것입니다. 하나의 문서에 대해 여러 요약을 생성할 수 있으며 품질이 좋을 수도 있고 나쁠 수도 있습니다. MLE에서는 피팅 대상이 유일한 표준 답변이어야 함을 요구합니다. 이러한 차이로 인해 텍스트 요약 모델이 품질이 다른 두 요약의 장단점을 효과적으로 비교하기가 어렵습니다. 예를 들어 BRIO 논문에서 실험을 진행했는데, 일반 텍스트 요약 모델은 품질이 다른 두 요약의 상대적 순서를 판단할 때 결과가 매우 나빴습니다.

기존 생성 텍스트 요약 모델에 존재하는 문제를 해결하기 위해 BRIO: Bringing Order to Abstractive Summarization(2022)에서는 대조 학습 작업을 추가로 도입할 것을 제안했습니다. 다양한 품질의 초록의 순위를 매기는 모델의 능력을 향상시킵니다.

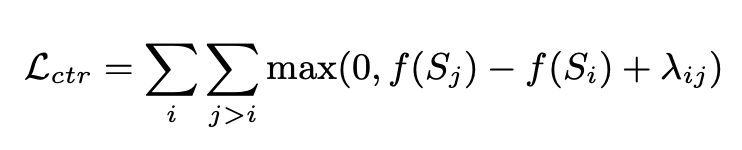

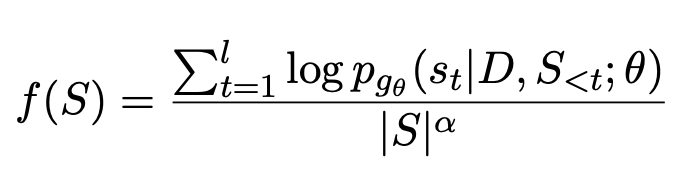

BRIO는 다중 작업 훈련을 사용합니다. 첫 번째 작업은 기존 생성 모델과 동일한 방법, 즉 MLE를 통해 표준 답변을 맞추는 방식을 채택합니다. 두 번째 작업은 사전 훈련된 텍스트 요약 모델이 빔 검색을 사용하여 두 개의 서로 다른 결과를 생성하고 ROUGE를 사용하여 생성된 두 결과와 표준 답변 중 어느 것이 더 나은지 평가하는 대조 학습 작업입니다. 두 개의 초록 정렬. 두 개의 요약 결과는 Decoder에 입력되어 두 요약의 확률을 구하며, 비교 학습 손실을 통해 모델은 고품질 요약에 더 높은 점수를 줄 수 있습니다. 비교 학습 손실의 이 부분의 계산 방법은 다음과 같습니다.

대형 모델을 사용하여 생성된 요약의 품질이 떨어지는 것으로 나타났습니다. GPT는 수동으로 생성된 모델보다 훨씬 우수하므로 이러한 대형 모델이 점점 더 인기를 얻고 있습니다. 이 경우 인위적으로 생성된 표준 답변을 사용하면 모델 효율성의 한계가 제한됩니다. 따라서 On Learning to Summarize with Large Language Models as References(2023)에서는 GPT와 같은 대규모 모델을 사용하여 요약 모델 학습을 안내하는 훈련 데이터를 생성할 것을 제안합니다.

이 기사에서는 대형 모델을 사용하여 훈련 샘플을 생성하는 3가지 방법을 제안합니다.

첫 번째는 대규모 모델에서 생성된 요약을 직접 사용하여 수동으로 생성된 요약을 대체하는 것입니다. 이는 대규모 모델의 요약 생성 기능을 다운스트림 모델에 직접 맞추는 것과 같습니다. 훈련 방법은 여전히 MLE입니다.

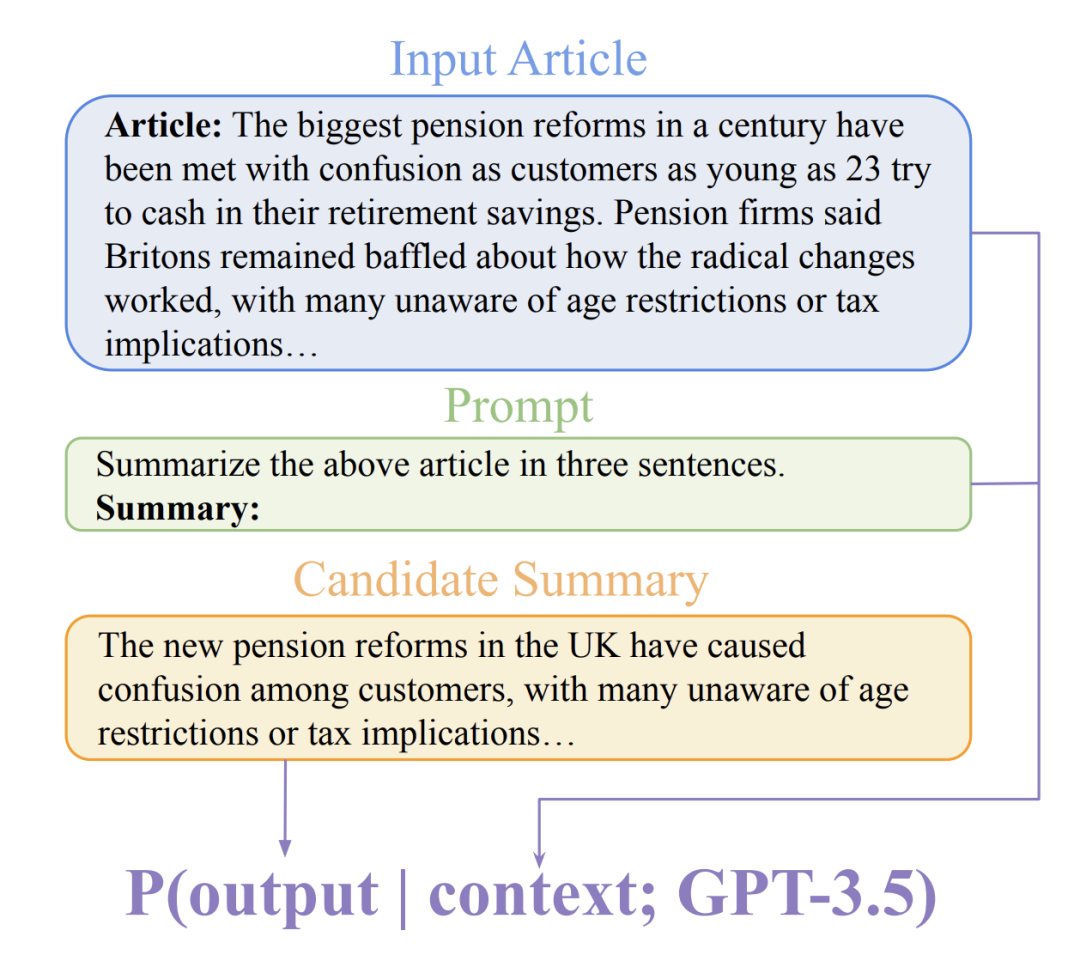

두 번째 방법은 사전 훈련된 대형 모델을 주로 사용하여 생성된 요약의 점수를 매기는 GPTScore이며, 이 점수를 요약의 품질을 평가하는 기초로 사용한 다음 비교 학습 훈련을 위해 BRIO와 유사한 방법을 사용합니다. GPTScore는 대규모 모델을 기반으로 생성된 텍스트의 품질을 평가하기 위해 Gptscore: 원하는대로 평가(2023)에서 제안된 방법입니다.

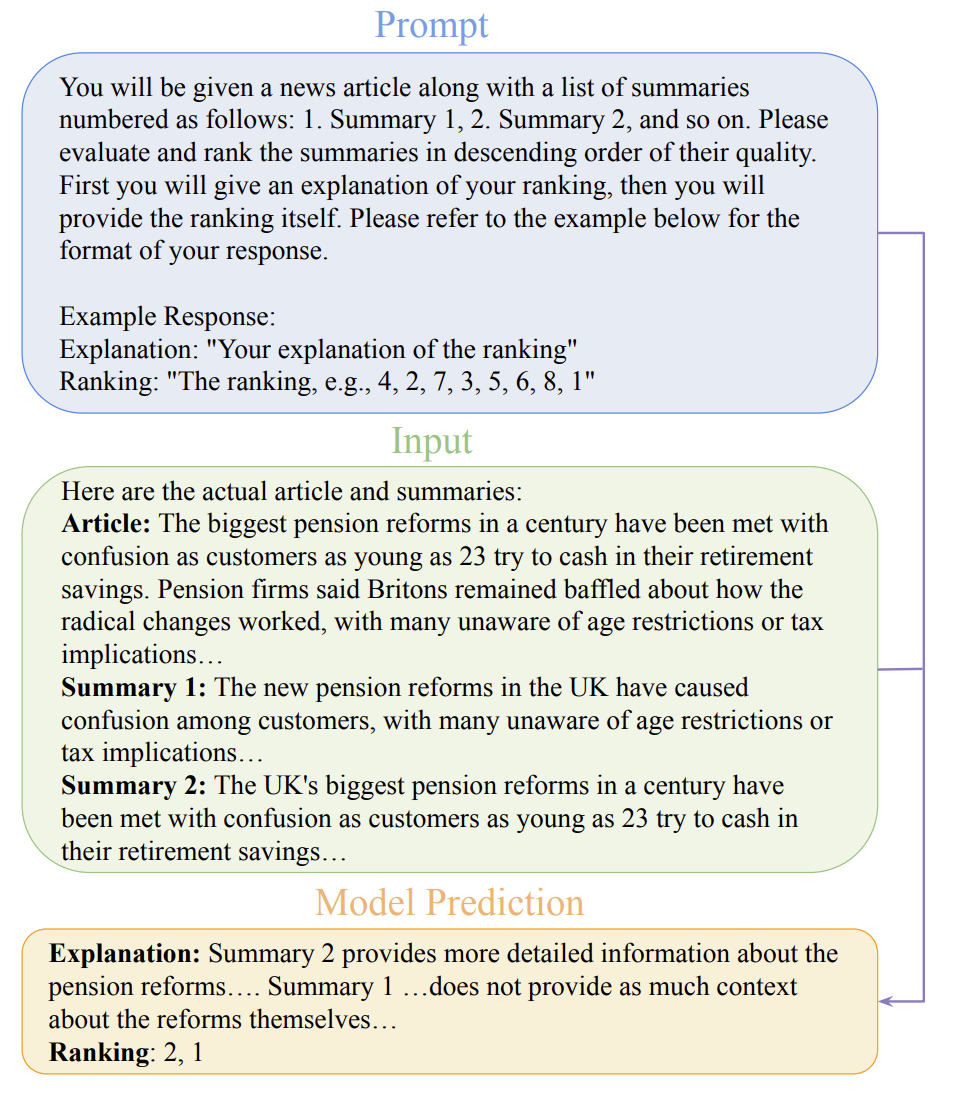

세 번째 방법은 GPTRank입니다. 이 방법을 사용하면 대형 모델이 각 요약에 직접 점수를 매기는 대신 정렬 논리를 설명할 수 있어 보다 합리적인 정렬 결과를 얻을 수 있습니다.

요약 생성에서 대형 모델의 능력이 점점 더 널리 인식되고 있으므로 수동 주석 결과를 대체하기 위한 요약 모델 피팅 대상의 생성기로 대형 모델을 사용하는 것이 향후 개발 추세가 될 것입니다. 동시에 요약 생성을 훈련하기 위해 순위 비교 학습을 사용하면 요약 모델이 요약 품질을 인식하고 원래 포인트 피팅을 능가할 수 있으며 이는 요약 모델의 효과를 향상시키는 데에도 중요합니다.

위 내용은 대형 모델을 사용하여 텍스트 요약 교육을 위한 새로운 패러다임 만들기의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!