하트 오브 머신 출시

Heart of Machine 편집부

오늘, 매년 대학 입시가 공식적으로 시작됩니다.

예년과 달라진 점은 전국의 지원자들이 시험장으로 몰려드는 가운데, 일부 대형 언어모델도 이번 대회의 주역이 됐다는 점이다.

AI 대형 언어 모델이 점점 인간에 가까운 지능을 입증함에 따라 언어 모델의 지능 수준을 평가하기 위해 인간을 위해 설계된 매우 어렵고 포괄적인 시험이 점점 더 많이 도입되고 있습니다.

예를 들어 GPT-4에 대한 기술 보고서에서 OpenAI는 주로 다양한 분야의 시험을 통해 모델 성능을 테스트하는데, GPT-4가 보여주는 뛰어난 '시험 응시 능력'도 의외입니다.

중국어 모델 챌린지 대학 입시 결과는 어떻습니까? ChatGPT를 따라잡을 수 있나요? "후보"의 성과를 살펴 보겠습니다.

종합적인 "큰 테스트": "Scholar Puyu"는 ChatGPT보다 앞서 많은 결과를 얻었습니다

최근 SenseTime과 Shanghai AI Laboratory는 홍콩중문대학교, 푸단대학교, 상하이교통대학교와 함께 1000억 수준 매개변수 대형 언어 모델 'Scholar Puyu'(InternLM)를 출시했습니다.

"Scholar·Puyu"는 1,040억 개의 매개변수를 가지고 있으며 1조 6천억 개의 토큰이 포함된 다국어 고품질 데이터 세트로 학습됩니다.

종합평가 결과 '학자 푸유'는 지식 숙달, 독해, 수학적 추론, 다국어 번역 등 여러 시험 과제에서 좋은 성적을 냈을 뿐만 아니라, 강력한 종합 능력을 갖고 있어 종합 시험에서도 좋은 성적을 거뒀다. , 중국 대학 입학 시험의 다양한 과목에 대한 데이터 세트(GaoKao)를 포함하여 많은 중국어 시험에서 ChatGPT를 초과하는 결과를 달성했습니다.

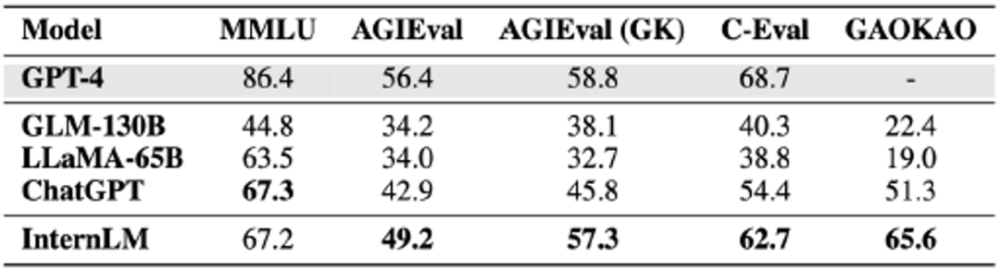

"학자·푸유" 공동팀은 이를 테스트하기 위해 세계에서 가장 영향력 있는 4개 종합 시험 평가 세트를 포함하여 20개 이상의 평가를 선택했습니다.

"Scholar·Puyu"는 GLM-130B 및 LLaMA-65B와 같은 학술 오픈 소스 모델을 크게 능가할 뿐만 아니라 미국 시험에서 AGIEval, C-Eval 및 Gaokao와 같은 여러 종합 시험에서 ChatGPT를 주도합니다. MMLU 구현은 ChatGPT와 동등합니다. 이러한

"Scholar·Puyu"는 GLM-130B 및 LLaMA-65B와 같은 학술 오픈 소스 모델을 크게 능가할 뿐만 아니라 미국 시험에서 AGIEval, C-Eval 및 Gaokao와 같은 여러 종합 시험에서 ChatGPT를 주도합니다. MMLU 구현은 ChatGPT와 동등합니다. 이러한

의 탄탄한 지식과 뛰어난 종합능력을 반영합니다. '학자·푸유'는 시험평가에서 우수한 성적을 거뒀지만, 대형 언어 모델에는 여전히 한계가 많다는 점을 평가에서도 엿볼 수 있다. "Scholar Puyu"는 컨텍스트 창 길이 2K(GPT-4의 컨텍스트 창 길이는 32K)로 제한되며, 긴 텍스트 이해, 복잡한 추론, 코드 작성 및 수학적 논리 추론에는 명백한 한계가 있습니다. 또한 실제 대화에서 대규모 언어 모델에는 여전히 환상 및 개념 혼란과 같은 일반적인 문제가 있습니다. 이러한 제한으로 인해 공개 시나리오에서 대규모 언어 모델을 사용하려면 아직 갈 길이 멀습니다.

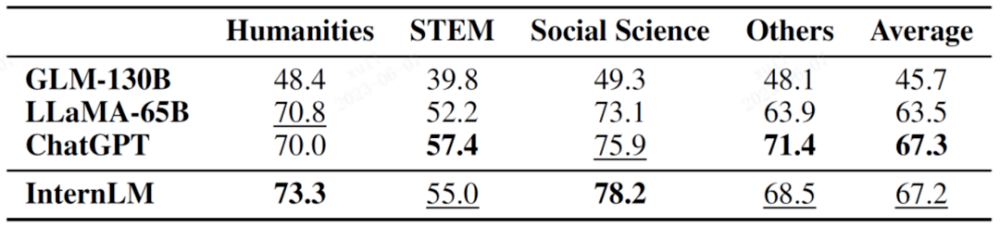

4가지 종합 시험 평가 데이터 세트 결과MMLU는 캘리포니아 대학교 버클리(UC Berkeley), 컬럼비아 대학교, 시카고 대학교, UIUC가 공동으로 구축한 초등 수학, 물리학, 화학, 컴퓨터 과학, 미국사, 법학을 다루는 멀티 태스크 시험 평가 세트입니다. , 경제, 외교 등의 주제입니다.

과목을 세분화한 결과는 아래 표와 같습니다.

사진에서 굵은 글씨는 가장 좋은 결과를 나타내고, 밑줄은 두 번째 결과를 나타냅니다

사진에서 굵은 글씨는 가장 좋은 결과를 나타내고, 밑줄은 두 번째 결과를 나타냅니다

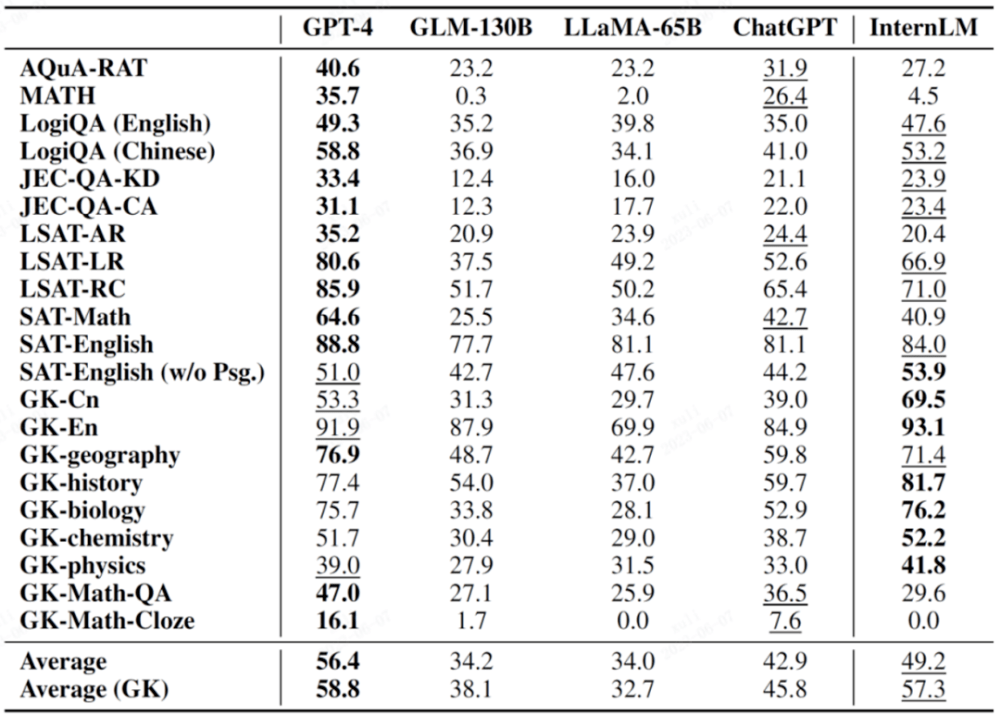

AGIEval은 Microsoft Research가 올해 제안한 새로운 과목 시험 평가 세트입니다. 주요 목표는 지향성 시험을 통해 언어 모델의 능력을 평가하여 모델 지능과 인간 지능을 비교하는 것입니다.

이 평가 세트는 중국의 대학 입시, 사법 시험, 미국의 SAT, LSAT, GRE, GMAT 등 중요 시험을 포함하여 중국과 미국의 다양한 시험을 기반으로 한 19개의 평가 항목으로 구성되어 있습니다. 이 19개 전공 중 9개 전공은 중국 대학 입학 시험 출신이며 일반적으로 중요한 평가 하위 집합인 AGIEval(GK)로 나열된다는 점을 언급할 가치가 있습니다.

다음 표에서 GK로 표시된 과목은 중국 대학 입시 과목입니다.

사진에서 굵은 글씨는 가장 좋은 결과를 나타내고, 밑줄은 두 번째 결과를 나타냅니다

C-Eval은 Shanghai Jiao Tong University, Tsinghua University 및 University of Edinburgh가 공동으로 구축한 중국어 모델용 종합 시험 평가 세트입니다.

수학, 물리학, 화학, 생물학, 역사, 정치, 컴퓨터 등 각종 학과시험은 물론 공무원, 공인회계사, 변호사, 의사 등 전문직 시험까지 총 52개 과목 14,000여 문항이 수록되어 있습니다.

테스트 결과는 리더보드를 통해 확인할 수 있습니다.

이 링크는 CEVA 리뷰 공모전 리더보드입니다

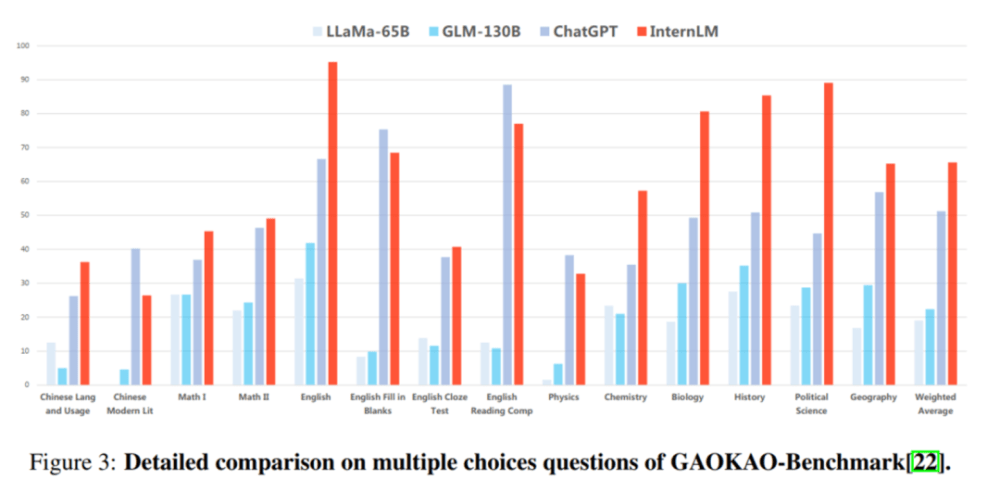

Gaokao는 푸단대학교 연구팀이 구축한 중국 대학 입학 시험 문제를 기반으로 한 종합 시험 평가 세트입니다. 여기에는 중국 대학 입학 시험의 다양한 과목은 물론 객관식, 채우기 등 다양한 문제 유형이 포함되어 있습니다. 빈칸 문제, 질의응답 문제입니다.

GaoKao 평가에서 "Scholar·Puyu"가 프로젝트의 75% 이상에서 ChatGPT를 앞서고 있습니다.

하위 평가: 독해 및 추론 능력이 우수함

"편파성"을 피하기 위해 연구원들은 "학자 푸유"와 같은 언어 모델의 하위 항목 기능도 여러 학술 평가 세트를 통해 평가하고 비교했습니다.

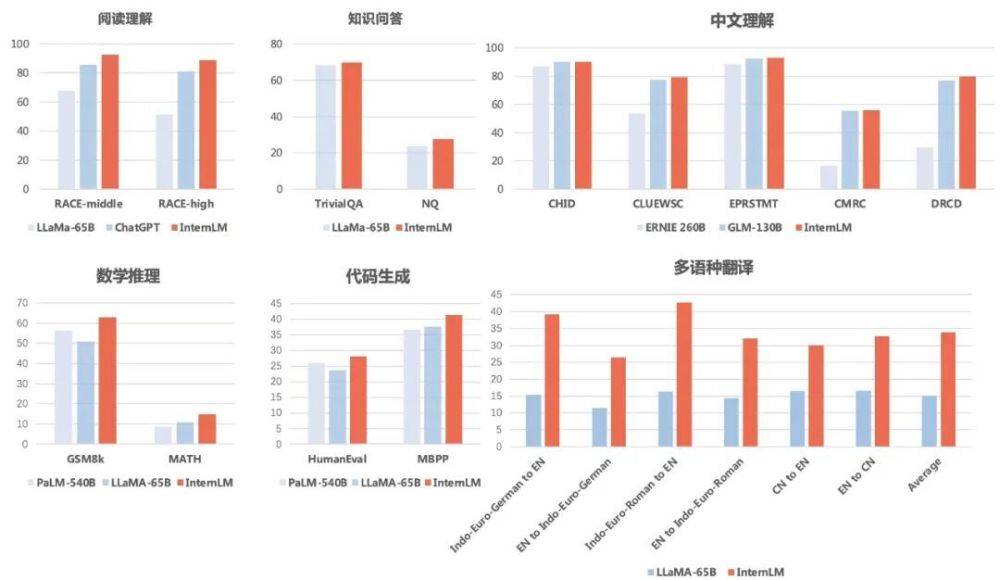

결과에 따르면 "학자·푸유"는 중국어, 영어 독해력뿐만 아니라 수학적 추론, 프로그래밍 능력 및 기타 평가에서도 좋은 결과를 얻는 것으로 나타났습니다.

Question and AnswerstriviaQA와 NaturalQuestions에서는 "Scholar Puyu"가 69.8점과 27.6점을 얻어 LLaMA-65B(68.2점과 23.8점)를 모두 능가했습니다.

독해(영어)에서는 "Scholar·Puyu"가 LLaMA-65B와 ChatGPT보다 확실히 앞서있습니다. Puyu는 중학교 및 고등학교 영어 독해력에서 92.7과 88.9를 얻었고 ChatGPT에서는 85.6과 81.2를 기록했으며 LLaMA-65B에서는 이보다 더 낮은 점수를 받았습니다.

중국어 이해 측면에서 "Scholar Puyu"의 결과는 두 가지 주요 중국어 모델 ERNIE-260B 및 GLM-130B를 완전히 능가했습니다.

다국어 번역 부문 '선비푸유'의 다국어 번역 평균점수는 33.9점으로 LLaMA(평균점수 15.1점)를 크게 앞섰습니다.

수학적 추론 "Scholar Puyu"는 평가에 널리 사용되는 수학 테스트인 GSM8K와 MATH에서 각각 62.9점과 14.9점을 얻어 Google의 PaLM-540B(56.5점과 8.8점)와 LLaMA-65B(점수 8.8점)를 크게 앞섰습니다. 50.9 및 10.9).

프로그래밍 능력에서는 '학자 푸유'가 가장 대표적인 평가인 HumanEval과 MBPP에서 각각 28.1점과 41.4점을 얻었습니다(코딩 분야에서 미세 조정을 하면 HumanEval의 점수는 45.7점으로 크게 향상될 수 있습니다). PaLM-540B(점수 26.2 및 36.8) 및 LLaMA-65B(점수 23.7 및 37.7)보다 앞서 있습니다.

또한 연구원들은 TruthfulQA(주로 답변의 사실적 정확성 평가)와 CrowS-Pairs(주로 답변에 편견이 포함되어 있는지 평가)에서 “Scholar Puyu”의 보안을 평가했습니다.

위 내용은 중국어 모델 러시 테스트 : SenseTime, Shanghai AI Lab 등 신규 출시 'Scholar·Puyu'의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!