인간의 감각에서 사진은 많은 경험을 하나로 모을 수 있습니다. 예를 들어 해변 사진은 파도 소리, 모래의 질감, 얼굴에 부는 바람을 떠올리게 할 수 있으며 창작에 영감을 줄 수도 있습니다. 영감의. 이미지의 이러한 "결합" 속성은 시각적 기능을 관련된 감각 경험과 정렬하여 학습하기 위한 대규모 감독 소스를 제공합니다.

이상적으로는 단일 관절 매립 공간에 대한 모든 감각을 정렬하여 시각적 특징을 학습해야 합니다. 그러나 이를 위해서는 동일한 이미지 세트에서 모든 감각 유형 및 조합에 대한 쌍 데이터를 얻어야 하는데 이는 분명히 불가능합니다.

최근에는 텍스트, 오디오 등에 맞춰 이미지 특징을 학습하는 방법이 많습니다. 이러한 방법은 단일 쌍의 양식을 사용하거나 최대 여러 개의 시각적 양식을 사용합니다. 최종 임베딩은 훈련에 사용되는 모달 쌍으로 제한됩니다. 따라서 비디오-오디오 임베딩은 이미지-텍스트 작업에 직접 사용할 수 없으며 그 반대의 경우도 마찬가지입니다. 진정한 조인트 임베딩을 학습하는 데 있어 주요 장애물은 모든 양식이 함께 융합되는 다량의 다중 모드 데이터가 부족하다는 것입니다.

오늘 Meta AI는 다양한 유형의 이미지 페어링 데이터를 활용하여 단일 공유 표현 공간을 학습하는 ImageBind를 제안했습니다. 이 연구에서는 모든 양식이 동시에 나타나는 데이터 세트가 필요하지 않습니다. 대신 각 양식의 임베딩이 이미지 임베딩과 일치하는 한 모든 양식이 이미지의 결합 속성을 활용합니다. 빠르게 정렬되었습니다. Meta AI도 해당 코드를 발표했습니다. 주소 : https://dl.fbaipublicfiles.com/imagebind/imagebind_final.pdf

github 주소 : https://github.com/facebookresearch/ ImageBind

동시에 연구원들은 ImageBind가 대규모 시각적 언어 모델(예: CLIP)을 사용하여 초기화될 수 있으므로 이러한 모델의 풍부한 이미지 및 텍스트 표현을 활용할 수 있다고 말했습니다. 따라서 ImageBind는 교육이 거의 필요하지 않으며 다양한 양식과 작업에 적용될 수 있습니다.

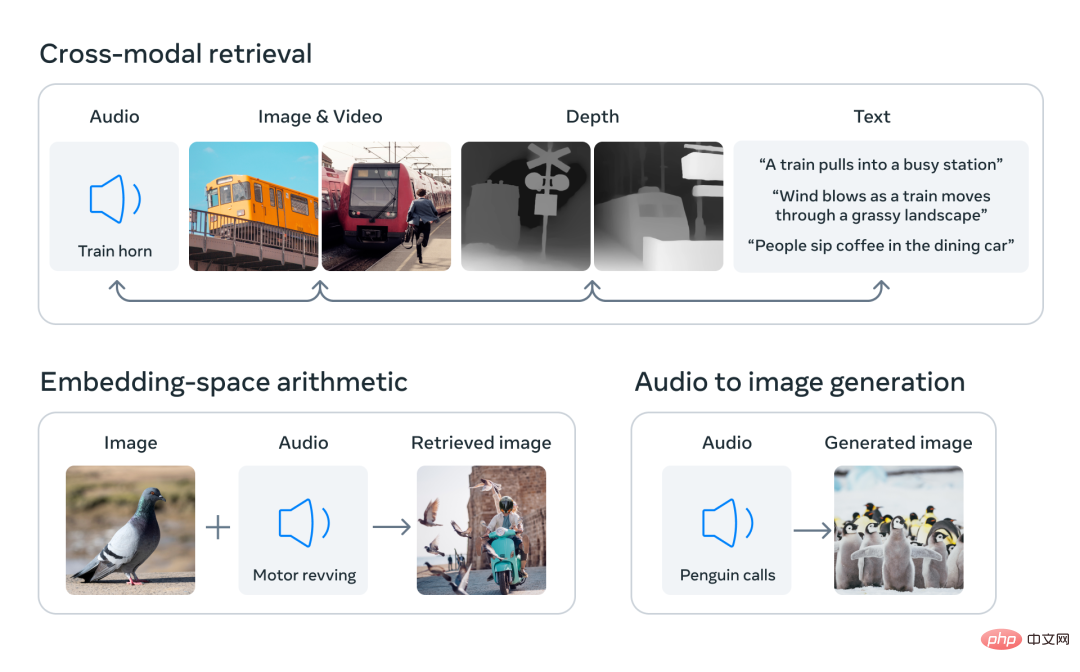

ImageBind는 모든 관련 유형의 데이터로부터 학습하는 다중 모드 AI 시스템을 만들기 위한 Meta의 노력의 일부입니다. 양식의 수가 증가함에 따라 ImageBind는 연구자들이 몰입형 가상 세계를 설계하거나 경험하기 위해 3D 및 IMU 센서를 결합하는 등 새로운 전체적 시스템을 개발할 수 있는 수문을 열어줍니다. 또한 텍스트, 비디오, 이미지의 조합을 사용하여 이미지, 비디오, 오디오 파일 또는 텍스트 정보를 검색함으로써 기억을 탐색할 수 있는 풍부한 방법을 제공합니다.

인간은 아주 적은 수의 샘플을 통해 새로운 개념을 학습할 수 있는 능력이 있습니다. 익숙하지 않은 자동차 모델의 사진을 통해 해당 자동차의 엔진에서 나는 소리를 예측할 수 있습니다. 이는 부분적으로 단일 이미지가 전반적인 감각 경험을 함께 "묶을" 수 있기 때문입니다. 그러나 인공지능 분야에서는 양식의 수가 증가하고 있지만 다감각 데이터의 부족으로 인해 쌍을 이루는 데이터가 필요한 표준 다중 모드 학습이 제한될 것입니다.

이상적으로는 다양한 유형의 데이터가 포함된 공동 임베딩 공간을 통해 모델이 시각적 특징을 학습하는 동시에 다른 양식을 학습할 수 있습니다. 이전에는 모든 양식이 공동 임베딩 공간을 학습하려면 가능한 모든 쌍별 데이터 조합을 수집해야 하는 경우가 많았습니다.

ImageBind는 최근 대규모 시각적 언어 모델을 활용하여 이러한 난제를 우회합니다. 이는 최근 대규모 시각적 언어 모델의 제로샷 기능을 비디오-오디오 및 이미지와 같은 이미지의 자연스러운 쌍을 통해 새로운 양식으로 확장합니다. -공동 임베딩 공간을 학습하기 위한 깊이 데이터. 다른 4가지 양식(오디오, 깊이, 열 화상 및 IMU 판독값)의 경우 연구원들은 자연스럽게 쌍을 이루는 자체 감독 데이터를 사용했습니다.

ImageBind는 6가지 양식의 임베딩을 공통 공간으로 정렬함으로써 여러 양식에서 동시에 관찰되지 않는 다양한 유형의 콘텐츠를 검색할 수 있습니다. 미리 훈련된 DALLE-2 디코더(CLIP 텍스트 임베딩과 함께 사용하도록 설계됨)와 함께 Meta AI의 오디오 임베딩을 사용하여 오디오-이미지 생성을 달성합니다.

인터넷에는 텍스트와 함께 나타나는 수많은 이미지가 있기 때문에 이미지-텍스트 모델 훈련이 널리 연구되어 왔습니다. ImageBind는 네트워크 데이터를 사용하여 텍스트를 이미지에 연결하거나 IMU 센서가 있는 웨어러블 카메라에서 캡처한 비디오 데이터를 사용하여 모션을 비디오에 연결하는 등 다양한 양식에 연결할 수 있는 이미지의 바인딩 속성을 활용합니다.

대규모 네트워크 데이터에서 학습된 시각적 표현은 다양한 모달 기능을 학습하기 위한 대상으로 사용될 수 있습니다. 이를 통해 ImageBind는 이미지를 동시에 존재하는 모든 양식과 정렬하여 해당 양식을 서로 자연스럽게 정렬할 수 있습니다. 이미지와 강한 상관관계가 있는 히트 맵, 깊이 맵과 같은 양식은 정렬하기가 더 쉽습니다. 오디오 및 IMU(관성 측정 장치)와 같은 비시각적 양식은 상관 관계가 약합니다. 예를 들어 아기 울음소리와 같은 특정 소리는 다양한 시각적 배경과 일치할 수 있습니다.

ImageBind는 이미지 페어링 데이터가 이러한 6가지 양식을 함께 묶는 데 충분하다는 것을 보여줍니다. 모델은 콘텐츠를 더 완전하게 설명할 수 있어 서로 다른 양식이 서로 "대화"하고 동시에 관찰하지 않고도 이들 사이의 연결을 찾을 수 있습니다. 예를 들어 ImageBind는 오디오와 텍스트를 함께 관찰하지 않고도 연결할 수 있습니다. 이를 통해 다른 모델은 리소스 집약적인 교육 없이도 새로운 양식을 "이해"할 수 있습니다.

ImageBind의 강력한 확장 성능을 통해 이 모델은 많은 인공 지능 모델을 대체하거나 향상하여 다른 양식을 사용할 수 있습니다. 예를 들어 Make-A-Scene은 텍스트 프롬프트를 사용하여 이미지를 생성할 수 있지만 ImageBind는 이를 업그레이드하여 웃음이나 빗소리와 같은 오디오를 사용하여 이미지를 생성할 수 있습니다.

Meta의 분석에 따르면 ImageBind의 크기 조정 동작은 이미지 인코더의 성능이 향상됨에 따라 향상됩니다. 즉, 양식을 정렬하는 ImageBind의 능력은 시각적 모델의 힘과 크기에 따라 확장됩니다. 이는 더 큰 시각적 모델이 오디오 분류와 같은 비시각적 작업에 유익하며 이러한 모델을 훈련하면 컴퓨터 비전 작업을 넘어서는 이점이 있음을 시사합니다.

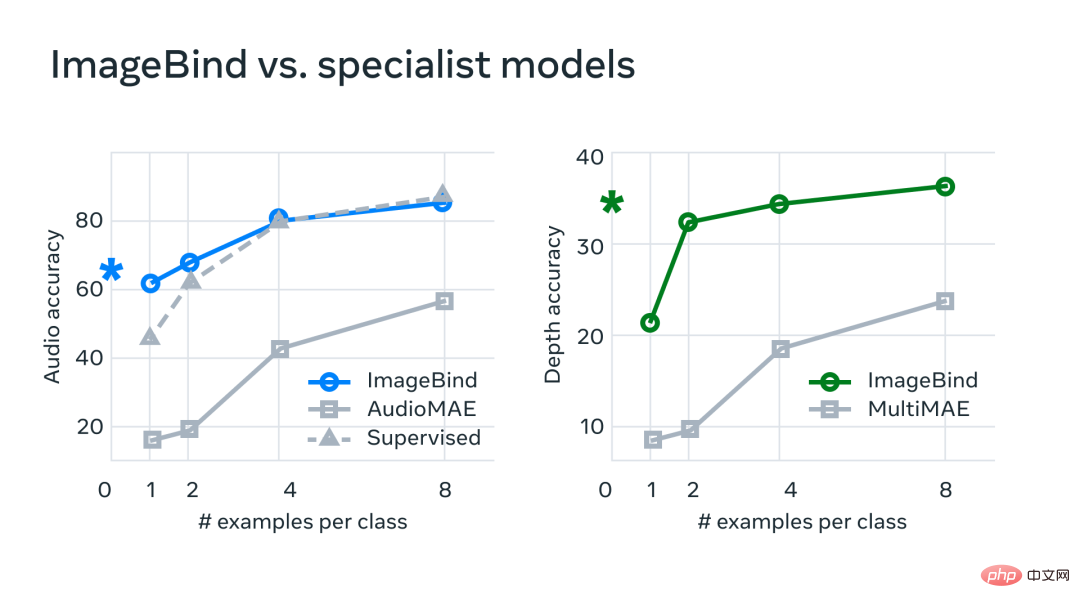

실험에서 Meta는 ImageBind의 오디오 및 깊이 인코더를 사용하여 제로샷 검색 및 오디오 및 깊이 분류 작업에 대한 이전 작업과 비교했습니다.

벤치마크에서 ImageBind는 오디오 및 깊이 측면에서 전문가 모델보다 성능이 뛰어납니다.

Meta는 ImageBind가 몇 장의 오디오 및 심층 분류 작업에 사용될 수 있으며 이전 사용자 정의 방법보다 성능이 뛰어나다는 사실을 발견했습니다. 예를 들어 ImageBind는 Audioset에서 훈련된 Meta의 자체 감독 AudioMAE 모델과 오디오 분류에 대해 미세 조정된 감독 AudioMAE 모델보다 훨씬 뛰어난 성능을 발휘합니다.

또한 ImageBind는 크로스 모달 제로샷 인식 작업에서 새로운 SOTA 성능을 달성하여 해당 양식의 개념을 인식하도록 훈련된 최첨단 모델보다 성능이 뛰어납니다.

위 내용은 이미지를 사용하여 모든 양식을 정렬하고, 메타 오픈 소스 다감각 AI 기본 모델을 통해 훌륭한 통합을 달성합니다.의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!