ChatGPT의 출시는 전체 AI 분야를 뒤흔들었고 주요 기술 회사, 스타트업 및 대학 팀이 이를 따르고 있습니다. 최근 하트 오브 더 머신(Heart of the Machine)에는 수많은 스타트업 기업과 대학팀의 연구 결과가 보도됐다.

어제 또 다른 대규모 국내 AI 대화 모델이 출시되었습니다. Tsinghua의 기술 성과를 변형하고 GLM-130B 1000억 기본 모델을 기반으로 한 회사의 스마트 스펙트럼 AI인 ChatGLM이 이제 초대 전용 대화 모델을 시작했습니다. 내부 베타.

Zhipu AI가 단일 소비자급 그래픽 카드에서 추론을 지원하는 중국어-영어 이중 언어 대화 모델 ChatGLM-6B도 오픈 소스로 제공했다는 점은 언급할 가치가 있습니다.

내부 베타 애플리케이션 웹사이트: chatglm.cn

ChatGLM 현재 버전의 성능 향상은 주로 고유한 1000억 베이스 모델인 GLM-130B에서 비롯된 것으로 이해됩니다. . BERT, GPT-3, T5와는 다른 아키텍처로 다중 목적 함수를 포함하는 자동 회귀 사전 학습 모델입니다.

2022년 8월, Tsinghua University와 Zhipu AI는 1,300억 개의 매개변수를 갖춘 중국어-영어 이중 언어 밀도 모델 GLM-130B를 연구 커뮤니티 및 업계에 공개했습니다. 중국어 및 영어 모두

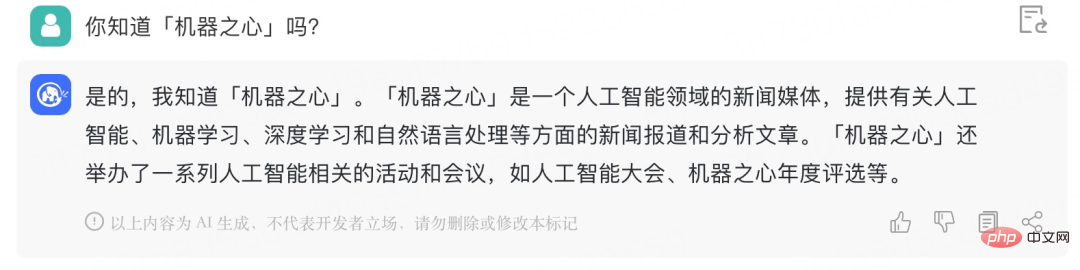

Heart of the Machine이 비공개 베타 초대 코드를 획득했습니다. ChatGLM과의 간단한 대화 내용은 다음과 같습니다.

"Station"의 실제 의미를 이해할 수 있습니다. CP":

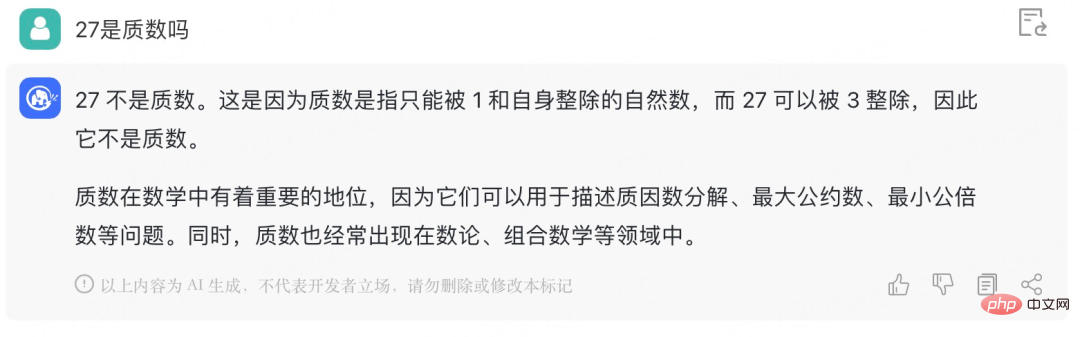

Give ChatGLM 수학 문제를 풀어보세요:

두 변수의 선형 방정식을 배웠기 때문에 이와 같은 기본적인 "같은 우리 안의 닭과 토끼" 문제는 더 이상 문제가 되지 않습니다. :

ChatGLM-6B는 중국어와 영어 이중 언어 질문과 답변을 지원하고 중국어에 최적화된 오픈 소스 대화 언어 모델입니다. 이 모델은 GLM(General Language Model) 아키텍처를 기반으로 하며 62억 개의 매개변수를 가지고 있습니다. 모델 양자화 기술과 결합하여 사용자는 이를 소비자급 그래픽 카드에 로컬로 배포할 수 있습니다(INT4 양자화 수준에서는 최소 6GB의 비디오 메모리가 필요함). ChatGLM-6B는 ChatGLM과 동일한 기술을 사용하며 중국어 Q&A 및 대화에 최적화되어 있습니다. 감독된 미세 조정, 피드백 셀프 서비스, 인간 피드백 강화 학습 및 기타 기술로 보완된 약 1T 식별자를 사용하여 중국어와 영어로 이중 언어 훈련을 마친 후 62억 개의 매개 변수 ChatGLM-6B(1000억 모델만큼 크지는 않지만) 추론 비용을 크게 줄이고 효율성을 향상시켰으며 이미 인간의 선호도와 상당히 일치하는 답변을 생성할 수 있습니다.

모델 오픈 소스 주소: https://github.com/THUDM/ChatGLM-6B

특히 ChatGLM-6B에는 다음과 같은 기능이 있습니다.

ChatGLM-6B 모델의 용량이 작기 때문에 필연적으로 다음과 같은 몇 가지 제한 사항과 단점이 있습니다.

GLM 팀은 ChatGLM이 여전히 최고의 국제 대형 모델 연구 및 제품에 비해 훨씬 뒤떨어져 있다고 밝혔습니다. 앞으로도 ChatGLM 및 관련 모델의 업데이트 버전을 계속 개발하고 오픈 소스할 것입니다. GLM 팀은 또한 ChatGLM-6B를 다운로드하고 이를 기반으로 연구 및 (비상업적) 애플리케이션 개발을 수행하는 모든 사람을 환영합니다.

위 내용은 Tsinghua 기반 기가비트 기본 대화 모델인 ChatGLM은 내부 테스트를 시작했으며 해당 모델의 오픈 소스 단일 카드 버전입니다.의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!