내가 깨어났을 때, 머신러닝 커뮤니티는 충격에 빠졌습니다.

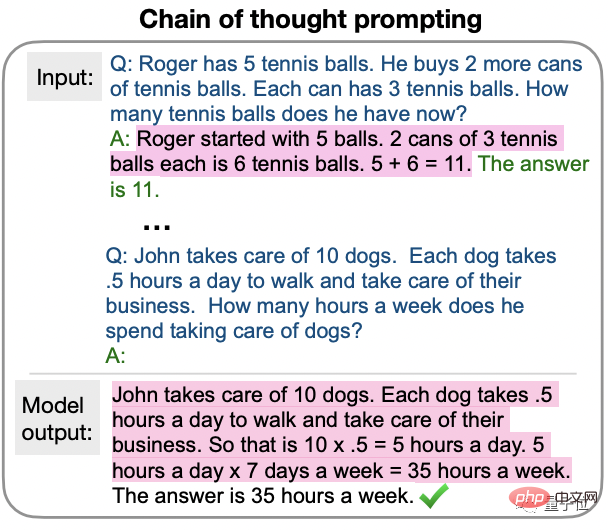

최신 연구에 따르면 GPT-3에게 "단계적으로 생각해보자"라고 말하는 것만으로도 이전에 답할 수 없었던 질문에 올바르게 답할 수 있다는 사실이 밝혀졌습니다.

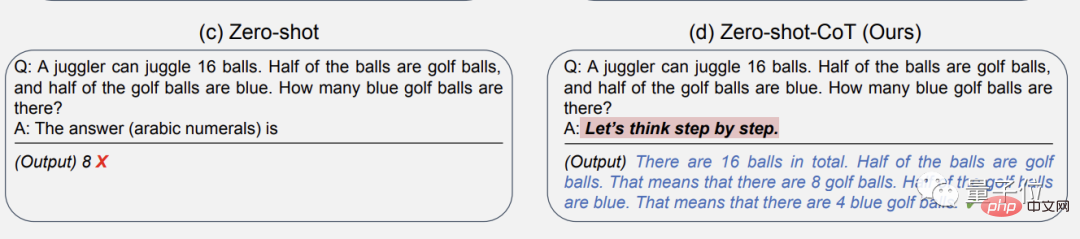

예를 들면 다음과 같습니다.

공 16개 중 절반은 골프공이고, 이 골프공 중 절반은 파란색입니다. 파란색 골프공은 모두 몇 개인가요?

(질문은 어렵지 않습니다. , 하지만 이는 제로샷 학습이므로 AI 훈련 단계에서 유사한 문제가 본 적이 없다는 의미입니다. )

GPT-3에게 "답이 무엇입니까"라고 직접 쓰라고 요청하면 이렇게 됩니다. 틀린 답을 주다: 8.

그러나 단계별로 생각하게 하는 "주문"을 추가한 후 GPT-3는 먼저 생각의 단계를 출력하고 마지막으로 정답인 4를 제공합니다!

그리고 이것은 우연이 아닙니다. 연구 팀은 논문에서 완전히 검증되었다고 말했습니다.

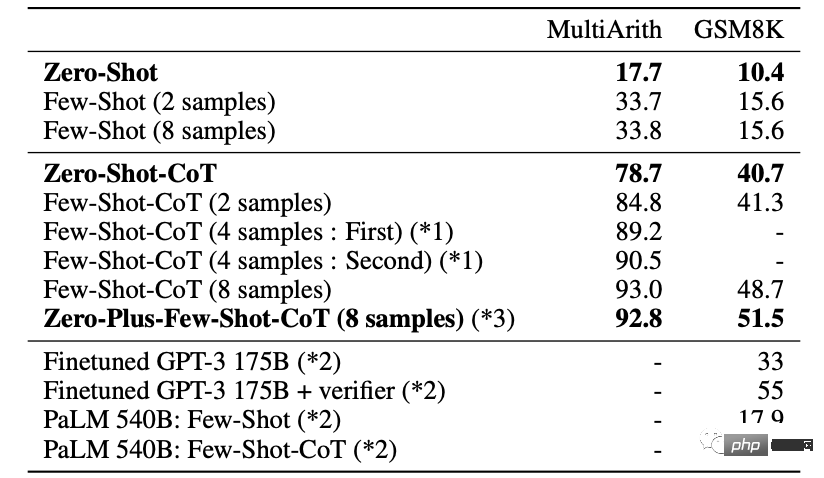

위의 질문은 특히 언어 모델의 수학적 문제 해결 능력을 테스트하는 클래식 MutiArith 데이터 세트에서 나온 것입니다. GPT-3은 원래 제로 샘플 시나리오에서 정확도가 17%에 불과했습니다.

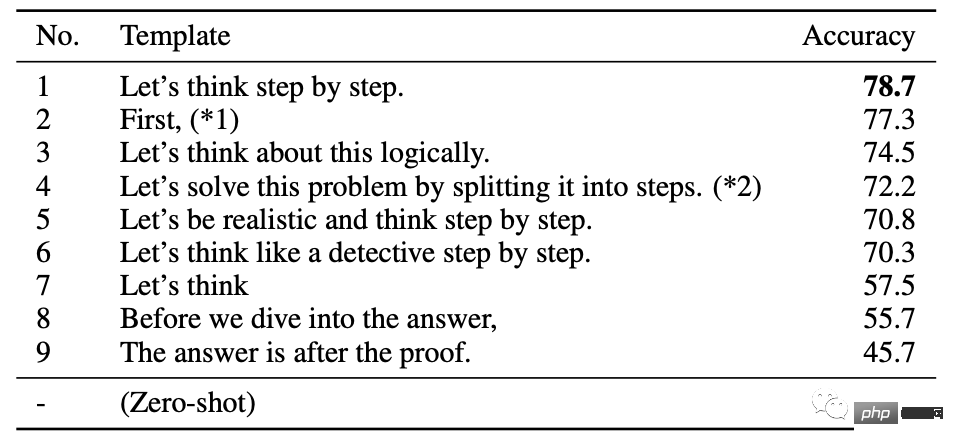

이 문서에는 가장 효과적인 프롬프트 단어 9개가 요약되어 있습니다. 그 중 GPT-3가 단계별로 생각하도록 하는 데 사용되는 처음 6개는 정확도를 70% 이상 높였습니다.

가장 간단한 문장인 "생각해보자"도 57.5%까지 올라갈 수 있습니다.

유치원 아줌마가 아이를 달래는 느낌...

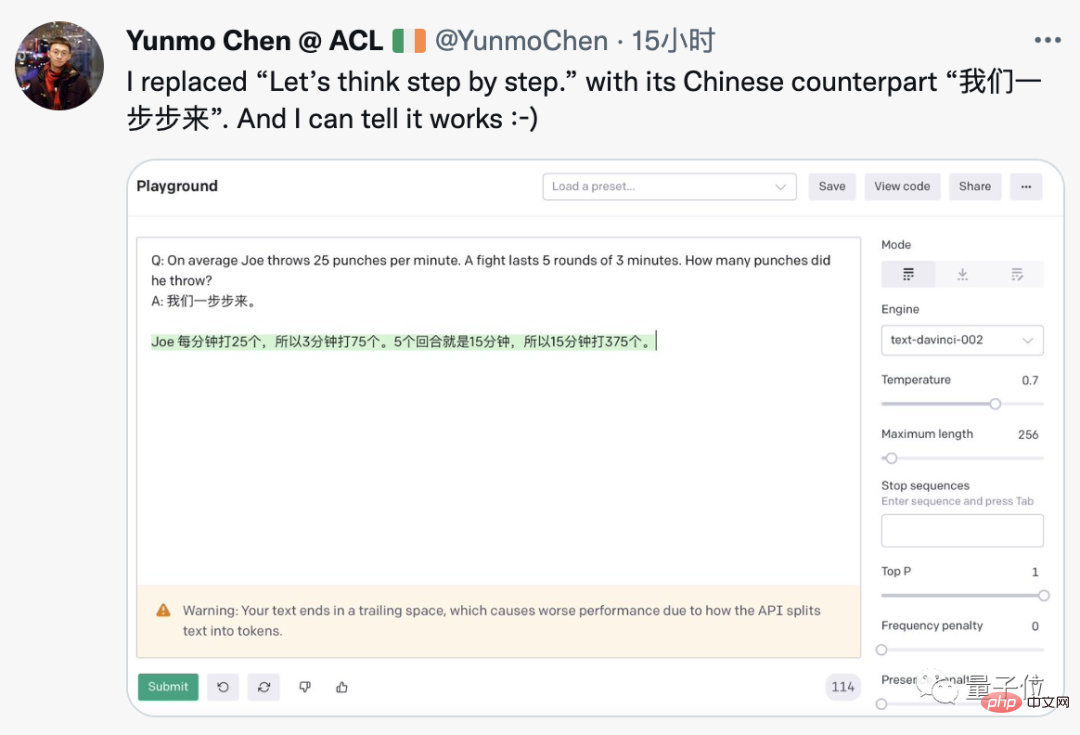

이 기술은 GPT-3에 마법적인 수정이 필요하지 않은 것 같습니다. 누군가 OpenAI 공식 데모에서 성공적으로 재현했으며 심지어 중국어로 변경하기도 했습니다.

영어 질문에 대한 중국어 힌트, GPT-3는 올바른 중국어 답변을 제공합니다.

이 논문을 소셜 네트워크에 처음 전달한 Google 연구원은 필요한 모든 것이 새로 추가되었다고 말했습니다.

이걸 보고 각계각층의 덩치 큰 놈들이 엉뚱한 생각을 갖고 놀리기 시작했습니다.

AI에게 "할 수 있다, 나는 당신을 믿는다"라고 격려하면 어떻게 될까요?

AI를 위협하면서 "시간이 얼마 남지 않았다"라던가 "시간이 얼마 남지 않았다"고 하면 어떻게 될까요? 머리에 총을 박아라"?

AI에게 "조심히 운전해"라고 말하는 것이 자율주행의 해결책이 될까요?

일부에서는 이것이 SF의 줄거리와 거의 같다고 제안하기도 했습니다. 이야기 "은하수를 여행하는 히치하이커를 위한 안내서" 일반 인공지능을 달성하는 열쇠는 그것을 올바르게 수행하는 방법을 아는 것입니다. AI에게 질문하세요.

이 마법 같은 현상은 어떻게 진행되고 있는 걸까요?

이 현상의 발견은 제로 샘플을 탐구하는 Google Brain과 도쿄 대학의 공동 연구에서 이루어졌습니다. -현장에서 대규모 언어 모델 성능의 샘플 역할.

논문 제목 "Language Model Is a Zero-Sample Reasoner"는 GPT-3의 "Language Model Is a Few-Sample Learner"에 대한 찬사이기도 합니다.

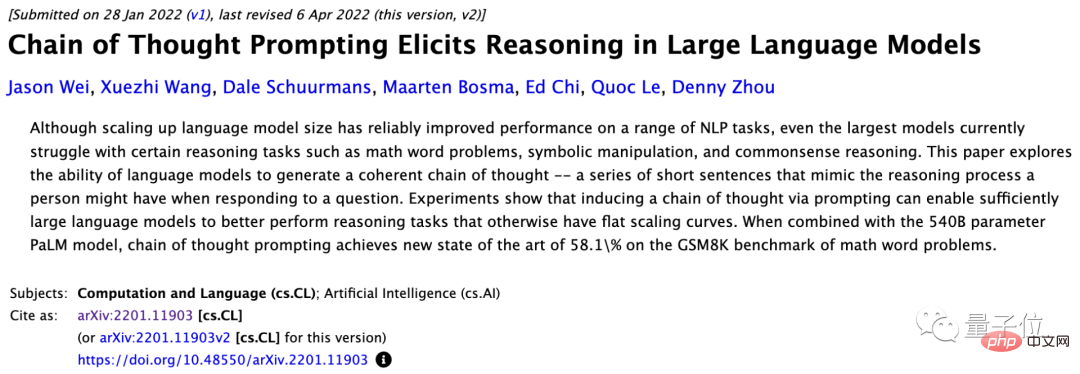

사용된 방법은 올해 1월 구글 브레인 팀이 제안한 Chain of Thought Prompting(CoT)에 속합니다.

초기 CoT는 퓨샷 학습에 적용되었으며, 질문을 하면서 AI가 가이드할 수 있도록 단계별 답변 예시를 제공했습니다.

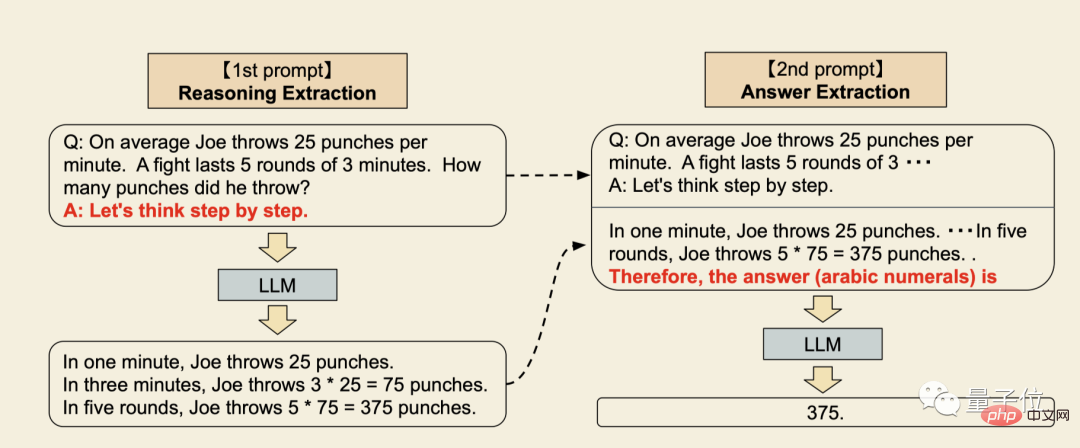

이 최신 연구에서는 제로 샘플 CoT를 제안합니다. 주요 변경 사항은 예제 부분을 단순화하는 것입니다.

이 작업의 가장 큰 장점은 보편적이며 다양한 문제 유형에 대한 전용 예제를 제공할 필요가 없다는 것입니다.

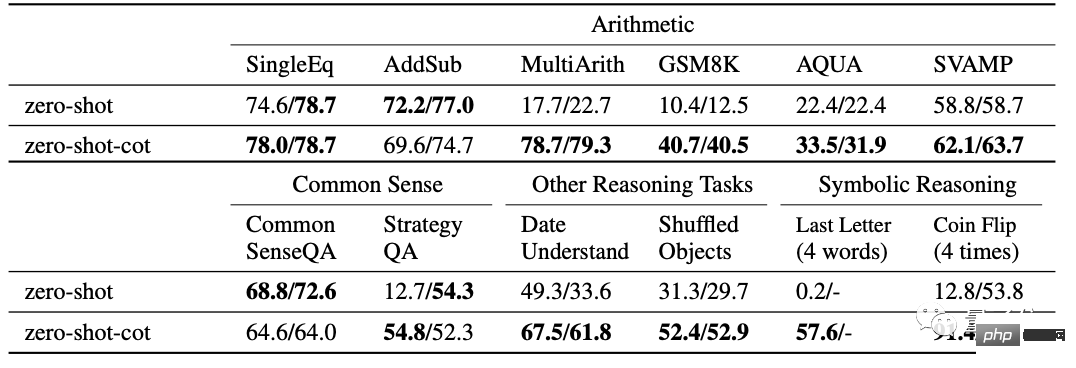

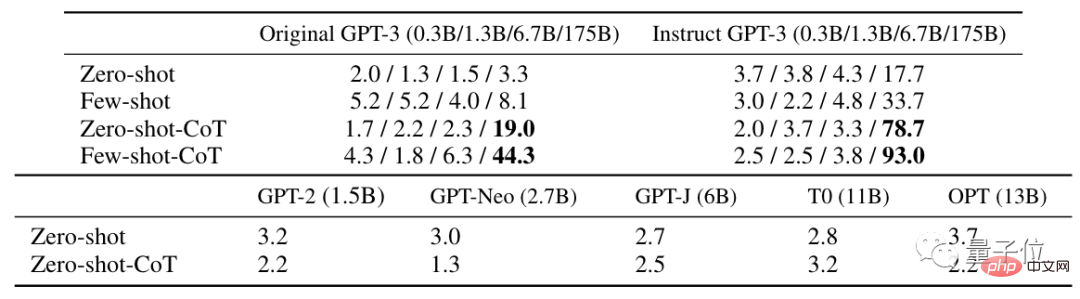

이 논문은 12가지 테스트를 포함하여 다양한 문제에 대해 충분한 실험을 수행했습니다.

일반 제로샷 학습과 비교하여 제로샷 CoT는 10가지에서 더 나은 결과를 얻습니다.

Δ오른쪽 값은 추가 실험 결과입니다

더 어려운 MultiArith 및 GSM8K 수학 테스트에서는 최신 버전의 GPT-3 Text-davinci-002( 175B).

최고의 결과를 얻기 위해 8번의 시도를 한다면 정확도는 93%까지 더욱 향상될 수 있습니다.

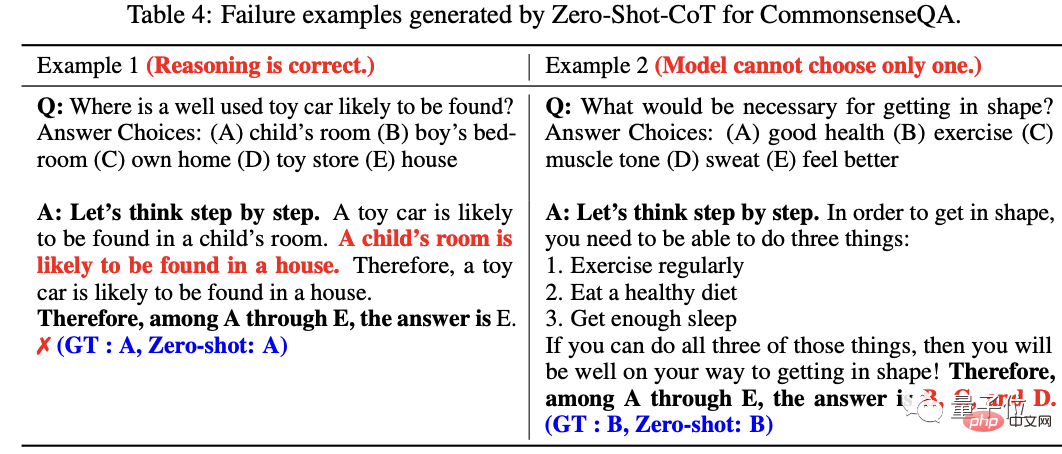

오류 결과 분석에서도 연구원들은 많은 질문에서 AI의 추론 과정이 실제로는 정확하지만 답변이 고유한 답변으로 수렴되지 않는 경우 여러 대안이 제공된다는 사실도 발견했습니다.

논문 끝에서 연구팀은 이 연구가 제로 샘플 CoT의 기준이 될 수 있을 뿐만 아니라, 미세 조정된 데이터 세트를 구축하기 전에 학계가 이를 깨닫고 소수 샘플 프롬프트 템플릿, 대규모 언어 모델 중요성의 제로 샘플 기능을 완전히 탐색합니다.

연구팀은 도쿄대학교 마쓰오 연구소 출신입니다.

마츠오 유타카 교수는 소프트뱅크 이사회 최초의 인공지능 전문가이기도 하다.

팀원 중 Gu Shixiang 객원 교수는 Google Brain 팀 출신입니다. Gu Shixiang은 3대 거물 중 하나인 Hinton 밑에서 학사 학위를 취득하고, 케임브리지 대학교에서 박사 학위를 취득했습니다.

제로 샘플 CoT가 작동하는 이유는 아직 탐구되지 않았습니다.

그러나 누군가 이 방법이 GPT-3(text-davinci-002)에만 효과적인 것 같다고 실험적으로 결론을 내렸습니다. 그는 버전 001을 시도했지만 거의 효과를 발견하지 못했습니다.

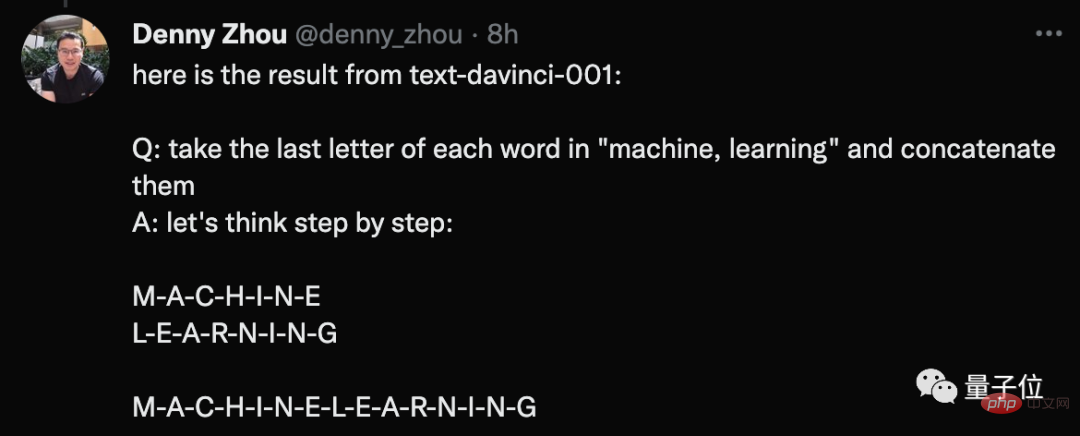

그는 자신이 한 일의 예를 나열했습니다.

질문: 머신앤러닝의 각 단어의 마지막 글자를 연결해주세요.

메시지가 표시될 때 GPT-3에서 제공하는 대답은 두 단어의 모든 문자를 연결하는 것입니다.

이에 대해 저자 중 한 명인 Gu Shixiang은 실제로 "주문"은 GPT-3 초기 버전과 개선 버전 모두에 영향을 미치며 이러한 결과는 GPT-3에도 반영된다고 답했습니다. 종이.

어떤 사람들은 딥러닝이 "마법의 주문"을 찾는 게임이 되었는지 의문을 제기하기도 했습니다.

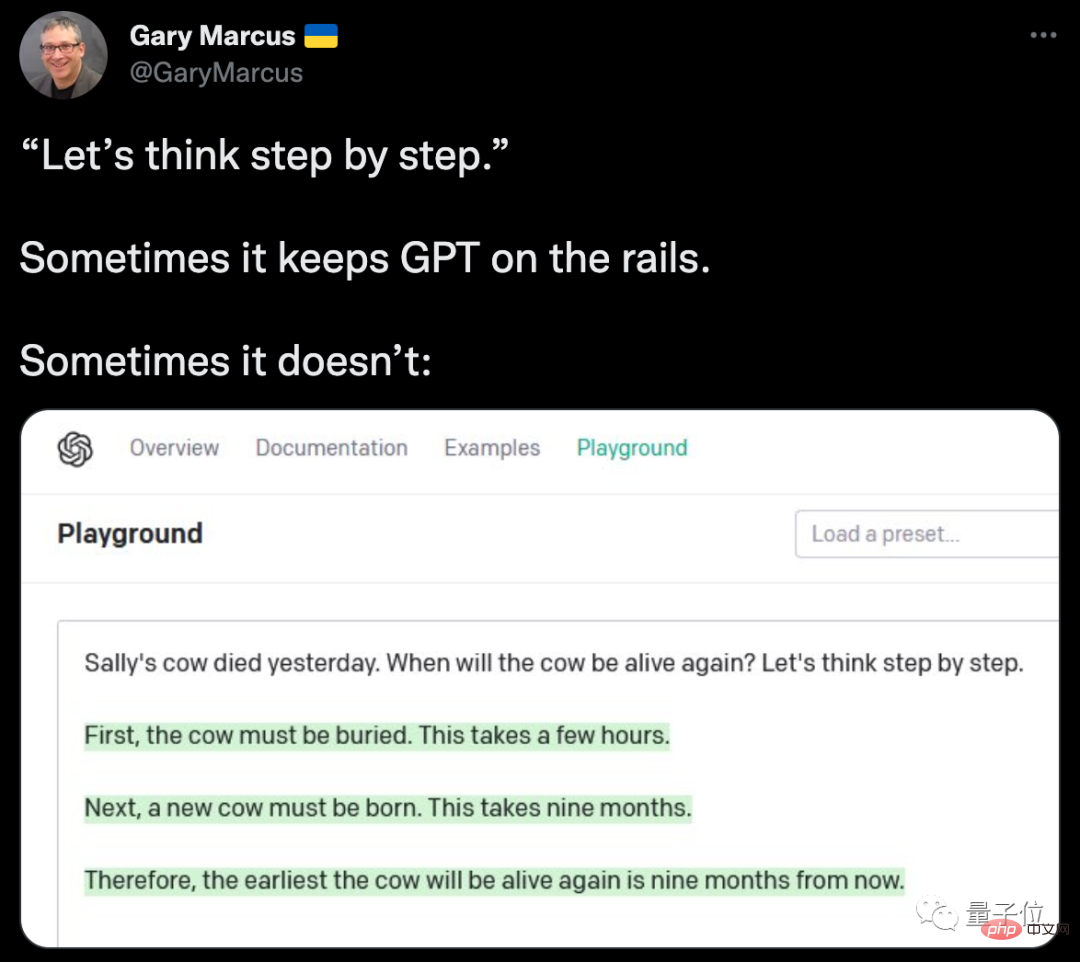

동시에 민원팀에서 마커스를 다시 만났습니다.

그는 또한 GPT-3가 "주문"의 축복을 받았음에도 불구하고 샐리의 소가 다시 살아날지 알 수 없었던 실패 사례를 열거했습니다...

그러나 AI에 약간의 마법을 추가하고 즉각적인 개선을 달성하는 이와 같은 사례가 드물지 않다는 점은 주목할 가치가 있습니다.

일부 네티즌들은 GPT-3를 사용할 때 중간 명령어 몇 개만 추가하면 오히려 더 만족스러운 결과를 얻을 수 있다고 공유하기도 했습니다.

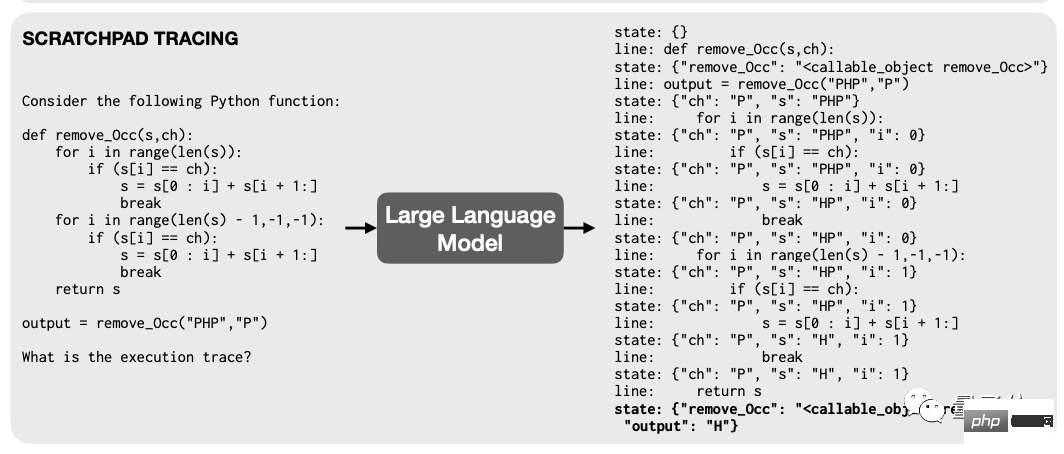

이전에 Google과 MIT의 연구원들은 훈련 언어 모델이 디버깅할 때 프로그래머와 같은 "중단점"을 갖는 한 모델의 코드를 읽고 수행하는 능력을 변경할 필요가 없다는 것을 발견했습니다. 연산이 즉시 향상됩니다.

원칙도 매우 간단합니다. 즉, 계산 단계가 많은 프로그램에서 모델이 각 단계를 텍스트로 인코딩하고 이를 "스티커 메모"라는 임시 레지스터에 기록하도록 합니다.

결과적으로 모델의 계산 과정이 더욱 명확해지고 질서정연해지며 성능도 자연스럽게 크게 향상됩니다.

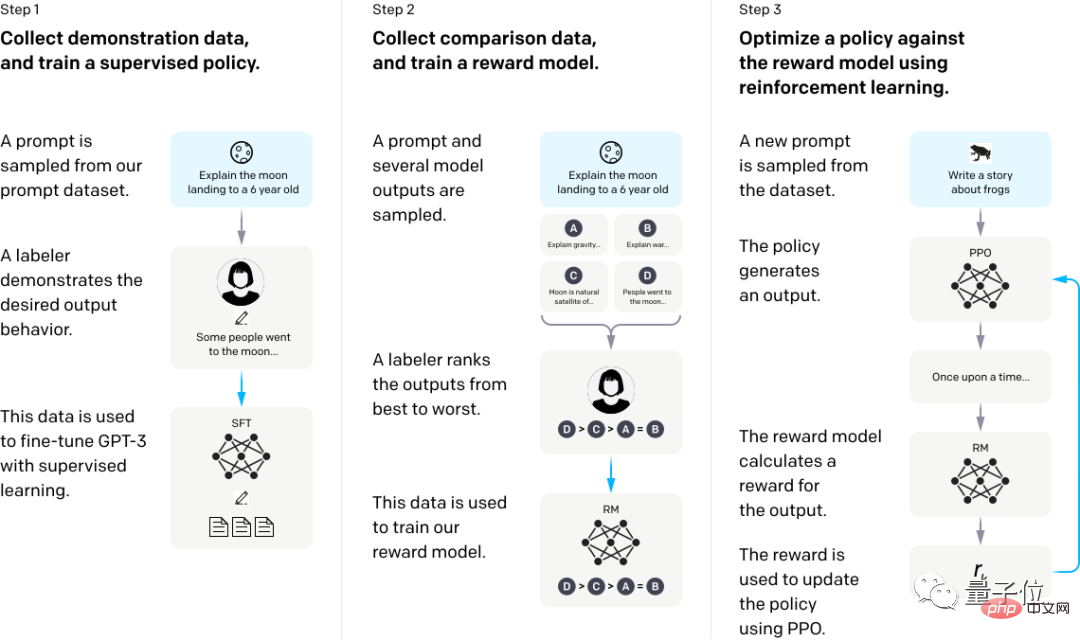

이 실험에서 테스트에 사용된 Instruct GPT-3도 있는데, 이것도 대표적인 예입니다.

GPT-3가 인간의 피드백을 통해 학습하도록 하는 것만으로도 잘못된 질문에 답하는 상황을 크게 개선할 수 있습니다.

구체적으로 말하면 먼저 인간의 시연 답변을 사용하여 모델을 미세 조정한 다음 특정 질문에 대한 여러 가지 출력 데이터 세트를 수집하고 여러 답변 세트를 수동으로 정렬하고 이 데이터 세트에 대한 보상 모델을 교육합니다. .

마지막으로 RM을 보상 함수로 사용하는 PPO(Proximal Policy Optimization) 알고리즘은 강화 학습 방법으로 보상을 극대화하기 위해 GPT-3 정책을 미세 조정합니다.

이 주제를 촉발한 Twitter 블로거 Aran을 포함해, "Unreal Engine"을 추가하면 AI 생성 이미지의 품질이 치솟을 수 있다는 사실을 처음 발견한 사람이 바로 이 사람이었습니다.

전 Google 로봇 사장인 Eric Zhang도 강화 학습이 비슷한 사고 방식을 사용하여 컴퓨팅 효율성을 향상시킬 수 있다는 사실을 이전에 발견했습니다.

AI에서 사용하는 이런 기술은 보통 뇌를 사용할 때 사용하는 기술이 아니라고 하는 분들도 계시죠?

사실 벤지오는 이전부터 AI의 운영 모델을 제안하기 위해 뇌과학에서 출발했습니다. .인간의 두뇌 모드와 같아야합니다.

인간의 인지 작업은 시스템 1 인지와 시스템 2 인지로 나눌 수 있습니다.

시스템 1 인지 작업은 무의식적으로 완료되는 작업을 말합니다. 예를 들어, 당신은 손에 쥐고 있는 것이 무엇인지 즉시 확인할 수 있지만, 이 과정을 어떻게 완료했는지 다른 사람에게 설명할 수는 없습니다.

시스템 2 인지 작업은 인간의 두뇌가 특정 단계에 따라 완료해야 하는 인지를 말합니다. 예를 들어 덧셈과 뺄셈 계산을 하면 최종 답에 어떻게 도달했는지 명확하게 설명할 수 있습니다.

이번에 추가된 "주문"은 AI가 한 단계 더 나아가 단계적으로 생각하는 법을 배울 수 있도록 하는 것입니다.

이러한 추세에 맞서 일부 학자들은 "힌트 엔지니어링이 피처 엔지니어링을 대체하고 있다"고 믿고 있습니다.

그러면 "큐 워드 헌터"가 차세대 NLP 연구자들의 별명이 될까요?

논문 주소://m.sbmmt.com/link/cc9109aa1f048c36d154d902612982e2

참조 링크:

[1]https://twitter.com/arankomatsuzaki/status/1529278580189908993

[2]https://evjang.com/2021/10/23/generalization.html

위 내용은 약간의 설득으로 GPT-3 정확도를 61%까지 높일 수 있습니다! 구글과 도쿄대학의 연구는 충격적이다의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!