이 기사는 Lei Feng.com에서 복제되었습니다. 재인쇄가 필요한 경우 Lei Feng.com 공식 웹사이트로 이동하여 승인을 신청하세요.

세계 최대 가속기 칩 CS-2 웨이퍼 스케일 엔진으로 유명한 회사인 Cerebras는 어제 인공 지능 훈련에 "거대 코어"를 사용하는 중요한 단계를 밟았다고 발표했습니다. 이 회사는 단일 칩에서 세계 최대 규모의 NLP(자연어 처리) AI 모델을 훈련시켰습니다.

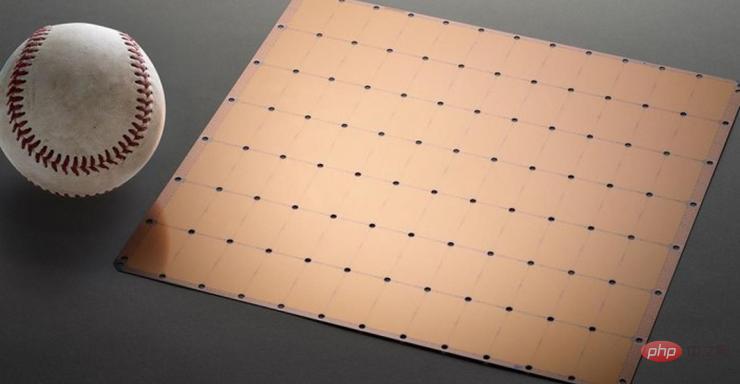

모델에는 20억 개의 매개변수가 있으며 CS-2 칩에서 훈련되었습니다. 세계 최대의 가속기 칩은 7nm 공정을 사용하며 정사각형 웨이퍼에서 식각됩니다. 주류 칩보다 수백 배 더 크며 15KW의 전력을 가지고 있습니다. 2조 6천억 개의 7nm 트랜지스터, 850,000개의 코어 및 40GB 메모리를 패키지로 통합합니다.

그림 1 CS-2 웨이퍼 스케일 엔진 칩

NLP 모델 개발은 인공지능에서 중요한 분야입니다. NLP 모델을 사용하면 인공지능은 텍스트의 의미를 "이해"하고 그에 상응하는 조치를 취할 수 있습니다. OpenAI의 DALL.E 모델은 대표적인 NLP 모델입니다. 이 모델은 사용자가 입력한 텍스트 정보를 이미지 출력으로 변환할 수 있습니다.

예를 들어 사용자가 "아보카도 모양의 안락 의자"를 입력하면 AI가 이 문장에 해당하는 여러 이미지를 자동으로 생성합니다.

사진: AI가 정보를 수신한 후 생성한 "아보카도 모양의 안락의자" 사진

또한 이 모델은 AI가 종, 기하학, 역사적 시대, 등.

그러나 이 모든 것을 달성하는 것은 쉽지 않습니다. NLP 모델의 전통적인 개발은 컴퓨팅 전력 비용과 기술적 한계가 매우 높습니다.

사실 숫자만 논하자면 Cerebras가 개발한 모델의 20억 매개변수는 동종 제품에 비해 다소 평범해 보입니다.

앞서 언급한 DALL.E 모델은 120억 개의 매개변수를 가지고 있으며, 현재 가장 큰 모델은 DeepMind가 지난해 말 출시한 Gopher로 2,800억 개의 매개변수를 가지고 있습니다.

그러나 엄청난 숫자 외에도 Cerebras가 개발한 NLP는 NLP 모델 개발의 어려움을 줄여주는 엄청난 혁신을 이루었습니다.

기존 프로세스에 따르면 NLP 모델을 개발하려면 개발자가 거대한 NLP 모델을 여러 기능적 부분으로 나누고 작업 부하를 수백 또는 수천 개의 그래픽 처리 장치에 분산시켜야 합니다.

수천 개의 그래픽 처리 장치는 제조업체에게 막대한 비용을 의미합니다.

기술적인 어려움도 제조업체를 비참하게 만듭니다.

슬라이싱 모델은 맞춤형 문제입니다. 각 신경망, 각 GPU 및 이들을 연결(또는 상호 연결)하는 네트워크의 사양은 고유하며 시스템 간에 이식할 수 없습니다.

제조업체는 첫 교육 전에 이러한 모든 요소를 명확하게 고려해야 합니다.

이 작업은 매우 복잡하며 때로는 완료하는 데 몇 달이 걸리기도 합니다.

Cerebras는 이것이 NLP 모델 훈련의 "가장 고통스러운 측면 중 하나"라고 말했습니다. 소수의 회사만이 NLP를 개발하는 데 필요한 자원과 전문 지식을 갖추고 있습니다. AI 업계의 다른 회사의 경우 NLP 교육은 너무 비싸고 시간이 많이 걸리며 사용할 수 없습니다.

그러나 단일 칩이 20억 개의 매개변수가 있는 모델을 지원할 수 있다면 모델 학습 작업량을 분산시키기 위해 대규모 GPU를 사용할 필요가 없다는 의미입니다. 이를 통해 제조업체는 수천 개의 GPU 교육 비용과 관련 하드웨어 및 확장 요구 사항을 절약할 수 있습니다. 또한 공급업체가 모델을 분할하고 수천 개의 GPU에 워크로드를 분산시키는 어려움을 겪지 않아도 됩니다.

Cerebras는 숫자에만 집착하지 않습니다. 모델의 품질을 평가할 때 매개변수의 개수만이 유일한 기준은 아닙니다.

"거대한 코어"에서 탄생한 모델의 "노력"을 기대하기보다, 세레브라스는 그 모델이 "스마트"해지기를 바랍니다.

Cerebras가 매개변수 수의 폭발적인 증가를 이룰 수 있는 이유는 Weighted Flow 기술을 사용하기 때문입니다. 이 기술은 컴퓨팅 공간과 메모리 공간을 분리하고 AI 워크로드를 증가시키는 모든 매개변수를 저장할 수 있을 만큼 메모리를 확장할 수 있습니다.

이 획기적인 발전 덕분에 모델 설정 시간이 몇 달에서 몇 분으로 단축되었습니다. 또한 개발자는 "단 몇 번의 키 입력"만으로 GPT-J와 GPT-Neo 등의 모델 간에 전환할 수 있습니다. 이는 NLP 개발을 더 쉽게 만듭니다.

이것은 NLP 분야에 새로운 변화를 가져왔습니다.

Intersect360 Research의 최고 연구 책임자인 Dan Olds는 Cerebras의 업적에 대해 다음과 같이 말했습니다. “대규모 언어 모델을 비용 효율적이고 접근 가능한 방식으로 대중에게 제공하는 Cerebras의 능력은 인공 지능의 흥미롭고 새로운 시대를 열어줍니다.”

위 내용은 세계 최대 AI 칩, 대형 모델의 단일 장치 훈련 기록 경신, Cerebras는 GPU를 '죽이고 싶어'의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!