Few-Shot 및 Zero-Shot 시나리오에서 ChatGPT의 놀라운 성능으로 인해 연구자들은 "사전 훈련"이 올바른 경로라는 확신을 갖게 되었습니다.

사전 훈련된 기초 모델(PFM)은 BERT, GPT-3, MAE, DALLE-E 및 ChatGPT에 대한 다양한 데이터 모드, 즉 대규모 데이터를 기반으로 하는 다양한 다운스트림 작업의 기초로 간주됩니다. 사전 훈련된 기본 모델은 다운스트림 애플리케이션에 대한 합리적인 매개변수 초기화를 제공하도록 훈련됩니다.

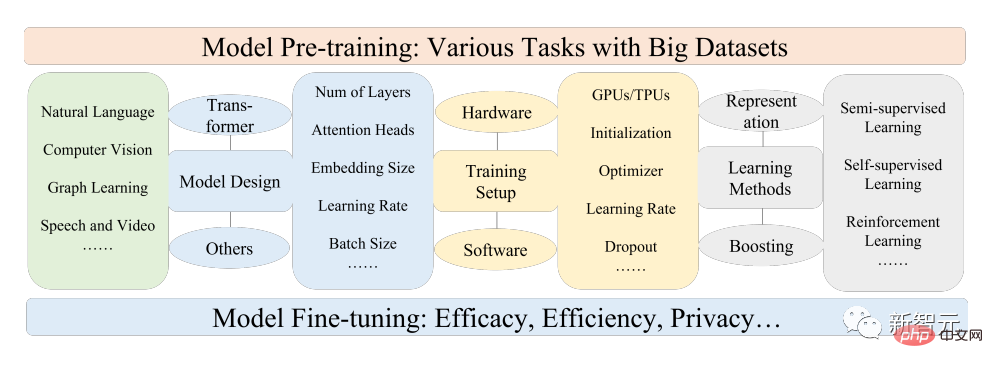

PFM의 사전 학습 아이디어는 대규모 모델 적용에서 중요한 역할을 합니다. 컨볼루션 및 재귀 모듈을 사용하는 이전의 특징 추출 방법과 달리 생성적 사전 학습(GPT) 방법입니다. Transformer를 특징 추출기로 사용하여 대규모 데이터 세트에 대해 자동 회귀 훈련을 수행합니다.

PFM이 다양한 분야에서 큰 성공을 거두면서 최근 발표된 논문에서 수많은 방법, 데이터 세트 및 평가 지표가 제안되었으며 업계에서는 BERT에서 ChatGPT까지의 개발 프로세스를 추적하는 포괄적인 검토가 필요합니다. .

최근 베이항대학교, 미시간주립대학교, 리하이대학교, 난양공과대학, 듀크 등 국내외 유명 대학 및 기업의 연구자들이 사전 훈련 기본 모델에 대한 리뷰를 공동으로 작성하여 최근 연구 진행 상황을 제공합니다. 텍스트, 이미지, 그래프 분야뿐만 아니라 현재와 미래의 과제와 기회에도 관심을 갖고 있습니다.

논문 링크: https://arxiv.org/pdf/2302.09419.pdf

연구진은 먼저 자연어 처리, 컴퓨터 비전 및 그래픽 학습의 기본 구성 요소와 기존 전처리를 검토했습니다. 그런 다음 데이터 품질과 양을 고려한 기타 고급 PFM 및 통합 PFM의 데이터 모드와 모델 효율성, 압축, 보안 및 개인정보 보호를 포함한 PFM의 기본 원칙에 대한 관련 연구를 논의합니다. 연구 방향, 과제 및 공개 질문.

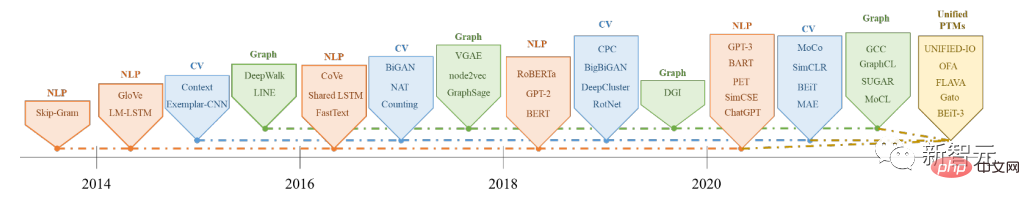

사전 학습 기본 모델(PFM)은 빅데이터 시대의 인공지능 시스템 구축에 중요한 부분으로 자연어 처리(NLP), 컴퓨터 비전 등에 널리 사용됩니다. (CV) 및 그래프 학습(GL) 인공지능의 세 가지 주요 분야가 광범위하게 연구되고 적용되었습니다.

PFM은 다양한 분야 또는 크로스 도메인 작업에 효과적인 일반 모델로, 텍스트 분류, 텍스트 생성, 이미지 분류, 객체 감지 및 이미지 분류 등 다양한 학습 작업에서 특징 표현 학습에 큰 잠재력을 보여줍니다. .

PFM은 대규모 말뭉치로 여러 작업을 훈련하고 유사한 소규모 작업을 미세 조정하는 데 탁월한 성능을 보여 신속한 데이터 처리를 가능하게 합니다.

PFM은 사전 훈련 기술을 기반으로 하며, 이는 다양한 다운스트림 애플리케이션에서 쉽게 미세 조정할 수 있는 일반 모델을 훈련하기 위해 많은 양의 데이터와 작업을 활용하는 것을 목표로 합니다.

사전 훈련의 아이디어는 CV 작업의 전이 학습에서 비롯되었습니다. 사람들은 CV 분야에서 사전 훈련의 효과를 인식한 후 다른 분야의 모델 성능을 향상시키기 위해 사전 훈련 기법을 사용하기 시작했습니다. 사전 훈련 기술이 NLP 분야에 적용되면 잘 훈련된 언어 모델(LM)은 장기 종속성, 계층적 관계 등과 같은 다운스트림 작업에 유용한 풍부한 지식을 포착할 수 있습니다.

또한 NLP 분야에서 사전 훈련의 중요한 이점은 훈련 데이터가 레이블이 없는 텍스트 코퍼스에서 나올 수 있다는 것입니다. 즉, 사전 훈련 과정에서 훈련 데이터의 양이 무제한이라는 것입니다.

초기 사전 훈련은 NNLM, Word2vec과 같은 정적 방법이었지만 나중에는 다른 의미론적 환경에 적응하기 어려웠으며 일부 연구자들은 BERT, XLNet 등과 같은 동적 사전 훈련 기술을 제안했습니다.

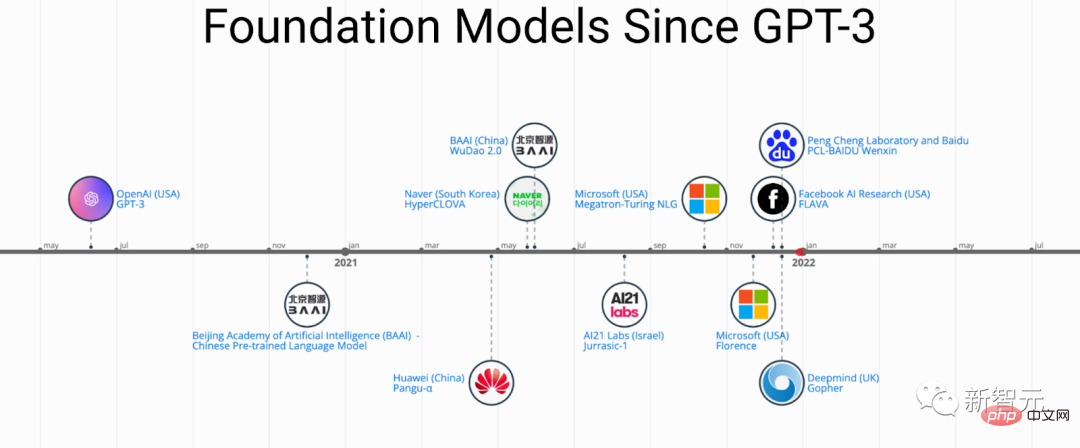

NLP, CV 및 GL 분야에서 PFM의 역사와 진화

사전 학습 기술을 기반으로 하는 PFM은 대규모 말뭉치를 사용하여 공통 의미 표현을 학습합니다. 다운스트림 작업 및 애플리케이션에 등장하여 적용되었습니다.

주목할만한 PFM 적용사례로는 최근 인기를 끌고 있는 ChatGPT가 있습니다.

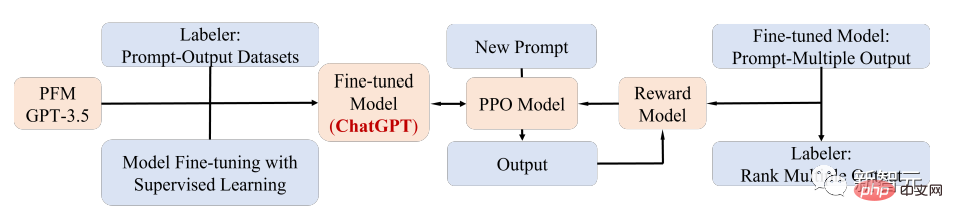

ChatGPT는 텍스트와 코드의 혼합 코퍼스에 대한 교육 후 생성적 사전 교육 Transformer인 GPT-3.5에서 미세 조정되었습니다. ChatGPT는 인간 피드백(RLHF) 기술의 강화 학습을 사용합니다. 현재 대규모 LM을 인간의 의도와 일치시키는 가장 유망한 방법 중 하나입니다.

ChatGPT의 탁월한 성능은 각 PFM 유형의 교육 패러다임 전환, 즉 강화 학습(RL), 프롬프트 튜닝 및 체인 연결을 포함한 교육 정렬 기술의 적용에 중요한 지점으로 이어질 수 있습니다. 생각), 궁극적으로 일반 인공지능으로 나아가게 됩니다.

이 글에서 연구자들은 상대적으로 성숙한 연구 분류 방법인 텍스트, 이미지, 그래프와 관련된 PFM을 주로 검토합니다.

텍스트의 경우 언어 모델은 다음 단어나 문자를 예측하여 다양한 작업을 수행할 수 있습니다. 예를 들어 PFM은 기계 번역, 질문 응답 시스템, 주제 모델링, 감정 분석 등에 사용될 수 있습니다. .

텍스트의 PFM과 유사한 이미지의 경우 대규모 데이터 세트를 사용하여 여러 CV 작업에 적합한 대규모 모델을 교육합니다.

그래프의 경우 유사한 사전 학습 아이디어를 사용하여 많은 다운스트림 작업에 사용할 수 있는 PFM을 얻습니다.

특정 데이터 도메인에 대한 PFM 외에도 이 기사에서는 음성, 비디오 및 도메인 간 데이터에 대한 PFM, 다중 모드 PFM과 같은 기타 고급 PFM도 검토하고 설명합니다.

또한 다중 양식을 처리할 수 있는 PFM의 대규모 융합 추세가 나타나고 있습니다. 이를 통합 PFM이라고 합니다. 연구자들은 통합 PFM의 개념을 먼저 정의한 후 최신 기술을 검토했습니다. OFA, UNIFIED-IO, FLAVA, BEiT-3 등을 포함한 최근 연구 통합 PFM의 예술

이 세 가지 분야의 기존 PFM의 특성을 바탕으로 연구원들은 PFM이 다음과 같은 두 가지 주요 이점을 가지고 있다고 결론지었습니다.

1 다운스트림 작업 성능에 대한 모델을 개선하려면 최소한의 미세 조정만 필요합니다.

2. PFM은 품질 테스트를 통과했습니다.

유사한 문제를 해결하기 위해 처음부터 모델을 구축하는 것보다 더 나은 옵션은 작업 관련 데이터 세트에 PFM을 적용하는 것입니다.

PFM의 엄청난 전망은 모델 효율성, 보안, 압축과 같은 문제에 초점을 맞추는 많은 관련 작업에 영감을 주었습니다.

이 리뷰의 특징은 다음과 같습니다.

참고자료: https://arxiv.org/abs/2302.09419

위 내용은 BERT부터 ChatGPT까지, 베이항대학교를 포함한 9개 최고 연구 기관에 대한 종합적인 리뷰: 우리가 수년간 함께 추구해 온 '사전 훈련 기본 모델'의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!